[论文阅读] AI+软件工程 | 开发者 AI 需求新指南:任务感知视角下的负责任 AI 实证研究

开发者 AI 需求新指南:任务感知视角下的负责任 AI 实证研究

1. 一段话总结

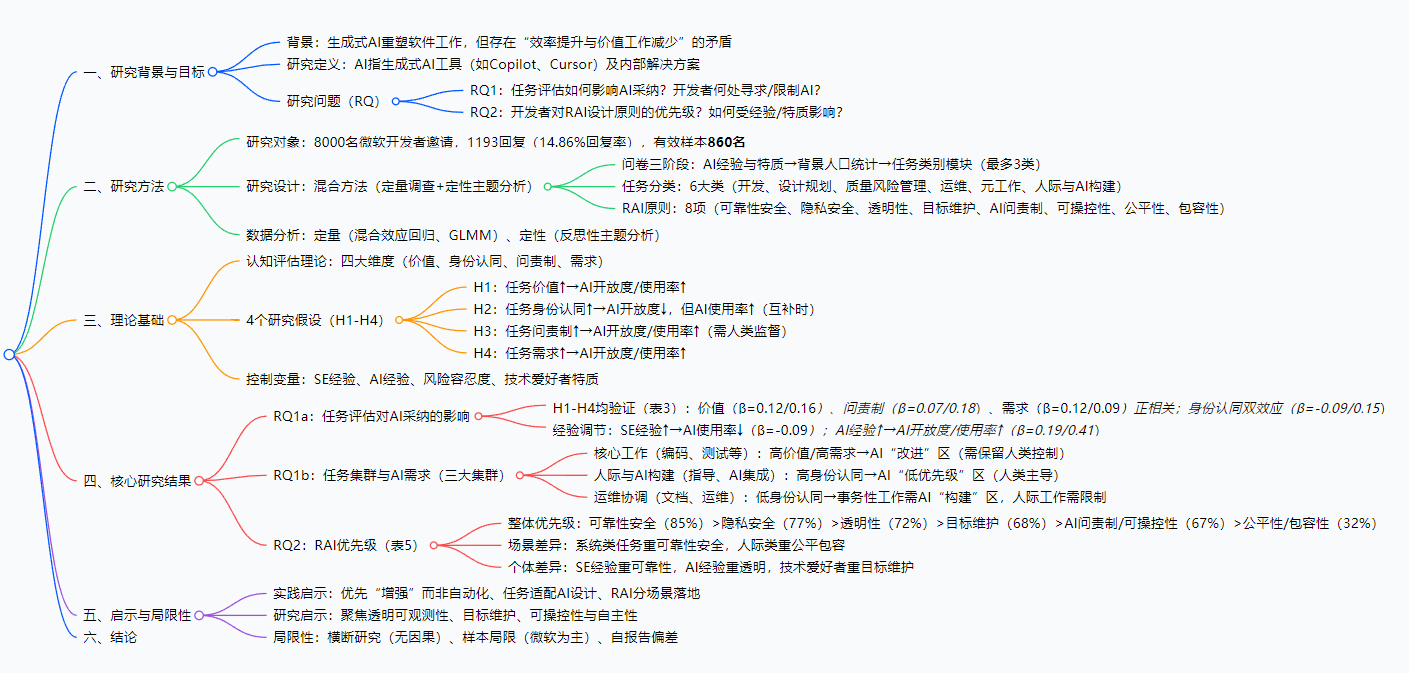

Rudrajit Choudhuri等人针对860名开发者(主要来自微软)开展了大规模混合方法研究,基于认知评估理论探索开发者在日常工作中对AI支持的“何处需要、为何需要及如何设计”,首次建立任务感知的、经验验证的开发者任务认知与AI采纳模式、负责任AI(RAI)优先级的映射关系。研究发现,任务评估(价值、身份认同、问责制、需求)可预测AI采纳:核心工作(如编码、测试)当前AI使用率高且需改进,事务性工作(如文档、运维)需AI减负,身份/人际相关工作(如指导)需限制AI;负责任AI优先级因场景而异(系统类任务需可靠性与安全,控制类任务需透明性与可操控性,人际类任务需公平性与包容性),最终为开发者工作场景下的AI设计提供具体、情境化指导。

2. 思维导图(mindmap)

3. 详细总结

1. 研究概述(摘要核心)

- 研究团队:Rudrajit Choudhuri(俄勒冈州立大学)与微软团队(Carmen Badea等)

- 研究定位:填补“开发者对AI支持的具体需求、限制及负责任设计”的研究空白

- 核心贡献:首次建立“开发者任务认知→AI采纳模式→RAI优先级”的任务感知映射,为AI工具设计提供实证指导

2. 研究背景与意义(引言)

- 现状矛盾:生成式AI(如Copilot)承诺提升效率,但存在“开发者满意度高却减少高价值工作”的悖论,可能削弱职业认同与质量判断

- 现有研究不足:虽关注AI采纳因素(如工作流适配、任务差异),但未解释“开发者为何在某些任务寻求/限制AI”的心理机制

- 研究价值:基于认知评估理论,从“任务意义感知”角度解析AI采纳,同时探索RAI原则的场景化优先级

3. 相关工作

| 研究方向 | 核心发现 | 不足 |

|---|---|---|

| AI采纳因素 | 工作流适配、习惯比“有用性”更影响早期采纳;信任受工具能力、风险容忍度影响 | 未深入任务层面的心理动因 |

| 任务层面差异 | 编码、测试等任务AI接受度高,协作、创意类低;事务性工作(文档、环境搭建)需AI减负 | 未解释“为何这些任务需/拒AI”,缺乏RAI相关研究 |

4. 理论基础与研究假设

- 认知评估理论:开发者通过4个维度评估任务,进而影响AI采纳:

- 价值:任务对项目/个人目标的重要性

- 身份认同:任务与职业自我概念的契合度

- 问责制:任务失败的责任与后果感知

- 需求:任务的认知负荷与难度

- 4个假设(均通过验证,见表3):

- H1:任务价值越高,开发者对AI的开放度和使用率越高(AI作为效率补充)

- H2:任务身份认同越高,AI开放度越低(保留核心 craft),但使用率越高(AI辅助提升能力)

- H3:任务问责制越高,AI开放度和使用率越高(AI作为风险保障,但需人类监督)

- H4:任务需求越高,AI开放度和使用率越高(AI降低认知负荷)

- 控制变量:SE经验(年数)、AI经验(使用频率)、风险容忍度(对AI错误的接受度)、技术爱好者特质(主动尝试AI的意愿)

5. 研究方法(详细设计)

- 研究对象:

- 抽样:微软全球6万+开发者中随机抽样8000人

- 数据筛选:1193份初始回复→剔除不完整(152)、模式化(59)、未通过注意力检查(98)、无AI经验(24)→最终860份有效样本(覆盖6大洲,北美占57.4%,男性占73.8%)

- 问卷设计(遵循Kitchenham指南,Qualtrics平台):

问卷阶段 核心内容 设计细节 1. AI经验与特质 AI工具使用史、风险容忍度、技术爱好者特质 无AI经验者退出;采用“认知风格量表”测量特质 2. 背景与人口统计 SE经验、性别(可选)、所在国家 无强制项,降低填写负担 3. 任务类别模块 任务评估(4维度)、AI开放度/使用率、RAI优先级 选2-3类任务(元工作自动补充,最多3类);Likert 5分量表+开放题 - 任务分类(基于多源实证,表1):

任务大类 具体任务 开发 编码、bug修复、性能优化、重构、AI集成 设计与规划 系统设计、需求工程、项目规划 质量与风险管理 测试/QA、代码审查、安全与合规 运维 DevOps(CI/CD)、环境搭建、基础设施监控 元工作 文档、利益相关者沟通、指导/入职、学习、研究 人际与AI构建 指导、AI集成(单独聚类) - 数据分析方法:

- 定量:混合效应回归(RQ1,控制个体/任务随机效应)、逻辑斯蒂GLMM(RQ2,预测RAI原则优先级)

- 定性:反思性主题分析(开放题编码,团队共识验证;1528条AI需求回复,2453条RAI解释回复)

6. 核心研究结果

6.1 RQ1:任务评估对AI采纳的影响及AI需求场景

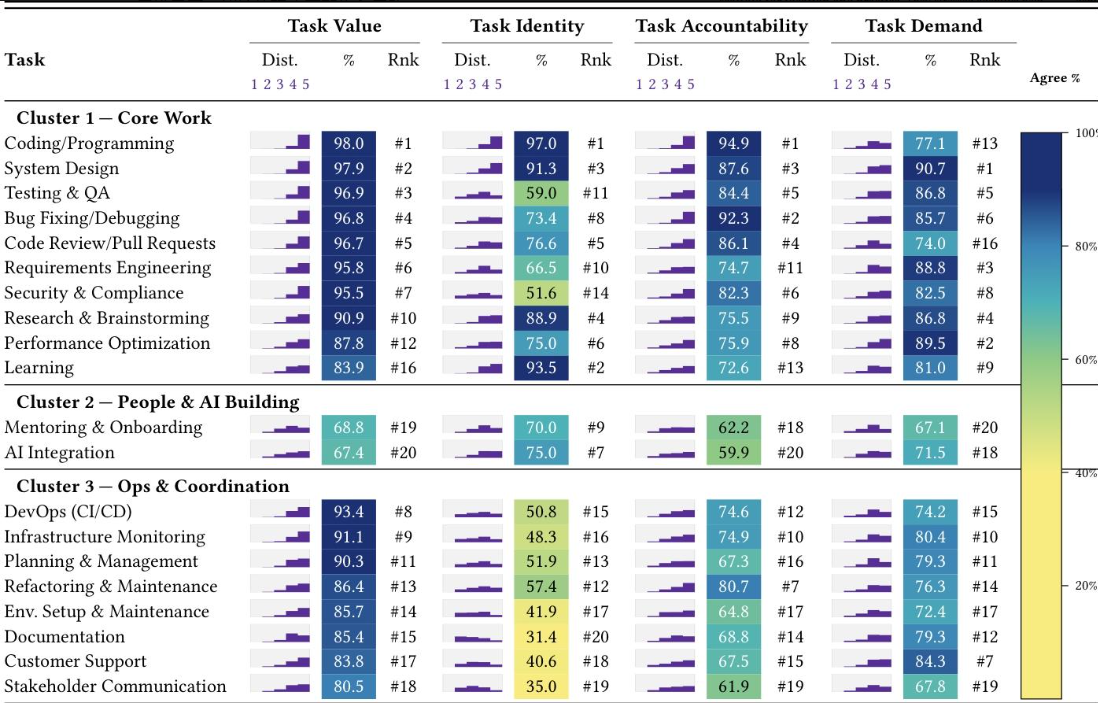

-

6.1.1 任务评估的预测作用(表3:混合效应回归结果):

评估维度 对AI开放度的影响(β) 对AI使用率的影响(β) 效应量(d) 结论 价值(H1) 0.12*** 0.16*** 0.16/0.18 高价值任务(如编码)更愿用AI,但需保留控制 身份认同(H2) -0.09*** 0.15*** -0.15/0.20 身份相关任务(如指导)不愿开放AI,但用AI提升能力 问责制(H3) 0.07*** 0.18*** 0.10/0.21 高风险任务(如安全合规)用AI降低风险,但需人类审核 需求(H4) 0.12*** 0.09*** 0.18/0.10 高负荷任务(如文档)用AI减负 SE经验 - -0.09*** -0.13 资深开发者依赖现有技能,AI使用率低 AI经验 0.19*** 0.41*** 0.27/0.46 AI经验越丰富,越愿用AI *注:**p<0.001,FDR校正后显著;R²m/R²c表示模型拟合度(开放度:0.25/0.45;使用率:0.25/0.48) -

6.1.2 任务集群与AI需求(3大集群,图1四象限):

任务集群 核心特征(评估维度) AI需求象限 具体表现 核心工作(编码、测试、代码审查等) 高价值、高问责制、中高身份认同 改进区(高需求+高使用) 用AI生成模板、查bug,但拒绝完全自动化(“保留最终决策权”) 人际与AI构建(指导、AI集成) 高身份认同、中价值、中问责制 低优先级区(低需求+低使用) 拒绝AI主导(“指导需人际信任”),仅用AI辅助基础步骤 运维协调(文档、DevOps、客户支持) 中高价值、低身份认同、中高需求 构建区(高需求+低使用)/低优先级区 事务性工作(文档、环境搭建)需AI改进工具;人际工作(客户沟通)拒绝AI

6.2 RQ2:负责任AI(RAI)原则的优先级

-

整体优先级(开发者选择率):

- 可靠性与安全(85%)→ 核心需求:AI输出无错误、无安全风险

- 隐私与安全(77%)→ 核心需求:保护敏感代码/数据

- 透明性(72%)→ 核心需求:AI决策可解释、来源可追溯

- 目标维护(68%)→ 核心需求:AI适配动态任务目标

- AI问责制(67%)/可操控性(67%)→ 核心需求:错误可溯源、AI行为可调整

- 公平性(32%)/包容性(32%)→ 当前优先级低,因“基础需求未满足”

-

场景与个体差异(表5:GLMM结果):

影响因素 RAI优先级变化 具体例子 任务类别:系统类(开发、运维) 可靠性安全、隐私安全优先级↑ 运维任务中,隐私安全OR=1.38*(比开发任务高38%概率被选) 任务类别:人际类(元工作、设计) 公平性、包容性优先级↑ 元工作中,公平性OR=3.06***(比开发任务高3倍概率被选) SE经验↑ 可靠性安全优先级↑ 资深开发者选可靠性安全的OR=1.15* AI经验↑ 透明性优先级↑ AI老手选透明性的OR=1.30* 技术爱好者特质↑ 目标维护优先级↑ 技术爱好者选目标维护的OR=1.16** 所有群体 可操控性优先级↑ SE经验/AI经验/风险容忍度/技术爱好者均提升可操控性优先级(OR=1.21*/1.11*/1.13**/1.28*)

7. 实践与研究启示

-

实践启示:

- 优先“增强”而非自动化:AI应辅助开发者(如生成备选方案),而非替代核心决策

- 任务适配设计:核心工作需“透明可操控”,运维工作需“可靠 deterministic”,人际工作需“人类主导+AI辅助”

- RAI分阶段落地:先满足可靠性/隐私/透明,再优化公平/包容

-

研究启示:

- 透明与可观测性:如何设计AI解释,避免过度依赖?

- 目标维护:如何让AI适配动态任务目标,减少“目标漂移”?

- 可操控性:如何平衡AI自主性与开发者控制,降低调整成本?

8. 局限性

- 结构效度:采用单题项测量任务评估维度(虽符合“具体构念”有效性,但可能遗漏细节)

- 内部效度:横断研究,仅能说明关联,无法证明因果

- 外部效度:样本以微软开发者为主,可能不适用于小型企业或开源社区

9. 结论

生成式AI在软件工作中的价值核心是“匹配任务场景与开发者需求”:在核心工作中提升效率、在事务性工作中减少负担、在人际/身份工作中保持人类主导,同时基于场景适配负责任AI原则,最终实现“AI在关键处”的价值最大化。

4. 关键问题

问题1:任务评估的四大维度(价值、身份认同、问责制、需求)如何具体影响开发者对AI的开放度与使用率?各维度的作用机制有何差异?

答案:四大维度均显著预测AI采纳(FDR校正后p<0.001),但作用机制存在明确差异:

- 价值:正向影响(开放度β=0.12,使用率β=0.16),机制是“高价值任务(如编码)需效率提升,但开发者会保留决策权以避免风险”,例如开发者用AI生成代码模板,但亲自审查逻辑;

- 身份认同:双效应(开放度β=-0.09,使用率β=0.15),机制是“身份相关任务(如指导、AI集成)不愿开放AI以保护职业craft,但会用AI辅助能力提升”,例如拒绝AI替代指导,但用AI生成入职资料;

- 问责制:正向影响(开放度β=0.07,使用率β=0.18),机制是“高风险任务(如安全合规)用AI作为‘风险缓冲’,但需人类监督以承担最终责任”,例如用AI扫描安全漏洞,但亲自验证修复方案;

- 需求:正向影响(开放度β=0.12,使用率β=0.09),机制是“高认知负荷任务(如文档、环境搭建)用AI降低负担”,例如用AI自动生成API文档,但需调整格式以匹配团队规范。

此外,SE经验(β=-0.09)负向影响AI使用率(资深开发者依赖现有技能),AI经验(β=0.41)正向影响使用率(熟悉AI特性后更愿采纳)。

问题2:不同任务集群(核心工作、人际与AI构建、运维协调)对AI支持的需求与限制存在哪些核心差异?这些差异背后的核心原因是什么?

答案:三大集群的AI需求差异显著,核心原因是“任务的意义感知(身份认同、价值)与风险感知(问责制)”:

-

核心工作集群(编码、测试、代码审查等):

- 需求:高需求+高使用率(“改进区”),需AI提升效率(如生成测试用例、查bug);

- 限制:拒绝完全自动化,需保留人类控制;

- 原因:任务“高价值+高问责制+中高身份认同”,开发者既需AI辅助,又需保护职业核心能力与最终责任。

-

人际与AI构建集群(指导、AI集成):

- 需求:低需求+低使用率(“低优先级区”),仅用AI辅助基础步骤(如生成指导手册框架);

- 限制:拒绝AI主导,坚持人类主导;

- 原因:任务“高身份认同+高人际依赖”,指导需建立信任、AI集成需craft把控,这些是AI无法替代的人类特质。

-

运维协调集群(文档、DevOps、客户支持):

- 需求:事务性工作(文档、环境搭建)高需求+低使用率(“构建区”),需AI减负;人际性工作(客户支持、利益相关者沟通)低需求(“低优先级区”);

- 限制:事务性工作需AI“可靠+可追溯”(如避免AI生成错误的CI/CD配置),人际性工作拒绝AI(如“客户沟通需个人温度”);

- 原因:事务性工作“低身份认同+高需求”,需AI降低负担;人际性工作“高人际依赖”,需人类的同理心与情境判断。

问题3:开发者对负责任AI(RAI)原则的优先级受哪些关键因素影响?不同场景下的优先级差异对AI工具设计有何具体指导意义?

答案:RAI优先级主要受“任务类别”和“个体特质”两大因素影响,差异对AI设计的指导意义明确:

-

影响因素1:任务类别(核心差异是“任务是否涉及系统风险或人际互动”):

- 系统类任务(开发、运维、质量风险管理):优先级最高的是可靠性与安全(OR基准=18.15***)、隐私与安全(OR基准=8.19***),其次是透明性(OR基准=5.17***);

- 设计指导:AI工具需默认开启“错误检测”“敏感数据屏蔽”功能,提供“输出来源追溯”(如代码建议来自某开源库);

- 人际类任务(元工作、设计规划):优先级提升的是公平性(元工作OR=3.06***)、包容性(元工作OR=2.49***),且降低可靠性要求(设计规划OR=0.49**);

- 设计指导:AI生成文档时需内置“偏见检测”(如避免性别歧视表述),创意类任务(如系统设计)可允许AI输出多样化方案(即使存在小瑕疵)。

- 系统类任务(开发、运维、质量风险管理):优先级最高的是可靠性与安全(OR基准=18.15***)、隐私与安全(OR基准=8.19***),其次是透明性(OR基准=5.17***);

-

影响因素2:个体特质(核心差异是“经验水平与风险态度”):

- SE经验丰富者:更关注可靠性与安全(OR=1.15*);设计指导:为资深开发者提供“严格模式”,减少AI自动修改代码;

- AI经验丰富者:更关注透明性(OR=1.30*);设计指导:为AI老手提供“详细解释”选项,展示AI决策逻辑;

- 技术爱好者:更关注目标维护(OR=1.16**);设计指导:允许技术爱好者自定义AI目标(如“优先生成性能优化代码”);

- 所有群体:均重视可操控性(SE经验OR=1.21*/AI经验OR=1.11*/风险容忍度OR=1.13**/技术爱好者OR=1.28*);设计指导:所有AI工具需提供“一键回滚”“局部调整”功能,避免AI强制自动化。

-

核心设计结论:RAI原则需“场景化配置”,而非一刀切——系统类任务优先“安全可靠”,人际类任务优先“公平包容”,同时为不同特质开发者提供“可调节的RAI选项”。