华为MindIE 推理引擎:架构解析

MindIE(Mind Inference Engine,昇腾推理引擎)是华为昇腾面向 AI 全场景的推理加速套件,通过分层开放 + 硬件深度优化,实现从端侧到数据中心的全场景推理能力覆盖。以下结合架构图与行业竞品,详细解析其技术设计与生态定位。

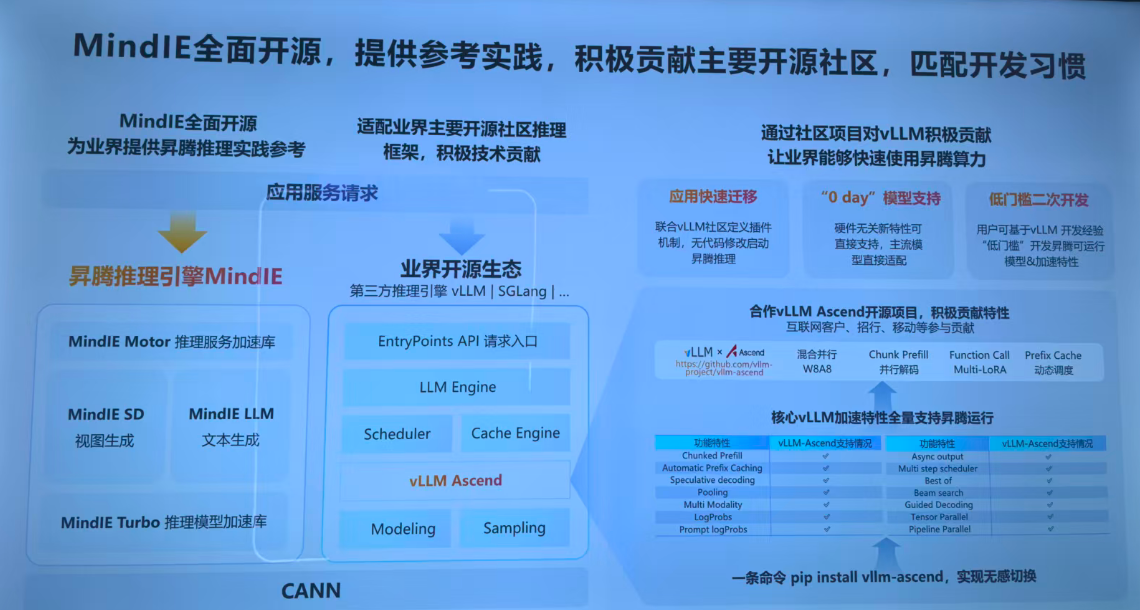

一、MindIE 架构与模块深度解析

MindIE 采用 **“服务化层 + 模型应用层 + 框架插件层 + 推理运行时”** 的分层架构,底层依托华为 CANN(昇腾异构计算架构)实现硬件算力调度,各层级功能相互协同:

1. 服务化层:MindIE-Service—— 推理服务的 “中枢大脑”

负责大模型推理的服务化部署、运维与生态对接,核心组件包括:

MindIE Server:推理服务端,提供模型的服务化封装能力,支持命令行部署 RESTful 服务,可对接 Triton、OpenAI、TGI、vLLM 等主流推理框架接口。

MindIE Client:服务客户端,提供标准化 API(如 Python/C++ 接口),简化用户对推理服务的调用流程。

MindIE MS(Management Service):服务策略管理模块,具备模型 Pod 级 / 实例级管理、自动扩缩容、负载均衡、故障重调度等运维能力,提升硬件资源利用率与服务稳定性。

MindIE Benchmark:性能与精度测试工具,支持在不同配置下测试大模型推理表现,为调优提供数据支撑。

该层的核心价值是 **“生态兼容 + 自主可控”**:既通过对接主流框架(如 vLLM-Ascend 项目)降低用户迁移成本,又通过自研服务化平台牵引生态向昇腾体系迁移。

2. 模型应用层:场景化加速的 “专项利器”

针对不同 AI 场景定制优化,典型模块包括:

MindIE LLM:大语言模型推理加速模块,集成连续批处理(Continuous Batching)、分页注意力(PageAttention)、FlashDecoding、PD 分离(Prefill 与 Decode 阶段并行)等技术。例如,通过 Grouped-Query Attention(GQA)/Multi-Query Attention(MQA)优化注意力计算,在多任务并行、长序列推理场景中性能提升显著;“SplitFuse” 优化可减少 Prefill 与 Decode 阶段的通信开销,实测吞吐量提升 3-4 倍。

MindIE SD:视图生成(如 Stable Diffusion 模型)推理套件,提供端到端的文生图加速方案,集成模型加载、图优化、推理执行等全流程能力,开箱即用。

MindIE Turbo:通用推理模型加速库,通过算子融合、内存复用、多流并行等技术,为各类 AI 模型提供推理性能增益,尤其在 MoE(混合专家)模型场景中,结合 “混合并行 + 专家负载均衡 + 极致算子融合” 等技术,推理效率提升可达 20 倍。

3. 框架插件层:生态对接的 “桥梁”

实现主流训练框架到昇腾推理的平滑迁移,代表模块为MindIE-Torch:

作为 PyTorch 的推理加速插件,支持TorchScript、torch.export、torch.compile等多种模型转换与编译模式,覆盖静态 / 动态 Shape 场景。

支持子图 + 单算子混合执行,自动识别并加速可在昇腾 NPU 上执行的算子,不支持的算子则 “fallback” 到 CPU 或torch_npu执行,兼顾兼容性与性能。

支持混合精度(FP32/FP16)、异步推理与数据拷贝,大幅提升 PyTorch 模型在昇腾平台的推理效率。

4. 推理运行时:MindIE-RT—— 性能加速的 “内核引擎”

作为昇腾推理的核心执行层,负责模型的 “图编译 - 优化 - 部署” 全流程:

图编译与统一表示:将 PyTorch、ONNX 等不同框架的模型转换为统一计算图,屏蔽框架差异。

多粒度优化:通过算子融合、量化(如动态量化)、内存预取等技术优化计算图,减少冗余操作。

高性能算子库(ATB):集成针对 Transformer 等大模型的专用加速算子,如 Encoder/Decoder 融合算子,大幅提升注意力机制、前馈网络的计算效率。

运行时调度:支持多任务队列并发执行、推理结果内存复用,降低延迟并提升吞吐量。

二、行业竞品对比:MindIE 的差异化优势与定位

当前大模型推理引擎领域,主流竞品包括vLLM(NVIDIA 生态)、TensorRT-LLM(NVIDIA)、TGI(Hugging Face)、llama.cpp等。MindIE 与它们的核心差异的可从以下维度对比:

维度 | MindIE | vLLM | TensorRT-LLM | TGI(Hugging Face) | llama.cpp |

硬件依赖 | 昇腾 NPU(910/950 系列深度优化) | NVIDIA GPU(A100/H100 等) | NVIDIA GPU(全栈硬件优化) | 多厂商 GPU | CPU / 边缘设备 |

核心技术 | PageAttention/PD 分离 / 算子融合(昇腾架构定制) | PagedAttention(显存管理) | 静态图编译 + 硬件级算子优化 | 生态集成 + 流式输出 | 多级量化 + 轻量部署 |

场景覆盖 | 端云协同(端侧 + 数据中心) | 数据中心大规模推理 | 低延迟生产级推理 | 易用性优先 | 边缘极简部署 |

生态对接 | 支持 Triton/TGI/vLLM 接口,自研服务化平台 | 开源社区活跃,兼容 OpenAI API | 深度集成 NVIDIA 生态(Triton 等) | Hugging Face 生态原生 | 跨平台(轻量生态) |

迁移成本 | 训推同构(与 MindSpore 协同),GPU 模型迁移约 2 人周 | 依赖 CUDA,框架迁移成本高 | 依赖 CUDA,模型编译门槛高 | 训练推理无缝衔接 | 模型量化后轻量迁移 |

特色优势 | 昇腾架构下大模型推理性能领先(如 MoE 场景效率提升 20 倍);端云协同能力 | 显存利用率超 90%,高吞吐量 | 极致低延迟,生产环境稳定性强 | 生态工具链完善 | 资源受限场景的 “兜底” 方案 |

MindIE 的核心竞争力

硬件 - 软件深度协同:针对昇腾 NPU 的达芬奇架构、多芯片互联等特性(如 950 系列的 HiF8 精度、灵衢 2.0 互联)定制优化,充分释放硬件算力,在 MoE 模型、长序列推理等场景性能优势显著。

全场景覆盖能力:从端侧(支持动态 Shape、轻量化部署)到数据中心大规模集群,同时兼顾 “通用推理 + 场景化加速(LLM/SD)”,满足不同行业的多元化需求。

生态平衡策略:通过兼容主流框架接口(如 vLLM-Ascend 项目,实现pip install vllm-ascend无感切换)降低用户迁移成本,同时打造自主可控的服务化平台,逐步构建昇腾推理生态。

待提升方向

生态成熟度:vLLM、TensorRT-LLM 依托 NVIDIA GPU 生态发展更早,社区资源与开源模型支持更广泛;MindIE 虽全面开源并积极贡献社区,但生态积累仍需时间。

硬件通用性:绑定昇腾 NPU,对已部署昇腾集群的企业是优势,但相比支持多厂商 GPU 的竞品,在跨硬件平台场景的灵活性稍逊。

综上,MindIE 是华为昇腾生态下的 “全场景推理中枢”,通过架构创新与硬件深度优化,在国产 AI 算力平台上实现了推理性能与生态兼容的平衡,为大模型落地提供了自主可控的技术选项。