Datawhale25年9月组队学习:llm-preview+Task2:大模型使用

1.API调用云端大模型

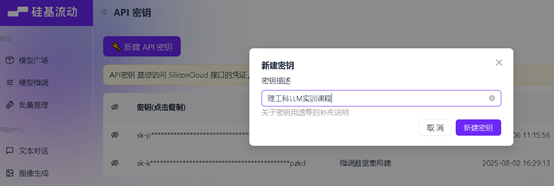

**Step1 注册硅基流动API key

Step2 保存自己的api_key

Step3 找到自己需要的云端的大模型,保存base_url**

2.课后作业

请同学们尝试使用 python 中的 requests 来调用模型服务。

‘’’

与大模型进行对话的函数

功能:输入用户提示词,返回云端LLM的回复文本,实现用户与云端LLM的对话

input: user_input: str, history: list = None, temperature: float, system_prompt: str

output: 返回模型回复的文本

Args:

user_input: 用户输入的文本

history: 历史对话记录列表

temperature: 温度参数,控制输出的随机性

system_prompt: 系统提示词

‘’’

函数定义

def chat_with_model(user_input: str, history: list = None, temperature: float = 0.7, system_prompt: str = None) -> str:

# 初始化 OpenAI 客户端

client = OpenAI(api_key=**"your api key"**, base_url=**"your url"**)# 初始化历史记录

if history is None:history = []# 构建消息列表

messages = []# 添加系统提示词(如果有)

if system_prompt:messages.append({"role": "system", "content": system_prompt})# 添加历史对话

for msg in history:messages.append(msg)# 添加当前用户输入

messages.append({"role": "user", "content": user_input})# 调用API获取响应

response = client.chat.completions.create(model="Qwen/Qwen3-8B",messages=messages,temperature=temperature

)# 返回模型回复的文本

return response.choices[0].message.content

print(chat_with_model("hello Qwen3-8B! "))