【计算机毕业设计】基于生成对抗网络的动作与表情一致性动漫角色生成算法系统

目录

前言

课题背景和意义

实现技术思路

一、 理论基础

1.1 GAN

1.2 DCGAN

二、 数据集

三、实验及结果分析

最后

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

最新最全计算机专业毕设选题精选推荐汇总

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于生成对抗网络的动作与表情一致性动漫角色生成算法系统

课题背景和意义

随着动画产业的迅速发展,动漫作品在全球范围内受到越来越多的关注与喜爱。动漫人物的创造不仅需要丰富的想象力和艺术才能,还涉及到复杂的设计与绘制过程。传统的动漫角色生成方法主要依赖于艺术家的手工绘制,这不仅耗时耗力,而且难以快速生成多样化的人物设计。动漫角色生成是计算机视觉与计算机图形学的重要交叉应用方向,广泛应用于动画制作、游戏开发、虚拟偶像、虚拟试衣与影视特效等领域。随着深度学习特别是生成式对抗网络(GAN)在图像生成任务上取得的显著进步,基于数据驱动的方法已成为生成高质量动漫人物图像的主流手段。传统的静态人物生成大多关注单帧图像的细节与风格(如发型、服饰与面部特征),但在动画与交互场景中,角色需要随动作变化展现连贯且与情绪相匹配的表情,这涉及到时序一致性、结构约束与语义控制等复杂问题。单纯对单帧图像建模无法保证跨帧的动作-表情语义一致性,从而导致视觉不连贯或违和感,降低观感与应用价值。

实现技术思路

一、 理论基础

1.1 GAN

生成式建模的核心任务是准确捕捉并重构数据的潜在分布,从而生成与原数据分布一致但内容不同的新样本。目前主流的生成式框架包括变分自编码器(VAE)与生成对抗网络(GAN),两者各有优劣。VAE通过对潜在空间进行概率建模,具备良好的训练稳定性与潜在空间连续性,便于插值与属性控制,但往往在生成样本的细节与清晰度上不及GAN;GAN则通过对抗训练大幅提升图像的精细纹理与视觉真实感,但训练时容易出现不稳定性、模式崩溃(mode collapse)与难以收敛的问题。针对动漫人物生成这一任务,重要的是选择或设计能够兼顾高保真视觉质量与潜在分布覆盖性的模型架构与训练策略。常见改进包括采用谱归一化(spectral normalization)、渐进式训练、多尺度判别器、感知损失(perceptual loss)与条件生成(如骨架/关键点/情绪标签)等技术,以增强生成图像的结构一致性与细节表现力。对于动作—表情一致性的需求,还需在生成框架中引入时序一致性约束(例如使用光流一致性损失、时序判别器或循环/卷积时序模块),以及设计能反映动作与表情耦合关系的条件输入格式(如将骨架序列与面部表达编码共同输入到生成器),从而使生成过程既保持帧间连贯性又保留风格特征。

反卷积网络在生成式任务中扮演着核心角色,其主要功能是将低分辨率的特征图逐步上采样并恢复到目标图像尺寸,从而实现从潜在向量到像素级图像的映射。与传统卷积操作相反,反卷积通过在输入特征图元素间插入零值或通过可学习的卷积核在更高分辨率的格点上计算输出来实现空间维度的扩张,这使得生成器能够在保持语义信息的同时逐层增加空间细节,为逐步构建图像的全局结构与局部纹理提供了可能,反卷积并非没有问题:直接使用反卷积层容易引入棋盘状伪影,这是由于步长、内核大小与填充方式不匹配导致的不均匀重叠效应,在实际设计生成器网络时,常采用替代或改进策略再做标准卷积、使用子像素卷积以减少伪影并提升输出的视觉平滑度和细节一致性。此外,多尺度特征融合、跳跃连接与批量归一化/谱归一化等技术通常与反卷积层联合使用,以稳定训练并增强生成图像的层次结构信息。

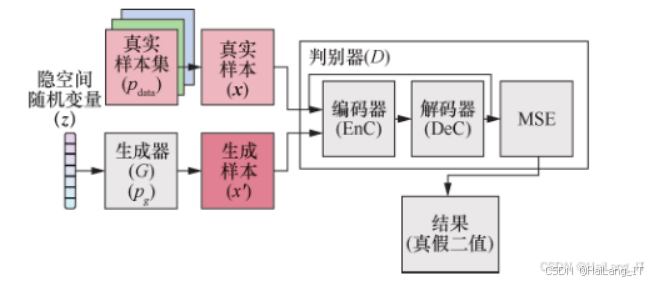

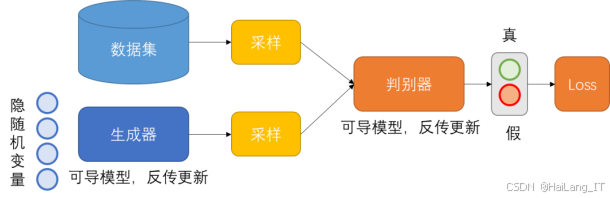

在生成对抗网络的框架中,生成器(G)与判别器(D)之间的对抗性训练构成了实现分布逼近的核心机制。生成器接收来自先验分布(通常为高斯或均匀分布)的随机噪声 z,通过一系列潜在空间映射与上采样模块(其中包含反卷积层)生成假样本,目标是让判别器无法区分这些假样本与真实样本。判别器则被训练为一个二分类器,旨在最大化对真实样本的判别概率并最小化对生成样本的判别概率,从而为生成器提供训练信号。该过程被形式化为一个最小-最大博弈问题:生成器最小化判别器对假样本的识别能力,而判别器最大化识别能力。通过交替优化二者的参数,G 被迫逐步改进其输出,使生成样本的分布向真实数据分布 P_data 收敛。值得注意的是,这一对抗训练过程在实践中容易出现若干训练病态现象,例如不稳定收敛、梯度消失或模式崩溃,提出了改进损失函数(如Wasserstein GAN、LSGAN)、正则化手段(谱归一化、梯度惩罚)、以及平衡训练步长与判别器/生成器的训练次数等策略来缓解这些问题,包括旨在稳定判别器的学习并为生成器提供有意义且持续的梯度信号。

在设计生成系统与评估方案时,通常需要结合多种指标与主观评估:对静态质量采用 FID/IS 等客观指标和人工视觉评分;对时序或属性一致性则引入专门的度量(如基于关键点或光流的帧间连续性误差、行为/表情一致性评分),并辅之以用户研究或专家评分以获取主观体验层面的评价。工程实现方面,还需关注判别器设计对训练动态的影响(例如使用多尺度判别器来同时监督全局结构与局部细节)、反卷积引发的伪影处理、以及在高分辨率生成场景下的计算与内存开销问题。

1.2 DCGAN

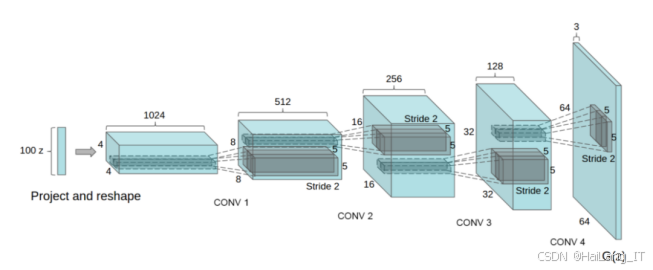

采用深度卷积生成对抗网络(DCGAN)作为基础模型时,其核心思想沿袭传统生成对抗网络(GAN)的博弈式训练框架,但将原始的多层感知器替换为卷积神经网络以更好地处理图像的空间特征。具体而言,DCGAN 的生成器通常以一个低维随机向量为输入,经过一系列反卷积层、批量归一化与非线性激活函数逐步放大特征图的空间尺寸,直至生成目标尺寸的彩色图像。判别器则采用多层卷积结构,通过逐层下采样、归一化与激活,将输入的 64×64×3 图像映射为单一的判别值,表示该图像来自真实数据分布的概率。在网络设计上,DCGAN 倡导使用无池化层、将步幅与内核尺寸配合以实现尺度变换、并在生成器中使用 ReLU、判别器中使用 LeakyReLU,以保证训练稳定性和生成样本的细节表现。同时,使用批量归一化或谱归一化可进一步规范梯度流、抑制训练不稳定与模式崩溃现象。

在训练流程方面,DCGAN 的损失函数与标准 GAN 保持一致,通过交替最小化生成器和最大化判别器目标实现对抗训练:判别器学习区分真实与生成样本,而生成器试图欺骗判别器以使生成样本更接近真实分布。在实现动漫人物生成时,需要注意若干工程要点以提高生成效果与稳定性:噪声维度、反卷积层数与每层通道数应根据目标分辨率与数据集复杂性调整;反卷积引发的棋盘伪影可通过先上采样再卷积、子像素卷积或精心选择卷积步幅与内核尺寸来缓解;再次,鉴于动漫图像对风格和细节的高度敏感,加入条件信息、感知损失或多尺度判别器可以显著提升结构一致性与视觉品质,训练过程中应结合定量指标与定性人工评价,监控模式多样性与时序一致性,并在模型达到满意效果后考虑模型压缩与加速,以便在动画制作流水线或实时交互场景中部署。

二、 数据集

在数据集采集过程中,根据研究目标选择合适的数据采集方法至关重要。例如,使用网络爬虫程序可以自动从网页上提取大量的文本数据或图像,这种方法适合于需要大规模数据的场景,能够高效、系统地收集信息。通过编写定向爬虫并结合站点地图、搜索引擎API与图像聚合站点的筛选规则,可以构建覆盖多种风格、姿态与表情的动漫图像库,在采集后必须进行严格的数据清洗与标注流程,包括去重、分辨率标准化、姿态与表情标签的半自动化标注以及版权来源跟踪。为了保证训练集在时序建模或动作—表情耦合研究中的有效性,采集时应注意保留动作序列信息或关联多帧样本,并尽量收集包含多角度、多表情和多光照条件下的样本,以提高模型的泛化能力与鲁棒性。针对需要高质量面部表情与细节的研究,还可采用混合采集策略:结合公开数据集与人工筛选的高质量样本,进而保证数据覆盖与标注准确性。

在某些特定情况下,例如进行动作—表情同步研究或需要精确控制动作参数的实验,手动采集或合作采集成为更为合适的选择。手动采集的优势在于能够在可控实验环境中获取带有精确标注的多模态数据,例如使用动作捕捉设备、面部表情捕捉或标注工具采集带有关键点、骨架与表情强度标签的时间序列数据。这类数据有利于建立动作与面部表情之间的因果或条件关系,为训练条件生成模型提供高质量的监督信号。手动采集通常成本较高、耗时较长,但能显著提升数据质量与实验可控性,尤其适用于验证模型在复杂动作与情绪转换场景中的表现,保证标注速度的同时提高标签的一致性与语义准确度。

三、实验及结果分析

在生成动漫人物之前,首先需要准备数据集。这一步骤涉及收集包含大量动漫人物图像的数据库,并对这些图像进行预处理。预处理的内容通常包括调整图像的大小、归一化像素值以及可能的数据增强,以增加数据集的多样性。通过将图像大小调整为统一的尺寸(例如64×64),可以确保在训练过程中输入的形状一致。

from torchvision import transforms

from PIL import Image

from pathlib import Path

import torch

from torch.utils.data import Dataset, DataLoaderimage_size = 64

data_root = "./data/anime"transform = transforms.Compose([transforms.Resize(image_size),transforms.CenterCrop(image_size),transforms.RandomHorizontalFlip(p=0.5),transforms.ToTensor(),transforms.Normalize([0.5]*3, [0.5]*3) # map to [-1,1]

])class FlatImageFolder(Dataset):def __init__(self, root, transform=None):self.paths = list(Path(root).glob("*.*"))self.transform = transformdef __len__(self):return len(self.paths)def __getitem__(self, idx):img = Image.open(self.paths[idx]).convert("RGB")if self.transform:img = self.transform(img)return imgdataset = FlatImageFolder(data_root, transform=transform)

dataloader = DataLoader(dataset, batch_size=128, shuffle=True, num_workers=4, pin_memory=True)生成器的核心任务是将潜在空间的随机噪声映射到像素空间。设计时要考虑信息如何从低维向高维解码:通常从一维噪声向量通过全连接重塑为小尺寸多通道特征图,再用一系列反卷积或“上采样+卷积”模块放大尺寸。中间层加 BatchNorm 有助于稳定梯度、加速收敛;ReLU 激活有利于传递正激活,输出层用 Tanh 将像素值映射到 [-1,1]。当使用 ConvTranspose2d 时留意棋盘伪影,可通过上采样+ Conv2d 或 PixelShuffle 替代以缓解。对于动漫图像,保持风格一致性与边缘清晰尤为重要,因此可以在生成器中引入跳跃连接、多尺度融合或条件输入影响生成多样性:过低可能降低样本多样性,过高增加训练难度。

import torch.nn as nnnz = 100 # 噪声维度

ngf = 64 # 基础通道数class Generator(nn.Module):def __init__(self, nz, ngf, nc=3):super().__init__()self.main = nn.Sequential(nn.ConvTranspose2d(nz, ngf*8, 4, 1, 0, bias=False),nn.BatchNorm2d(ngf*8),nn.ReLU(True),nn.ConvTranspose2d(ngf*8, ngf*4, 4, 2, 1, bias=False),nn.BatchNorm2d(ngf*4),nn.ReLU(True),nn.ConvTranspose2d(ngf*4, ngf*2, 4, 2, 1, bias=False),nn.BatchNorm2d(ngf*2),nn.ReLU(True),nn.ConvTranspose2d(ngf*2, ngf, 4, 2, 1, bias=False),nn.BatchNorm2d(ngf),nn.ReLU(True),nn.ConvTranspose2d(ngf, nc, 4, 2, 1, bias=False),nn.Tanh())def forward(self, z):return self.main(z)判别器的任务是区分真实图像与生成图像,为生成器提供训练信号。判别器通常采用逐层卷积和下采样来提取图像的多尺度特征,输出单值或多值判别结果。LeakyReLU 在判别器中常被用来避免死节点问题。过强的判别器会使生成器难以获得有效梯度(梯度消失),过弱则无法对生成器施加足够压力,因此需通过调节网络深度、学习率或训练频率来平衡 G 与 D。为增强对细节的判别能力,可以采用多尺度判别器或局部判别器来同时监督全局结构与局部细节。判别器输出通常使用 logits 并配合 BCEWithLogitsLoss 以提高数值稳定性。

class Discriminator(nn.Module):def __init__(self, nc=3, ndf=64):super().__init__()self.main = nn.Sequential(nn.Conv2d(nc, ndf, 4, 2, 1, bias=False),nn.LeakyReLU(0.2, inplace=True),nn.Conv2d(ndf, ndf*2, 4, 2, 1, bias=False),nn.BatchNorm2d(ndf*2),nn.LeakyReLU(0.2, inplace=True),nn.Conv2d(ndf*2, ndf*4, 4, 2, 1, bias=False),nn.BatchNorm2d(ndf*4),nn.LeakyReLU(0.2, inplace=True),nn.Conv2d(ndf*4, ndf*8, 4, 2, 1, bias=False),nn.BatchNorm2d(ndf*8),nn.LeakyReLU(0.2, inplace=True),nn.Conv2d(ndf*8, 1, 4, 1, 0, bias=False),)def forward(self, x):return self.main(x).view(-1)合理的权重初始化能加速训练并减少早期不稳定。DCGAN 实践中常将卷积核权重初始化为均值 0、方差 0.02 的正态分布,BatchNorm 权重初始化为 1、偏置为 0。设置随机种子可保证结果可复现。选择合适的设备(GPU > CPU)对训练速度影响显著;若使用多卡训练需采用 DistributedDataParallel 并调整 batch size 与学习率。训练时建议定期保存模型 checkpoint、日志和生成样本,便于监控与恢复。

def weights_init(m):classname = m.__class__.__name__if classname.find('Conv') != -1:nn.init.normal_(m.weight.data, 0.0, 0.02)elif classname.find('BatchNorm') != -1:nn.init.normal_(m.weight.data, 1.0, 0.02)nn.init.constant_(m.bias.data, 0)device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

torch.manual_seed(999)

netG = Generator(nz, ngf).to(device)

netD = Discriminator(ndf=64).to(device)

netG.apply(weights_init)

netD.apply(weights_init)GAN 常用的损失为二元交叉熵,但该损失在训练中可能导致梯度消失或训练不稳定。改进的损失如 WGAN(Wasserstein GAN)及其带梯度惩罚的版本(WGAN-GP)在稳定性方面通常表现更好。Adam 优化器是常用选择,参数 betas=(0.5,0.999) 被广泛推荐以配合 GAN 训练。如果判别器学习过快,可适当降低 D 的学习率或减少 D 的更新步数;反之亦然。还可使用标签平滑(例如把真实标签从 1.0 改为 0.9)或在判别器输入中加入噪声以提高鲁棒性。

criterion = nn.BCEWithLogitsLoss()

lr = 2e-4

beta1 = 0.5

optimizerD = optim.Adam(netD.parameters(), lr=lr, betas=(beta1, 0.999))

optimizerG = optim.Adam(netG.parameters(), lr=lr, betas=(beta1, 0.999))real_label = 1.0

fake_label = 0.0 训练时按 mini-batch 交替更新判别器与生成器:先用真实图像和生成图像训练判别器(提高其鉴别能力),再更新生成器以尽可能“欺骗”判别器;监控损失与定期保存生成样本用于可视化训练进程,并注意平衡 D 与 G 的训练步数以避免一方过强。

fixed_noise = torch.randn(64, nz, 1, 1, device=device)for epoch in range(num_epochs):for i, real_images in enumerate(dataloader):# (1) 更新判别器netD.zero_grad()real_images = real_images.to(device)b_size = real_images.size(0)label = torch.full((b_size,), real_label, device=device)output_real = netD(real_images)errD_real = criterion(output_real, label)errD_real.backward()noise = torch.randn(b_size, nz, 1, 1, device=device)fake_images = netG(noise)label.fill_(fake_label)output_fake = netD(fake_images.detach())errD_fake = criterion(output_fake, label)errD_fake.backward()optimizerD.step()# (2) 更新生成器netG.zero_grad()label.fill_(real_label) # 期望判别器认为为真output = netD(fake_images)errG = criterion(output, label)errG.backward()optimizerG.step()if i % 100 == 0:print(f"Epoch[{epoch}] Iter[{i}] Loss_D: {(errD_real+errD_fake).item():.4f} Loss_G: {errG.item():.4f}")# 每 epoch 保存可视化样本with torch.no_grad():fake_fixed = netG(fixed_noise).detach().cpu()grid = vutils.make_grid(fake_fixed, normalize=True, scale_each=True)vutils.save_image(grid, f"./outputs/epoch_{epoch:03d}.png")训练完成或在训练中定期保存模型后,从标准正态分布中采样噪声向量(例如 100 维),输入生成器得到图像;通过可视化(保存网格图)与指标(如 FID)或人工评估判断图像质量与多样性,并根据观察调整模型或训练策略。

# 载入训练好的模型权重(可选),生成并保存样本网格

netG.load_state_dict(torch.load("./outputs/netG_final.pth", map_location=device))

netG.eval()

import torch

noise = torch.randn(64, nz, 1, 1, device=device)

with torch.no_grad():samples = netG(noise).cpu()

grid = vutils.make_grid(samples, nrow=8, padding=2, normalize=True)

vutils.save_image(grid, "./outputs/final_samples.png")

print("Saved generated samples to ./outputs/final_samples.png")针对应用场景做图像后处理(色调调整、去噪)、量化压缩模型以适配边缘部署,并使用客观指标(FID/IS)与主观打分结合的方法全面评估模型表现;若要提升时序连贯性或控制属性,可将条件信息(关键点、表情标签、骨架序列)并入模型输入并在判别器中加入时序判别器或一致性损失。

# netG_cpu = netG.to('cpu') # netG_q = torch.quantization.quantize_dynamic(netG_cpu, {torch.nn.ConvTranspose2d, torch.nn.Linear}, dtype=torch.qint8)# torch.save(netG_q.state_dict(), "./outputs/netG_quantized.pth")最后

我是海浪学长,创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!