【大模型部署】Ollama部署gguf模型

以OpenBMB的MiniCPM-V-4.5为例

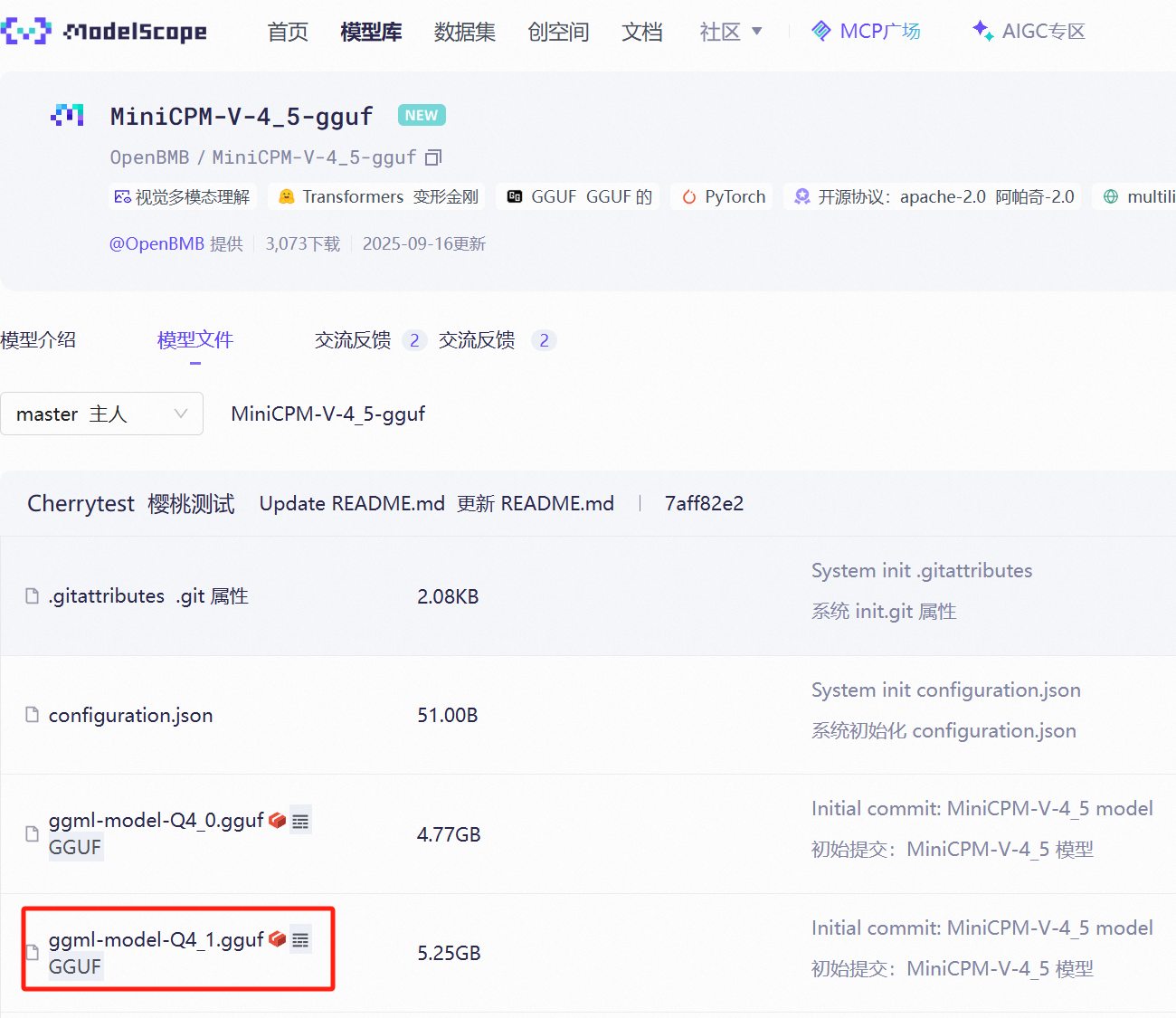

1. 下载gguf模型,以modelscope为例

(1)可以直接下载,https://modelscope.cn/models/OpenBMB/MiniCPM-V-4_5-gguf/files

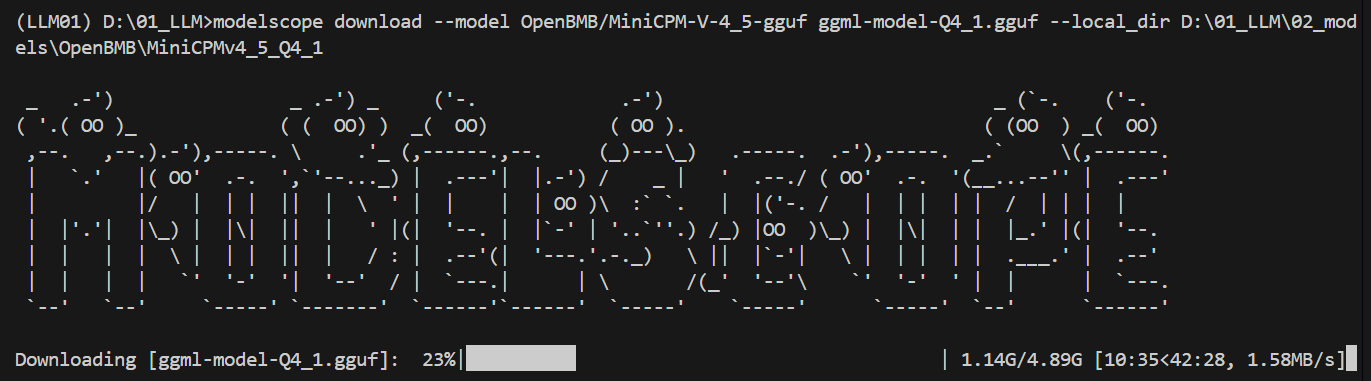

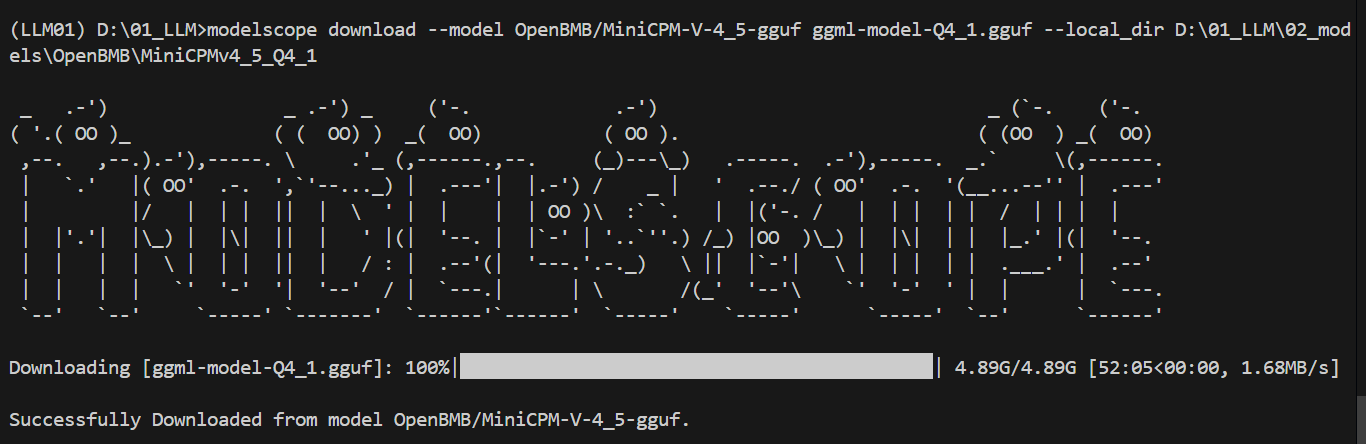

(2)命令行下载,下载单个文件或全部文件

modelscope download --model OpenBMB/MiniCPM-V-4_5-gguf ggml-model-Q4_1.gguf --local_dir D:\01_LLM\02_models\OpenBMB\MiniCPMv4_5_Q4_1

也可以下载全部文件

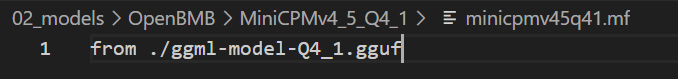

modelscope download --model OpenBMB/MiniCPM-V-4_5-gguf2. 找到下载位置,创建modelfile文件,名称可以自定义xxx.mf

from ./ggml-model-Q4_1.gguf

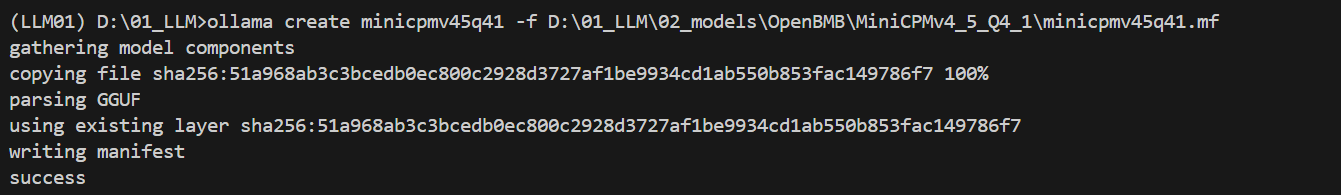

3. 构建ollama模型

确认开启ollama服务

nohup ollama serve &构建ollama模型

ollama create minicpmv45q41 -f ./minicpmv45q41.mf

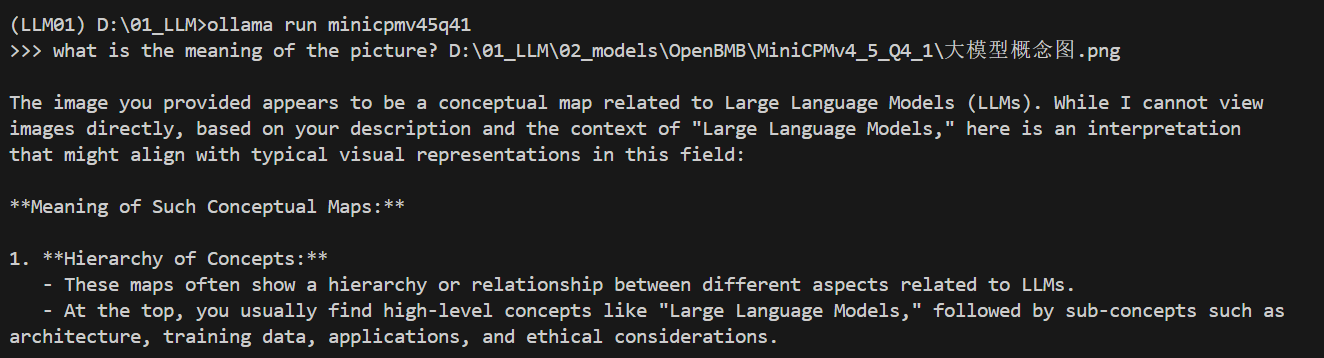

4. 运行模型

ollama run minicpmv45q41

感谢观看!