李宏毅机器学习笔记44

目录

摘要

1.meta learning对比machine learning

2.model-agnos meta-learning(MAML)

摘要

本篇文章继续学习李宏毅老师2025春季机器学习课程,学习内容是meta learning与machine learning的差异,以及meta learning寻找初始参数的方法

1.meta learning对比machine learning

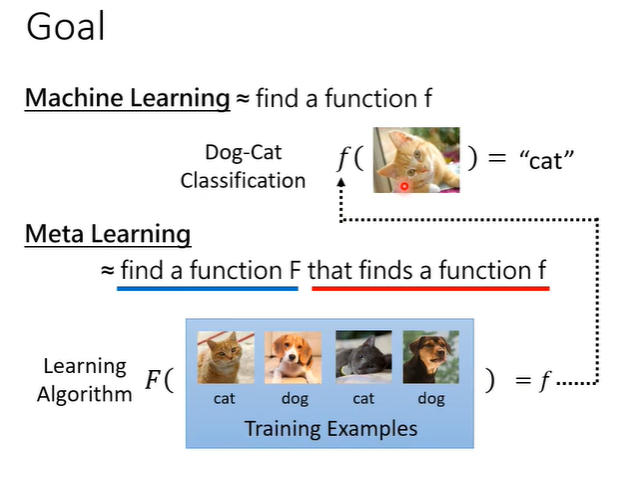

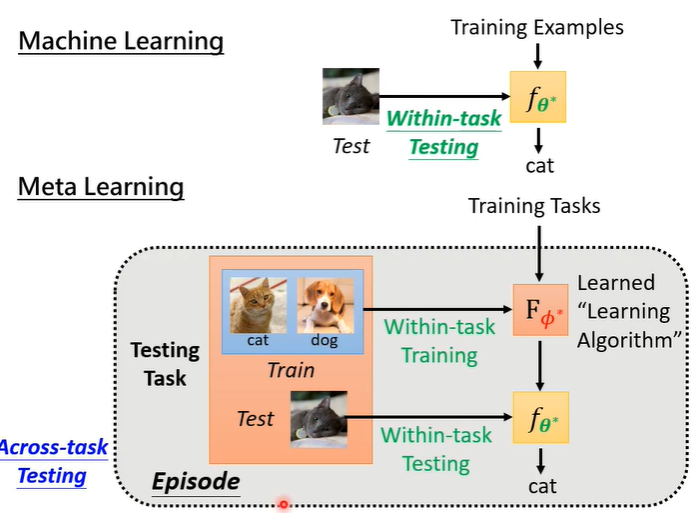

machine learning是找到一个函数f,可能是一个classify,给他一张图片,可以得出分类结果。meta learning同样是找一个函数F,但是这个函数F是一个可以找函数f的函数。它以训练资料作为输入输出为函数f。

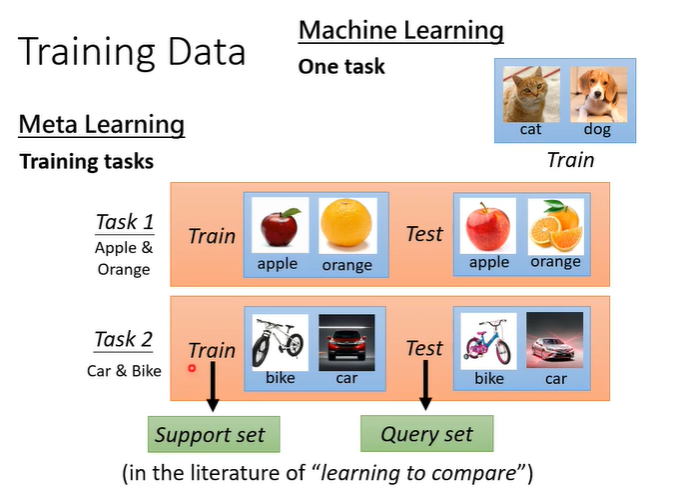

在machine learning中,是以某一个训练资料进行训练,在meta learning中,是以训练任务进行训练,每个训练任务都有训练资料和测试资料。

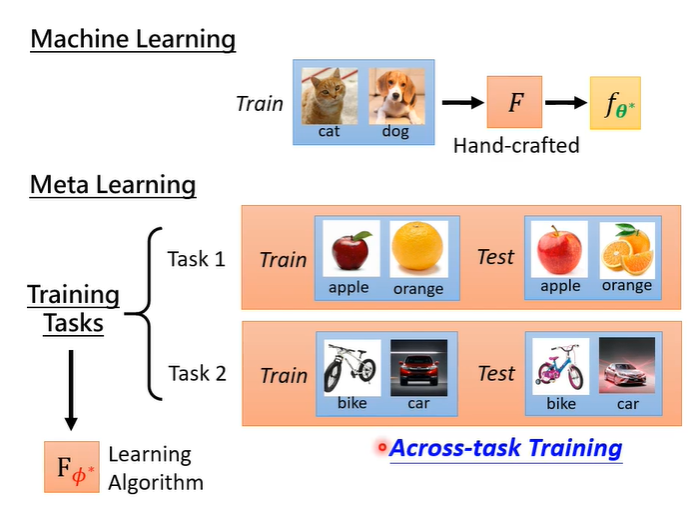

在machine learning中,有一个hand-crafted的learning algorithm,输入训练资料,输出classify,训练称为within-task training。在meta learning中,有一堆训练任务,用这些训练任务找出learning algorithm,meta learning包括一大堆的任务,所以训练也称为across-task training。

下图是machine learning和meta learning的架构图对比

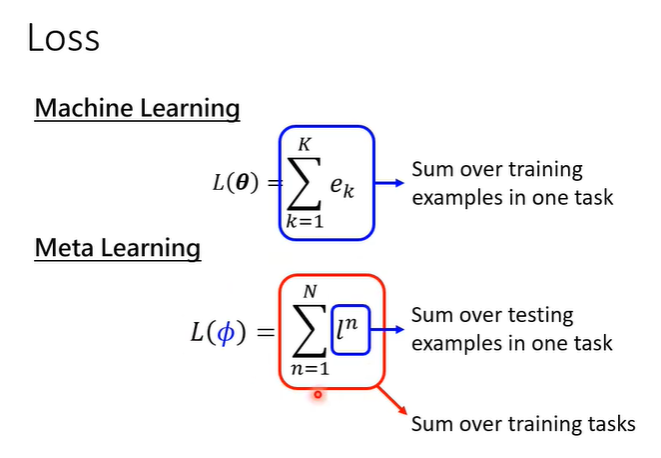

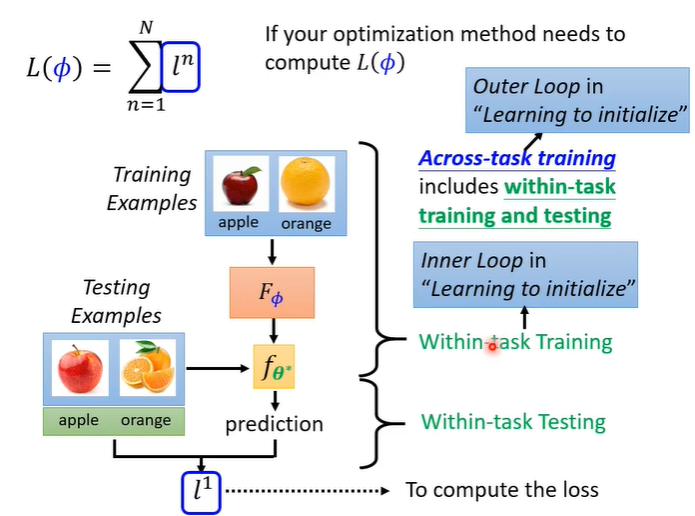

在machine learning中,loss函数的值L是用一个任务的所有测试资料算出来的,在meta learning中,l是某个任务里的所有测试资料算出来的,而loss函数的值L是所有任务的l算出来的。

在meta learning中,计算一次l的计算量往往非常大,算一个l就需要做一次完成的训练再做一次测试才能计算出一个l。假设要找使得

最小,就需要算L很多次,就会使得计算量变得非常大。

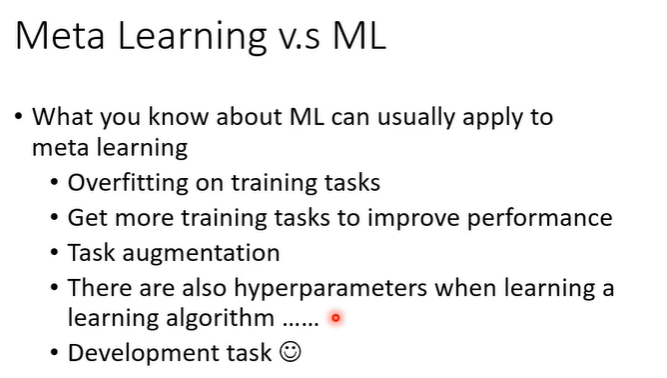

machine learning和meta learning也有许多相似的地方,例如overfitting问题,解决方法(收集更多资料)都是同样适用的。

2.model-agnos meta-learning(MAML)

好的初始化训练参数会让训练更简单,MAML是meta learning中常见的找初始参数的方法。

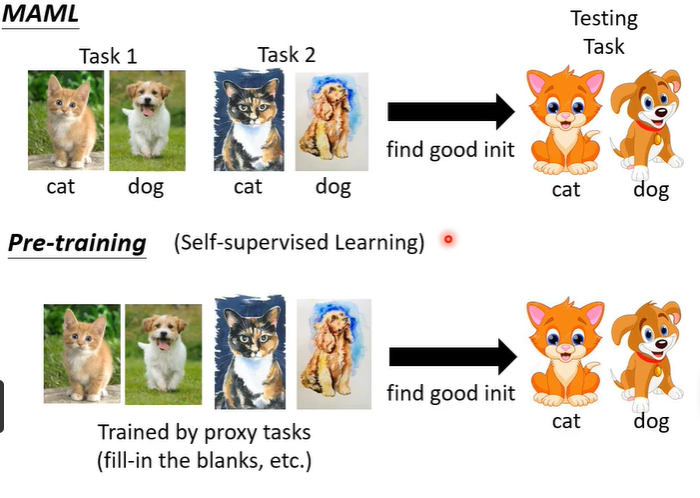

在学习self supervised learning时,是有一堆没有标注的资料,用proxy task去训练。会进行pre-training,结果是好的就用在测试任务上。对meta learning来说,在这些训练任务上找一个好的initialization,在这些任务上都有好的结果,也许就可以transfer到testing的任务上。

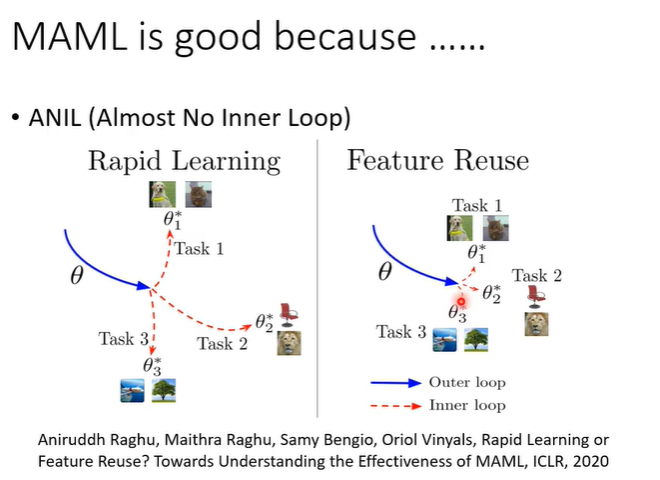

MAML会好的原因,有两种假设,第一个是MAML找到的initial参数是很厉害的参数,可以让learning algorithm快速找到每个任务上的好参数。另一个假设是MAML找到的initial参数本来就跟每个任务上最终好的结果非常接近。