【机器学习算法】面试中的ROC和AUC

🧔 这里是九年义务漏网鲨鱼,研究生在读,主要研究方向是人脸伪造检测,长期致力于研究多模态大模型技术;国家奖学金获得者,国家级大创项目一项,发明专利一篇,多篇论文在投,蓝桥杯国家级奖项、妈妈杯一等奖。

✍ 博客主要内容为大模型技术的学习以及相关面经,本人已得到B站、百度、唯品会等多段多模态大模型的实习offer,为了能够紧跟前沿知识,决定写一个“从零学习 RL”主题的专栏。这个专栏将记录我个人的主观学习过程,因此会存在错误,若有出错,欢迎大家在评论区帮助我指出。除此之外,博客内容也会分享一些我在本科期间的一些知识以及项目经验。

🌎 Github仓库地址:Baby Awesome Reinforcement Learning for LLMs and Agentic AI

📩 有兴趣合作的研究者可以联系我:yirongzzz@163.com

📈 深入理解 ROC 与 AUC

文章目录

- 📈 深入理解 ROC 与 AUC

- 🧠 一、为什么要学 ROC 和 AUC?

- 🧩 二、前置知识:TPR 与 FPR

- 🎯 三、ROC 曲线的几何含义

- (1) ROC 是什么?

- 📊 ROC 坐标意义

- 🧮 四、AUC:ROC 曲线下的面积

- 1️⃣ **排序概率意义**

- 2️⃣ **能量分布意义**

- 3️⃣ **ROC 曲线的几何物理意义**

- 🧩 五、AUC 与 Accuracy 的区别

- 💻 六、代码实现:从零计算 ROC 与 AUC

- 📊 七、ROC 曲线可视化

- 📘 八、科研与工程视角下的AUC

- 🎓 九、总结回顾

🧠 一、为什么要学 ROC 和 AUC?

很多初学者在看论文或面试时都会遇到这些问题:

“你模型的 AUC 是多少?”

“AUC 为什么比 accuracy 更能反映模型性能?”

“ROC 曲线的意义是什么?”

这些问题听起来简单,但如果回答得不够系统,很容易暴露出你对模型评估的理解层次。在面试过程中,不仅仅会让你手撕AUC,还会问你AUC和ROC的物理意义,表示什么。在平常的学习中,我们只知道越高越好,但是不了解更深层的实际意义。

因此,本文就从基础到进阶,把 ROC 和 AUC 讲透,做到:

-

理论 + 直觉 + 几何 + 代码 实现;

-

附加:面试常见问题及答法;

-

深度理解:AUC 其实是“排序能力”的度量。

🧩 二、前置知识:TPR 与 FPR

在二分类任务中,我们通常得到如下混淆矩阵(Confusion Matrix):

| 实际值\预测值 | Positive | Negative |

|---|---|---|

| Positive | TP | FN |

| Negative | FP | TN |

由此定义:

TPR=TPTP+FN,FPR=FPFP+TN\text{TPR} = \frac{TP}{TP + FN}, \text{FPR} = \frac{FP}{FP + TN}TPR=TP+FNTP,FPR=FP+TNFP

其中:

-

TPR (True Positive Rate):正样本被识别正确的比例

-

FPR (False Positive Rate):负样本被误识别为正的比例

💬 面试常问:

Q:FPR 高代表什么?

A:模型误判负样本的比例高,意味着模型更“激进”,容易将负样本判成正样本。

🎯 三、ROC 曲线的几何含义

(1) ROC 是什么?

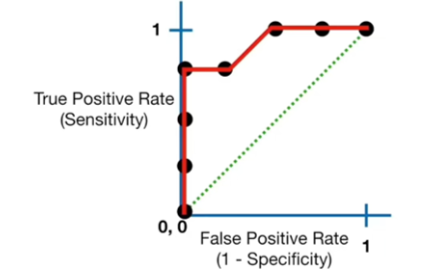

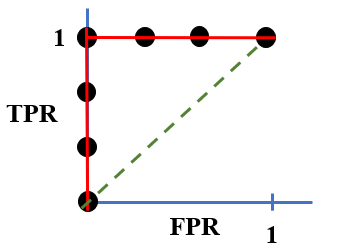

ROC(Receiver Operating Characteristic)曲线是以横轴:FPR, 纵轴:TPR 为坐标绘制出的二维曲线。

每一个点代表模型在某个分类阈值 τ\tauτ 下的表现。

在实际中,分类模型(如 logistic regression, CNN, Transformer classifier)通常输出一个概率值:

p=sigmoid(z)p = \text{sigmoid}(z)p=sigmoid(z)

当我们改变判定阈值 τ\tauτ(如 0.3、0.5、0.8),TPR 和 FPR 都会随之变化,于是得到 ROC 曲线。

📊 ROC 坐标意义

-

X轴(FPR):负样本被误判为正的比例(越小越好)

-

Y轴(TPR):正样本被正确识别的比例(越大越好)

极端情况解释:

| 线段 | 含义 |

|---|---|

y = 1 | 正样本全判对 |

x = 0 | 负样本全判对 |

y = x | 完全随机分类器(无判别力) |

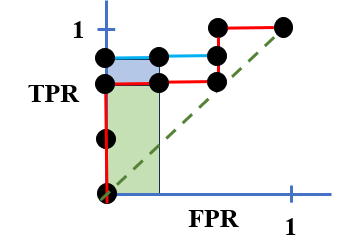

如下图示意:

💡 面试常问:

Q:ROC 曲线离对角线越远代表什么?

A:模型判别能力越强;如果 ROC 低于对角线,说明模型方向反了(预测反向更优)。

🧮 四、AUC:ROC 曲线下的面积

AUC(Area Under Curve)是 ROC 曲线与横轴围成的面积。

其定义为:

AUC=∫01TPR(FPR)d(FPR)AUC = \int_0^1 TPR(FPR) \, d(FPR)AUC=∫01TPR(FPR)d(FPR)

直观地,它代表了:

当我们从模型中随机选取一个正样本和一个负样本时,

正样本得分高于负样本的概率。

AUC 不仅仅是一个“面积”,它其实有非常直观的物理含义,可以从三个层面理解:

1️⃣ 排序概率意义

AUC 表示:

随机抽取一个正样本和一个负样本,模型给正样本打的分高于负样本的概率。

即:

AUC=P(scorepositive>scorenegative)AUC = P(\text{score}_{positive} > \text{score}_{negative})AUC=P(scorepositive>scorenegative)

-

当 AUC = 0.5 → 模型与随机猜测一样;

-

当 AUC = 1.0 → 模型能完美区分正负样本;

-

当 AUC < 0.5 → 模型在“反着预测”(负样本分数更高)。

2️⃣ 能量分布意义

可以把模型的输出看作一个“能量”或“信号强度”。

AUC 衡量的就是模型在 能量空间上将两类样本“拉开”的能力。

-

当两类分布几乎重叠 → AUC ≈ 0.5

-

当正负分布分离 → AUC → 1

这意味着:AUC 越高,模型的 latent space (潜空间)在区分正负样本上越有能量间隔(margin)。

这也是许多论文用 “Energy-based separation” 或 “Score margin” 来解释 AUC 的原因。

AUC可以描述的是随机抽取一个正样本和负样本,正样本得分大于负样本得分的概率:

AUC=P(正样本得分>负样本得分)AUC=P(正样本得分>负样本得分) AUC=P(正样本得分>负样本得分)

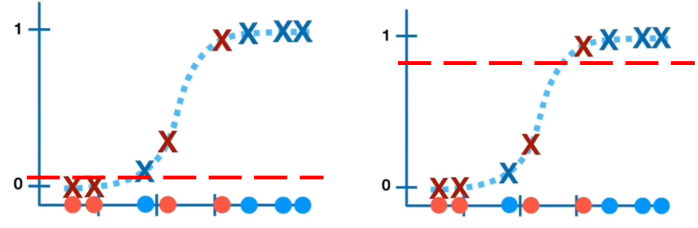

因为AUC在计算的过程中也间接计算了正负样本的排序,当出现错误顺序(误判负样本为正样本时),AUC的累积值减少,如图所示,模型而(蓝色线)的AUC累积值要大于模型一(红色线),这是由于在阈值降低的过程中,出现错误顺序的阈值更低。同时,FPR的增加,可以与坐标轴围成矩形区域,该面积可以表示为样本中得分比当前负样本得分高的所有正负样本对。

3️⃣ ROC 曲线的几何物理意义

ROC 曲线从几何角度来看:

-

横坐标 FPR 增长表示“误报代价”;

-

纵坐标 TPR 增长表示“检测收益”。

AUC 实际上是:

在单位误报成本下,模型能提供的平均检测收益。

因此,在不同任务中(如伪造检测、医学诊断、异常检测),AUC 可以视为模型在整体阈值变化下的全局性能平均值,不依赖具体阈值。

🧩 五、AUC 与 Accuracy 的区别

| 指标 | 含义 | 是否依赖阈值 | 优缺点 |

|---|---|---|---|

| Accuracy | 分类正确率 | ✅ 是 | 易解释但不鲁棒 |

| ROC-AUC | 模型排序能力 | ❌ 否 | 鲁棒,对类不平衡敏感度低 |

💬 面试题实战:

Q:为什么在正负样本不平衡任务中更推荐 AUC?

A:因为 Accuracy 容易被多数类“掩盖”,而 AUC 评估模型整体排序能力,不受比例影响。

💻 六、代码实现:从零计算 ROC 与 AUC

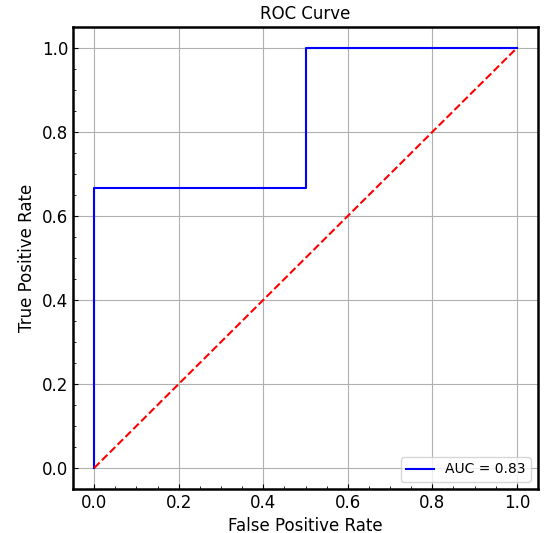

下面代码演示如何从原始输出中手动计算 ROC 曲线与 AUC 值。

def calculate_roc_acc(y, y_prop):y = np.array(y)y_prop = np.array(y_prop)sorted_indexs = np.argsort(-y_prop) # 默认从小到大将索引排序,所以从大到小需要负号y = y[sorted_indexs]y_prop = y_prop[sorted_indexs]posNum = sum(y)negNum = len(y) - posNum# 记录不同阈值下的TPR和FPRTPRS = [0]FPRS = [0]# 阈值初始化thresholds = y_prop[np.argsort(-y_prop)]for threshold in thresholds:TP = np.sum((y_prop >= threshold) & (y == 1)) # 预测为正且实际为正FP = np.sum((y_prop >= threshold) & (y == 0)) # 预测为正但实际为负TPRS.append(TP / posNum)FPRS.append(FP / negNum)AUC = 0for i in range(1, len(FPRS)):AUC += (FPRS[i] - FPRS[i - 1]) * (TPRS[i] + TPRS[i - 1]) / 2return FPRS, TPRS, AUC

📊 七、ROC 曲线可视化

def plot_roc_curve(FPR, TPR, auc):plt.rcParams["axes.linewidth"] = 1.8plt.rcParams["axes.labelsize"] = 12plt.rcParams["xtick.minor.visible"] = Trueplt.rcParams["ytick.minor.visible"] = Trueplt.rcParams["xtick.direction"] = "in"plt.rcParams["ytick.direction"] = "in"plt.rcParams["xtick.labelsize"] = 12plt.rcParams["ytick.labelsize"] = 12plt.rcParams["xtick.top"] = Falseplt.rcParams["ytick.right"] = False# plt.rcParams['font.sans-serif'] = ['SimHei']plt.figure(figsize=(6, 6))plt.plot(FPR, TPR, label=f"AUC = {auc:.2f}", color='blue')plt.plot([0, 1], [0, 1], 'r--')plt.title("ROC Curve")plt.xlabel("False Positive Rate")plt.ylabel("True Positive Rate")plt.legend(loc="lower right")plt.grid()plt.show()

📘 八、科研与工程视角下的AUC

-

科研视角(CVPR / ICML常见)

-

AUC 是衡量模型泛化能力与排序能力的标准;

-

在检测、伪造识别、医疗影像任务中非常常见;

-

AUC 提高不代表模型 calibration 更好,仅说明排序更优。

-

-

工程视角

-

实际部署中通常会配合 Precision-Recall 曲线使用;

-

ROC 对极度不平衡任务(如 fraud detection)有时不敏感,此时 PR-AUC 更合理。

-

💬 面试深问:

Q:ROC-AUC 高但模型 precision 很低,说明什么?

A:模型整体排序能力强,但阈值选取不佳或分布偏移,需要 calibration 或重新调阈。

🎓 九、总结回顾

| 维度 | 说明 |

|---|---|

| ROC | 展示模型在不同阈值下的性能曲线 |

| AUC | ROC 曲线下的面积,表示模型排序能力 |

| 数学本质 | 积分 or Rank 概率 |

| 工程意义 | 不依赖阈值、对不平衡鲁棒 |

| 面试建议 | 一定要能解释 AUC = P(正样本得分 > 负样本得分) 这一点 |

🎤 一句话总结

“AUC 衡量的是模型有没有把‘猫’排在‘狗’前面,而不是在某个阈值上有没有分类对。”