【论文阅读】Debating with More Persuasive LLMs Leads to More Truthful Answers

论文题目:Debating with More Persuasive LLMs Leads to More Truthful Answers

来源:ICML 2024

话题:大语言模型;辩论机制设计

作者:

![]()

论文链接:https://dl.acm.org/doi/abs/10.5555/3692070.3693020

摘要

常见的大语言模型(LLM)对齐方法严重依赖人工标注数据。然而,随着模型日益强大,它们将超越人类专业水平,人类评估者的角色也将随之转变为“非专家监督专家”。为提前应对这一局面,我们提出如下问题:较弱的模型能否评估较强模型的正确性?我们在一个类比场景中研究该问题:较强的模型(专家)拥有回答问题所需的全部信息,而较弱的模型(非专家)虽具备同等基础能力,却缺乏关键信息。我们评估的方法是对抗式辩论——由两位LLM专家分别支持不同答案,并由一位非专家担任裁判选出胜方。在QuALITY阅读理解任务上,辩论持续帮助非专家模型和人类提高答题准确率,分别达到76%与88%(朴素baseline为48%与60%)。进一步发现,仅以无监督方式优化辩手的说服力,就能提升非专家在辩论中识别真相的能力。我们的结果首次提供了鼓舞人心的实证证据:即便没有真实标签,辩论机制仍可被用于模型对齐,并随模型能力提升而保持可扩展性。

一、引言

主流的大语言模型(LLM)对齐方法几乎无一例外地依赖人工标注数据(Ouyang et al., 2022; Menick et al., 2022)。然而,当模型能够回答的语境越来越宽广、问题越来越专业时,获取可靠标注就必须依靠领域专家(OpenAI, 2023; Gemini Team et al., 2023)。继续向前,模型将在诸多维度上超越专家,ground truth不再可得,传统对齐范式随之失效。因此,我们需要“可扩展监督”(scalable oversight)——能够随模型能力同步扩展的对齐机制(Amodei et al., 2016; Christiano et al., 2018; Irving et al., 2018; Bowman et al., 2022)。

一条颇具前景的路线是用“弱”模型监督“强”模型(Cotra, 2021; Bowman et al., 2022; Burns et al., 2023)。这些方法共同默认“指出或批判正确答案比生成正确答案更容易”(Goodfellow et al., 2014; Bai et al., 2022; Saunders et al., 2022)。若一次批判不足以判断,可对批判再批判——沿此思路,Irving et al. (2018)提出用“辩论”对齐超人类AI:让两位专家各自捍卫相反答案,人类或弱模型通过观察对抗性论证,更易发现真相。

本文在阅读理解任务上验证这一设想。我们构建“信息非对称”环境:辩手可访问全文,裁判(弱模型或人类)只能看到论证文本,从而模拟“强-弱”监管关系。实验发现:

- 弱裁判确能监督强辩手。最具说服力的配置下,非专家人类裁判借助辩论可达88%准确率,非专家LLM裁判达76%,显著高于朴素基线(60%与48%)。

- 优化辩手“说服力”可提升裁判识别真相的能力。通过best-of-N与“批判-精化”等无监督方法,辩手越能说服裁判,辩论越倾向于揭示正确答案;相反,在单模型咨询(consultancy)设置下,说服力提升反而降低裁判准确率。

- 人类裁判校准度更高,且在辩论中误差更低。基于置信度的拒绝推断显示,辩论在所有覆盖率下均优于咨询,且人类置信度校准更好。

尽管“信息更强”只是未来强-弱差距的一种形式,但本文首次在真实任务上实证表明:辩论可作为可扩展监督手段,并随模型能力提升而持续有效。

二、方法

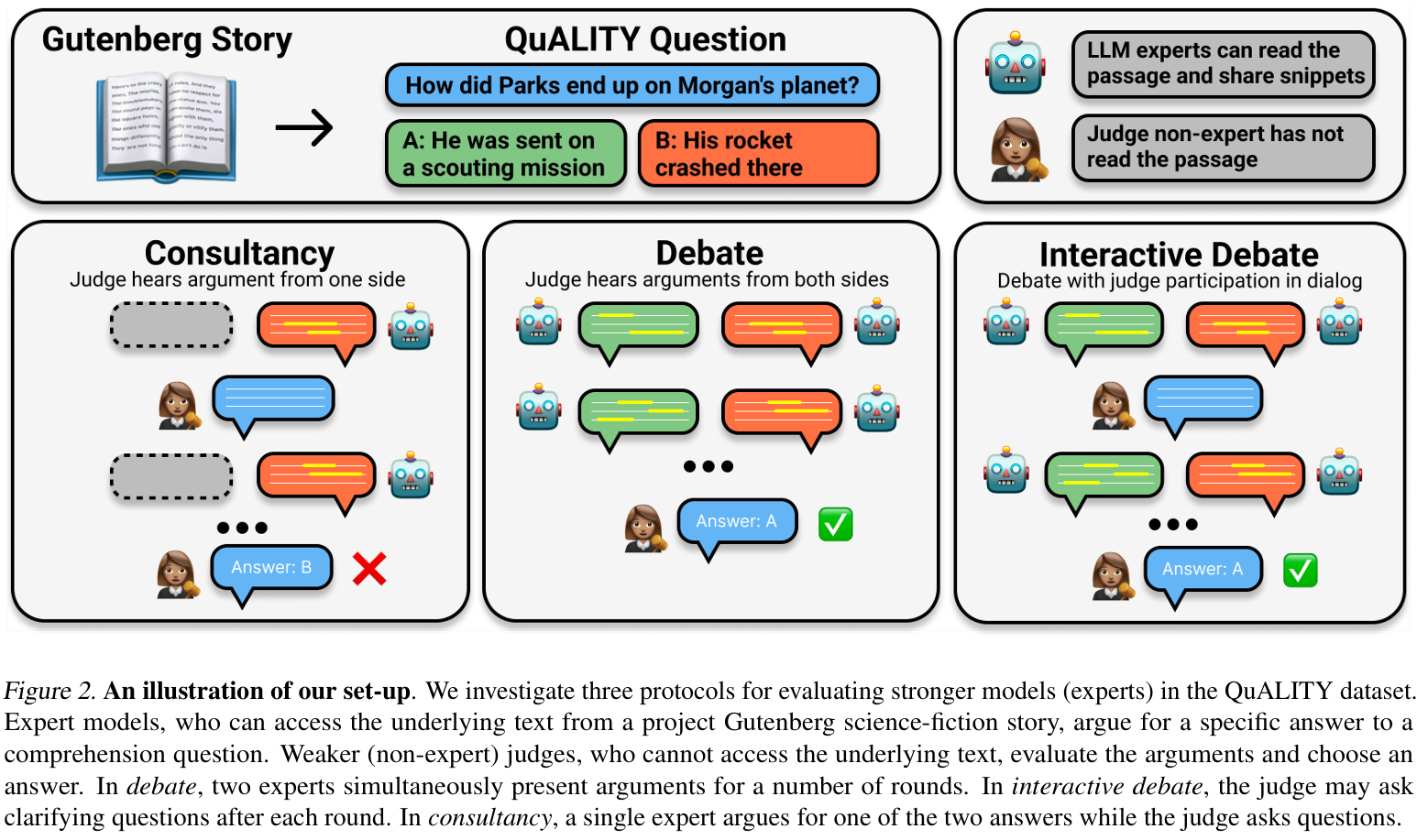

我们关注那些能让非专家从专家那里获取真相的协议。在此,我们阐述所研究的协议以及评估它们的任务设置,如图2所示。此外,我们定义了不依赖标签的新指标来评估辩手的强度。

图2

在图2中:

- 有专家/辩手能读完整篇Project Gutenberg科幻故事;裁判(Judge)完全看不到原文。

- Consultancy(咨询):一个专家vs一个裁判,一问一答。

- Debate(辩论):两个专家互相对抗,各捍卫相反答案,裁判只读记录。

- Interactive Debate(互动辩论):在辩论每轮结束后,裁判可以插话提问,专家必须回应。

- 只能依据专家在对话里给出的、经过quote工具实时校验的“可验证引用”——绿色高亮表示与原文完全匹配,黄色表示未匹配或伪造。

2.1 协议

Debate——我们首先介绍辩论,这是一种两个专家模型(辩手)为问题的相反答案进行辩论的协议。辩论进行预先设定的N轮,期间记录辩手的论证记录。在每一轮中,辩手可以看到之前几轮的论证,并同时生成下一轮的论证。N轮结束后,裁判阅读记录并尝试选择正确答案。每个辩手都试图说服裁判选择他们的答案,而裁判的任务是选择正确答案。该协议的对抗性源于辩手之间的激励冲突,因为每个辩手都会战略性地提出论证来解释为什么对手的说法是错误的。在一轮开始时,辩手会收到几乎相同的提示,解释游戏规则、他们所分配的答案以及当前的记录。

Interactive debate——与辩论类似,互动辩论也使用两位专家为相反答案进行辩论。除了以上的机制外,在每一轮结束后,裁判可以发表陈述。这使裁判能够突出子问题、要求澄清以及向任一辩手提出问题。该陈述会被附加到记录中,并在接下来的所有轮次中对所有玩家可见。

Consultancy (Baseline)——为了与辩论进行比较,我们使用Michael等人(2023)建立的Consultancy基线。在Consultancy中,一个专家模型(Consultant)被分配一个特定答案,并旨在说服裁判他们的答案是正确的。裁判旨在通过询问Consultant探究性问题来引出正确答案。Consultancy进行预先设定的N轮(与辩论相同),在此期间Consultant和裁判依次发表声明。在Consultancy结束时,裁判决定选择哪个答案。在每一轮开始时,Consultant会收到一份提示,其中包含游戏规则、他们所分配的答案以及当前记录。在我们的所有评估中,我们对正确答案和错误答案都运行Consultancy;从而产生与辩论相同的50/50先验。

2.2 实验细节

为了将监督问题具体化,我们进行了信息非对称实验(Michael等人,2023),其中非专家无法获得回答问题所需的信息,但专家可以。

任务——我们评估非专家裁判回答“Question Answering with Long Input Texts, Yes!”(QuALITY;Pang等人,2022)阅读理解数据集中问题的能力。不允许裁判访问原始理解文本,这限制了他们回答问题的能力,并使他们处于非专家地位。我们在附录C中阐述了此设置的动机并提供了实施建议。我们使用Gutenberg计划科幻故事子集中的文本,这些文本的中位长度约为7000个标记。从这些故事中,我们选择HARD子集,其中所有无时间限制的注释者都选择了正确答案,并将答案评为明确无误。对于每个问题,我们提供两个答案:正确答案和最佳干扰项。我们为LLM裁判实验使用两个数据分割:(400个训练集问题)和

(291个开发集问题)。对于人类实验,由于一个故事只能出现一次,我们使用

(153个问题,来自两个集合)和

(47个问题,来自两个集合)。有关问题过滤详细信息,请参见附录D.1。

引用验证工具——在每个协议中,专家模型都可以访问报价工具,从<quote>标签中的文本中提供报价。与Radhakrishnan(2023)类似,如果引用直接匹配文本的一部分,则该工具生成已验证的<v_quote>,否则,它生成未验证的<u_quote>标签(参见附录D.2)。法官被指示只相信经过验证的报价(见附录D.8)。

轮数和字数限制——我们进行3轮的协议。关于轮数的分析,请参见附录A.8。为了控制跨协议向裁判呈现的信息量,并减轻LLM裁判的冗长偏见,我们将记录总字数限制为900字,每位Consultant每轮论证的字数限制为300字,每位辩手每轮论证的字数限制为150字(参见附录D.6)。

语言模型——我们评估了四个大型语言模型作为辩手和Consultant:GPT-4-Turbo、GPT-3.5-Turbo、Claude 2.1和Claude 1.3。GPT模型通过来自人类反馈的强化学习进行微调(Ouyang等人, 2022),Claude模型通过Constitutional AI进行微调(Bai等人,2022)。辩手呈现的是一种以自我为中心的观点,他们的论点首先出现。我们为所有模型提供了一个scratchpad(刮板,Wei等人,2022;Nye等人,2022),这允许模型输出一组包含在<thinking>标签中的令牌,其他玩家不会看到(见附录G.1)。

为了为我们的LLM裁判实验生成大量不同的辩手能力水平,我们使用best-of-N(boN)采样进行推理时优化。使用boN,模型被采样N次,然后使用偏好模型选择最具说服力的论证。我们向偏好模型提供提示,以优化裁判反馈。对于一部分模型,我们还使用了批判和精化(cN)(Saunders等人,2022),其中另一个模型用于生成N个批判;然后偏好模型对这些批判进行评分,并使用最有帮助的批判来精化答案。对于所有偏好模型,我们使用GPT-4-Turbo的对数概率。我们在附录D.3中记录了提示迭代,在附录A.9中记录了使用示例的学习。

对于LLM裁判,我们使用了GPT-4-Turbo、GPT-3.5-Turbo和Claude 2.1。提示在附录G.2中提供。与Zheng等人(2023)类似,我们发现LLM裁判存在强烈的偏见。为了减轻位置偏见,我们对每场辩论进行两次判断:一次使用原始记录,一次交换辩手顺序。为了减轻冗长偏见,我们应用严格的字数限制。我们在附录A.7中记录了裁判偏见,并在附录D.6中记录了减轻技术。

交叉比赛锦标赛——为了研究辩论如何随模型能力扩展,我们需要一种比较辩手的方法。我们进行交叉比赛辩论,其中不同的辩手相互辩论。为了比较大量的辩手,我们使用锦标赛来生成信息丰富的比赛。对于n个辩手,运行所有可能的比赛是不可行的,因为这需要O(n²)场比赛。相反,我们使用瑞士制比赛来决定比赛,这可以在O(n log n)场比赛中产生排名(参见附录D.4)。

人类裁判——我们通过基于推荐的注释平台Pareto招募了30名人类裁判。注释者通过网页界面判断辩论,在界面中向他们展示问题、答案和辩论记录。这30名注释者经过培训阶段,并根据测试阶段的表现筛选到21名。为了避免基于ground truth标签进行任何优化(Perez等人,2021),我们根据注释者之间的一致性和他们提供的解释质量来筛选注释者(参见附录E.2)。

额外的上限和下限——我们引入了一个朴素的裁判和一个专家裁判来评估最差和最佳情况的表现。对于朴素裁判,我们只向非专家模型展示问题和可能的答案;这有助于识别数据集中是否存在非专家训练中的污染。对于专家裁判,我们向专家裁判展示完整的文本,以展示非专家裁判可以期望达到的合理上限。对于人类实验,我们没有运行专家裁判基线,而是使用Pang等人(2022),他们报告了在HARD子集上,可以访问文本的注释者达到了89%的准确率。我们筛选了100%无时间限制的准确率,因此期望89%是专家人类表现的下限。

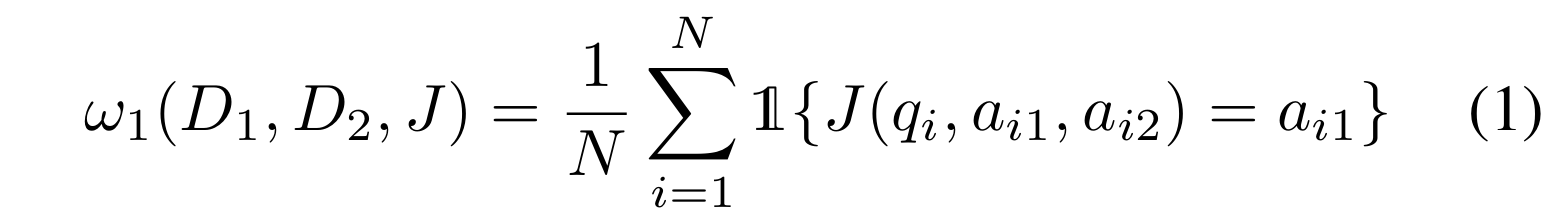

2.3 测量辩手和裁判的表现

我们对没有标签访问权限的监督协议感兴趣,但现有工作使用假设可以访问ground truth的指标。在本节中,我们介绍了不依赖此假设来测量辩手能力的指标。给定一个包含N个问题(q)和候选答案的数据集D,

,辩论比赛由

定义,包括两个模型

和

,以及一个裁判J 。第一个参数指的是哪个模型被分配

来支持(在这种情况下是

),第二个参数指的是哪个模型被分配

。与Consultant D的咨询比赛表示为(D, -, J) 或(-, D, J) 。

胜率(Win rate)——我们将胜率定义为一个裁判选择特定辩手答案的频率。对于比赛,辩手

的胜率

由下式给出:

实际上,这个胜率取决于答案选择的分配,这不公平地有利,因为某些分配可能更容易辩论(例如,有些答案比其他答案更容易辩护)。为了减轻这种情况,我们翻转分配,使 和

为相反的分配辩护,然后取平均值

。假设辩手在所有问题上的表现同样出色,我们说如果

![]()

则比

更有说服力。

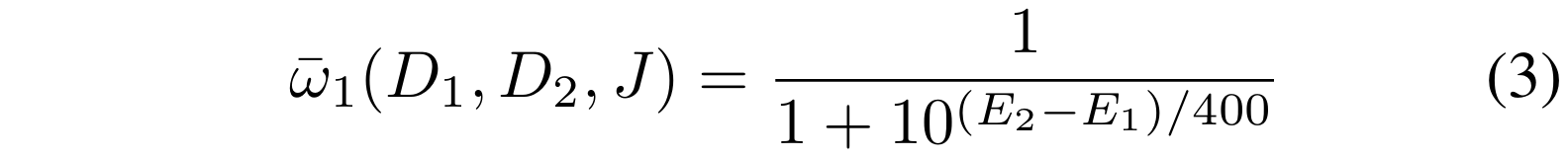

Elo评分(Elo rating)——为了捕捉说服力的普遍概念,我们评估每个辩手在一组共同辩手中的总体胜率。我们通过潜在技能参数化胜率,使用Elo排名指标(Elo, 1978)。我们通过最小化预测胜率与观察胜率之间的误差来计算评分(参见附录D.5)。总体评分被定义为辩手独立于分配的潜在技能。给定两个辩手和

,以及一个裁判J ,我们将每个玩家的总体评分

和

定义为以下等式的解:

胜率和总体评分是无监督指标,可用于在没有ground truth标签的情况下优化监督协议。

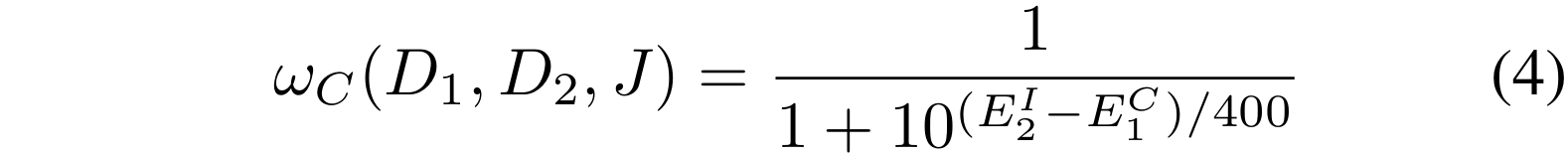

为了理解辩论中的真实性,我们还考虑了被分配所有正确答案(假设有ground truth标签)时的胜率。我们计算玩家的正确评分

和错误评分

如下:

裁判准确率(Judge accuracy)——根据辩论的最初动机,我们计算裁判准确率α,作为在同一模型副本之间比赛的准确率; 。由于裁判不知道Consultant的意图,我们计算咨询的两种潜在比赛的准确率

![]()

三、语言模型裁判的实验结果

洞见1:辩论帮助LLM裁判回答难题,效果优于咨询。我们在辩手上进行超参数与提示优化,以胜率作为优化目标(见附录D.7)。在测试集(、

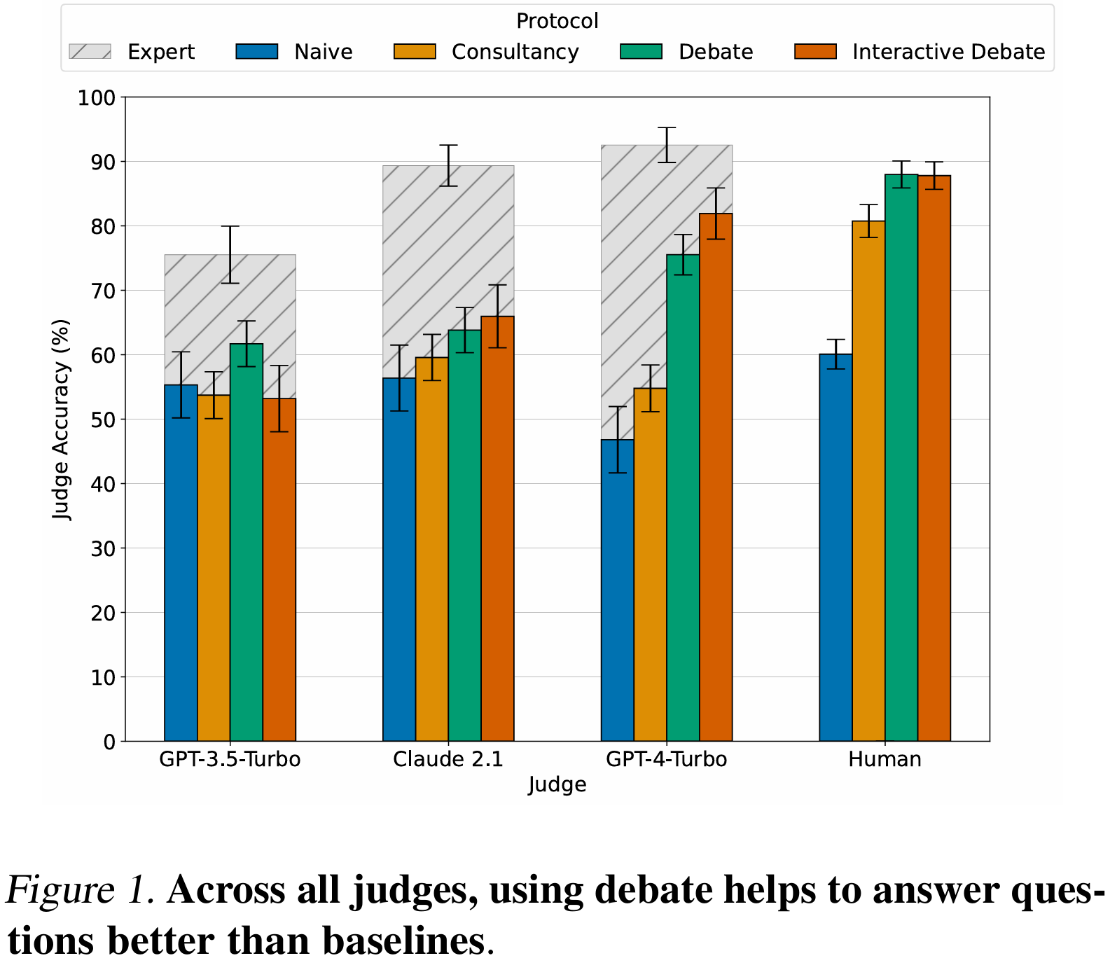

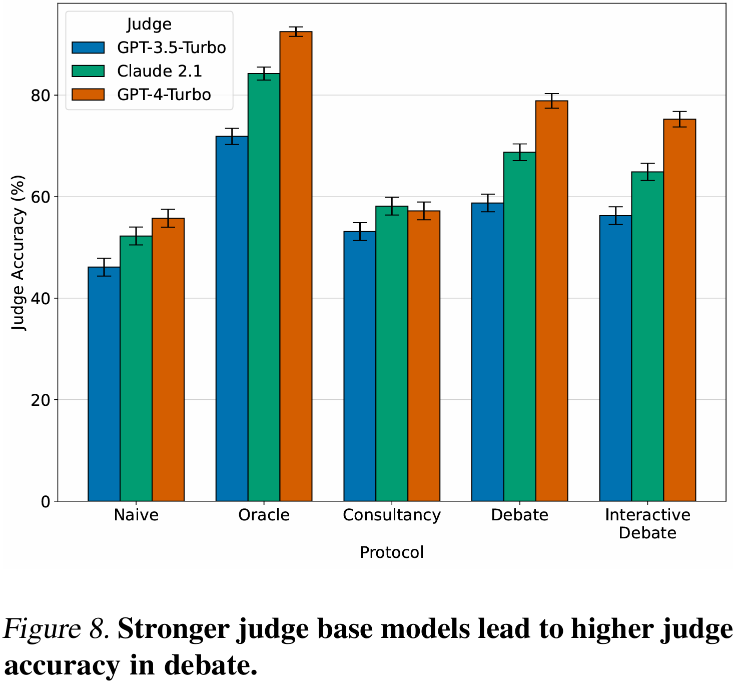

)上评估各协议,GPT-4-Turbo与best-of-16采样同时用于辩手与Consultant。图1与图8显示,所有协议均使非专家答题表现优于朴素裁判基线;辩论持续优于咨询,且随着裁判能力增强,与专家裁判的差距缩小(75.6% vs 92.5%)。附录H给出示例记录。

图1和图8

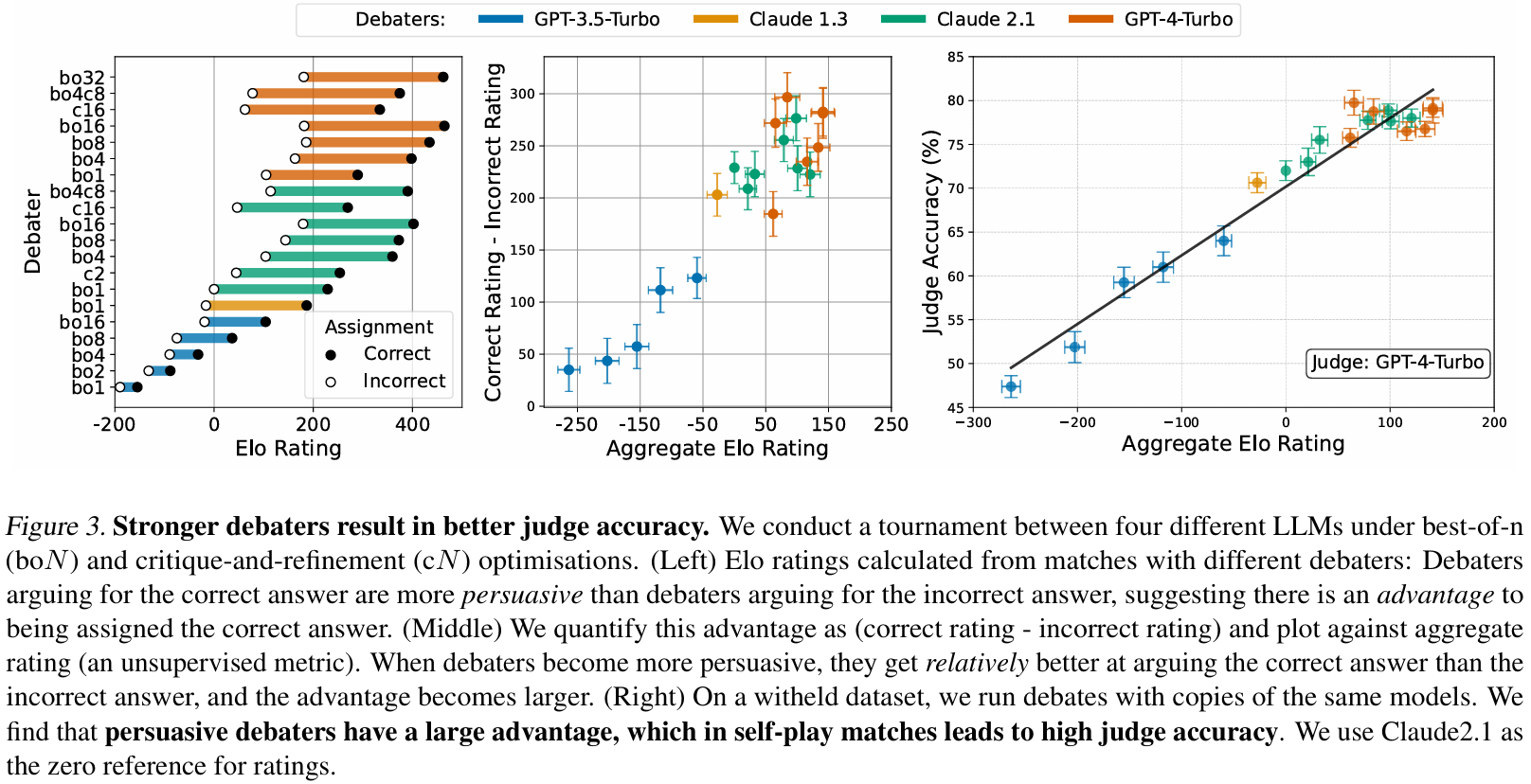

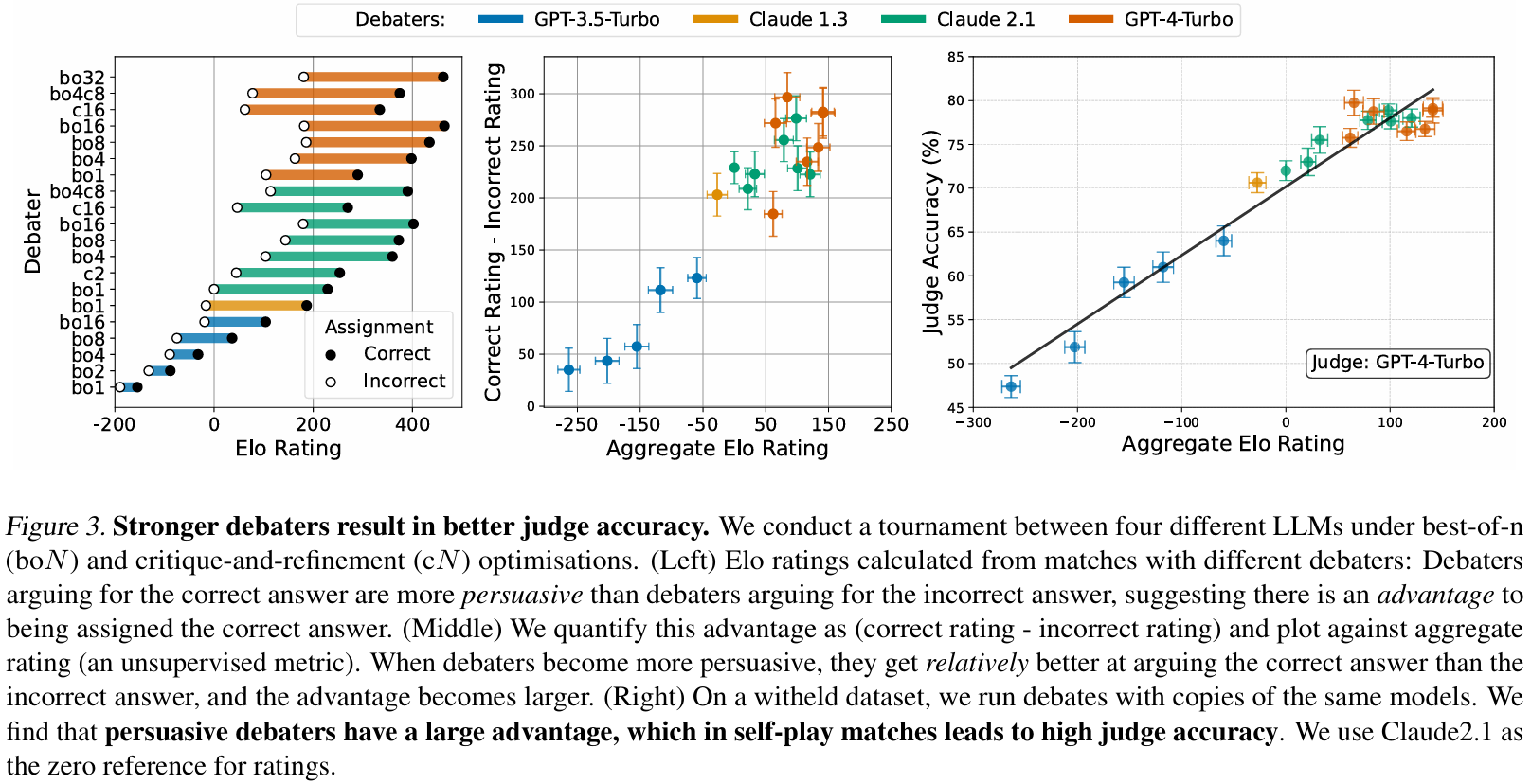

洞见2:被分配正确答案的辩手具有先天优势,且该优势随说服力增强而放大。交叉锦标赛中,20名不同辩手各与不同对手比赛4场(无自对弈),共产生80份胜率用于计算Elo。图3-left/middle显示,同一模型被分配正确答案时更具说服力(Elo更高),且聚合Elo越高,正确-错误Elo差越大,表明在QuALITY辩论中“说真话”确实更容易。该趋势在不同裁判身上一致(图5)。基础模型本身是最强说服力指标,GPT-4-Turbo表现最佳;critique-and-refinement说服力低于best-of-N,说明生成有用批判比挑选好样本更难。

洞见3:辩手聚合Elo越高,裁判准确率越高。用锦标赛排名,让同一模型副本自对弈,GPT-4-Turbo裁判给出准确率。图3-right显示聚合Elo与裁判准确率强相关:以无监督胜率(裁判偏好)为优化目标,反而提升裁判判断真相的能力。这为“最优辩论可揭示真相”提供了弱证据(Irving et al., 2018),并暗示更强辩手可让非专家获得更高准确率。

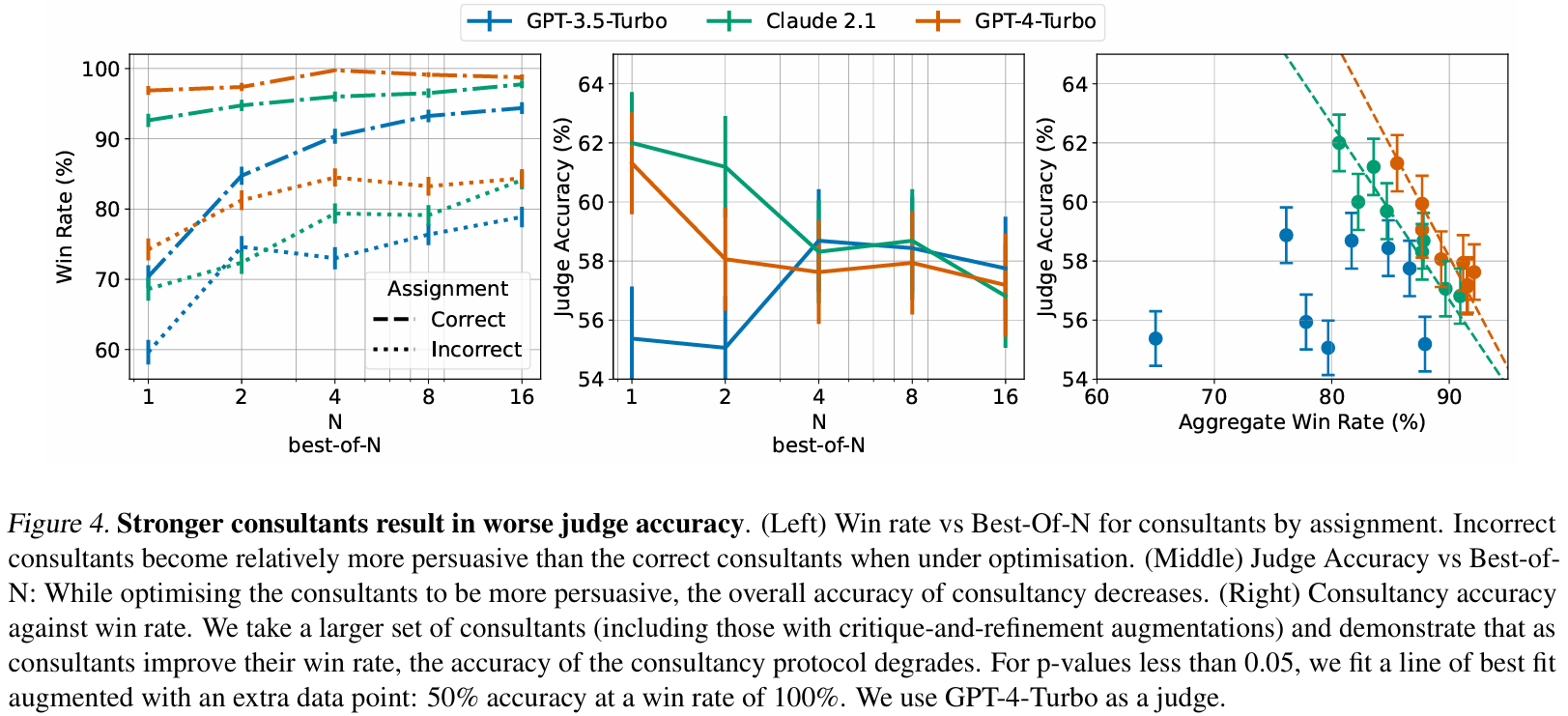

洞见4:Consultant能力越强,咨询准确率反而下降。用best-of-N与critique-and-refinement生成大量Consultant。图4-left显示,优化后Consultant胜率提高;由于RLHF模型本善于为正确立场辩护,优化可能disproportionately提升其为错误立场辩护的能力,导致裁判性能下降(图4-middle/right)。附录直接对比了辩论与咨询。

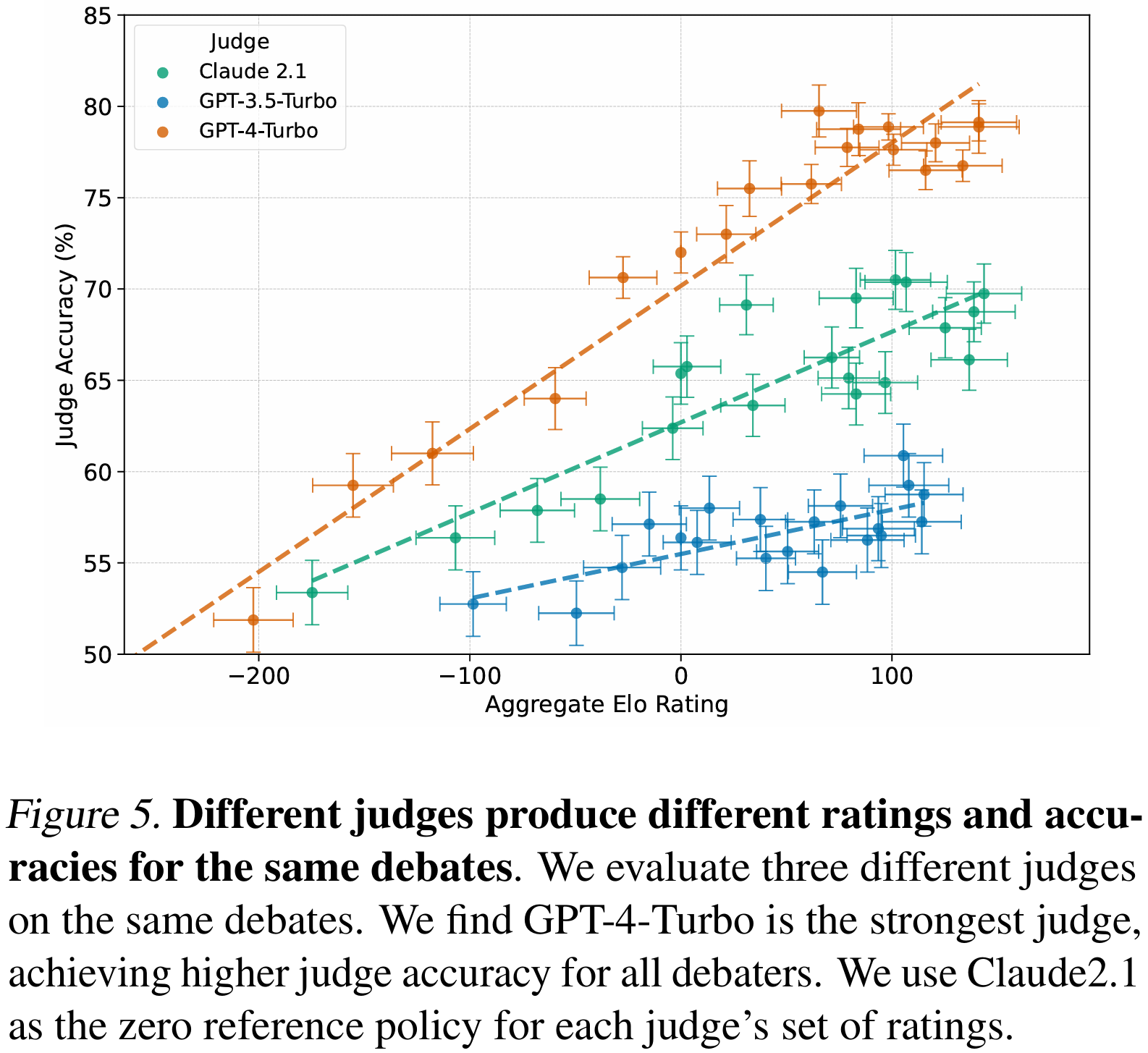

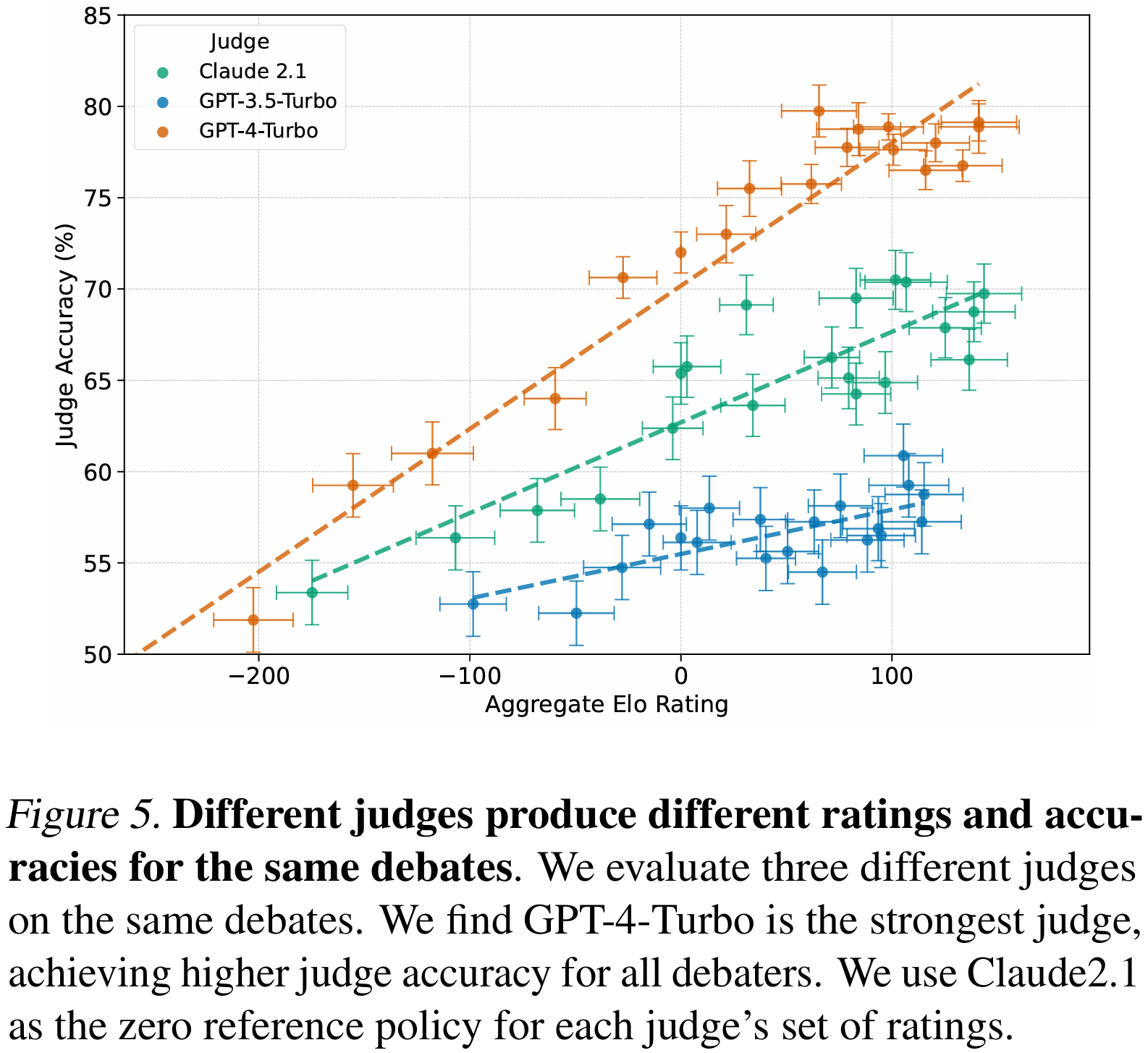

洞见5:更强裁判在所有辩手强度上都能更准确地识别正确论证。用Claude 2.1与GPT-3.5-Turbo重新裁判同一场交叉赛。图5显示,不同裁判给出的胜率、聚合Elo与自对弈准确率均不同;更强裁判产生的Elo分布更宽,且在全区间内准确率更高。即使偏好模型与裁判模型不同,强辩手仍能提升辩论准确率。附录给出提升裁判性能的其他方法。

四、人类裁判的实验结果

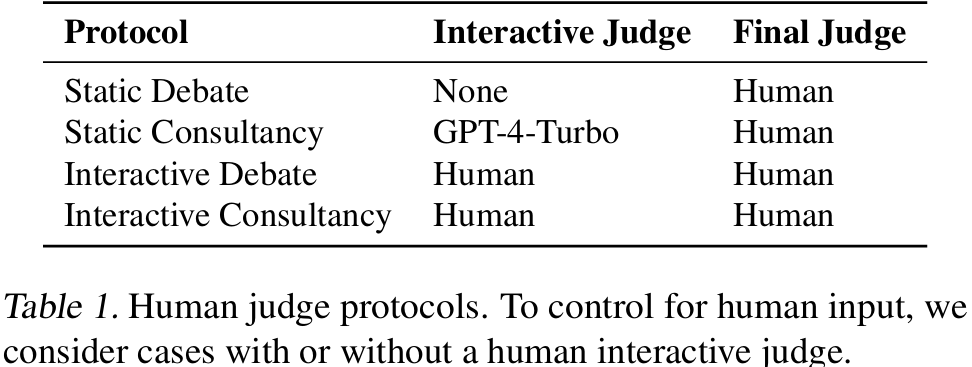

我们关心LLM裁判结果是否泛化到人类、人类是否优于LLM,以及协议在实施层面有何差异。为此,我们测试了每种协议的静态与互动两种变体(表1)。静态协议仅最后一步由人类裁判选择答案;互动协议允许人类在过程中提问或澄清。

实验共进行五周迭代(七批题目),随后进入四周测试期(每裁判47题)。题目与答案顺序随机,测试阶段不反馈正确答案。最终收集测试阶段953份人类判断、迭代阶段2362份,以及6476份训练阶段判断。

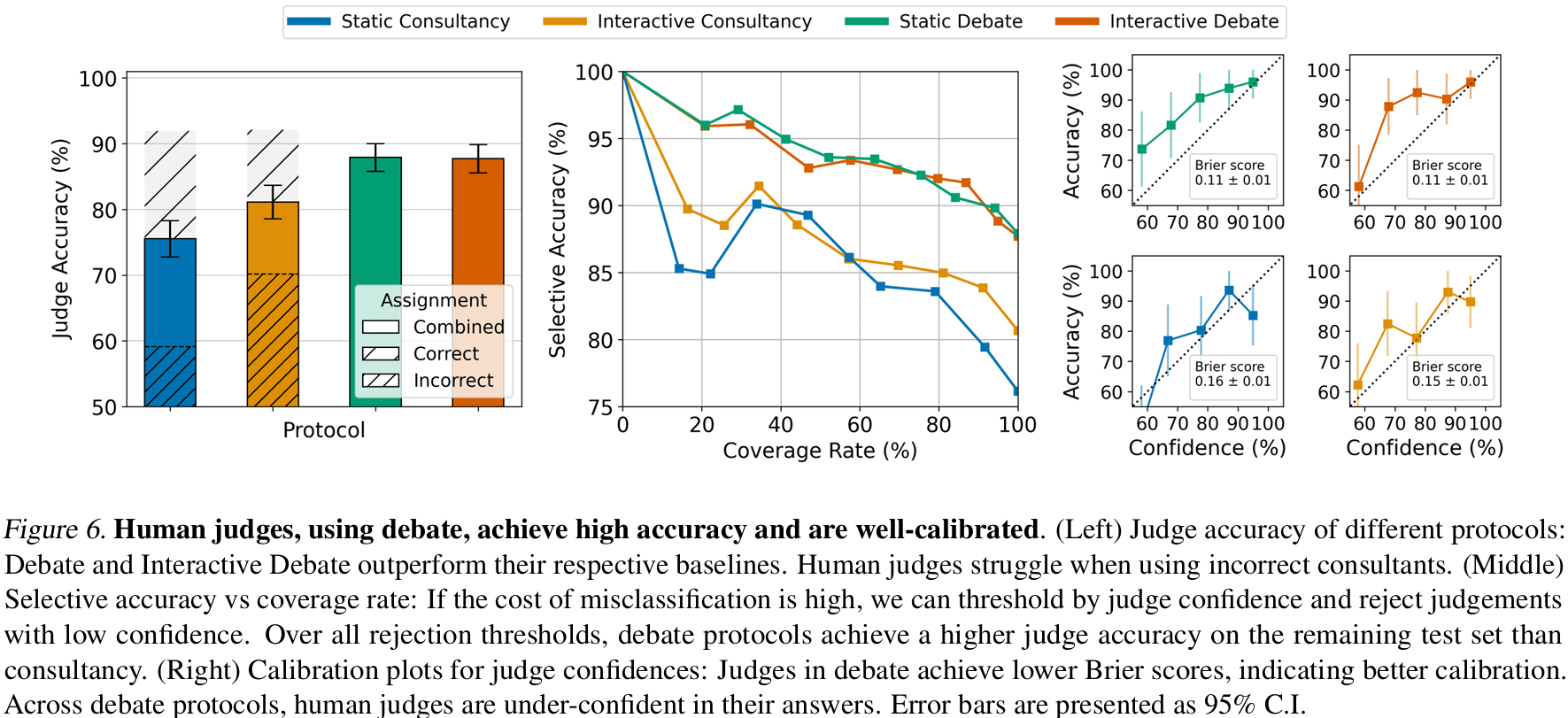

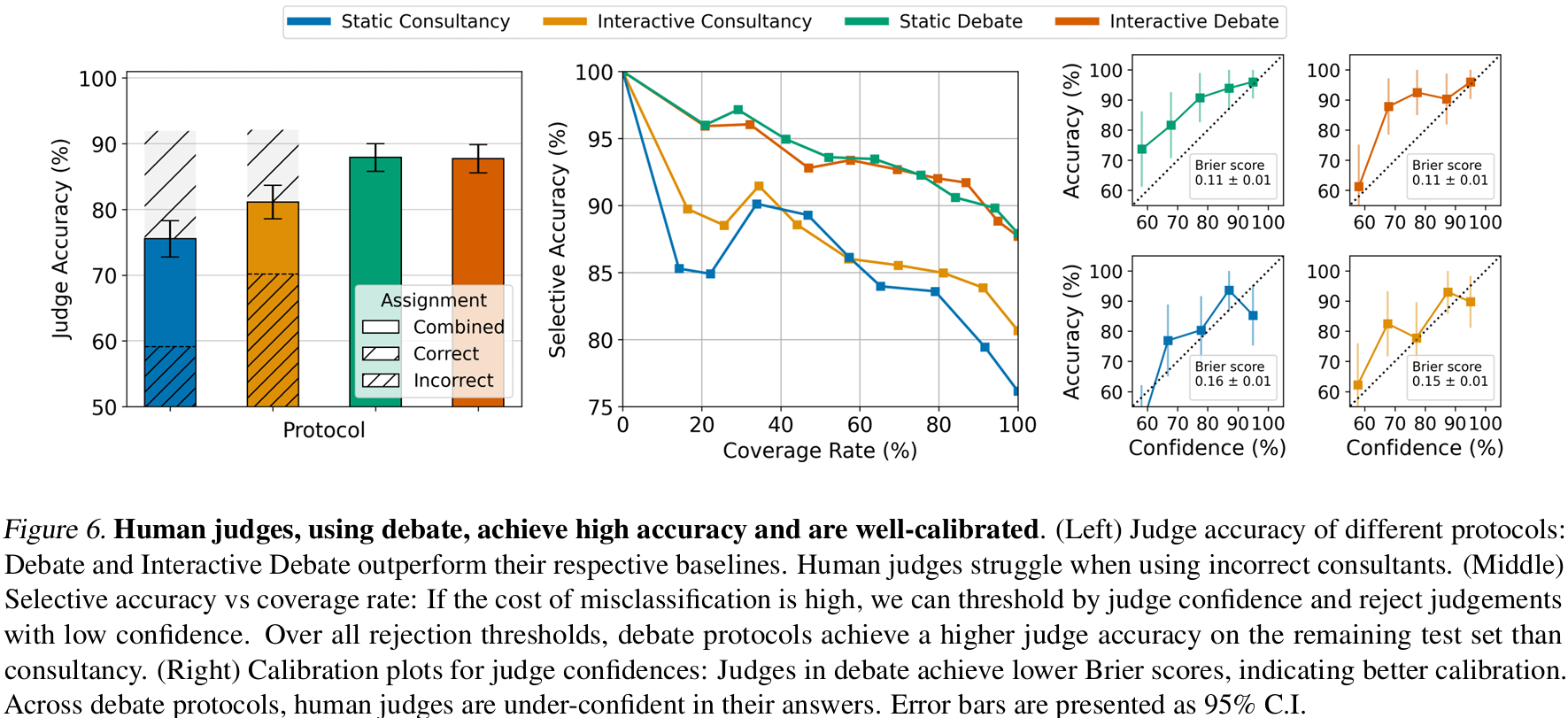

洞见6:辩论协议在人类裁判上准确率显著高于咨询。图6-left显示,无论静态还是互动,辩论均显著优于咨询(p=0.001, p=0.048)。咨询中错误专家导致低准确率,表明人类更容易被单方论证误导。所有协议下人类裁判准确率均高于LLM裁判。

洞见7:增加非专家互动并未提升准确率。静态与互动辩论的裁判准确率相同,说明在信息非对称情境下,允许人类提问并不能进一步帮助判断,这与LLM互动裁判结果一致。

洞见8:高置信度的辩论判断非常可靠。人类裁判以5%-95%区间给出置信度。若拒绝低置信判断(如<75%),静态辩论在保留65%题目时准确率升至94%。在所有拒绝阈值下,辩论协议的剩余准确率均高于咨询(图6-middle)。辩论裁判的Brier分数也更低(图6-right),表明校准更好。

洞见9:LLM辩手是当前准确率瓶颈。对所有人类裁判选错案例进行错误分析,发现辩论中最常见错误是正确辩手论证薄弱,通常因引用选择不佳;咨询中最常见错误是裁判未能从错误Consultant口中套出关键引用。这表明我们的辩手远未达到最优。

五、相关工作

已存在许多试图监督强模型的研究(Christiano et al., 2018;Bowman et al., 2022)。与辩论类似,这些方法都试图利用“验证正确解比生成正确解更容易”这一不对称性(Christiano et al., 2017;Stiennon et al., 2020;Saunders et al., 2022)。另一些方法鼓励模型将推理过程分解(Nye et al., 2022;Wei et al., 2022;Radhakrishnan et al., 2023;Yao et al., 2023),其效果类似于辩论生成一份可检查的论证记录。还有一种思路是开发归纳偏置,使弱模型能够直接监督强模型(Burns et al., 2023)。此外,也有研究通过“人类—AI混合团队”增强人类决策,例如联合团队在信贷风险预测中提升推理表现(Chromik et al., 2021)。相比之下,我们利用的是更通用的大语言模型,可在序列任务中反复应用,例如学习生成越狱提示(Nikola, 2023)。已有研究指出,人类—AI团队常会对其建议过度自信(Bansal et al., 2021),而我们发现参与辩论的人类裁判通常反而信心不足。

Irving et al. (2018)最早提出“辩论游戏”作为训练安全AI的机制。此后,一系列工作聚焦于验证其在监督中的有效性(Barnes, 2020;Parrish et al., 2022b;Parrish et al., 2022a;Michael et al., 2023)。这些研究全部采用人类辩手,而本文的辩手则是大语言模型。使用LLM辩手使我们能够控制辩手技能,并研究自对弈辩论。

此前也有关于LLM辩手的研究(Perez et al., 2019;Michael et al., 2023;Radhakrishnan, 2023;Du et al., 2023)。Perez et al. (2019)在理解任务上进行辩论,但辩手只能抽取源文本中的相关陈述,而不能自主生成论证。Michael et al. (2023)在QuALITY上首次引入信息非对称辩论设置,但使用LLM辩手时并未得到正向结果;他们主要关注人类辩手,因此没有考虑通过交叉胜率来提升辩手能力。与本文同期,Radhakrishnan (2023)也在QuALITY上进行辩论,但其协议仅包含单轮辩论,重点是通过强化学习训练辩手,并且未使用人类裁判。

六、讨论、局限性与结论

在本文中,我们探讨了辩论作为一种让大语言模型给出更真实回答的方法。我们证明,通过让非专家裁判观察两位专家之间的辩论记录,可以识别出问题的正确答案。此外,我们还表明,这一监督机制可以用大语言模型裁判来自动化。尽管Irving等人(2018)提出的原始辩论协议要求只判断辩论的某个子部分即可验证整个辩论,但我们的结果表明,仅对完整辩论记录进行判断就已经足以利用非专家和不可信专家为数据生成专家级标签。我们的发现适用于不同基础的大语言模型,无论是作为专家辩手还是非专家裁判,也适用于人类裁判,这表明辩论协议对裁判能力的变化具有鲁棒性,这一点很重要,因为模型仍在不断进步。

我们的工作存在重要局限。在我们的设置中,强与弱的区别仅体现在信息获取上。在未来,更强的模型可能在推理能力或其他技能上有所不同。此外,我们评估的模型经过了基于人类反馈的强化学习微调,具有诚实倾向;目前尚不清楚辩论是否适用于具有欺骗性的模型(Greenblatt等人,2023;Hubinger等人,2024)。最后,我们的结果仅限于辩手可以向裁判提供可验证证据的设置(在我们的案例中由辩手引用工具提供)。如果没有这样的系统,为错误答案辩护的辩手可以简单地编造一个替代叙事,使他们的答案看起来正确(而裁判由于无法访问底层故事,将无法发现这一点)。其他领域对证据有不同的概念,辩手的工具使用可能有所不同或没有必要。例如,数学辩论中的论点可能需要访问模拟器,而物理辩论可以以实验数据为基础。我们认为,这样的工具使用能力将帮助裁判更快地决定辩论,并且更值得信赖。

在我们的领域中,我们观察到,随着模型说服力的提高,辩论变得更加求真。这一发现可以通过以下观察来解释:当模型的输出针对裁判认可进行优化时,它们相对更擅长为正确答案辩护,而不是为错误答案辩护。这表明,针对说服力进行优化可以产生更真实的模型,为今后通过辩论微调大语言模型的研究铺平道路。此外,我们还展示了辩论如何用于增强人类判断,并生成超出其知识范围的准确问题标签。总体而言,这些结果表明,辩论是在没有ground truth的情况下实现可扩展监督的一种有前景的方法。

七、阅读笔记

①感觉这篇论文在技术方面的贡献没有多少,就是单纯地调用LLM来针对某个数据集来进行测评。评估那方面可能有一点点设计到技术方面的计算(Elo rating)。

②潜在的缺陷:让LLM去拥护一个错误答案可能会比较困难。实验用的大模型(GPT/Claude系列)都经过RLHF或Constitutional AI微调,天生倾向于“说真话”。这些LLM如果被喂给错误答案的话,很有可能会直接认输(self-defeat),甚至主动提醒裁判“对方才是对的”。