pytorch 52 基于SVD从全量训练模型中提取lora模型

从全量训练模型中提取 LoRA(Low-Rank Adaptation)模型,核心是分离全量模型中 “预训练基础参数” 与 “LoRA 新增的低秩适配参数”—— 本质是逆向还原 LoRA 的训练逻辑(即全量模型参数 = 预训练基础参数 + LoRA 低秩矩阵乘积)。实现该操作有两个目的:

1、lora训练的效果是不如全参数训练的,但全参数训练的模型在部署热切换时比较耗时,故需要针对全量微调后的模型,在基模的基准上,提取出lora模型;

2、在AIGC领域,大家都基于lora模型实现模型能力切换,但有些库只发布了全量模型,没有提供lora模型,这不利于部署测试。

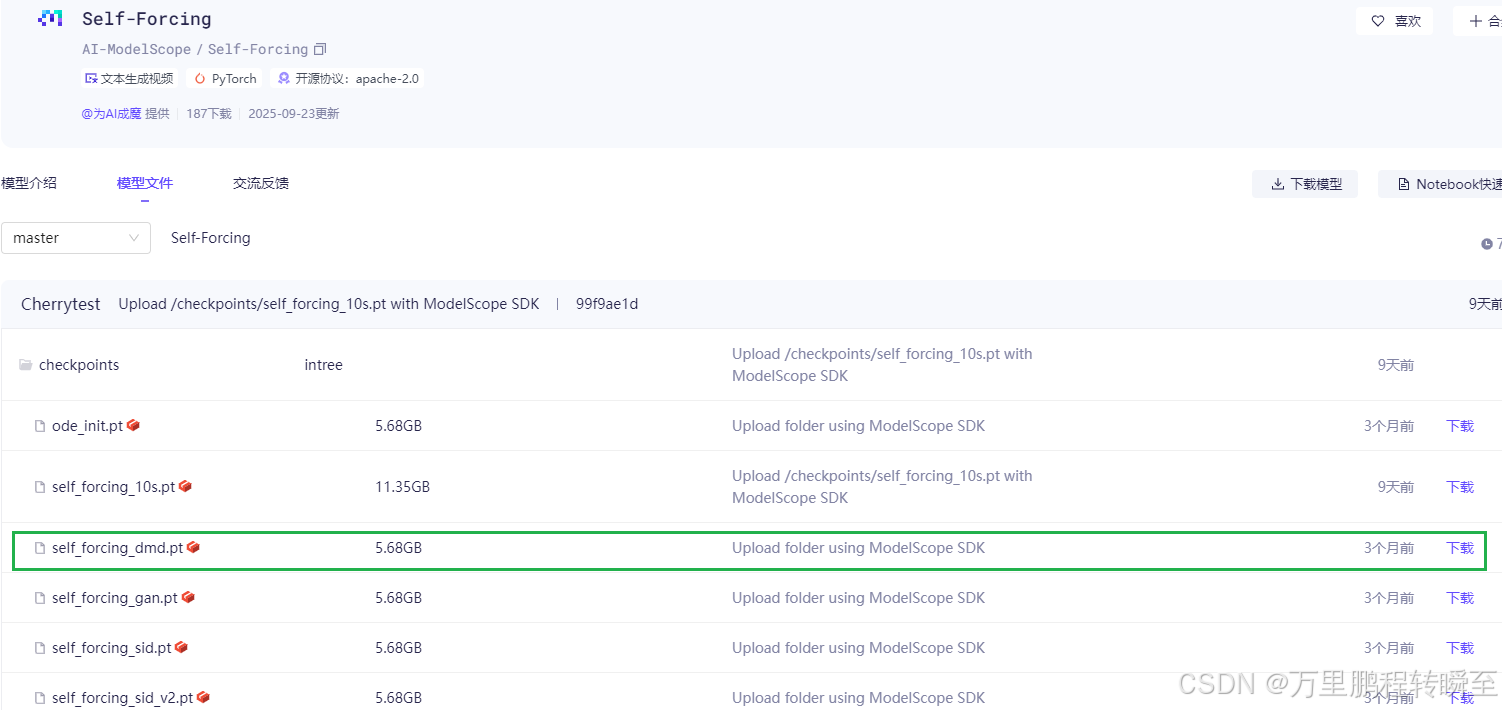

本博文以wan1.3b t2v self_forcing_dmd模型为全量训练的模型

以 Wan2_1-T2V-1_3B_bf16 为原始模型,进行lora模型提取