LLaMA-Factory windows wls 安装vllm,并对比速度

为LLaMA-Factory微调框架安装vllm

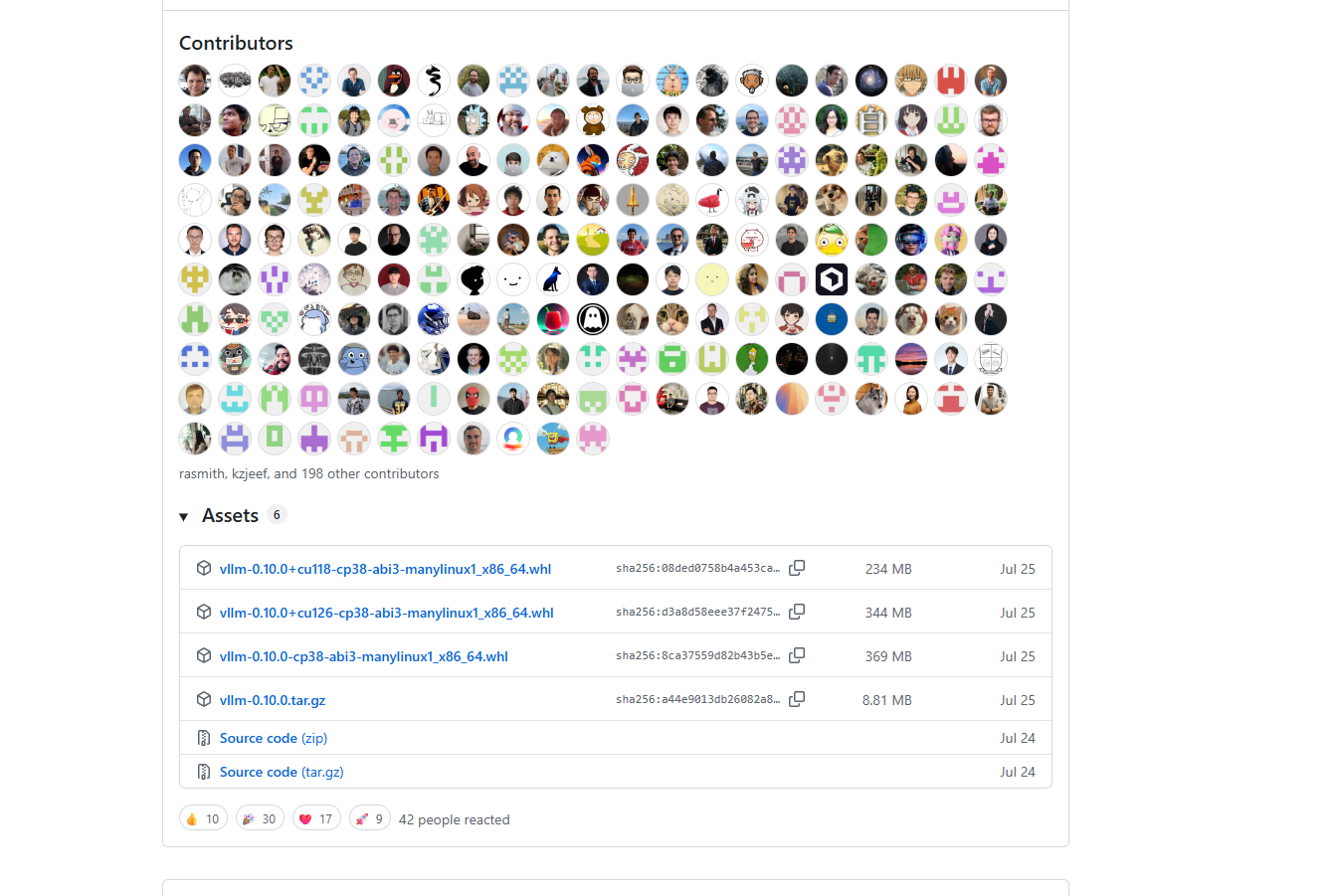

vllm releases地址下载符合条件的whl文件

下载对应cu版本

wget https://github.com/vllm-project/vllm/releases/download/v0.10.0/vllm-0.10.0+cu126-cp38-abi3-manylinux1_x86_64.whl

安装

pip install /mnt/d/Ubuntu_WSL/file/vllm-0.10.0+cu126-cp38-abi3-manylinux1_x86_64.whl -i https://pypi.tuna.tsinghua.edu.cn/simple

安装完成可能仍有RuntimeError: Failed to find C compiler. Please specify via CC environment variable.错误

通过下述代码安装即可

apt-get install --no-upgrade build-essential

运行vllm_infer

python ./scripts/vllm_infer.py --model_name_or_path /mnt/e/model/DeepSeek-R1-Distill-Qwen-7B --template deepseek --dataset data_sample --cutoff_len 512 --max_samples 1000 --batch_size 32 --enable_thinking False --max_new_tokens 512

然后4090GPU 100条数据推理仍然要40秒,比较奇怪,比web ui 快一点,webui70秒,自己用ai生成的代码只要20s,还要再研究下

参考链接