【Big Data】AI赋能的ClickHouse 2.0:从JIT编译到LLM查询优化,下一代OLAP引擎进化路径

目录

1. 什么是ClickHouse?

2. 诞生背景与发展历程

3. 架构设计解析

3.1 存储引擎:MergeTree家族

3.2 分布式模型:分片与副本

3.3 执行流程:向量化与并行计算

4. 解决的问题与适用场景

4.1 典型问题

4.2 适用场景

5. 关键技术特性与优势

5.1 列式存储与压缩

5.2 向量化执行引擎

5.3 分布式架构与高可用性

5.4 Projection 与关联查询优化

5.5 内存优化与资源管理

6. 与同类产品对比

6.1 与OLTP数据库对比

6.2 与HBase对比

6.3 与TPC-H测试结果对比

7. 使用方法与最佳实践

7.1 安装与配置

7.2 基本操作

7.3 性能调优指南

8. 实际应用案例

8.1 某地震台网中心

8.2 5G专网感知系统

8.3 焊接机器人数据采集系统

9. 局限性与未来发展趋势

10. 文末

参考资料:

ClickHouse作为一款在数据分析领域快速崛起的列式存储数据库,ClickHouse 已经在互联网、金融、物联网等多个行业得到广泛应用。本文将全面解析ClickHouse的核心概念、架构设计、应用场景及最佳实践,帮助技术开发人员快速掌握这一强大的OLAP工具。

1. 什么是ClickHouse?

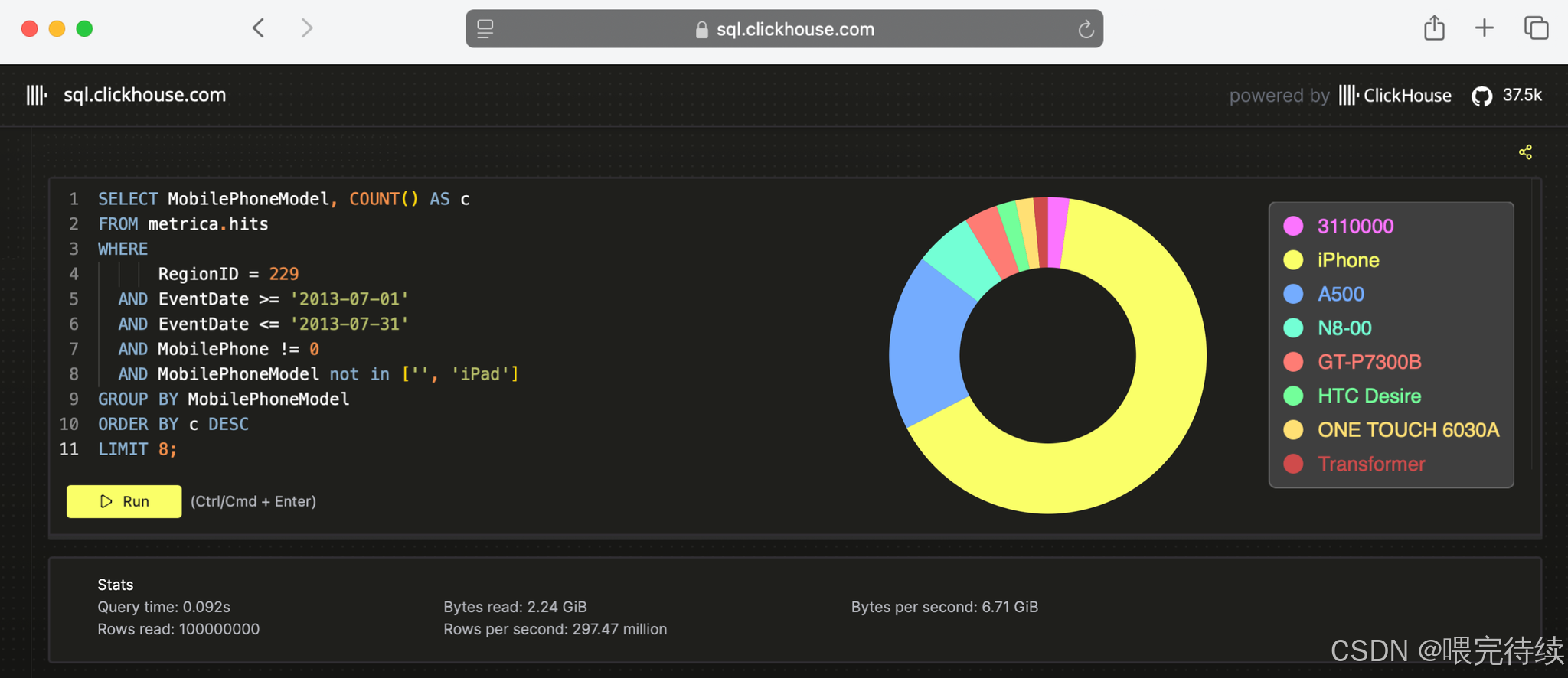

ClickHouse 是一款高性能、面向列的开源OLAP数据库管理系统,由俄罗斯搜索引擎巨头Yandex公司于2009年内部开发,2016年开源,使用C++编写。它专为海量数据的实时分析设计,能够在处理数亿行数据时提供秒级响应,是处理高吞吐、低延迟分析查询的理想选择。

与传统行式数据库(如MySQL)不同,ClickHouse采用列式存储架构,这意味着数据表中每一列的数据都以独立的单元形式存储在磁盘上。这种设计使得数据更容易被压缩,同时在查询时只需读取必要的列,而非整个行,从而显著减少了I/O开销。此外,ClickHouse还采用了向量化执行引擎,能够利用现代CPU的SIMD指令并行处理数据,进一步提升了查询性能。

(面向行的DBMS)

ClickHouse 的核心优势在于其极致的查询速度和简便的使用体验。它支持标准的SQL语法,允许开发者通过熟悉的SQL语句进行数据查询和分析,同时提供丰富的内置函数和表引擎,满足各种复杂的数据处理需求。

(面向列的DBMS)

2. 诞生背景与发展历程

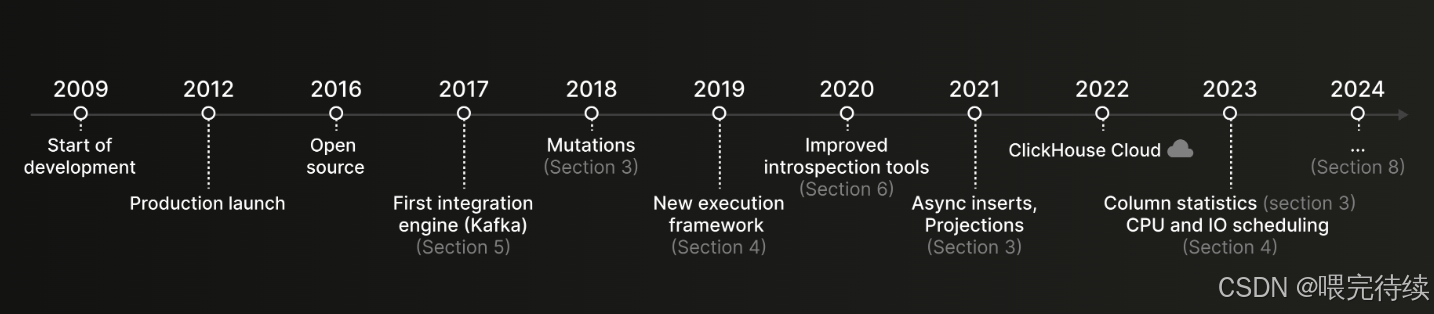

ClickHouse的诞生源于Yandex内部对高性能数据分析的迫切需求。作为俄罗斯最大的搜索引擎,Yandex每天需要处理数十亿次用户搜索请求和广告点击数据,传统的OLTP数据库(如MySQL)和OLAP工具(如Hive)无法满足其实时分析和大规模数据处理的需求 。

在2009年,Yandex开始研发ClickHouse的前身,用于支撑其流量分析平台"Metrica"。这个平台每天需要处理超过30亿个事件,覆盖数百万网站,支持超过10万分析师用户的实时查询需求。ClickHouse最初被设计为一个"耿直boy",专注于解决单表遍历的性能问题,而非复杂的关联查询。这种专注使得它在处理简单聚合查询时能够提供惊人的速度。

2016年,ClickHouse正式开源,迅速吸引了全球开发者的关注。2021年,ClickHouse,Inc.公司成立,并获得了近5000万美元的A轮融资和2.5亿美元的B轮融资,标志着它从开源项目正式迈入商业化阶段。如今,ClickHouse已经在阿里云、腾讯音乐、bilibili、京东等互联网公司得到广泛应用,成为处理海量数据分析的首选工具之一。

3. 架构设计解析

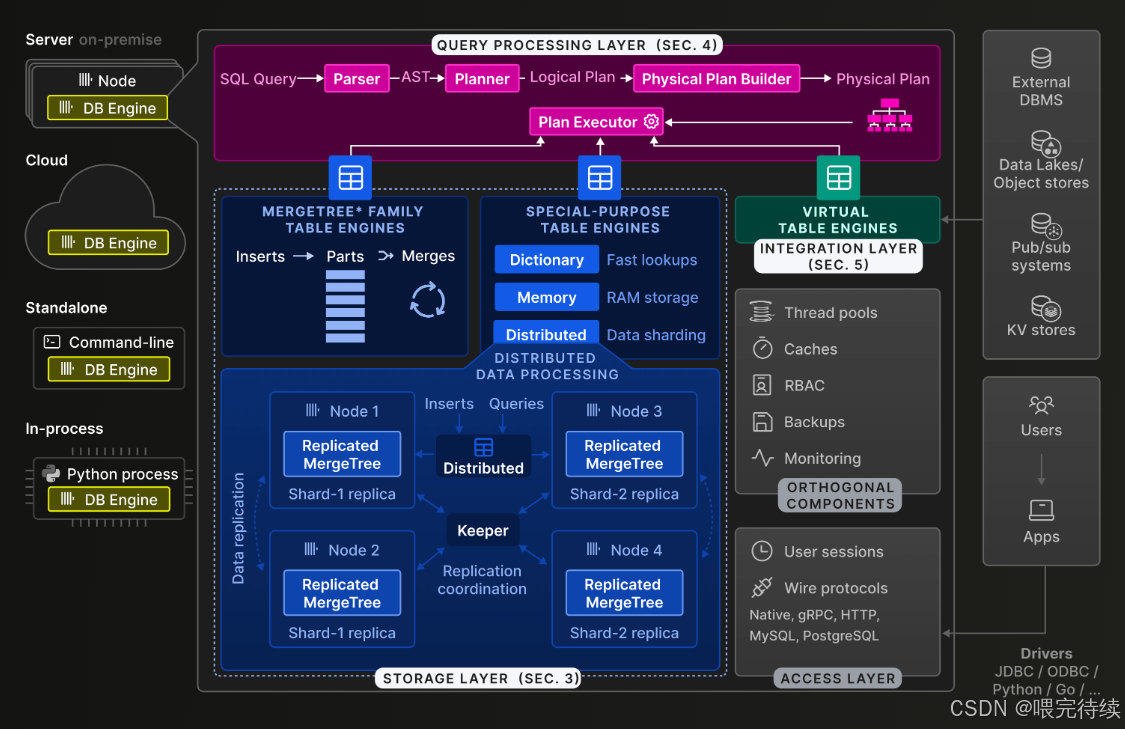

ClickHouse的架构设计围绕其核心目标——高性能OLAP查询展开,主要包括以下几个关键组件:

3.1 存储引擎:MergeTree家族

(CK存储层)

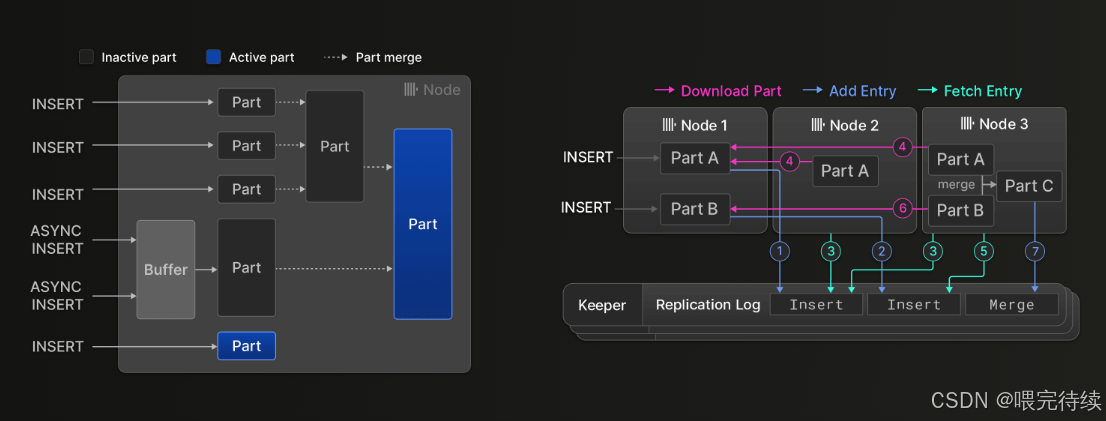

MergeTree系列引擎是ClickHouse的核心存储引擎,它基于列式存储和合并树的概念,提供了高性能和可扩展的数据处理能力 。MergeTree引擎具有以下特点:

-

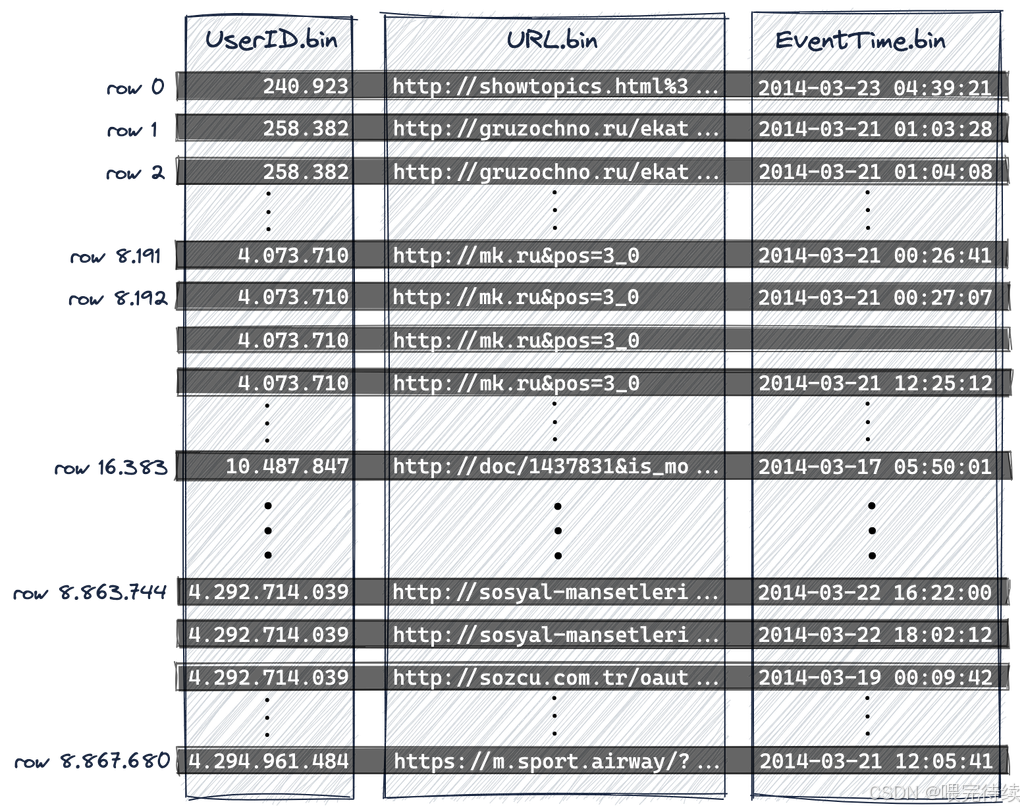

列式存储结构:将同一列的数据连续存储,大大提高了压缩效率和查询性能。相比行式存储,列式存储的压缩率通常高出3-5倍,同时减少了查询时的I/O开销。

-

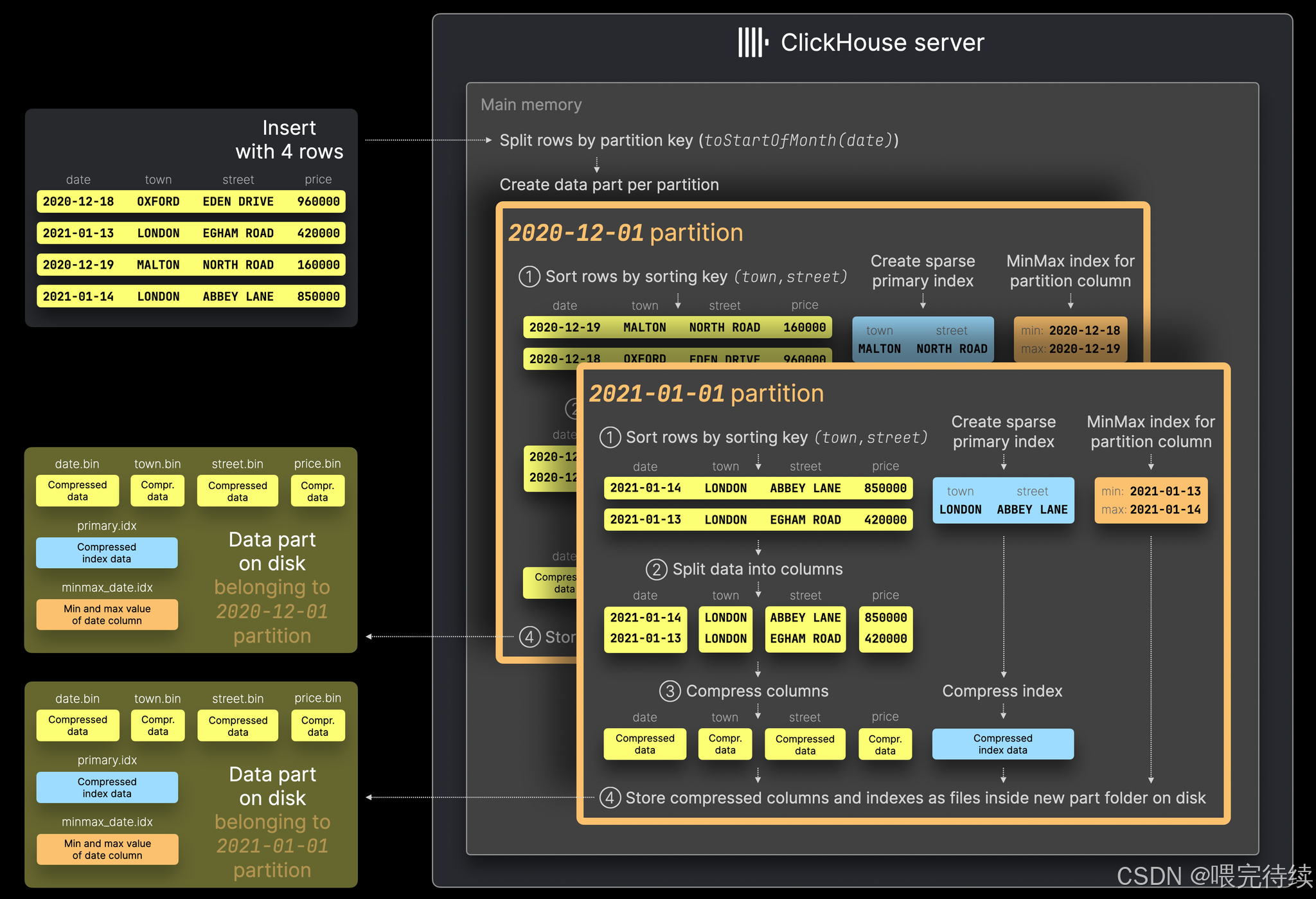

分区与排序:数据按照指定的分区键(PARTITION BY)水平分割成多个独立的分区,每个分区内按照排序键(ORDER BY)排序。这种设计使得范围查询能够快速定位数据,减少扫描量。

-

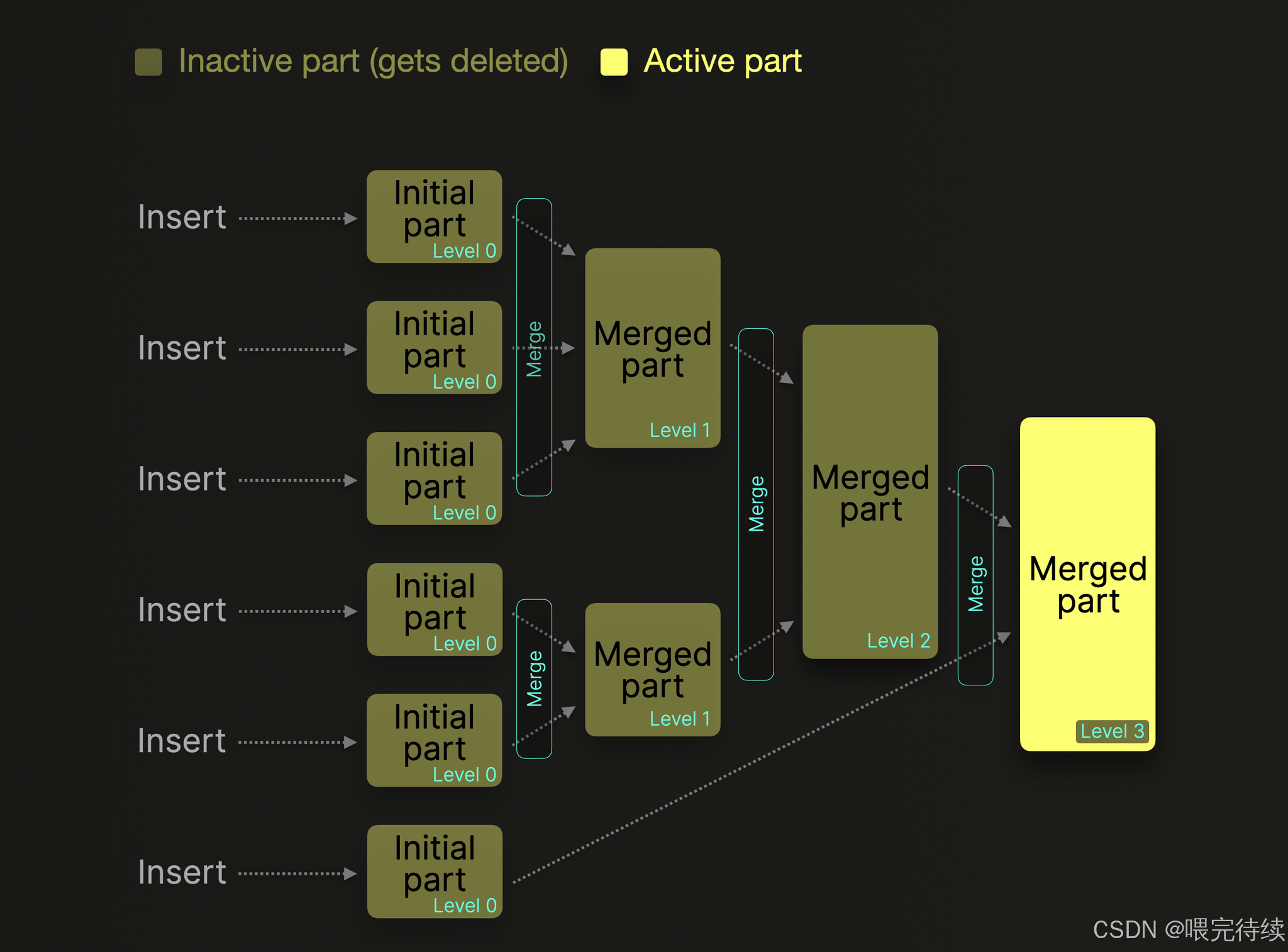

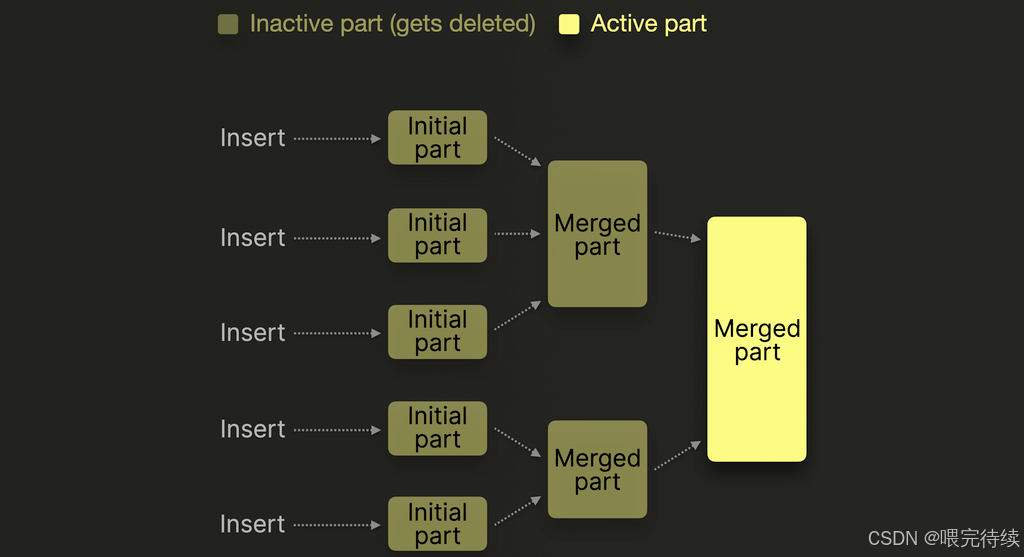

合并机制:MergeTree引擎会定期将相邻的分区按照一定策略合并,生成更大的数据块,从而减少文件数量,提高查询效率。合并过程是后台异步执行的,不会对正在进行的查询产生影响。

-

表引擎扩展:MergeTree引擎家族包含多种变体,如ReplacingMergeTree(按主键保留最新版本)、SummingMergeTree(对相同主键的行执行求和)、AggregatingMergeTree(按主键预聚合)等,这些变体引擎为特定场景提供了优化的数据处理能力。

MergeTree引擎的工作原理可以概括为:数据首先被写入内存缓存,然后顺序append写入磁盘形成part文件,系统会根据配置参数(如max_bytes_for_merge、min_bytes_for_merge)自动触发合并操作,将多个part合并成一个更大的part,同时保持数据有序。

3.2 分布式模型:分片与副本

ClickHouse的分布式架构基于分片(Shard)和副本(Replica)机制,实现了水平扩展和高可用性:

-

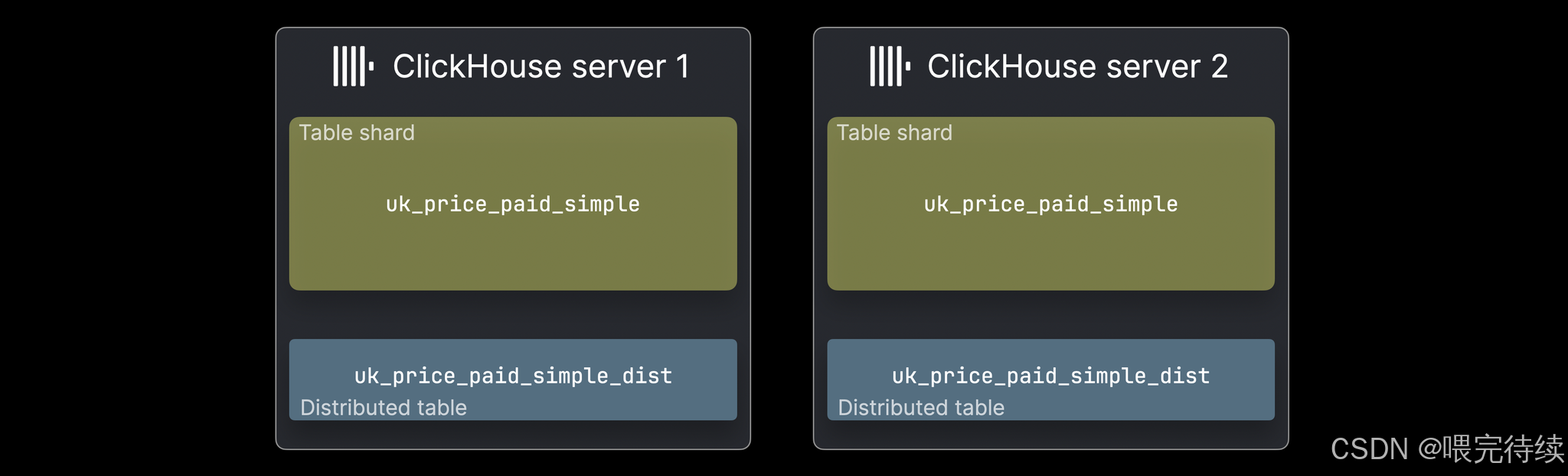

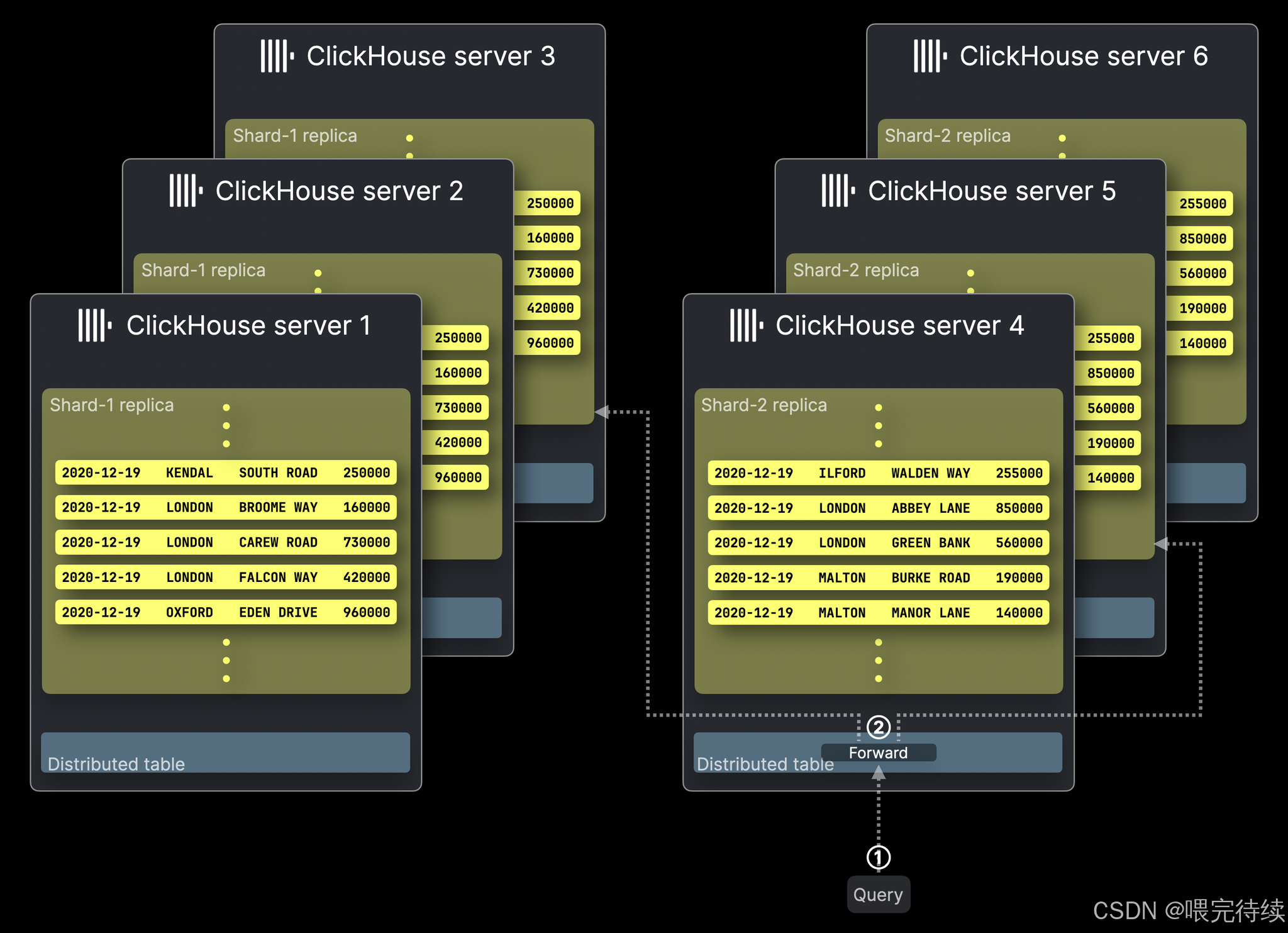

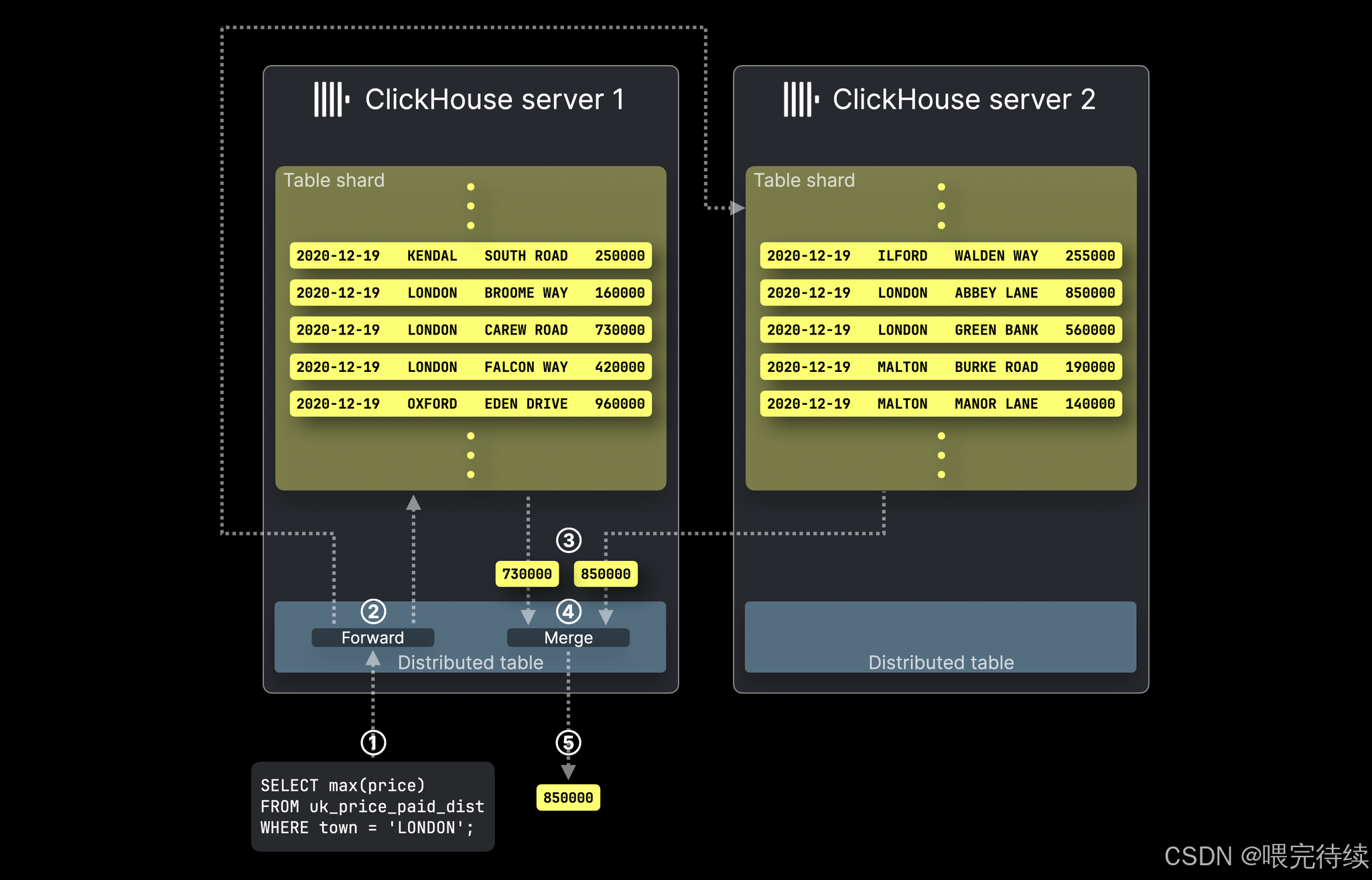

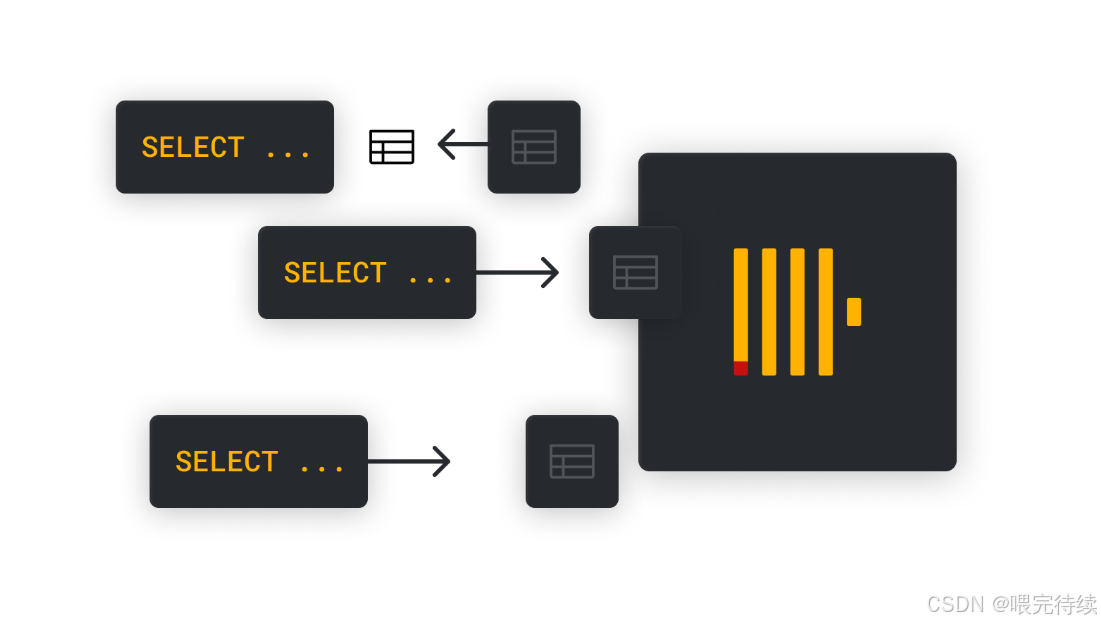

分片(Shard):数据按水平拆分到不同的分片上,每个分片存储数据子集。查询时,ClickHouse会自动将查询分发到所有分片上并行执行,然后将结果汇总返回。

-

副本(Replica):每个分片可以有多个副本,用于数据冗余和故障恢复。副本之间通过ZooKeeper/Keeper协调数据同步,确保数据一致性。

-

分布式表引擎:Distributed引擎将查询映射到集群中的分片和副本,实现透明的分布式查询。分布式表可以理解为集群所有分片上的本地表的合并视图,对分布式表的操作会根据分片规则映射到相应的分片节点上。

在实际部署中,分片规则通常基于数值类型(如日期)定义,例如将相同年份的数据放置在同一分片上。这种设计使得数据分布均匀,查询时能够有效利用所有节点的计算资源 。

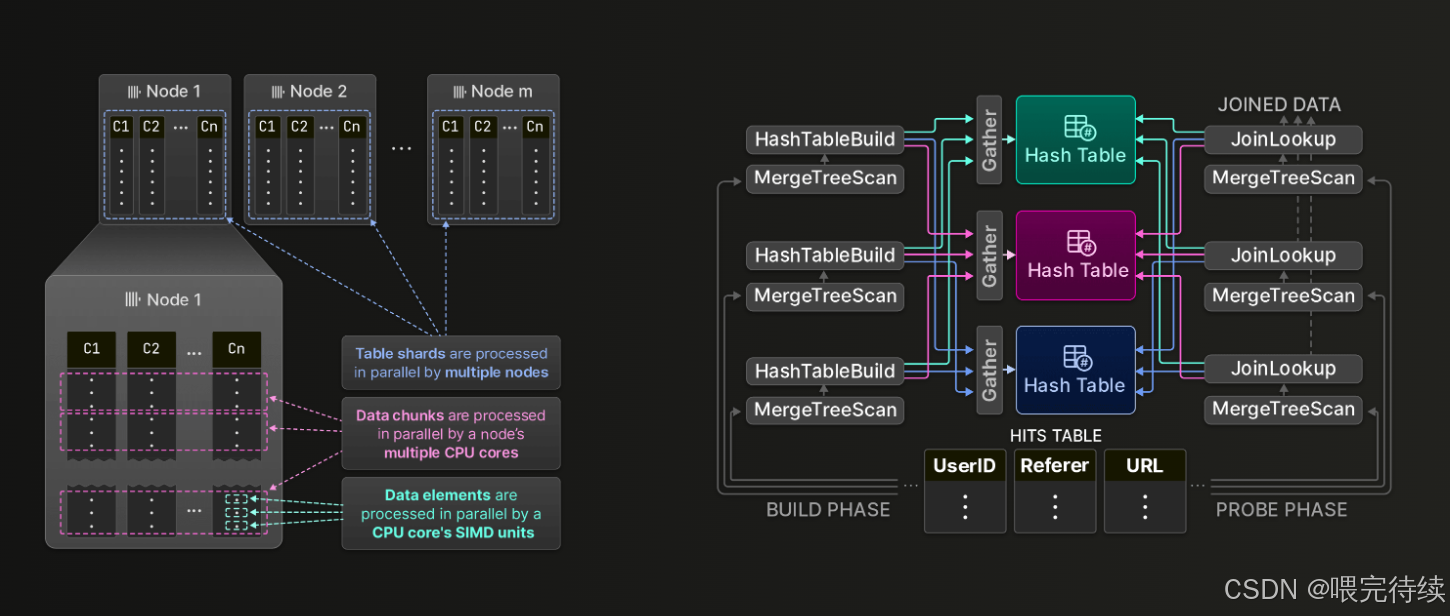

3.3 执行流程:向量化与并行计算

ClickHouse的执行流程采用了向量化执行和多核并行处理技术,这是其高性能的关键所在:

-

向量化执行引擎:ClickHouse将数据以Block(默认8192行)为单位加载到内存,按列连续处理。这种设计允许利用SIMD指令(如SSE、AVX)进行批量计算,大幅提高CPU利用率。

-

零拷贝技术:数据在Block间传递时仅共享指针,而非复制数据,减少了内存开销。

-

多核并行处理:单机查询能够利用所有CPU核心处理分区数据,分布式查询自动拆解任务到集群节点并行执行,最大化硬件资源利用率 。

-

SIMD指令优化:ClickHouse大量使用SIMD内置函数对关键代码路径进行优化,例如过滤器(Filter)的计算,通过向量化指令一次处理多个数据点。

-

代码生成优化:ClickHouse通过动态生成汇编代码加速聚合函数,编译器自动向量化简单循环,进一步提升性能。

4. 解决的问题与适用场景

ClickHouse主要解决传统数据库在OLAP场景中的性能瓶颈问题,特别是以下几类场景:

4.1 典型问题

-

海量数据实时分析:传统OLTP数据库(如Oracle、MySQL)在处理千亿级数据时存在I/O瓶颈,而ClickHouse通过列式存储和向量化执行实现了秒级响应 。

-

高吞吐写入与低延迟查询矛盾:LSM-Tree类数据库(如HBase)写入快但查询慢,而ClickHouse通过MergeTree引擎的异步合并机制平衡了两者。

-

分布式一致性与扩展性:通过ZooKeeper/Keeper协调分片与副本,实现数据自动同步和线性扩展。

-

复杂SQL查询性能:支持标准SQL但传统数据库难以高效处理GROUP BY、JOIN等操作,ClickHouse通过向量化和列存优化解决了这一问题。

-

资源受限环境:基于普通硬盘的低成本存储方案,避免了传统OLAP系统对高端硬件的依赖。

4.2 适用场景

-

实时数仓:日均千亿级数据实时查询,如广告平台、用户行为分析、金融交易监控等场景 。

-

时序数据处理:高频率传感器数据、日志数据的批量写入与快速聚合,如物联网设备监控、工业生产数据采集等。

-

多维分析:支持宽表和灵活维度组合的复杂分析,如商业智能、数据可视化等。

-

高并发写入场景:每秒百万级数据点的写入,如互联网日志收集、用户行为追踪等。

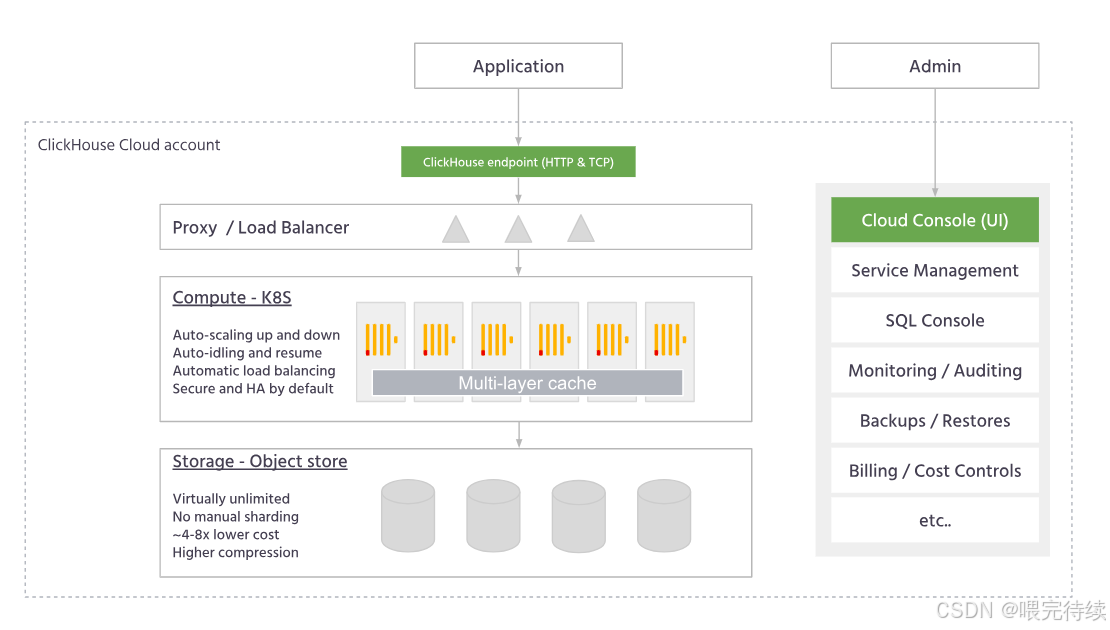

-

存算分离架构:结合对象存储(如S3)实现低成本、高扩展的数据存储方案 。

ClickHouse不适用于以下场景:需要事务支持的场景、数据频繁更新的场景、小数据量高并发的OLTP场景。它最适合数据一次性写入后不再修改的分析场景,这是其高性能的基础假设。

5. 关键技术特性与优势

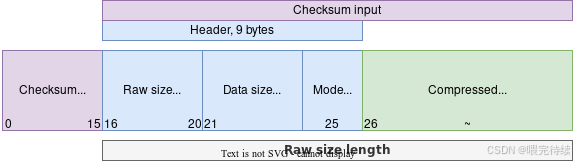

5.1 列式存储与压缩

列式存储是ClickHouse的基础,它将同一列的数据连续存储,使得数据更容易被压缩,同时查询时只需读取必要的列,而非整个行。相比行式存储,列式存储的压缩率通常高出3-5倍,同时减少了查询时的I/O开销。

ClickHouse支持多种压缩算法,包括:

| 压缩算法 | 压缩速度 | 解压速度 | 压缩率 | 适用场景 |

|---|---|---|---|---|

| LZ4 | 极快 | 极快 | 中等 | 默认选择,通用场景 |

| ZSTD | 快 | 极快 | 高 | 存储成本敏感,CPU资源充足 |

| ZLIB | 慢 | 中等 | 高 | 历史兼容,不推荐新项目使用 |

此外,ClickHouse还针对特定类型的数据提供了专用压缩策略,如字典编码(对低基数列自动构建字典,用整数代替原始值存储)和Delta压缩(对有序数值列存储差值而非原始值,大幅减少存储空间)。

5.2 向量化执行引擎

向量化执行引擎是ClickHouse的另一大核心优势,它通过SIMD指令并行处理数据块,显著提升了计算效率。

传统行式执行逐行处理数据,而向量化执行按列处理数据,减少了CPU指令的分支预测失败和缓存失效,提高了计算密度。例如,在过滤操作中,传统数据库需要对每行数据逐一判断条件,而ClickHouse可以一次性处理数千行数据,大幅提高了查询速度。

ClickHouse的向量化执行依赖于其底层数据结构——PODArray。PODArray通过填充区(pad_left和pad_right)设计,使得数据对齐更高效,支持裸指针迭代器和移动构造函数,减少拷贝开销,提升向量化效率。

5.3 分布式架构与高可用性

ClickHouse的分布式架构基于分片(Shard)和副本(Replica)机制,实现了水平扩展和高可用性:

-

分片与副本:数据水平拆分到多个分片,每个分片有多个副本。查询时自动路由到所有分片并行执行,结果汇总返回。

-

协调服务:ZooKeeper/Keeper管理元数据(如副本状态、DDL操作),确保分布式一致性。

-

ClickHouse-Keeper:2024年后,ClickHouse开始推广使用ClickHouse-Keeper替代ZooKeeper,简化高可用管理,提高系统稳定性。

-

数据同步:通过主键排序和稀疏索引(如跳数索引),实现多副本间的数据同步,确保数据一致性。

-

故障恢复:节点故障时,系统能够自动检测并切换到健康的副本,保证服务可用性。

5.4 Projection 与关联查询优化

Projection是ClickHouse 24.3版本引入的重要特性,通过预计算特定列组合加速关联查询,解决传统宽表在复杂JOIN中的性能瓶颈。

Projection类似于物化视图,但更轻量,可以动态生成列的投影结构,减少全表扫描。例如,对于经常需要进行JOIN的表,可以创建包含JOIN键的Projection,使得查询能够直接利用投影数据,大幅提升性能。

5.5 内存优化与资源管理

ClickHouse在内存管理方面做了大量优化,避免了传统OLAP系统常见的内存溢出问题:

-

内存参数控制:通过max_memory_usage参数控制单查询内存使用上限(默认2GB),防止查询耗尽系统资源。

-

外部聚合:当数据量过大无法全部加载到内存时,ClickHouse会自动切换为外部聚合(基于磁盘的聚合),避免内存溢出。

-

查询执行优化:通过EXPLAIN命令分析查询执行计划,识别性能瓶颈并进行针对性优化。

-

资源隔离:通过query_id分组限制资源使用,确保关键查询能够获得足够的系统资源。

6. 与同类产品对比

6.1 与OLTP数据库对比

| 特性 | ClickHouse | MySQL/Oracle |

|---|---|---|

| 存储模型 | 列式存储 | 行式存储 |

| 适用场景 | OLAP:批量读取、聚合计算、复杂分析 | OLTP:频繁单行读写、事务操作 |

| I/O效率 | 仅读取查询涉及的列 | 读取整行,即使只需少量字段 |

| 压缩潜力 | 高(同列数据类型一致,重复模式多) | 低(不同数据类型相邻,压缩率低) |

| 写入性能 | 高吞吐(每秒百万级行) | 低吞吐(每秒万级行) |

| 查询性能 | 高(批量处理,SIMD加速) | 低(逐行处理) |

| 事务支持 | 不支持 | 支持 |

ClickHouse在OLAP场景中性能远超传统OLTP数据库。例如,在处理2.8亿条数据的入库时,ClickHouse仅需30分钟,而传统数据库可能需要数小时 。

6.2 与HBase对比

| 特性 | ClickHouse | HBase |

|---|---|---|

| 存储模型 | 列式存储 | 列族存储 |

| 查询语言 | SQL兼容 | 原生API,不支持标准SQL |

| 吞吐量 | 亿级/秒 | 百万级/秒 |

| 延迟 | 秒级 | 毫秒级(点查) |

| 扩展性 | 水平扩展(分片) | 水平扩展 |

| 数据压缩 | 高(专用压缩算法) | 中等(通用压缩算法) |

| 关联查询 | 支持(但性能一般) | 不支持 |

ClickHouse在OLAP场景中性能远超HBase,特别是在复杂聚合查询方面。HBase更适合高吞吐、低延迟的点查场景,而ClickHouse则专注于批量读取和聚合计算。

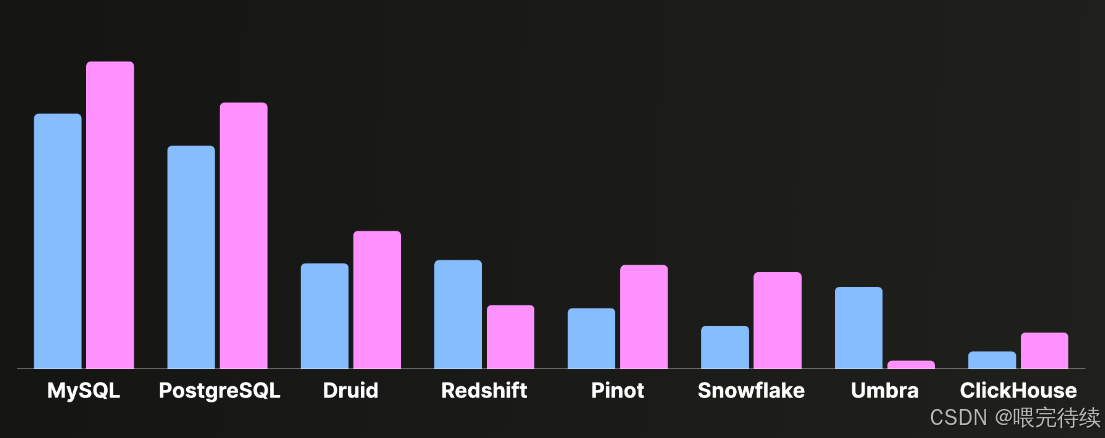

6.3 与TPC-H测试结果对比

在TPC-H测试中,ClickHouse表现出色,但也暴露了一些短板:

| Query | ClickHouse | Oracle | OushuDB |

|---|---|---|---|

| 1 | 15.4s | 114.3s | 9.7s |

| 2 | 17.3s | 1.9s | 1.3s |

| 3 | 内存溢出 | 165.8s | 8.8s |

| 4 | 内存溢出 | 158.4s | 4.9s |

| 5 | 内存溢出 | 174.5s | 8.9s |

| 6 | 4.8s | 126.7s | 4.5s |

| 7 | 内存溢出 | 181.5s | 10.5s |

| 8 | 内存溢出 | 209.7s | 6.9s |

| 9 | 内存溢出 | 256.0s | 16.8s |

| 10 | 58.3s | 195.6s | 8.3s |

| 11 | 6.7s | 8.7s | 0.9s |

| 12 | 10.7s | 186.0s | 4.9s |

| 13 | 134.1s | 33.3s | 12.1s |

| 14 | 10.2s | 170.0s | 3.3s |

| 15 | 11.2s | 161.8s | 4.7s |

| 16 | 4.0s | 10.8s | 2.7s |

| 17 | 44.6s | 156.5s | 5.3s |

| 18 | 内存溢出 | 416.8s | - |

| 19 | >600s | 144.1s | - |

| 20 | 31.2s | 171.0s | - |

| 21 | 语法错误 | 360.7s | - |

| 22 | 8.4s | 37.7s | - |

在简单查询(如Q1、Q6)中,ClickHouse显著快于Oracle;但在复杂关联查询(如Q3、Q7)中,常因内存溢出或SQL兼容性问题失败,甚至不如Oracle。相比之下,OushuDB在TPC-H全场景中性能领先2-5倍,且支持完整的SQL语法。

7. 使用方法与最佳实践

7.1 安装与配置

ClickHouse支持多种安装方式,包括Docker、Ubuntu、CentOS等:

-

Docker快速部署:

docker pull yandex/clickhouse-server docker run -d --name clickhouse-server -p 9000:9000 -p 8123:8123 yandex/clickhouse-server -

Ubuntu安装步骤:

sudo apt-get install apt-transport-https ca-certificates dirmngr sudo apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv E0C56BD4 echo "deb https://repo.clickhouse.com/deb/stable/ main/" | sudo tee /etc/apt/sources.list.d/clickhouse.list sudo apt-get update sudo apt-get install -y clickhouse-server clickhouse-client sudo service clickhouse-server start -

集群部署:需要部署3台虚拟机作为ClickHouse节点,每台配置32核CPU、128G内存、300G硬盘。通过keeper_endpoints参数配置ClickHouse-Keeper集群,替代传统ZooKeeper。

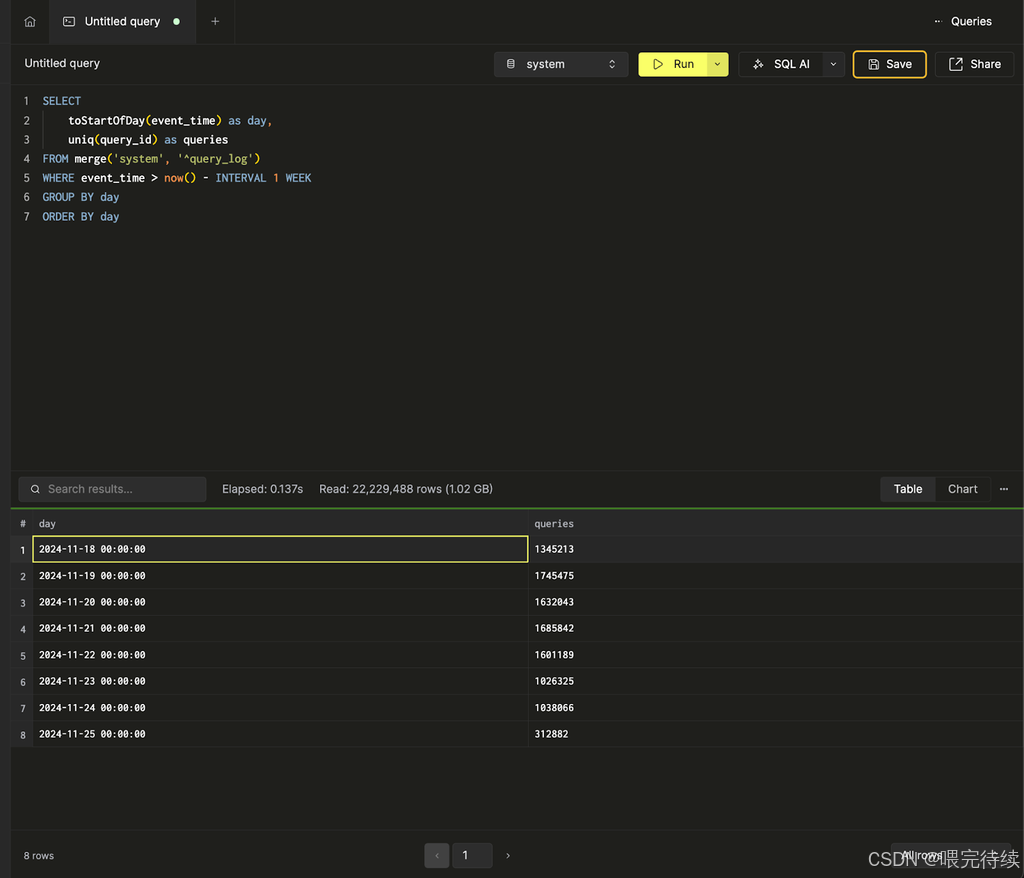

7.2 基本操作

ClickHouse支持标准SQL语法,提供了丰富的数据操作功能:

-

创建表:

CREATE TABLE events (event_date Date,user_id UInt64,event_type String,ts DateTime ) ENGINE = MergeTree() PARTITION BY toYYYYMMDD(event_date) ORDER BY (user_id, ts) -

插入数据:

INSERT INTO events VALUES('2025-08-30', 1, 'login', toDateTime('2025-08-30 10:00:00')),('2025-08-30', 2, 'logout', toDateTime('2025-08-30 11:00:00')); -

查询数据:

SELECT event_type, COUNT(*) AS cnt FROM events WHERE event_date >= '2025-08-01' GROUP BY event_type -

创建分布式表:

CREATE TABLE distributed_events AS events ENGINE = Distributed('cluster_name', 'db', 'events', rand()); -

数据迁移:使用clickhouse-copier工具迁移数据,支持全量和增量迁移。迁移时通过XML配置灵活创建表和数据导入 。

7.3 性能调优指南

ClickHouse的性能调优主要围绕以下几个方面:

-

表设计优化:

- 合理选择分区键,避免过多小分区(建议按月或周分区)。

- 使用合适的排序键,加速范围查询。

- 对低基数列使用ReplacingMergeTree等变体引擎,实现去重 。

-

查询优化:

- 使用PREWHERE优先过滤低基数字段,减少数据读取量。

- 限制查询结果行数,避免全表扫描。

- 使用EXPLAIN分析查询执行计划,识别性能瓶颈 。

-

配置参数优化:

<!-- config.xml --> <max_memory_usage>8G</max_memory_usage> <max_threads>16</max_threads> <max_partitions_per_insert_block>100</max_partitions_per_insert_block> <keeper_endpoints>keeper1:9181,keeper2:9181,keeper3:9181</keeper_endpoints> -

合并策略优化:

ALTER TABLE events MODIFY settings ('merge_tree' = '{"maxBytesForMerge": 1073741824,"minBytesForMerge": 104857600}' ); -

资源管理:

- 监控集群负载,动态调整写入速率。

- 对高并发查询设置资源隔离,确保关键查询能够获得足够的系统资源。

8. 实际应用案例

8.1 某地震台网中心

某地震台网中心将Oracle数据库中的约13TB地球物理观测数据迁移到ClickHouse,并每日更新。实际测试表明,ClickHouse显著提升了数据读写性能,增强了数据统计查询能力,通过多副本保证了数据库的一致性和安全性 。

迁移过程中,针对Oracle中按测项、数据类型、采样率分表存储的结构,重新设计了适用于ClickHouse的表结构,将CLOB字段拆分为时序数据格式单独建表存放。这种设计使得ClickHouse能够充分发挥其列式存储和向量化执行的优势。

8.2 5G专网感知系统

某5G专网感知系统采用ClickHouse作为数据存储层,解决了专网1万张号卡每秒1000次话单插入、每天8000万话单量存储的需求 。系统通过Kafka集群接收数据消息,然后使用FlinkCDC将数据写入ClickHouse。ClickHouse的高吞吐写入和列式存储特性使得系统能够处理每秒数百万的话单数据,并支持每秒50次的并发查询,查询响应时间不超过5秒。

8.3 焊接机器人数据采集系统

焊接机器人数据采集系统通过ClickHouse的列式存储和向量化执行特性,实现了每秒百万级传感器数据的实时存储与分析 。系统采用三层数据通信模块设计:

- 第一层:部署在机器人便携式PC上,负责与机器人设备通信,解决不同品牌设备协议差异问题。

- 第二层:基于Netty框架实现NIO服务器,负责数据预处理和标签添加。

- 第三层:将实时数据批量写入ClickHouse,并发布到MQ供实时监控页面使用。

ClickHouse的MergeTree引擎按日期分区、时间+设备编号联合排序,支持快速范围查询和故障统计分析,大大提升了工业物联网场景的数据处理能力 。

9. 局限性与未来发展趋势

尽管ClickHouse在性能方面表现出色,但仍存在一些局限性:

- SQL标准支持不完整:部分复杂查询(如多表JOIN)支持有限,或性能较差。

- 内存使用限制:复杂查询容易触发内存溢出,需通过参数调整(如max_bytes_before_external_group_by)控制。

- 数据更新机制不完善:数据写入后不可修改,仅支持后台合并实现间接更新。

- 高并发写入挑战:大量小文件可能导致合并效率下降,需通过调整合并策略优化。

未来发展趋势:

- ClickHouse-Keeper替代ZooKeeper:简化高可用管理,提高系统稳定性。

- Projection功能完善:进一步优化关联查询性能,解决复杂查询场景的性能瓶颈 。

- 内存优化增强:通过改进内存管理机制,减少复杂查询的内存溢出风险。

- 安全功能加强:支持更完善的数据加密和访问控制机制,提升系统安全性 。

10. 文末

ClickHouse是一款专为OLAP场景设计的高性能列式存储数据库,通过列式存储、向量化执行和分布式架构,解决了传统数据库在分析场景中的性能瓶颈。它特别适合处理海量数据的实时分析,如日志分析、用户行为分析、时序数据处理等场景。

使用ClickHouse时应注意以下几点:

- 明确应用场景:确保数据写入后不再修改,适合只追加(Append-Only)的分析场景。

- 合理设计表结构:选择合适的分区键和排序键,避免过多小分区,充分利用MergeTree引擎的优势。

- 关注查询优化:使用PREWHERE过滤低基数字段,避免全表扫描,必要时使用Projection优化关联查询。

- 监控系统资源:定期监控内存使用情况,及时调整参数防止内存溢出。

- 考虑数据加密:在敏感数据场景中,结合对象存储的加密功能或使用HTTPS端口进行传输加密。

随着ClickHouse的不断发展和社区的壮大,相信它将在更多领域发挥重要作用。特别是Projection功能的引入和ClickHouse-Keeper的推广,将进一步提升系统的性能和可用性,为数据分析提供更强大的支持。

对于技术开发人员来说,掌握ClickHouse的核心概念和使用方法,将有助于构建高性能的数据分析系统,应对日益增长的数据处理需求。无论是互联网、金融还是工业物联网领域,ClickHouse都将成为处理海量数据分析的有力工具。

参考资料:

- ClickHouse 官方文档

- ClickHouse 论文-《ClickHouse- Lightning Fast Analytics for Everyone》

本博客专注于分享开源技术、微服务架构、职场晋升以及个人生活随笔,这里有:

📌 技术决策深度文(从选型到落地的全链路分析)

💭 开发者成长思考(职业规划/团队管理/认知升级)

🎯 行业趋势观察(AI对开发的影响/云原生下一站)

关注我,每周日与你聊“技术内外的那些事”,让你的代码之外,更有“技术眼光”。

日更专刊:

🥇 《Thinking in Java》 🌀 java、spring、微服务的序列晋升之路!

🏆 《Technology and Architecture》 🌀 大数据相关技术原理与架构,帮你构建完整知识体系!关于博主:

🌟博主GitHub

🌞博主知识星球