分布式锁的具体实现和原理分析

分布式锁的具体实现和原理分析

开篇:从共享会议室的钥匙说起

大家好,今天我们来聊一个在分布式系统中绕不开的话题——分布式锁。在深入技术细节之前,我们先来看一个生活中的场景。想象一下,我们公司有一个非常抢手的、只能容纳一人专心工作的“灵感小屋”,这间小屋没有排班表,谁想用就得去前台拿唯一的钥匙。这个“灵感小屋”就像是我们系统中的一个共享资源,比如一个商品的库存,而想要进去工作的同事们,就是我们系统里并发的请求或线程。那把唯一的钥匙,就是我们今天要讨论的主角——“锁”。

在这个场景里,规则很简单:谁先拿到钥匙,谁就能进去使用小屋,并且会把门锁上,其他人只能在外面焦急地等待。等里面的人出来后,把钥匙还给前台,下一个人才能拿走钥匙进去。这个机制保证了在任何一个时间点,都只有一个人能使用这个“灵感小屋”,避免了混乱。这就是“互斥”的核心思想。

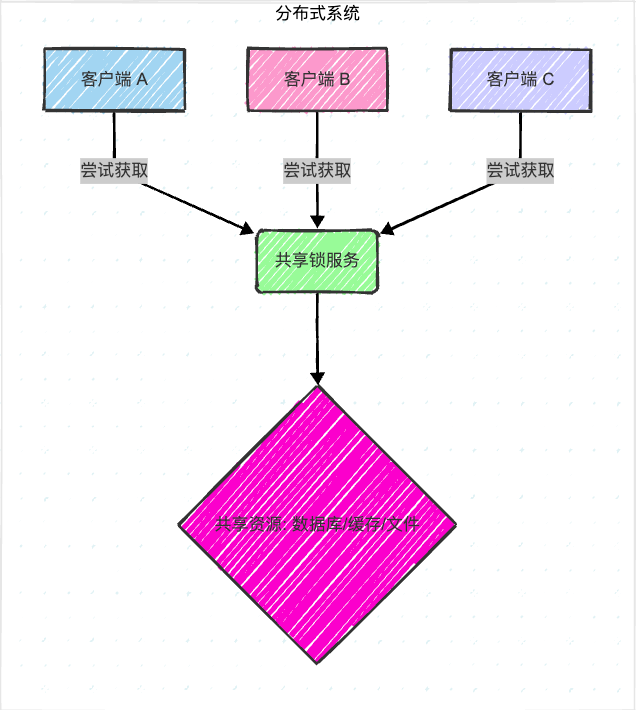

但如果把这个场景放大到分布式的世界,问题就变得复杂了:如果公司有好几个前台(多个服务节点),钥匙放在哪个前台?一个同事拿到钥匙后,万一在小屋里睡着了(服务宕机),钥匙一直不归还怎么办?或者,一个同事误把另一个同事的钥匙还了回去怎么办?这些问题,正是分布式锁需要解决的核心挑战。每个服务节点都运行在独立的进程中,它们无法直接感知到其他进程的执行状态,因此,我们需要一个外部的、所有进程都能访问的共享存储来协调它们的行为。今天,我们就将化身为这个“钥匙管理员”,一步步设计和完善我们的分布式锁机制,确保在分布式环境下,共享资源能够被安全、高效地访问。

上图展示了分布式锁服务在多客户端共享资源场景中的核心位置,它负责协调对共享资源的访问。

二、 为什么需要分布式锁?从Redis实现开始探索

理解了生活中的类比和分布式锁的宏观作用后,我们再把视角拉回到技术世界。

在单体应用时代,我们用synchronized或者ReentrantLock就能很好地解决并发问题,因为所有线程都在同一个JVM进程里,大家遵循着同一套规则。但是,当我们的系统演进到微服务架构时,情况就变了。比如电商的秒杀场景,扣减库存的服务可能部署在多个节点上。如果不加任何控制,多个节点的多个请求同时读取库存“10”,然后各自减1,再写回“9”,最终库存只被减了1,但实际上卖出去了好几个商品,这就是典型的“超卖”问题。每个服务节点都在自己的JVM里,Java内置的锁显然已经无能为力,因为它锁不住其他机器上的线程。我们需要一个“全局”的锁,一个所有服务节点都能看到并遵守的规则。这就是分布式锁的用武之地。

在众多的分布式锁实现方案中,基于Redis的实现因其高性能和易于理解而广受欢迎。Redis本身是单线程处理命令的,这为实现原子操作提供了天然的优势。接下来,让我们一步步揭开用Redis实现分布式锁的神秘面纱,看看从一个“青铜”方案如何一步步“进化”到“王者”级别。相信通过这个过程,大家会对分布式锁的设计要点有更深刻的理解。这种逐步改进的思路,也是我们解决复杂技术问题时常用的方法论,它能帮助我们系统性地发现问题并给出更健壮的解决方案。

1. 最初的尝试:SETNX命令

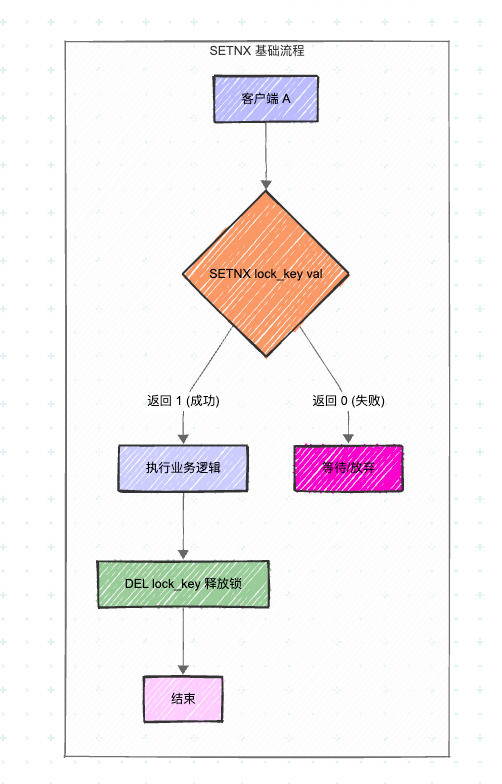

我们最容易想到的方案就是利用Redis的SETNX(SET if Not eXists)命令。这个命令的特性是:如果key不存在,则设置key-value并返回1;如果key已存在,则不做任何操作并返回0。这不就是我们想要的“占坑”效果吗?

执行流程

- 客户端A尝试执行

SETNX lock_key "any_value"。 - 如果返回1,说明客户端A成功获取了锁,可以执行业务逻辑。

- 业务逻辑执行完毕后,客户端A执行

DEL lock_key来释放锁。 - 如果步骤1返回0,说明锁已被其他客户端持有,客户端A可以选择等待后重试,或者直接放弃。

上图展示了使用SETNX实现分布式锁的基本流程。这是最简单的尝试,但存在明显缺陷。

原理与问题

这个方案看起来很美好,但它有一个致命的缺陷:如果客户端A在执行完业务逻辑后、释放锁(DEL lock_key)之前,突然宕机或网络中断了,那么这个锁就永远不会被释放。其他客户端将永远无法获取到锁,造成“死锁”。这就像那个在“灵感小屋”里睡着的同事,钥匙不还,谁也别想用。这种情况下,锁将永久占用,直到手动干预,这在生产环境中是不可接受的。

2. 改进方案:SETNX + EXPIRE

为了解决死锁问题,我们自然会想到给锁加一个“有效期”。如果在客户端A宕机后,锁能自动过期被删除,问题不就解决了吗?于是,我们想到了在SETNX成功后,紧接着使用EXPIRE命令设置一个超时时间。这个思路是正确的,但实现方式需要非常严谨。

代码示例(错误示范)

// 这是一个有问题的实现,仅用于说明

public boolean tryLock(String lockKey, String requestId, int expireTime) {// 尝试获取锁if (jedis.setnx(lockKey, requestId) == 1) {// !!! 注意:如果在这里宕机,锁将无法过期,造成死锁 !!!jedis.expire(lockKey, expireTime); return true;}return false;

}上述代码展示了一个非原子性的加锁操作,setnx和expire是两个独立的步骤。这种分离操作在高并发或故障场景下极易引发问题。

新的问题:非原子性

这个方案看似解决了问题,但引入了新的风险。SETNX和EXPIRE是两个独立的命令,它们不是原子操作。如果在执行完SETNX后,还没来得及执行EXPIRE时,客户端就宕机了,那么我们又回到了最初的死锁问题。虽然这个概率很小,但在高并发的生产环境中,“小概率事件”迟早会发生。记住,在分布式系统设计中,我们必须杜绝这种“可能”发生的问题。一个健壮的系统,必须考虑到所有可能的异常情况并给出解决方案。

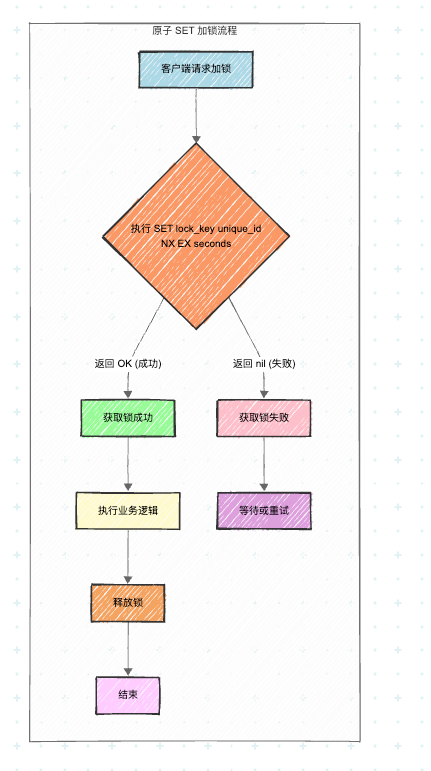

3. 终极方案:原子操作的SET命令

幸运的是,Redis官方也意识到了这个问题。从Redis 2.6.12版本开始,SET命令进行了扩展,允许在一条命令中同时完成“SETNX”和“EXPIRE”的功能,从而保证了原子性。这就像是把拿钥匙和设置闹钟这两个动作,打包成了一个不可分割的整体,要么都成功,要么都失败。

执行流程

使用命令:SET lock_key unique_id NX EX seconds

lock_key:锁的名称,例如“product:123:lock”。unique_id:一个唯一的标识,通常是UUID或者线程ID,用于安全地释放锁。它确保“谁加的锁,谁才能解”。NX:表示只在key不存在时才设置(等同于SETNX)。EX seconds:设置锁的过期时间,单位是秒。

这条命令将“加锁”和“设置过期时间”合并成了一个原子操作,彻底解决了中途宕机导致的死锁问题。

上图展示了使用Redis原子SET命令进行加锁的流程。原子性保证了加锁和设置过期时间这两个关键步骤的同步执行。

代码示例(正确实现)

import redis.clients.jedis.Jedis;

import redis.clients.jedis.params.SetParams;public class RedisDistributedLock {private final Jedis jedis;public RedisDistributedLock(Jedis jedis) {this.jedis = jedis;}/*** 尝试获取锁* @param lockKey 锁的key* @param requestId 请求标识,必须唯一,用于安全释放锁* @param expireTime 过期时间(秒)* @return 是否获取成功*/public boolean tryLock(String lockKey, String requestId, int expireTime) {// 使用 SET key value NX EX timeout 原子命令// NX: 只在key不存在时才设置// EX: 设置key的过期时间,单位秒SetParams params = SetParams.setParams().nx().ex(expireTime);String result = jedis.set(lockKey, requestId, params);return "OK".equals(result);}

}上述代码使用了Jedis客户端提供的set方法,通过SetParams参数实现了原子性的加锁操作,这是目前推荐的标准做法。它将SETNX和EXPIRE合二为一,避免了多步操作带来的竞态条件。

4. 安全释放锁:校验与原子删除

现在我们的加锁操作已经很安全了,但释放锁呢?直接DEL lock_key可以吗?答案是:不可以!

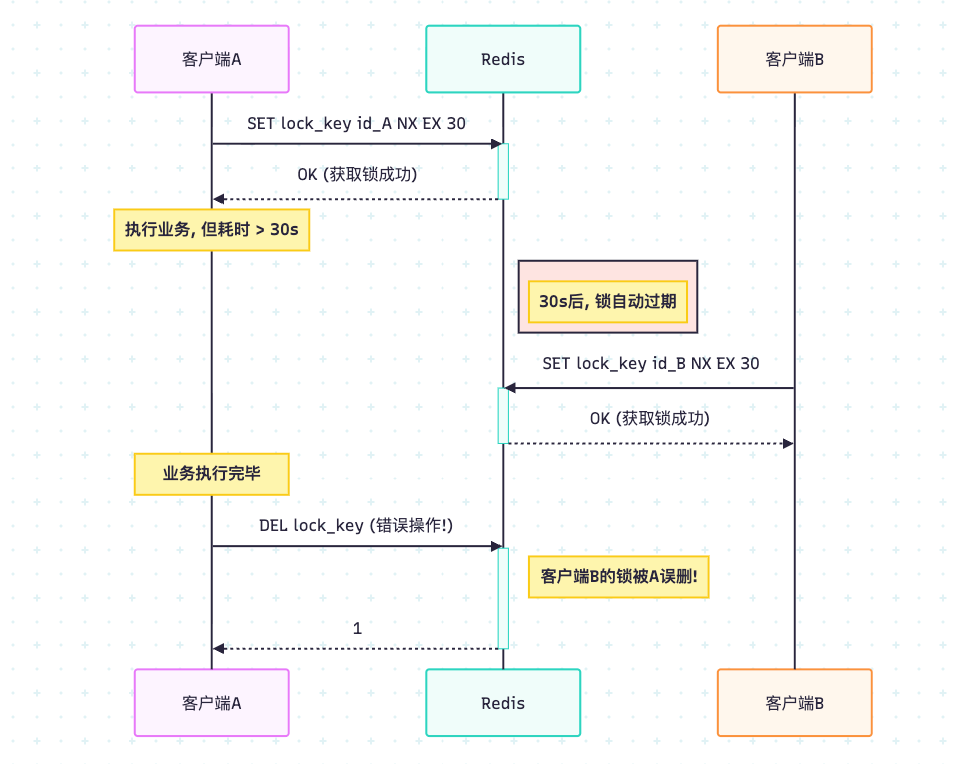

场景分析

考虑这个场景:

- 客户端A获取了锁,过期时间设置为30秒。

- 客户端A的业务逻辑执行时间超过了30秒(例如因为Full GC或者网络延迟),在第31秒,锁因为超时被Redis自动释放了。

- 此时,客户端B成功获取了这把锁。

- 紧接着,客户端A的业务逻辑执行完毕,它执行了

DEL lock_key命令,结果把客户端B刚刚获取的锁给释放了!

这就造成了严重的混乱。客户端B以为自己持有锁,但实际上锁已经被释放了,可能导致对共享资源的并发访问问题。为了解决这个问题,我们在加锁时设置的那个unique_id就派上用场了。

上图展示了错误释放锁导致的问题:客户端A因为业务耗时过长,在锁过期后,将客户端B新获取的锁误删,从而引发并发问题。

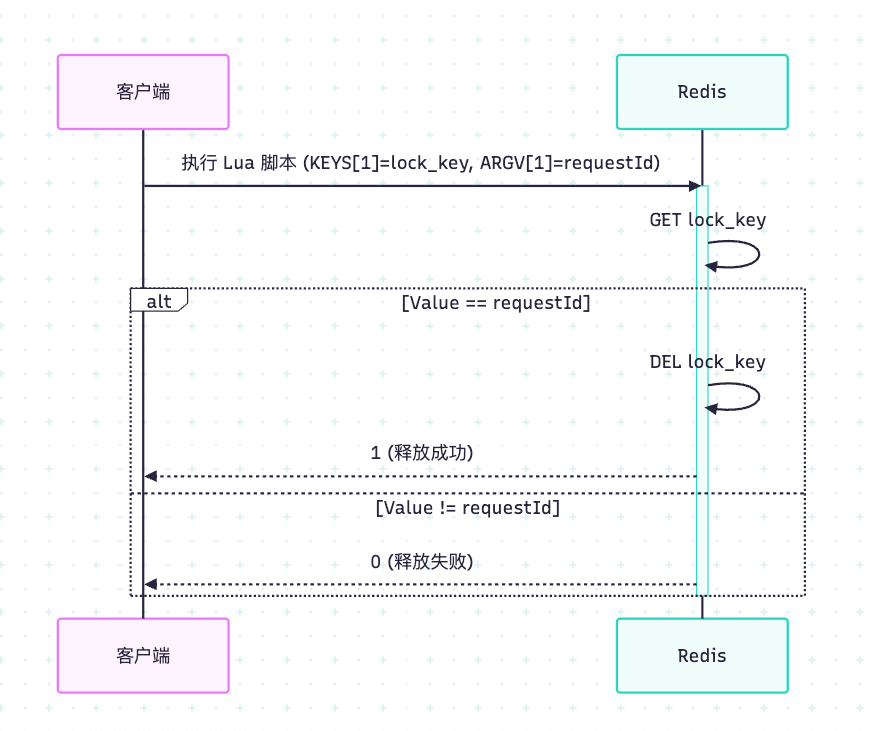

解决方案:Lua脚本

释放锁的原则是:只能释放自己加的锁。我们在释放锁时,必须先判断当前锁的持有者是不是自己。

- 获取锁的值。

- 判断该值是否与自己加锁时设置的

unique_id相等。 - 如果相等,则执行

DEL命令。

这三个步骤也必须是原子操作,否则在判断相等和执行删除之间,锁可能又过期了。实现原子操作的最佳方式就是使用Lua脚本,因为Redis保证Lua脚本的执行是原子的。它就像是Redis内部的一个事务,要么全部成功,要么全部失败,不会出现中间状态。

上图展示了通过Lua脚本实现安全释放锁的原子操作。Redis在执行Lua脚本时确保其原子性,避免了竞态条件。

代码示例(安全的释放锁)

import redis.clients.jedis.Jedis;

import java.util.Collections;public class RedisDistributedLock {private final Jedis jedis;public RedisDistributedLock(Jedis jedis) {this.jedis = jedis;}// ... tryLock方法同上/*** 安全地释放锁* @param lockKey 锁的key* @param requestId 请求标识,必须与加锁时一致* @return 是否释放成功*/public boolean releaseLock(String lockKey, String requestId) {// Lua脚本保证原子性:先判断值是否匹配,再删除String script = "if redis.call('get', KEYS[1]) == ARGV[1] then return redis.call('del', KEYS[1]) else return 0 end";Object result = jedis.eval(script, Collections.singletonList(lockKey), Collections.singletonList(requestId));// Redis Lua脚本返回的是Long类型return Long.valueOf(1).equals(result);}

}上述代码通过执行一段Lua脚本来安全地释放锁。脚本首先检查锁的持有者是否是当前请求,只有在匹配的情况下才执行删除操作,从而避免了误删。这是实现锁可重入和安全性的关键,也是Redis分布式锁的常用实践。

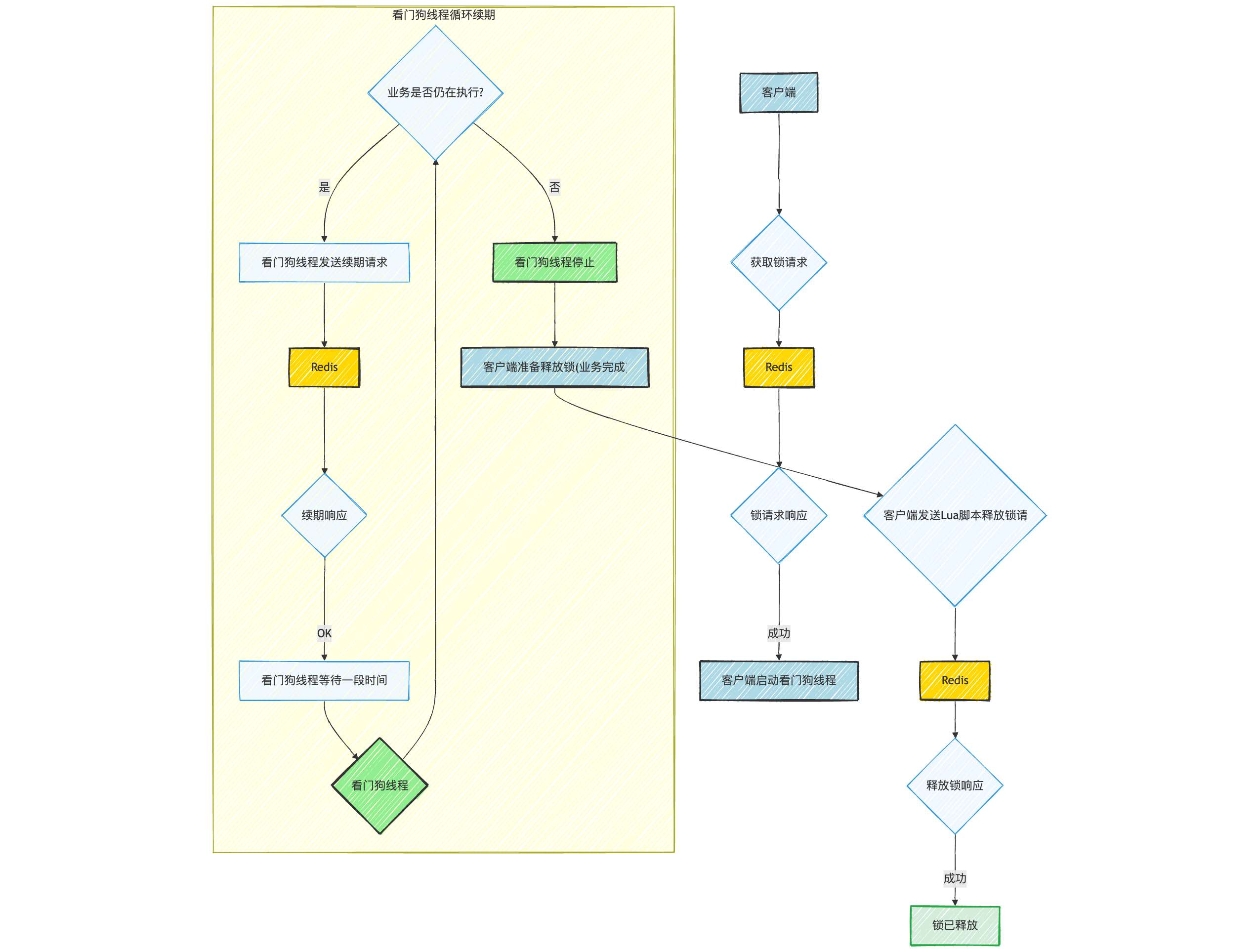

5. 锁的续期:Watchdog机制

我们的方案已经相当完善了,但还有一个问题:锁的过期时间到底设置多长合适?设置太短,业务可能没执行完锁就过期了;设置太长,万一服务宕机,资源被锁定的时间就会过长。为了解决这个两难问题,我们可以引入“自动续期”机制,也常被称为“看门狗”(Watchdog)。

原理

当一个客户端成功获取锁后,我们启动一个后台线程(看门狗)。这个线程会定期检查客户端是否还持有锁,如果持有,就为这个锁延长过期时间。例如,每隔锁过期时间的三分之一,就给锁续期。当客户端的业务逻辑执行完毕,正常释放锁后,这个看门狗线程也会随之停止。如果客户端宕机,看门狗线程自然也消失了,也就不会再为锁续期,锁在过期后会自动释放。知名的Java Redis客户端Redisson就内置了这种强大的看门狗机制,它大大简化了我们实现可靠分布式锁的复杂度。

上图展示了Redis分布式锁中看门狗(Watchdog)的续期机制。它通过后台线程周期性地为锁续期,解决了锁过期时间难以设置的问题。

三、 另一种选择:基于Zookeeper的分布式锁

我们花了大量篇幅讨论了基于Redis的分布式锁,因为它在性能上确实非常出色。但Redis的锁并非绝对可靠,例如在Redis主从切换的特定时刻,可能会导致两个客户端同时获取到锁。虽然通过RedLock算法可以增强其可靠性,但实现也更复杂。如果我们追求的是绝对的可靠性和一致性,那么就不得不提另一个重量级选手——Zookeeper。

Zookeeper是一个为分布式应用提供一致性服务的软件,它的数据模型是一棵树状的节点结构(ZNode)。基于Zookeeper的特性,我们可以非常可靠地实现分布式锁。它就像是我们公司里那位德高望重、说一不二的行政总管,他来管理“灵感小屋”的钥匙,绝对不会出错。虽然找他办事流程可能多一点(性能稍差),但绝对稳妥。让我们看看他是怎么做的。

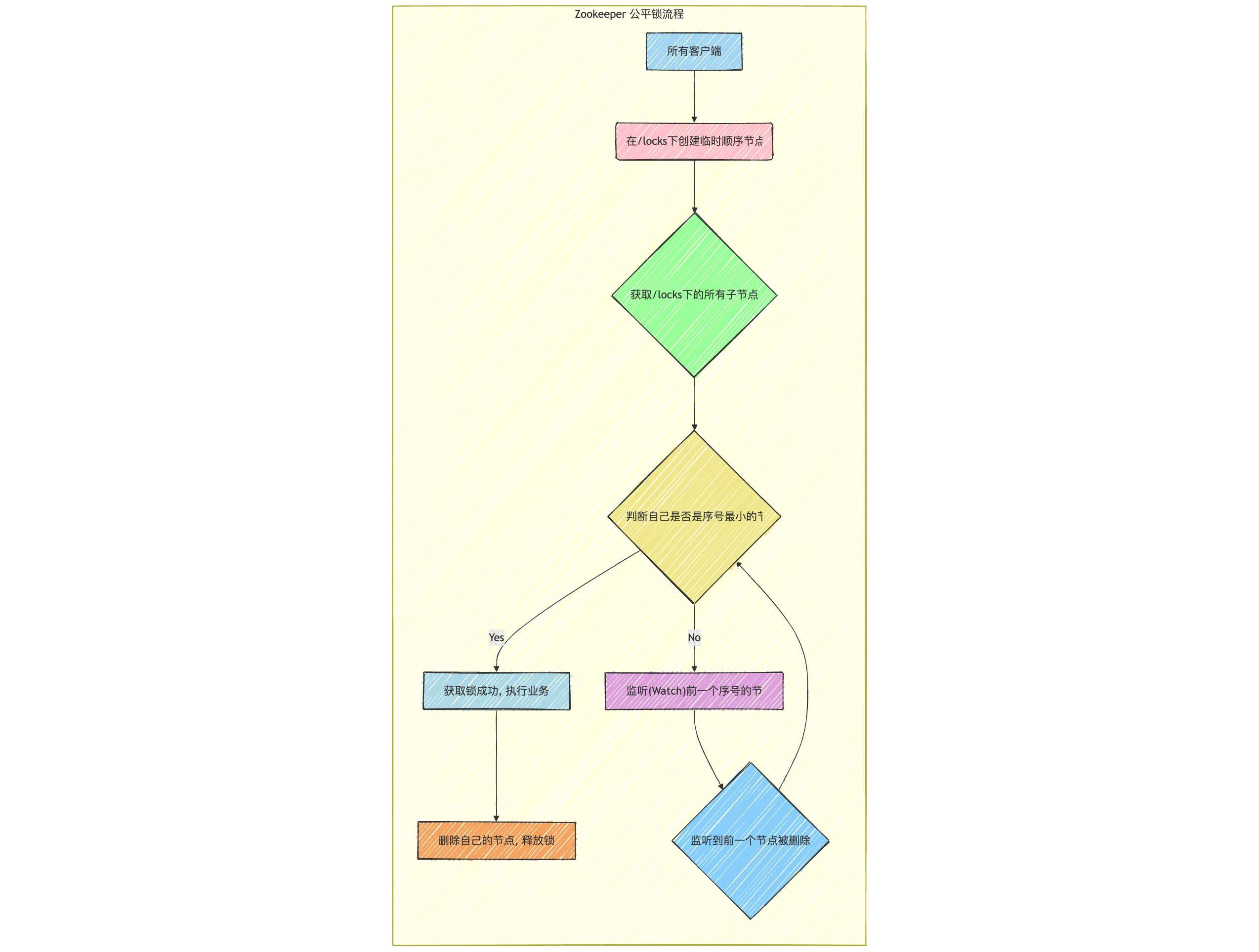

Zookeeper锁的实现原理

Zookeeper实现分布式锁主要利用了它的两个特性:

- 临时节点(Ephemeral ZNode):客户端与Zookeeper的会话结束时,这个节点会自动被删除。这完美地解决了服务宕机导致死锁的问题。只要创建锁的客户端宕机,会话断开,锁节点自动消失。

- 顺序节点(Sequential ZNode):在创建节点时,可以在路径后加上一个递增的序号。这个特性可以避免“惊群效应”,并能轻松实现公平锁。

执行流程(公平锁)

上图清晰地展示了基于Zookeeper实现公平分布式锁的完整流程。通过临时顺序节点和监听机制,确保了锁的可靠性和公平性。

- 在一个指定的父节点下(例如

/locks),每个想要获取锁的客户端都尝试创建一个临时顺序节点,比如/locks/lock-0000000001,/locks/lock-0000000002。 - 创建节点后,客户端获取

/locks下的所有子节点列表,并判断自己创建的节点序号是否是最小的。 - 如果是最小的,那么该客户端就成功获得了锁。

- 如果不是最小的,说明锁在别人手里。客户端需要找到比自己序号小的前一个节点,并对它注册一个“监听器”(Watcher)。这里是关键,只监听前一个,而不是所有前面的节点,避免“惊群效应”。

- 然后,客户端就进入等待状态。当它的前一个节点被删除时(即前一个客户端释放了锁),Zookeeper会通知该客户端。

- 客户端收到通知后,再次检查自己是否是当前最小的节点。如果是,就获取锁;如果不是,就继续监听前一个节点(这种情况在网络抖动或有其他客户端插队时可能发生,但Zookeeper的强一致性保证了最终正确性)。

- 业务执行完毕后,客户端只需删除自己创建的那个临时节点,就完成了锁的释放。由于是临时节点,即使客户端宕机,该节点也会自动消失,从而避免死锁。

Zookeeper锁的优缺点

-

优点:

- 高可靠性: 基于Zookeeper的强一致性模型,不存在Redis锁可能遇到的超时、主从切换等问题,锁的持有和释放非常可靠。

- 解决死锁: 临时节点机制天然解决了客户端宕机导致的死锁问题,无需额外的续期机制。

- 公平锁: 顺序节点机制可以轻松实现公平锁,保证了请求的顺序性。

- 避免惊群效应: 只监听前一个节点,而不是所有节点,有效减少了不必要的通知。

-

缺点:

- 性能开销: 每次加锁和解锁都涉及到网络I/O和Zookeeper集群的写操作(创建/删除节点),性能相较于Redis较低。尤其是在高并发场景下,Zookeeper的吞吐量可能成为瓶颈。

- 复杂性: 实现相对复杂,通常需要借助Apache Curator等成熟的客户端框架来简化操作和处理各种异常情况。

- 部署和维护成本: Zookeeper集群的部署和维护相对复杂,需要专业的运维知识。

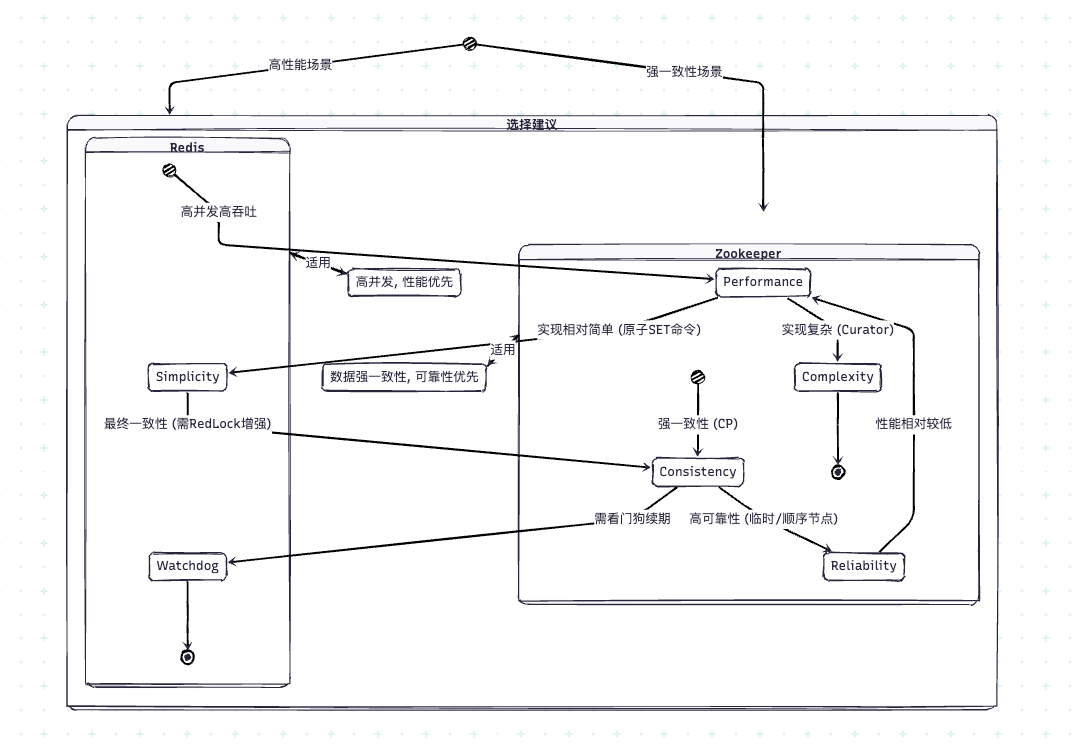

四、 方案对比与总结

经过上面的详细分析,相信大家对基于Redis和Zookeeper的分布式锁都有了深入的了解。它们就像是工具箱里的两把不同的锤子,各有适用的场景。选择哪种方案,取决于你的具体业务需求和对性能、可靠性的权衡。

上图是一个状态图,对比了Redis和Zookeeper分布式锁的核心特性、优缺点和适用场景。它能帮助我们直观地理解两种方案的差异。

我通常是这样建议的: 如果你的业务场景对并发性能要求极高,并且能容忍极低概率下的锁失效问题(例如,缓存重建、防重提交等),那么Redis分布式锁是你的不二之选。通过原子命令和Lua脚本,以及看门狗机制,它能提供一个高性能且相对可靠的解决方案。但如果你的业务涉及到资金、库存等绝对不能出错的场景,对数据一致性的要求高于一切,那么Zookeeper分布式锁会是更稳妥、更可靠的保障。虽然它的性能可能不如Redis,但其提供的强一致性保证是无与伦比的。

结尾:全文回顾

通过今天的讨论,我们从一个生活中的小例子出发,深入探索了分布式锁的奥秘。希望大家对这个话题有了新的认识,让我们共同进步,不断探索新技术。下面我们来回顾一下今天的主要内容,它将帮助你构建一个清晰的知识体系:

-

开篇: 通过“共享会议室钥匙”的例子,生动地引入了分布式锁的核心概念——互斥,并指出了分布式环境下的挑战。

-

Redis分布式锁的进化史:

- 从最初的

SETNX方案出发,认识到其死锁风险。 - 分析了

SETNX + EXPIRE的非原子性缺陷。 - 介绍了使用

SET key value NX EX timeout原子命令的终极加锁方案,并通过代码示例和流程图进行了详细说明。 - 探讨了使用Lua脚本和唯一ID来保证安全释放锁的重要性,并辅以序列图解释了误删的风险和Lua脚本的原子性。

- 引入了“看门狗”机制,通过序列图展示了其自动续期的原理,解决了锁超时时间设置的两难问题。

- 从最初的

-

Zookeeper分布式锁的原理:

- 利用“临时节点”天然解决死锁问题。

- 利用“顺序节点”和“监听器”机制实现公平锁,避免惊群效应,并通过流程图详细阐述了其工作机制。

-

方案对比与总结: 对比了Redis和Zookeeper两种方案的优缺点和适用场景,通过状态图直观展示了它们的特性,帮助大家在实际工作中做出更合适的选型。

希望能帮助大家少走弯路,让我们共同打造更高效、更可靠的技术解决方案。通过今天的分享,希望能给大家带来一些启发。欢迎随时交流,一起分享经验!