智能机器人学习:智能机器人环境感知传感器介绍

一、环境感知传感器:机器人的“外部感官系统”

这类传感器模拟人类五官功能,赋予机器人观察和理解外部世界的能力:

1、视觉传感器:环境感知的核心

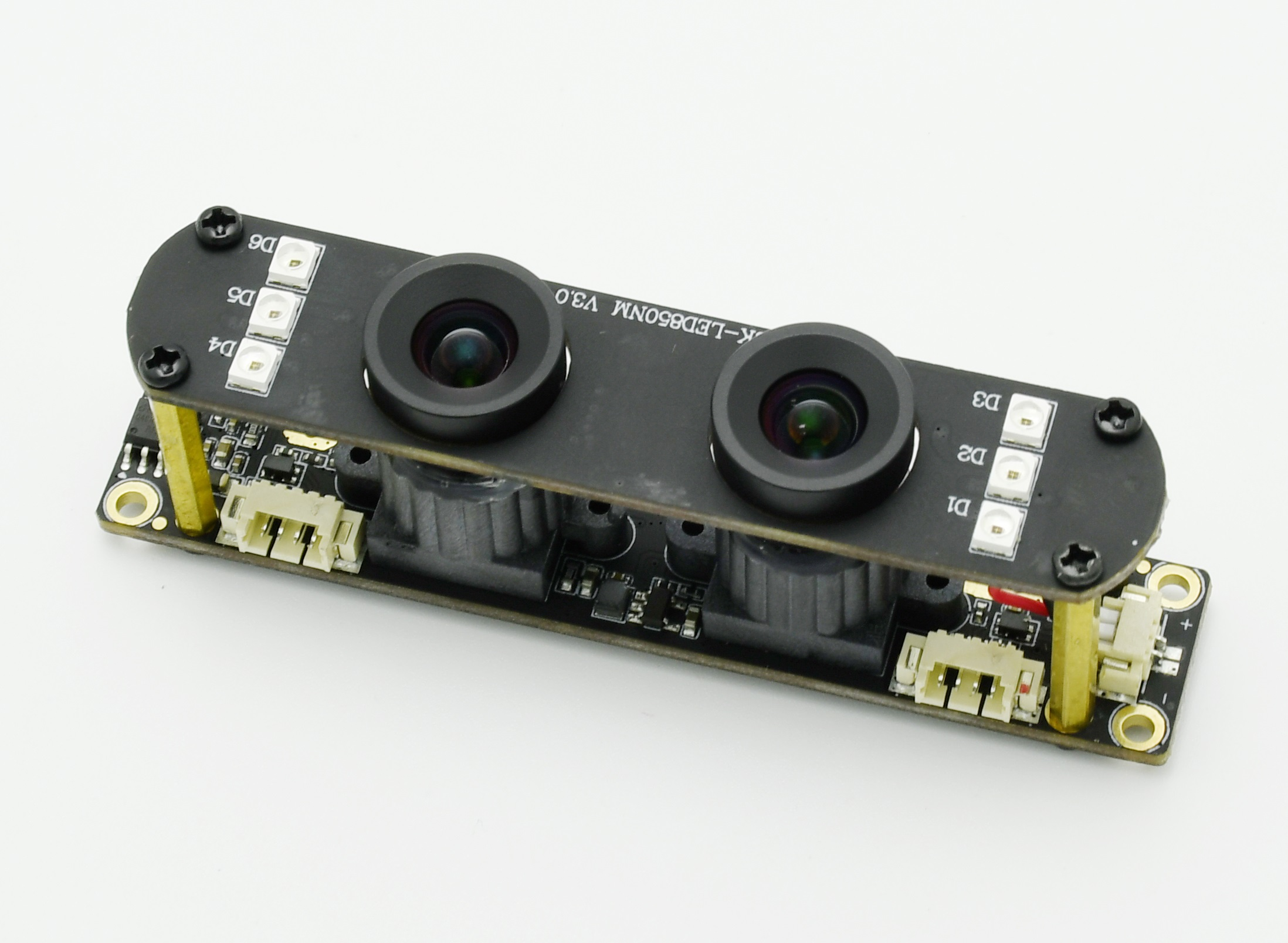

双目视觉系统:通过仿生双眼视差原理(如舜宇的方案),采用双摄像头+深度算法生成RGB-D点云数据,视场角达120°,帧率60fps以上,实现毫米级精度避障和物体识别。

3D视觉系统:如北京团队的“Humanoid Occupancy系统”,结合语义占用表征技术,对三维空间进行精细化建模,使机器人能识别复杂场景中的动态物体(如行走时避开突然出现的儿童)1。

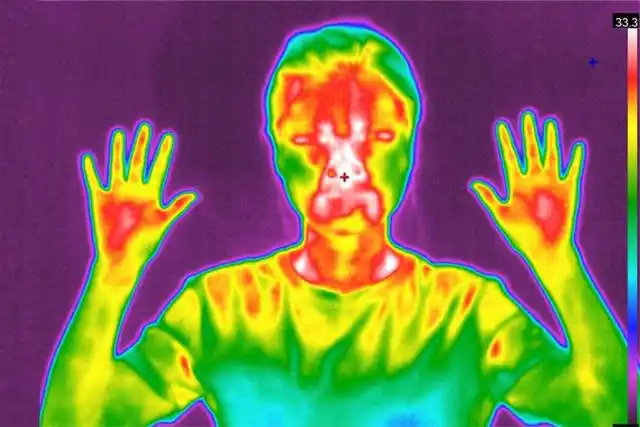

红外/热成像:汉威科技的非制冷红外热成像模组,可穿透烟雾识别热源,在火灾救援场景中定位被困人员3。

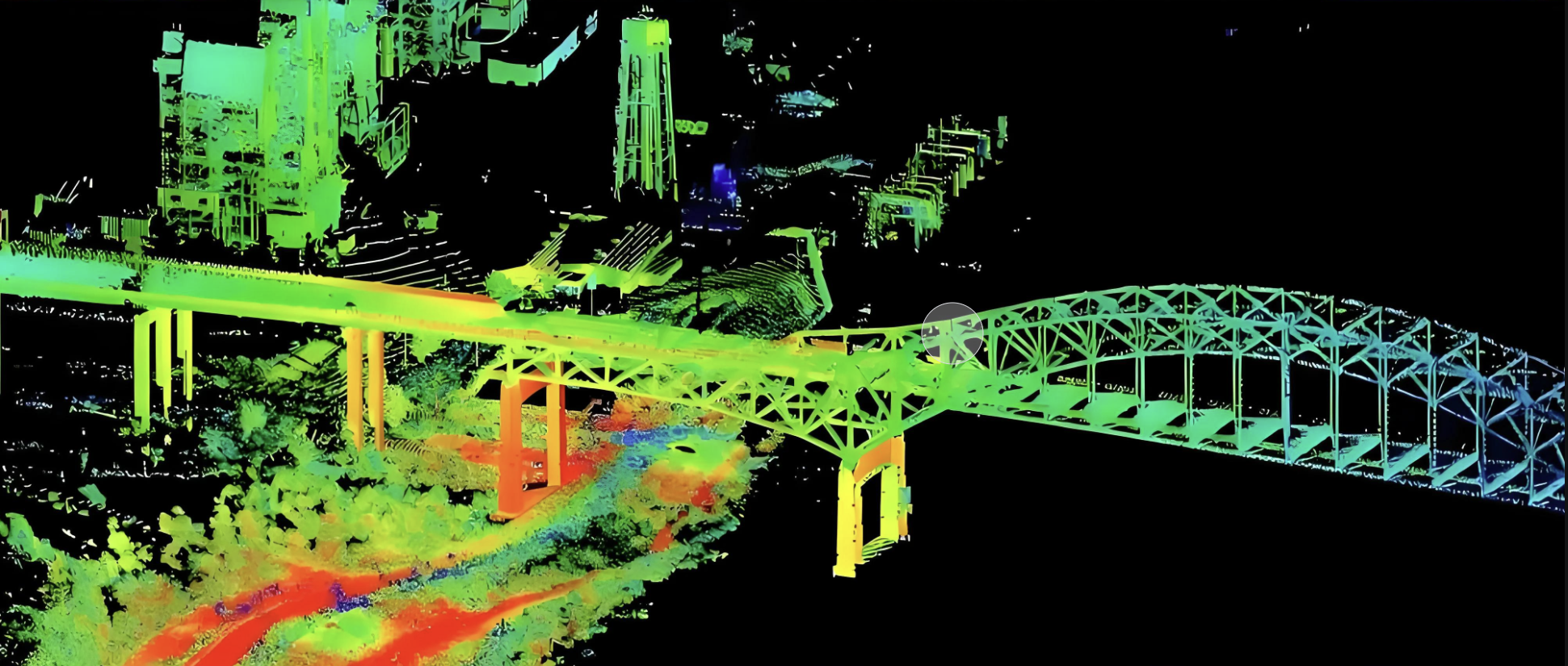

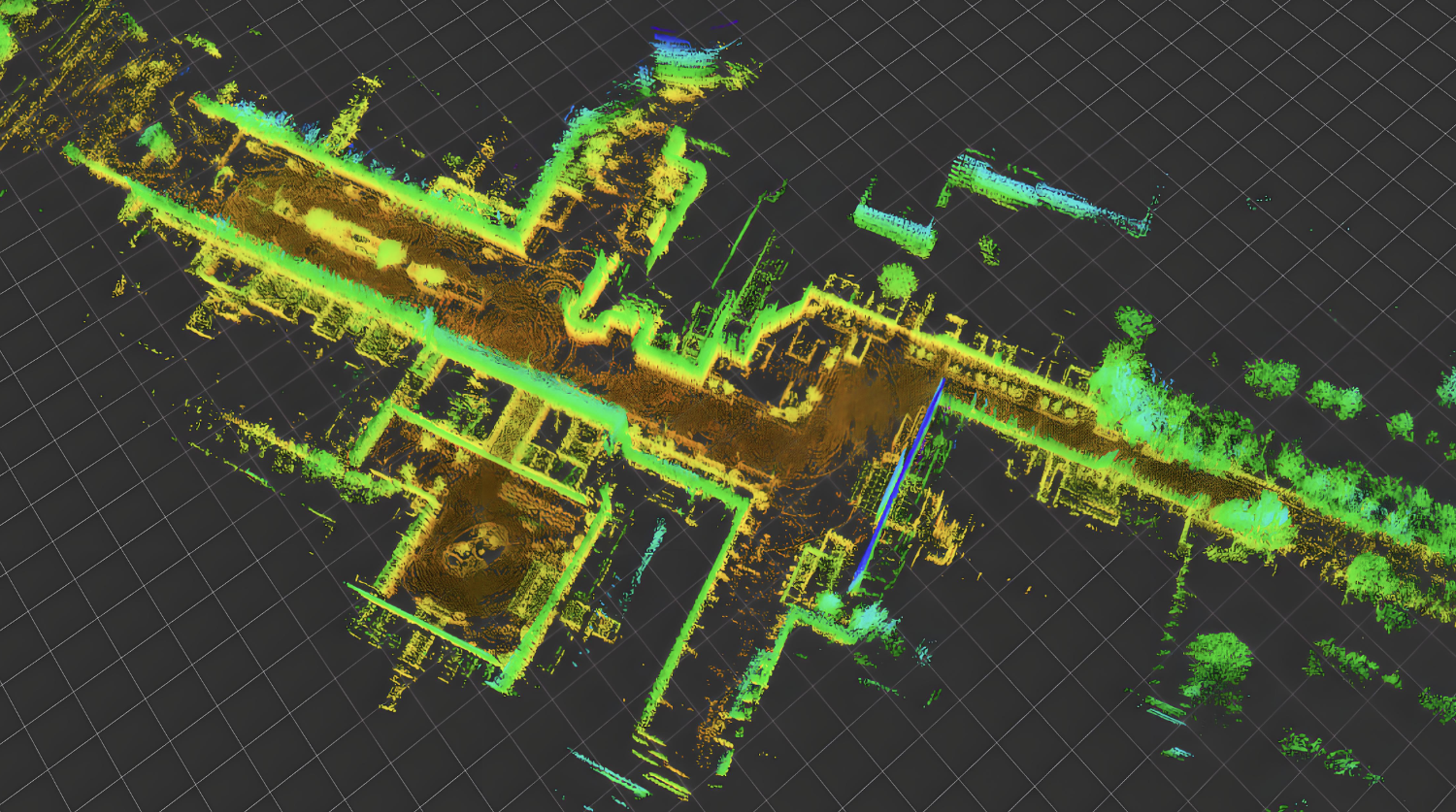

激光雷达(LiDAR):空间测绘的核心

扫描原理:通过TOF(飞行时间)或三角测距法(如速腾聚创Airy雷达),实现360°×90°半球形扫描,探测距离120米,点云密度172万点/秒7。

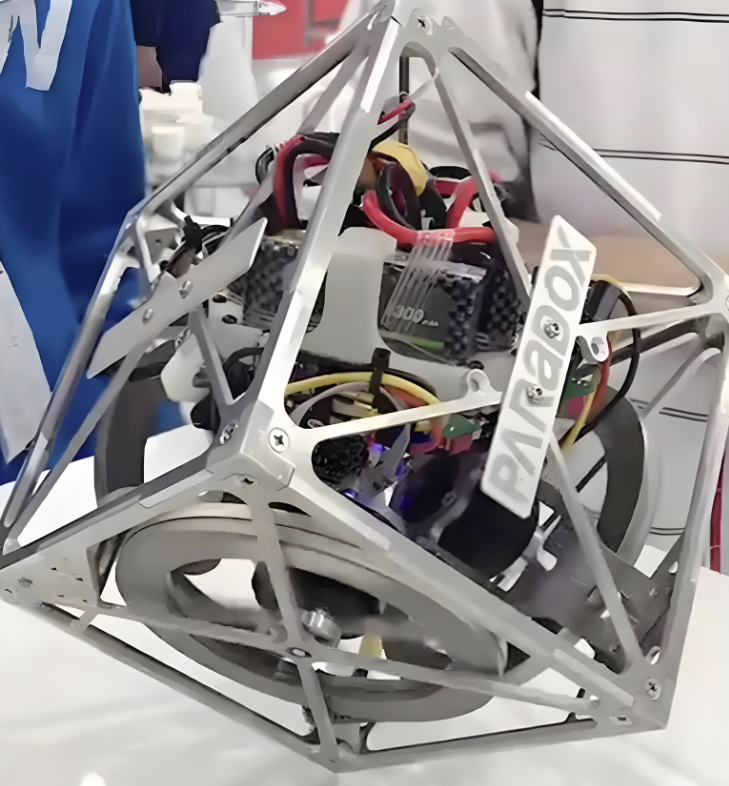

固态化趋势:MEMS微振镜替代机械旋转部件(如越疆DOBOT Atom所用),体积缩小50%,抗振动性提升3倍,更适合人形机器人头部集成78。

SLAM应用:结合IMU与轮式里程计,构建实时环境地图。例如VICP算法校正运动畸变,使机器人在不平地面行走时保持定位精度8。

听觉与环境传感器:理解环境语义

麦克风阵列:6-8麦克风组成波束成形系统,定位声源方向±3°内(如识别“救命”声方位)4。

电子鼻技术:汉威的MEMS气体传感器,通过AI算法识别500+种气体,检出率ppm级。应用场景包括厨房煤气泄漏预警或医疗场景的酮症呼气检测23。

表:环境感知传感器关键参数对比

传感器类型 | 关键参数 | 应用场景 | 代表产品/技术 |

双目视觉 | 精度0.1mm@1m, 帧率60fps | 精细抓取、避障 | 舜宇RGBD融合方案6 |

固态LiDAR | 视场角360°×90°, 点云172万点/秒 | 动态建图、定位 | 速腾聚创Airy7 |

MEMS气体传感器 | 检测精度1ppm, 识别气体500+种 | 危险气体监测、医疗诊断 | 汉威“电子鼻”3 |

✋ 二、身体感知传感器:机器人的“本体神经”

实现精细动作控制和安全交互的核心,分布在机器人体表与关节:

触觉传感器:电子皮肤技术

指尖触觉阵列:汉威科技的柔性传感器采用石墨烯薄膜,厚度<0.5mm,可检测1mN羽毛级压力(相当于蚊虫停落的力度),覆盖指腹90%曲面25。

三维力传感:同步测量法向/剪切力,精度0.1%,用于拧瓶盖时防滑控制(如旋转力矩超过阈值自动调整握力)3。

力觉与本体感知:运动控制基础

六维力传感器:安装在关节处的MEMS器件,测量XYZ轴力/力矩,带宽1kHz。确保单腿站立时实时调整重心35。

惯性测量单元(IMU):MPU9250等芯片集成三轴陀螺仪+加速度计+磁力计,通过卡尔曼滤波(ESKF算法)融合数据,姿态解算误差<0.1°8。

应变片与编码器:贴片式应变计测量金属结构形变;光电编码器在关节电机中反馈位置,分辨率达0.01°58。

🔄 三、多传感器融合技术:感知智能的核心挑战

单一传感器存在局限(如视觉受光照影响、LiDAR对玻璃失效),融合提升鲁棒性:

融合方法演进

前端级融合:原始数据层合并(如RGB图像+LiDAR点云配准),需时间同步精度≤10ms1。

后端决策融合:各传感器独立处理再汇总(如视觉识别物体+触觉确认材质),降低系统耦合度4。

算法框架实例

SLAM系统:激光雷达建图+IMU运动补偿+轮式里程计,采用因子图优化(g2o框架),定位误差降至厘米级8。

具身感知方案:汉威“触觉-嗅觉-力控”联动,例如抓取水果时触觉判断硬度+嗅觉检测成熟度3。

技术挑战

数据冲突:视觉识别为“墙”但LiDAR穿透(实际是窗帘),需置信度加权4。

计算负载:172万点云+1080P图像处理需100TOPS算力,催生3D堆叠芯片技术(内存带宽提升5倍)5。

📚 四、学习路径建议:从理论到实践的阶梯

基础阶段

必学硬件:IMU(MPU6050)、RGB-D相机(Intel RealSense)、单线雷达(RPLIDAR)8。

理论入门:《机器人学中的状态估计》+《计算机视觉:算法与应用》。

进阶实践

ROS开发:编写激光雷达滤波节点(laser_filters包),实现动态障碍物去除8。

标定实战:双目相机外参标定(使用checkerboard图案),IMU温度漂移补偿。

系统集成

复现SLAM:在TurtleBot上实现Gmapping算法8。

表:人形机器人工程师技能进阶路径

阶段 | 核心学习内容 | 实践项目 | 目标能力 |

基础 | 传感器原理、ROS基础、电路设计 | Arduino读取IMU数据 | 理解数据手册与接口协议 |

中级 | SLAM算法、滤波理论、机械设计 | 搭建差分底盘实现自主导航 | 多传感器标定与故障诊断 |

高级 | 深度学习、强化学习、仿生控制 | 设计灵巧手抓取策略(触觉+视觉反馈) | 全栈系统优化能力 |

🔮 五、未来发展趋势:技术爆发临界点

短期(5年):仿生皮肤材料突破,触觉点密度提升至100/cm²(接近人类指尖)5;

中期(15年):神经形态传感器普及,事件相机(Event Camera)替代传统CMOS,动态响应延迟降至微秒级4;

长期(30年):多模态具身智能实现,传感器与AI模型联合优化(如触觉信号直接生成运动控制指令)45。

要深入动手实践,可关注2025世界机器人大会展示的汉威触觉方案(C馆C612)2或复现舜宇双目视觉demo代码。人形机器人的感知系统如同人类神经系统的外延,需将物理信号转化为行动智慧——这既是技术挑战,也是工程师创造力的舞台。