使用Ollama,VLLM,LMDeploy部署大模型

1.ollama

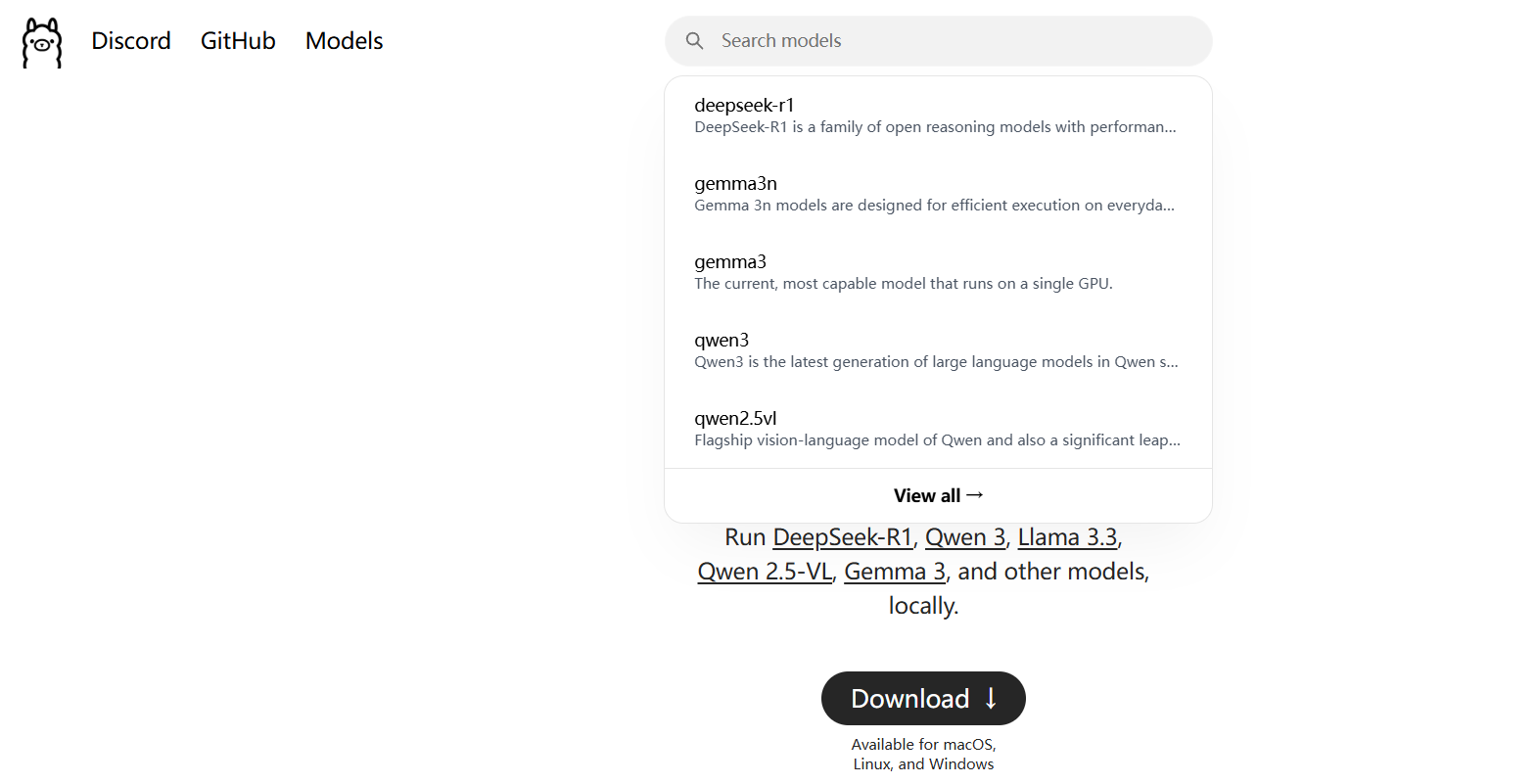

Ollama

这个工具适合个人自己部署大模型,因为他支持的模型比较小,而且只支持特定的模型,可以在搜索框找到的即可

下载支持Linux,widows,macOS

这边使用Linux平台,将下载命令放到终端运行即可(建议创建一个虚拟环境)

curl -fsSL https://ollama.com/install.sh | sh开启服务:

ollama run 模型的绝对路径建议使用vscode,因为可以开启多个终端,ollama启动后不能关闭,新建一个终端执行对话

运行示例代码:其中qpi_key是随便写的,因为ollama的api_key是公共的,想写什么都可以,但是不能不写,不写会报错

from openai import OpenAIclient=OpenAI(base_url="http://localhost:11434/v1/",api_key="jdiaojnkca")

chat_completion=client.chat.completions.create(messages=[{"role":"user","content":"你好,请介绍下你自己"}],model="qwen2.5:0.5b"

)

print(chat_completion.choices[0])2.VLLM

欢迎来到 vLLM! | vLLM 中文站

一般都在服务器上使用,如果是非CUDA的用户请按照要求参考文档操作

系统: Linux Python: 3.9 -- 3.12 创建一个新的虚拟环境,以防有些包与其他的冲突(冲突有时候解决很麻烦,因为可能你换了合适的版本之后又会有别的包冲突,遇到过几次,折磨怕了),所以建议友友们有条件还是尽量创建一个新的虚拟环境

依次执行这三条命令

conda create -n vllm python=3.12 -y

conda activate vllm

pip install vllm然后在vscode终端输入

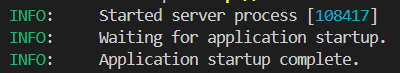

vllm serve Qwen/Qwen2.5-1.5B-Instruct(这个要写模型存放的绝对路径)然后等待下载需要的包和资源,当出现下面这种,就可以新开一个终端你要执行的代码,开启会话

3.LMDeploy

https://lmdeploy.readthedocs.io/zh-cn/stable/index.html

这个其实和vllm类似,不过要注意这个要求,要求使用的显卡,只有在sm70以上的才可以

conda create -n lmdeploy python=3.8 -y

conda activate lmdeploy

pip install lmdeploylmdeploy serve api_server 模型的绝对路径开启服务后,新建终端,激活创建的虚拟环境,运行代码文件,python 文件名.py

from openai import OpenAI

client = OpenAI(api_key='YOUR_API_KEY',base_url="http://0.0.0.0:23333/v1"

)

model_name = client.models.list().data[0].id

response = client.chat.completions.create(model=model_name,messages=[{"role": "system", "content": "You are a helpful assistant."},{"role": "user", "content": " provide three suggestions about time management"},],temperature=0.8,top_p=0.8

)

print(response)