从云平台到系统内核:SmartMediakit如何重构实时视频系统

一、引子:实时视频的第二曲线

当我们谈论“直播”时,许多人仍停留在“视频播放”的层面。然而在工业、教育、安防、无人系统等领域,实时视频早已不再是娱乐或信息传递的手段,而是 系统神经的一部分。

从摄像头采集、边缘节点处理,到算法推理与控制反馈,每一帧视频的传递都意味着一次决策。

时间,就是系统的神经信号。

传统的云平台直播方案提供了极高的接入便利性,但它更像一个“外部服务”——统一、封装、不可控。而当企业需要把视频能力嵌入自身系统、让视频流成为“数据流”的一部分时,平台化方案的便利性,反而变成了系统化演进的瓶颈。

于是,一个新的趋势正在出现:

从“云服务”回归“系统内核”,从“使用功能”走向“掌控能力”。

这正是 SmartMediaKit 的设计初衷:

它不是一个云服务,而是一套可嵌入、可重构、可演进的实时音视频系统引擎。

二、技术观:从“功能堆叠”到“系统秩序”

SmartMediaKit 的架构核心,不在于“支持多少协议”,而在于“让时间链路保持秩序”。

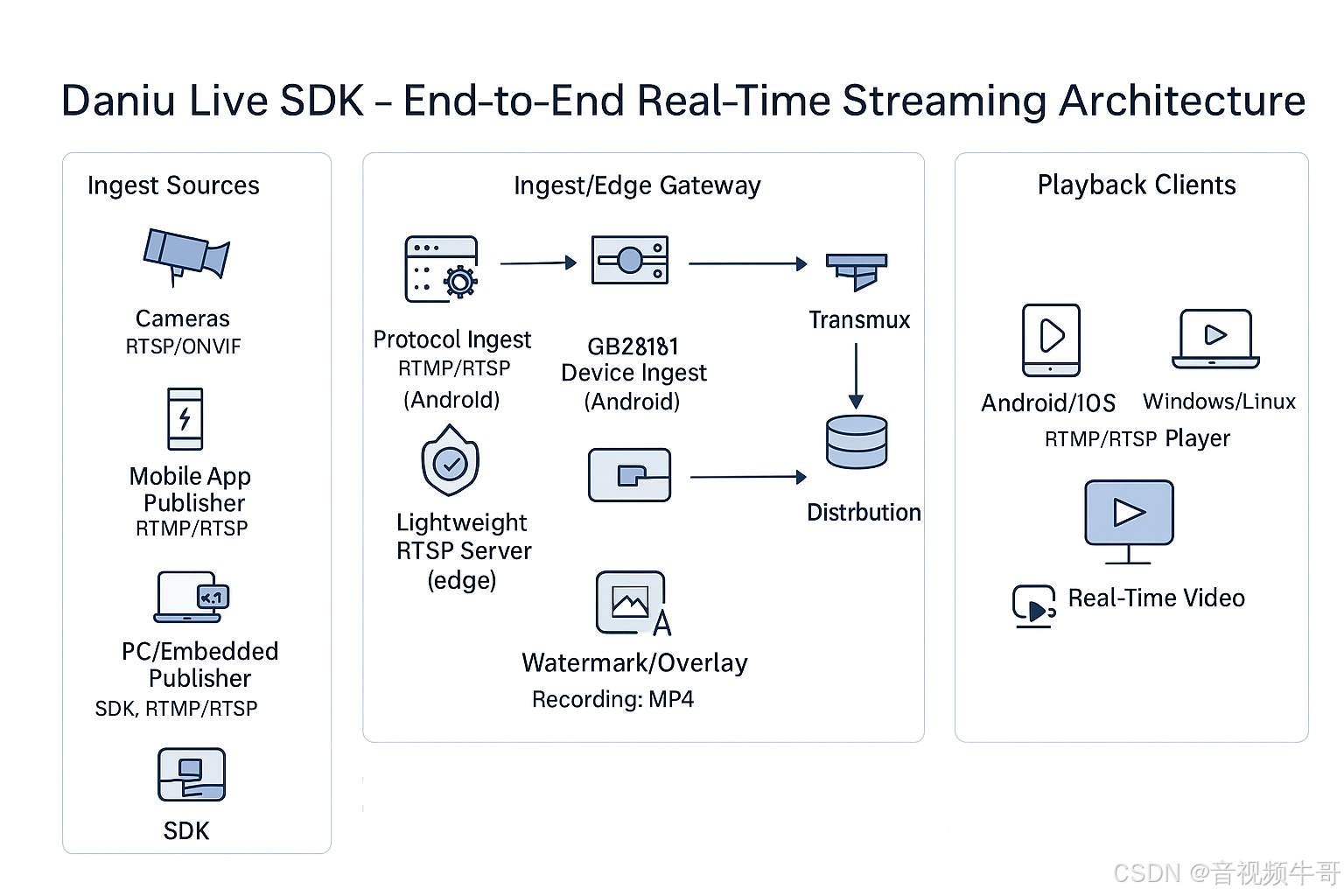

它以模块化架构为基础,覆盖从 采集 → 编码 → 传输 → 播放 → 录制 → 分发 → AI扩展 的完整链路。每个模块既可以独立运行,也可以被组合成一个可控的系统单元。

其技术哲学可以概括为三句话:

-

Everything is localizable(所有能力可本地化)

无论在移动端、嵌入式、服务器还是边缘节点,都能独立运行。

这意味着视频链路可以深入设备,而不依赖云的“黑盒控制”。 -

Everything is replaceable(每个模块可替换)

推流、播放、转发、服务、GB28181 接入、SEI 扩展等模块均可单独授权与部署,

企业可按需构建最轻或最强版本的系统。 -

Everything is measurable(时间与延迟可量化)

端到端链路延迟稳定在 100~200ms,

SEI 模块可对齐时间戳与 AI 元数据,实现毫秒级同步。

这种“系统秩序”的设计,使 SmartMediaKit 不仅是一套 SDK,更像是一个微型的 视频操作系统内核。

三、底层能力:毫秒级实时链路的实现逻辑

在实时系统中,延迟不是“体验问题”,而是“系统能否成立的问题”。SmartMediaKit 的底层设计以“时间秩序”为核心,从采集、传输、解码到渲染的每个环节,形成一条可控、可观测、可校准的时间链路。

1. 技术特性

-

稳定低时延链路:针对实时业务场景优化的端到端调度机制,常规延迟可控在 100–200 ms。

-

连续性与抗抖动:在弱网环境下通过时间序列修正与流量平滑处理,保障画面流畅与音画同步。

-

弹性码控:根据场景动态调节码率与分辨率,优先保障关键画面与交互响应。

-

模块化集成:推流、播放、转发、存储、设备接入可按需组合,实现灵活部署与快速集成。

-

跨平台一致性:Android、iOS、Windows、Linux、Unity3D 全平台接口统一,表现一致。

-

工程级可用性:内置断线重连、异常恢复与状态监测机制,支持大规模运行与长期运维。

2. 智能时间序对齐机制

多线程与网络波动常导致音视频时间漂移。SmartMediaKit 通过智能时间序校正机制与动态时钟协调策略,在采集、编码、传输、渲染全链路维度保持毫秒级的时间一致性,确保画面与声音的严格对齐。

3. 多协议融合内核

SmartMediaKit 支持 RTMP、RTSP、HTTP-FLV、WebSocket-FLV、GB28181 及 MP4 录制等多种协议。底层采用统一的数据流调度与分发架构,在不同协议间共享资源、统一调度逻辑,实现高效的数据流转与带宽利用。

4. 边缘优化与轻量部署

SmartMediaKit 模块具备出色的可移植性与轻量化特征,可运行于嵌入式 Linux、麒麟、Android、iOS、Windows 等多种系统环境。适合部署于无人机、工业网关、车载终端、摄像头 SoC 等资源受限设备中,为边缘节点提供实时、安全、稳定的音视频支撑能力。

四、模块体系:一个可生长的系统

SmartMediaKit 的核心在于可组合架构。每个模块既能独立运行,也能协同构建完整链路,形成从设备到平台的实时视频系统。

-

RTMP 推流模块

支持摄像头、屏幕、麦克风及外部编码流推送,具备软硬编切换、码率自适应、断线重连与多分辨率输出,可用作直播引擎或工业数据上传节点。 -

多协议播放模块(RTSP / RTMP / HTTP-FLV)

统一播放接口,端到端延迟 100–200 ms,可硬件解码、帧级回调、截图与缩放,适配 Android、Windows、Linux、Unity3D 等多端场景。 -

轻量级 RTSP 服务模块

无复杂依赖,可在本地或边缘节点快速启用,使设备端直接输出 RTSP 流,构建内网级实时分发。 -

多路转发模块(RTSP→RTMP / RTSP|RTMP→GB28181)

支持多通道并发拉流与集中转推,适用于安防与监控系统的多摄像头聚合与集中分发。 -

GB28181 接入模块

让不具备国标能力的移动或嵌入式终端快速接入,支持位置订阅、图像抓拍、语音对讲、录像回放等。 -

录像模块(推送端 / 播放端)

支持边推边录、断点续录与 MP4 / FLV 封装,音视频同步记录,满足安防、金融、工业等场景的合规要求。 -

SEI 扩展模块

支持时间戳、AI 元数据与传感信息嵌入,实现视频内容与算法结果的毫秒级同步。 -

跨平台一致性

统一 API 设计,兼容 Windows、Linux(含麒麟)、Android、iOS、Unity3D,保障多端一致与快速集成。

安卓RTMP播放器同时播放4路RTMP流延迟测试

五、商业逻辑:从“租用服务”到“拥有能力”

相较平台化方案,SmartMediaKit 的核心优势在于控制权与可演进性。

它让企业从被动租用云服务,转向主动掌握系统能力。

-

成本可控,收益长期化

云端方案按流量、并发计费,规模越大成本越高。

SmartMediaKit 采用一次性模块授权,成本固定且可线性扩展,

在大规模或长期业务中,总体投入可减少 60%–80%。 -

系统主权与安全合规

面向安防、能源、医疗、政务等高敏场景,SmartMediaKit 支持本地化部署与内网传输。

视频链路、缓存与存储全部在用户系统内完成,确保数据可控、可审计、可合规。 -

可持续演进的系统生态

作为系统级 SDK,SmartMediaKit 能在企业自有生态中持续生长。

可叠加 AI 识别、算法加速、WebRTC 通信、视频云对接等模块,

构建贴合自身业务逻辑的专属视频架构。 -

灵活授权与组合集成

各模块可独立授权、自由组合。

无论是单一推流、播放,还是集成录制、转发、GB28181 接入,

均可一次集成,多场景复用,最大化投资效益。

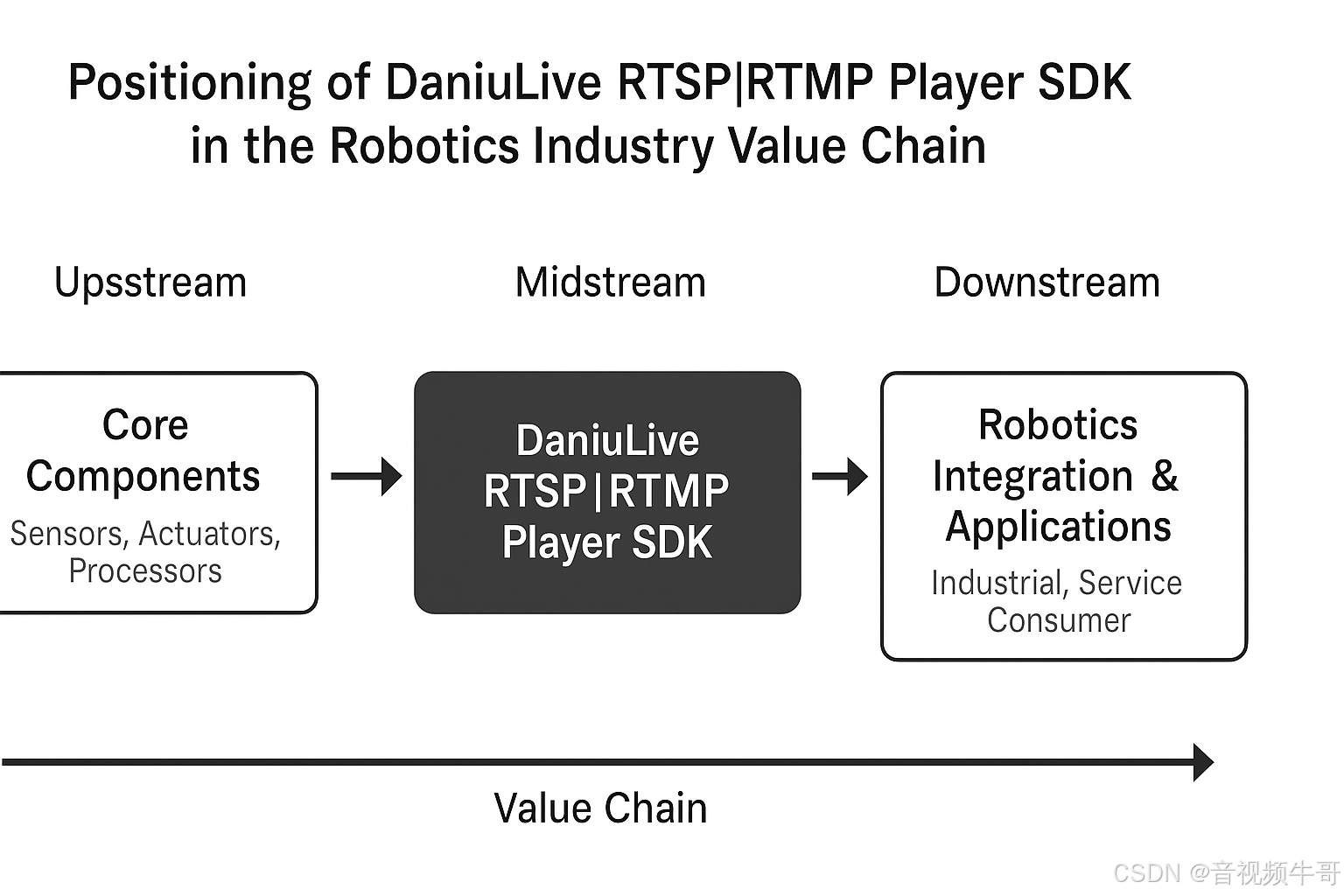

六、应用方向:从实时视频到系统智能

实时视频曾是“看得见”的问题,如今已成为“系统能不能感知”的核心。

SmartMediaKit 不仅是流媒体引擎,更是构建智能系统的视频基座。

它让视频从信息流,转变为可被计算、调度与决策的系统要素。

-

智慧城市与应急指挥

通过 RTSP、GB28181、HTTP-FLV 等模块,实现城市级视频汇聚与多源分发,支撑监控、调度、应急等业务的低延迟协同。 -

无人系统与低空经济

在无人机、无人车、机器人等场景中,SmartMediaKit 提供毫秒级视频链路与本地录制能力,保障“边看边控”的实时反馈,适配复杂网络与移动边缘节点。 -

工业检测与远程运维

结合 AI Adapter 模块,支持实时图像识别、状态检测与异常预警,为制造业、能源、交通等场景提供可靠的视频感知底座。 -

远程医疗与教学培训

通过 RTMP 推流与多协议播放模块,实现低延迟音视频互动与多端同步,满足医疗会诊、实验演示、在线实训等高实时性需求。 -

AI 感知与系统智能化

当视频流与算法流融合,系统不再只是“传输画面”,而是形成“时间驱动的计算节点”。SmartMediaKit 正在成为企业构建 AI-Native 系统的关键连接层——让视频成为智能系统的时间神经。

安卓RTSP播放器多实例播放时延测试

七、结语:系统智能的时间秩序

在大牛直播SDK(SmartMediaKit)的体系中,“实时”并非一个抽象的目标,而是一条从采集到呈现的完整链路。我们把时间当作系统的骨架,让每一帧画面、每一段音频都能按既定秩序到达。

只有当时间是稳定的,系统的智能才能被信任。

经过多年的演进,大牛直播SDK 已形成一套可直接嵌入业务系统的通用能力:

-

从 RTMP 推流、RTSP 播放 到 HTTP-FLV / WS-FLV 分发,

-

从 GB28181 设备接入 到 录像、转发、边缘节点部署,

-

从 AI Adapter 到 跨平台接口(Windows / Linux / Android / iOS / Unity3D)。

这些模块共同构成了一个稳定可控、可组合扩展的实时视频系统。

它既能在城市级平台上运行,也能部署在无人机、机器人、工业相机等边缘设备中,

支撑安防监控、远程控制、工业检测、远程医疗、教育培训等多种行业场景。

我们相信,未来的智能系统不是堆叠功能,而是管理时间的系统。

当每一条视频流都能在毫秒级精度下被采集、传输、分析与决策,

实时链路便成为整个系统智能的基础。

这正是大牛直播SDK 的使命:让视频系统更稳定,让时间链路更精准,让智能真正“跟上现实”。

📎 CSDN官方博客:音视频牛哥-CSDN博客