宽依赖的代价:Spark 与 MapReduce Shuffle 的数据重分布对比

MapReduce与Spark Shuffle过程对比:大数据处理中的洗牌机制分析

🌟 你好,我是 励志成为糕手 !

🌌 在代码的宇宙中,我是那个追逐优雅与性能的星际旅人。

✨ 每一行代码都是我种下的星光,在逻辑的土壤里生长成璀璨的银河;

🛠️ 每一个算法都是我绘制的星图,指引着数据流动的最短路径;

🔍 每一次调试都是星际对话,用耐心和智慧解开宇宙的谜题。

🚀 准备好开始我们的星际编码之旅了吗?

目录

- MapReduce与Spark Shuffle过程对比:大数据处理中的洗牌机制分析

- 摘要

- Shuffle是什么?为什么它如此重要?

- MapReduce Shuffle:一代经典的设计

- 核心流程剖析

- 设计背后的思考与局限

- Spark Shuffle:青出于蓝的优化

- SortShuffleManager 详解

- SortShuffle普通机制

- SortShuffle Bypass机制

- Spark Shuffle的优势

- 全方位对比:MapReduce vs. Spark

- 总结与展望

- 参考链接

- 关键词标签

摘要

Shuffle是分布式数据处理中的关键环节,其效率直接决定了大规模数据计算的整体性能。作为连接Map和Reduce操作的桥梁,Shuffle负责数据的重新分区、排序和网络传输。本文深入剖析了两种主流大数据框架——Hadoop MapReduce和Apache Spark——在Shuffle机制上的核心设计差异。文章首先详细阐述了MapReduce基于排序和磁盘I/O的经典Shuffle模型,分析了其稳定性和性能瓶颈。随后,重点转向Spark的Sort-based Shuffle机制,探讨其如何通过内存计算、Tungsten引擎以及优化的数据结构,显著提升Shuffle效率,减少磁盘读写开销。通过清晰的流程图、时序图和架构对比,本文直观地展示了两者在数据流、I/O模型和资源利用上的不同策略。此外,文章还通过表格形式对关键特性进行了总结,旨在为读者提供一个关于大数据Shuffle技术演进的全面视角,并为相关技术选型和性能优化提供参考。

Shuffle是什么?为什么它如此重要?

想象一下,你手里有一副被打乱的扑克牌,你的任务是按花色把它们分开,并把相同花色的牌放在一起。这个“整理牌”的过程,在大数据世界里,就是Shuffle。

官方点说,Shuffle是连接Map阶段和Reduce阶段的桥梁。Map阶段负责“分”,将原始数据切分成一个个键值对(Key-Value);而Reduce阶段负责“合”,对相同Key的数据进行聚合处理。Shuffle的核心任务,就是确保所有来自Map阶段的、拥有相同Key的数据,都能准确无误地“奔赴”到同一个Reduce任务中去。这个过程涉及到数据的分区、排序、网络传输和合并,是整个计算流程中最耗时、最复杂的环节之一。可以说,Shuffle的效率,直接定义了大数据处理的性能天花板。

MapReduce Shuffle:一代经典的设计

作为大数据时代的开创者,MapReduce的Shuffle设计思想影响深远。它的核心特点是:稳健、可靠,但严重依赖磁盘I/O。

核心流程剖析

MapReduce的Shuffle过程可以清晰地划分为Map端和Reduce端两个部分。

Map端:

-

环形缓冲区

每个Map任务在启动时都会分配一个环形内存缓冲区,默认大小为100MB。这个缓冲区采用环形设计,能够高效地处理数据的写入和读取操作。当Map函数处理输入数据并生成键值对(Key-Value pairs)时,这些数据会首先被序列化并写入环形缓冲区。

详细工作机制:

序列化过程:Map输出的键值对会先被转换为字节序列,这个过程包括键和值的序列化处理

缓冲区管理:环形缓冲区采用先进先出(FIFO)的策略,新数据写入缓冲区尾部,旧数据从头部读取

内存优化:缓冲区大小可根据任务需求动态调整,平衡内存使用和I/O性能

并发控制:多个Map任务可以并行运行,每个任务拥有独立的缓冲区,避免资源竞争 -

分区与排序

当缓冲区使用率达到一定阈值(如80%)时,会启动一个后台线程,根据Partitioner(分区器)的逻辑对数据进行分区。在每个分区内部,数据会根据Key进行快速排序。

分区处理:

分区器(Partitioner):根据用户定义的分区逻辑,将数据划分到不同的Reduce任务分区

哈希分区:默认采用哈希分区算法,确保相同Key的数据被分配到同一分区

自定义分区:支持用户自定义分区策略,满足特定业务需求

排序机制:

快速排序:在每个分区内部,数据会根据Key进行快速排序,确保数据有序性

内存排序:排序操作在内存中完成,充分利用内存的高效性

稳定性:排序算法保证稳定性,相同Key的数据保持原有顺序 -

溢写(Spill):排序后的数据会被“溢写”到磁盘,生成一个临时的溢写文件。这个过程会不断重复,直到Map任务处理完所有数据,从而产生多个溢写文件。

溢写流程:

触发条件:缓冲区达到阈值或Map任务完成时触发溢写

文件生成:每次溢写生成一个独立的临时文件,包含特定分区的有序数据

压缩处理:溢写文件通常采用压缩格式存储,减少磁盘空间占用

元数据记录:同时记录每个分区的元数据信息,包括数据量、位置等

优化策略:

批量写入:采用批量写入策略,减少磁盘I/O次数

异步操作:溢写过程在后台异步执行,不影响Map任务的继续处理

错误恢复:支持部分失败时的重试机制 -

归并(Merge):最后,Map任务会将所有溢写文件合并(Merge)成一个更大的、已分区且有序的文件。同时,还会生成一个索引文件,用于标记每个分区数据在文件中的位置。

当Map任务处理完所有输入数据后,系统将所有溢写文件进行归并操作,采用多路归并算法高效合并多个有序文件,将所有溢写文件合并成一个更大的、已分区且有序的最终文件。同时生成索引文件记录每个分区数据在文件中的精确位置,索引文件使Reduce任务能够快速定位所需数据,确保数据的完整性和正确性,减少不必要的数据传输和读取操作。

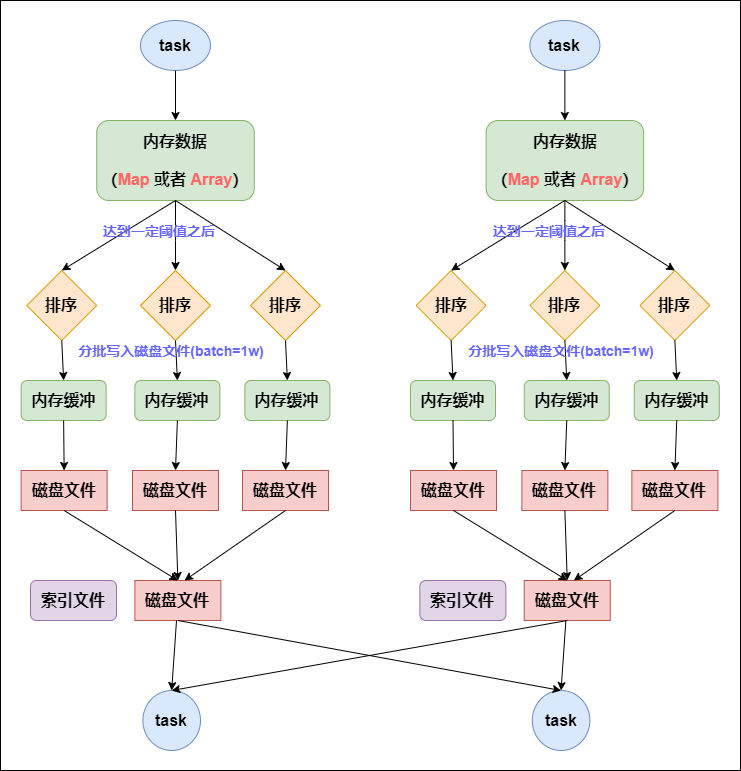

下面这幅图清晰地展示了Map端的整个流程。

图1:MapReduce Map端Shuffle流程图

Reduce端:

- 拉取数据(Fetch):Reduce任务启动后首先从各个Map任务节点获取属于自己的数据分区,通过反向查询Map任务生成的索引文件确定需要拉取的数据位置,使用HTTP协议进行数据传输确保跨节点的可靠通信,同时从多个Map节点并行拉取数据提高传输效率。采用就近原则优先从同一机架或同一数据中心的节点拉取数据,在传输过程中进行数据校验确保数据完整性,支持传输失败时的自动重试机制。

- 内存与磁盘归并:拉取到的数据首先存放在Reduce任务的内存缓冲区中,采用类似Map端的环形缓冲区设计,根据数据量动态调整内存使用策略,优先处理小文件提高整体处理效率。当内存使用率达到阈值时触发磁盘溢写,生成按照Key范围组织的临时文件,采用压缩格式减少磁盘空间占用,确保数据的有序存储和快速访问。

- 最终归并:当所有数据都从Map端拉取完毕后,Reduce任务进行最终的归并排序,采用多阶段归并算法逐步合并小文件,在内存允许的情况下优先使用内存归并,对于大数据量则采用外部排序算法。归并过程先将多个溢写文件按照大小和Key范围进行分组,然后逐步合并小文件再合并大文件,最终确保所有数据按照Key有序排列,为Reduce函数的执行做好准备。

- 执行Reduce:经过归并排序的数据最终被送入Reduce函数进行处理,相同Key的数据被分组在一起进行迭代处理,处理结果写入最终输出文件。整个过程支持流水线处理模式,具备完善的错误检测和恢复机制,提供详细的任务执行监控信息,确保数据处理的高效性和可靠性。

import org.apache.hadoop.io.*;

import org.apache.hadoop.mapreduce.*;/*** 自定义MapReduce分区器 - 按Key的哈希值进行分区*/

public class CustomPartitioner extends Partitioner<Text, IntWritable> {@Overridepublic int getPartition(Text key, IntWritable value, int numPartitions) {// 确保相同Key的数据进入同一分区return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;}

}/*** 自定义排序比较器 - 按Key进行字典序排序*/

public class KeyComparator extends WritableComparator {protected KeyComparator() {super(Text.class, true);}@Overridepublic int compare(WritableComparable a, WritableComparable b) {Text key1 = (Text) a;Text key2 = (Text) b;return key1.compareTo(key2);}

}/*** Map任务配置示例*/

public class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {private final static IntWritable one = new IntWritable(1);private Text word = new Text();@Overrideprotected void setup(Context context) {// 初始化环形缓冲区相关参数// 缓冲区大小默认100MB,阈值80%触发溢写}@Overridepublic void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {String line = value.toString();String[] words = line.split(" ");for (String w : words) {word.set(w);// 数据写入环形缓冲区,序列化为字节格式context.write(word, one);}}

}

设计背后的思考与局限

MapReduce的这套设计,在当年堪称经典。它通过大量的磁盘读写来保证即使在内存极其有限的机器上也能处理海量数据,容错性极强。但成也萧何,败也萧何,频繁的I/O操作也成了它最大的性能瓶颈。

在那个硬件资源相对匮乏的年代,MapReduce选择用磁盘换取稳定性和可扩展性,是完全正确的。但随着时代发展,这种设计的局限性也愈发明显。

首先,MapReduce需要将计算的中间结果写入磁盘,之后还要读取磁盘,这也就意味着在此期间会存在大量的IO消耗,效率也很低。之前老师讲的课件没找到,这里给大家看一个我自己写的图(如果有问题还请大佬指出)。

加入这个时候我们打算给这几个字符串计数,在split阶段由于“分而治之”的思想,数据会被相对平均的放入两个分区(当然这里你也可以自己定是几个分区数,应当尽量让分区满载运行从而避免资源浪费);map阶段基于字符串的k-v键值对去统计不同字段的数量,并不会去汇总,因为汇总的步骤放在combine了;之后在sort/shuffle阶段会进行重分区,把不同字段放进相应的分区内,另外是基于哈希值进行计算的;最后交给reduce端进行下一步操作。由于数据分区是随机的,所以有时候会存在数据倾斜的问题导致性能下降,还有可能因为频繁地IO流作业导致内存不足最终溢出到磁盘。另外从上面的代码也可以看到,MapReduce的代码比较复杂,平时写的也不多。

Spark Shuffle:青出于蓝的优化

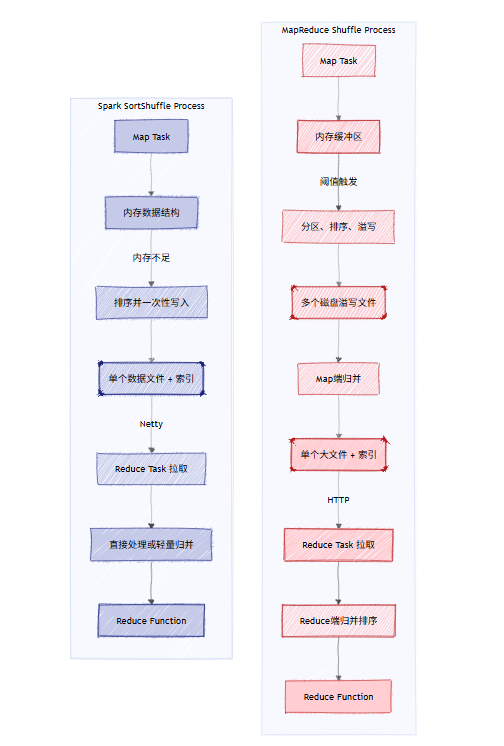

Spark的出现,很大程度上就是为了解决MapReduce的性能问题。它的Shuffle机制经过了多次迭代,从HashShuffle到SortShuffle,再到引入Tungsten引擎的UnsafeShuffle,核心思想是:尽可能利用内存,减少磁盘I/O,并优化数据结构。

目前,SortShuffleManager是Spark的默认选择,我们重点剖析它。

SortShuffleManager 详解

Spark的SortShuffleManager借鉴了MapReduce的排序思想,但做了大量优化。

- 写入过程:与MapReduce为每个溢写操作都生成一个新文件不同,Spark Map任务在整个生命周期中,只会为每个Reduce分区生成一个文件。它会先将数据写入一个内存数据结构(

PartitionedPairBuffer或PartitionedAppendOnlyMap),当内存不足时,会将这个数据结构中的所有数据进行排序,然后一次性溢写到一个合并后的文件中。同时,它会记录下每个数据块在该文件中的偏移量,并写入一个索引文件(.index文件)。 - 数据结构优化:在满足特定条件时(如分区数小于阈值、不需要聚合等),Spark会启用

UnsafeShuffleWriter。这是Tungsten项目的一部分,它会跳过常规的序列化/反序列化,直接在序列化后的二进制数据上进行操作,将数据以一种极度紧凑的格式(UnsafeRow)存放在内存中,极大地降低了内存占用和GC压力。

此外,SortShuffle还有普通机制和Bypass机制之分。

SortShuffle普通机制

SortShuffle是Spark默认的Shuffle机制,其核心思想是在Map端对数据进行排序和合并,以减少Reduce端的处理负担。在普通机制下,每个Map任务会为每个分区创建一个内存缓冲区,当数据写入缓冲区后,会根据目标分区ID进行排序。当缓冲区达到阈值时,数据会被溢写到磁盘上的临时文件,这些文件按照分区ID有序排列。与传统的HashShuffle不同,SortShuffle不会为每个分区创建单独的文件,而是将所有分区的数据合并到同一个文件中,同时生成一个索引文件来记录每个分区数据在文件中的起始位置。这种设计显著减少了小文件的数量,降低了文件系统的压力。在Reduce阶段,每个Reduce任务只需要读取索引文件中对应分区的数据块,避免了全文件扫描的开销。SortShuffle还支持数据压缩,可以在写入磁盘前对数据进行压缩,减少磁盘I/O和网络传输的开销。虽然排序操作会带来一定的CPU开销,但通过优化的排序算法和内存管理,SortShuffle在大多数场景下都能提供更好的整体性能。

SortShuffle Bypass机制

Bypass机制是SortShuffle的一种优化策略,专门用于处理分区数量较少的情况。当Reduce任务的分区数小于等于spark.shuffle.sort.bypassMergeThreshold参数设定的阈值(默认200)时,Spark会自动启用Bypass机制。在这种机制下,Map任务不会对数据进行排序,而是直接将数据写入对应分区的临时文件中,每个分区对应一个独立的文件。这种方式避免了排序操作的开销,特别适合分区数较少且不需要排序的场景。Bypass机制的工作流程类似于传统的HashShuffle,但有一个重要改进:在Map任务结束时,所有分区的临时文件会被合并成一个大的输出文件,并生成相应的索引文件。这种合并操作减少了小文件的数量,避免了HashShuffle中可能出现的文件句柄耗尽问题。Bypass机制在保持HashShuffle低延迟优势的同时,通过文件合并解决了其可扩展性问题。对于诸如groupByKey等不需要排序的算子,Bypass机制能够提供更好的性能。然而,当分区数较多时,Bypass机制会产生大量小文件,反而会降低性能,因此Spark会根据分区数自动选择最合适的Shuffle机制。

这两张图片是我从网上找的。如果想理解的更加深入可以去看看这篇文章:

Spark性能调优-Shuffle调优及故障排除篇(万字好文)

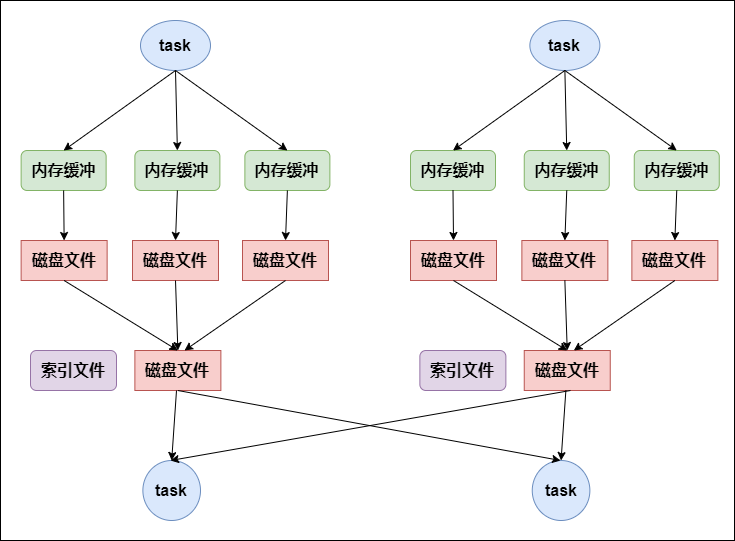

我们可以通过一个时序图来理解Reduce任务是如何从Spark的Shuffle文件中拉取数据的。

图2:Spark Shuffle数据拉取时序图

Spark Shuffle的优势

- 减少磁盘I/O:Spark Shuffle通过将多次溢写合并为对单个文件的追加操作,显著减少了磁盘I/O开销。这种设计避免了MapReduce中频繁的磁盘溢写操作,大大降低了文件句柄的数量和磁盘寻道的开销。在传统的MapReduce框架中,每个Map任务会产生多个溢写文件,而Spark采用更智能的文件管理策略,将相同分区的数据追加到同一个文件中,减少了文件创建和删除的操作次数。这种优化不仅提升了磁盘利用率,还降低了系统调用的开销,特别是在处理大规模数据时效果更为明显。此外,Spark还采用了更高效的压缩算法和序列化机制,进一步减少了磁盘空间的占用和数据传输量。

- 高效的内存利用:Tungsten引擎的引入是Spark Shuffle在内存利用方面的重大突破,使得数据能以二进制形式紧凑地存储和处理。与传统的Java对象序列化相比,Tungsten引擎直接操作二进制数据,避免了Java对象序列化的开销和垃圾回收的压力。这种设计显著提高了内存使用效率,允许在相同的内存容量下处理更大规模的数据。Tungsten引擎还采用了列式存储和向量化处理技术,进一步优化了内存访问模式和数据局部性。通过智能的内存管理和数据布局优化,Spark能够在内存中完成更多的计算任务,减少了对磁盘的依赖,从而大幅提升了整体处理性能。特别是在迭代算法和交互式查询场景中,这种内存优化带来的性能提升尤为显著。

- 无需在Reduce端进行强制合并:由于Map端已经做好了大部分排序和合并工作,Reduce端在很多情况下可以直接处理拉取到的数据流,省去了强制的归并排序步骤。这种设计简化了Reduce端的处理流程,减少了不必要的计算开销。Spark Shuffle采用更灵活的数据处理策略,根据数据特性和任务需求动态调整合并策略,避免了过度排序带来的性能损失。对于某些不需要严格排序的应用场景,Spark允许跳过排序步骤,直接进行数据聚合操作,进一步提升了处理效率。这种优化特别适合机器学习算法和流式处理应用,其中数据的处理顺序可能不是关键因素。通过减少不必要的排序操作,Spark能够在保证正确性的同时,显著提升作业的执行速度。

下面的架构图直观地对比了两种模式。

图3:MapReduce与Spark执行模型对比架构图

import org.apache.spark._

import org.apache.spark.rdd.RDD

import org.apache.spark.sql.SparkSession

import org.apache.spark.sql.execution.UnsafeRow

import org.apache.spark.shuffle.sort.SortShuffleWriter/*** Spark Sort Shuffle 完整示例* 展示Sort Shuffle的核心工作机制和优化策略*/

object SparkSortShuffleExample {def main(args: Array[String]): Unit = {// 配置Sort Shuffle相关参数val conf = new SparkConf().setAppName("SortShuffleDemo").setMaster("local[4]").set("spark.shuffle.manager", "sort") // 启用Sort Shuffle.set("spark.shuffle.sort.bypassMergeThreshold", "200") // Bypass阈值.set("spark.sql.tungsten.enabled", "true") // Tungsten优化.set("spark.shuffle.spill.numElementsForceSpillThreshold", "1000000") // 溢写阈值.set("spark.shuffle.file.buffer", "1MB") // Shuffle文件缓冲区val spark = SparkSession.builder().config(conf).getOrCreate()val sc = spark.sparkContexttry {demonstrateSortShuffle(sc)} finally {spark.stop()}}/*** 演示Sort Shuffle的核心流程*/def demonstrateSortShuffle(sc: SparkContext): Unit = {println("=== Spark Sort Shuffle 演示开始 ===")// 1. 创建测试数据 - 模拟大规模数据集val largeData = sc.parallelize(1 to 1000000).flatMap { i =>// 生成带分区的键值对数据(1 to 10).map { j =>val key = s"partition_${i % 100}_key_$j" // 模拟100个分区(key, i * j)}}println(s"原始数据分区数: ${largeData.getNumPartitions}")println(s"数据总量: ${largeData.count()}")// 2. 触发Sort Shuffle操作 - 按Key分组val shuffledData = largeData.groupByKey()println("=== Shuffle操作执行中 ===")println("Sort Shuffle机制启动:")println("- 数据序列化为二进制格式")println("- 按分区ID和Key进行排序")println("- 合并小文件减少磁盘I/O")// 3. 应用Tungsten优化后的操作val processedData = shuffledData.map { case (key, values) =>// Tungsten优化的聚合操作val sum = values.sumval count = values.sizeval avg = sum.toDouble / count(key, (sum, count, avg))}// 4. 再次触发Shuffle - 按处理结果排序val finalResult = processedData.sortByKey()println("=== Shuffle结果统计 ===")val sampleResults = finalResult.take(10)sampleResults.foreach { case (key, (sum, count, avg)) =>println(s"Key: $key, Sum: $sum, Count: $count, Avg: $avg")}println("=== Sort Shuffle流程完成 ===")}

}/*** 自定义Sort Shuffle配置类* 展示Sort Shuffle的核心配置参数*/

class SortShuffleConfig {// Sort Shuffle关键配置参数val configs = Map("spark.shuffle.manager" -> "sort","spark.shuffle.sort.bypassMergeThreshold" -> "200", // 分区数阈值"spark.shuffle.file.buffer" -> "1MB", // 文件缓冲区"spark.shuffle.spill.compress" -> "true", // 压缩溢写文件"spark.shuffle.accurateBlockThreshold" -> "100MB", // 精确块阈值"spark.shuffle.unsafe.fastMergeEnabled" -> "true", // 快速合并"spark.shuffle.service.enabled" -> "false" // 外部Shuffle服务)/*** 根据数据规模自动优化Shuffle配置*/def optimizeForDataSize(dataSizeMB: Long): Map[String, String] = {val optimized = configs ++ Map("spark.shuffle.file.buffer" -> {if (dataSizeMB > 1000) "2MB" else "1MB" // 大数据量使用更大缓冲区},"spark.shuffle.spill.numElementsForceSpillThreshold" -> {if (dataSizeMB > 500) "500000" else "100000" // 调整溢写阈值})optimized}

}/*** Sort Shuffle 文件管理示例* 展示Shuffle文件的创建、合并和清理过程*/

object ShuffleFileManager {/*** 模拟Shuffle文件合并过程*/def demonstrateFileMerging(): Unit = {println("=== Shuffle文件合并过程 ===")// Sort Shuffle的文件合并策略val mergeStrategies = List("小文件合并: 将多个小溢写文件合并为单个大文件","索引创建: 为合并后的文件创建分区索引","压缩优化: 使用Snappy或LZ4压缩减少磁盘占用","内存映射: 对大文件使用内存映射提高读取速度")mergeStrategies.foreach(println)}/*** 展示Bypass机制的条件判断*/def checkBypassConditions(numPartitions: Int): Boolean = {val bypassThreshold = 200val useBypass = numPartitions <= bypassThresholdif (useBypass) {println(s"分区数 $numPartitions ≤ 阈值 $bypassThreshold,启用Bypass机制")println("Bypass机制特点:")println("- 跳过排序操作,直接写入分区文件")println("- 减少CPU开销,提高小分区场景性能")println("- 最终仍会合并文件,避免小文件问题")} else {println(s"分区数 $numPartitions > 阈值 $bypassThreshold,使用标准Sort Shuffle")}useBypass}

}/*** Tungsten内存优化示例* 展示二进制数据格式和堆外内存管理*/

object TungstenOptimization {def demonstrateTungstenFeatures(): Unit = {println("=== Tungsten引擎优化特性 ===")val features = List("二进制数据格式: 避免Java对象序列化开销","堆外内存管理: 减少GC压力,提高内存利用率", "代码生成: 为特定操作生成本地优化代码","列式存储: 优化数据访问模式,提高缓存命中率","向量化处理: 支持SIMD指令,提高计算效率")features.foreach(println)// 演示UnsafeRow的二进制操作println("\n=== UnsafeRow二进制操作示例 ===")demonstrateUnsafeRow()}private def demonstrateUnsafeRow(): Unit = {// 创建包含3列的二进制行val row = new UnsafeRow(3)// 直接设置二进制数据(模拟Tungsten操作)// 实际中这些操作由Tungsten引擎自动处理println("UnsafeRow二进制数据操作:")println("- 直接操作内存地址,避免序列化")println("- 紧凑存储格式,减少内存占用")println("- 支持快速排序和比较操作")}

}// 运行示例

SparkSortShuffleExample.main(Array.empty)

Sort Shuffle机制通过排序和文件合并显著优化了Spark的Shuffle性能。代码展示了核心配置参数、自动机制选择(Bypass vs 标准Sort)和Tungsten内存优化。关键优化包括:二进制数据格式避免序列化开销,智能文件合并减少磁盘I/O,内存溢写阈值动态调整。Bypass机制在分区数少时跳过排序提升性能,而标准Sort机制通过多路归并处理大数据量。Tungsten引擎的堆外内存管理和代码生成进一步提升了执行效率。整个机制体现了Spark在性能优化方面的深度思考。

ps:本文进讨论Spark SortShuffle 和MapReduce shuffle 的对比,还不包括Tungsten Sort Shuffle。

Tungsten Sort Shuffle是Spark在Tungsten项目下对Shuffle机制的深度优化,代表了Spark Shuffle演进的最高水平。该机制的核心创新在于完全绕过了Java对象序列化的传统方式,直接在二进制数据层面进行操作。Tungsten引擎引入了一种称为"Unsafe Row"的紧凑内存格式,将数据以二进制的形式存储在堆外内存中,避免了Java对象序列化的开销和垃圾回收的压力。这种设计使得数据在内存中的存储更加紧凑,内存使用效率大幅提升。在Shuffle过程中,Tungsten Sort Shuffle采用基于指针的排序算法,直接在二进制数据上进行排序操作,无需将数据反序列化为Java对象。这种排序方式不仅效率更高,而且减少了内存占用和CPU开销。此外,Tungsten还引入了代码生成技术,为特定的数据处理操作生成优化的本地代码,进一步提升了执行效率。Tungsten Sort Shuffle还支持高效的压缩算法和列式存储,在数据传输和存储方面进行了全面优化。这种机制特别适合处理大规模数据集,在内存受限的环境中表现出色,为Spark的高性能计算提供了坚实的技术基础。这里放一个Tungsten Sort Shuffle的运行示意图吧。

全方位对比:MapReduce vs. Spark

为了更直观地感受两者的差异,我们用一个表格来总结。

| 特性 | MapReduce Shuffle | Spark SortShuffle |

|---|---|---|

| I/O模型 | 大量小文件,频繁磁盘读写 | 合并为大文件,显著减少I/O |

| 内存使用 | 相对保守,主要用作缓冲区 | 积极利用内存,Tungsten优化 |

| 排序机制 | Map端多次排序合并,Reduce端再次合并 | Map端排序后直接写,Reduce端可能无需排序 |

| 数据结构 | Java对象序列化 | 优化的内存布局(UnsafeRow) |

| 容错 | 极强,中间结果持久化在磁盘 | 同样可靠,但更依赖内存状态 |

| 性能 | 较低,受限于磁盘I/O | 非常高,得益于内存计算和优化 |

一个典型的数据处理作业,其时间开销可以用下面的饼图来近似表示。在MapReduce中,Shuffle阶段往往占据了“大头”。

图4:典型数据作业耗时分布饼图

Spark的优化,正是精准地打击了这个最耗时的环节。

总结与展望

总而言之,MapReduce的Shuffle机制是面向磁盘的、稳健可靠的经典设计,而Spark的Shuffle则是面向内存的、追求极致性能的现代优化。MapReduce作为大数据处理的开山之作,其Shuffle机制建立在磁盘存储的基础上,通过环形缓冲区、分区排序、溢写和归并等精心设计的步骤,确保了大规模数据处理的可靠性和容错性。这种设计虽然相对保守,但在处理超大规模数据集时表现出色,特别是在面对节点故障时能够保证数据安全性,为早期的大数据应用奠定了坚实基础。

Spark Shuffle则在MapReduce的基础上进行了革命性的优化,通过合并文件、优化内存数据结构、减少不必要的排序等一系列"组合拳",将Shuffle的性能提升到了新的高度。SortShuffle机制的引入,特别是普通机制和Bypass机制的智能切换,体现了Spark对性能的极致追求。Tungsten引擎的二进制内存管理和列式存储优化,使得Spark能够在内存中高效处理数据,大幅减少了磁盘I/O开销。这种面向内存的设计理念,使得Spark特别适合迭代计算、交互式查询和机器学习等需要多次数据重用的场景。

这场新老两代框架的“洗牌”对决,清晰地展示了大数据技术从“能用”到“好用”再到“快用”的演进路径。未来,随着硬件的进一步发展和计算模型(如Serverless、Remote Shuffle Service)的创新,Shuffle机制还将继续进化,为我们带来更高效、更智能的数据处理体验。

参考链接

- Hadoop MapReduce Tutorial

- Spark Cluster Overview - Shuffle Behavior

- Deep Dive into Spark Shuffle

- Project Tungsten: Bringing Spark Closer to Bare Metal

- How a MapReduce Program Works

关键词标签

#SparkShuffle #大数据 #分布式计算 #MapReduce #数据倾斜