【完整源码+数据集+部署教程】 【运输&加载码头】仓库新卸物料检测系统源码&数据集全套:改进yolo11-DRBNCSPELAN

背景意义

随着全球经济的快速发展和电子商务的蓬勃兴起,仓储物流行业面临着前所未有的挑战与机遇。传统的物料管理方式已难以满足现代化仓库对效率、准确性和实时性的高要求。尤其是在新卸物料的检测与管理中,如何快速、准确地识别和分类不同类型的物料,成为了提升仓库运营效率的关键因素之一。基于此背景,开发一套高效的仓库新卸物料检测系统显得尤为重要。

本研究旨在基于改进的YOLOv11模型,构建一个高效的仓库新卸物料检测系统。YOLO(You Only Look Once)系列模型因其优越的实时检测能力和高精度,已广泛应用于各类物体检测任务。通过对YOLOv11模型的改进,我们期望在检测速度和准确性上实现进一步的提升,以适应仓库环境中复杂多变的物料特征。

本项目所使用的数据集“Module 3”包含495张图像,涵盖了1个类别,主要涉及叉车、托盘和原材料等物料。这些数据不仅为模型的训练提供了丰富的样本,也为后续的模型评估和优化奠定了基础。通过对这些物料的准确识别,仓库管理人员能够实时掌握新卸物料的种类和数量,从而提高仓库的运营效率,降低人工成本,减少物料损失。

此外,随着人工智能技术的不断进步,基于深度学习的物体检测系统在智能仓储中的应用前景广阔。通过本研究的实施,不仅可以推动仓储行业的智能化转型,还能为相关领域的研究提供有价值的参考与借鉴。因此,基于改进YOLOv11的仓库新卸物料检测系统的研究,具有重要的理论意义和实际应用价值。

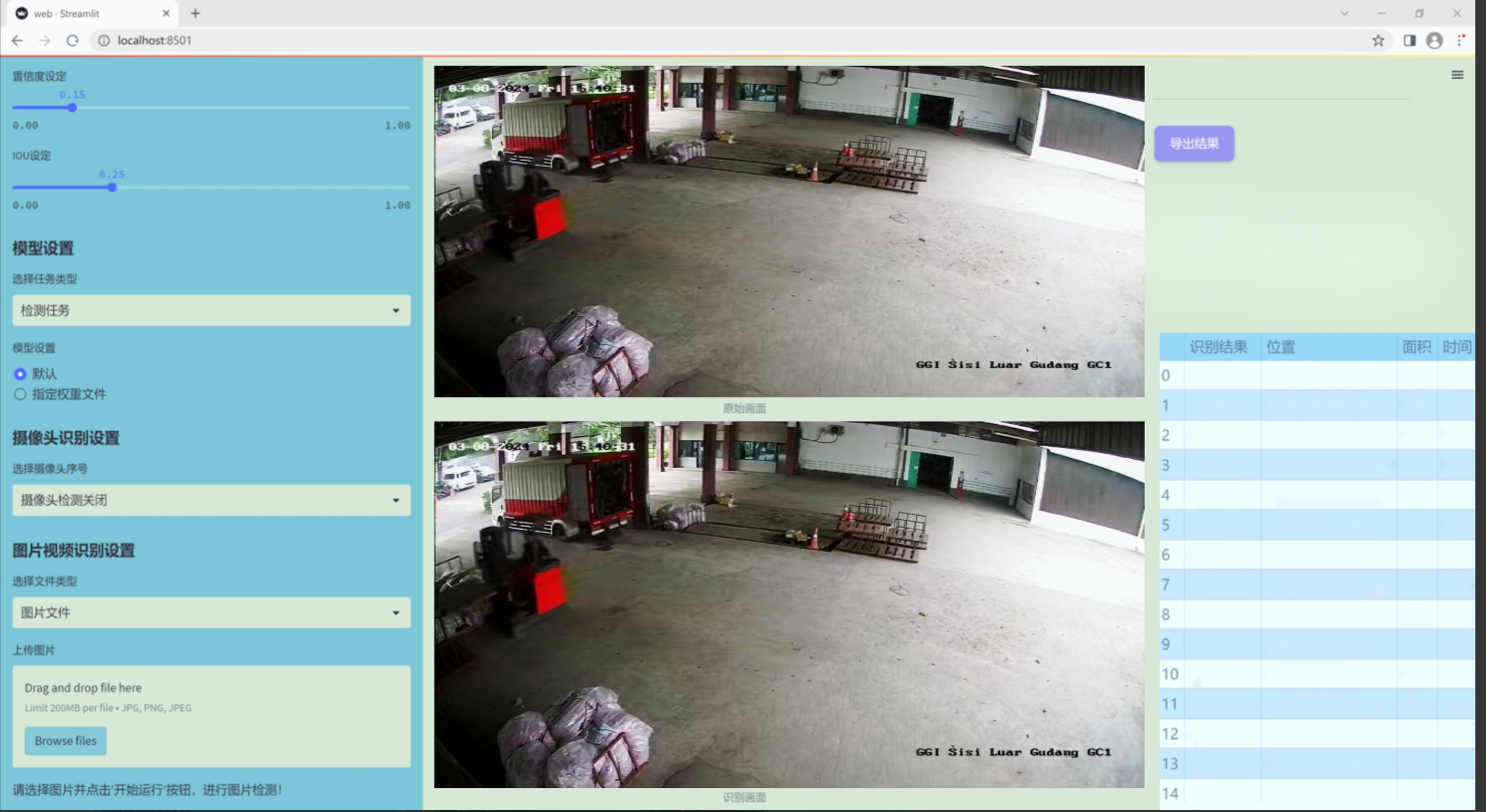

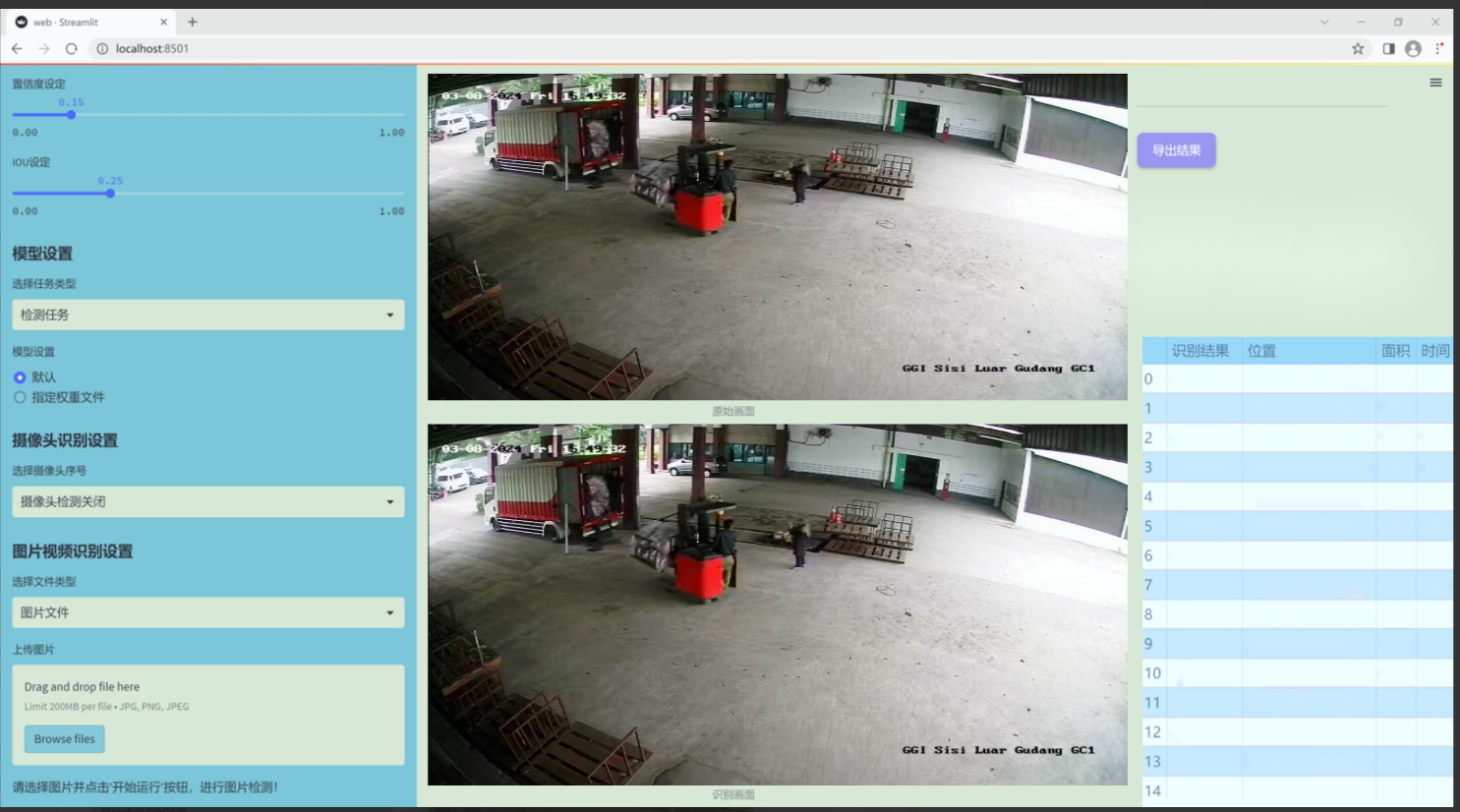

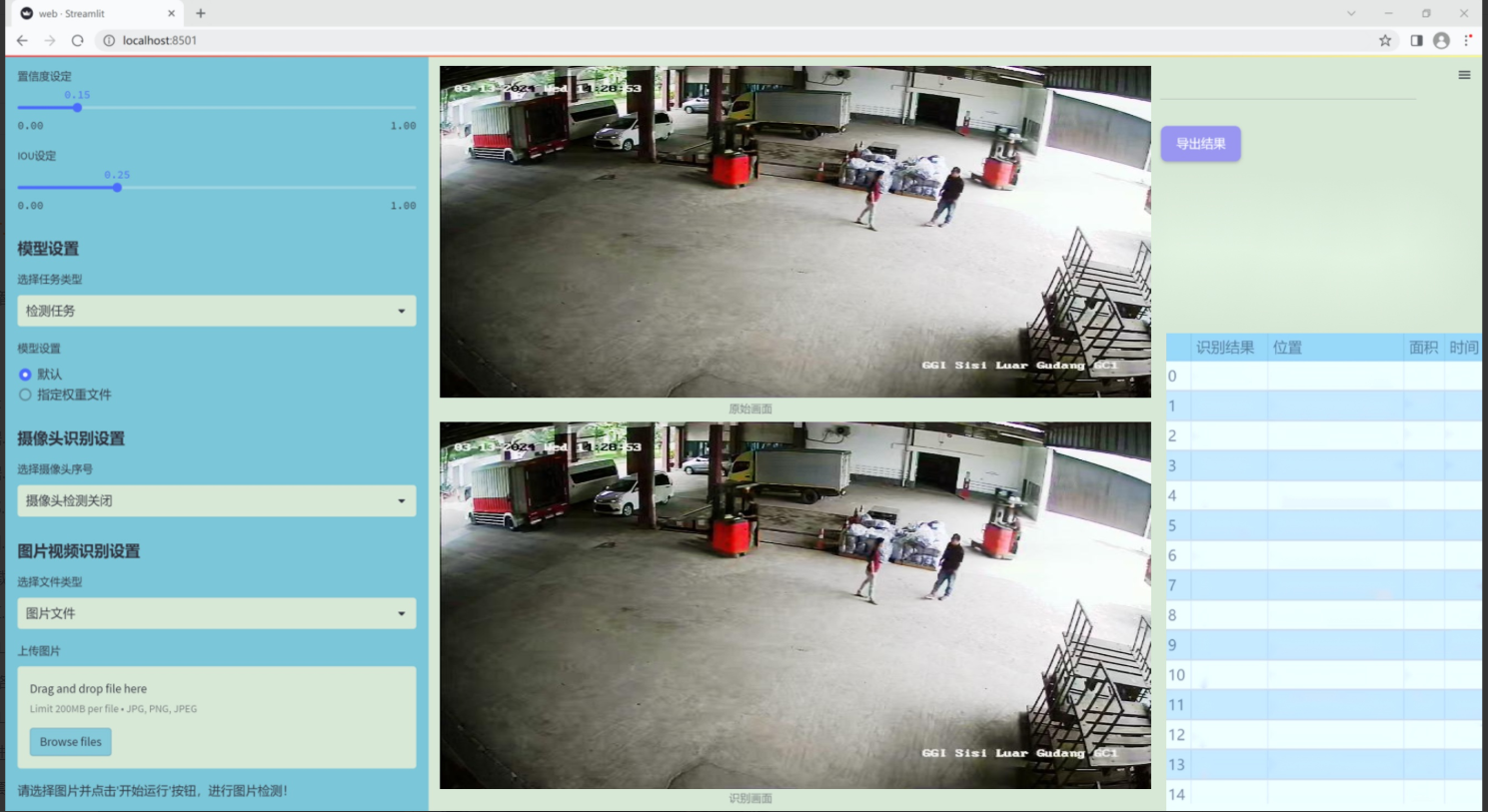

图片效果

数据集信息

本项目所使用的数据集名为“Sisi gudang”,旨在为改进YOLOv11的仓库新卸物料检测系统提供强有力的支持。该数据集专注于仓库环境中常见的物料种类,包含三类主要对象,分别是“forklite”(叉车)、“pallete”(托盘)和“raw materials”(原材料)。通过对这些类别的精确标注和丰富的样本收集,Sisi gudang数据集为算法的训练提供了多样化的场景和条件,确保了模型在实际应用中的鲁棒性和准确性。

在数据集的构建过程中,研究团队对每一类物料进行了详尽的图像采集,涵盖了不同的角度、光照条件和背景环境。这种多样性不仅增强了模型的泛化能力,还能有效应对仓库作业中可能遇到的各种复杂情况。数据集中每个类别的样本数量经过精心设计,以确保模型在学习过程中能够获得均衡的训练体验,从而提高对各类物料的识别率。

此外,Sisi gudang数据集还特别注重数据的质量与标注的准确性。每一张图像都经过严格的审核,确保标注信息的可靠性。这一过程不仅提升了数据集的整体质量,也为后续的模型训练打下了坚实的基础。通过使用这一数据集,研究团队期望能够显著提升YOLOv11在仓库新卸物料检测任务中的表现,进而推动智能仓储管理的发展。

总之,Sisi gudang数据集为本项目提供了丰富而高质量的训练数据,助力于构建一个高效、智能的物料检测系统,以满足现代仓储管理的需求。

核心代码

以下是提取后的核心代码部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

class FreqFusion(nn.Module):

def init(self, channels, scale_factor=1, lowpass_kernel=5, highpass_kernel=3, **kwargs):

super().init()

hr_channels, lr_channels = channels

self.scale_factor = scale_factor

self.lowpass_kernel = lowpass_kernel

self.highpass_kernel = highpass_kernel

# 压缩高分辨率和低分辨率特征通道self.compressed_channels = (hr_channels + lr_channels) // 8self.hr_channel_compressor = nn.Conv2d(hr_channels, self.compressed_channels, 1)self.lr_channel_compressor = nn.Conv2d(lr_channels, self.compressed_channels, 1)# 低通滤波器生成器self.content_encoder = nn.Conv2d(self.compressed_channels,lowpass_kernel ** 2 * self.scale_factor * self.scale_factor,kernel_size=3,padding=1)# 高通滤波器生成器self.content_encoder2 = nn.Conv2d(self.compressed_channels,highpass_kernel ** 2 * self.scale_factor * self.scale_factor,kernel_size=3,padding=1)def kernel_normalizer(self, mask, kernel):"""对卷积核进行归一化处理"""n, mask_c, h, w = mask.size()mask_channel = int(mask_c / float(kernel**2))mask = mask.view(n, mask_channel, -1, h, w)mask = F.softmax(mask, dim=2) # 进行softmax归一化mask = mask.view(n, mask_channel, kernel, kernel, h, w)mask = mask.permute(0, 1, 4, 5, 2, 3).view(n, -1, kernel, kernel)mask /= mask.sum(dim=(-1, -2), keepdims=True) # 归一化return maskdef forward(self, x):"""前向传播函数x: 输入特征,包含高分辨率和低分辨率特征"""hr_feat, lr_feat = x# 压缩特征compressed_hr_feat = self.hr_channel_compressor(hr_feat)compressed_lr_feat = self.lr_channel_compressor(lr_feat)# 生成低通和高通滤波器的掩码mask_lr = self.content_encoder(compressed_hr_feat)mask_hr = self.content_encoder2(compressed_hr_feat)# 对掩码进行归一化mask_lr = self.kernel_normalizer(mask_lr, self.lowpass_kernel)mask_hr = self.kernel_normalizer(mask_hr, self.highpass_kernel)# 使用掩码对低分辨率特征进行处理lr_feat = F.conv2d(lr_feat, mask_lr, padding=self.lowpass_kernel // 2)# 使用掩码对高分辨率特征进行处理hr_feat = F.conv2d(hr_feat, mask_hr, padding=self.highpass_kernel // 2)# 返回融合后的特征return hr_feat + lr_feat

代码注释说明:

导入必要的库:导入 PyTorch 的核心库和功能模块。

FreqFusion 类:定义了一个用于频率感知特征融合的神经网络模块。

init 方法:初始化网络的各个层,包括通道压缩层和低通/高通滤波器生成器。

kernel_normalizer 方法:对生成的掩码进行归一化处理,以确保其和为1。

forward 方法:执行前向传播,接收高分辨率和低分辨率特征,生成掩码并应用于特征,最后返回融合后的特征。

该代码实现了一个频率感知特征融合的模块,适用于图像预测任务。

这个程序文件 FreqFusion.py 实现了一种名为“频率感知特征融合”的深度学习模型,主要用于密集图像预测任务。该模型利用高频和低频特征的融合来提升图像的重建质量。以下是对代码的详细说明。

首先,文件导入了必要的库,包括 PyTorch 和一些用于卷积操作的模块。它还尝试从 mmcv 库中导入一些函数,如果未安装该库则会忽略这些导入。接着,定义了一些初始化函数,如 normal_init 和 constant_init,用于对模型参数进行初始化。

resize 函数用于调整输入张量的大小,使用了 PyTorch 的插值功能,并且在调整大小时会发出警告,以提醒用户可能的对齐问题。hamming2D 函数生成二维 Hamming 窗,用于后续的特征处理。

接下来定义了 FreqFusion 类,这是模型的核心部分。该类的构造函数接收多个参数,包括通道数、缩放因子、低通和高通卷积核大小等。模型通过卷积层对高分辨率(HR)和低分辨率(LR)特征进行压缩,并生成用于特征融合的掩码。

在 FreqFusion 类中,模型初始化了多个卷积层,用于处理高频和低频特征。init_weights 方法用于初始化模型的权重,确保模型在训练开始时具有良好的性能。

kernel_normalizer 方法用于对生成的掩码进行归一化处理,确保掩码的和为1。forward 方法是模型的前向传播函数,它接收高分辨率和低分辨率特征,计算融合后的特征。

在 _forward 方法中,模型首先对输入特征进行压缩,然后根据不同的设置(如是否使用高通或低通滤波器)生成掩码,并利用这些掩码对特征进行融合。融合后的特征通过不同的操作(如 carafe 和插值)进行处理,以生成最终的输出。

此外,文件中还定义了 LocalSimGuidedSampler 类,这是一个用于生成偏移量的模块,主要用于在特征重采样时引导特征的选择。该类的构造函数接收多个参数,定义了用于计算偏移量的卷积层。

compute_similarity 函数用于计算输入张量中每个点与其周围点的余弦相似度,以便在特征重采样时使用。

整体来看,这个程序文件实现了一个复杂的深度学习模型,利用频率感知的方法对图像特征进行融合,旨在提高图像重建的精度和质量。模型的设计充分考虑了不同频率特征的互补性,通过高频和低频特征的结合,能够更好地捕捉图像中的细节信息。

10.4 dynamic_snake_conv.py

以下是经过简化和注释的核心代码部分,保留了主要功能并对每个部分进行了详细的中文注释:

import torch

import torch.nn as nn

class DySnakeConv(nn.Module):

def init(self, inc, ouc, k=3) -> None:

super().init()

# 初始化三个卷积层

self.conv_0 = Conv(inc, ouc, k) # 标准卷积

self.conv_x = DSConv(inc, ouc, 0, k) # 沿x轴的动态蛇形卷积

self.conv_y = DSConv(inc, ouc, 1, k) # 沿y轴的动态蛇形卷积

def forward(self, x):# 前向传播,连接三个卷积的输出return torch.cat([self.conv_0(x), self.conv_x(x), self.conv_y(x)], dim=1)

class DSConv(nn.Module):

def init(self, in_ch, out_ch, morph, kernel_size=3, if_offset=True, extend_scope=1):

super(DSConv, self).init()

# 用于学习可变形偏移的卷积层

self.offset_conv = nn.Conv2d(in_ch, 2 * kernel_size, 3, padding=1)

self.bn = nn.BatchNorm2d(2 * kernel_size) # 批归一化

self.kernel_size = kernel_size

# 定义沿x轴和y轴的动态蛇形卷积self.dsc_conv_x = nn.Conv2d(in_ch, out_ch, kernel_size=(kernel_size, 1), stride=(kernel_size, 1), padding=0)self.dsc_conv_y = nn.Conv2d(in_ch, out_ch, kernel_size=(1, kernel_size), stride=(1, kernel_size), padding=0)self.gn = nn.GroupNorm(out_ch // 4, out_ch) # 组归一化self.act = Conv.default_act # 默认激活函数self.extend_scope = extend_scope # 扩展范围self.morph = morph # 卷积核的形态self.if_offset = if_offset # 是否需要偏移def forward(self, f):# 前向传播offset = self.offset_conv(f) # 计算偏移offset = self.bn(offset) # 批归一化offset = torch.tanh(offset) # 将偏移限制在[-1, 1]之间input_shape = f.shapedsc = DSC(input_shape, self.kernel_size, self.extend_scope, self.morph) # 创建DSC对象deformed_feature = dsc.deform_conv(f, offset, self.if_offset) # 进行可变形卷积# 根据形态选择对应的卷积if self.morph == 0:x = self.dsc_conv_x(deformed_feature.type(f.dtype))else:x = self.dsc_conv_y(deformed_feature.type(f.dtype))x = self.gn(x) # 组归一化x = self.act(x) # 激活return x

class DSC(object):

def init(self, input_shape, kernel_size, extend_scope, morph):

self.num_points = kernel_size # 卷积核的大小

self.width = input_shape[2] # 输入宽度

self.height = input_shape[3] # 输入高度

self.morph = morph # 卷积核的形态

self.extend_scope = extend_scope # 偏移范围

# 定义特征图的形状self.num_batch = input_shape[0] # 批大小self.num_channels = input_shape[1] # 通道数def deform_conv(self, input, offset, if_offset):# 进行可变形卷积y, x = self._coordinate_map_3D(offset, if_offset) # 计算坐标图deformed_feature = self._bilinear_interpolate_3D(input, y, x) # 双线性插值return deformed_featuredef _coordinate_map_3D(self, offset, if_offset):# 计算3D坐标图# 此处省略具体实现细节passdef _bilinear_interpolate_3D(self, input_feature, y, x):# 进行3D双线性插值# 此处省略具体实现细节pass

代码说明:

DySnakeConv:这是一个动态蛇形卷积层,包含三个卷积层(标准卷积和两个动态蛇形卷积)。

DSConv:实现动态蛇形卷积,支持沿x轴和y轴的卷积操作,并可以选择是否使用偏移。

DSC:用于计算可变形卷积的坐标图和进行双线性插值,负责生成变形后的特征图。

此代码的核心功能是实现动态蛇形卷积,通过偏移和形态变化来增强卷积操作的灵活性。

这个程序文件定义了一个动态蛇形卷积(Dynamic Snake Convolution)模块,主要由两个类构成:DySnakeConv 和 DSConv,以及一个辅助类 DSC。这些类的设计旨在实现一种新的卷积操作,通过动态的形变来增强特征提取能力。

首先,DySnakeConv 类是一个神经网络模块,继承自 nn.Module。在初始化方法中,它接受输入通道数 inc、输出通道数 ouc 和卷积核大小 k。该类内部定义了三个卷积层:conv_0 是标准卷积,conv_x 和 conv_y 是动态蛇形卷积,分别沿着 x 轴和 y 轴进行形变卷积。在前向传播方法中,输入 x 会经过这三个卷积层,并将它们的输出在通道维度上拼接在一起。

接下来,DSConv 类实现了动态蛇形卷积的具体操作。它同样继承自 nn.Module,并在初始化时定义了多个卷积层和参数,包括输入和输出通道数、卷积核大小、形变类型、是否需要偏移等。该类的前向传播方法首先通过一个卷积层 offset_conv 计算出偏移量,然后使用 DSC 类生成的坐标图进行形变卷积。根据形变类型的不同(x 轴或 y 轴),会调用不同的卷积层进行处理。

DSC 类是一个辅助类,负责处理坐标映射和双线性插值。它的初始化方法接受输入特征图的形状、卷积核大小、扩展范围和形变类型。该类的 _coordinate_map_3D 方法生成变形后的坐标图,而 _bilinear_interpolate_3D 方法则实现了双线性插值,以便根据生成的坐标图对输入特征图进行采样和变形。

总的来说,这个程序实现了一种新的卷积操作,通过动态的形变来增强特征提取的能力,适用于需要对输入数据进行灵活处理的深度学习任务。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式