书生浦语实战营第六期 L1-G3000

LMDeploy 部署

1.配置开发机

- 镜像为 Cuda12.2-conda

- GPU 为 30%A100

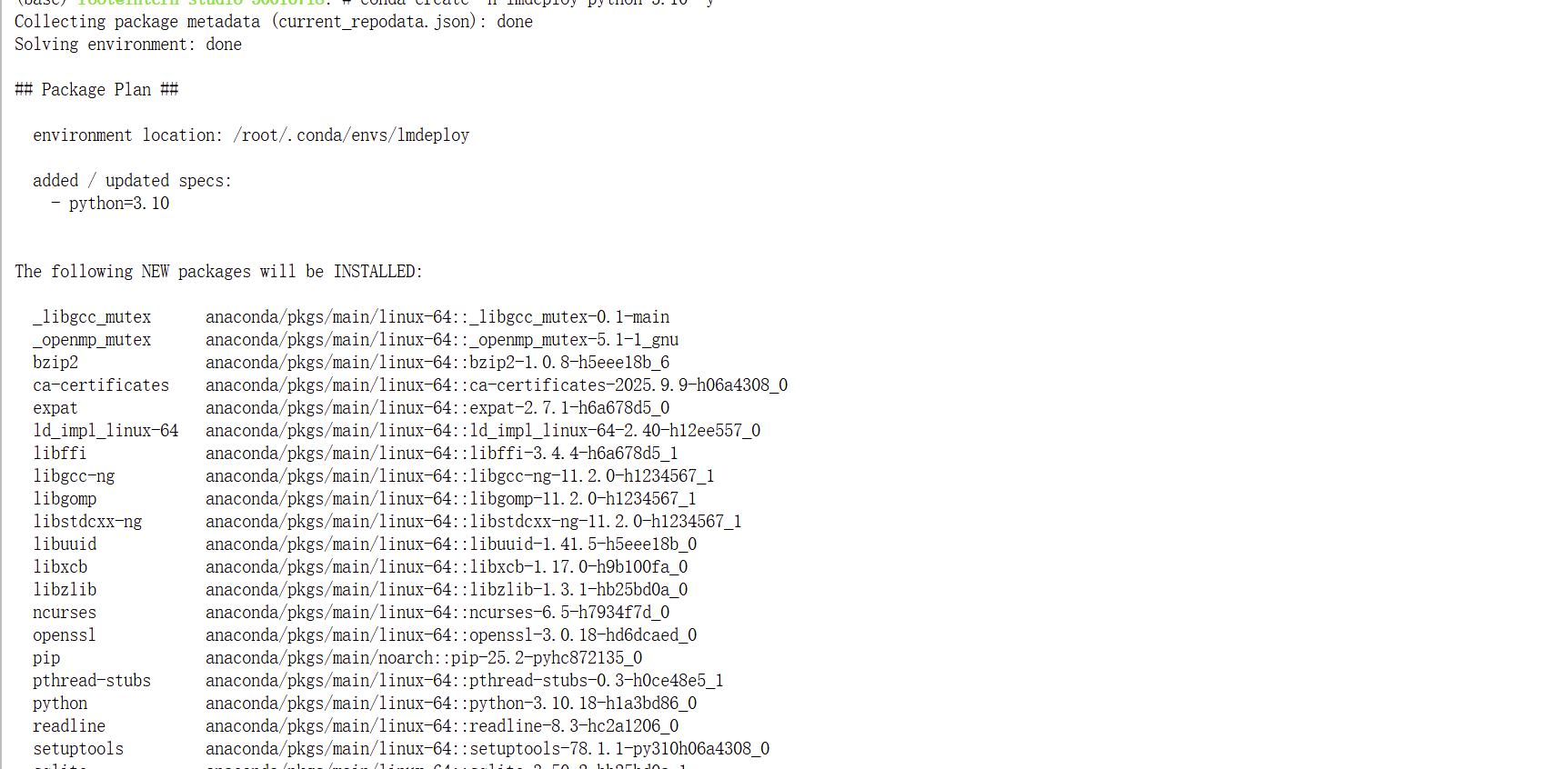

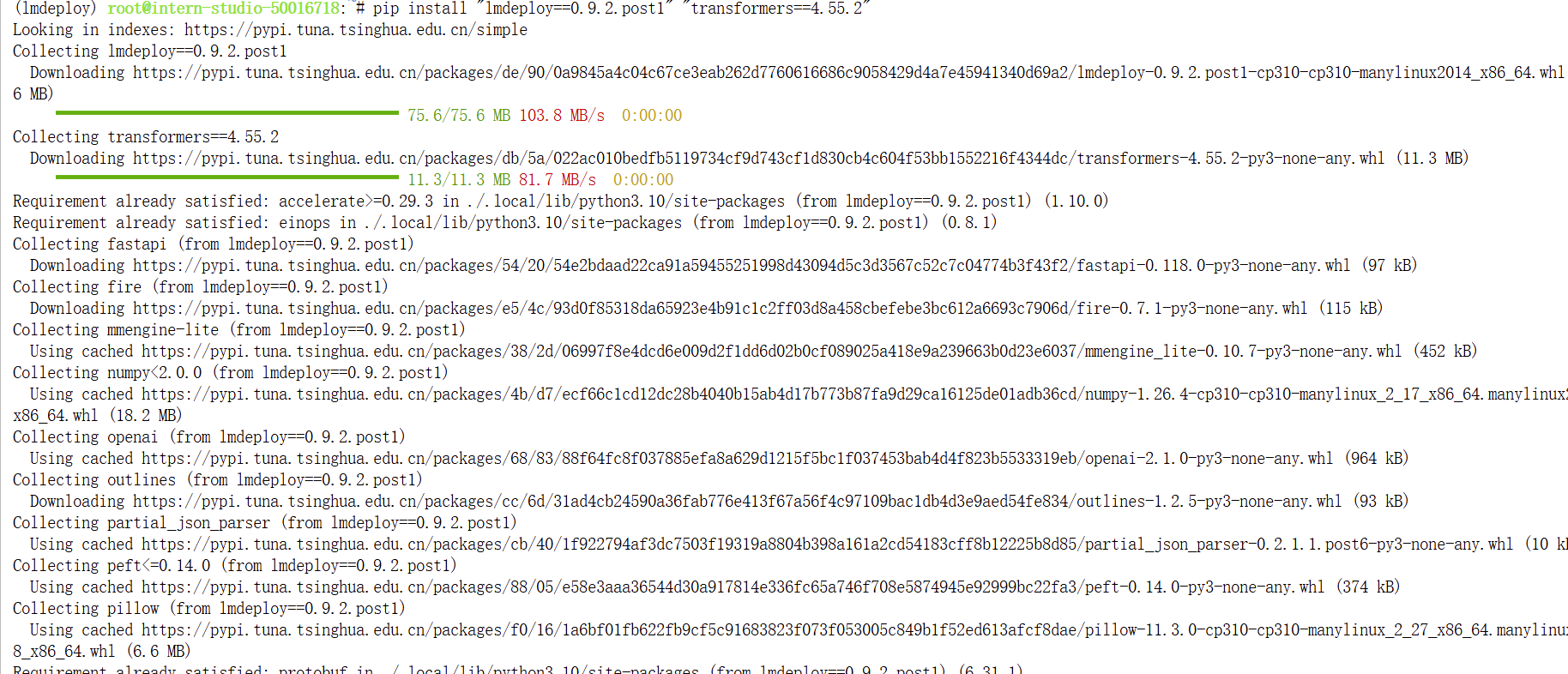

2.配置环境

conda create -n lmdeploy python=3.10 -y

conda activate lmdeploy

pip install "lmdeploy==0.9.2.post1" "transformers==4.55.2"

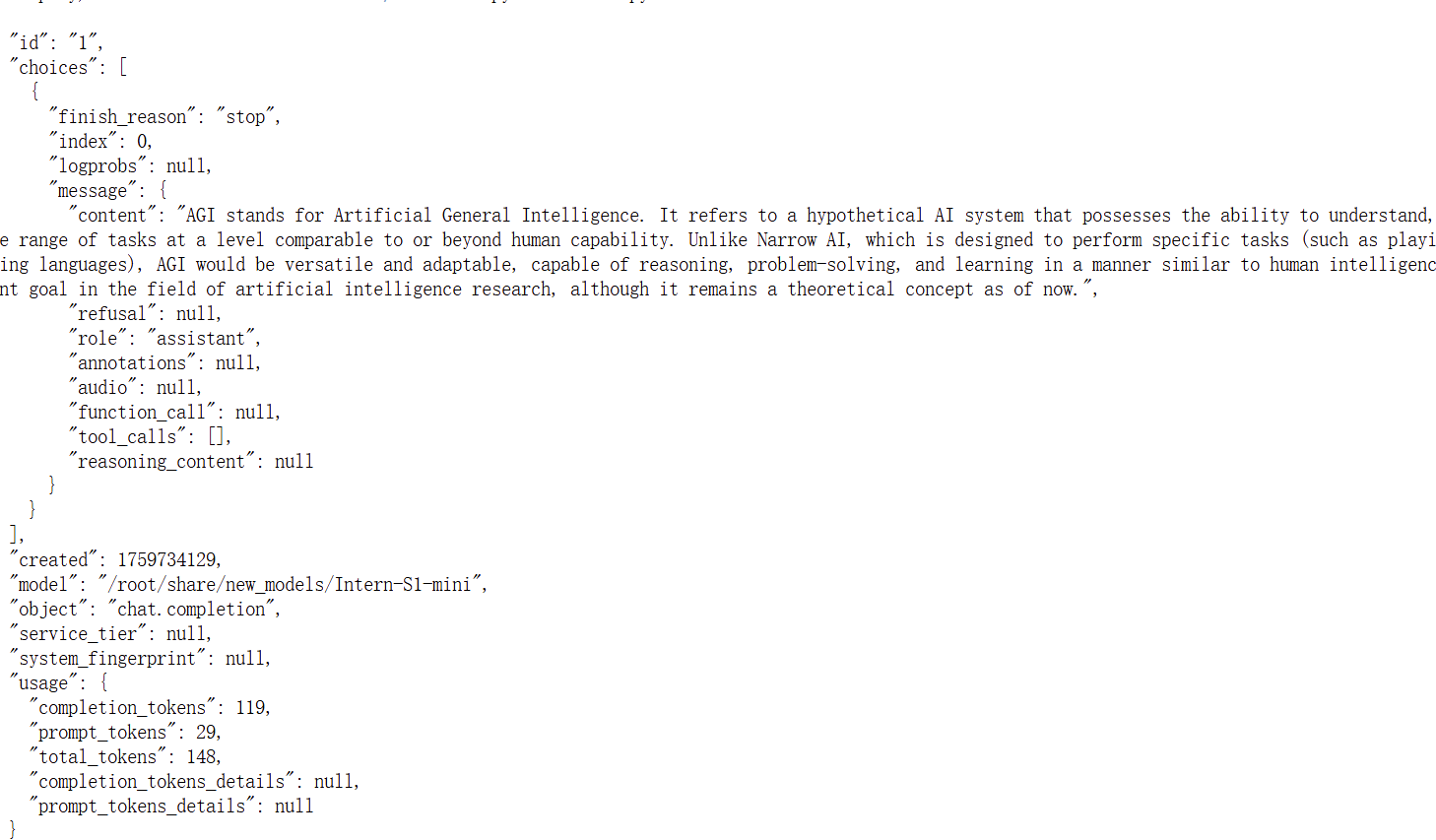

3.运行LMdeploy

lmdeploy serve api_server /root/share/new_models/Intern-S1-mini \--reasoning-parser intern-s1 \--tool-call-parser intern-s1 \--cache-max-entry-count 0.1 \--max-batch-size 8 \--backend turbomind \--session-len 2048参数解析:

--tool-call-parser intern-s1

作用: 指定工具调用(Function Calling)的解析器。

--cache-max-entry-count 0.1

作用: 设置 KV 缓存所能占用的 GPU 显存比例。

--max-batch-size 8

作用: 设置动态批处理的最大批次大小。

--backend turbomind

作用: 指定推理后端引擎。

--session-len 2048

作用: 设置模型能处理的最大会话长度(以 token 为单位)。