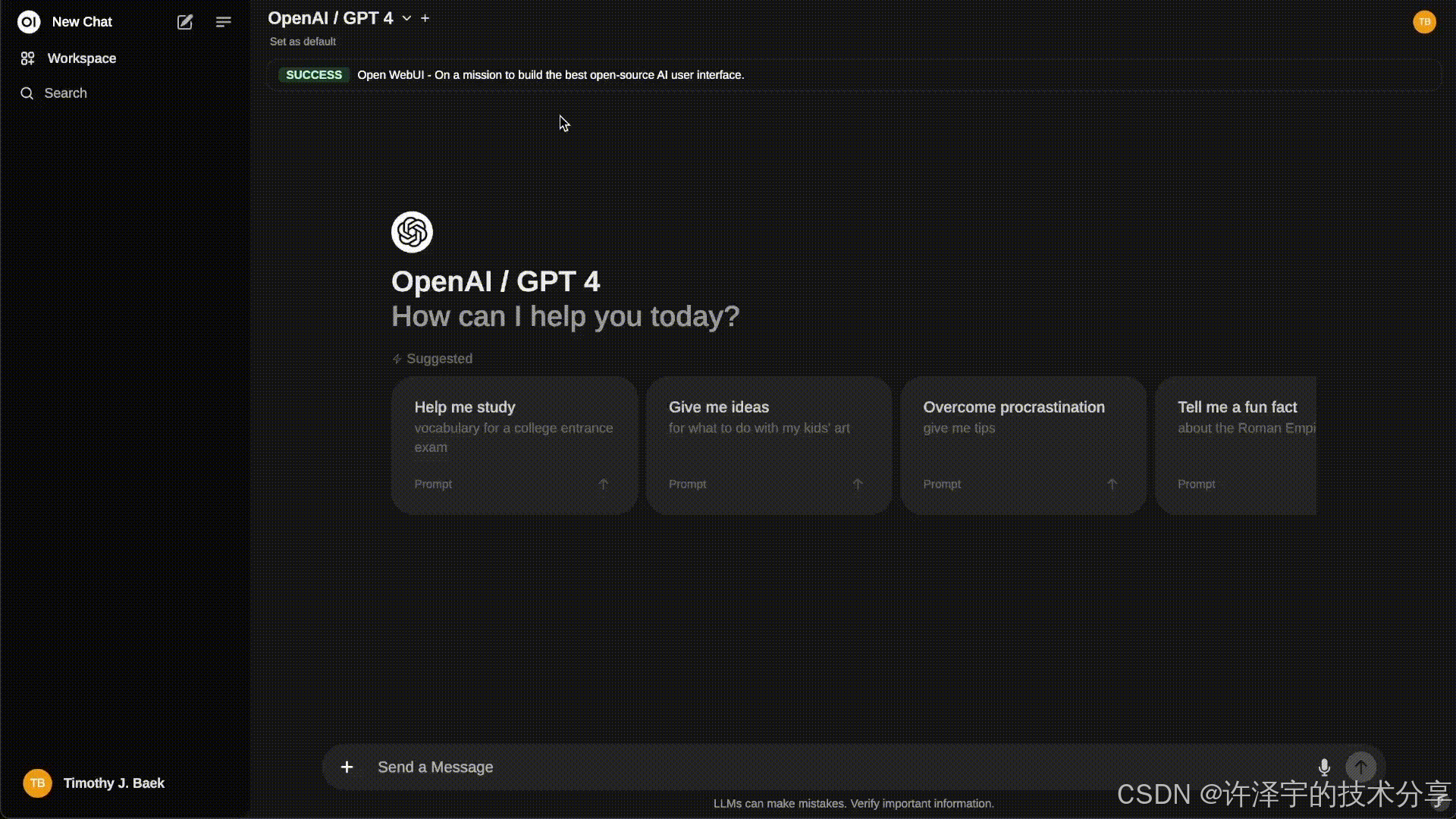

【打造你的全栈 AI 中控台】一文拆解 Open WebUI:从多模型聚合、RAG 引擎到未来 Agent 化的演进密码

如果说大模型是“发动机”,那 Open WebUI 更像是把发动机、变速箱、仪表盘、油耗统计、保养系统乃至副驾驶都塞进一个可私有部署的车体里。它不生产模型,它只是 AI 应用交互体验的“总装厂”。本文将从源码与实际工程视角,系统拆解其技术架构、设计哲学、典型场景与未来演进方向。全文 8000+ 字,建议收藏细读。

0. 为什么需要 Open WebUI?(动机篇)

过去一年,团队在“怎么把模型用起来”这件事上经历了四次心态迭代:

-

有个 API 就行:能发请求拿回答,先爽为敬;

-

需要记忆与检索:模型忘性太大,必须让它“读文档”;

-

工具 / 工作流编排:调用数据库、抓网页、跑脚本……孤立回答不够;

-

运营、合规、成本、体验统一:不同人用不同模型,不同场景要不同 Prompt,还得受控、可审计。

Open WebUI 正是对第 4 阶段痛点的回应:

-

聚合多模型(本地 Ollama、云端 OpenAI、扩展 Tool Server)

-

提供结构化的 RAG(检索增强)能力

-

提供函数调用 / 工具集成与扩展工厂

-

图文音多模态渐进支持

-

面向“运营 + 安全 + 性能 + 协作”场景的基础设施化封装

一句话:它是“可组合的 AI 超级界面”。

1. 总体结构鸟瞰(Architecture Overview)

从仓库骨架看,项目分为三大主干:

-

backend(Python / FastAPI):核心服务、模型适配、RAG、工具、用户与权限、配置、审计、遥测

-

src(SvelteKit 前端):聊天/知识/工作流交互、富文本编辑、国际化、实时协作

-

infra(docker-compose、k8s、scripts):部署、GPU/多模型/观测场景覆盖

核心设计理念可概括为 5 个“解耦”:

-

模型解耦:不同模型后端统一抽象(Ollama、本地、OpenAI 接口兼容、外部 reranker)。

-

检索解耦:Loader / Splitter / Embedding / VectorDB / Rerank 各自为策略点。

-

配置解耦:环境变量 + PersistentConfig 持久化数据库 + 运行时热更新。

-

扩展解耦:Tool Server / External Reranker / Web Search 驱动按需组合。

-

会话解耦:WebSocket 实时层与弹性后端分开,允许水平扩展。

架构图(文字版):

┌──────────┐ ┌──────────────────────────┐

│ Browser │──WS──▶│ Realtime Socket Layer │

│ Svelte │ └──────────┬───────────────┘

│ TipTap │──HTTP────────────▶ FastAPI Routers

└────┬─────┘ │ (auth / chats / retrieval / models ...)│ ││ ▼│ ┌────────────────┐│ │ Service Layer │ (Chats, Retrieval, Tools, Functions)│ └──────┬─────────┘│ ││ ┌─────▼──────┐│ │ Adapters │ (Embedding, Rerank, VectorDB, Search)│ └─────┬──────┘│ ││ ┌────────┬───────┴──────────────┬─────────┐▼ ▼ ▼ ▼ ▼Redis Postgres File Storage (FS/S3) External APIs Tool Servers│▼Persistent Config / Migrations

2. 技术栈深描(Tech Stack)

2.1 后端

| 模块 | 技术 | 用途 | 设计亮点 |

|---|---|---|---|

| Web 框架 | FastAPI | 高性能异步 API + 类型提示 | 与 lifespan + 自定义中间件协同管理资源 |

| ORM & 迁移 | SQLAlchemy + Alembic | 模型/配置/会话存储 | 启动即迁移,降低“版本漂移”风险 |

| 缓存 & 协作 | Redis | 会话、任务指令、事件中转 | 支撑多实例部署与实时功能 |

| 检索增强 | sentence-transformers / LangChain 组件 | 向量嵌入、文档切片、重排 | 自定义 Hybrid + 多搜索引擎 fallback |

| 多模型支持 | Ollama / OpenAI / External | 大模型推理通道 | 可轮询、多端点聚合、轻装适配层 |

| 代码执行 | Jupyter / Pyodide | 轻量 Code Interpreter | 按需授权 + 超时控制 |

| 观测 | OpenTelemetry | Trace + Metrics | 按开关启用,不污染主逻辑 |

| 安全审计 | AuditLoggingMiddleware | 关键操作日志 | 可外接 SIEM / Elastic / Loki |

| OAuth/OIDC | authlib | 登录 / 第三方授权 | 多集成源并存 |

2.2 前端

| 领域 | 技术 | 亮点 |

|---|---|---|

| 框架 | SvelteKit | SSR/CSR 混合, 编译期优化减少运行时损耗 |

| UI & 样式 | TailwindCSS + Typography + Container Queries | 自适配富文本/文档场景 |

| 富文本 | TipTap + y-prosemirror + yjs | 协作编辑 / Prompt 资产化 |

| 实时 | socket.io-client | 会话状态、事件提示、工具执行反馈 |

| 浏览器 Python | Pyodide + @pyscript/core | 前置数据处理、轻量分析 |

| 国际化 | i18next + 动态资源 | 语言包自动解析与打包脚本 |

| 可视化 | chart.js / mermaid / leaflet | 多模态输出场景支撑 |

2.3 DevOps / 运行

-

多套

docker-compose.*.yaml:GPU、观测 (otel)、数据分离、API 模式等。 -

Kubernetes Helm Charts:云原生部署基础。

-

线程池调谐:动态写入 AnyIO ThreadLimiter token 上限,减少 embedding / I/O 争抢。

-

代码规范:ESLint + Pylint + Black + Prettier;前后端统一标准降低跨栈沟通成本。

3. 核心架构分层(Layering)

| 层 | 关键词 | 说明 | 示例源码 |

|---|---|---|---|

| 入口层 | 协议抽象 | HTTP + WebSocket | main.py、socket/main.py |

| 会话与上下文 | Chat Orchestrator | 合并历史、裁剪窗口、注入检索上下文 | routers/chats.py |

| 检索增强 | Retriever + Ranker | Loader → Splitter → Embed → Vector/HNSW | retrieval.py / retrieval/vector/ |

| 模型适配 | Provider Interface | 统一 Chat/Completion/Streaming 行为 | routers/openai.py、routers/ollama.py |

| 工具执行 | Functions / Tools | JSON Schema 描述 + 决策调用 | routers/functions.py |

| 配置与策略 | PersistentConfig | Env → DB → 动态刷新 | config.py |

| 数据层 | ORM + 文件 | 用户、知识、消息、配置、文件、向量元数据 | models/*.py |

| 基础设施 | Redis / Telemetry | 任务监听、指标、限流、事件推送 | utils/telemetry、utils/redis |

| 前端交互 | 会话视图、知识库、编辑器 | 多区域工作区 + 富文本 + 分析块 | src/routes + components |

这一分层使得“加一种向量库”与“加一个外部模型”复杂度都集中在 Adapter 层,避免牵涉业务层逻辑,维持修改半径最小化。换言之:它鼓励“中间件式创新”,而非“核心拆重写”。

4. 生命周期与运行机制(Lifecycle)

4.1 启动阶段

-

读环境变量 → 构造

AppConfig; -

迁移数据库(Alembic Upgrade Head)避免 schema 漂移;

-

初始化 OAuth / Tool / 模型配置结构写入

app.state; -

建立 Redis 连接、启动任务监听器(

redis_task_command_listener); -

线程池令牌注入(提升嵌入并发安全性);

-

预热:可选加载基础模型列表(减少首屏白屏等待);

-

OpenTelemetry 装饰(若开启)。

4.2 请求处理(Streaming Chat)

-

Auth 校验 → 解析上下文(历史 / 上下文窗口裁剪策略) → 可选 RAG → 组装 Prompt → Provider 流式推送 → 写入聊天记录。

-

中途若产生 Tool Invocation:先暂停主流 → 调用工具 → 注入结果 → 续写补全。

4.3 资源释放

-

Lifespan 结束时取消任务监听协程、防止“幽灵协程”残留。

4.4 状态划分

| 存储介质 | 典型数据 | 使用语义 |

|---|---|---|

内存 (app.state) | 模型列表、配置开关、实例 ID | 进程级快速访问 |

| Redis | 会话缓存、任务指令、事件派发 | 跨实例共享 / 临时状态 |

| 数据库 | 用户、消息、文件元数据、知识库、配置版本 | 持久一致性 |

| 文件系统 / 对象存储 | 原始文件、转换中间件产物 | 非结构化资产 |

5. 数据流全路径(RAG + 工具调用)

一个“带工具 + 检索”的复杂请求可抽象为:

User Query│▼

Session Context Loader (历史裁剪 + 会话策略)│├─► (可选) Retrieval Pipeline│ ├─ Loader / Source (Files/Web/Youtube)│ ├─ Splitter (Recursive / Markdown Header)│ ├─ Embed (SentenceTransformer / External)│ ├─ Vector Search (ANN / Hybrid)│ ├─ Rerank (CrossEncoder / ColBERT / External)│ └─ Context Assembly (Prefix + Top-K)│├─► Tool Decision (基于 Prompt + JSON Schema)│ ├─ Need Call? → Yes → Invoke Tool Server / Internal Func│ └─ Merge Tool Output → Augment Prompt│▼

Provider Adapter (Ollama / OpenAI / ...)│ (stream tokens)▼

Incremental Persist + WebSocket Emit│▼

Post Processing (Formatting / Markdown / Math / Code Blocks)

要点:

-

检索与工具决策并非强耦合;可串行也可策略上并行(先工具后检索或反之)。

-

Hybrid Search 降低纯向量召回语义漂移风险;Rerank 将 Top-K 再精炼。

-

Tool 回填结果可视作一个“中间节点上下文扩展事件”。

-

流式输出前端可边渲染边解析 Markdown,再延迟执行代码高亮、公式渲染。

6. 模型抽象与扩展策略(Model Abstraction)

6.1 统一调用契约

无论 Ollama / OpenAI / 自建兼容 API,都应符合:

-

输入:messages[], model, temperature, tools(optional), stream=bool

-

输出(流式):delta(content/tool_calls/role) + usage 统计(结束时)

6.2 本地优先与多后端聚合

-

Ollama:适合私有、离线、成本可控实验;多 Base URL 提供简易负载分摊。

-

远程 API:补足最新能力(高质量 reasoning 模型、多模态输入)。

-

策略路由:后续可按对话特征 / Token 预算 / 召回难度进行“动态模型切换”。

6.3 Reranker / Embedding 模块热替换

-

Embedding:可切换模型(不同尺寸、不同语料适配),对长文本批量化处理。

-

Reranker:CrossEncoder 强质量但慢;ColBERT 适中;External(如远程 API)做“软插槽”。

-

通过工厂函数

get_ef/get_rf隔离实现差异,减少上层联动变更。

6.4 资源治理

-

模型加载惰性 + 缓存;大模型加载失败时回退(错误日志 + 提醒前端)。

-

结合未来 Token Ledger,可形成:调用预算 → 路由模型 → 限流 / 降级。

7. RAG 策略矩阵(Retrieval Strategy Matrix)

| 维度 | 选项 | 影响 | 调优建议 |

|---|---|---|---|

| Chunk 切分 | 递归字符 / Markdown Header / Token 限制 | 上下文语义完整度 vs 召回精度 | 文档结构明显 → Header;代码类 → Token 控制 |

| 向量模型 | 通用 sentence-transformers / 域适配 / 多语言 | 召回语义匹配质量 | 多语言场景选择 LaBSE / mContriever |

| Hybrid | 仅向量 / 向量+关键词 | 长尾覆盖 | 内容含领域术语时启用关键词过滤 |

| Rerank | 无 / CrossEncoder / ColBERT / External | 最终 Top-K 相关性 | QPS 高时减少 Rerank K 值 |

| Top-K | 3~10 | 上下文窗口长度 | 结合模型上下文限制动态裁剪 |

| 缓存 | 向量缓存 / 召回缓存 | 吞吐提升 | 对冷门长文本启用持久化缓存 |

| 来源混合 | 本地 + Web Search | 时效性 / 准确性 | 命中阈值不足走外部搜索补全 |

高级玩法:

-

语义聚类后重排序(降低重复 chunk)。

-

动态 K:依据用户问题长度 / 领域匹配度自适应。

-

负反馈(用户点踩)反向写回:调整文档权重或触发重嵌入。

8. 安全、合规与审计(Security & Compliance)

| 领域 | 实践 | 深化建议 |

|---|---|---|

| 身份认证 | OAuth / OIDC / API Key 开关 | 引入细粒度 Token Scope、过期策略 |

| 授权 | 用户组、资源分组 | 基于 Attribute 的策略标签(ABAC) |

| 日志审计 | Audit 中间件 | 统一格式(JSON Lines)+ TraceID 关联 |

| 数据隔离 | 知识库集合按组过滤 | 结合向量库命名空间、物理隔离高敏集合 |

| 隐私保护 | 预处理脱敏(哈希/掩码) | RAG 前过滤敏感标签片段 |

| 外部调用 | Tool Server 白名单 | 结果沙箱校验(JSON Schema + 字段白名单) |

| 代码执行 | 超时 + 授权开关 + Kernel 隔离 | 资源配额(CPU/内存)+ 导出黑名单 |

| 配置修改 | PersistentConfig 版本化 | 变更审计 + 回滚策略 |

9. 前端交互范式(Interaction Patterns)

9.1 消息与上下文视图

-

左侧会话树 / 中间消息流 / 右侧知识或工具侧栏。

-

虚拟列表技术保障长对话不卡顿。

9.2 富文本 + Prompt 工具箱

-

TipTap 插件:表格、代码、公式、引用、Mention、文件内联。

-

Prompt 收藏与版本控制可进一步演化为“Prompt Registry”。

9.3 实时与协作

-

yjs 协同:多人同时编辑知识文档或共享 Prompt 模板。

-

WebSocket 推送系统消息(模型更新 / 系统公告)。

9.4 浏览器内 Python(Pyodide)

-

数据预览、轻量清洗、预先统计再提交后端做大活。

-

结合安全策略:前端侧不接触敏感原始数据时更易合规。

9.5 可观测反馈与信任

-

Token 计数 / 延迟指示 / 模型来源标记提升用户心智。

-

回答后“自评”或“引用来源”可增强可解释性(结合 RAG 引用段落高亮)。

10. 典型应用场景与案例(Use Cases)

10.1 企业私有知识助理

(略,已在前稿描述,此处扩展测量指标)

-

KPI:首次答复命中率、平均检索延迟、平均学习周期缩短。

-

监控:向量召回命中分布、Rerank 前后 NDCG 改善幅度。

10.2 多模型评测工作台

-

增加“评分模板”+ 主观打分表单,形成模型对比排行榜。

-

自动采样真实历史 Query 回放 → 统一生成 → 人工或半自动评估。

10.3 法务 / 合规问答

-

构建“高敏集合” + 审计日志联动,当回答引用敏感章节时增加风险提示。

10.4 数据分析与轻量 BI

-

结合 Code Interpreter 直接在会话中生成趋势图;图形对象存档并可再次引用。

10.5 运营活动智能生成

-

读取历史活动文案 → 向量检索优秀案例 → 模型生成新方案 → 审核流(工具函数:检测敏感词 / 法务校验)。

10.6 Dev 团队知识传承

-

解析 Git Repo README / ADR(架构决策记录)→ 分层拆分 → 检索回答“为什么选型 X?”

10.7 事件驱动协作机器人

-

Redis 监听队列事件,如“新版本发布”→ 推送公告 + 自动生成 Changelog 摘要。

10.8 教学实验与模型原理拆解

-

学生上传论文 PDF,系统自动切片+嵌入 → 提问概念 → 展示引用段落 → 增强可追溯学习。

10.9 客户支持知识助手

-

工单摘要 + 历史 FAQ → 模型建议初步回复 → 人类审核再发出;日志用于持续调优。

10.10 智能脚本执行 / 运维助手(受控)

-

工具函数封装白名单运维命令(查看服务状态、重载某配置)。

-

LLM 解析意图 → 匹配工具 → 返回结果 Markdown 化。

11. 性能、扩展与调优(Performance & Scaling)

| 场景 | 风险 | 策略 |

|---|---|---|

| 高并发检索 | 向量搜索放大效应 | 预分片索引 / 限制并发 / 热点集合分裂 |

| 大文件批量导入 | CPU 切片/嵌入阻塞 | 异步任务队列 + 进度事件 + 断点续处 |

| Rerank 过载 | CrossEncoder 线性放大 | 动态阈值(相似度>阈值跳过重排) |

| 模型响应抖动 | 外部 API 波动 | 多端点轮询 + 熔断 + 指数退避重试 |

| Redis 瓶颈 | 大消息广播 | 频道拆分 + 批量合并 + TTL 剪枝 |

| 内存膨胀 | 大量上下文缓存 | LRU / 会话分级(活跃 vs 冷)迁移到 Redis |

| Token 成本不可控 | 用户滥用 | 日配额 + Prompt 长度裁剪策略 |

11.1 观测闭环

-

Trace 分解阶段:切片 | 嵌入 | 检索 | Rerank | 模型调用 | 工具时间。

- 指标:

-

rag_recall_count / rag_rerank_adjustment

-

model_latency_bucket

-

tool_invocation_failure_total

-

-

日志与 Trace 关联:统一

request_id注入。

11.2 未来可加速点

-

SIMD / GPU Embedding 批量化

-

向量索引定期重构(减少碎片)

-

前端 WASM 预嵌入(小模型)减轻后端压力

12. 未来演进路线(Roadmap 倾向)

| 方向 | 价值 | 技术挑战 |

|---|---|---|

| 多 Agent 协作编排 | 复杂任务拆解 | 状态共享一致性、竞态冲突 |

| 动态模型路由 | 成本/质量自适应 | 质量评分在线评估闭环 |

| Token 成本账本化 | 预算控制 / 报表 | 精确流式计量与对账 |

| 机密计算 / 隐私 | 金融/医疗落地 | SGX/TEE 集成、加密向量检索 |

| 多模态统一 | 图像/音频/视频/文本融合 | 向量维度差异与交叉对齐 |

| 插件生态市场 | 社区扩展 | 版本兼容与沙箱安全 |

| 边缘协同推理 | 低延迟/离线 | 模型量化、调度策略 |

13. 实施落地建议(Adoption Guide)

13.1 渐进式接入路线

-

Phase 1:单节点部署 + 单模型聊天

-

Phase 2:接入 RAG(文件 → 向量化 → 问答)

-

Phase 3:工具函数(数据库查询 / Web 抓取)

-

Phase 4:审计 / 遥测 / 成本统计(闭环优化)

-

Phase 5:多模型自适应 + Prompt 资产管理

13.2 环境与配置建议

-

使用 docker-compose.gpu + 按需挂载持久卷(data / models / logs)。

-

Redis 建议哨兵或集群(高可用)。

-

向量库若使用外部(如 Milvus / Weaviate)需加网络加密与 ACL。

13.3 运维基线

| 项目 | 基线 | 告警阈值 |

|---|---|---|

| API p95 延迟 | < 2s | >5s 连续 5min |

| 工具失败率 | < 2% | >10% |

| Redis CPU | < 60% | >85% |

| 嵌入排队深度 | < 20 | >100 |

| Token 日用量偏差 | ±15% | 超过 30% |

13.4 团队协作模式

-

平台组:维护底座(检索 / 模型 / 工具框架)。

-

业务组:只编写工具函数 + Prompt 模板。

-

安全合规:配置策略 + 审计回看。

-

数据分析:用评估模块反馈质量 → 推动模型/Prompt 进化。

14. 与其他同类项目的对比简析

| 项目 | 侧重点 | 差异化 |

|---|---|---|

| Open WebUI | 通用多模型 + RAG + 工具 + 交互体验 | 前端协作/富文本 + Pyodide + 插拔策略 |

| LangChain Hub | Prompt/Chain 分享 | Open WebUI 更偏“执行界面” |

| ChatGPT Web UI 镜像类 | 单一模型聊天 | 缺少检索、工具、治理与扩展框架 |

| LlamaIndex Playground | 文档索引 / RAG | WebUI 在多模型与工具层更全栈 |

| AutoGen Studio (设想) | 多 Agent 对话 | WebUI 可演进补齐 Agent 调度 |

15. 常见踩坑与规避

| 问题 | 诱因 | 解决 |

|---|---|---|

| 检索结果无关 | Chunk 过小 / 模型不匹配 | 调整切分策略 + 更换领域模型 |

| Rerank 超时 | Top-K 过大 | 控制初筛 K 或启用相似度阈值直接通过 |

| 模型频繁报错 | 多端点质量不一 | 健康检查 + 熔断剔除失效端点 |

| WebSocket 断连 | 代理超时 / 心跳无 | 加心跳包 + 重连策略 |

| 工具误调用 | 描述过宽 | JSON Schema 更严格 + 反向确认策略 |

| 配置改不生效 | 缓存未更新 | 确认 PersistentConfig 开启并触发 save_config |

16. 代码片段式理解(Micro Insights)

16.1 Lifespan 预热

通过 lifespan 异步上下文在 FastAPI 启动时创建后台任务(模型列表预取、Redis 监听),使请求路径保持轻量纯净。

16.2 Retrieval 工厂

get_ef / get_rf 将“模型路径解析 + 更新策略 + 信任代码”抽象,便于集中安全审查(如限制远程代码执行)。

16.3 PersistentConfig 模式

优先从数据库加载最新配置,而非死锁在 env:利于“UI 可调优 / 实验参数在线 Gray Release”。

16.4 Web Search 适配

多搜索引擎函数统一包装返回结构体(title / url / snippet),后续统一 Rerank 或拼接摘要,降低接入碎片度。

17. 未来想象:向“自治 AI 运营控制台”迈进

一旦加入:

-

Agent 任务图(DAG) + 任务状态可视化

-

自适应模型选择(质量-成本-延迟多目标优化)

-

Prompt 模板 AB 实验平台

-

Token 财务账本 + 成本归属追踪

-

知识治理(文档陈旧度评分 / 自动重嵌入计划) Open WebUI 将从“聊天入口”转变为“AI 运营中枢”,为组织沉淀标准化智能接口逻辑与治理能力。

18. 总结(Key Takeaways)

-

它不是“再造一个聊天框”,而是 AI 应用编排与治理的“壳层”。

-

五个关键支点:多模型抽象、可组合 RAG、工具/函数生态、配置持久化、观测与审计。

-

技术价值 = 降低试验摩擦 + 降低跨栈沟通消耗 + 提升治理可视化。

-

未来竞争力核心在“生态 + 低耦合扩展性 + 成本与质量闭环”。

-

对个人开发者:是快速验证想法的“侧重体验的全家桶”;对团队:是构建私有 AI 能力平台的跳板。

归根到底,Open WebUI 的“魔力”不是功能堆砌,而是将 AI 能力的五个离散要素(数据、模型、工具、上下文、协作)压缩成一个统一可迭代界面。剩下的,就是在它之上生长业务价值。

19. 附录:快速部署(示意)

以下仅示范结构,实际请参考官方 README。命令基于 Windows PowerShell。

git clone https://github.com/open-webui/open-webui.git

cd open-webui

docker compose -f docker-compose.yaml up -d

# 浏览器访问 http://localhost:8080

可选:启用 GPU (NVIDIA):

docker compose -f docker-compose.gpu.yaml up -d

持久卷建议:挂载 data/ 与 models/ 避免重启重建。

20. 彩蛋:为什么说它“像瑞士军刀但不臃肿”?

-

组件原子化(工具、检索、模型、会话、配置各自围栏);

-

依赖边界清晰;

-

插拔点公开(工厂/路由/中间件);

-

最终用户体验层在前端强交互表达(富文本、协作、可视化)。

你可以只用它的 30%,也能在其上延展 300%。

感谢阅读到这里。如果你计划:

-

将多个模型“控台化”

-

搭建团队知识助理 / 运维助手 / 评测平台

-

试验 RAG、工具函数、Agent 编排 Open WebUI 值得 fork 一下。

让可组合的底座去对抗复杂度,让创造力专注在业务与体验上。祝构建愉快!

更多AIGC文章