AIOps概述:Langfuse、Opik、KeepHQ、LangSmith

概述

AIOps,可大致等同于MLOps,将大数据与人工智能或机器学习相结合,以增强或部分取代广泛的IT运维流程和任务。DevOps的重点是在整个应用生命周期中不断地进行微小的增量改进。AIOps通过在开发和运维过程中添加数据科学来增强DevOps,DevOps的演进。

LLMOps,是MLOps的细分领域概念,是伴随大模型火热后产生的概念,针对LLM全生命周期管理的实践和流程,涵盖模型开发、部署、监控及优化等环节。

功能列表:

- 模型管理:支持低代码/无代码流程设计,通过可视化界面拆分任务逻辑,对接多种大模型API及系统,快速构建复杂推理能力的智能体

- 模型微调:针对特定任务微调LLM,并细化模型以获得最佳性能

- 数据管理:处理大量数据集,确保正确的数据版本控制,并促进探索性数据分析

- 提示工程:创建有效的提示模板以提高模型性能

- 运维监控:提供持续实时运行看板、跟踪模型结果、资源调度、异常告警、日志追溯、检测精度下降并解决模型漂移问题,确保高并发环境下的稳定性

- 安全合规:集成数据脱敏、权限管控等功能,保障AI模型在处理敏感数据时符合行业监管标准

本文不严格区分AIOps、MLOps、LLMOps。早期AIOps平台后面也持续新增LLMOps功能。

Langfuse

开源(GitHub,16.1K Star,1.5K Fork),官方文档,LLM全栈解决方案。

定位:

开源LLM工程平台:LLM可观测性、指标、评估、提示管理、演练场、数据集。集成OpenTelemetry、Langchain、OpenAl SDK、LiteLLM等。

通过分布式追踪技术构建覆盖LLM调用、RAG过程、Agent决策等环节的多层次、细粒度监控,采用树状结构存储追踪数据,每个节点(Span)包含输入输出、耗时、Token使用量、成本估算等元数据,支持可视化时间线分析和复杂会话的上下文重建。

提示管理系统引入模板继承与组合机制,例如支持通过{{parent_prompt}}标签实现跨提示的知识片段复用。

提供Python、TS SDK,支持在客户端缓存追踪数据并批量异步上报,以减少对生产应用主线程的性能影响。

采用微服务架构设计,旨在提供端到端的LLMOps能力,核心组件:

- 追踪收集器:高性能API端点,设计用于处理每秒万级Span写入。

- 分析引擎:对收集到的追踪数据进行实时分析,计算质量、成本、延迟等关键指标。

- 提示仓库:支持多环境、多版本的提示模板管理与部署。

- 评估工作流:集成自动化测试框架与人工评估接口,支持数据集管理和评估结果追踪。

通过OpenTelemetry兼容协议实现与现有监控体系的对接。其独特的会话视图(Session View)功能可将分散的LLM调用、工具使用和用户反馈聚合为完整的用户交互上下文,便于理解复杂Agent行为。在扩展性方面,Langfuse提供插件机制支持自定义数据导出器和评估器开发。

通过自动检测LangChain的回调接口实现零配置或极少配置集成,能够捕获包括Tool使用、Memory机制交互在内的完整执行轨迹。

数据屏蔽功能支持基于正则表达式或自定义逻辑对追踪数据中的敏感内容进行筛查和替换,并可将包含潜在违规内容的记录路由到隔离存储区或触发告警。

LLM-as-Judge方案采用分层评估策略:首先通过可配置的规则引擎(如关键词检测、长度限制)过滤明显错误的响应,然后调用如GPT-4这样的强模型进行语义一致性、事实性等方面的评分。这种混合方法在保证评估精度的同时,据称可将评估成本降低42%。

Opik

Comet开源(GitHub,13.9K Star,977 Fork),官方文档,官网

提出三层评估框架:

- 单元测试层:验证单个提示或小组件(如解析器、工具调用)的响应准确性、格式合规性;

- 集成测试层:检查包含多个LLM调用、RAG、Agent逻辑的多步骤工作流的逻辑一致性和端到端性能;

- 生产监控层:持续追踪用户反馈(如点赞/点踩)、业务指标(如转化率)以及模型漂移情况。

支持指标:

- 响应相关性(Relevance):响应内容与用户问题的匹配程度

- 事实准确性(Factualness/Groundedness):响应内容是否基于提供的上下文或真实世界知识,有无幻觉

- 无害性/毒性(Toxicity/Harmfulness):响应内容是否包含不当言论

- 风格一致性(Style Consistency):响应是否符合预设的语气、角色或格式要求

- 简洁性(Conciseness):响应是否简洁明了,无冗余信息

提出的预部署检查清单中包含针对欧盟AI法案等法规的合规性验证项,并支持基于评估结果自动生成部分技术文档。

KeepHQ

官网,开源(GitHub,10.7K Star,1.1K Fork)AIOps平台,基于Python,易于增强和定制,支持添加新集成,目前已有110多个提供者,涵盖工具如Prometheus、CloudWatch和Datadog。支持CI/CD管道集成,适合云、内部部署或隔离环境,满足不同安全和合规需求。

部署方式:

- 提供Helm Chart和Docker Compose安装脚本,支持本地和k8s环境一键部署

- 提供沙盒环境Playground,用户可在此探索功能

- Platform则用于租户配置,确保团队能测试和优化策略

功能:

- 集中警报管理:将多个Prometheus实例和按地区/账户的CloudWatch设置的警报集中到一个仪表板,供审查、节流和微调。

- 警报丰富:通过观测工具、数据库和工单系统提供上下文,包括企业特定触发器和客户影响细节,便于决策。

- 自动化警报响应:自动化常见警报响应,如确认端点502错误或检查低优先级客户影响前不升级。

- 多环境监控:跨环境集中警报,设置环境特定规则,提供统一系统健康视图。

- 噪音减少:通过去重、节流和静音减少噪音,确保团队只关注关键问题。

- SLA合规性:跟踪警报解决时间,确保SLA合规性,配备自动化和报告功能。

- 事件关联:使用工作流和映射规则关联相关警报,快速识别根本原因,提供分组可操作见解。

- 工单系统集成:与Jira和ServiceNow等工单工具同步,自动化工单创建和更新,确保无缝工作流。

生态集成方面,支持超过110个提供者,通过Webhook、路由策略或API与工具如Zabbix、Nagios连接。

企业安全功能包括完整身份验证支持(如SSO、SAML、OIDC、LDAP),以及细粒度的访问控制(RBAC、ABAC)和团队管理,适合生产规模工作负载,支持高可用性和水平扩展。

与StackStorm相比,Keep提供更简单的UI和更紧密的监控工具API集成。社区还建议添加功能如抖动检测(Flap Detection)和自动补救,目前节流策略已可用,抖动检测计划中。

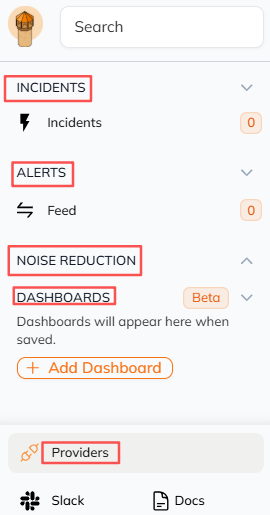

界面

分类

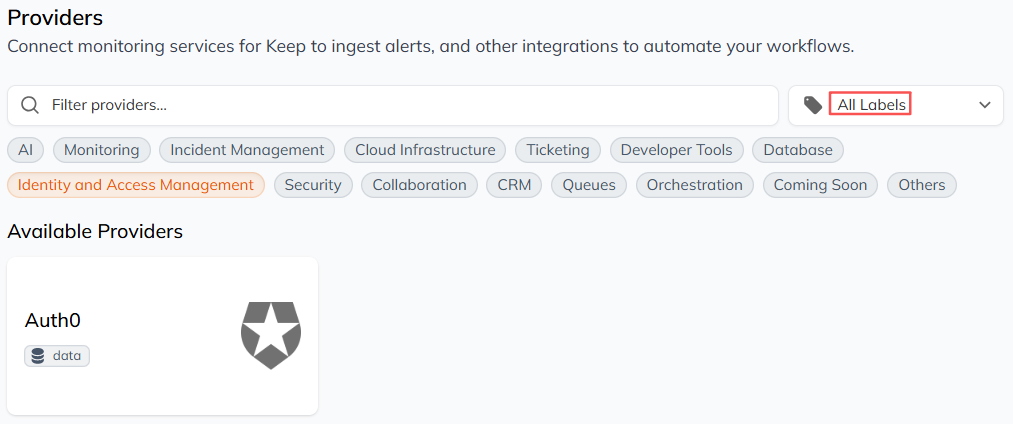

标签

其中AI提供商:Anthropic、DeepSeek、Gemini、Grok、LiteLLM、Llama.cpp、Ollama、OpenAI、vLLM

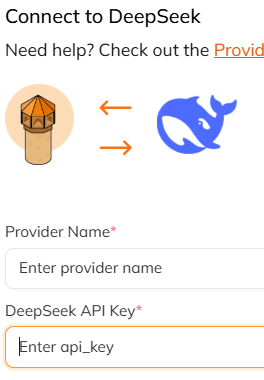

连接到DeepSeek,配置API Key即可:

工作流

监控领域的n8n.io,监控工具的GitHub Actions。Keep工作流是一个声明式的YAML文件,用于自动化警报和事件管理。每个工作流包含:

- 触发器:启动工作流的条件(警报、事件、计划或手动)

- 步骤:读取或获取数据(丰富、上下文)

- 操作:执行操作(更新工单、发送通知、重启服务器)

示例

workflow:id: sentry-alerts

description: create ticket alerts for critical alerts from sentry

triggers:- type: alert# customize the filter to run only on critical alert from sentryfilters:- key: sourcevalue: sentry- key: severityvalue: critical# regex to match specific services- key: servicevalue: r"(payments|ftp)"

actions:- name: send-slack-message-team-payments# if the alert is on the payments service, slack the payments teamif: "'{{ alert.service }}' == 'payments'"provider:type: slack# control which Slack configuration you want to useconfig: " {{ providers.team-payments-slack }} "# customize the alert message with context from {{ alert }} or any other {{ step }}with:message:|"A new alert from Sentry: Alert: {{ alert.name }} - {{ alert.description }}{{ alert}}"- name: create-jira-ticket-oncall-board# control the workflow flow with "if" and "foreach" statementsif: "'{{ alert.service }}' == 'ftp' and not '{{ alert.ticket_id }}'"provider:type: jiraconfig: " {{ providers.jira }} "with:board_name: "Oncall Board"custom_fields:customfield_10201: "Critical"issuetype: "Task"# customize the summarysummary: "{{ alert.name }} - {{ alert.description }} (created by Keep)"description:|"This ticket was created by Keep.Please check the alert details below:{code:json} {{ alert }} {code}"# enrich the alerts with more context. from now on, the alert will be assigned with the ticket id, type and urlenrich_alert:- key: ticket_typevalue: jira- key: ticket_idvalue: results.issue.key- key: ticket_urlvalue: results.ticket_url

解读:为来自Sentry的支付和API服务的关键警报创建Jira工单。

Phoenix

Arize AI开源(GitHub,7K Star,571 Fork),官网,官方文档。AI可观测性和评估框架。

基于OTEL实现跨框架的追踪数据收集,支持将LLM性能指标与基础设施监控数据(如CPU、内存使用率)进行关联分析

提出基于嵌入向量的语义相似度分析框架,通过对比输入问题与知识库文档的向量距离,或对比问题与响应的相似度,辅助识别语义不一致或与知识库不符等响应质量异常案例。

自动评估库内置了超过20个预置评估模板(Evaluators),支持通过少量样本快速构建定制化评估流程,覆盖事实性、相关性、毒性等多个维度。其分布式任务调度器据称可在一小时内完成百万级响应的质量筛查

与HuggingFace生态系统深度整合,其评估模板库中包含针对常见NLP任务的预置检查项和数据集。

OpenLLMetry

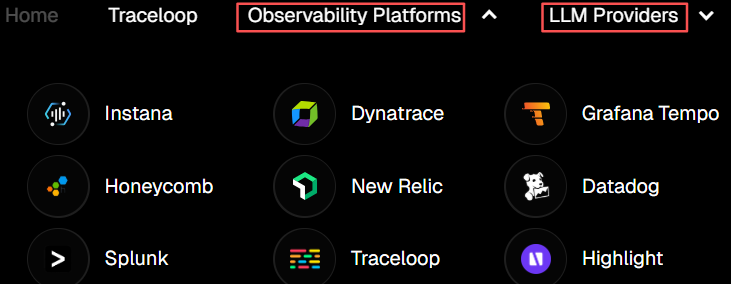

开源(GitHub,6.4K Star,798 Fork),官方文档,官网

LLM提供商全是国外的。

将OpenTelemetry(OTEL)标准引入LLM领域,通过扩展Span定义(如增加llm.prompt,llm.completion,llm.token_count.prompt等属性),实现对模型名称、版本、temperature等LLM特有属性的标准化采集。

通过扩展OpenTelemetry的语义约定(Semantic Conventions for LLMs),使得监控数据的采集与底层模型实现和具体框架解耦。

评估数据管道可与Dynatrace等APM系统的日志与指标系统深度集成,使运维团队能够直接在其熟悉的APM界面查看模型性能相关的评估指标。

Agenta

开源(GitHub,3.2K Star,370 Fork),官方文档,官网

专注于优化LLM应用的迭代开发和团队协作体验,其架构特点:

- 交互式Playground:支持并行对比多个不同模型、不同版本提示或不同参数配置的输出结果;

- 配置管理系统:基于JSON Schema构建可视化编辑器,简化复杂应用(如RAG流程、Agent)的参数配置与管理;

- 评估看板:聚合自动化测试结果与人工反馈数据,提供多维度评估指标的可视化。

提出的环境标签机制允许开发者在不同部署阶段(如开发、暂存、生产)动态切换提示模板,其版本控制系统支持基于Git的分支策略管理提示的迭代过程。

技术栈:React和Django。

在权限控制和数据治理方面,提供完整的基于角色的访问控制(RBAC)权限管理体系。实现基于属性的访问控制(ABAC),能够更细粒度地确保提示版本库、评估数据集和测试结果在组织内的安全共享。

在部署方案上,Agenta支持Kubernetes集群部署和完全托管的云服务两种模式。

在多模型支持方面,实现统一的API抽象层,当前已集成OpenAI等超过15家主流LLM提供商的模型接口。

在人工评估环节,Agenta实现标注任务队列管理,支持基于模型输出的置信度分数或其他启发式规则,动态路由样本到人工复核环节,相比全量人工审核,可显著减少工作量。

成本控制与预算预警:Agenta的用量监控与预警系统,可基于历史数据和滑动窗口算法预测月度API支出,精度据称可达±5%以内,帮助团队避免超预算。

Pezzo

开源(GitHub,3.1K Star,258 Fork),官方文档,官网

提供基于Web的实时协作编辑器,并整合变更审批工作流,以确保提示的修改和发布符合企业级开发规范。

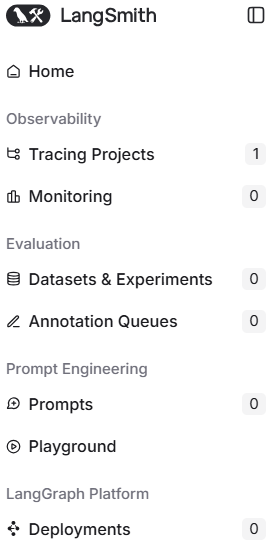

LangSmith

开源(GitHub,639 Star,150 Fork),官方文档,官网。

LangChain提供的AI应用开发监测平台,可用于观察调用链运行情况。功能:

- 记录运行日志

- 提示词版本管理

- 数据集评估

入门

登录后侧边栏如下

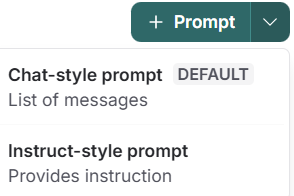

新增Prompt

LangGraph平台:一键部署LangGraph应用,仅限付费用户。

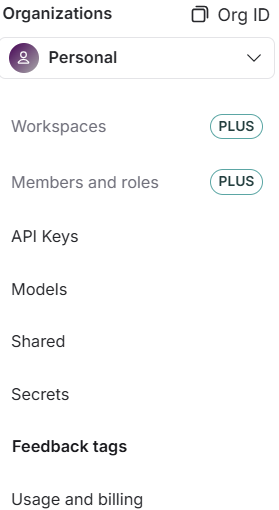

设置

可新增组织

新增API Key

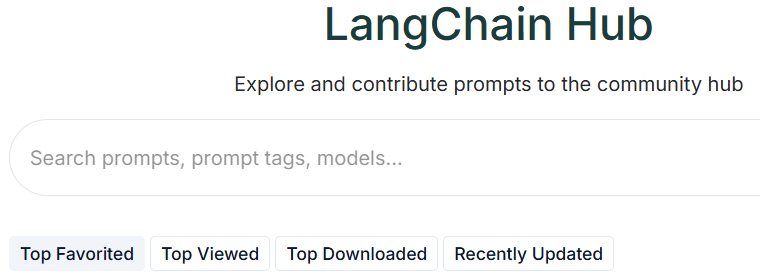

LangSmith提供LangSmith Hub

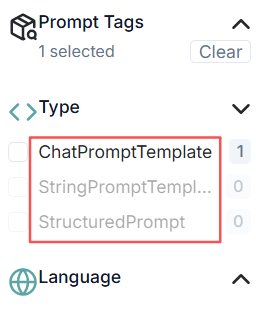

搜索筛选条件包括标签(如RAG、Chatbots)、类型(三种,ChatPromptTemplate、StringPromptTemplate、StructuredPrompt)和语言:

功能:

- 编辑提示语及提示语版本

- 类似Playground的提示语运行环境

- 在应用中加载提示语

- 与他人共享提示语

提供Python和JS SDK接入:

# Create a LANGSMITH_API_KEY in Settings > API Keys

from langsmith import Client

client = Client(api_key=LANGSMITH_API_KEY)

# 加载特定版本的提示语:hub.pull("yakult/quickstart:c53fcc9d")

prompt = client.pull_prompt("hardkothari/prompt-maker", include_model=True)