LRU缓存详解:用C语言实现高效数据管理

引言:图书馆管理员的智慧

想象你是一个图书馆管理员,书架上只能存放10本书。当读者归还一本书时,你需要把它放回书架。但如果书架已满,你就必须决定哪本书应该被移走。

聪明的做法是:把最近最少被借阅的书移走。因为这本书已经很久没人关心了,很可能近期也不会有人借它。

这就是LRU(Least Recently Used)缓存算法的核心思想!在计算机世界中,我们用它来管理有限的内存空间,确保最常用的数据能够快速访问。

第一部分:LRU缓存是什么?为什么需要它?

什么是缓存?

缓存就像是你桌面上最常用的文件和工具——你把它们放在手边,这样就不需要每次都用时都去文件柜里翻找。

LRU的特殊之处

LRU缓存有一个特点:它会自动淘汰那些最近最少使用的数据,就像聪明的图书馆管理员一样。

为什么需要LRU?

// 没有缓存的情况:每次都需要慢速查找

int 获取数据(int 键) {return 从慢速存储器中查找(键); // 很慢!

}// 有LRU缓存的情况:大部分时间快速访问

int 获取数据(int 键) {if (缓存中有(键)) {return 从缓存中获取(键); // 很快!} else {int 数据 = 从慢速存储器中查找(键); // 慢,但不可避免将数据放入缓存(键, 数据); // 为后续访问加速return 数据;}

}

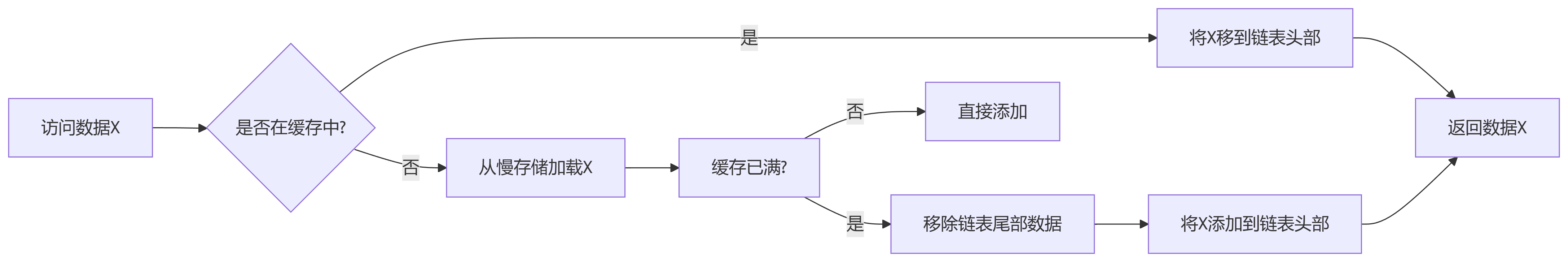

第二部分:LRU缓存的工作原理

基本思路

LRU缓存就像一个有容量限制的热门排行榜:

1. 当你访问一个数据时,它就被标记为"最近使用"

2. 当缓存满了需要腾空间时,淘汰那个最久没被使用的数据

需要什么数据结构?

为了实现LRU,我们需要:

1. 快速查找:用哈希表通过键快速找到数据

2. 记录使用顺序:用双向链表记录数据的使用顺序

第三部分:用C语言实现LRU缓存

定义数据结构

#include <stdio.h>

#include <stdlib.h>

#include <assert.h>// 缓存节点结构

typedef struct CacheNode {int key; // 键int value; // 值struct CacheNode *prev; // 前一个节点struct CacheNode *next; // 后一个节点

} CacheNode;// LRU缓存结构

typedef struct {int capacity; // 缓存容量int size; // 当前大小CacheNode *head; // 链表头(最近使用的)CacheNode *tail; // 链表尾(最久未用的)CacheNode **hashmap; // 哈希表(用于快速查找)

} LRUCache;创建缓存

// 创建LRU缓存

LRUCache* lruCreate(int capacity) {LRUCache *cache = (LRUCache*)malloc(sizeof(LRUCache));cache->capacity = capacity;cache->size = 0;cache->head = NULL;cache->tail = NULL;// 创建哈希表(简单数组实现,实际应用可能需更复杂的哈希表)cache->hashmap = (CacheNode**)calloc(1000, sizeof(CacheNode*));return cache;

}关键操作:将节点移到链表头部

// 将节点移动到链表头部(表示最近使用)

void moveToHead(LRUCache *cache, CacheNode *node) {if (node == cache->head) return; // 已经是头部// 从当前位置移除节点if (node->prev) node->prev->next = node->next;if (node->next) node->next->prev = node->prev;// 如果节点是尾部,更新尾部指针if (node == cache->tail) {cache->tail = node->prev;}// 将节点插入到头部node->prev = NULL;node->next = cache->head;if (cache->head) {cache->head->prev = node;}cache->head = node;// 如果缓存为空,设置尾部if (cache->tail == NULL) {cache->tail = node;}

}获取数据

// 从缓存中获取数据

int lruGet(LRUCache *cache, int key) {// 在哈希表中查找CacheNode *node = cache->hashmap[key];if (node == NULL) {return -1; // 未找到}// 找到数据,将其移到头部(标记为最近使用)moveToHead(cache, node);return node->value;

}添加数据

// 向缓存中添加数据

void lruPut(LRUCache *cache, int key, int value) {// 检查是否已存在CacheNode *node = cache->hashmap[key];if (node != NULL) {// 已存在,更新值并移到头部node->value = value;moveToHead(cache, node);return;}// 创建新节点node = (CacheNode*)malloc(sizeof(CacheNode));node->key = key;node->value = value;node->prev = NULL;node->next = NULL;// 如果缓存已满,需要移除最久未用的数据if (cache->size >= cache->capacity) {// 移除尾部节点(最久未用)CacheNode *tail = cache->tail;cache->hashmap[tail->key] = NULL; // 从哈希表中移除if (cache->tail->prev) {cache->tail = cache->tail->prev;cache->tail->next = NULL;} else {cache->head = NULL;cache->tail = NULL;}free(tail);cache->size--;}// 添加新节点到头部if (cache->head == NULL) {cache->head = node;cache->tail = node;} else {node->next = cache->head;cache->head->prev = node;cache->head = node;}// 更新哈希表和大小cache->hashmap[key] = node;cache->size++;

}

第四部分:完整示例

完整代码main示例

// 测试代码

int main() {// 创建容量为2的LRU缓存LRUCache *cache = lruCreate(2);// 添加数据lruPut(cache, 1, 100); // 缓存: {1=100}lruPut(cache, 2, 200); // 缓存: {2=200, 1=100}// 获取数据printf("键1的值: %d\n", lruGet(cache, 1)); // 返回100// 现在缓存: {1=100, 2=200}// 添加新数据,导致键2被淘汰(因为它是最近最少使用的)lruPut(cache, 3, 300); // 缓存: {3=300, 1=100}printf("键2的值: %d\n", lruGet(cache, 2)); // 返回-1(未找到)printf("键3的值: %d\n", lruGet(cache, 3)); // 返回300return 0;

}输出结果

键1的值: 100

键2的值: -1

键3的值: 300第五部分:LRU缓存的实际应用

1. 数据库缓存

数据库使用LRU缓存来存储频繁查询的结果,减少磁盘访问。

2. Web服务器缓存

Web服务器缓存频繁访问的网页内容,加快响应速度。

3. CPU缓存

CPU使用类似LRU的算法管理缓存层次结构。

4. 移动应用

手机应用使用LRU缓存最近查看的图片或数据。

第六部分:优化和改进

简单哈希表的限制

我们的实现使用了简单数组作为哈希表,这在键的范围很大时效率低下。实际应用中可以使用:

1. 更复杂的哈希函数

2. 处理哈希冲突的机制

3. 动态扩容的哈希表

线程安全

多线程环境下需要添加锁机制来保证线程安全。

更高效的实现

生产环境中可能会使用更高效的数据结构,如Linux内核中的LRU实现。

总结:LRU缓存的价值

LRU缓存之所以重要,是因为它解决了计算机科学中的一个基本问题:如何在有限的空间中管理数据,使得访问效率最高。

通过这个简单的C语言实现,你可以看到:

1. 双向链表记录了数据的使用顺序

2. 哈希表提供了快速的数据查找

3. 淘汰机制确保了缓存中总是保存着最有价值的数据

就像聪明的图书馆管理员一样,LRU缓存确保"热门图书"总是触手可及,而"冷门图书"则被妥善归档。

思考题:如果让你实现一个缓存,除了LRU,你还能想到其他的淘汰策略吗?哪种策略在什么场景下更有效?欢迎在评论区分享你的想法!