本地部署大模型和知识库实现问答AI

环境

系统:windows11

硬件:amd 7900x 3d、32G DDR5、3070(8g)、pcie4.0 1t固态硬盘

注意:请保持C盘有30GB+的空余空间,模型和环境(ollama等)所在的盘需要有20GB+的可用空间。

安装ollama

官网

https://ollama.com/

点击Download下载

配置环境变量

首先配置未来模型存放的位置,需要在系统变量中添加“OLLAMA_MODELS”,其值为你想要将未来下载模型存放的位置,这里我设置为“D:\LLM\ollama\models”

执行安装

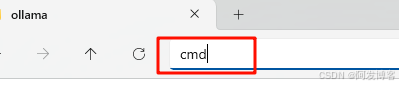

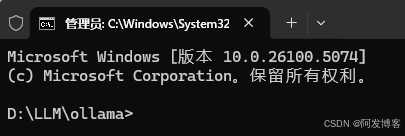

默认情况下,ollama是安装在c盘下的,如果需要安装在其他路径,可以再目标路径创建好文件夹,比如D:\LLM\ollama,然后将下载的OllamaSetup.exe文件拷贝到该文件夹下,在该文件夹下的文件管理器的文件路径中输入cmd,回车即可打开命令提示符窗口,此时命令提示符窗口就指向了该路径。

在命令提示符窗口内输入“OllamaSetup.exe /DIR=D:\LLM\ollama”,就会唤起ollama安装程序,此时执行安装,就会安装到目标位置,执行完安装后,ollama就安装完成了。

安装完成后,在桌面右下角位置,可以看到ollama图标

如果没有的话,你也可以在开始中搜索到它

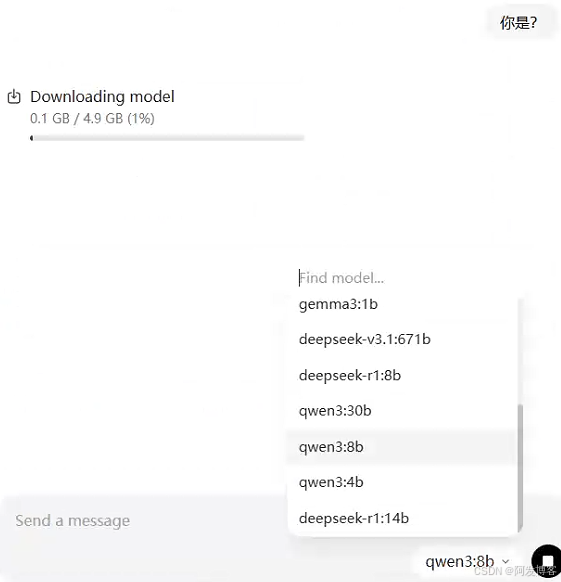

双击后,可以打开ollama的ui界面,在chat界面,可以在界面右下角看到选择模型的下拉框,点击后,可以选择模型,当你与该模型进行会话时,如果该模型你本地还没有下载部署,那么会先执行下载部署操作

在图中可以看到deepseek-r1:14b,是因为我已经下载安装了,截止目前,默认情况下是没有改模型选项的,所以如果这里没有你想要的模型,那么请继续看后面如何通过指令来实现目标模型的下载安装操作。

安装完成后,将 Ollama 添加到系统环境变量,请在系统变量的Path 变量中添加刚才ollama安装的位置“D:\LLM\ollama”,这样就可以直接在