Day21_【机器学习—决策树(2)—ID3树 、C4.5树、CART树】

一、ID3 决策树

1. 核心思想

使用信息增益(Information Gain)作为特征选择的标准,递归地构建决策树。

2. 特征选择标准

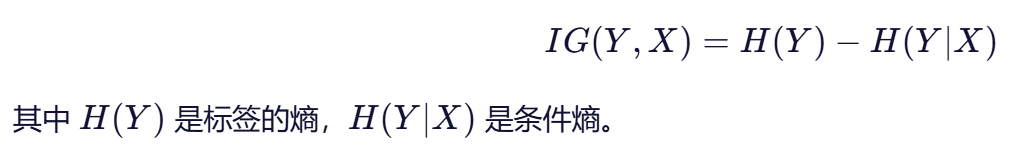

信息增益(IG):

选择使信息增益最大的特征进行划分。

3. 优点

- 算法简单,易于理解。

- 能够生成可解释性强的规则。

4. 缺点

- 只能处理离散(分类)特征,不能直接处理连续特征。

- 偏向于选择取值较多的特征(因为信息增益会偏高)。

5. 适用任务

仅支持分类任务。

二、C4.5 决策树

1. 核心思想

在 ID3 基础上改进,使用信息增益率(Gain Ratio)来克服信息增益的偏向性。

2. 特征选择标准

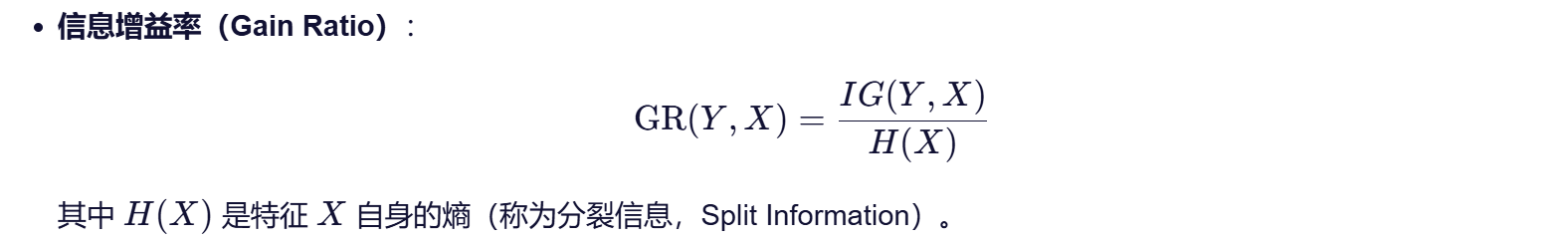

信息增益率(Gain Ratio):

使用增益率可以惩罚取值较多的特征,减少偏向。

3. 改进点(相比 ID3)

- ✅ 支持连续特征:通过二分法寻找最佳分割点。

- ✅ 支持缺失值处理:使用概率分布分配样本。

- ✅ 引入剪枝(后剪枝):提高泛化能力。

- ✅ 支持不同代价的误分类(代价敏感学习)。

4. 优点

- 适用于真实世界复杂数据。

5. 缺点

- 对噪声敏感。

- 可能产生较多小分支。

7. 适用任务

仅支持分类任务。

三、CART 决策树

1. 核心思想

使用基尼指数(分类)或平方误差(回归)作为划分标准,构建二叉树结构。

2. 特征选择标准

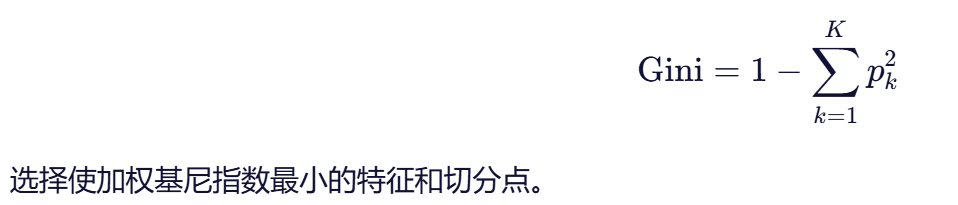

分类任务:使用基尼指数(Gini Impurity)

回归任务:使用最小平方误差(MSE),选择使子集方差最小的划分。

3. 树的结构

- 必须是二叉树:每个节点只分裂为两个子节点。

- 对离散特征:相当于进行“是/否”判断。

- 对连续特征:寻找最优分割阈值。

4. 优点

- 支持分类和回归两种任务。

- 输出结果稳定,易于实现。

- 支持剪枝,防止过拟合。

5. 缺点

- 二叉树可能导致树较深。

- 对数据变化敏感(小变化可能导致树结构大变)。

6. 适用任务

✅ 支持分类和回归任务。

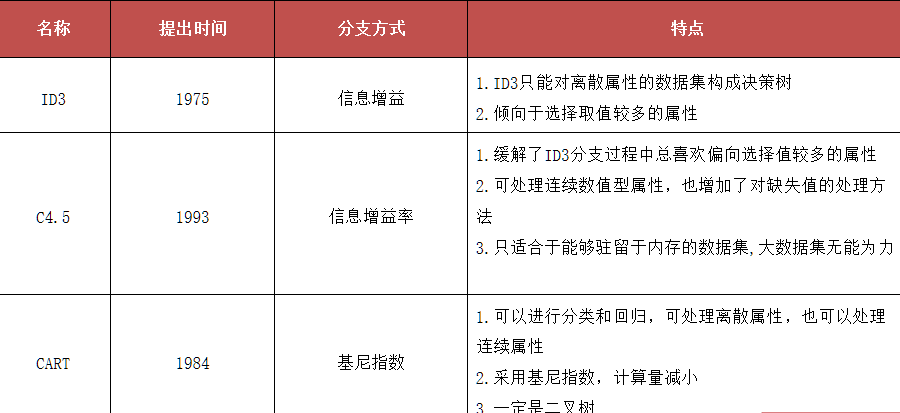

四、对比

五、小结

信息增益(ID3)、信息增益率值越大(C4.5),则说明优先选择该特征。

基尼指数值越小(cart),则说明优先选择该特征。