机器学习-朴素贝叶斯

在机器学习领域,朴素贝叶斯是入门级但实用性极强的分类算法。它基于贝叶斯定理和 “特征独立” 的朴素假设,不仅计算速度快,还能在文本分类、数据预测等场景中展现出色性能。

一、朴素贝叶斯的 “基石”:贝叶斯定理与朴素假设

1. 从 “正向 / 逆向概率” 理解贝叶斯定理

贝叶斯定理解决的是 “逆向概率” 问题 —— 已知结果,反推原因的概率。我们先通过生活中的例子区分正向概率和逆向概率:

正向概率:袋子里有 60 个白球、40 个黑球,伸手摸一个,摸到黑球的概率是多少?(已知 “因”:球的比例,求 “果”:摸球概率)

逆向概率:闭着眼摸出 1 个黑球,反推袋子里黑白球的比例可能是多少?(已知 “果”:摸出黑球,求 “因”:球的比例)

贝叶斯定理的数学表达式为:

P(h∣D)=P(D)P(D∣h)×P(h)

各符号含义:

--P(h∣D):后验概率,已知观测数据D(如 “穿长裤”“输入错误单词”),推测假设h(如 “是女生”“想输入 top”)成立的概率;

--P(D∣h):似然概率,在假设h成立的条件下,观测到数据D的概率;

--P(h):先验概率,假设h本身独立发生的概率(如 “女生占比 40%”“top 单词出现频率”);

--P(D):证据概率,观测数据D发生的总概率(对所有假设而言是常数,比较不同假设时可忽略)。

2. 朴素假设:简化计算的关键

朴素贝叶斯的 “朴素” 体现在假设所有特征相互独立—— 即特征之间不会相互影响。例如在垃圾邮件分类中,“免费” 和 “中奖” 两个单词的出现概率互不干扰。

这个假设看似严格,但实际应用中效果却很好:它能大幅简化计算,避免了 “计算多特征联合概率” 的复杂问题,让朴素贝叶斯在大数据场景下依然高效。

二、贝叶斯定理的经典实例

光看公式不够直观,我们通过两个实例理解贝叶斯定理的应用逻辑。

实例 1:穿长裤的学生是男生还是女生?

假设某学校学生中,男生占 60%(P(Boy)=0.6),女生占 40%(P(Girl)=0.4);男生全穿长裤(P(Pants∣Boy)=1),女生一半穿长裤(P(Pants∣Girl)=0.5)。

问题:迎面走来一个穿长裤的学生,是女生的概率是多少?

根据贝叶斯定理计算:

- 分子:P(Girl)×P(Pants∣Girl)=0.4×0.5=0.2;

- 分母(穿长裤的总概率):P(Boy)×P(Pants∣Boy)+P(Girl)×P(Pants∣Girl)=0.6×1+0.4×0.5=0.8;

- 后验概率:P(Girl∣Pants)=0.80.2=0.25(即 25%)。

结论:穿长裤的学生中,女生的概率仅 25%,更可能是男生。

实例 2:拼写纠正 —— 用户输入 “tlp” 想打什么?

当用户输入不在字典中的 “tlp” 时,我们需要推测其真实想输入的单词(如 “top” 或 “tip”)。

核心逻辑:比较不同假设的后验概率,选择概率最大的猜测。

定义变量:

- D:观测数据(用户输入 “tlp”);

- h1:假设 1(想输入 “top”);

- h2:假设 2(想输入 “tip”)。

简化计算:

由于P(D)对所有假设是常数,只需比较P(h)×P(D∣h):- P(h1):“top” 在日常文本中的出现频率(先验概率),假设为 0.001;

- P(D∣h1):想输入 “top” 却输成 “tlp” 的概率(似然概率),假设为 0.01;

- P(h2):“tip” 的出现频率,假设为 0.0005;

- P(D∣h2):想输入 “tip” 却输成 “tlp” 的概率,假设为 0.01。

计算比较:

- P(h1)×P(D∣h1)=0.001×0.01=10−5;

- P(h2)×P(D∣h2)=0.0005×0.01=5×10−6。

结论:“top” 的概率更高,因此推测用户想输入 “top”。

三、朴素贝叶斯的三大变体

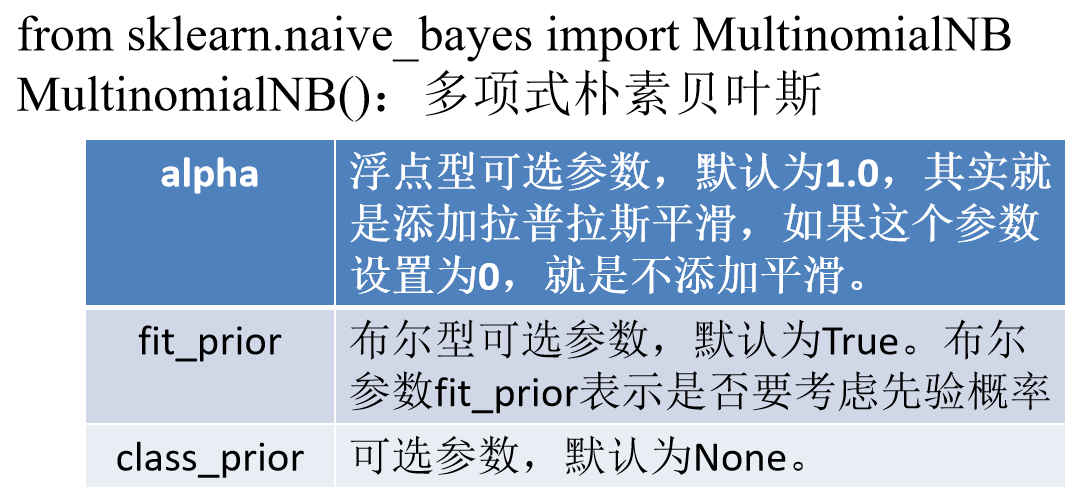

1. 多项式朴素贝叶斯(MultinomialNB):适合离散计数特征

适用场景

特征是离散型计数数据,例如文本分类中的 “单词出现次数”、图像中的 “像素灰度值计数”(如 0-255 的整数)。

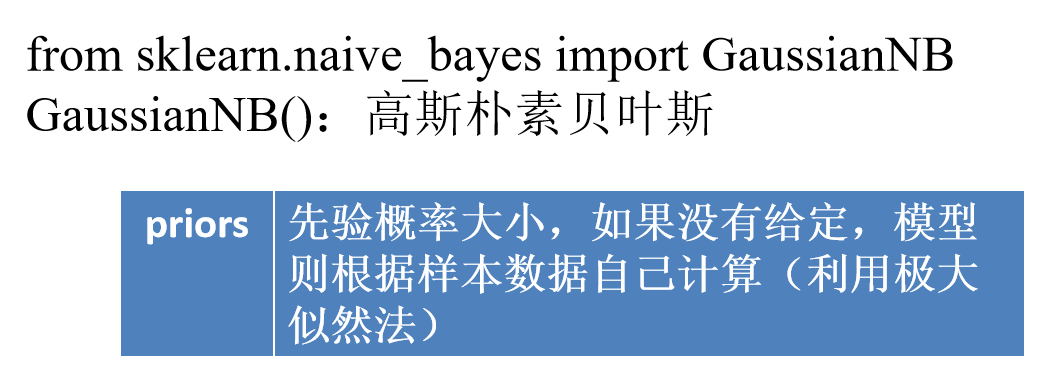

2. 高斯朴素贝叶斯(GaussianNB):适合连续型特征

适用场景

特征是二值数据(仅 0 或 1),例如文本分类中的 “单词是否出现”(1 = 出现,0 = 未出现)、用户行为中的 “是否点击”(1 = 点击,0 = 未点击)。

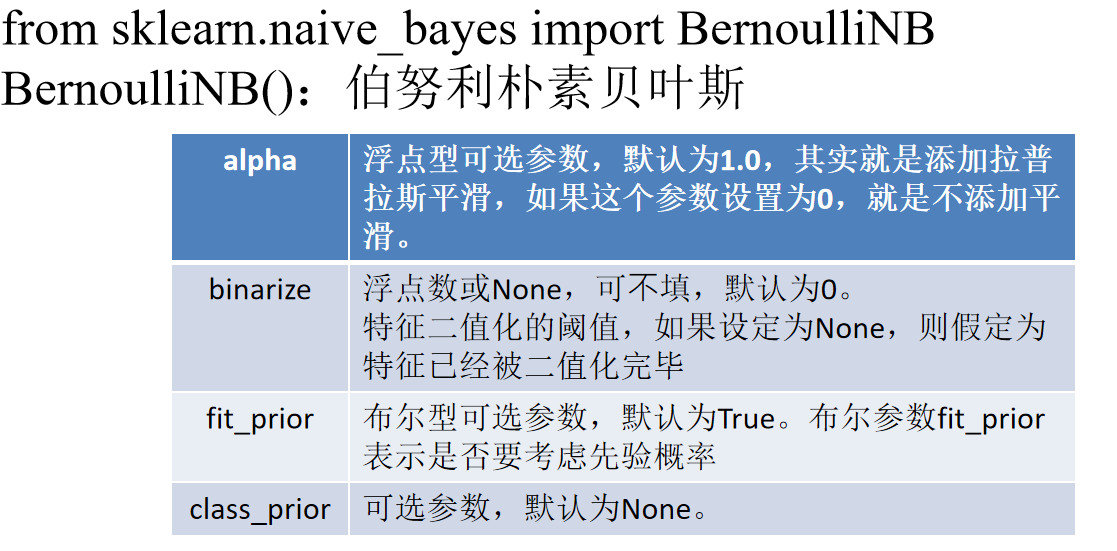

3. 伯努利朴素贝叶斯(BernoulliNB):适合二值特征

适用场景

特征是二值数据(仅 0 或 1),例如文本分类中的 “单词是否出现”(1 = 出现,0 = 未出现)、用户行为中的 “是否点击”(1 = 点击,0 = 未点击)。

四、朴素贝叶斯的优缺点与适用场景

优点

- 速度快:计算量小,无需迭代训练,适合大数据场景;

- 鲁棒性强:对缺失数据不敏感,且对异常值的容忍度较高;

- 可解释性好:能输出类别概率,便于理解预测逻辑;

- 内存占用低:仅需存储特征的概率分布,无需保存训练数据。

缺点

- “朴素假设” 局限:假设特征独立,但现实中很多特征存在关联(如 “下雨” 和 “湿度高”),可能影响准确率;

- 对先验概率敏感:若先验概率设置不合理(如样本不平衡),会导致预测偏差;

- 不适合高维稀疏数据:如文本分类中若词汇表过大,可能导致概率计算不准确。

适用场景

1.文本分类(垃圾邮件识别、情感分析);

2.推荐系统(用户偏好预测);

3.医疗诊断(初步筛查,如疾病风险预测);

4.小样本数据集(数据量少,其他复杂模型易过拟合)。

五、总结

朴素贝叶斯是机器学习中的 “轻量级选手”—— 它原理简单却实用性强,通过 “贝叶斯定理 + 特征独立假设” 实现高效分类。在实际应用中,只需根据特征类型选择对应的变体(多项式 / 高斯 / 伯努利),就能快速解决分类问题。