速通 OpenPI 本地部署(远端推理)简易实现 —— WSL2 + Ubuntu 24.04 环境完整指南

速通 OpenPI 本地部署(远端推理)简易实现 —— WSL2 + Ubuntu 24.04 环境完整指南

摘要:本文将深入解析Physical Intelligence公司最新推出的PI0模型原理,并提供基于WSL2 Ubuntu 24.04的详细部署指南。通过本文,你将了解PI0如何实现从自然语言指令到机器人动作的端到端控制,以及如何在本地环境中部署这一先进模型进行机器人任务仿真。

一、引言:具身智能的新里程碑

在人工智能发展的浪潮中,具身智能(Embodied AI)代表了一个重要方向——让AI真正"存在于"物理世界中,而不仅仅是处理抽象数据。机器人学习作为具身智能的核心,面临着数据稀缺、泛化能力差和鲁棒性不足等挑战。

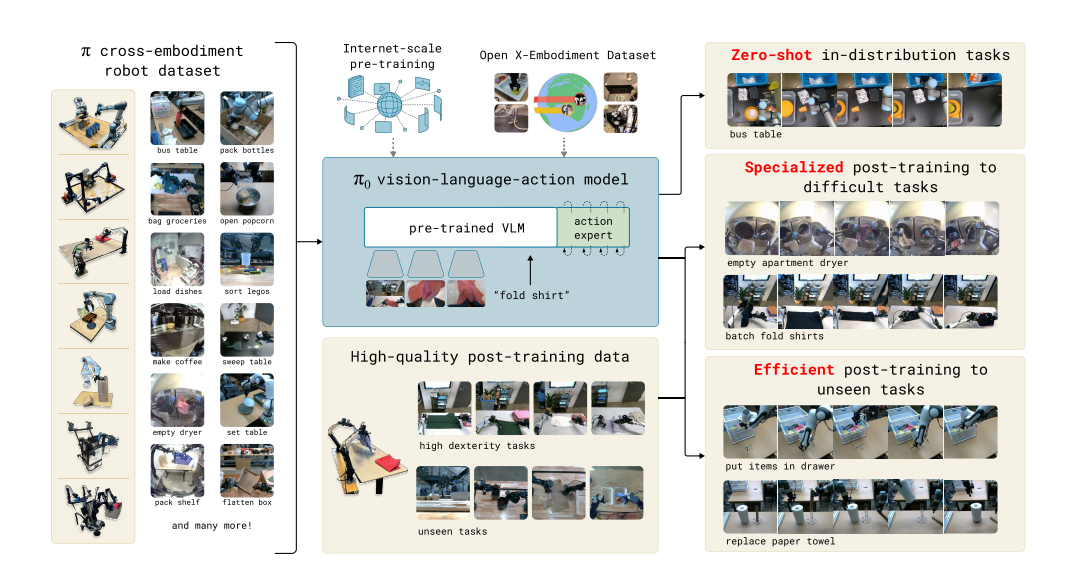

PI0 (π0) 作为Physical Intelligence公司推出的通用机器人策略模型,代表了机器人基础模型(robot foundation models)的最新进展。它能够理解自然语言指令,感知环境状态,并生成精确的机器人动作,实现了从"互联网知识"到"物理操作"的跨越。

本文将首先深入解析PI0的核心原理,然后提供详细的部署指南,帮助你在WSL2 Ubuntu 24.04环境中快速搭建PI0推理服务。

二、PI0模型原理深度解析

什么是PI0?

PI0 (π0) 是一个视觉-语言-动作(Vision-Language-Action, VLA) 流模型,专为通用机器人控制设计。它的核心价值在于:

- 理解自然语言指令:如"grasp the red box"(抓取红色方块)

- 感知环境状态:通过摄像头获取RGB-D图像

- 生成精确动作:输出机器人关节角度或末端执行器轨迹

- 零样本任务适应:无需针对每个新任务重新训练

三、PI0部署实战:WSL2 Ubuntu 24.04环境

现在,让我们进入实战环节,在WSL2 Ubuntu 24.04环境中部署PI0推理服务。

3.1 环境准备

3.1.1 基本要求

- 操作系统:Windows 11 + WSL2 (Ubuntu 24.04)

- Python版本:服务器端3.11,客户端3.10

- 显存要求:≥24GB (建议RTX 4090或A6000)

- GPU驱动:已安装最新NVIDIA驱动

注意:纯Windows环境不支持,必须使用WSL2构建完整Linux开发环境

3.1.2 安装WSL2和Ubuntu 24.04

# 以管理员身份运行PowerShell

wsl --install -d Ubuntu-24.04

随后安装miniconda完成以下命令:

mkdir -p ~/miniconda3

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh -O ~/miniconda3/miniconda.sh

bash ~/miniconda3/miniconda.sh -b -u -p ~/miniconda3

rm ~/miniconda3/miniconda.sh

source ~/miniconda3/bin/activate

conda init --all

3.2 服务器端部署(高性能GPU环境)

3.2.1 创建Conda环境

conda create -n openpi_env python=3.11 -y

conda activate openpi_env

3.2.2 克隆项目代码

git clone https://ghfast.top/https://github.com/Physical-Intelligence/openpi.git

cd openpi

提示:使用ghfast.top镜像加速GitHub下载

3.2.3 配置国内镜像源并安装依赖

# 设置清华镜像源

pip config set global.index-url https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple# 安装现代包管理器uv

pip install uv# 设置uv默认索引源

export UV_DEFAULT_INDEX=https://mirrors.tuna.tsinghua.edu.cn/pypi/web/simple# 克隆项目(跳过LFS文件)

GIT_LFS_SKIP_SMUDGE=1 uv sync

常见问题:如果遇到TUNA镜像的流量限制

我们检测到您所在的子网和/或所使用的客户端存在大量下载某些较大二进制文件的行为...解决方案:

- 更换网络环境(如切换为手机热点)

- 联系support@tuna.tsinghua.edu.cn提交标识符申请解封

- 尝试中科大、阿里云等其他镜像站

3.2.4 下载并解压模型权重

wget https://www.modelscope.cn/models/masheng/pi0-fine-Tuned-Models/resolve/master/pi0_fast_libero.zip

unzip pi0_fast_libero.zip -d $HOME/.cache/openpi/openpi-assets/checkpoints/

重要:确保解压路径正确,否则模型无法加载

3.2.5 启动推理服务

export HF_ENDPOINT=https://hf-mirror.com

uv run scripts/serve_policy.py --env LIBERO

说明:

HF_ENDPOINT指向hf-mirror.com加速Hugging Face资源访问- 服务默认监听

0.0.0.0:8080- 可通过

--host和--port参数自定义

3.3 本地端部署(WSL2 Ubuntu 24.04)

3.3.1 创建本地环境

conda create -n pi0_demo python=3.10 -y

conda activate pi0_demogit clone https://github.com/yueduduo/pi0_fast_deploy.git

cd pi0_fast_deploy

pip install -r requirements.txt

3.3.2 配置服务器地址

编辑demo.py,修改以下参数:

class Args:host = "你的服务器IP地址" # 如192.168.1.100或公网IPport = 8080 # 与服务器端一致video_out_path = "./output/videos"

注意:确保防火墙开放对应端口,且WSL2能被外部访问

3.3.3 运行演示程序

python demo.py

在命令行输入:

grasp the red box

首次运行提示:可能会出现"段错误 (核心已转储)",这是robosuite初始化问题,重启一次即可正常运行

3.3.4 结果查看

成功执行后,视频将保存至:

./output/videos/grasp_the_red_box.mp4

四、常见问题与解决方案

4.1 WSL2图形渲染问题(最常见的问题,请参考我的博客)

WSL2解决MuJoco渲染问题

4.2 HF-Mirror使用说明

HF-Mirror是Hugging Face的国内镜像,使用方式:

export HF_ENDPOINT=https://hf-mirror.com

对于需要登录的受保护模型:

- 先在Hugging Face官网申请权限

- 获取Access Token

- 使用

--token参数下载:

huggingface-cli download --token hf_*** --resume-download model_name

4.3 机器人兼容性限制

当前模型基于Panda机械臂微调,不能直接迁移到其他机器人(如UR5)。若更换机器人,需重新收集数据并微调模型。

五、总结与展望

PI0代表了具身智能领域的重要突破,通过结合预训练VLM和流匹配技术,实现了高质量的机器人控制。它的成功部署为我们提供了:

- 自然语言到机器人动作的端到端控制

- 零样本任务适应能力

- 跨机器人平台的通用性

尽管PI0已经取得了显著进展,但仍存在一些局限:

- 数据构成的优化空间

- 不同任务所需数据量的不确定性

- 跨越更广泛领域的通用性验证

未来,随着更多高质量机器人数据的积累和模型架构的优化,我们有望看到真正通用的机器人基础模型,让机器人像人类一样灵活地适应各种物理环境和任务。

参考资料

- PI0论文

- OpenPI GitHub

- yueduduo/pi0_fast_deploy

- HF-Mirror使用指南

致谢:本文参考了Physical Intelligence公司的PI0论文及相关开源项目,特别感谢yueduduo提供的简化部署方案。如果你觉得本指南有帮助,请给相关项目点个Star支持!