GPT-OSS 与 Ollama 完整安装使用教程

关于UCloud(优刻得)旗下的compshare算力共享平台

UCloud(优刻得)是中国知名的中立云计算服务商,科创板上市,中国云计算第一股。

Compshare GPU算力平台隶属于UCloud,专注于提供高性价4090算力资源,配备独立IP,支持按时、按天、按月灵活计费,支持github、huggingface访问加速。

使用下方链接注册可获得20元算力金,免费体验10小时4090云算力,此外还有3090价格每小时只需要8毛,还有和48G的4090,赠送的算礼金够用一整天。

https://www.compshare.cn/?ytag=GPU_lovelyyoshino_Lcsdn_csdn_display

0. 引言

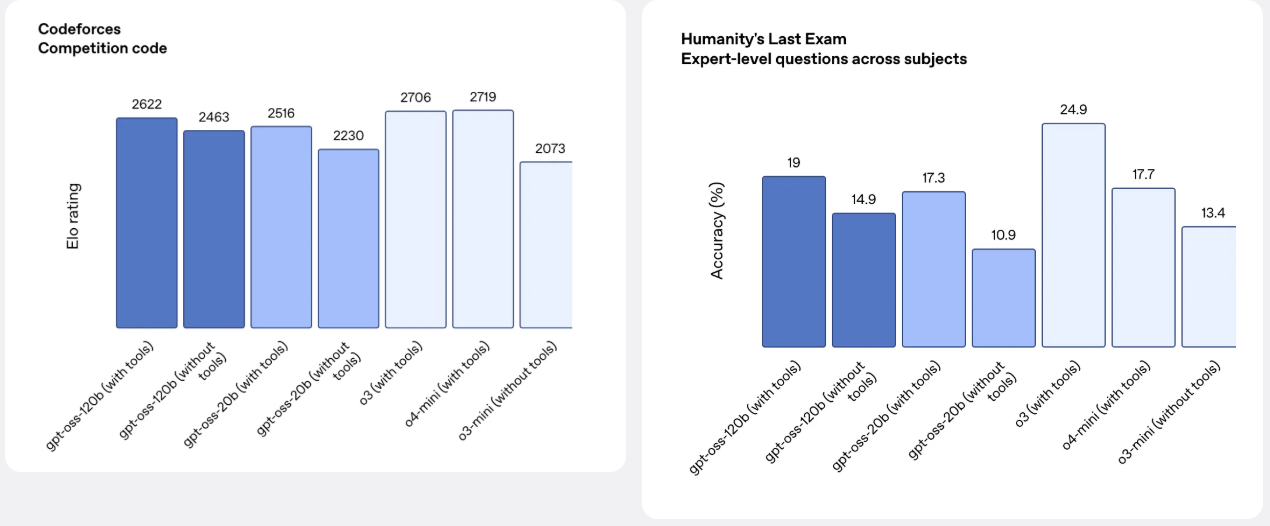

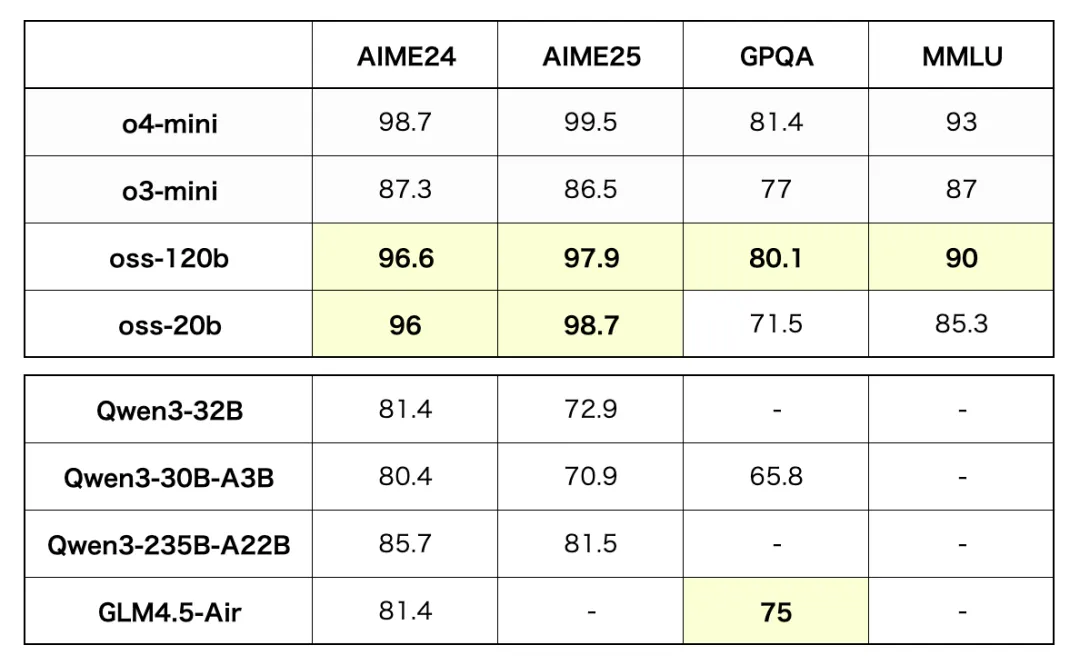

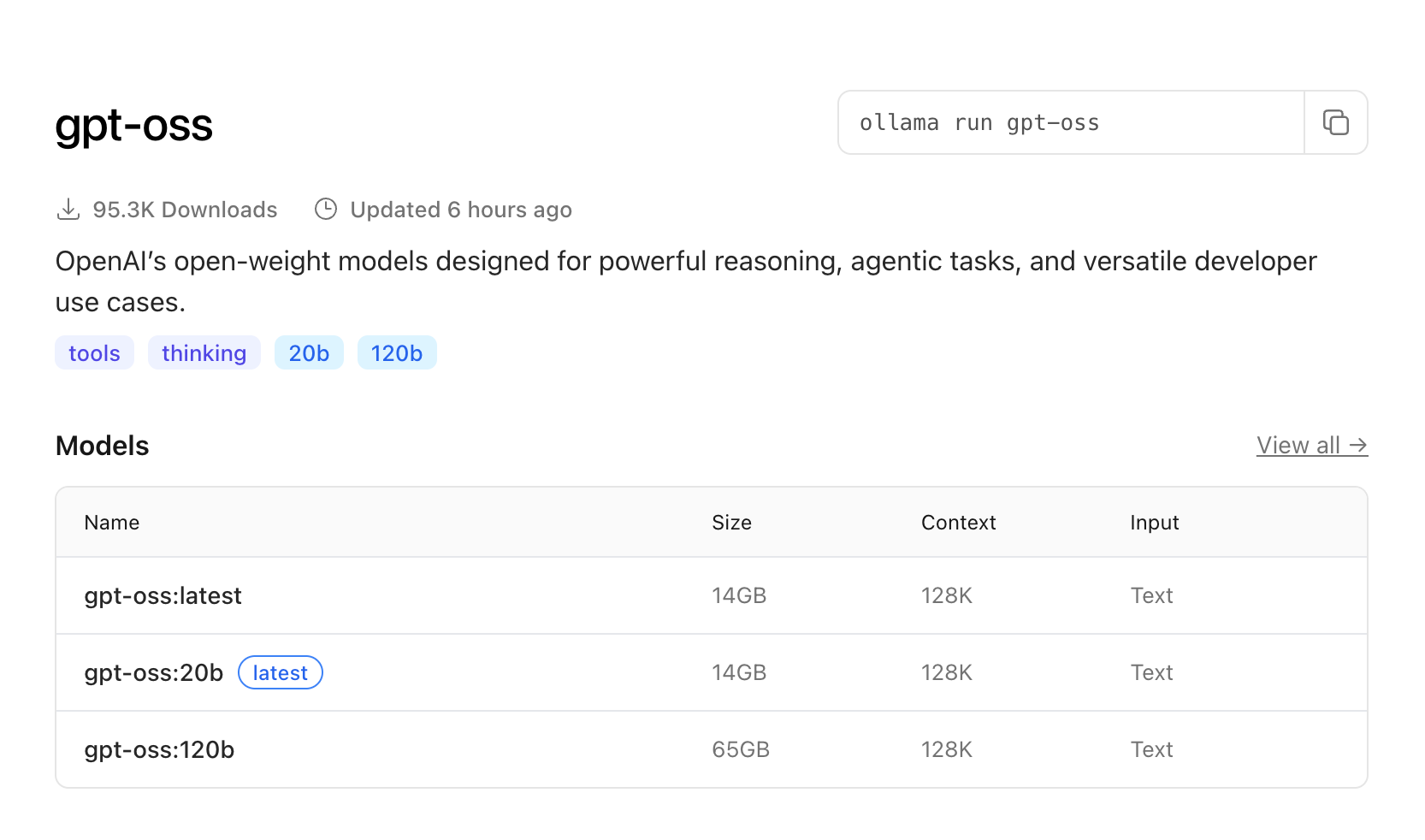

2025年8月,OpenAI正式发布了其首个开源大语言模型系列——gpt-oss,这标志着自GPT-2以来OpenAI首次将其核心模型技术开源。gpt-oss系列包含两个主要版本:gpt-oss-20b和gpt-oss-120b,分别针对不同的应用场景和硬件配置进行了优化。

这一开源举措的意义重大,它不仅为开发者提供了接近商业级性能的开源模型选择,更重要的是推动了整个AI生态系统的民主化进程。gpt-oss模型在推理能力、工具调用、代码生成等多个维度上都展现出了与商业版本相当的性能,为本地部署和定制化应用开辟了新的可能性。

这里最近受到优刻得的使用邀请,正好解决了我在大模型和具身智能行业对GPU的使用需求,现在优刻得正在着力于发展具身服务。作为UCloud云计算旗下的Compshare的GPU算力云平台。他们提供高性价比的24G的4090,按时收费每卡1.88元;此外48G的4090 ,也即将上线5090 GPU,并附带200G的免费磁盘空间。暂时已经满足我的使用需求了,同时支持访问加速,独立IP等功能,能够更快的完成项目搭建。此外对于低性能的还有3080TI使用只需要0.88元,已经吊打市面上主流的云服务器了。这里我们也提供了镜像,作者在compshare平台制作了这个镜像,可以直接一键部署:https://compshare.cn/images/z7kcO88ZQcfQ

1. 模型架构与设计理念

gpt-oss系列采用了专家混合系统(Mixture of Experts, MoE)的Transformer架构,这是一种能够显著提升模型性能同时控制计算成本的技术方案。在MoE架构中,模型包含多个专家网络,每个token只激活部分专家,从而实现了参数规模与计算效率的平衡。

gpt-oss-20b模型总参数量为20B,但每个token实际激活的参数仅为3.6B,这种设计使得模型能够在相对较小的硬件配置上高效运行。gpt-oss-120b模型总参数量达到120B,每个token激活参数为5.1B,为需要更高性能的应用场景提供了选择。

两个模型都支持128K的上下文窗口,这一长度足以处理大多数长文档和复杂对话场景。模型采用了GPT-3同款的注意力模式,结合了密集注意力和局部带状稀疏注意力模式,在保持性能的同时优化了内存使用效率。

2. 系统要求

gpt-oss-20b模型的最低硬件要求相对较低,推荐配置为16GB内存和8GB显存。对于CPU推理,建议使用支持AVX2指令集的现代处理器,如Intel i7/i9系列或AMD Ryzen 7/9系列。对于GPU推理,推荐使用NVIDIA RTX 3080或更高配置的显卡。

gpt-oss-120b模型对硬件要求较高,需要至少80GB显存的GPU。推荐使用NVIDIA A100、H100或RTX 4090等高端显卡。对于CPU推理,建议使用64GB或更多内存的服务器级配置。

存储方面,建议使用SSD硬盘以确保模型加载速度,gpt-oss-20b需要约20GB可用空间,gpt-oss-120b需要约70GB可用空间。

3. Ollama 安装与配置详解

3.1 安装 Ollama

Ollama的安装过程相对简单,支持多种安装方式。对于macOS用户,可以通过官方网站下载安装包,或者使用Homebrew进行安装:

# 使用 Homebrew 安装

brew install ollama# 或者下载官方安装包

curl -fsSL https://ollama.ai/install.sh | sh

对于Linux用户,可以使用官方安装脚本:

curl -fsSL https://ollama.ai/install.sh | sh

安装完成后,启动Ollama服务:

# 启动 Ollama 服务

ollama serve# 在另一个终端中验证安装

ollama list

配置优化

Ollama的配置文件通常位于用户主目录下的.ollama文件夹中。可以通过修改配置文件来优化性能:

# ~/.ollama/config.yaml

models:gpt-oss-20b:parameters:num_ctx: 131072 # 上下文窗口大小num_gpu: 1 # GPU数量num_thread: 8 # CPU线程数temperature: 0.7 # 温度参数top_p: 0.9 # top-p采样参数top_k: 40 # top-k采样参数repeat_penalty: 1.1 # 重复惩罚参数

然后进入ollama.service修改下面三个内容

# vim /etc/systemd/system/ollama.service

[Service]

Environment="OLLAMA_HOST=0.0.0.0"Environment="OLLAMA_MODELS=/workspace/ollama/models/"Environment="CUDA_VISIBLE_DEVICES=0,1"

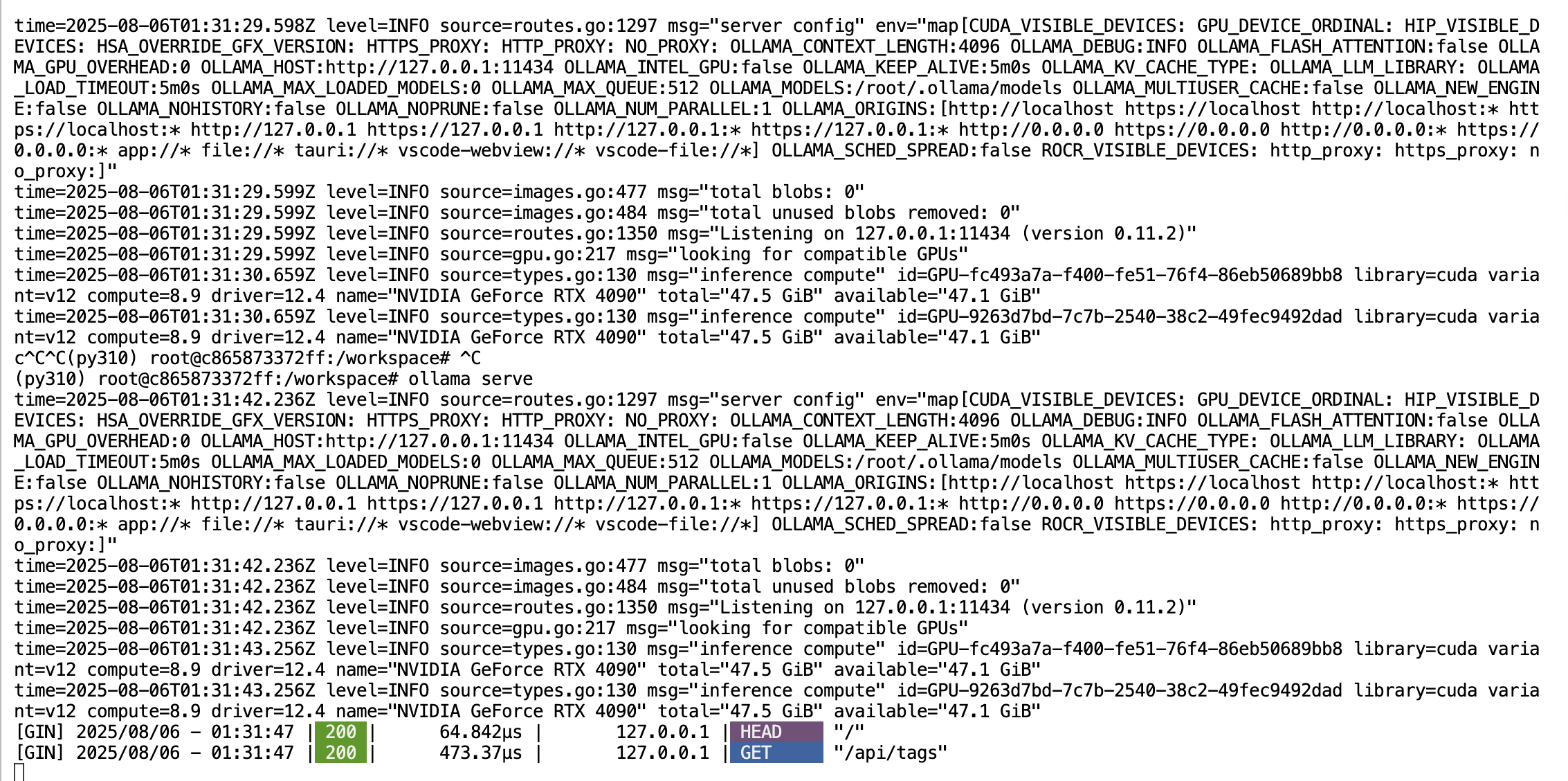

然后重启ollama查看信息,我们就可以查看到我们的端口发生变化了

apt-get install systemctlsystemctl daemon-reload

systemctl restart ollama

4. GPT-OSS 模型部署指南

4.1 模型下载与安装

使用Ollama下载gpt-oss模型非常简单,只需要一条命令:

# 下载 gpt-oss-20b 模型

ollama pull gpt-oss:20b# 下载 gpt-oss-120b 模型

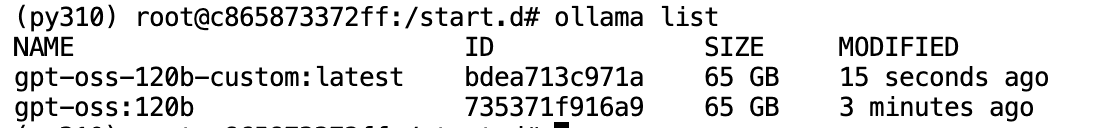

ollama pull gpt-oss:120b# 查看已安装的模型

ollama list

下载过程中,Ollama会自动处理模型文件的下载、验证和安装。下载速度取决于网络环境,建议在网络稳定的环境下进行。

4.2 模型验证与测试

下载完成后,可以通过简单的测试验证模型是否正常工作:

# 测试 gpt-oss-20b

ollama run gpt-oss:20b "Hello, please introduce yourself briefly."# 测试 gpt-oss-120b

ollama run gpt-oss:120b "What are your key capabilities?"

4.3 自定义模型配置

可以通过创建自定义模型文件来调整模型行为:

# 创建自定义配置文件

# ~/.ollama/models/gpt-oss-20b-custom.modelfile

FROM gpt-oss:120b# 设置系统提示词

SYSTEM """

You are a helpful AI assistant with expertise in programming and technical topics.

Always provide clear, accurate, and well-structured responses.

Use markdown formatting for code blocks and technical explanations.

"""# 设置参数

PARAMETER temperature 0.7

PARAMETER top_p 0.9

PARAMETER top_k 40

PARAMETER repeat_penalty 1.1

PARAMETER num_ctx 8192

创建自定义模型:

# 创建自定义模型

ollama create gpt-oss-120b-custom -f ~/.ollama/models/gpt-oss-20b-custom.modelfile# 运行自定义模型

ollama run gpt-oss-120b-custom

5. 使用指南与最佳实践

5.1 基本使用方法

Ollama提供了多种使用方式,包括命令行、API接口和Web界面。

命令行使用:

# 交互式对话

ollama run gpt-oss:20b# 单次查询

ollama run gpt-oss:20b "Explain the concept of machine learning in simple terms."# 流式输出

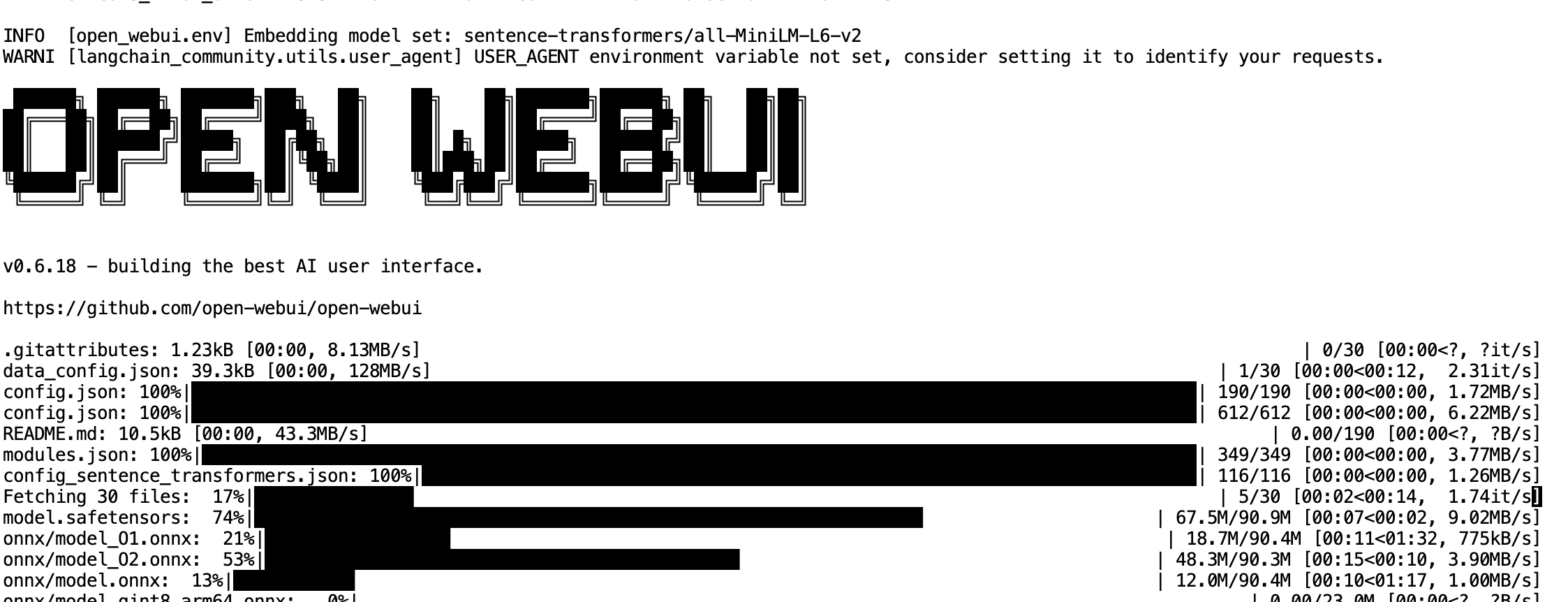

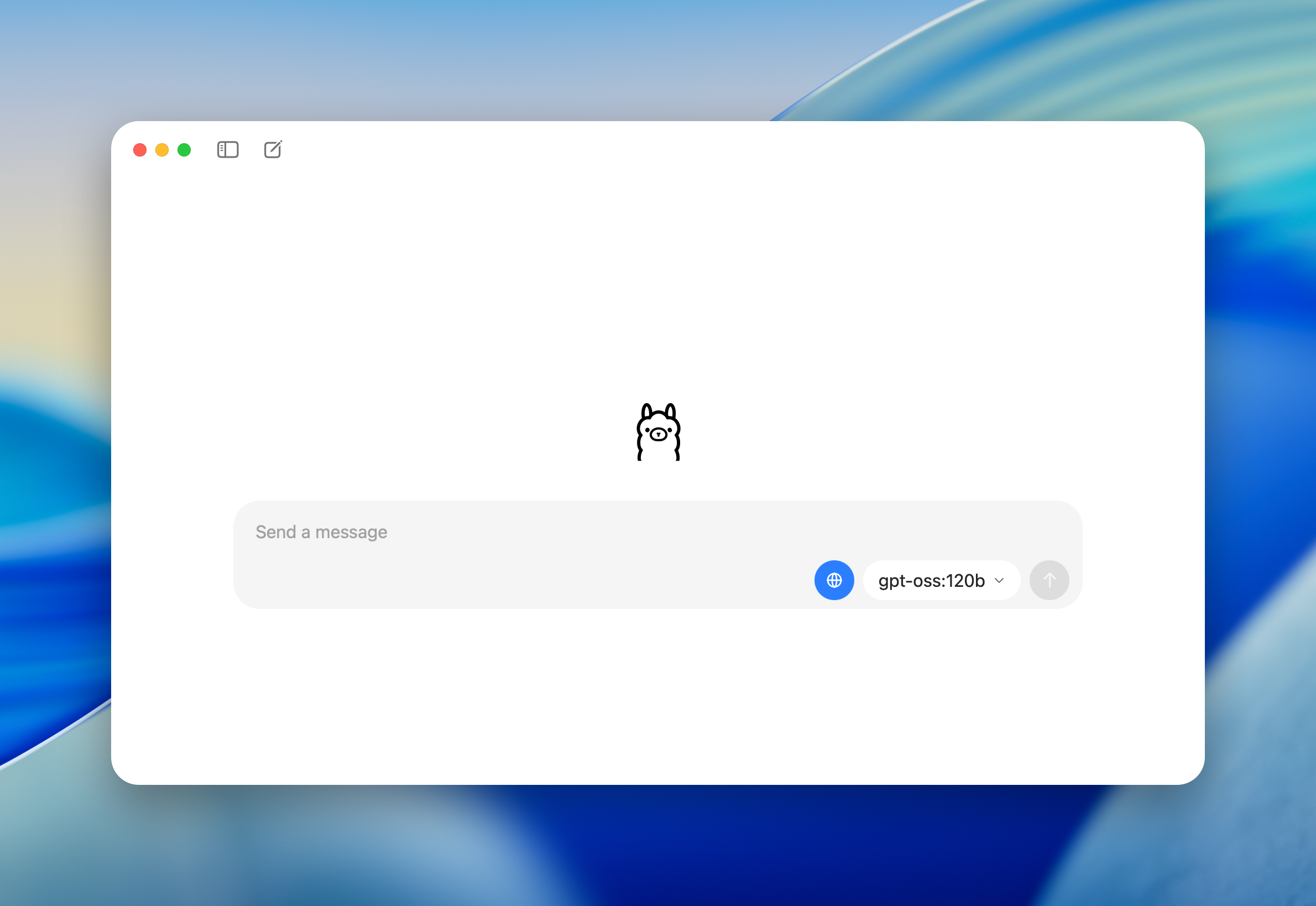

ollama run gpt-oss:20b --stream "Write a Python function to calculate fibonacci numbers."# 可视化使用open-webui

pip install open-webuiopen-webui serve --port 5678 --host 0.0.0.0## 账户ucloud@163.com, 密码为ucloud

API接口使用:

import requests

import json# 发送请求到Ollama API

def query_ollama(prompt, model="gpt-oss:20b"):url = "http://localhost:11434/api/generate"data = {"model": model,"prompt": prompt,"stream": False}response = requests.post(url, json=data)return response.json()["response"]# 使用示例

response = query_ollama("Explain quantum computing")

print(response)

5.2 高级功能使用

gpt-oss支持多种高级功能,包括函数调用、工具使用和结构化输出。

函数调用示例:

import requests

import jsondef call_function_with_ollama():url = "http://localhost:11434/api/generate"# 定义函数functions = [{"name": "get_weather","description": "Get weather information for a location","parameters": {"type": "object","properties": {"location": {"type": "string","description": "City name"},"unit": {"type": "string","enum": ["celsius", "fahrenheit"]}},"required": ["location"]}}]data = {"model": "gpt-oss:20b","prompt": "What's the weather like in Beijing?","functions": functions,"stream": False}response = requests.post(url, json=data)return response.json()# 使用示例

result = call_function_with_ollama()

print(json.dumps(result, indent=2))

6. 总结与未来展望

gpt-oss的发布标志着开源AI模型发展的一个重要里程碑。从技术角度来看,这一模型在多个方面都展现出了与商业版本相当的性能,特别是在推理能力、工具调用和代码生成方面。

未来,我们可以期待看到更多基于gpt-oss的创新应用。随着模型优化技术的不断发展,本地部署的门槛将进一步降低,更多的开发者将能够利用这些强大的AI能力构建自己的应用。

7. 参考链接

https://mp.weixin.qq.com/s/an7gK0BPOcoyQI0lNu79Vg

https://mp.weixin.qq.com/s/yLy6o3aliHE-Jt-_vfzdvg

https://caovan.com/zaiubuntufuwuqibushuopen-webui/.html