coze1-podman容器化部署coze

podman容器化部署coze

- 0.说在前面

- 1.前置环境

-

- 1.1.ollama安装

- 1.2.podman安装

- 3.安装

-

- 3.1.拉取镜像

- 3.2.配置LLM模型服务

- 3.3.配置.env

- 3.4.启动容器

- 3.5.访问

0.说在前面

coze已经开源一段时间了,版本升级的也比较快,记录下使用podman部署coze的过程,这里使用的是coze v0.2.2的版本来安装了,老的版本会和新版本不太一样,肯定是推荐使用新版本来安装。

因为docker不好拉取镜像,使用podman可以顺畅的拉取相关镜像,所以也强烈推荐使用podman。

本文采用本地ollama来部署embedding和LLM模型。

1.前置环境

1.1.ollama安装

如果已经安装好,那么忽略。

安装ollama、拉取LLM和embedding模型,可以参考我的另外一篇文章或者更靠谱的文档来。

# 相应的模型拉取:

ollama pull bge-m3:567m

ollama pull qwen3:8b

1.2.podman安装

如果已经安装好,那么忽略。

podman和podman compose安装参考我的另外一篇podman安装的文章

3.安装

3.1.拉取镜像

git clone https://github.com/coze-dev/coze-studio#拉取后,默认是main分支,就用这个分支。免得后面更新完,忘记切换分支了。

3.2.配置LLM模型服务

cd coze-studio

#复制模型配置模版,这里使用本地部署的ollama服务的相关模型

cp backend/conf/model/template/model_template_ollama.yaml backend/conf/model/ollama.yaml

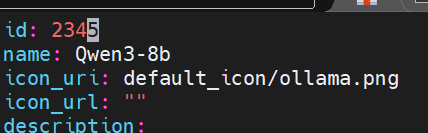

设置 id, meta.conn_config.api_key, 和 meta.conn_config.model ,meta.conn_config.base_url

设置好那么保存,具体的URL和model名称,根据实际情况来修改。