NLP学习路线图(十五):TF-IDF(词频-逆文档频率)

在自然语言处理(NLP)的浩瀚宇宙中,TF-IDF(词频-逆文档频率) 犹如一颗恒星,虽古老却依然璀璨。当ChatGPT、BERT等大模型光芒四射时,TF-IDF作为传统方法的代表,其简洁性、高效性与可解释性仍在诸多场景中焕发着不可替代的生命力。本文将深入解析TF-IDF的原理、实现、应用及其在现代NLP中的独特价值。

一、 权重之殇:为何需要TF-IDF?

1.1 词频(TF)的局限:常见词的“暴政”

设想你搜索“苹果手机评测”。仅依赖词频(TF)的搜索引擎会陷入困境:

-

“手机”、“评测”等常见词充斥各文档,掩盖了真正重要的“苹果”。

-

大量包含“手机评测”却无关苹果的文档被误判为高相关度。

-

核心问题:常见词携带的区分信息量低,却因高频获得不当权重。

1.2 文档频率(DF)的启示:稀有即珍贵

-

若“苹果”在少数文档出现(低DF),其出现往往标志着文档与查询高度相关。

-

若“的”、“是”几乎在所有文档出现(高DF),其存在对区分文档贡献甚微。

-

核心思想:赋予在少数文档中出现(低DF)的词更高权重。

TF-IDF应运而生:将TF的局部重要性与IDF的全局区分力完美融合。

二、 解构TF-IDF:数学之美与工程实践

2.1 核心公式:简洁的力量

TF-IDF(t, d, D) = TF(t, d) * IDF(t, D)

-

t: 目标词项(Term) -

d: 当前文档(Document) -

D: 文档集合(Corpus) -

TF(t, d): 词t在文档d中的词频 -

IDF(t, D): 词t在语料库D中的逆文档频率

2.2 TF (Term Frequency) 变体:平滑的艺术

-

原始计数:

TF_raw(t, d) = count(t in d)

问题:偏向长文档(词出现机会多)。 -

标准化词频(常用):

TF(t, d) = count(t in d) / len(d)

优势:消除文档长度影响。 -

对数缩放:

TF_log(t, d) = log(1 + count(t in d))

优势:抑制高频词的绝对优势,更关注存在性。 -

增强标准化:

TF_aug(t, d) = 0.5 + 0.5 * (count(t in d) / max_count_in_d)

优势:避免完全忽略低频词,平衡权重分布。

2.3 IDF (Inverse Document Frequency) 演进:对抗零值与平滑

-

基础定义:

IDF(t, D) = log(N / (1 + DF(t)))-

N:语料库中文档总数 -

DF(t):包含词t的文档数(Document Frequency)

-

-

+1平滑(拉普拉斯平滑):

防止DF(t) = 0导致除零错误:IDF(t, D) = log(N / (1 + DF(t))) + 1(或等价变形) -

+1在分子?Sklearn 的独特实现:

IDF(t, D) = log((1 + N) / (1 + DF(t))) + 1

目的:确保即使DF(t) = N(词出现在所有文档),IDF 也不为零(>0),避免完全忽略该词。 -

对数底数选择:自然对数(

ln)或log10常见。数值比例关系不变,不影响排序。

2.4 TF-IDF 计算示例

| 文档 (d) | 内容 | 词 (t) | TF (标准化) | DF (t) | N | IDF (log(N/(DF+1))) | TF-IDF |

|---|---|---|---|---|---|---|---|

| d1 | “苹果是一种水果。” | 苹果 | 1/4 = 0.25 | 2 | 4 | log(4/(2+1)) ≈ 0.29 | 0.25 * 0.29 ≈ 0.07 |

| 水果 | 1/4 = 0.25 | 3 | 4 | log(4/(3+1)) = 0 | 0.25 * 0 = 0 | ||

| d2 | “苹果公司发布新手机。” | 苹果 | 1/5 = 0.2 | 2 | 4 | log(4/(2+1)) ≈ 0.29 | 0.2 * 0.29 ≈ 0.06 |

| 手机 | 1/5 = 0.2 | 1 | 4 | log(4/(1+1)) ≈ 0.69 | 0.2 * 0.69 ≈ 0.14 | ||

| d3 | “我喜欢吃水果沙拉。” | 水果 | 1/4 = 0.25 | 3 | 4 | log(4/(3+1)) = 0 | 0.25 * 0 = 0 |

| d4 | “手机市场竞争激烈。” | 手机 | 1/4 = 0.25 | 1 | 4 | log(4/(1+1)) ≈ 0.69 | 0.25 * 0.69 ≈ 0.17 |

结果解读:

-

“水果” (DF=3) 的 IDF=0,权重为0,无法区分文档。

-

“苹果” (DF=2) 在 d1 和 d2 中有显著权重 (0.07, 0.06)。

-

“手机” (DF=1) 在 d2 和 d4 中获得最高权重 (0.14, 0.17),是强区分词。

2.5 向量化与归一化:从词到文档表示

-

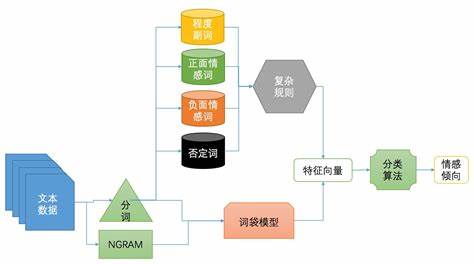

词袋模型(Bag-of-Words, BoW)基础:每个文档表示为一个

|V|维向量(V是词汇表大小),每个维度对应一个词的 TF-IDF 值。 -

稀疏性:向量极度稀疏(大多数词未出现,值为0),高效存储(如 CSR 格式)。

-

归一化(常用 L2):

v_d = [TFIDF(t1,d), ..., TFIDF(tk,d)] / ||v_d||_2

目的:消除不同文档向量长度差异,使相似度计算(如余弦相似度)仅取决于方向而非模长。

三、 实战:TF-IDF的工程实现与应用

3.1 Python (Scikit-learn) 实现示例

from sklearn.feature_extraction.text import TfidfVectorizer# 语料库示例

corpus = ['苹果是一种水果。','苹果公司发布新手机。','我喜欢吃水果沙拉。','手机市场竞争激烈。'

]# 创建 TF-IDF 向量化器 (关键参数解析)

vectorizer = TfidfVectorizer(norm='l2', # 默认 L2 归一化,确保余弦相似度有效use_idf=True, # 启用 IDF 计算 (默认 True)smooth_idf=True, # 应用 IDF 平滑 (默认 True, 即前述 +1 平滑)sublinear_tf=False, # 是否使用 log(1+TF) 替代 TF (默认 False)min_df=1, # 忽略 DF < min_df 的词 (控制特征维度)max_df=1.0, # 忽略 DF > max_df 的词 (e.g., 0.85 忽略出现在 85% 文档以上的词)stop_words=None, # 可指定停用词列表 ('english' 或自定义列表)token_pattern=r'(?u)\b\w\w+\b', # 默认匹配至少2字母的词analyzer='word' # 按词切分 (可改为 'char' 或 'char_wb' 用于n-gram)

)# 拟合语料库并转换文档为 TF-IDF 矩阵

tfidf_matrix = vectorizer.fit_transform(corpus)# 查看词汇表 (特征索引)

print("词汇表 (特征名):", vectorizer.get_feature_names_out())

# 输出: ['一种' '公司' '发布' '喜欢' '市场' '手机' '新手机' '沙拉' '水果' '激烈' '竞争' '苹果' '是一种']# 查看 d2 ('苹果公司发布新手机。') 的 TF-IDF 向量 (稀疏表示)

print("\n文档 d2 的 TF-IDF 向量 (稀疏格式):")

print(tfidf_matrix[1])

# 输出: (0, 11) 0.44 (苹果) | (0, 1) 0.44 (公司) | (0, 2) 0.44 (发布) | (0, 5) 0.32 (手机) | (0, 6) 0.44 (新手机)# 计算文档间余弦相似度矩阵 (基于归一化后的 TF-IDF 向量)

from sklearn.metrics.pairwise import cosine_similarity

cos_sim = cosine_similarity(tfidf_matrix, tfidf_matrix)

print("\n文档间余弦相似度矩阵:")

print(cos_sim)

# 结果: d1 和 d2 因共享 "苹果" 有弱相似 (~0.2),d2 和 d4 因共享 "手机" 有弱相似 (~0.2),d1 和 d3 因共享 "水果" 但 IDF=0 故相似度=0。3.2 关键应用场景

-

信息检索(IR):

-

搜索引擎核心排序因子:查询

q表示为查询词 TF-IDF 向量(常忽略 IDF 或特殊处理),计算q与文档d的余弦相似度作为相关度得分。 -

Lucene/Solr/Elasticsearch 基石:TF-IDF (及 BM25 变种) 是其默认评分算法核心。

-

-

文档分类与聚类:

-

文本分类特征:TF-IDF 向量作为 SVM、朴素贝叶斯、逻辑回归等分类器的输入特征。

-

聚类相似度度量:K-Means、层次聚类等使用余弦相似度(基于 TF-IDF 向量)衡量文档距离。案例:新闻自动归类、用户评论主题划分。

-

-

关键词提取:

-

简单有效的方法:计算文档中各词的 TF-IDF 值,取 Top-N 作为关键词候选。改进:结合词性过滤(名词为主)、位置信息(标题、首段加权)。

-

-

推荐系统:

-

基于内容的推荐:将物品(文章、商品描述)表示为 TF-IDF 向量,为用户画像(历史交互物品向量平均)计算余弦相似度推荐相似物品。

-

-

搜索引擎优化(SEO):

-

内容优化参考:分析目标关键词在竞争页面中的 TF-IDF 分布,指导内容创作中关键词的合理密度与分布。

-

四、 TF-IDF的挑战、局限与改进

4.1 固有局限性

-

语义鸿沟:

-

无法捕捉词义(“苹果”水果 vs 公司)、同义词(“手机” vs “电话”)、多义词。

-

“词袋”假设:完全忽略词序、句法结构和上下文信息。“狗咬人” vs “人咬狗” 向量相同。

-

-

词汇表爆炸与稀疏性:

-

高维稀疏向量对内存和计算有要求(尤其大数据集),虽然稀疏存储可缓解。

-

未登录词(OOV)问题:新词或罕见词在训练词汇表中不存在,直接忽略。

-

-

长文档偏好?:虽然标准化 TF 缓解了绝对长度问题,但长文档有更多机会包含查询词的不同组合,可能获得更高相似度(BM25 针对性改进)。

-

IDF 的全局性假设:IDF 基于整个语料库计算。若语料库主题分布不均或与目标领域不符,IDF 权重可能不最优。

4.2 经典改进方案

-

BM25 (Okapi Best Matching):

-

信息检索的黄金标准:超越 TF-IDF 的事实标准排序函数。

-

核心改进:

-

TF 饱和控制:引入参数

k1,防止单个词频无限增长影响:TF_bm25 = (tf * (k1 + 1)) / (tf + k1) -

文档长度归一化:引入参数

b和平均文档长度avgdl:B = (1 - b) + b * (len(d) / avgdl),惩罚过长文档。 -

IDF 变体:

IDF_bm25 = log((N - DF + 0.5) / (DF + 0.5))

-

-

公式:

Score(q, d) = Σ [IDF_bm25(t) * TF_bm25(t, d) / B](对查询q中每个词t求和)。

-

-

TF-ICF (Inverse Category Frequency):

-

适用于分类场景:用类别频率

CF(t)(包含词t的类别数) 替代文档频率DF(t)计算 IDF。 -

ICF(t) = log(N_categories / CF(t)) -

目的:提升类别区分词的权重,抑制类别通用词。

-

-

n-gram 特征:

-

将连续的词序列(如 bigram “新手机”, trigram “发布新手机”)也作为词项。

-

优势:部分捕捉词序和短语信息(如区分“新手机”和“手机新”)。

-

代价:特征维度急剧膨胀,需更强特征选择。

-

-

特征选择与降维:

-

DF 阈值 (

min_df,max_df):过滤极罕见或极常见词。 -

卡方检验 (Chi-square):选择与类别最相关的词。

-

主成分分析 (PCA) / 潜在语义分析 (LSA):在 TF-IDF 矩阵上降维,捕捉潜在主题,缓解稀疏性和噪声。

-

五、 现代NLP中的TF-IDF:老兵不死,只是逐渐演变

在 Transformer 和预训练语言模型主导的今天,TF-IDF 并未消亡,而是找到了新的定位:

-

轻量级任务的王者:

-

资源受限环境:移动端、嵌入式设备、实时性要求极高的系统(如高频搜索),TF-IDF 的计算效率和低内存占用是巨大优势。

-

小样本/冷启动:当标注数据极少时,TF-IDF 作为强基线或特征工程的一部分,往往比复杂模型更稳定可靠。案例:初创公司快速构建最小可行产品(MVP)的搜索或分类功能。

-

-

深度学习模型的助推器:

-

特征融合:TF-IDF 向量可与词嵌入(Word2Vec, GloVe)、甚至 BERT 的句向量拼接或加权融合,提供互补的统计信息。研究表明,这种融合有时能提升下游任务性能。

-

注意力机制的初始化或补充:TF-IDF 权重可视为一种“硬”注意力,为神经网络提供先验知识。研究:将 TF-IDF 融入图神经网络(GNN)进行文本分类。

-

-

可解释性的灯塔:

-

模型调试与理解:当深度模型做出错误预测时,检查 TF-IDF 高的词是理解输入重要特征的快捷方式。

-

业务沟通的桥梁:向非技术人员解释“为什么这篇文档被分类为科技类?因为‘算法’、‘人工智能’、‘大数据’这些词的 TF-IDF 很高”比解释神经网络注意力权重直观得多。

-

-

特定任务中的持续有效性:

-

短文本匹配/去重:计算微博、商品标题等短文本的 TF-IDF 余弦相似度,仍是快速去重或找相似的有效方法。

-

法律/专利检索:这些领域术语精准、词义相对固定,TF-IDF(或 BM25)结合严格的查询语法,效果依然出色。

-

TF-IDF vs. 词嵌入 vs. 上下文嵌入:

| 特性 | TF-IDF | Word2Vec/GloVe | BERT/Transformer | ||

|---|---|---|---|---|---|

| 语义表示 | 统计权重 (无语义) | 静态词义 (一词一义) | 动态上下文 (一词多义) | ||

| 词序/结构 | 完全忽略 (BoW) | 部分忽略 (CBOW/Skip) | 完全建模 (Self-Att) | ||

| 特征维度 | 高维稀疏 ( | V | ) | 低维稠密 (e.g., 300d) | 高维稠密 (e.g., 768d) |

| 训练需求 | 无监督 (语料统计) | 无监督 (大规模语料) | 大规模有监督预训练 | ||

| 计算开销 | 极低 | 低 (推理) / 中 (训练) | 极高 (训练/推理) | ||

| 可解释性 | 高 (权重直接对应词) | 中 (词相似度) | 低 (黑盒) | ||

| OOV 处理 | 差 (完全忽略) | 差 (固定词表) | 较好 (Subword Token) | ||

| 典型优势场景 | 检索/分类 (轻量/可解释) | 词相似/类比任务 | 复杂理解/生成任务 |

六、 结语:传统智慧与现代创新的交响

TF-IDF 作为 NLP 发展史上的里程碑,其核心思想——通过统计手段量化词在文档中的局部重要性和在整个语料库中的全局区分能力——至今仍闪耀着智慧的光芒。尽管它无法理解语言的深层语义和复杂结构,但在效率、可解释性、作为强基线以及与现代模型协同等方面,展现出持久的价值。