Llamaindex Rag 报错

1:llamaindex 做rag 是加载模型使用openai_like 格式是找不到模型

加载模型代码如下图所示

llm = OpenAILike(model=r"/root/superti-tmp/models/Qwen-7B-Chat01",api_base=r"http://0.0.0.0:23333/v1",api_key="fake",context_window=4096,is_chat_model=True,is_function_calling_model=False,)

Settings.llm = llm

错误原因是找不到模型,此处的model 参数的值要和部署模型时的模型名称保持一致

lmdeploy serve api_server /root/xxx/ --tp=2 --model-nmae=qwen_chat

******此处需要注意的是lmdeploy 不是模型的模型名称并不是模型路径,openai_like 中 model 参数必须和部署模型名称保持一致即 --model-name 的值,因此需要修改成

llm = OpenAILike(model="qwen_chat",api_base=r"http://0.0.0.0:23333/v1",api_key="fake",context_window=4096,is_chat_model=True,is_function_calling_model=False,)

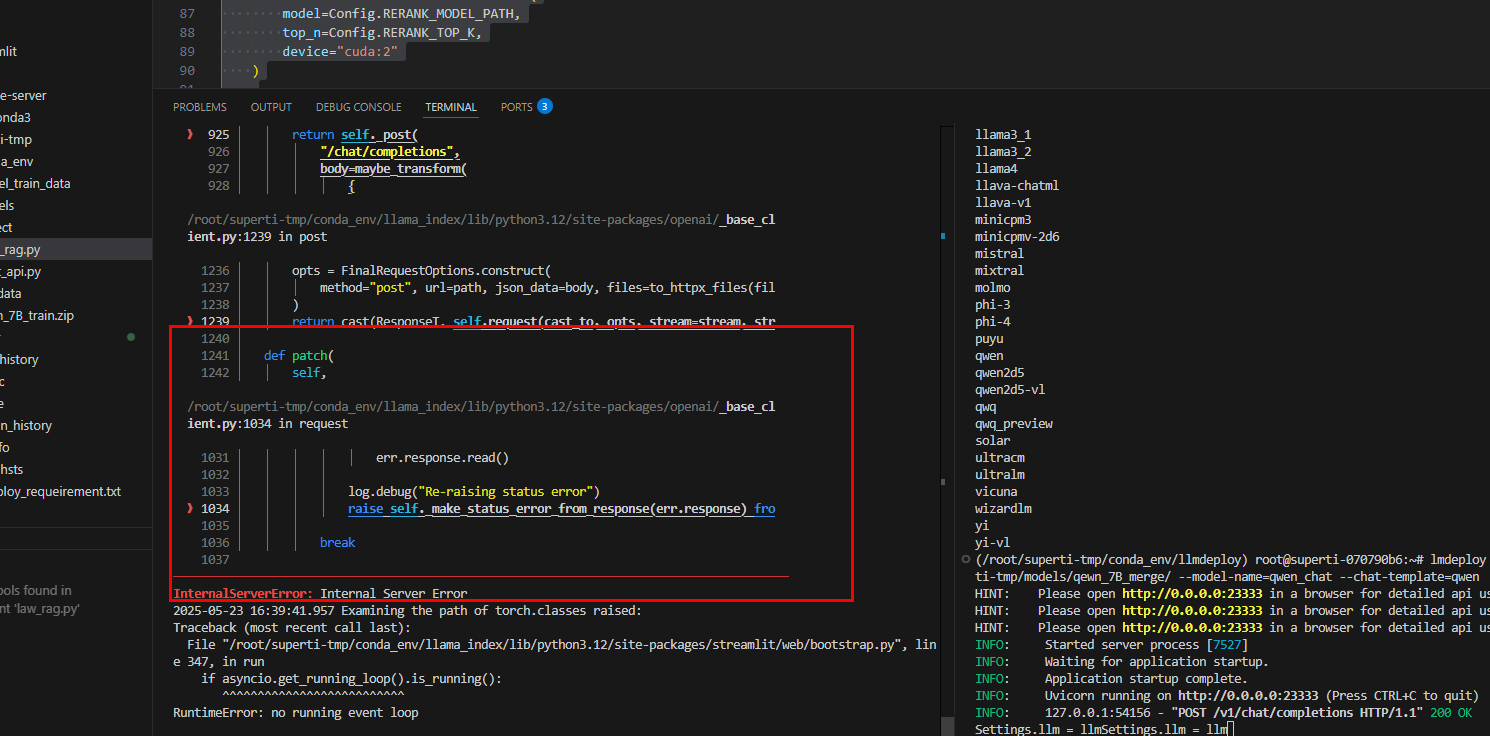

2:RAG 请求大模型时报错

查看是框架报错是因为部署模型时没有指定对话模版,重新部署命令如下

lmdeploy serve api_server --tp=2 /root/superti-tmp/models/qewn_7B_merge/ --model-name=qwen_chat --chat-template=qwen

具体的对话模版根据部署的模型选择。