计算机视觉——图像数据增强从原理到落地的全解析

在计算机视觉(CV)领域,模型的性能高度依赖数据的“质量”与“数量”。但现实中,我们常面临标注成本高、样本分布不均、场景覆盖不足等问题——训练集里全是晴天的猫,遇到雨天的猫就“认不出”;医疗影像中肿瘤样本稀少,模型难以学到有效特征。这时候,图像数据增强就成了低成本解决数据困境的“利器”。

本文将从核心原理出发,系统梳理图像数据增强的方法体系,结合分类、检测、分割等实际任务给出落地指南,再补充工具选型与避坑技巧,帮你真正把这项技术用起来。

一、数据增强为什么能提升模型性能?

很多初学者会疑惑:“对图像做旋转、裁剪这些操作,又没增加真实数据,为什么能帮模型提升泛化能力?”这就要从CNN的训练本质和数据增强的核心逻辑说起。

1. 核心原理

CNN模型的训练过程,本质是学习“数据特征”与“标签”的映射关系。如果训练集样本单一(比如所有汽车图片都从正面拍摄),模型就会“死记硬背”这些无关细节(如固定角度的车头轮廓),而非真正的核心特征(如车轮、车身结构),这就是“过拟合”。

数据增强的核心逻辑是:通过模拟现实世界中图像的自然变异,生成大量“新样本”。这些样本保留了原始图像的核心语义(猫还是猫,肿瘤还是肿瘤),但在细节上存在差异(角度、光照、背景不同)。这种差异迫使模型关注真正具有区分性的特征,从而减少对训练集噪声的依赖,提升在陌生数据上的表现。

2. 关键分类:在线增强 vs 离线增强

根据增强操作的执行时机,数据增强可分为两类,二者各有适用场景,实际开发中需灵活选择。

| 对比维度 | 离线增强(Offline Augmentation) | 在线增强(Online Augmentation) |

|---|---|---|

| 执行时机 | 训练前一次性对原始数据增强,生成新数据集 | 训练中读取批次(Batch)数据时,动态随机增强 |

| 数据存储 | 需额外存储增强样本,占用大量磁盘空间 | 不存储增强样本,实时生成,节省空间 |

| 样本多样性 | 增强样本固定,模型可能“记住”,多样性有限 | 每次批次增强方式随机,多样性更高 |

| 训练效率 | 无需实时计算,训练速度快 | 实时计算增加开销,训练速度略有下降 |

| 适用场景 | 小规模数据集(几百~几千张),需快速扩充样本 | 中大规模数据集(几万~几十万张),追求高泛化 |

目前主流选择是在线增强,比如PyTorch的torchvision.transforms、TensorFlow的ImageDataGenerator,其随机性带来的多样性优势更符合CNN的训练需求。

二、核心方法

数据增强的方法繁多,但核心原则始终是“不改变图像语义”。比如不能将手写数字“6”垂直翻转成“9”,也不能将医疗影像中的病灶“翻转”消失。下面按“基础→进阶→任务特定”的顺序,梳理实战中最常用的增强技巧。

1. 基础操作:几何与像素级变换

这类方法是所有CV任务的“基石”,操作简单但效果显著,主要分为几何变换(改变空间形态)和像素变换(改变颜色分布)两类。

(1)几何变换:提升空间不变性

核心作用是让模型适应物体在不同空间位置、角度、尺度下的形态,比如识别“正面猫”和“侧面猫”是同一种动物。

翻转(Flip):最常用的增强手段,分为水平翻转和垂直翻转。水平翻转(如将人脸左右翻转)几乎适用于所有任务,但垂直翻转需谨慎——比如文本识别中,垂直翻转会导致语义完全改变。实践中通常设置50%的概率执行水平翻转,避免增强方式固定。

随机裁剪与缩放(RandomResizedCrop):先随机裁剪图像的任意区域,再缩放至固定尺寸。这种操作能模拟“物体在图像中不同位置和尺度”的场景,增强模型的尺度不变性。在目标检测中需特别注意:裁剪后需判断目标是否存在,避免只保留背景的无效样本。

旋转与仿射变换(Rotation & Affine):旋转是绕图像中心旋转一定角度(通常±30°,避免过度旋转导致语义失真);仿射变换则包含平移、剪切、透视等复杂变换,能更全面地模拟拍摄角度的变化。这类操作在目标检测、分割任务中需同步变换标签——比如图像旋转10°,bounding box坐标或分割掩码也必须旋转10°。

(2)像素级变换:模拟环境差异

核心作用是让模型适应不同光照、拍摄设备下的图像特征,比如在强光和弱光下都能识别出汽车。

颜色抖动(Color Jitter):随机调整图像的亮度、对比度、饱和度、色相,模拟不同光照条件。参数需控制在合理范围(如亮度±50%),否则会导致颜色失真——比如将“红色消防车”变成“蓝色”,就违背了语义不变原则。

随机灰度化(RandomGrayscale):以一定概率(如20%)将彩色图像转为灰度图。这种操作能迫使模型关注物体的形状、轮廓等结构特征,而非依赖颜色信息,在分类任务中效果显著。

噪声与模糊(Noise & Blur):随机添加高斯噪声、泊松噪声(模拟传感器噪声),或进行高斯模糊、运动模糊(模拟拍摄抖动)。这类操作能提升模型的抗干扰能力,在自动驾驶、监控等实际场景中尤为重要。

2. 进阶操作:局部与语义级增强(提升鲁棒性)

基础操作主要改变整体特征,进阶操作则通过破坏或融合局部特征,让模型学习更鲁棒的表征,适用于分类、检测等中高难度任务。

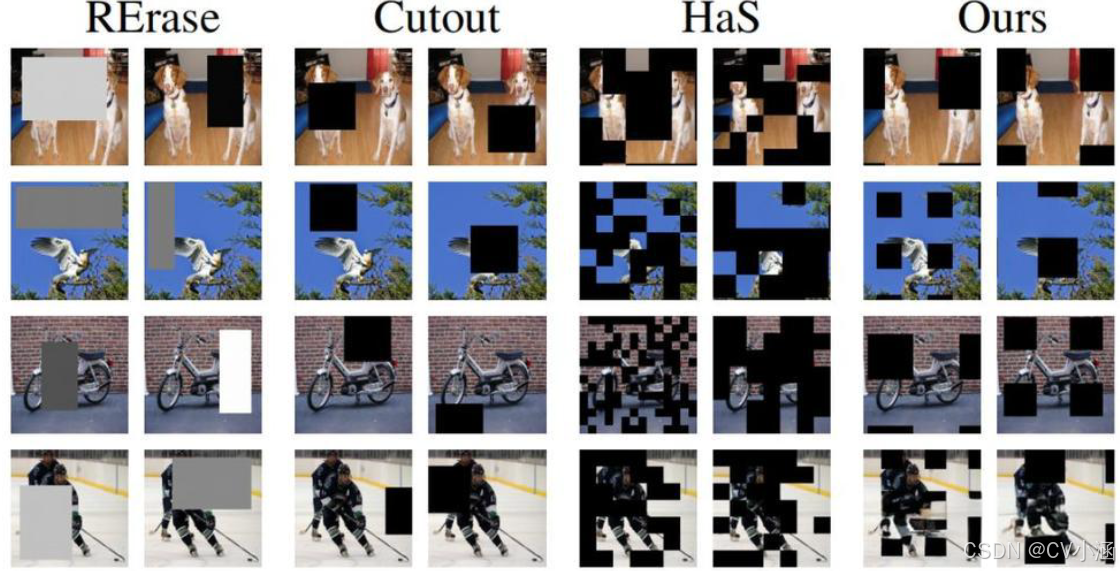

Cutout / Random Erasing:随机遮挡图像中的一个或多个矩形区域(Cutout是固定尺寸,Random Erasing是随机尺寸)。这种操作能模拟“物体部分被遮挡”的场景,比如行人被广告牌遮挡,迫使模型通过局部特征推断整体,提升抗遮挡能力。

MixUp / CutMix:两者都是通过融合两张图像生成新样本,核心创新是“标签融合”。MixUp是将两张图像按比例线性叠加(如0.7的图像A + 0.3的图像B),标签也按相同比例融合;CutMix则是将图像B的局部区域裁剪后粘贴到图像A上,标签按粘贴区域的面积比例融合。这类方法能让模型学习到样本间的关联特征,大幅提升泛化能力,在ImageNet竞赛中被广泛使用。

Mosaic(YOLO风格):将4张不同的图像拼接成一张新图像,每张图像都保留完整的目标。这种操作能同时扩充背景多样性和目标尺度范围,是YOLO系列模型训练中的核心增强手段,特别适合目标检测任务。

Copy-Paste(实例复制粘贴):针对语义分割、目标检测任务,将一张图像中的目标实例(带分割掩码)复制粘贴到另一张图像中。这种方法能有效解决“小类样本稀缺”问题——比如在交通场景数据中,“行人”样本多而“自行车”样本少,就可以通过Copy-Paste扩充“自行车”样本。

3. 任务特定增强:按需定制是关键

数据增强没有“万能公式”,需结合具体任务的特点定制策略。以下是几类典型任务的增强原则:

分类任务:自由度最高,可组合使用基础变换 + MixUp/CutMix + 噪声增强,重点提升样本多样性。

目标检测/语义分割:核心是“标签同步”——所有图像变换必须同步应用于bounding box、分割掩码或关键点。避免使用可能破坏目标完整性的操作(如过度裁剪)。

医疗影像:慎用颜色变换(如调整色相,可能改变病灶特征),优先使用仿射变换、弹性形变、噪声模拟(如CT图像的伪影)。对于3D医疗数据(如MRI序列),需进行体积级增强,保持切片间的空间一致性。

OCR/文档识别:重点模拟文档拍摄的真实场景,如透视变换(模拟倾斜拍摄)、文字模糊、背景纹理添加(模拟纸张褶皱),但需避免文字变形导致语义改变。

视频CV任务:需保持时间一致性——同一视频序列的增强方式应连贯,避免帧间突变。可使用时间抖动、光流感知增强,仅对帧间变化区域进行调整。

4. 前沿方向:生成式与自动化增强

随着深度学习的发展,数据增强已从“手工设计”走向“智能生成”,以下两类方法代表了当前的前沿趋势:

生成式增强:利用GAN(生成对抗网络)、扩散模型等生成全新的真实样本。比如用StyleGAN生成不同姿态、表情的人脸样本,用CycleGAN实现跨域增强(如将素描图转为照片)。这种方法能快速扩充稀有样本,尤其适合标注成本极高的任务(如医疗影像、工业缺陷检测)。

自动化增强:通过算法自动搜索最优增强策略,减少人工调参成本。典型代表有AutoAugment(基于强化学习搜索增强序列)、RandAugment(简化搜索过程,提升效率)、TrivialAugment(完全随机选择增强方式,实用性更强)。这类方法在ImageNet等大型数据集上已证明效果优于手工设计的增强策略。

三、实战代码示例与工具选型

理论讲得再多,不如一行代码来得实在。以下结合PyTorch和TensorFlow两大框架,给出实战中的增强流水线实现,并推荐常用工具库。

1. PyTorch实现:在线增强流水线

PyTorch的torchvision.transforms是实现在线增强的主流工具,通过Compose组合多个变换,在DataLoader中动态应用。

import torch

from torchvision import transforms

from torch.utils.data import DataLoader, Dataset

# 1. 定义增强流水线(分类任务示例)

train_transform = transforms.Compose([transforms.RandomResizedCrop(size=224, scale=(0.8, 1.0)), # 随机裁剪+缩放transforms.RandomHorizontalFlip(p=0.5), # 50%概率水平翻转transforms.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2), # 颜色抖动transforms.RandomGrayscale(p=0.1), # 10%概率灰度化transforms.RandomApply([transforms.GaussianBlur(kernel_size=3)], p=0.3), # 30%概率高斯模糊transforms.ToTensor(), # 转为Tensortransforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) # 归一化

])

# 2. 定义数据集(自定义Dataset示例)

class CustomDataset(Dataset):def __init__(self, img_paths, labels, transform=None):self.img_paths = img_pathsself.labels = labelsself.transform = transform

def __getitem__(self, idx):img = Image.open(self.img_paths[idx]).convert('RGB')label = self.labels[idx]if self.transform:img = self.transform(img) # 应用增强return img, label

def __len__(self):return len(self.img_paths)

# 3. 构建DataLoader(动态应用增强)

train_dataset = CustomDataset(train_img_paths, train_labels, transform=train_transform)

train_loader = DataLoader(train_dataset, batch_size=32, shuffle=True, num_workers=4)

# 注意:验证集仅做归一化和尺寸调整,不做增强

val_transform = transforms.Compose([transforms.Resize((224, 224)),transforms.ToTensor(),transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])2. TensorFlow实现:ImageDataGenerator

TensorFlow的ImageDataGenerator支持在线增强,可直接读取文件夹中的图像并实时生成增强样本。

import tensorflow as tf

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 1. 定义增强参数(分类任务示例)

train_datagen = ImageDataGenerator(rescale=1./255, # 归一化rotation_range=30, # 随机旋转±30°width_shift_range=0.2, # 水平平移±20%height_shift_range=0.2, # 垂直平移±20%shear_range=0.2, # 剪切强度±20%zoom_range=0.2, # 随机缩放±20%horizontal_flip=True, # 水平翻转brightness_range=[0.5, 1.5], # 亮度调整范围fill_mode='nearest' # 填充方式

)

# 2. 读取图像并应用增强(从文件夹读取,标签自动生成)

train_generator = train_datagen.flow_from_directory('train_data/',target_size=(224, 224),batch_size=32,class_mode='categorical' # 多分类任务

)

# 3. 验证集不增强,仅归一化

val_datagen = ImageDataGenerator(rescale=1./255)

val_generator = val_datagen.flow_from_directory('val_data/',target_size=(224, 224),batch_size=32,class_mode='categorical'

)3. 主流工具库推荐

除了框架内置工具,以下第三方库在实战中更常用,支持更多增强方式且速度更快:

Albumentations:检测/分割任务的首选,支持所有基础和进阶增强,能自动同步处理bounding box、掩码和关键点,速度比torchvision快30%以上。

Kornia:基于PyTorch的GPU加速图像库,所有增强操作都可在GPU上执行,避免数据在CPU和GPU间频繁传输,大幅提升训练效率。

NVIDIA DALI:适用于超大规模数据集,支持CPU/GPU加速的数据加载和增强,能解决大型模型训练中的数据瓶颈问题。

AutoAugment实现库:如

tensorflow_models中的AutoAugment模块,可直接调用预定义的增强策略,无需手动实现。

四、注意不要过分增强

数据增强看似简单,但实践中很容易因细节失误导致模型性能下降。以下是高频坑点及解决方法:

1. 增强过度导致语义失真

「坑点」:旋转角度过大(如将猫旋转90°导致无法识别)、颜色抖动参数过强(将绿色树叶变成紫色)。

「解决」:① 控制参数范围,如旋转角度不超过±30°,亮度调整不超过±50%;② 对每个增强操作设置概率(如p=0.5),避免所有样本都被过度增强;③ 可视化增强后的样本,人工检查语义是否保持。

2. 验证集/测试集也做增强

「坑点」:为了“公平”,给验证集也应用和训练集一样的增强,导致评估结果失真。

「解决」:数据增强的唯一目的是辅助训练,验证集/测试集必须保持原始数据分布,仅做归一化、尺寸调整等必要预处理,才能真实评估模型的泛化能力。

3. 标签与图像不同步

「坑点」:目标检测中,图像旋转后bounding box坐标未更新;分割任务中,图像裁剪后掩码未同步裁剪。

「解决」:① 使用Albumentations等支持标签同步的工具,避免手动计算坐标;② 增强后对标签进行校验,如bounding box是否超出图像范围,掩码是否完整。

4. 忽略任务特性盲目套用增强策略

「坑点」:将分类任务的增强策略直接套用到医疗影像上,如调整CT图像的色相导致病灶特征丢失。

「解决」:根据任务特性定制策略——医疗影像优先几何变换,OCR优先透视变换,避免使用与任务冲突的增强方式。

5. 未验证增强的有效性

「坑点」:盲目添加多种增强操作,认为“增强越多越好”,但未对比无增强的基线模型效果。

「解决」:做A/B测试,分别训练“无增强”和“有增强”的模型,对比测试集准确率、鲁棒性等指标。若增强后性能下降,及时调整策略。

图像数据增强是计算机视觉中“低成本、高收益”的核心技术,其本质是通过模拟自然变异扩充样本多样性,让模型学习更鲁棒的特征。从基础的几何变换到前沿的生成式增强,技术一直在演进。