Apriel-1.5-15b-Thinker 中间训练新突破

传送锚点

- 性能卓越表现

- 研发理念与技术细节

- 快速体验方式

Apriel-1.5-15b-Thinker 多模态推理模型由 ServiceNow-AI 团队发布 带来了 AI 训练领域的新鲜视角。这款模型的核心理念是“中间训练即所需” Mid training is all you need. 团队通过深度且广泛的持续预训练 Continual Pre-training CPT 在文本与图像领域打下了坚实基础。

令人瞩目的是 即使没有进行图像特定的指令微调 SFT 也没有使用强化学习 RL 它依然在多模态推理任务上取得了领先性能 这颠覆了传统认知。它表明 智能的中间训练策略可能比后期复杂的专门优化更为关键。

性能卓越表现

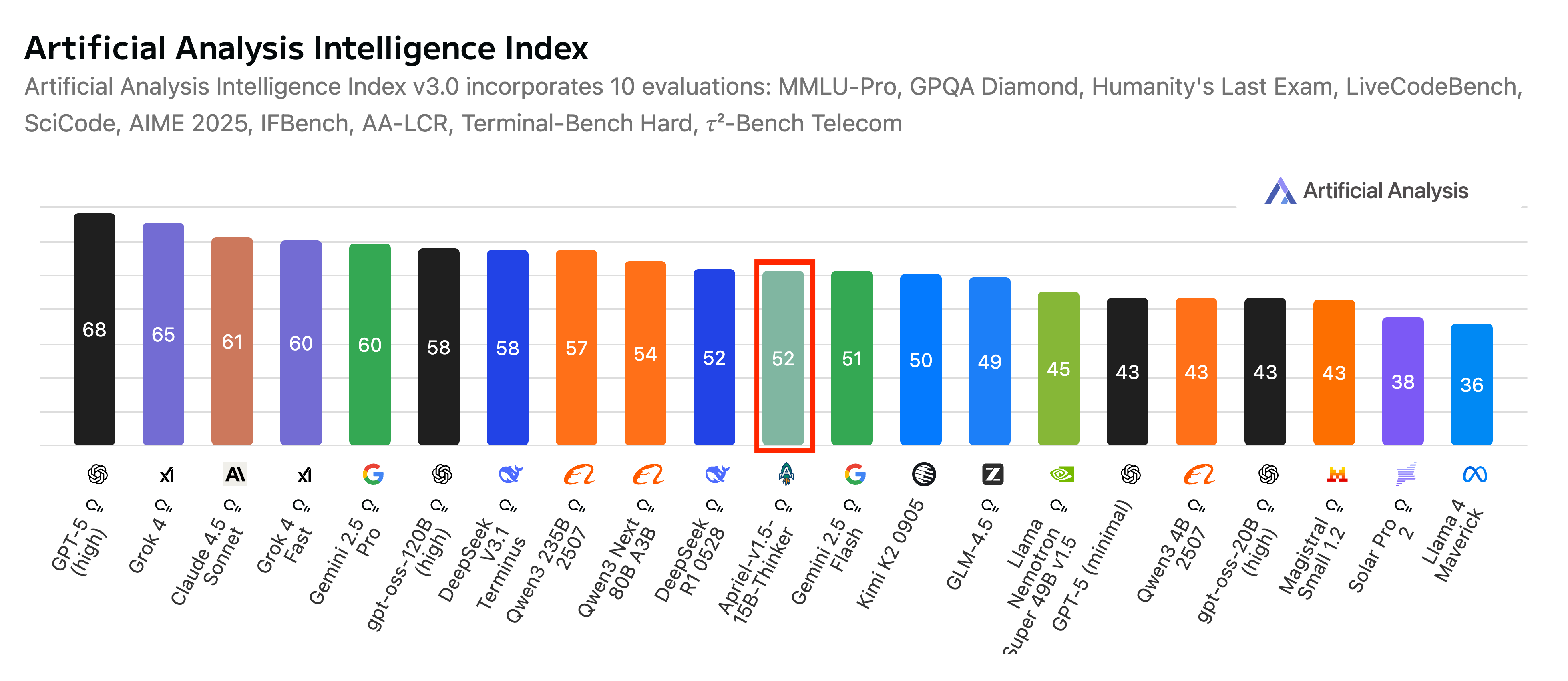

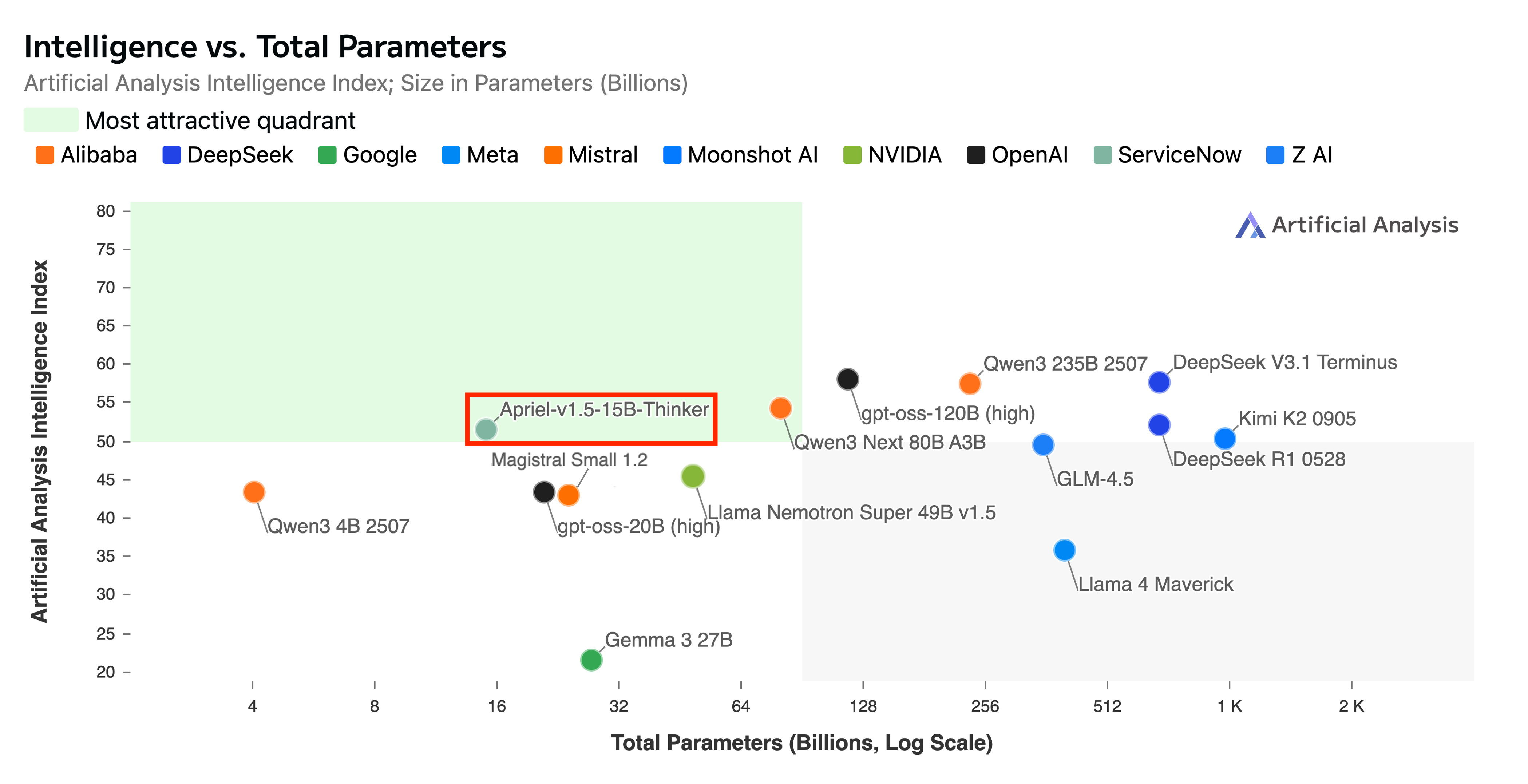

这款参数量仅为 15B 的模型 在 Artificial Analysis 指数上取得了 52 分 与 Deepseek R1 0528 Gemini-Flash 等体量远超十倍的模型表现相媲美。

在关键企业级基准测试中 Apriel-1.5-15b-Thinker 在 Tau2 Bench Telecom 达到 68 分 在 IFBench 达到 62 分 进一步验证了其在实际应用场景中的强大实力。它最大的亮点之一是高效性 15B 的参数规模使其能够便捷地部署在单张 GPU 上 大幅降低了计算资源需求和推理成本。

研发理念与技术细节

ServiceNow-AI 团队在有限资源下追求卓越 强调通过数据设计与稳健方法论构建顶尖模型。他们的策略是优先实现 SOTA 级别性能。模型默认执行广泛推理 投入额外内部努力提升稳健性与准确性 即使是对更简单的查询。尽管初期可能伴随更高的 token 使用量和响应时间 团队正致力于未来版本的效率优化。

模型的训练过程分为持续预训练 CPT 和监督微调 SFT 两个阶段。CPT 阶段 模型学习了数以亿计来自数学推理 编程挑战 科学论述 逻辑谜题以及丰富知识文本的样本 同时涵盖图像理解 推理 图像描述以及图文交错数据。

这一阶段旨在强化模型的通用推理能力。SFT 阶段 模型在超过 2M 高质量文本样本上进行微调 涵盖数学科学问题解决 编程任务 指令遵循 API 调用以及对话场景。

值得注意的是 尽管没有进行图像特定的微调 模型固有的多模态能力和文本 SFT 带来的跨模态推理行为转移使其在图像任务上也表现出色。

快速体验方式

Apriel-1.5-15b-Thinker 现已在 Hugging Face 平台开放 用户可通过 Python 的 transformers 库轻松加载使用。详细的运行指令与代码示例可在模型页面找到。对于寻求更高性能的用户 部署时可考虑结合 vLLM 并利用其定制的工具与推理解析器进行优化。