AI 实战篇:用 LangGraph 串联 RAG+MCP Server,打造能直接操控 Jira 的智能体

大家好,我是CV君,一个在AI技术领域持续深耕的老司机。在日常开发中,Jira是我们绕不开的项目管理工具。但不知道你有没有这样的痛点:

-

操作繁琐: 创建一个任务,要填一堆字段,点N次下拉框。

-

信息隔离: 任务相关的需求文档、API说明散落在Confluence、Git等各处,查起来费时费力。

-

状态滞后: 任务进度需要人工手动更新,经常与实际情况不符,带来很多烦恼。

如果,我们能有一个“智能秘书”呢?你只需要对它说一句:“帮我把‘用户登录模块优化’这个需求,创建成一个Story,分配给前端小王,优先级高,并把相关的API文档链接附上。”

几秒钟后,Jira里就妥妥地出现了一条规范、信息完整的任务。这,就是我们今天要聊的:基于LangGraph的智能体(Agent),结合RAG和MCP Server,打造一个真正AI赋能的Jira助手。

整个代码框架已经Ready,架构也已跑通,下面我就为大家彻底拆解这个项目。

01 核心架构:让AI学会“思考”和“动手”

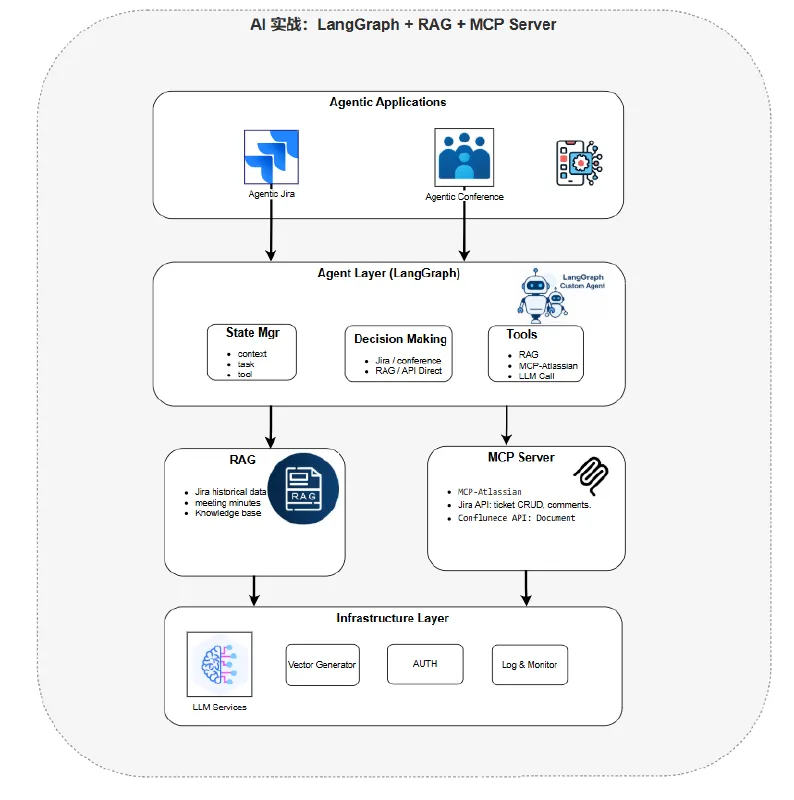

在深入的聊技术之前,我们先看看下面的这张架构图,让大家对整个系统有个宏观认识。

架构核心思想:LangGraph作为“大脑”,协调各个“专业工具人”(Tools)来完成复杂任务, 这里RAG作为知识库, 就是个“大仓库” 或者“口袋”, 下面的地盘或者叫“底座”是个LLM(大语言模型)。

我们来逐一拆解图中的核心模块:

1. LangGraph Agent(智能体大脑)

-

角色: 总指挥。它负责理解用户的自然语言指令,并规划执行步骤, 如果执行或者具体处理逻辑都归它管。

-

优势: LangGraph的`StateGraph`能够完美管理智能体的状态,实现多步骤、有条件的复杂工作流。比如,它可能会先查询知识库,再决定如何创建Jira单。

2. RAG(检索增强生成)- 智能体的“外挂知识库”

-

角色: 领域专家。我们的项目有大量的内部知识,比如代码规范、API文档、历史需求等。

-

工作流:

-

-

索引:将Confluence文档、Git代码注释等内部知识库进行切片、向量化,存入向量数据库(如ElasticSearch / OpenSearch)。

-

-

-

检索:当用户提问时(例如:“创建任务时,性能测试的标准是什么?”),RAG会从向量库中检索最相关的知识片段。

-

-

-

增强:将这些片段作为上下文,与用户问题一并送给LLM,让LLM基于“内部知识”生成更精准的回答或执行动作。

-

3. MCP Server for Jira(智能体的“手和脚”)

-

角色: 实干家。这是最关键的一环!MCP(Model Context Protocol)是新兴的标准化协议,它允许我们以统一的方式为LLM提供工具。

-

功能: 我们封装了一个MCP Server,专门用于操作Jira。它暴露出一系列标准工具函数,例如:

-

-

jira_get_issue:Get details of a specific issue

-

jira_search:Search issues using JQL

-

-

-

jira_create_issue:Create a new issue

-

-

-

jira_update_issue:Update an existing issue

-

jira_transition_issue:Transition an issue to a new status

-

jira_add_comment:Add a comment to an issue

-

好处: LangGraph Agent可以直接调用这些标准化工具,无需关心Jira REST API的复杂细节,实现了完美的解耦。

02 代码实战:核心流程一览

代码框架已经Ready,这里贴出最核心的LangGraph图定义和执行流程,让大家感受一下其简洁和强大。

from typing import Dict, Any

from langgraph.graph import StateGraph, END

from src.core.state import AgentState

from src.agents.router import AgentRouter

from src.agents.jira_agent import JiraAgent

from src.agents.conference_agent import ConferenceAgent

import logging# Set up logging

logging.basicConfig(level=logging.INFO)

logger = logging.getLogger(__name__)classGraphManager:"""Manages the LangGraph workflow for the agent system."""def__init__(self):# 初始化GraphManager,创建所需的代理和图构建器logger.info("Initializing GraphManager")self.router = AgentRouter() # 路由代理,负责请求分发self.jira_agent = JiraAgent() # Jira代理,处理Jira相关操作self.conference_agent = ConferenceAgent()self.builder = StateGraph(AgentState) # 基于AgentState的状态图构建器self._setup_graph() # 设置图结构def_setup_graph(self):"""Set up the graph nodes and edges."""logger.info("Setting up graph nodes and edges")# 添加节点self.builder.add_node("router", self._route_request) # 路由节点self.builder.add_node("jira_agent", self._process_jira_request) # Jira处理节点self.builder.add_node("conference_agent", self._process_conference_request)# 添加条件边,根据_route_decision函数输出决定路由self.builder.add_conditional_edges("router",self._route_decision,{"jira_agent": "jira_agent","conference_agent": "conference_agent","end": END})# 添加从Agent到工作流结束的线性边self.builder.add_edge("jira_agent", END)self.builder.add_edge("conference_agent", END)# 设置入口点,所有工作流都从路由器开始self.builder.set_entry_point("router")logger.info("Graph setup completed")def_route_request(self, state: AgentState) -> Dict[str, Any]:"""Route the request to the appropriate agent."""logger.info("Routing request")return self.router.process(state)def_process_jira_request(self, state: AgentState) -> Dict[str, Any]:"""Process a Jira request."""logger.info("Processing Jira request")return self.jira_agent.process(state)def_process_conference_request(self, state: AgentState) -> Dict[str, Any]:"""Process a conference request."""logger.info("Processing Conference request")return self.conference_agent.process(state)def_route_decision(self, state: AgentState) -> str:"""Make routing decision based on state."""# 访问最后一条消息以确定路由messages = state.get("messages", [])logger.info(f"Making routing decision based on state. Messages count: {len(messages)}")ifnot messages:logger.info("No messages found, routing to end")return"end"# 目前根据current_agent字段进行路由current_agent = state.get("current_agent", "")logger.info(f"Current agent: {current_agent}")if current_agent == "jira":# 路由到Jira代理logger.info("Routing to jira_agent")return"jira_agent"elif current_agent == "conference":logger.info("Routing to conference_agent")return"conference_agent"else:logger.info("Routing to end")return"end"defcompile(self):"""Compile and return the graph."""logger.info("Compiling graph")return self.builder.compile()03 AI赋能Jira:不止于创建任务

这个智能体能做什么?大家可以头脑风暴一下!

1. 自然语言生成任务卡片: 如开篇所述,一句话创建复杂任务。

2. 智能问答与报告:

-

“我们Q1季度,哪个模块产生的Bug最多?列出Top3。”

-

“把‘电商大促’项目的所有阻塞态任务汇总成一个Markdown报告发到群里。”

3. 自动化工单处理:

-

监控日志,自动为频繁出现的Error创建Bug单。

-

识别Git Commit Message,自动将关联的任务状态更新为“Resolved”。

4. 上下文感知辅助:

-

在任务界面,直接问Agent:“这个任务关联的PR代码评审意见是什么?”(它通过RAG去Git里找)。

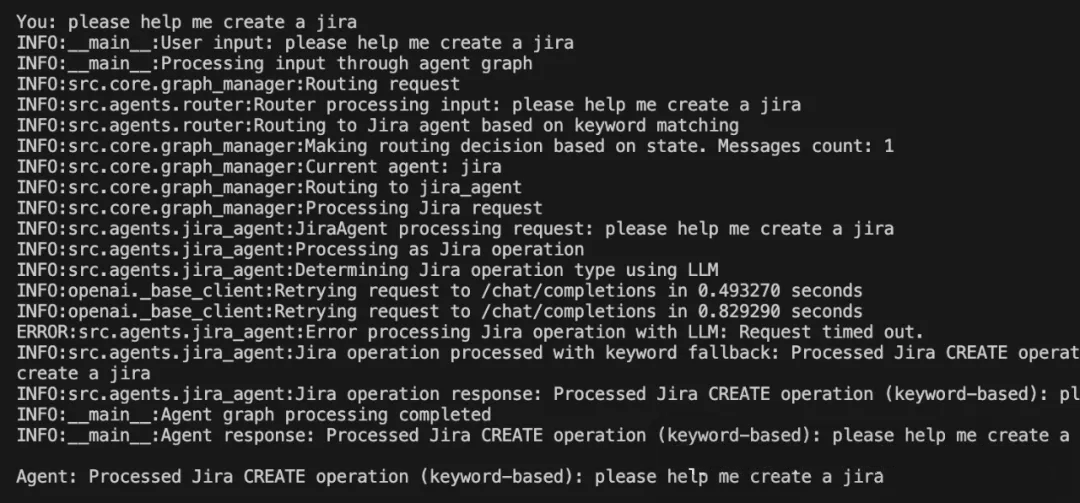

智能体运行截图:

接下来,我也为读者朋友们准备了一份 “完整版” 大模型资源,里面包含了论文、书籍、面试题、项目源码和课程等。如果你想快速学会大模型,只需在【小灰熊大模型】后台对我发出接头暗号:【111】 ,我就会把完整资料包发送给你。

04 总结与展望

通过 LangGraph(协调) + RAG(知识) + MCP Server(执行) 这个黄金组合,我们成功地构建了一个能理解、会思考、可执行的AI Agent。

这套架构的可扩展性极强:

-

未来要操作Confluence?再加一个MCP Server即可。

-

要连接Jenkins?同样封装成MCP工具。

-

LangGraph会轻松地将它们纳入统一的工作流中。

技术栈总结:

-

Agent框架: LangGraph

-

大模型: 开源LLM,比如Qwen3,DeepSeek,gpt-oss

-

工具协议: MCP

-

知识库: RAG (ElasticSearch / OpenSearch + 文本嵌入模型)

-

目标系统: Jira (REST API)

AI不是飘在空中的概念,而是能落地解决实际问题的利器。希望这个实战项目能给你带来启发。如果你对LangGraph、MCP或者RAG的细节感兴趣,欢迎在评论区留言,我们可以再开专题深入讨论。

觉得这篇文章干货满满吗?关注我!点赞、收藏、转发三连,让更多的小伙伴看到AI技术的魅力!