[人工智能-大模型-115]:模型层 - 用通俗易懂的语言,阐述神经网络为啥需要多层

我们用大白话 + 生活比喻 + 一步步推理,来彻底讲清楚:

🔥 为什么神经网络要“多层”?一层不行吗?

答案是:

👉 一层就像小学生,只能学简单规则;多层就像成年人,能从简单中学会复杂。

🧒 一、先看“单层神经网络”能干啥?

想象你有一个“单层神经网络”,它就像一个勤奋但只会加减乘除的小学生。

它可以学会:

- 天气热 → 多喝水 ✅

- 年龄大 → 收入高(粗略趋势)✅

但它学不会:

- 看一张照片,找出里面有没有猫 ❌

- 听一句话,判断是不是讽刺 ❌

为啥?因为它只能做线性或接近线性的判断(即使加了激活函数,表达能力也很有限)。

📌 科学术语叫:表达能力不足

🎨 二、现实世界的问题是“分层次”的,不断高阶抽象!

让我们看看人类是怎么认一只猫的:

👁️ 认猫的过程(其实是分步的):

- 第一眼:看到很多像素点(原始数据)

- 看到边缘、线条(比如耳朵的轮廓)

- 拼出眼睛、鼻子、胡须等局部特征

- 组合成“脸”的形状

- 判断:“哦,这是只猫!”

👉 这是一个逐层抽象的过程!

每一层都在回答一个问题:

- 第一层:有边吗?

- 第二层:这些边能不能组成眼睛?

- 第三层:眼睛+鼻子+耳朵像不像猫?

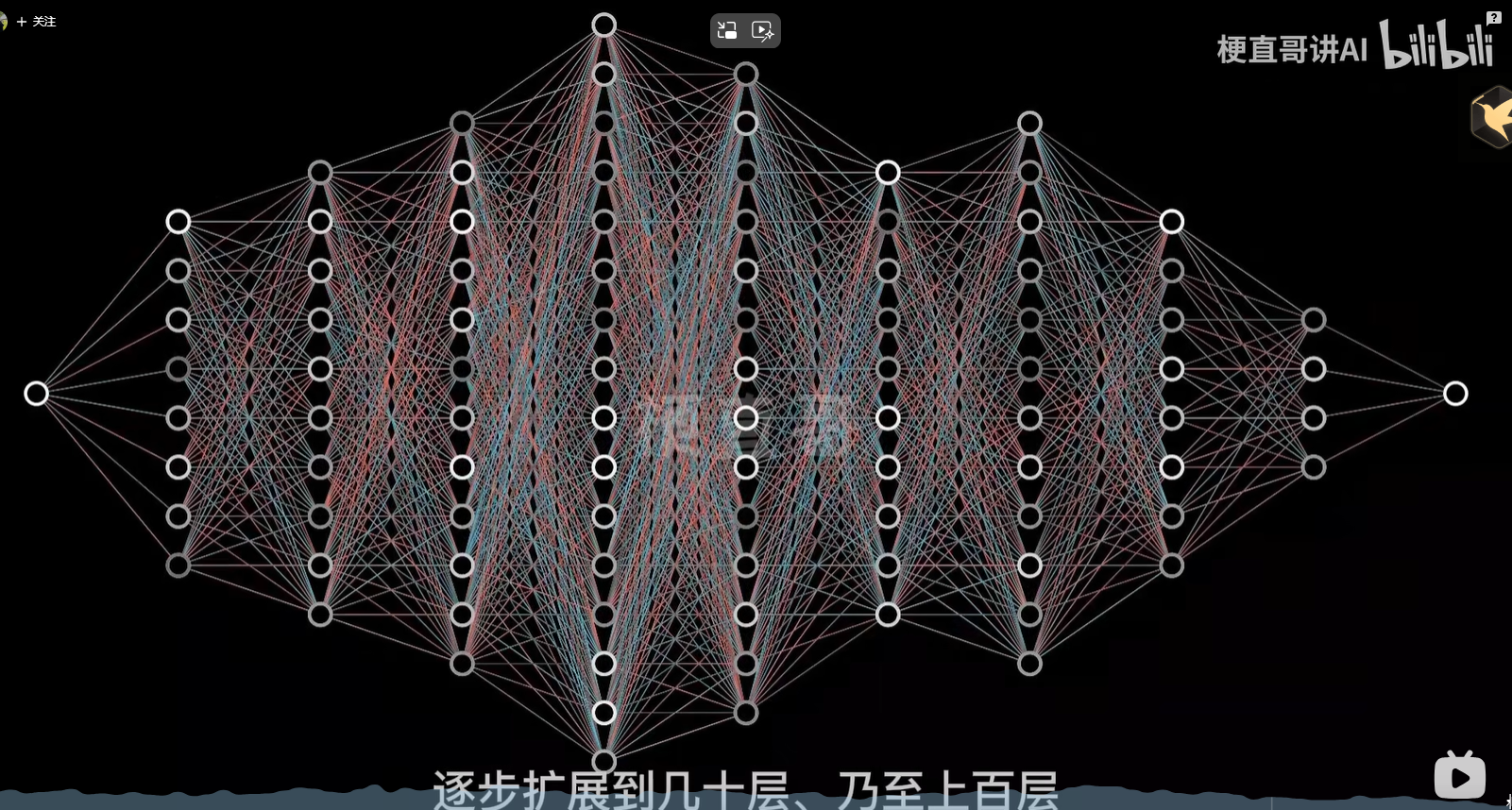

🏗️ 三、神经网络的“层” = 抽象的台阶

每增加一层,就相当于上了一个认知台阶:

输入层(像素) ↓

第1层:找边、角、颜色块(初级特征) ↓

第2层:拼成眼睛、轮子、门(中级特征) ↓

第3层:组合成“猫脸”、“汽车前脸”(高级特征) ↓

输出层:这是猫!✅

🎯 就像搭积木:

你不能跳过中间步骤,直接从零块积木搭出一座城堡。

🧩 四、举个生活例子:做菜

假设你要教AI做宫保鸡丁。

如果只有一层:

它只能记住:“鸡肉 + 花生 = 宫保鸡丁”

但如果你换个盘子、少放点葱,它就认不出来了。

如果有多层:

- 第一层:识别食材(肉、花生、辣椒)

- 第二层:判断烹饪方式(炒、炸、煮)

- 第三层:结合色香味模式,得出结论

👉 即使换了个锅、少了点盐,它也能说:“嗯,还是宫保鸡丁。”

✅ 多层让它学会了“本质”,而不是死记硬背“表面”。

📐 五、数学角度解释(依然通俗)

还记得我们说过:单层 + 非线性激活函数,理论上也能拟合任意函数?

是的,数学上有“通用逼近定理”支持这一点。

但问题是:

❗ 要达到同样的效果,单层需要天文数字般的神经元数量,根本不现实。

而多层网络可以用更少的总参数,实现更强的表达力,就像:

- 用几块 Lego 组合成复杂模型

- 而不是用一整块塑料雕出同样东西

📌 所以:

多层 ≠ 只是为了更深,而是为了高效地组合特征

🔄 六、类比:写文章

- 一字一句 → 字符层(输入)

- 组成词语 → 第1层

- 形成句子 → 第2层

- 表达段落意思 → 第3层

- 传达主题思想 → 输出

如果你只有“词→句”这一层,永远写不出有深度的文章。

🧠 神经网络也一样:

层越多,越能捕捉“从局部到整体”的语义结构。

⚠️ 七、那是不是层数越多越好?

NO!Too much is too bad 😅

| 层数太少 | 学不到复杂规律,欠拟合 |

|---|---|

| 层数太多 | 容易过拟合、训练难、速度慢 |

✅ 正确做法:根据任务选合适的深度

- 图像分类(ResNet)→ 50~150层

- 文本处理(BERT)→ 12~24层

- 简单预测 → 2~3层就够了

✅ 最后总结一句话:

神经网络需要多层,是因为真实世界的问题是“层层递进”的——从简单特征出发,逐步构建复杂概念。

就像人不是天生就会认猫的,而是通过经验一层层学会的。

🔥 没有多层,就没有真正的“深度”学习!

https://www.bilibili.com/video/BV1YY411a7F7