LangChain PromptTemplate 全解析:从模板化提示到智能链构

目录

- 前言

- 1. PromptTemplate 概述

- 1.1 什么是 PromptTemplate

- 1.2 为什么需要模板化提示

- 2. PromptTemplate 的参数与用法

- 2.1 主要参数说明

- 2.2 支持多种模板语法

- 3. 与 LLMChain 的结合使用

- 3.1 基本链式调用

- 3.2 多变量与上下文集成

- 4. PromptTemplate 与 ChatPromptTemplate 的区别

- 5. 实践技巧与最佳实践

- 5.1 提示设计建议

- 5.2 常见错误与排查

- 结语

前言

在大模型应用开发中,“提示词”(Prompt)扮演着至关重要的角色。一个好的提示词可以显著提升模型输出质量,而一个结构混乱或信息不明确的提示,则可能让模型答非所问。

然而,在复杂的项目中,提示词往往需要根据不同上下文、不同变量动态生成,这让“硬编码”成为难以维护的痛点。

为了解决这一问题,LangChain 提供了一个强大的组件——PromptTemplate。它允许开发者通过模板化方式构建提示词,让大模型的调用过程更灵活、更可复用、更结构化。本文将深入解析 PromptTemplate 的设计理念、使用方法及其在实际项目中的应用技巧。

1. PromptTemplate 概述

1.1 什么是 PromptTemplate

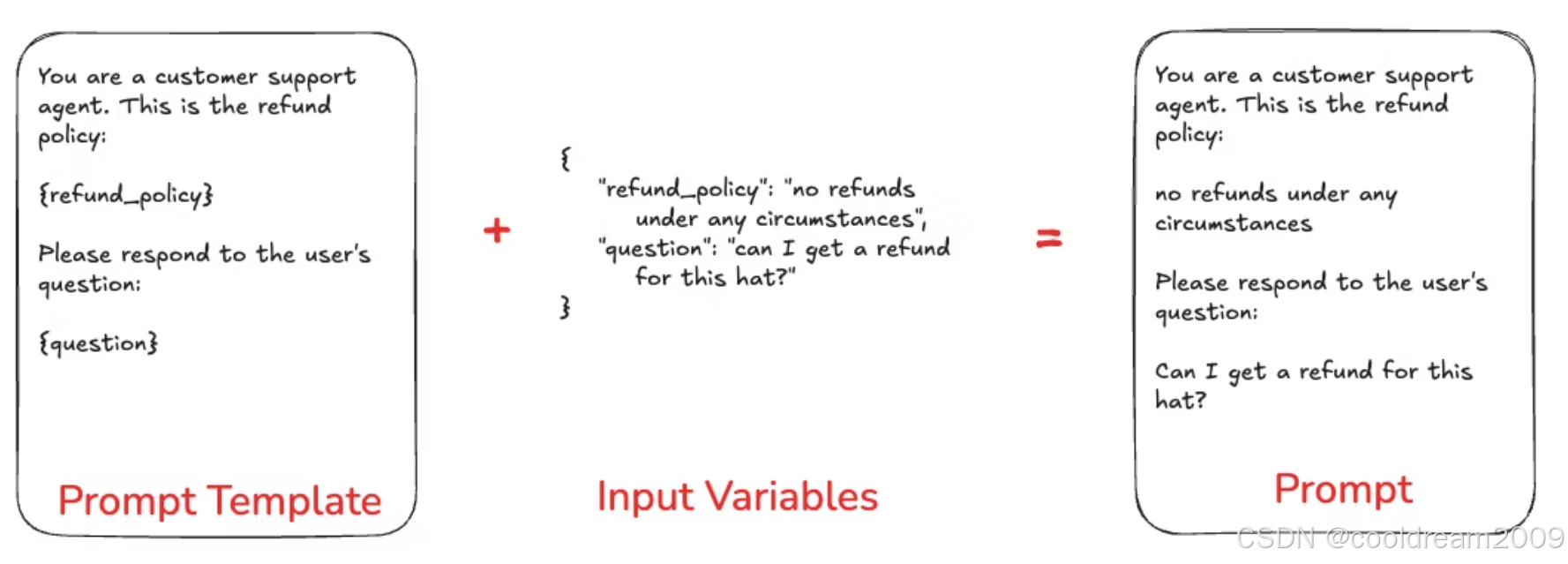

PromptTemplate 是 LangChain 中用于构建提示词模板的核心类。它的主要功能是:

- 参数化提示词内容:通过变量占位符定义动态部分;

- 减少重复代码:让提示结构可复用;

- 保证输入一致性:自动校验变量名称;

- 支持多种模板语法:包括 f-string 与 jinja2。

简单来说,PromptTemplate 就像一个“提示生成器”,你只需定义模板结构,运行时再传入不同变量即可快速生成新的提示内容。

1.2 为什么需要模板化提示

在传统开发中,我们可能会直接在代码中硬编码提示,例如:

prompt = "请为产品 LangChain 智能助手 编写一段广告文案。"

这种方式的问题包括:

- 不能灵活替换参数;

- 提示词复用性差;

- 结构不统一,易出错。

而使用 PromptTemplate,我们可以这样定义:

from langchain.prompts import PromptTemplatetemplate = "请为产品 {product_name} 编写一段广告文案,突出其 {feature}。"

prompt = PromptTemplate.from_template(template)

随后,只需动态填充变量:

print(prompt.format(product_name="LangChain 智能助手", feature="高效与灵活"))

输出结果:

请为产品 LangChain 智能助手 编写一段广告文案,突出其 高效与灵活。

这种方式不仅简洁明了,还能在不同上下文中重复利用相同的模板。

2. PromptTemplate 的参数与用法

2.1 主要参数说明

| 参数名 | 类型 | 说明 |

|---|---|---|

input_variables | List[str] | 模板中使用的变量名列表 |

template | str | 模板字符串内容 |

template_format | str | 模板语法类型(默认 “f-string”) |

validate_template | bool | 是否在初始化时校验模板的有效性 |

你可以直接手动传参:

prompt = PromptTemplate(input_variables=["product_name", "feature"],template="请为 {product_name} 写一段宣传语,突出其 {feature}。"

)

或使用更简洁的 from_template() 方法自动识别变量:

prompt = PromptTemplate.from_template("请介绍 {topic} 的主要特征。")

2.2 支持多种模板语法

LangChain 默认使用 Python 的 f-string 模板,但也支持更灵活的 Jinja2 模板引擎。

示例:

from langchain.prompts import PromptTemplatetemplate = """请写一篇关于{{topic}}的短文,字数大约{{length}}字。"""

prompt = PromptTemplate(input_variables=["topic", "length"],template=template,template_format="jinja2"

)

print(prompt.format(topic="人工智能", length=300))

输出结果:

请写一篇关于人工智能的短文,字数大约300字。

Jinja2 模板支持条件判断、循环、逻辑控制,更适合复杂提示构建场景。

3. 与 LLMChain 的结合使用

3.1 基本链式调用

在 LangChain 中,PromptTemplate 通常与 LLMChain 一起使用。后者是连接大模型与提示模板的桥梁。

from langchain.chains import LLMChain

from langchain.llms import OpenAIllm = OpenAI(temperature=0.7)prompt = PromptTemplate(input_variables=["question"],template="请用简洁的中文回答以下问题:{question}"

)chain = LLMChain(llm=llm, prompt=prompt)result = chain.run("LangChain 是什么?")

print(result)

在这段代码中:

PromptTemplate定义提示结构;LLMChain将提示与模型绑定;chain.run()自动完成变量填充并调用模型。

3.2 多变量与上下文集成

PromptTemplate 可以处理多输入场景,非常适合问答或知识检索系统(RAG)。

template = """

你是一名{role}。

请回答以下问题:

{question}背景信息:

{context}

"""prompt = PromptTemplate(input_variables=["role", "question", "context"],template=template

)print(prompt.format(role="数据分析专家",question="为什么数据可视化很重要?",context="数据可视化可以帮助发现趋势和异常。"

))

输出结果:

你是一名数据分析专家。

请回答以下问题:

为什么数据可视化很重要?背景信息:

数据可视化可以帮助发现趋势和异常。

这样的结构让提示更加上下文化,有助于模型生成更符合语境的回答。

4. PromptTemplate 与 ChatPromptTemplate 的区别

LangChain 同时提供了 PromptTemplate 与 ChatPromptTemplate,二者的用途不同。

| 对比项 | PromptTemplate | ChatPromptTemplate |

|---|---|---|

| 适用场景 | 单轮文本提示 | 多轮对话 |

| 数据结构 | 纯字符串 | 消息列表(包含角色) |

| 常见角色 | - | system、user、assistant |

| 典型应用 | LLMChain、简单任务 | ChatModel、智能体(Agent) |

例如使用 ChatPromptTemplate:

from langchain.prompts import ChatPromptTemplateprompt = ChatPromptTemplate.from_messages([("system", "你是一名中文写作助手。"),("user", "请为主题 {topic} 写一段100字的介绍。")

])print(prompt.format(topic="LangChain"))

这种结构可以更自然地表达多轮对话中的上下文关系。

5. 实践技巧与最佳实践

5.1 提示设计建议

- 明确角色定位:告诉模型“你是谁”能显著提升输出风格一致性。

- 保持格式一致:定义好输出格式(如 JSON、Markdown)方便后续解析。

- 使用参数化变量:不要在模板中硬编码具体内容。

- 验证模板:设置

validate_template=True以防止变量遗漏。 - 配合上下文动态生成:可与文档检索、记忆模块结合,自动生成补充信息。

5.2 常见错误与排查

| 错误类型 | 原因 | 解决方案 |

|---|---|---|

| KeyError | 模板变量与输入变量不一致 | 检查 input_variables |

| 模板格式异常 | Jinja2 模板语法错误 | 确认模板符号 {{ }} 是否匹配 |

| 输出偏离预期 | 提示结构不清晰 | 明确模型角色与任务目标 |

结语

在 LangChain 框架中,PromptTemplate 是构建智能交互的基础组件。它将提示词从“静态文本”转变为“动态生成逻辑”,使开发者能够:

- 快速构建结构化提示;

- 轻松管理多任务提示体系;

- 与链、代理、记忆等模块无缝衔接。

如果说 LangChain 是让大模型“工作”的系统框架,那么 PromptTemplate 就是让它“听懂指令”的语言基础。 掌握 PromptTemplate,不仅能让你的提示更智能、更灵活,也能为构建复杂的 AI 应用奠定坚实的根基。