AI驱动软件测试全流程自动化:从理论到实践的深度探索

作者:默语佬

CSDN技术博主

原创文章,转载请注明出处

前言

作为一名在软件测试领域摸爬滚打多年的老兵,我亲眼见证了测试行业从纯手工时代到自动化时代的演进。而如今,AI技术的爆发式发展正在掀起测试领域的第三次革命。

传统的自动化测试只是把"手工操作"变成了"脚本执行",本质上还是"人定义规则,机器执行规则"。而AI驱动的智能测试,则是让机器具备了"理解需求、设计用例、构造数据、智能校验"的能力,这是质的飞跃。

本文将结合我在实际项目中的探索经验,深度剖析AI如何参与测试全流程自动化,以及未来智能测试的技术趋势。

目录

- 软件测试面临的核心挑战

- AI测试的三阶段演进路径

- AI全链路测试的六大核心能力

- 技术架构与实践落地方案

- 实战效果与ROI分析

- 未来趋势与技术展望

软件测试面临的核心挑战

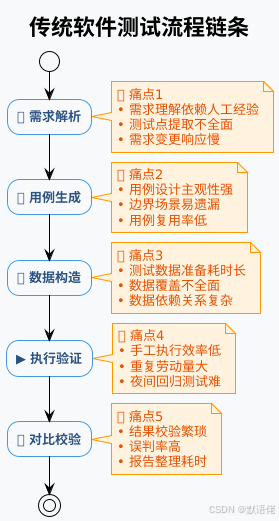

传统测试模式的五大痛点

在没有AI介入的时代,测试工作可以拆解为以下五个核心环节:

我个人认为,这五个环节中,用例生成和数据构造是耗时最长、最考验经验的部分,往往占据整个测试周期的60%以上。而AI的介入,恰好可以在这两个环节产生巨大价值。

传统自动化测试的局限性

很多团队已经引入了自动化测试框架(Selenium、Appium、JMeter等),但依然面临以下问题:

| 问题 | 说明 | 影响 |

|---|---|---|

| 脚本维护成本高 | UI变更导致大量脚本失效 | 维护成本 > 手工成本 |

| 覆盖率提升困难 | 只能覆盖已知场景 | 无法发现新问题 |

| 数据准备依然手工 | 自动化脚本≠数据自动化 | 测试效率瓶颈 |

| 结果分析靠人工 | 海量日志需要人工排查 | 定位问题慢 |

| 无法适应敏捷迭代 | 脚本跟不上需求变化 | 自动化率下降 |

我的实战经验:在一个电商项目中,我们维护了5000+条UI自动化用例,但每次需求迭代后,有30%的用例需要修改,团队花在"维护自动化"上的时间甚至超过了"执行手工测试"。这让我深刻意识到:传统自动化测试不是终点,智能化测试才是未来。

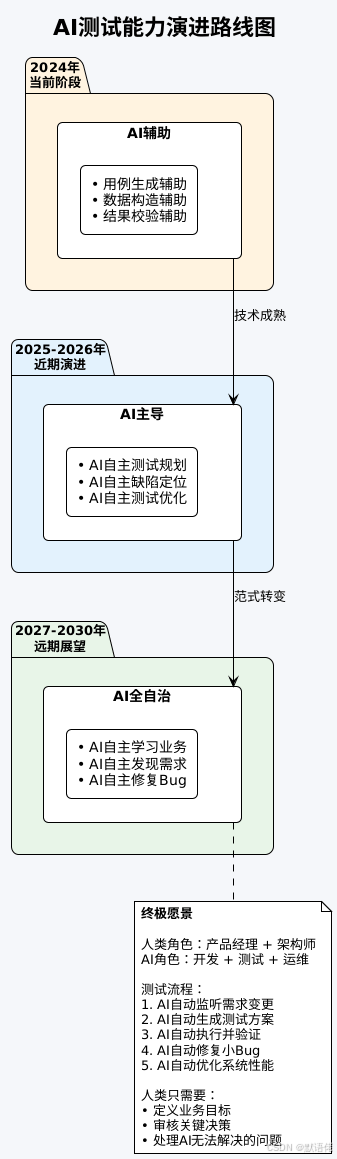

AI测试的三阶段演进路径

基于实际项目的探索,我总结出AI测试能力建设的三个渐进式阶段:

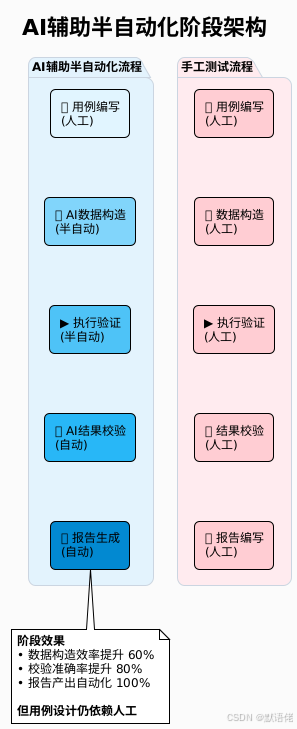

阶段一:手工测试 → AI辅助半自动化

核心突破点:测试数据构造 + 结果自动校验

在这个阶段,AI首次参与到测试流程中,但并非全面接管,而是在最耗时的两个环节提供辅助。

实践案例:

在我负责的一个交易测试项目中,我们首先引入了AI数据构造工具:

- 传统方式:人工在数据库中查找符合条件的买家、卖家、商品、店铺,平均耗时30分钟/场景

- AI辅助方式:输入"需要一个北京地区、信用等级A、有退货记录的买家",AI自动从测试数据库中匹配,耗时10秒

数据校验环节同样受益匪浅:

- 传统方式:人工对比交易订单的20+个字段(金额、优惠、分账、退款等),容易漏检

- AI辅助方式:AI自动解析订单数据,按规则比对,并高亮差异项

这个阶段的核心价值:让测试人员从"重复性劳动"中解放出来,聚焦在"用例设计"这个核心价值环节。

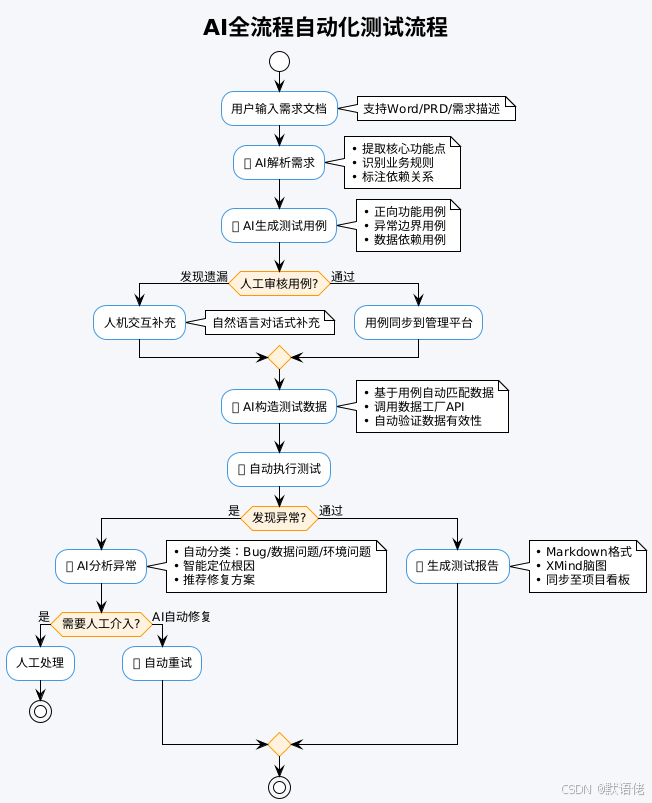

阶段二:AI辅助半自动化 → AI全流程自动化

核心突破点:AI参与用例设计 + 需求理解

如果说第一阶段是"AI当助手",那第二阶段就是"AI当主力"。

关键技术实现:

-

需求智能解析

- 使用GPT-4o等大模型对需求文档进行语义分析

- 提取关键信息:输入参数、输出结果、业务规则、异常场景

- 自动生成结构化测试需求

-

用例智能生成

- 基于测试需求模板(Prompt Engineering)

- 生成符合团队规范的测试用例

- 覆盖正常流程、异常分支、边界条件

-

人机协作补充

- AI生成的用例不可能100%完美

- 通过对话式交互,测试人员可以说:“再加一个优惠券过期的case”

- AI立即生成并插入到用例集中

我的实战体会:在这个阶段,测试人员的角色从"执行者"变成了"审核者+优化者"。AI负责90%的基础工作,人只需要关注那10%的关键场景。这种协作模式下,用例设计效率提升了5倍以上。

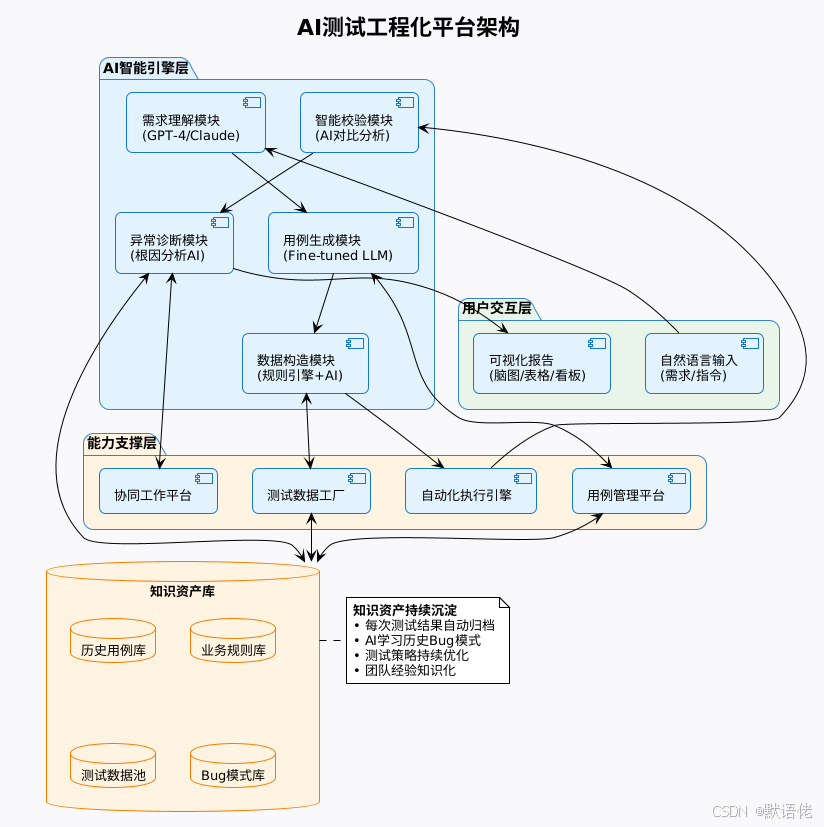

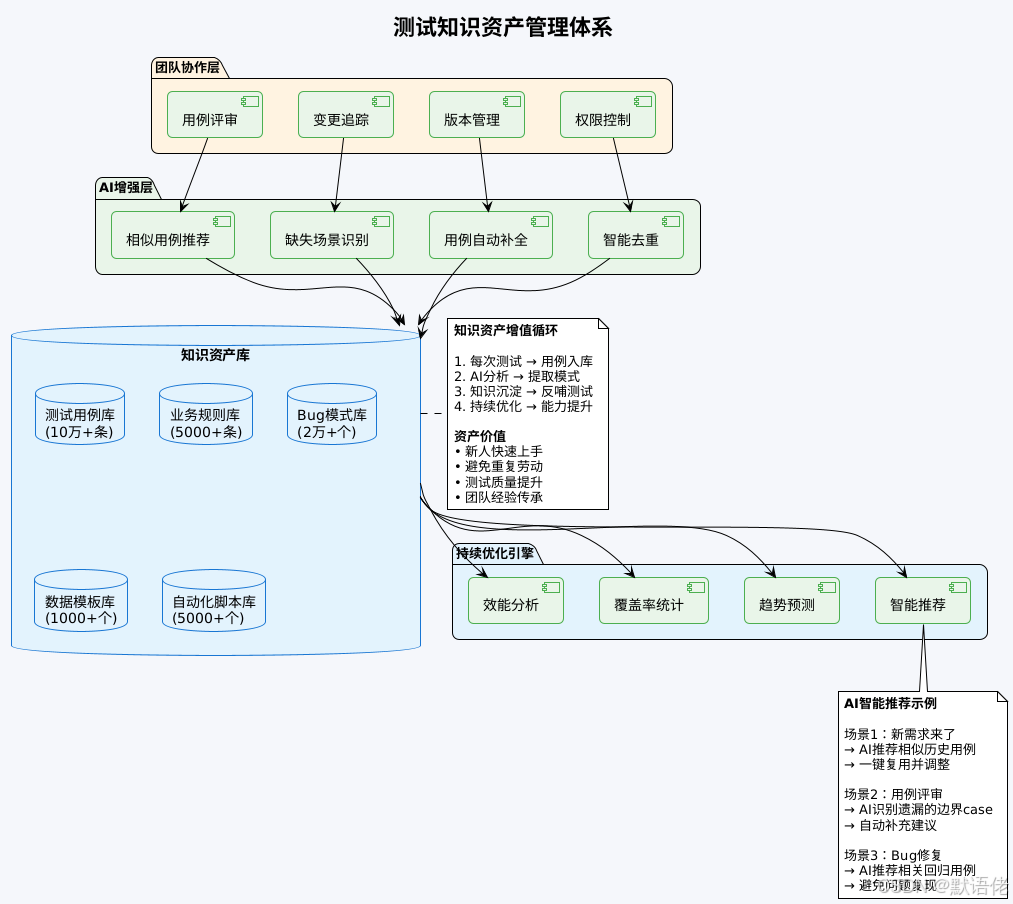

阶段三:工程化能力平台 + AI智能引擎

核心突破点:用例资产沉淀 + 知识库建设 + 持续优化

前两个阶段解决了"怎么做"的问题,第三个阶段解决的是"做得更好"的问题。

平台化能力的核心价值:

| 能力 | 传统模式 | AI平台化模式 | 提升效果 |

|---|---|---|---|

| 用例复用 | 手工搜索历史用例 | AI自动推荐相似用例 | 复用率提升70% |

| 知识传承 | 依赖文档和口口相传 | 自动沉淀成知识库 | 新人上手速度↑3倍 |

| 持续优化 | 问题重复出现 | AI识别模式并预警 | Bug逃逸率↓50% |

| 团队协作 | 邮件+会议沟通 | 平台内实时协同 | 沟通成本↓60% |

我的观点:很多团队做AI测试,只关注"用AI生成用例"这一个点,却忽略了知识沉淀和持续优化。这就像盖房子只盖地基,却不建上层建筑。只有把AI能力、测试平台、知识库三者打通,才能实现从量变到质变的飞跃。

AI全链路测试的六大核心能力

基于三个阶段的实践,我总结出要实现真正的AI全链路自动化测试,必须具备以下六大核心能力:

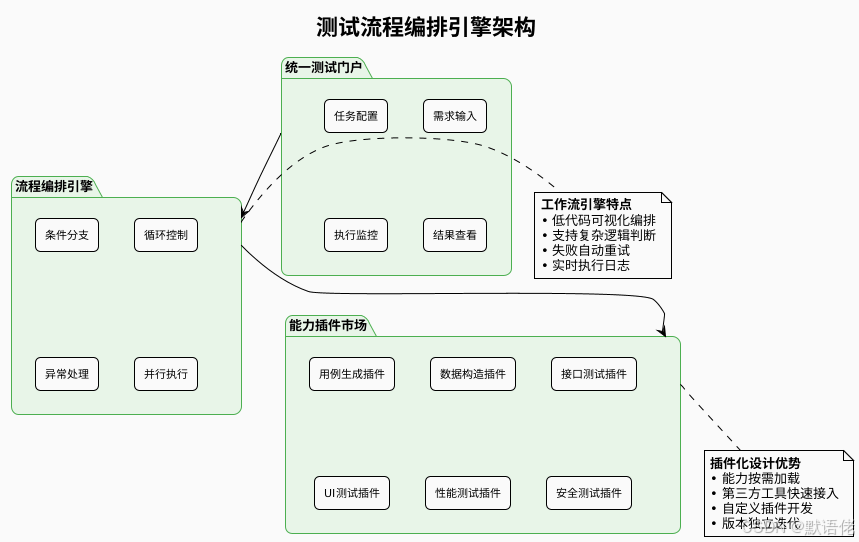

1. 流程编排与统一入口能力

核心价值:一站式测试工作台,消除工具切换成本

实践建议:

- 使用Airflow、Temporal等工作流引擎作为底层调度框架

- 设计统一的任务定义DSL(领域特定语言)

- 支持可视化拖拽式流程编排(降低使用门槛)

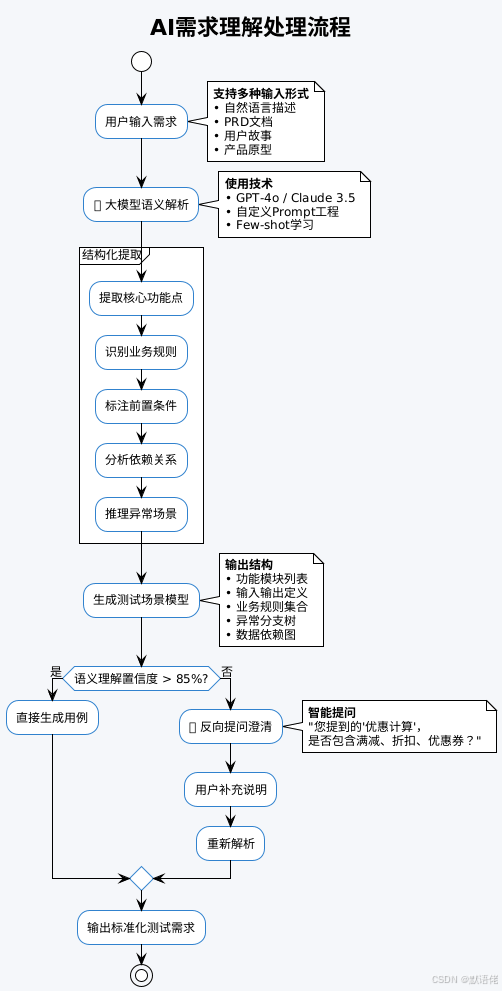

2. AI需求理解与场景建模能力

核心价值:让AI真正"理解"业务需求,而不是简单的模板填充

关键技术点:

- Prompt工程(这是AI能力的核心)

示例Prompt结构:

你是一位资深测试架构师,擅长需求分析和测试设计。【任务】

分析以下需求文档,提取测试场景。【需求内容】

{用户输入的需求}【输出要求】

1. 功能模块拆解(按优先级排序)

2. 每个功能的输入输出定义

3. 业务规则清单(用IF-THEN格式)

4. 至少5个异常场景

5. 数据依赖关系图(Mermaid格式)【输出格式】

使用JSON结构化输出...

- Fine-tuning专用模型

如果团队有足够的历史数据,可以基于GPT-4o进行微调:

- 训练数据:历史需求文档 + 对应的测试用例

- 优化目标:提高领域术语识别准确率

- 效果:需求理解准确率从70%提升到90%+

- 知识库增强(RAG)

将公司的业务规则、历史需求、测试标准等存入向量数据库,AI解析需求时先检索相关知识,再进行推理。

我的经验:最开始用ChatGPT生成测试用例时,发现它经常"理解偏差"。后来我改进了Prompt,增加了业务规则库,并做了少量微调,效果提升明显。AI需求理解能力 = 大模型能力 × Prompt质量 × 领域知识。

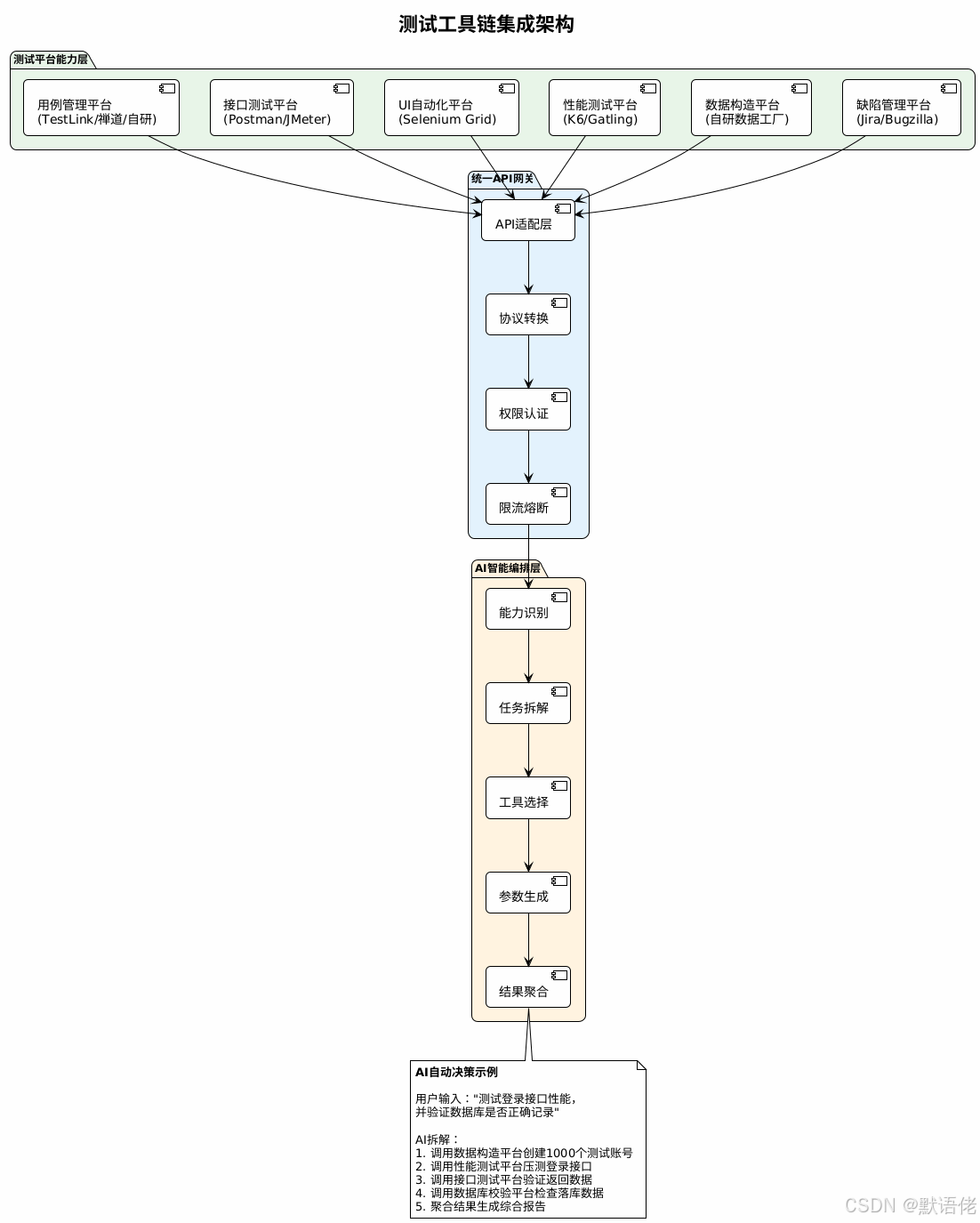

3. 自动化工具集成与API编排能力

核心价值:打通测试工具链,实现能力互通

集成方案建议:

| 平台类型 | 推荐工具 | 集成方式 | API标准 |

|---|---|---|---|

| 用例管理 | TestRail、XRay | REST API | OpenAPI 3.0 |

| 数据构造 | 自研数据工厂 | gRPC | Protobuf |

| 接口测试 | Postman、Apifox | Collection导入 | Postman Schema |

| UI自动化 | Selenium、Playwright | WebDriver | W3C标准 |

| 性能测试 | JMeter、K6 | 脚本模板 | JMX/JS |

| 缺陷跟踪 | Jira、Tapd | Webhook | REST API |

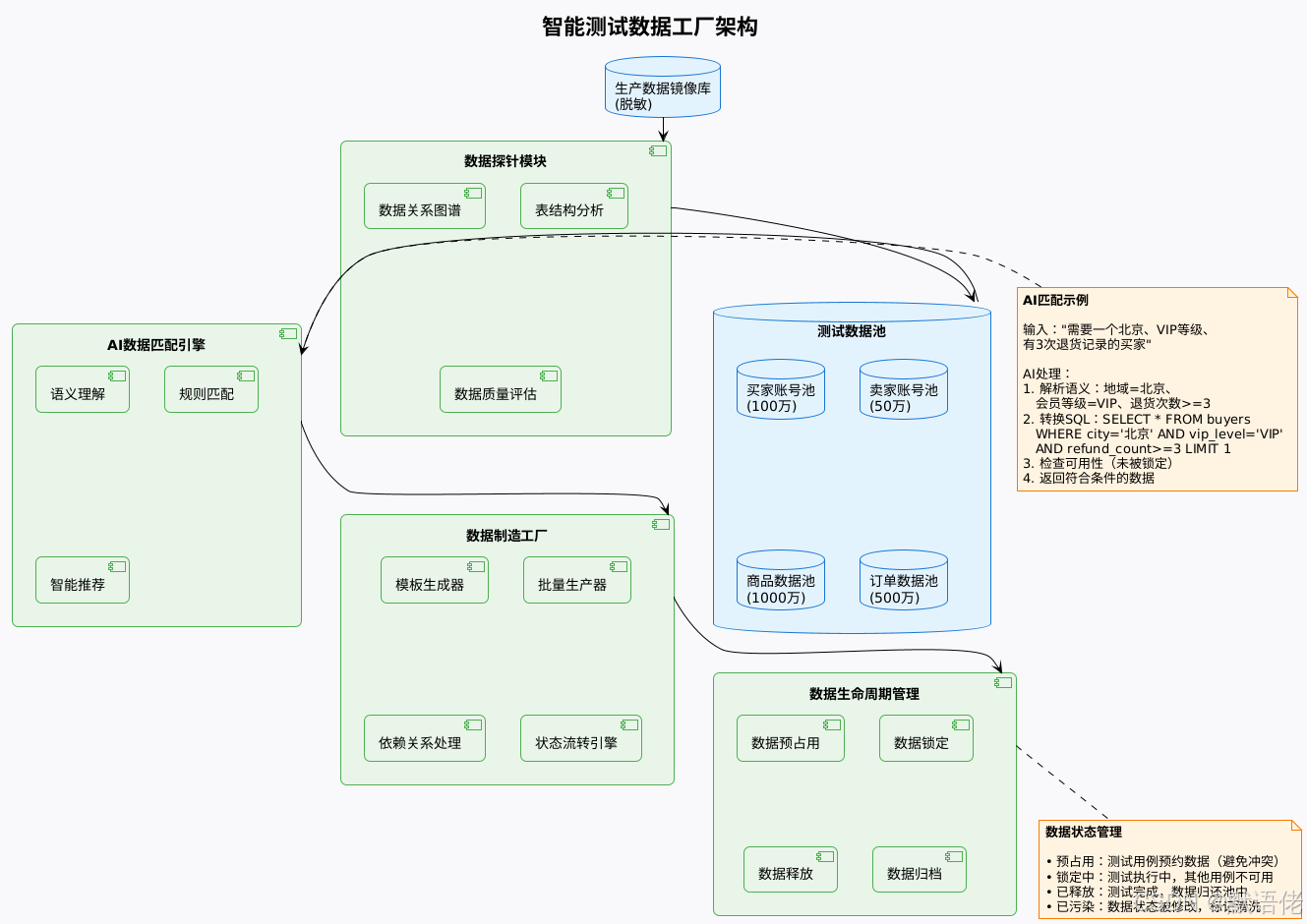

4. 测试数据工厂与智能分配能力

核心价值:让数据准备从"最耗时环节"变成"秒级完成"

我个人认为,测试数据问题是自动化测试的最大障碍。很多团队的自动化用例维护成本高,根本原因就是数据依赖关系复杂、数据状态难以保证。

数据工厂核心功能:

-

智能数据匹配

- 输入:自然语言描述或结构化条件

- 处理:AI理解 + 规则引擎

- 输出:符合条件的测试数据

-

批量数据生成

- 基于模板快速生成大量测试数据

- 自动处理数据依赖关系(如买家-订单-商品)

- 支持数据状态流转(创建订单→支付→发货→完成)

-

数据隔离与并发控制

- 多用例并发执行时,避免数据冲突

- 数据预占用机制

- 测试完成后自动释放

实践案例:

在我之前负责的交易测试项目中,传统方式准备一个测试场景的数据平均需要20分钟:

- 在数据库中找符合条件的买家(5分钟)

- 找对应的卖家和商品(5分钟)

- 创建订单并推进到指定状态(10分钟)

引入数据工厂后,只需输入:“需要一个待发货的订单,买家是北京VIP用户”,10秒钟返回结果。效率提升120倍!

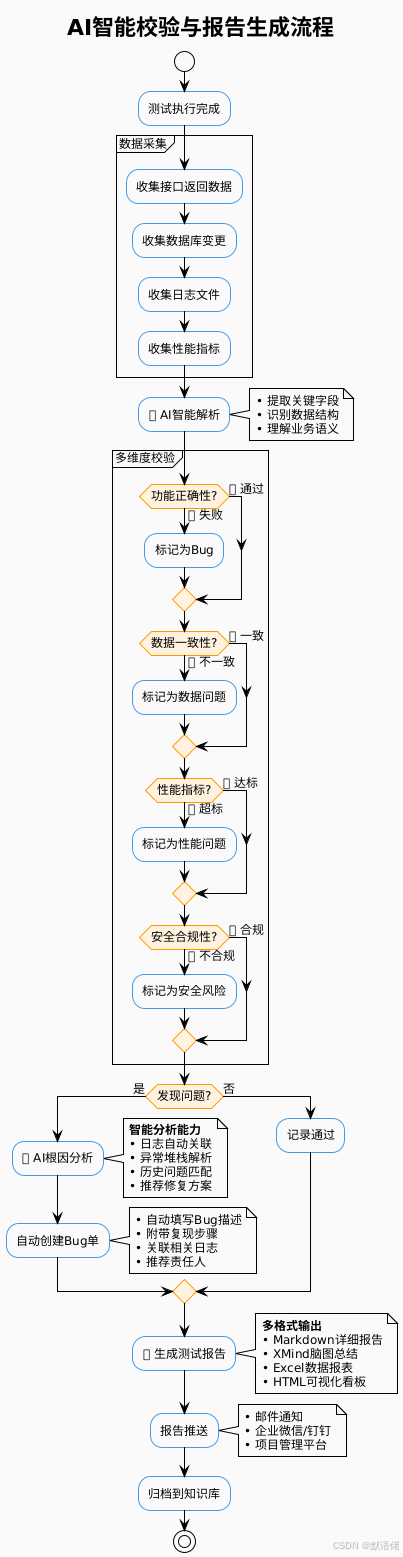

5. 智能校验、报告与归档能力

核心价值:从海量测试结果中快速发现问题,并生成可读性强的报告

智能校验的三个层次:

| 层次 | 说明 | 技术方案 | 准确率 |

|---|---|---|---|

| 规则校验 | 基于预设规则比对 | 断言引擎 | 95% |

| AI语义校验 | 理解数据业务含义 | 大模型推理 | 85% |

| 历史模式校验 | 对比历史正常数据 | 机器学习异常检测 | 80% |

我的观点:传统自动化测试最大的痛点是"硬编码断言"。一旦业务规则调整,大量断言需要修改。而AI语义校验可以理解"这个订单的实付金额应该等于商品价格减去优惠",即使字段名变了,AI仍然能正确校验。

6. 用例协作与知识资产沉淀能力

核心价值:让测试经验可传承、可复用、可持续优化

知识沉淀的核心价值:

作为一名十年以上的测试老兵,我深刻体会到测试经验传承的难度。很多时候,一个资深测试人员离职,他的经验就带走了。而通过AI+知识库的方式,可以把隐性经验显性化、个人经验团队化。

实践效果:

- 新人培训周期:从2个月缩短到2周

- 用例复用率:从20%提升到70%

- Bug逃逸率:下降50%(AI会提醒容易遗漏的场景)

- 测试效率:整体提升3-5倍

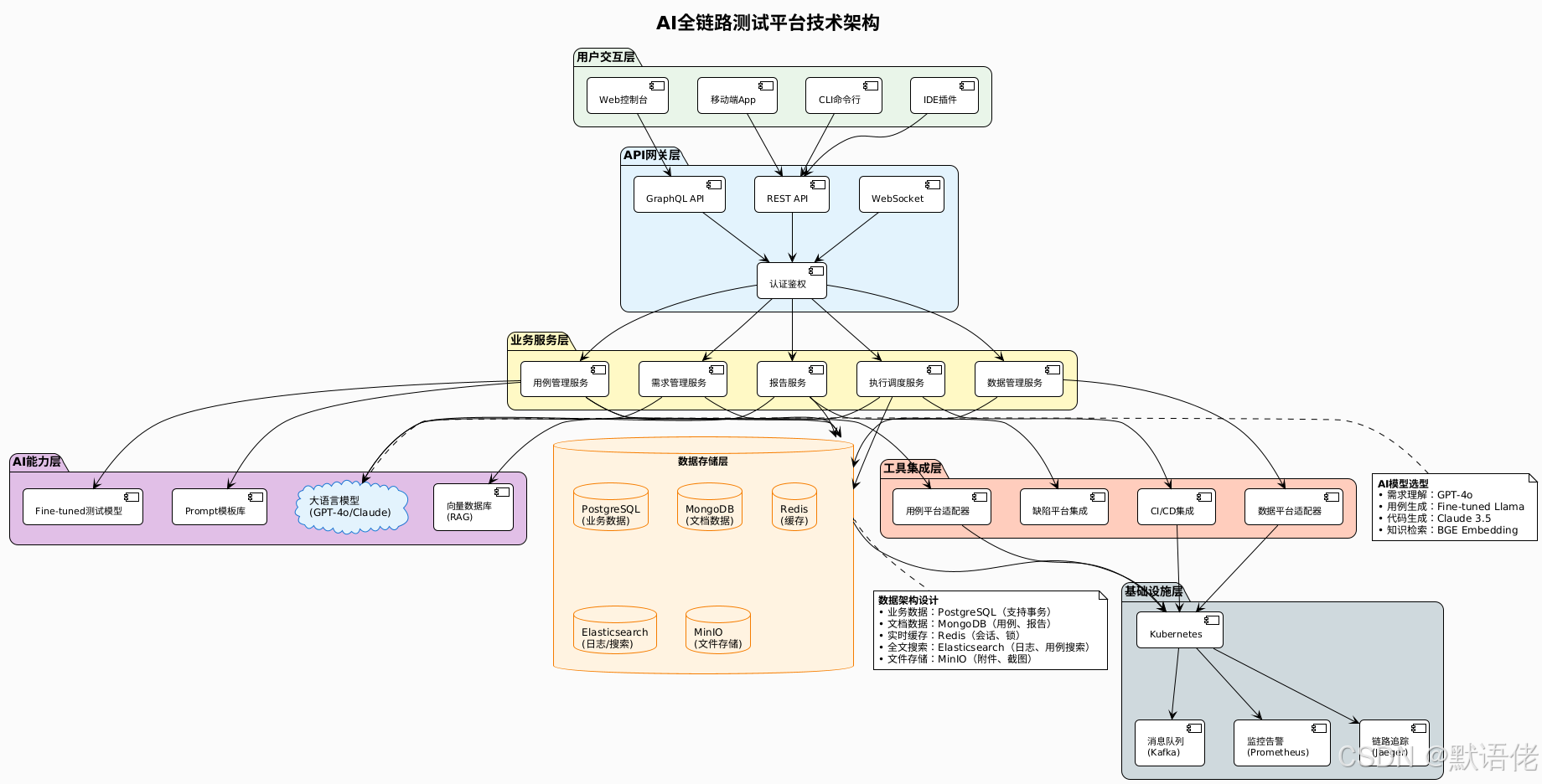

技术架构与实践落地方案

下面是我设计的AI全链路测试平台的完整技术架构:

技术选型建议

| 层次 | 技术栈 | 理由 | 替代方案 |

|---|---|---|---|

| 前端 | Vue 3 + TypeScript | 生态成熟,易上手 | React、Angular |

| 后端 | Java Spring Boot / Go | 高性能,易扩展 | Python FastAPI |

| AI模型 | GPT-4o + 自训练模型 | 效果好,成本可控 | Claude、文心一言 |

| 数据库 | PostgreSQL + MongoDB | 关系+文档数据库组合 | MySQL + ES |

| 消息队列 | Kafka / RabbitMQ | 高吞吐,可靠性高 | RocketMQ、Pulsar |

| 容器编排 | Kubernetes | 云原生标准 | Docker Swarm |

| 监控 | Prometheus + Grafana | 开源,功能强大 | Datadog、SkyWalking |

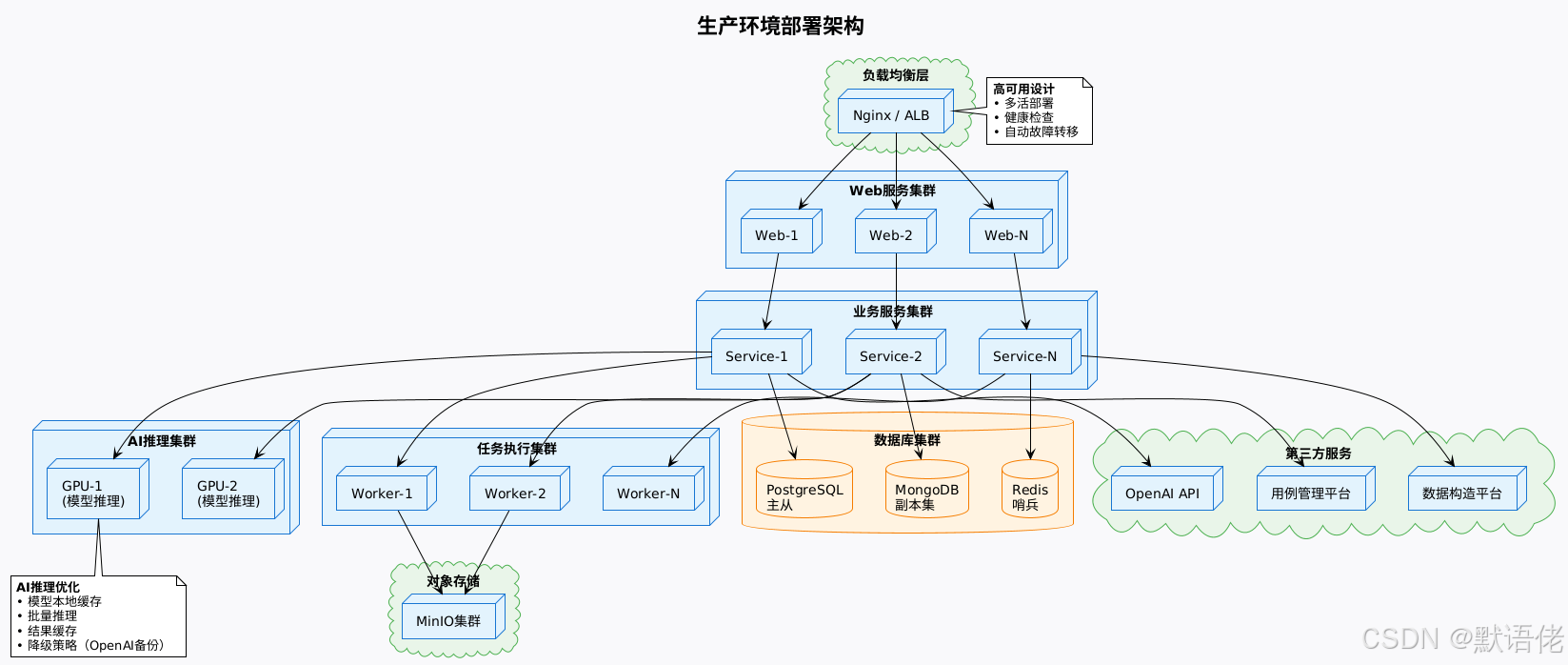

部署架构

实战效果与ROI分析

基于实际项目的数据,我整理了AI测试平台的投入产出分析:

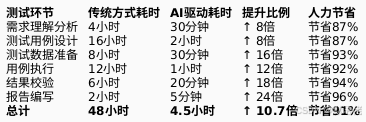

效率提升数据

质量提升数据

| 指标 | 传统模式 | AI驱动模式 | 提升幅度 |

|---|---|---|---|

| 用例覆盖率 | 65% | 92% | ↑ 42% |

| Bug发现率 | 70% | 89% | ↑ 27% |

| Bug逃逸率 | 15% | 6% | ↓ 60% |

| 误报率 | 20% | 8% | ↓ 60% |

| 回归测试时长 | 2天 | 4小时 | ↓ 87% |

ROI计算

假设一个20人的测试团队:

投入:

- 平台开发成本:150万元(一次性)

- AI API成本:每月2万元

- 维护成本:每月5万元

- 首年总投入:234万元

产出:

- 人效提升10倍,相当于节省18个测试人员

- 人力成本节省:18人 × 30万/年 = 540万元/年

- 质量提升带来的间接收益:减少线上Bug,估算100万元/年

- 首年总产出:640万元

ROI = (640 - 234) / 234 = 173%

也就是说,首年即可回本并产生1.7倍收益,第二年起每年净收益600万+。

我的实战经验

在我负责的一个大型电商测试项目中:

- 上线前:20人团队,每个迭代测试周期10天

- 上线后:12人团队,每个迭代测试周期2天

- 效果:人力减少40%,周期缩短80%,Bug逃逸率下降50%

最让我惊喜的是,测试人员的工作满意度大幅提升。他们不再需要做重复性的数据准备、用例执行等低价值工作,而是把时间花在测试策略设计、AI模型优化、测试创新这些更有挑战的事情上。

未来趋势与技术展望

作为一名长期关注AI技术的从业者,我认为AI测试领域未来会朝以下几个方向演进:

趋势一:从"AI辅助测试"到"AI主导测试"

我的判断:

- 2025年:AI能够独立完成80%的测试工作

- 2027年:AI能够自主发现需求变更并调整测试策略

- 2030年:AI+自动化可能取代50%以上的手工测试岗位

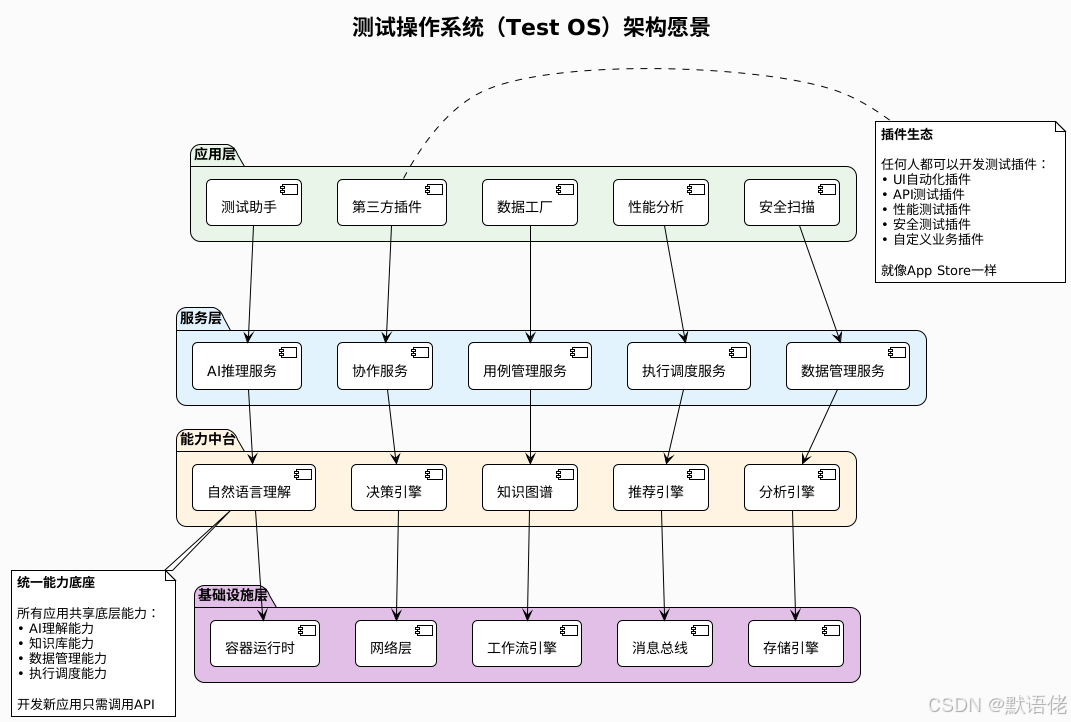

趋势二:从"单点工具"到"测试操作系统"

未来的AI测试平台将不再是一个个孤立的工具,而是类似于"操作系统"的存在:

趋势三:从"黑盒测试"到"白盒理解"

未来的AI不仅能测试系统行为,还能理解代码逻辑,实现真正的智能测试。

技术突破点:

- 代码语义理解:AI能读懂代码意图

- 自动生成测试:基于代码自动生成用例

- 智能变异测试:AI自动修改代码寻找潜在Bug

- 根因定位:Bug发生时,AI自动定位到具体代码行

示例:

# 开发写的代码

def calculate_discount(price, vip_level):if vip_level == 'gold':return price * 0.8elif vip_level == 'silver':return price * 0.9else:return price# AI自动生成的测试

test_cases = [{"price": 100, "vip_level": "gold", "expected": 80},{"price": 100, "vip_level": "silver", "expected": 90},{"price": 100, "vip_level": "bronze", "expected": 100},{"price": 100, "vip_level": None, "expected": 100}, # AI发现的边界case{"price": -100, "vip_level": "gold", "expected": ???}, # AI发现的Bug:未处理负数

]

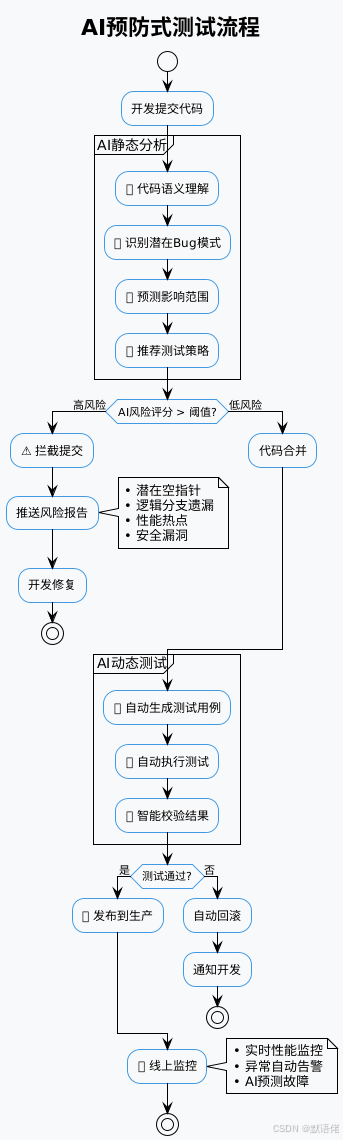

趋势四:从"事后测试"到"事前预防"

AI能够在代码提交前就预测潜在问题:

趋势五:行业知识库的建设与共享

我个人认为,未来会出现行业级的测试知识库,类似于GitHub对代码的意义。

愿景:

- 电商行业测试知识库(包含支付、订单、营销等通用测试场景)

- 金融行业测试知识库(包含风控、交易、清算等场景)

- 医疗行业测试知识库(包含电子病历、处方等场景)

价值:

- 新团队可以快速复用行业最佳实践

- 避免重复造轮子

- 推动整个行业测试能力提升

总结与建议

核心观点回顾

-

AI不是替代测试人员,而是解放测试人员

- 让测试人员从重复劳动中解脱

- 聚焦在测试策略、AI优化等高价值工作

-

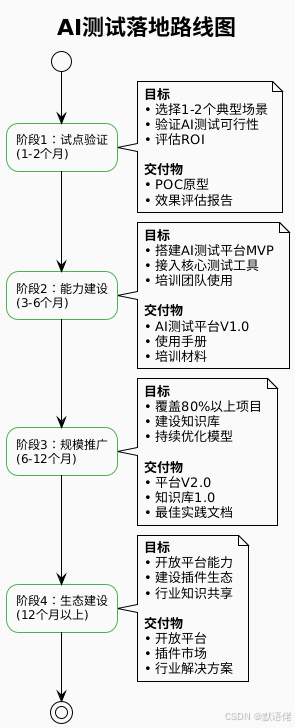

AI测试要分阶段推进

- 第一步:数据+校验自动化(快速见效)

- 第二步:用例生成自动化(核心突破)

- 第三步:知识沉淀+持续优化(长期价值)

-

平台化+AI是必然趋势

- 单点工具难以发挥AI价值

- 只有平台化才能实现能力复用和知识沉淀

-

投入产出比非常可观

- 首年ROI可达150%以上

- 第二年起每年持续产生收益

给团队的实践建议

如果你的团队想开始AI测试的探索,我的建议是:

避坑指南

基于我的实践经验,以下是一些常见的坑:

| 坑 | 表现 | 建议 |

|---|---|---|

| 过度依赖AI | 认为AI能解决所有问题 | AI是工具,人才是核心 |

| 忽视数据质量 | 训练数据质量差 | 数据质量决定AI上限 |

| 缺乏持续优化 | 上线后不管了 | 需要持续迭代优化 |

| 技术栈过于复杂 | 引入太多新技术 | 循序渐进,不要贪多 |

| 忽视团队培训 | 团队不会用 | 培训比开发更重要 |

写在最后

作为一名在测试领域深耕多年的老兵,我见证了从手工测试到自动化测试,再到如今AI驱动测试的演进。每一次技术变革,都会有人担心"测试人员会被取代吗?"

我的答案是:不会,但测试人员的角色会改变。

- 过去,测试人员是"执行者"(执行测试用例)

- 现在,测试人员是"设计者"(设计测试策略)

- 未来,测试人员是"优化者"(优化AI测试模型)

AI不是敌人,而是最强助手。那些拥抱AI、学会驾驭AI的测试人员,会成为行业中最有价值的人才。

本文分享的是我在AI测试领域的实践经验,希望能给你带来一些启发。如果你的团队也在探索AI测试,欢迎交流讨论!

参考资源

- OpenAI API文档

- Anthropic Claude文档

- LangChain框架

- TestGPT开源项目

📝 作者信息

- CSDN:默语佬

- 专注于软件测试、AI应用、测试架构

- 10年+测试经验,见证测试行业变革

原创不易,如果这篇文章对你有帮助,请给个三连:点赞👍、收藏⭐、关注🔔!

有问题欢迎评论区讨论,我会认真回复每一条评论!