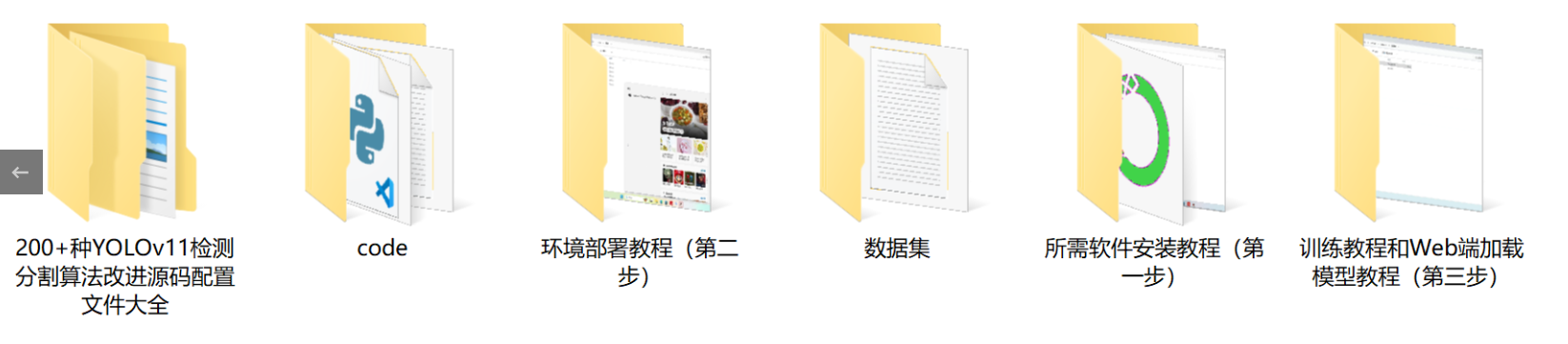

【完整源码+数据集+部署教程】 飞机表面缺陷检测系统源码和数据集:改进yolo11-EfficientFormerV2

背景意义

研究背景与意义

随着航空工业的快速发展,飞机的安全性和可靠性成为了公众和行业的关注焦点。飞机在使用过程中,表面缺陷如裂纹、凹陷和缺失的紧固件等,可能对飞行安全造成严重威胁。因此,及时、准确地检测和修复这些缺陷显得尤为重要。传统的人工检测方法不仅耗时耗力,而且容易受到人为因素的影响,导致漏检或误检的情况。因此,开发一种高效、自动化的飞机表面缺陷检测系统,成为了航空维修领域亟待解决的问题。

基于深度学习的计算机视觉技术,尤其是目标检测算法的快速发展,为飞机表面缺陷检测提供了新的解决方案。YOLO(You Only Look Once)系列算法因其高效性和准确性,已广泛应用于各种目标检测任务。YOLOv11作为该系列的最新版本,具备更强的特征提取能力和实时检测性能,适合在复杂的航空环境中应用。通过对YOLOv11进行改进,可以进一步提升其在飞机表面缺陷检测中的表现。

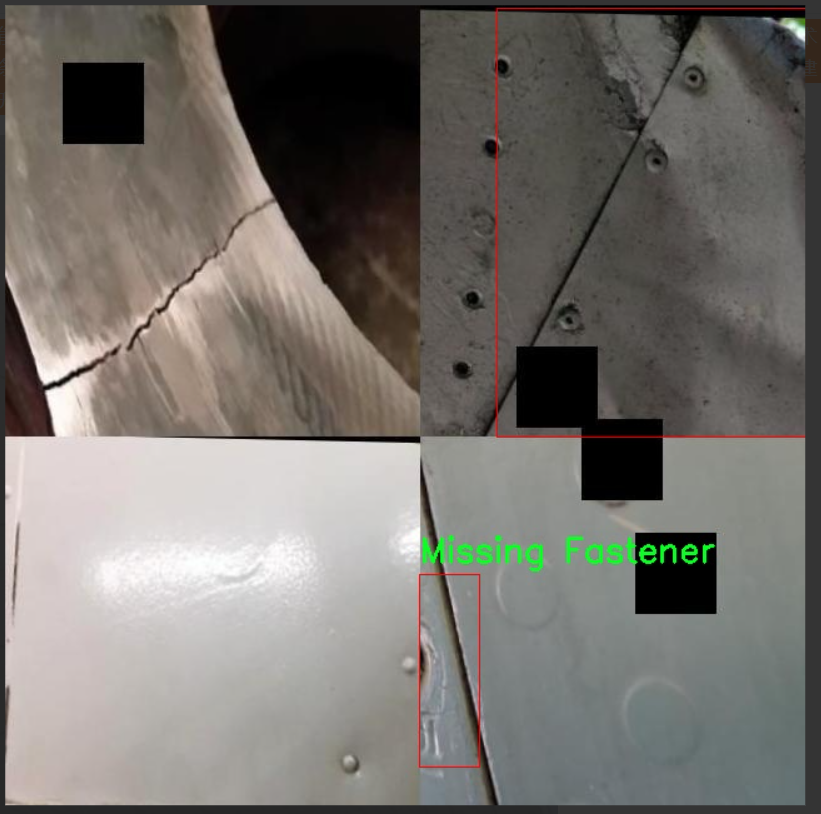

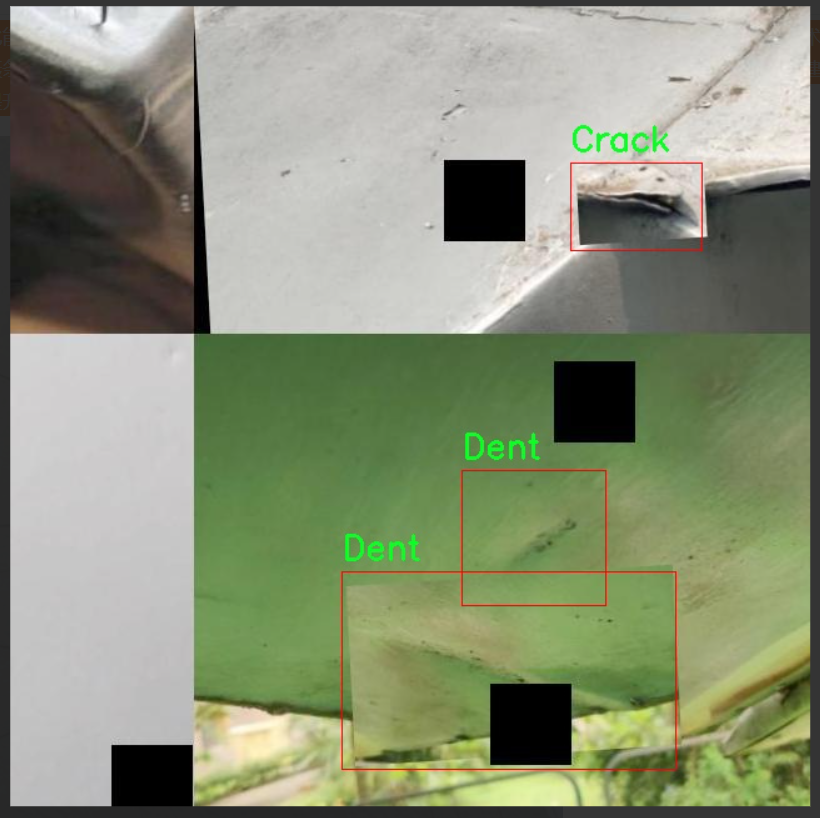

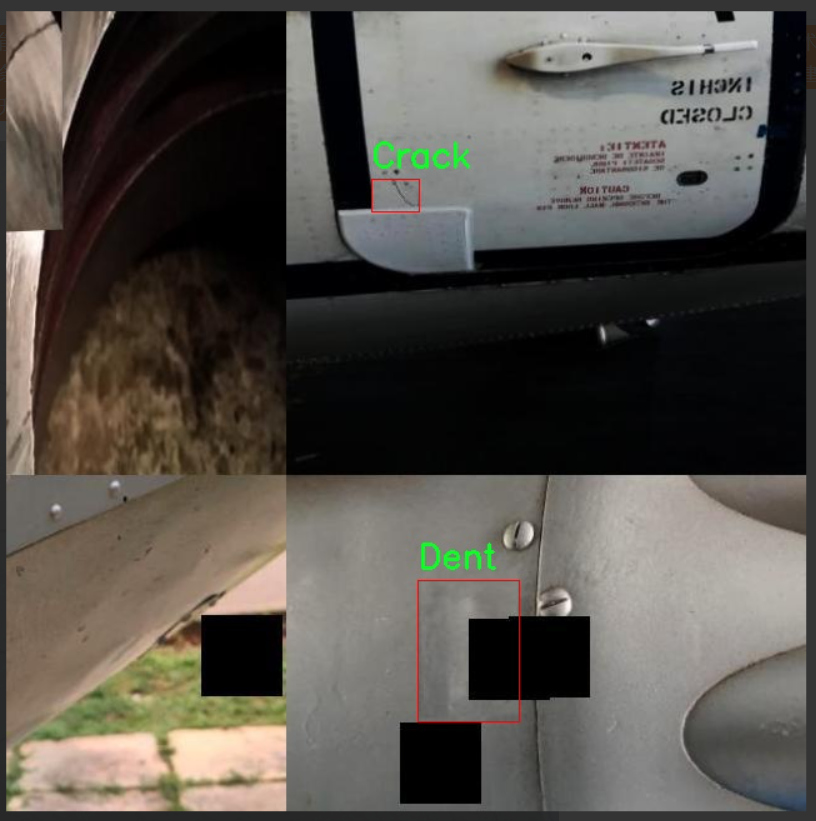

本研究将构建一个基于改进YOLOv11的飞机表面缺陷检测系统,利用包含5813张图像的数据集进行训练和测试。该数据集涵盖了三种主要缺陷类型:裂纹、凹陷和缺失的紧固件,提供了丰富的样本以支持模型的学习与优化。通过精确的缺陷检测,不仅可以提高飞机维修的效率,还能有效降低因缺陷导致的安全隐患,提升航空运输的整体安全性。

综上所述,本研究的意义在于通过先进的计算机视觉技术,推动飞机表面缺陷检测的自动化进程,为航空维修行业提供一种可靠、高效的解决方案,进而促进航空安全的提升和行业的可持续发展。

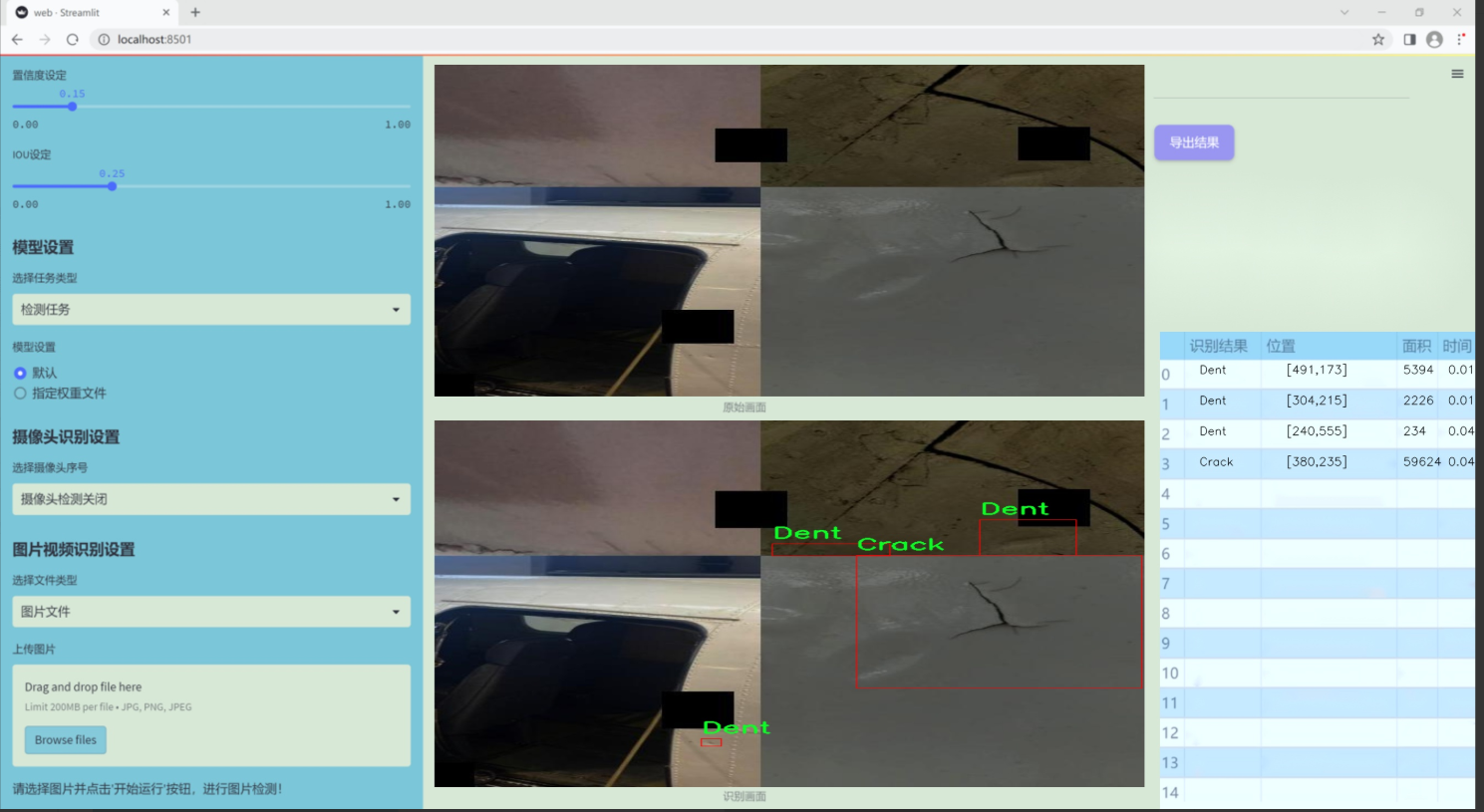

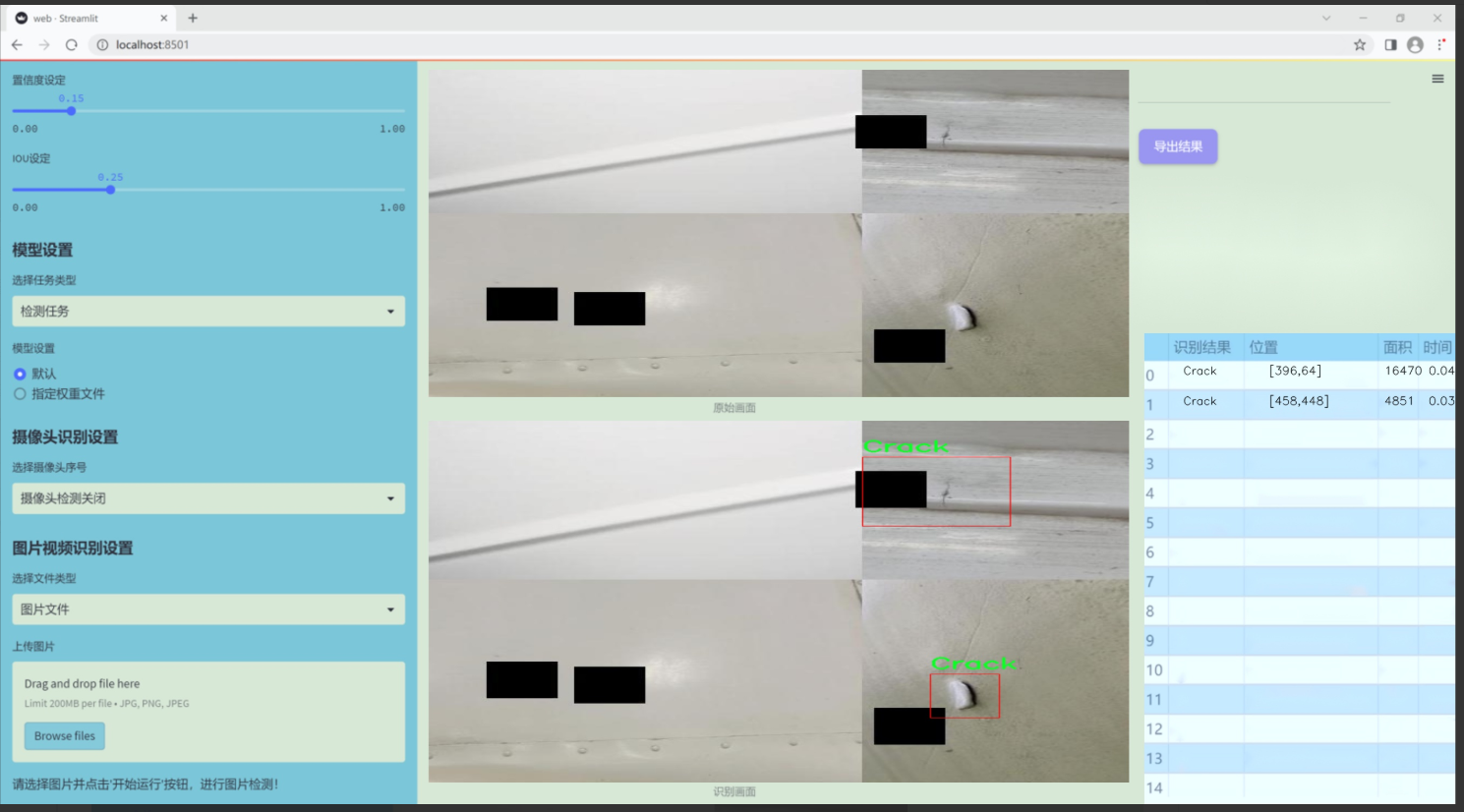

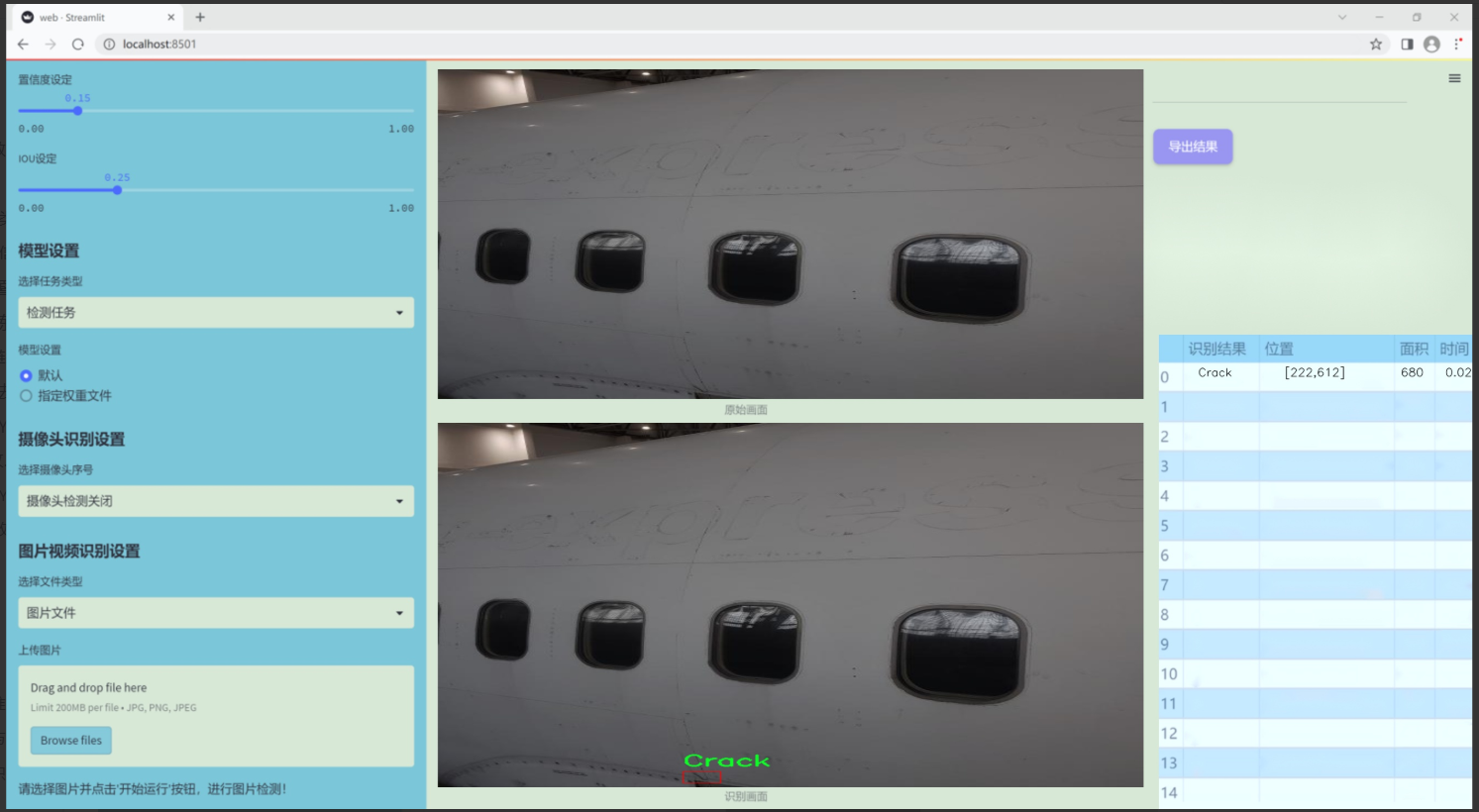

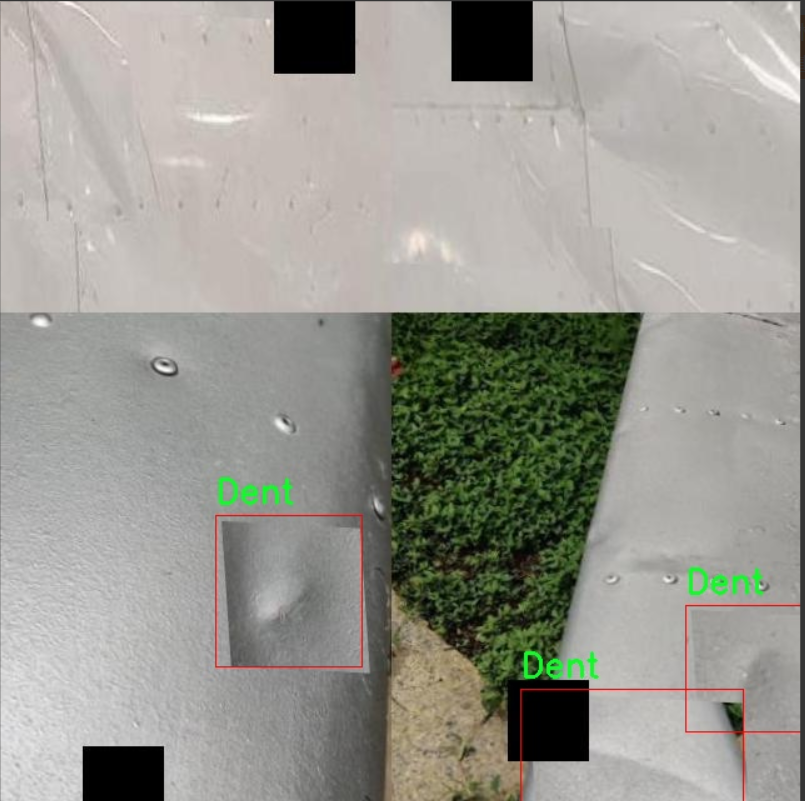

图片效果

数据集信息

本项目数据集信息介绍

本项目旨在开发一种改进的YOLOv11模型,以实现对飞机表面缺陷的高效检测。为此,我们构建了一个专门的数据集,聚焦于航空器表面可能出现的三种主要缺陷类型:裂纹(Crack)、凹陷(Dent)和缺失的紧固件(Missing Fastener)。该数据集包含丰富的图像样本,涵盖了不同角度、光照条件和背景环境下的飞机表面,以确保模型在实际应用中的鲁棒性和准确性。

在数据集的构建过程中,我们收集了来自多个航空公司和维修机构的真实飞机表面图像。这些图像经过精心标注,确保每一类缺陷都能被准确识别。裂纹类别主要包括不同长度和宽度的裂缝,凹陷类别则涵盖了从轻微凹陷到较大凹陷的多种情况,而缺失的紧固件则涉及不同部位和类型的紧固件缺失。通过这种多样化的样本选择,我们的数据集不仅反映了实际航空器维护中的常见问题,也为模型的训练提供了丰富的学习素材。

此外,为了增强模型的泛化能力,我们在数据集中引入了数据增强技术,包括旋转、缩放、翻转和颜色调整等。这些技术的应用旨在模拟不同的拍摄条件和环境变化,使得模型在面对新数据时能够保持较高的检测性能。通过这样的数据集构建和处理,我们期望能显著提升YOLOv11在飞机表面缺陷检测任务中的表现,从而为航空安全提供更为可靠的技术支持。

核心代码

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

class KANConvNDLayer(nn.Module):

def init(self, conv_class, norm_class, input_dim, output_dim, spline_order, kernel_size,

groups=1, padding=0, stride=1, dilation=1,

ndim: int = 2, grid_size=5, base_activation=nn.GELU, grid_range=[-1, 1], dropout=0.0):

super(KANConvNDLayer, self).init()

# 初始化参数self.inputdim = input_dim # 输入维度self.outdim = output_dim # 输出维度self.spline_order = spline_order # 样条曲线的阶数self.kernel_size = kernel_size # 卷积核大小self.padding = padding # 填充self.stride = stride # 步幅self.dilation = dilation # 膨胀率self.groups = groups # 分组数self.ndim = ndim # 维度self.grid_size = grid_size # 网格大小self.base_activation = base_activation() # 基础激活函数self.grid_range = grid_range # 网格范围# 初始化dropout层self.dropout = Noneif dropout > 0:if ndim == 1:self.dropout = nn.Dropout1d(p=dropout)elif ndim == 2:self.dropout = nn.Dropout2d(p=dropout)elif ndim == 3:self.dropout = nn.Dropout3d(p=dropout)# 检查分组数和输入输出维度的有效性if groups <= 0:raise ValueError('groups must be a positive integer')if input_dim % groups != 0:raise ValueError('input_dim must be divisible by groups')if output_dim % groups != 0:raise ValueError('output_dim must be divisible by groups')# 初始化基础卷积层self.base_conv = nn.ModuleList([conv_class(input_dim // groups,output_dim // groups,kernel_size,stride,padding,dilation,groups=1,bias=False) for _ in range(groups)])# 初始化样条卷积层self.spline_conv = nn.ModuleList([conv_class((grid_size + spline_order) * input_dim // groups,output_dim // groups,kernel_size,stride,padding,dilation,groups=1,bias=False) for _ in range(groups)])# 初始化归一化层self.layer_norm = nn.ModuleList([norm_class(output_dim // groups) for _ in range(groups)])# 初始化PReLU激活函数self.prelus = nn.ModuleList([nn.PReLU() for _ in range(groups)])# 创建网格h = (self.grid_range[1] - self.grid_range[0]) / grid_sizeself.grid = torch.linspace(self.grid_range[0] - h * spline_order,self.grid_range[1] + h * spline_order,grid_size + 2 * spline_order + 1,dtype=torch.float32)# 使用Kaiming均匀分布初始化卷积层权重for conv_layer in self.base_conv:nn.init.kaiming_uniform_(conv_layer.weight, nonlinearity='linear')for conv_layer in self.spline_conv:nn.init.kaiming_uniform_(conv_layer.weight, nonlinearity='linear')def forward_kan(self, x, group_index):# 对输入应用基础激活函数并进行线性变换base_output = self.base_conv[group_index](self.base_activation(x))x_uns = x.unsqueeze(-1) # 扩展维度以进行样条操作target = x.shape[1:] + self.grid.shape # 计算目标形状grid = self.grid.view(*list([1 for _ in range(self.ndim + 1)] + [-1, ])).expand(target).contiguous().to(x.device)# 计算样条基bases = ((x_uns >= grid[..., :-1]) & (x_uns < grid[..., 1:])).to(x.dtype)# 计算多个阶数的样条基for k in range(1, self.spline_order + 1):left_intervals = grid[..., :-(k + 1)]right_intervals = grid[..., k:-1]delta = torch.where(right_intervals == left_intervals, torch.ones_like(right_intervals),right_intervals - left_intervals)bases = ((x_uns - left_intervals) / delta * bases[..., :-1]) + \((grid[..., k + 1:] - x_uns) / (grid[..., k + 1:] - grid[..., 1:(-k)]) * bases[..., 1:])bases = bases.contiguous()bases = bases.moveaxis(-1, 2).flatten(1, 2) # 调整基的形状spline_output = self.spline_conv[group_index](bases) # 通过样条卷积层x = self.prelus[group_index](self.layer_norm[group_index](base_output + spline_output)) # 归一化和激活# 应用dropoutif self.dropout is not None:x = self.dropout(x)return xdef forward(self, x):# 将输入按组分割split_x = torch.split(x, self.inputdim // self.groups, dim=1)output = []for group_ind, _x in enumerate(split_x):y = self.forward_kan(_x.clone(), group_ind) # 对每个组进行前向传播output.append(y.clone())y = torch.cat(output, dim=1) # 合并输出return y

代码核心部分解释:

初始化方法:__init__方法中初始化了卷积层、归一化层、激活函数和dropout等组件,并检查输入参数的有效性。

前向传播方法:forward_kan方法中实现了样条卷积的核心逻辑,包括计算样条基、通过卷积层进行处理以及激活和归一化。

整体前向传播:forward方法将输入按组分割并对每个组进行处理,最后合并输出。

这个结构设计使得该层能够处理多维卷积,并且通过样条基的引入增强了模型的表达能力。

这个程序文件定义了一个名为 KANConvNDLayer 的神经网络层,主要用于实现一种基于样条插值的卷积操作。该层支持多维输入(1D、2D、3D),并且可以通过不同的卷积和归一化方法进行配置。程序中还定义了三个具体的子类 KANConv1DLayer、KANConv2DLayer 和 KANConv3DLayer,分别用于处理一维、二维和三维数据。

在 KANConvNDLayer 的构造函数中,首先初始化了一些基本参数,包括输入和输出维度、卷积核大小、样条的阶数、步幅、填充、扩张率、分组数等。接着,根据分组数创建了多个基础卷积层和样条卷积层,这些卷积层使用 conv_class 参数指定的卷积类型(如 nn.Conv1d、nn.Conv2d 或 nn.Conv3d)。此外,还创建了归一化层和激活函数(默认为 GELU),并根据输入的 dropout 参数决定是否添加 dropout 层。

在 forward_kan 方法中,首先对输入进行基础激活处理,然后进行基础卷积操作。接着,程序计算样条基函数,利用输入数据和预定义的网格来生成样条的输出。最后,将基础卷积输出和样条卷积输出相加,并通过归一化和激活函数处理,最后返回结果。

forward 方法负责将输入数据按组分割,并对每个组调用 forward_kan 方法进行处理,最后将所有组的输出拼接在一起。

KANConv3DLayer、KANConv2DLayer 和 KANConv1DLayer 类分别继承自 KANConvNDLayer,并在构造函数中调用父类的构造函数,传入相应的卷积和归一化类。这使得这些子类可以直接使用父类中定义的功能,同时适应不同维度的数据。

总体来说,这个程序实现了一个灵活且功能强大的卷积层,能够处理多维数据并结合样条插值技术,以增强模型的表达能力。

10.4 rmt.py

以下是代码中最核心的部分,并附上详细的中文注释:

import torch

import torch.nn as nn

import torch.nn.functional as F

class DWConv2d(nn.Module):

“”" 深度可分离卷积类 “”"

def init(self, dim, kernel_size, stride, padding):

super().init()

# 创建深度可分离卷积层

self.conv = nn.Conv2d(dim, dim, kernel_size, stride, padding, groups=dim)

def forward(self, x: torch.Tensor):'''x: 输入张量,形状为 (b, h, w, c)'''x = x.permute(0, 3, 1, 2) # 转换为 (b, c, h, w)x = self.conv(x) # 进行卷积操作x = x.permute(0, 2, 3, 1) # 转换回 (b, h, w, c)return x

class MaSA(nn.Module):

“”" 多头自注意力机制类 “”"

def init(self, embed_dim, num_heads, value_factor=1):

super().init()

self.factor = value_factor

self.embed_dim = embed_dim

self.num_heads = num_heads

self.head_dim = self.embed_dim * self.factor // num_heads

self.key_dim = self.embed_dim // num_heads

self.scaling = self.key_dim ** -0.5 # 缩放因子

# 定义线性变换层

self.q_proj = nn.Linear(embed_dim, embed_dim, bias=True)

self.k_proj = nn.Linear(embed_dim, embed_dim, bias=True)

self.v_proj = nn.Linear(embed_dim, embed_dim * self.factor, bias=True)

self.out_proj = nn.Linear(embed_dim * self.factor, embed_dim, bias=True)

def forward(self, x: torch.Tensor, rel_pos):'''x: 输入张量,形状为 (b, h, w, c)rel_pos: 位置关系张量'''bsz, h, w, _ = x.size() # 获取输入的批次大小、高度和宽度# 线性变换得到查询、键、值q = self.q_proj(x)k = self.k_proj(x)v = self.v_proj(x)# 对键进行缩放k *= self.scaling# 计算注意力权重qk_mat = torch.matmul(q, k.transpose(-1, -2)) + rel_pos # 加上相对位置qk_mat = torch.softmax(qk_mat, dim=-1) # 归一化# 计算输出output = torch.matmul(qk_mat, v) # 加权求和output = self.out_proj(output) # 最后的线性变换return output

class FeedForwardNetwork(nn.Module):

“”" 前馈神经网络类 “”"

def init(self, embed_dim, ffn_dim, activation_fn=F.gelu, dropout=0.0):

super().init()

self.fc1 = nn.Linear(embed_dim, ffn_dim) # 第一层线性变换

self.fc2 = nn.Linear(ffn_dim, embed_dim) # 第二层线性变换

self.dropout = nn.Dropout(dropout) # dropout层

self.activation_fn = activation_fn # 激活函数

def forward(self, x: torch.Tensor):'''x: 输入张量,形状为 (b, h, w, c)'''x = self.fc1(x) # 第一层线性变换x = self.activation_fn(x) # 激活函数x = self.dropout(x) # dropoutx = self.fc2(x) # 第二层线性变换return x

class VisRetNet(nn.Module):

“”" 可视化回归网络类 “”"

def init(self, in_chans=3, num_classes=1000, embed_dims=[96, 192, 384, 768], depths=[2, 2, 6, 2], num_heads=[3, 6, 12, 24]):

super().init()

self.patch_embed = PatchEmbed(in_chans=in_chans, embed_dim=embed_dims[0]) # 图像嵌入层

self.layers = nn.ModuleList() # 存储各层的列表

# 构建各层for i_layer in range(len(depths)):layer = BasicLayer(embed_dim=embed_dims[i_layer], depth=depths[i_layer], num_heads=num_heads[i_layer])self.layers.append(layer)def forward(self, x):'''x: 输入张量,形状为 (b, c, h, w)'''x = self.patch_embed(x) # 嵌入图像for layer in self.layers:x = layer(x) # 逐层前向传播return x

定义一个简单的图像嵌入类

class PatchEmbed(nn.Module):

def init(self, in_chans=3, embed_dim=96):

super().init()

self.proj = nn.Conv2d(in_chans, embed_dim, kernel_size=4, stride=4) # 卷积层用于图像嵌入

def forward(self, x):B, C, H, W = x.shapex = self.proj(x) # 进行卷积操作return x # 返回嵌入后的张量

实例化模型并进行前向传播

if name == ‘main’:

model = VisRetNet() # 创建模型实例

inputs = torch.randn((1, 3, 640, 640)) # 随机生成输入

res = model(inputs) # 前向传播

print(res.size()) # 输出结果的尺寸

代码核心部分说明:

DWConv2d: 实现了深度可分离卷积,适用于特征提取。

MaSA: 实现了多头自注意力机制,计算输入特征之间的关系。

FeedForwardNetwork: 实现了前馈神经网络,包含线性变换和激活函数。

VisRetNet: 主网络结构,负责图像的嵌入和特征提取。

PatchEmbed: 将输入图像划分为小块并进行嵌入。

这些部分共同构成了一个用于图像处理的深度学习模型,能够提取和处理图像特征。

这个程序文件 rmt.py 实现了一个基于视觉变换器(Vision Transformer)的模型,名为 VisRetNet,并定义了一系列相关的类和方法。该模型主要用于处理图像数据,具有多层次的特征提取能力。以下是对代码的详细说明。

首先,程序导入了必要的库,包括 PyTorch 和一些自定义的模块,如 DropPath 和 trunc_normal_。这些库提供了深度学习所需的基本功能和工具。

接下来,定义了一些基础的模块类。DWConv2d 是一个深度可分离卷积层,能够有效地进行特征提取。RelPos2d 类用于生成二维相对位置编码,支持在注意力机制中使用,以增强模型对空间关系的理解。MaSAd 和 MaSA 是多头自注意力机制的实现,分别支持不同的注意力计算方式。

FeedForwardNetwork 类实现了前馈神经网络,包含两个线性层和激活函数,用于增强模型的非线性表达能力。RetBlock 类是一个包含注意力机制和前馈网络的基本模块,支持残差连接和层归一化。

PatchMerging 和 BasicLayer 类分别用于处理图像的分块和构建基础的变换器层。PatchEmbed 类将输入图像转换为补丁嵌入,准备输入到后续的网络层中。

VisRetNet 类是整个模型的核心,负责构建和组织各个层次。它接受输入图像并通过多个层进行处理,最终输出特征图。模型的各个参数如嵌入维度、层数、头数等都可以通过构造函数进行配置。

最后,文件中定义了几个函数 RMT_T、RMT_S、RMT_B 和 RMT_L,这些函数用于创建不同规模的 VisRetNet 模型,分别对应不同的嵌入维度和层数配置。

在 main 部分,程序创建了一个 RMT_T 模型实例,并生成一个随机输入进行前向传播,输出特征图的尺寸。这部分代码可以用于快速测试模型的构建和运行是否正常。

总体来说,这个程序实现了一个灵活且可扩展的视觉变换器模型,适用于各种计算机视觉任务,如图像分类、目标检测等。通过不同的参数配置,用户可以根据需求选择合适的模型规模和结构。

源码文件

源码获取

欢迎大家点赞、收藏、关注、评论啦 、查看👇🏻获取联系方式