泰州建设局网站安监站通报低功耗集成主板做网站

目录

一、数据处理工具的定义与作用

1.什么是数据处理工具

2.数据处理工具的重要性

3.数据处理工具在不同行业的应用

二、常见的数据处理方法

1.数据清洗

2.数据转换

3.数据集成

4.数据分析

5.数据可视化

三、数据处理工具的选择

1.根据业务需求选

2.根据数据规模选

3.根据易用性和成本选

四、数据处理过程中的注意事项

1.数据安全

2.数据质量监控

3.合规性

五、数据处理的发展趋势

1.自动化与智能化

2.实时处理

3.云化

4.融合与集成

总结

Q&A常见问答

现在这时代,数据满天飞,谁手上没点数据呢?但这些原始数据啊,大多数时候都乱糟糟的,东一块西一块,直接看根本看不出啥名堂。想让它真正发挥价值?得靠“加工”。数据处理工具,就是干这个“加工”活的得力助手。今天,咱们就实实在在地聊聊,数据处理工具到底能干啥,以及那些常用的处理方法都是怎么回事。你准备好了吗?

一、数据处理工具的定义与作用

1.什么是数据处理工具

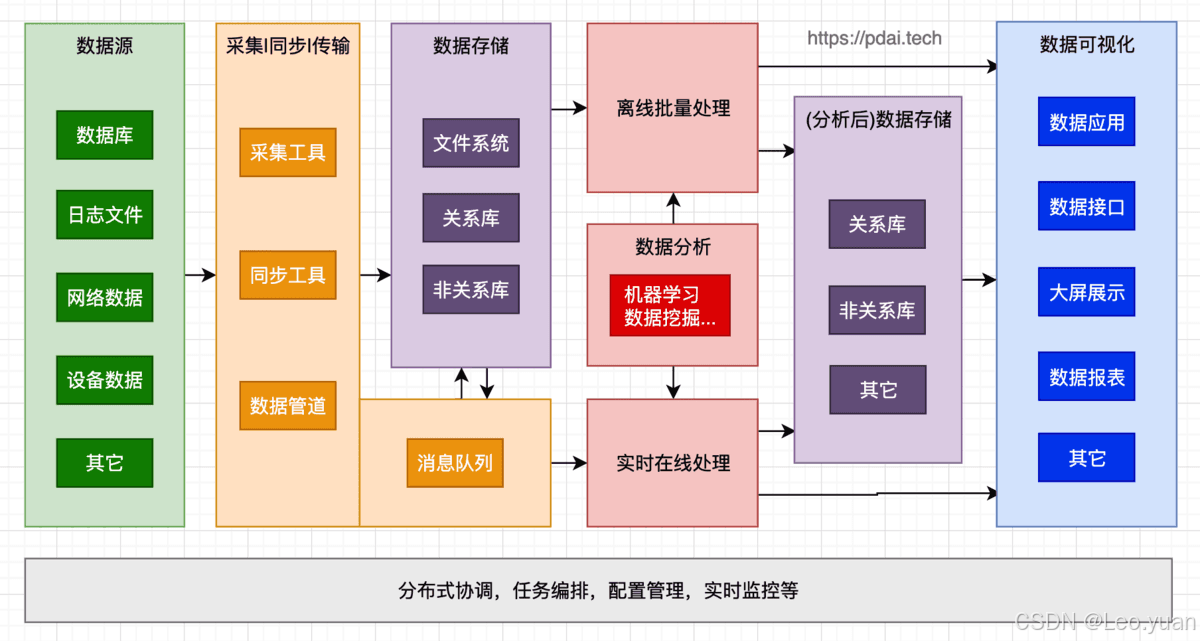

简单来说,数据处理工具就是专门用来“收拾”数据的软件或者平台。从哪儿“拿”数据(采集)、把数据里的“脏东西”去掉(清洗)、把数据变成我们想要的格式(转换)、最后找个地方好好“放”起来(存储),这些活它都能干。说白了,它就是个数据加工厂,把那些原始、杂乱的数据原料,一步步变成我们能看懂、能用的有用信息。有了它,企业和组织管理数据、利用数据就顺手多了,做决定也能更靠谱,更有依据。你懂我意思吧?

2.数据处理工具的重要性

为啥说它重要?原因很实在。

- 第一,它能让数据更干净、更靠谱。原始数据里,错误、重复、缺胳膊少腿(缺失值)的情况太常见了。手动去挑?累死人还容易漏。数据处理工具就能系统性地把这些“毛病”找出来、修好或者清理掉,保证你最后拿到手的数据是准确、完整的。想想看,电商的订单数据里,客户名字写错了、地址没写全,这种问题是不是很普遍?用工具处理,分分钟就能搞定,省心省力。

- 第二,它能省下大把的时间和人力。面对海量数据,手动操作简直就是体力活,效率低还容易出错。数据处理工具的优势就在于能把很多重复性的任务自动化。比如,每个月都要汇总分析销售数据,手动搞可能得好几天,要是用对了工具,几个小时就弄利索了,而且出错概率小得多。我一直强调,时间就是成本,省下的时间就是赚到的。

- 第三,它能帮你从数据里“挖”出真金白银。数据本身不会说话,但经过处理和转换、分析之后,它就“活”了。企业能从中发现市场变化的苗头、客户心里在想啥、业务哪里卡壳了。这些信息太关键了,直接关系到怎么定营销策略、怎么优化业务。举个最直接的例子,分析客户的购买行为,就能知道他们喜欢啥,然后精准地推荐产品,这效果能不好吗?

3.数据处理工具在不同行业的应用

这工具可不是哪一行的专属,各行各业都用得上,而且用处还不小。

- 金融行业:银行用它分析客户的信用数据,评估这人借钱靠不靠谱,该不该给贷款。保险公司用它处理理赔数据,揪出那些可疑的、可能是骗保的行为,能省下不少冤枉钱。

- 医疗行业:医院用它管病历、分析病历。海量的病历数据里藏着宝,医生通过分析,能摸清楚某种病的发病规律、哪种治疗效果更好,这对临床决策的帮助是实实在在的。听着是不是很熟?现在很多大医院都在这么干。

- 制造业:工厂用它收集和分析生产线上设备运转的数据。目标是啥?就是让生产流程更顺、产品质量更高。比如,分析设备的运行数据,就能预判它啥时候可能要出毛病,提前维护,避免停产损失。用过来人的经验告诉你,这招预防性维护,能省大钱。

二、常见的数据处理方法

知道了工具是啥,再来看看它具体怎么“加工”数据。这里介绍几种最核心、最常用的方法。

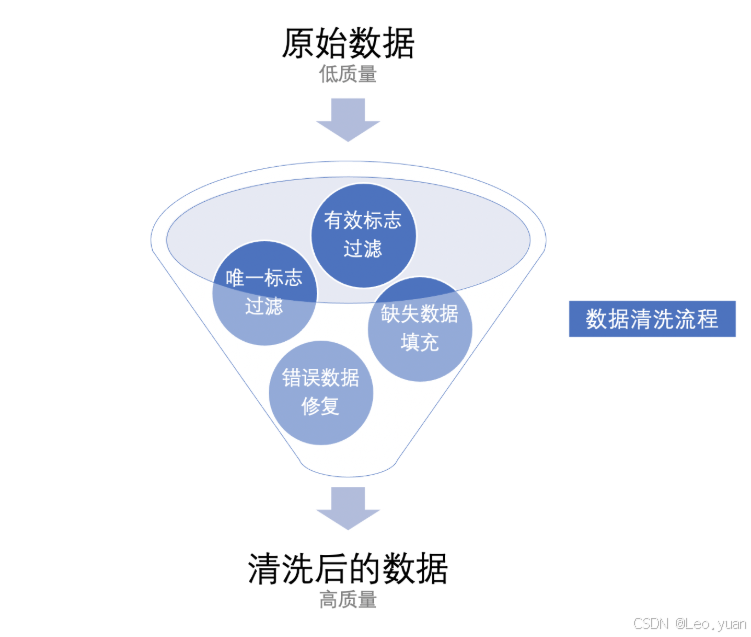

1.数据清洗

这绝对是数据处理的第一步,也是打基础的关键一步。简单来说,数据清洗就是给数据“洗澡”、“理发”、“治病”,把里面的“脏东西”(噪声)、错误、前后不一致的地方都清理干净,让它变得清清爽爽、准确无误。

- 去重:就是找出完全一样或者高度相似的重复记录,删掉多余的。为啥?数据重复了,不光占地方,分析起来效率也低,结果还可能被误导。比如客户信息库里有好几个一模一样的张三记录,不清洗掉怎么行?

- 处理缺失值:数据缺了一块(缺失值),这确实让人头疼。直接扔了?可能损失重要信息。不管它?分析结果可能不准。常见做法有几种:如果这条记录缺得太多或者关键信息缺了,可能就整条删掉;如果只是个别值缺了,可以用平均值、中位数这类有代表性的数来补上;更高级点,还能用一些预测模型(机器学习算法)来猜(预测)这个缺的值大概是多少。比如销售数据里某个产品的销售额漏记了,用这个产品过去的平均销售额填上,总比空着强。

- 修正错误:数据错了,可能是录入手滑,也可能是系统抽风。清洗工具能帮你检查、修正。检查日期是不是真的“年月日”格式、电话号码是不是11位数字、邮箱地址带不带“@”符号…这些校验规则一设,错误就难逃法眼。

数据清洗做好了,后面的分析才站得住脚。这一步偷懒,后面准后悔。

2.数据转换

原始数据的样子,不一定适合直接分析。数据转换,就是给它“变个身”,变成分析工具或者模型“爱吃”的格式。

- 数据标准化(归一化):想象一下,你有一堆数据,有的数值特别大(比如销售额几百万),有的特别小(比如用户评分1-5分)。直接放一起分析,大的会把小的“声音”盖住。标准化就是给它们调整到一个“音量”水平上(相同的尺度和范围)。比如在训练机器学习模型时,常用“z-score标准化”(减均值除以标准差)或者“最小-最大标准化”(缩放到0-1之间),这样不同特征的重要性才能公平比较。

- 数据离散化(分箱):把连续不断的数值,切成几段,归到不同的“箱子”里。比如年龄,0-18岁算“少年”,19-35岁算“青年”,36-60岁算“中年”,60岁以上算“老年”。收入也可以分成“低收入”、“中等收入”、“高收入”几档。这样做的好处是简化数据,让复杂的关系更容易看出来,也方便人理解。

- 数据编码:很多厉害的分析工具和算法,只认数字,不认文字(分类数据)。编码就是把文字标签变成数字。最常用的是“独热编码”和“标签编码”。独热编码比如把“颜色”这个属性,“红”变成[1,0,0],“绿”变成[0,1,0],“蓝”变成[0,0,1]。标签编码更简单,比如“男”编码成0,“女”编码成1(但要注意这可能会引入顺序误解)。说白了,就是给分类数据穿上数字马甲,让机器能看懂。

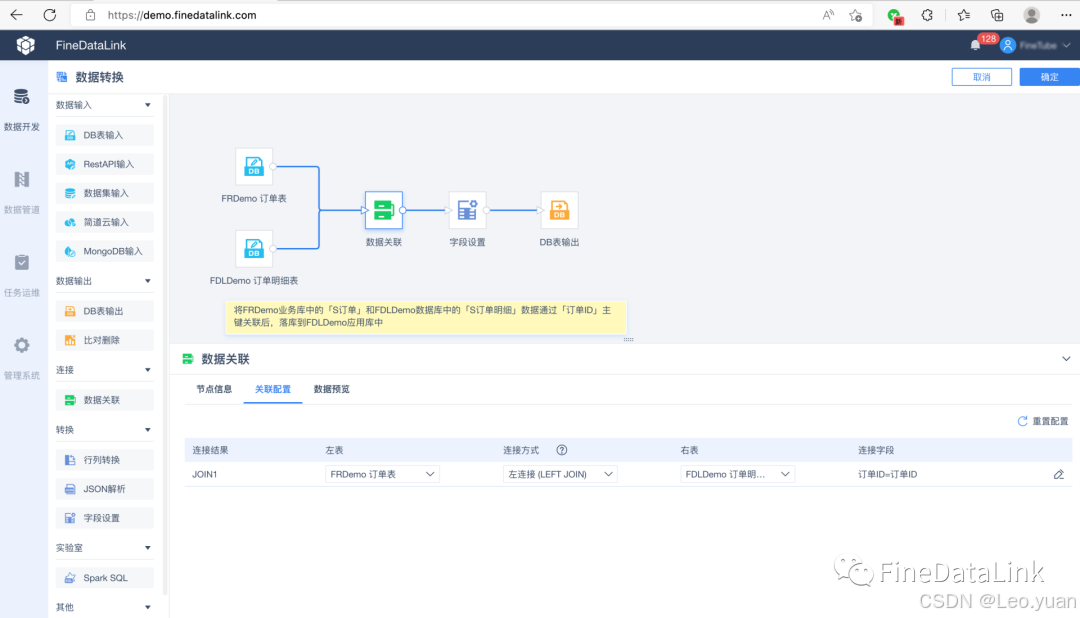

3.数据集成

企业里的数据,常常像散落的珍珠,藏在各个系统里:销售系统、财务系统、HR系统…各有各的数据库。数据集成,就是把这些散落的珍珠串成一条项链,汇集到一个统一的地方(比如数据仓库),方便你整体看、综合分析。

- 难点在哪?各个系统“方言”不一样!同一个客户,销售系统里叫“客户名称”,财务系统里可能叫“往来单位名称”;性别编码,A系统用“M/F”,B系统用“1/2”。这就是数据格式不一致、语义冲突。

- 怎么解决?需要“翻译”和“映射”。数据处理工具就是干这个的“翻译官”+“搬运工”。你配置好各个数据源(源头)和你的目标数据仓库(目的地),设定好规则:比如告诉工具,“客户名称”就是“往来单位名称”,“M”对应“1”(男),“F”对应“2”(女)。它就能按规则把数据准确地搬过来、转换好,集成到一起。这一步做好了,才能有全局视角。

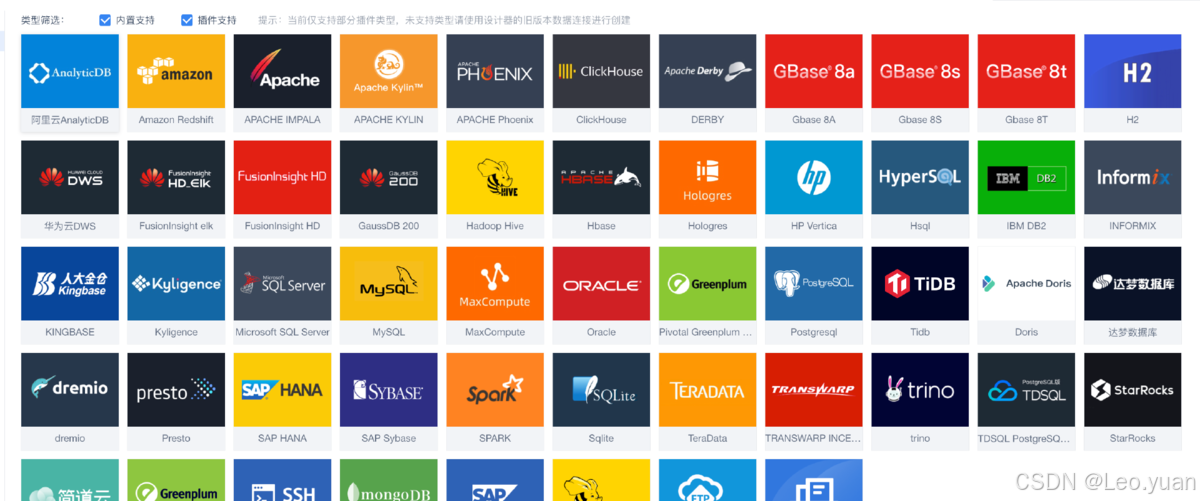

FineDataLink作为一款专业的数据集成与治理工具,在面向用户大数据场景下,可回应实时和离线数据采集、集成、管理的诉求,提供快速连接、高时效融合各种数据、灵活进行ETL数据开发的能力,帮助企业打破数据孤岛,大幅激活企业业务潜能,使数据成为生产力。这款实用数据集成工具的地址我放在这里了,感兴趣的可以立即体验:免费试用FDL

4.数据分析

前面洗也洗了、转也转了、集也集了,终于到重头戏——分析。数据分析就是拿着“放大镜”(当然不是真显微镜,咱们避免浮夸词)仔细看数据,找出里面的门道、规律和价值。常用方法不少:

- 描述性统计分析:这是最基础的“体检报告”。算算平均值(整体水平)、中位数(中间位置)、标准差(数据波动大不大)、最大值、最小值等等。比如分析班级考试成绩,平均分告诉你整体咋样,最高最低分体现差距,标准差反映成绩是集中还是分散。简单来说,就是让你快速了解数据的“身体状况”。

- 相关性分析:看看两个或多个变量之间,是不是“同进同退”。比如,你想知道广告费花得多,销售额是不是真的涨了?算个相关系数(比如皮尔逊相关系数),结果在-1到1之间。接近1,说明正相关(广告多卖得多);接近-1,说明负相关(广告多卖得少?这得警惕);接近0,说明没啥关系。这能帮你判断投入方向对不对。

- 回归分析:这比相关性更进一步,是要建立一个“公式”(数学模型),量化地描述变量之间的关系,还能用来预测。比如,建一个模型:销售额=a*价格+b*促销力度+c*…+常数。有了这个模型,你调整价格、加大促销,就能预测销售额大概会变多少。这是做精细化运营和预测的利器。

5.数据可视化

辛辛苦苦分析出来的结果,总不能还是一堆数字表格吧?那谁看得下去。数据可视化,就是把这些分析成果,变成一眼就能看懂的图表、图形。它能把数据里的故事,生动地讲出来。

- 常用图表各司其职:

- 柱状图/条形图:比大小(不同产品销量、不同地区销售额)。

- 折线图:看趋势(销售额随时间变化、用户增长曲线)。

- 饼图/环形图:看占比(市场份额、费用构成)。

- 散点图:看关系(广告投入和销售额的关系、用户年龄和购买金额的关系)。

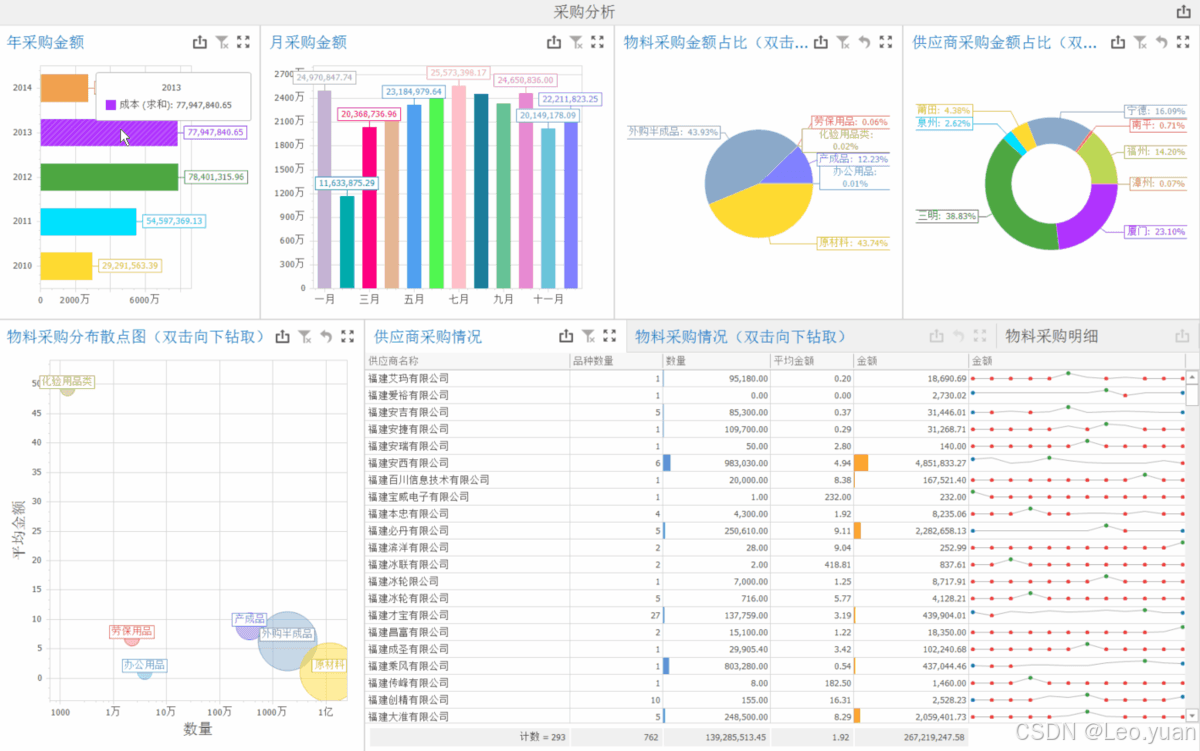

- 好工具让这事变简单:像FineBI这类数据可视化工具,能直接连上处理好的数据,点点拖拖,就能生成专业又美观的图表、仪表盘(Dashboard)。老板、业务部门一看就明白,决策起来自然更快、更准。可视化做得好,沟通效率翻倍。

三、数据处理工具的选择

工具这么多,选哪个好?别眼花,抓住几个关键点。

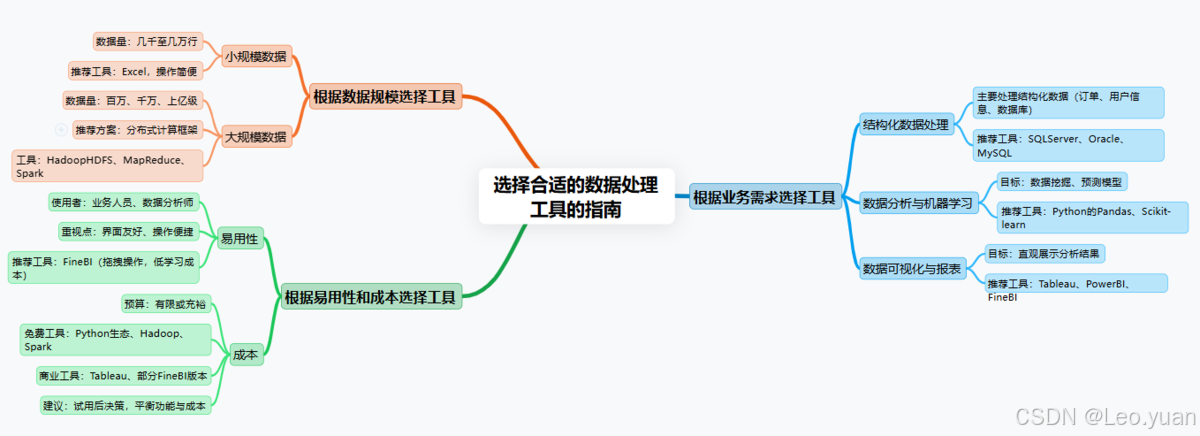

1.根据业务需求选

这是最根本的。企业要用工具解决什么问题?

- 主要处理数据库里规规矩矩的结构化数据(订单、用户信息等)?那像SQLServer,Oracle,MySQL这些专业数据库管理工具就很强,处理大量结构化数据是看家本领。

- 想搞数据挖掘、机器学习预测未来?那得选侧重分析的。Python里的Pandas(数据处理)、Scikit-learn(机器学习)这些开源库是首选,灵活强大,生态丰富。

- 目标是把分析结果直观漂亮地展示出来,做报表、看板?那就盯着数据可视化工具选,Tableau,PowerBI,FineBI都是这方面的佼佼者,交互体验好,图表美观。

2.根据数据规模选

数据量大小直接影响工具选型。

- 数据量小(比如就几千几万行),Excel其实挺够用,简单方便,人人都会点。别小看Excel,小规模数据处理它很能打。

- 数据量巨大(百万、千万、上亿级别),到了“大数据”范畴?那必须考虑分布式计算框架了。HadoopHDFS存数据,MapReduce/Spark来处理数据,它们专为海量数据而生,能利用多台机器并行计算,速度快。听着是不是很熟?现在谈大数据基本绕不开它们。

3.根据易用性和成本选

这两点很现实,尤其对中小企业。

- 易用性:使用者是谁?如果是业务人员、数据分析师(非专业程序员),那工具的易用性、界面友不友好就太重要了。像FineBI这种,主打可视化操作,拖拉拽就能完成很多数据处理和分析,学习门槛低。我一直强调,工具是给人用的,顺手最重要。

- 成本:预算多少?开源工具(Python生态、Hadoop/Spark等)免费,但可能需要更强的技术团队来折腾和维护。商业工具(Tableau,部分FineBI版本等)功能强大、服务好,但需要支付许可费用。企业得掂量掂量自己的钱包和技术实力,在功能和成本间找个平衡点。很多工具也提供免费试用版或基础版,用过来人的经验告诉你,先试用再掏钱,准没错。

四、数据处理过程中的注意事项

活儿干得好,细节不能少。处理数据时,这几个坑得绕着走。

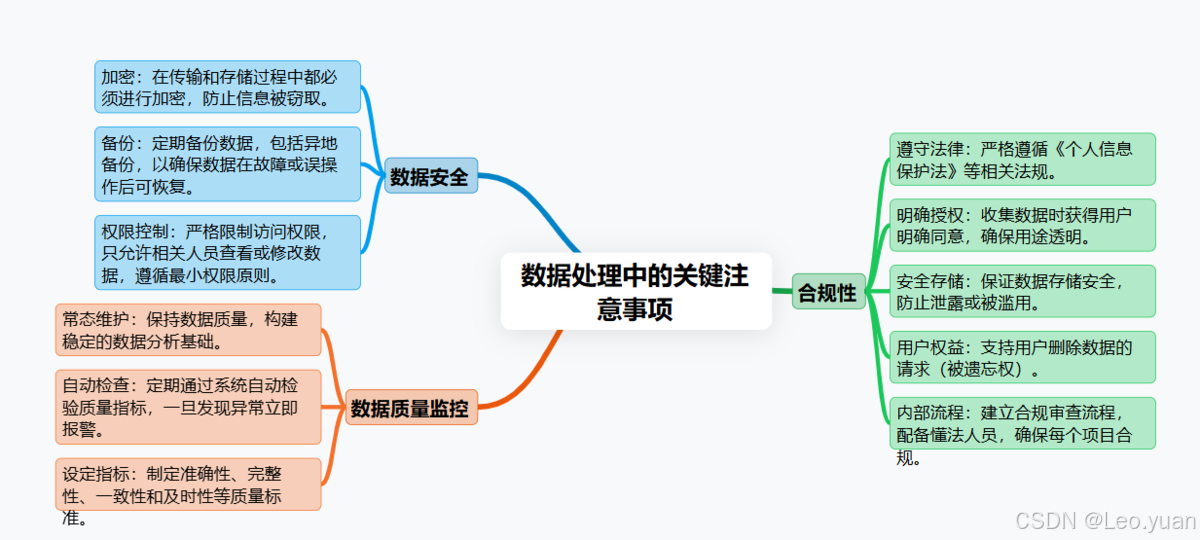

1.数据安全

这是头等大事!数据里往往有用户的身份证号、电话、地址,有公司的财务数据、核心策略。这些要是泄露了,后果不堪设想。

- 怎么做?

- 加密:数据在“路上”(传输)和“家里”(存储)都得加密,别让人轻易偷看。

- 权限控制:不是谁都能看所有数据!严格设定权限,谁只能看啥、能改啥,分清楚。最小权限原则是金科玉律。

- 备份:服务器坏了、手滑删了怎么办?定期备份数据,而且最好异地备份一份。真出事了,还能救回来。数据丢了,哭都来不及。

2.数据质量监控

清洗不是一锤子买卖。数据源在变,新数据在进来,质量可能还会波动。得持续盯着。

- 怎么做?定好数据质量的“尺子”:准确性(数据对不对)、完整性(数据全不全)、一致性(同一东西在不同地方是不是一个样)、及时性(数据新不新)等等。设定好规则,定期自动检查。一旦发现指标异常(比如突然多了很多空值、某个字段格式乱了),马上报警,赶紧处理。质量是分析的基石,基石不稳,大厦必倾。

3.合规性

现在数据监管越来越严,不能乱来。尤其是处理个人信息。

- 怎么做?必须遵守《个人信息保护法》等法律法规!核心是:收集数据要用户明确同意(别偷偷摸摸),用数据要符合当初说的目的(别挂羊头卖狗肉),存数据要安全(别被一锅端),用户有权要求删除他们的数据(被遗忘权)。企业内部得有懂法的人或者流程,对数据处理项目进行合规审查。不合规,罚起款来可不是闹着玩的,声誉损失更大。你懂我意思吗?

五、数据处理的发展趋势

这行变化快,了解下风向标。

1.自动化与智能化

未来工具会越来越“聪明”。AI和机器学习不是噱头,是真能落地到数据处理环节。

- 啥表现?比如,数据清洗规则能不能自动学习生成?异常值检测能不能更智能、更准?数据转换流程能不能根据目标自动推荐最优方案?甚至数据分析模型的选择、调参也能自动化。说白了,就是让机器干更多繁琐、重复、需要经验的活,把人解放出来去思考更重要的问题。这样效率更高,人为错误更少。

2.实时处理

“事后诸葛亮”越来越不够用了。业务要敏捷,决策要快,数据也得跟上。

- 啥表现?工具要能支持实时或近实时(秒级/分钟级)的数据采集、处理和分析。金融交易实时风控、工厂设备运行状态实时监控预警、电商网站用户行为实时分析推荐…这些场景下,等批量处理完黄花菜都凉了。实时数据流处理技术(如Flink,SparkStreaming)会越来越重要。

3.云化

上云是大势所趋,数据处理也不例外。

- 啥好处?

- 省钱:不用自己买一堆贵死人的服务器,按需租用云资源就行。

- 省事:硬件维护、基础软件升级这些破事,云服务商包了。

- 弹性好:业务高峰时需要更多算力?云上随时能扩。低谷期?缩回来省钱。灵活得很。

- 集成易:云平台本身就集成了各种数据存储、处理、分析服务,用起来更方便。中小企业尤其受益,门槛大大降低。

4.融合与集成

未来的工具,界限会越来越模糊,走向“全家桶”模式。

- 啥表现?数据从采集接入、到清洗转换、再到分析挖掘、最后可视化展现,最好能在一个平台上或者一套无缝衔接的工具链里完成。告别在不同工具间倒腾数据、转换格式的麻烦。比如,像FineDataLink做数据集成和基础处理,FineBI做分析和可视化,这种组合拳就体现了融合趋势。一站式的体验,效率提升不是一点半点。

总结

聊了这么多,核心就一点:数据处理工具是现代企业不可或缺的“数据炼金术士”。它能实实在在地提升数据质量、把埋藏在数据里的价值“炼”出来,让企业决策不再是拍脑袋,而是有据可依。数据清洗、转换、集成、分析、可视化,这些方法是它的核心“手艺活”。

选工具,别跟风,老老实实看自己的业务要解决啥问题、数据量有多大、用的人方不方便、预算有多少。在用的过程中,数据安全这根弦时刻绷紧,数据质量要持续盯着,法律法规的红线坚决不能碰。

往后看,自动化智能化让数据处理更省心,实时处理满足业务快节奏,上云是大方向降低门槛,工具融合集成提供一站式爽快体验。企业得睁大眼睛,跟上这些趋势,选对用好像FineDataLink这样的工具,才能真正把数据变成驱动发展的强劲引擎。说到底,用好数据,才能赢在未来。

Q&A常见问答

Q:数据处理工具难学吗?

A:这个真得看工具。像Excel这种,稍微有点电脑基础,摸索一下常用函数、数据透视表,基本就能上手干活了。但像要用Python写Pandas代码处理数据,或者玩转Spark,那肯定需要投入时间学编程思想和相关知识,门槛自然高一些。不过别怕,现在网上教程、视频课、社区问答多的是,只要肯花点功夫,入门到能用并不遥远。很多工具也提供了非常友好的图形界面(比如FineDataLink,FineBI),大大降低了技术门槛。

Q:数据处理工具的价格贵吗?

A:价格跨度非常大。

- 开源的(Python库、Hadoop/Spark等)完全免费,但可能需要自己多钻研或者有技术支持。

- 商业软件(比如Tableau,某些版本的FineBI)功能强大服务好,但需要支付许可费,价格从几千到几十万不等。

我的建议是:先明确需求,然后多看看。很多商业工具都有免费试用版、社区版或者针对小微企业的优惠套餐。先用起来,觉得值再考虑付费。别一上来就被价格吓退,也别盲目追求最贵的。

Q:数据处理需要专业的技术人员吗?

A:分情况看。

- 简单任务:用Excel做做汇总、排序、基础图表?普通业务人员学一学完全能胜任。

- 复杂任务:比如要搭建企业级数据仓库、处理TB/PB级大数据、构建预测模型做机器学习?这绝对需要专业的数据工程师、数据分析师甚至数据科学家出马。他们懂数据库、懂分布式计算、懂算法。

- 趋势是:工具越来越易用,很多过去需要写代码的活,现在通过可视化界面配置就能完成(像FineDataLink,FineBI的核心功能)。所以,非技术人员能做的数据处理范围在不断扩大。但核心的架构设计、复杂逻辑实现、模型开发等,还是离不开专业人士。团队协作是常态。