Weight decay 和 L2 Regularization

Weight Decay

weight decay是在参数更新规则中直接衰减权重即 θ←(1−ηλ)θ\theta \leftarrow (1-\eta \lambda)\thetaθ←(1−ηλ)θ

其核心思想在于对权重进行缩放,强制衰减。

L2 regularization

L2正则则是在损失函数上添加一项λ2∣∣θ∣∣2\frac{\lambda}{2}||\theta||^22λ∣∣θ∣∣2,其思想是通过优化带正则项的顺势函数,间接限制权重大小。

异同

两者在SGD算法中在形式上是等价的

这是由于L2正则的梯度刚好等于使用权重衰减的内容

L2正则的梯度

∇θ(Ldata+λ2∣∣θ∣∣2)=∇θLdata+λθθt+1=θt−η∇θ(Ldata+λ2∣∣θ∣∣2)=(1−ηλ)θt−η∇θLdata\nabla_{\theta}(L_{data} + \frac{\lambda}{2}||\theta||^2)=\nabla_{\theta}L_{data}+\lambda\theta \\

\theta_{t+1}=\theta_{t}-\eta \nabla_{\theta}(L_{data} + \frac{\lambda}{2}||\theta||^2) \\= (1-\eta\lambda)\theta_t -\eta \nabla_{\theta}L_{data}∇θ(Ldata+2λ∣∣θ∣∣2)=∇θLdata+λθθt+1=θt−η∇θ(Ldata+2λ∣∣θ∣∣2)=(1−ηλ)θt−η∇θLdata

这和权重衰减在形式上完全一致

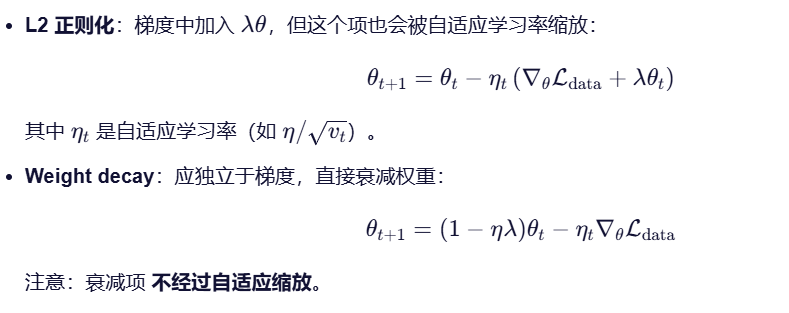

而在使用其他优化器如Adam、RMSProp、AdaGrad时,由于对学习率进行了缩放,所以两者并不一样。