Vibe Coding - MCP Feedback Enhanced(交互反馈 MCP)

文章目录

- Pre

- MCP Feedback Enhanced(交互反馈 MCP)

- 为什么需要它 / 背后动机

- 架构与实现

- MCP 基础回顾(作为前提)

- 核心组件与模块

- 交互流程 (典型调用路径)

- 与标准 MCP 的区别/增强点对比

- Cursor中配置

- 用例 / 应用场景

- 优缺点 / 挑战与风险

- 优点

- 缺点 / 限制

- 实践建议 / 使用指南

- 未来方向与思考

- 参考

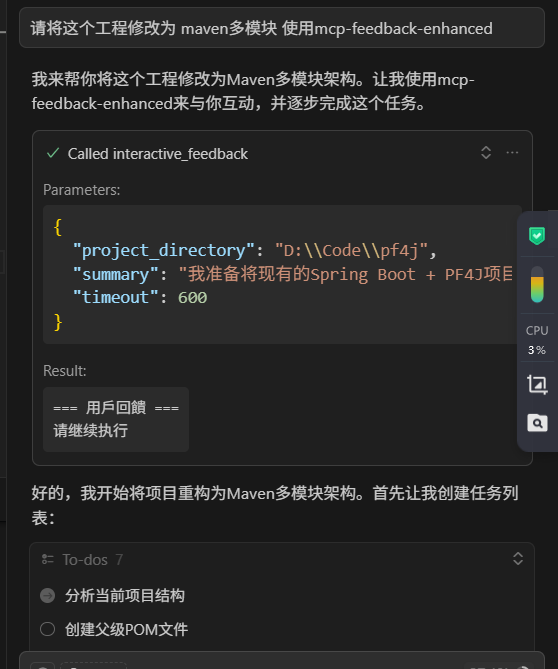

Pre

Vibe Coding - context7-mcp 和 server-sequential-thinking

MCP Feedback Enhanced(交互反馈 MCP)

“mcp-feedback-enhanced” 是一个以 Model Context Protocol (MCP) 为基础,强化“人机交互反馈”(Human-in-the-Loop / interactive feedback)机制的服务器/中间层组件。其核心目标是:在 AI(尤其是带工具调用能力的模型代理/助手)做出判断或执行操作之前,引入用户确认/澄清流程,从而减少错误、避免无谓工具调用浪费、提升交互质量。

GitHub 项目:Minidoracat/mcp-feedback-enhanced 。

在社区描述中,它经常被称作 “增强的交互反馈 MCP 服务器 (Enhanced Interactive Feedback MCP Server)”

简而言之:它是在标准 MCP 的基础上加了一层“中断 + 反馈确认 / 选项交互”的机制,以防 AI “擅自猜测”或 “盲目调用工具”。

为什么需要它 / 背后动机

要理解它的价值,我们先回顾一个常见问题:在 AI + 工具调用(例如辅助编程、自动化脚本)场景中,模型常常根据提示“猛干一通”——先调用工具、执行操作、生成代码或命令,可能偏离用户真实意图,甚至出错。每一次错误都可能浪费资源(API 请求次数、算力、用户时间)或造成不良后果(破坏环境、出错)。

引入一个“反馈中断点”(“在继续之前,向用户确认”)就能显著缓解这种风险。这样,AI 在执行重大步骤之前可以说 “请确认一下,你要我做 A 还是 B?” 或 “以下是我理解的目标,我执行 X,你看对不对?” ——用户给出反馈后,才继续。这个确认流程不会消耗新的主要 API 请求(因为它是一个工具调用,而不是完整的新对话),从而在效率和安全之间找到一个折中。

据社区和博客介绍,这种机制在 Cursor(一个带工具调用能力的 AI 编程辅助工具中)环境下尤其被看重:它可以将多次迭代/澄清过程压缩在一个请求周期里,从而“变相提升”API 请求数的利用效率。

用一句话概括:让 AI 多“问一句”,少“错一招”。

架构与实现

MCP 基础回顾(作为前提)

- MCP(Model Context Protocol) 是一种用于 AI 客户端与外部服务器/工具交互的标准(或规定机制)。通过 MCP,客户端(如 Cursor、Claude、Cline 等)可以把“工具调用”、“资源查询”、“提示模板”等能力暴露给模型,而模型可以通过 MCP 接口发起调用、接收结果等。

- 在传统 MCP 流程中,模型若要调用工具,会发出一个工具调用指令(tool call),由服务器处理后返回结果给模型,然后模型在对话中继续。

- 这种机制允许模型在回答中混合 “自然语言 + 工具调用结果” 的能力,是许多 AI Agent / 区域扩展系统的基础。

mcp-feedback-enhanced 基于这个基础,引入“交互反馈工具 (interactive_feedback)”作为其中一个 MCP 工具,以在关键点暂停执行、收集用户反馈、再继续。

核心组件与模块

从阅读项目及文档,可以提炼出以下主要模块 / 角色:

| 模块 / 角色 | 作用 / 职责 |

|---|---|

| MCP Server 主体 | 启动 MCP 接口,监听客户端 (AI agent) 的请求与工具调用。 |

| interactive_feedback 工具 | 提供一个机制:模型发起这个工具调用时,服务器弹出反馈 UI(或通过 WebSocket/界面)让用户输入/选择反馈内容,返回给模型。 |

| UI 界面层(双界面) | 提供 Web UI + 本地桌面界面(基于 Tauri / Qt / Web 前端等)支持用户交互。文档里提到支持 Web 和 Desktop(Windows / macOS / Linux)双模式([GitHub][1])。 |

| 会话管理 / 跟踪 | 对话历史、反馈记录、工具调用历史、会话上下文保持、反馈统计等。 |

| 环境适配 / 智能检测 | 根据运行环境(是否 WSL、SSH 远程、GUI 可用性等),智能选择启动界面、自动打开浏览器、切换模式等。文档中提到 “WSL 完整支持 / 自动启动 Windows 浏览器” 是一个特性([GitHub][5])。 |

| 提示 / 模板嵌入 | 在工具描述(tool docstring)或提示里嵌入交互指令(即模型如何调用 interactive_feedback),以及如何解释反馈流程。社区里看到有 PR “add prompt instructions into tool docstring”([GitHub][6])。 |

| 错误 / 异常处理 & 回退 | 如果 feedback 中断流程失败(如界面异常、序列化错误、超时没反馈),系统需要有回退策略。GitHub issues 中有人提到 “Image 序列化错误” 是目前的一个 bug 问题([GitHub][7])。 |

交互流程 (典型调用路径)

下面是一个简化的流程示意:

- 用户在 AI 客户端(如 Cursor)下达一个复合指令/请求,比如 “帮我把这个代码重构 + 加注释 + 写单元测试”。

- AI 模型解析后,需要做多个步骤/调用多个工具(重构工具、测试工具等)。在某个关键节点,它不确定应该先做哪个分支、或者参数如何设定,就调用

interactive_feedback这个 MCP 工具,发送一个结构化请求(包含当前理解、候选选项、补充说明等)。 - MCP Server 接收到这个调用,打开 UI 或界面给用户(可能是一个弹窗、Web 页面、命令行提示等),展示模型的理解、给几个选项(或自由输入),用户进行确认/修改/补充指令。

- 用户提交反馈后,MCP Server 返回给客户端/模型。模型收到反馈后,继续执行后续工具调用或生成最终输出。

- 若还需要进一步反馈,也可以再次调用

interactive_feedback多次,直到没有更多反馈为止。模型再最终 conclude(结束任务)。 - 全部过程是一个会话,记录在历史里;工具调用、反馈循环、环境状态等都被管理和维护。

优点在于:多次澄清不必每次都开启新的主请求;错误降低;交互更清晰。

与标准 MCP 的区别/增强点对比

- 标准 MCP 通常只有工具调用 + 结果返回,没有“中断 / 人为干预”机制。

- mcp-feedback-enhanced 在工具层面引入交互反馈机制,使得流程更可控、更安全。

- 提供 dual UI 支持、环境智能适配、会话管理、反馈统计等“工程化”能力,这些在基础 MCP 实现中可能是薄弱或缺失的。

- 将反馈机制作为核心工具(而不是外挂),让模型 Prompt / 规则层能天然调用它。

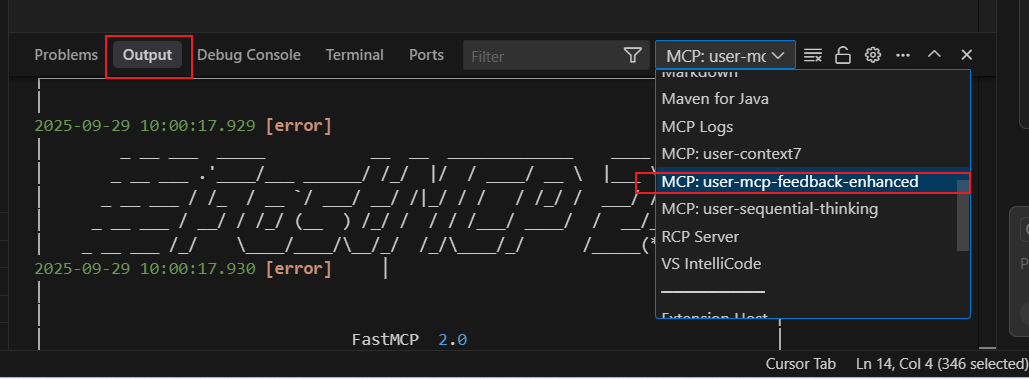

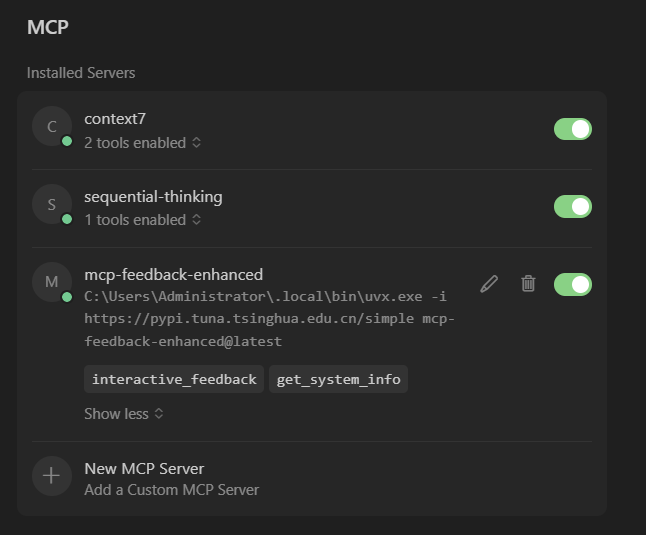

Cursor中配置

"mcp-feedback-enhanced": {"command": "C:\\Users\\Administrator\\.local\\bin\\uvx.exe", // 建议在环境变量中,直接使用 uvx "args": ["-i","https://pypi.tuna.tsinghua.edu.cn/simple","mcp-feedback-enhanced@latest"],"timeout": 600,"env": {"FORCE_WEB": "true","MCP_DEBUG": "true" },"autoApprove": ["interactive_feedback"]}

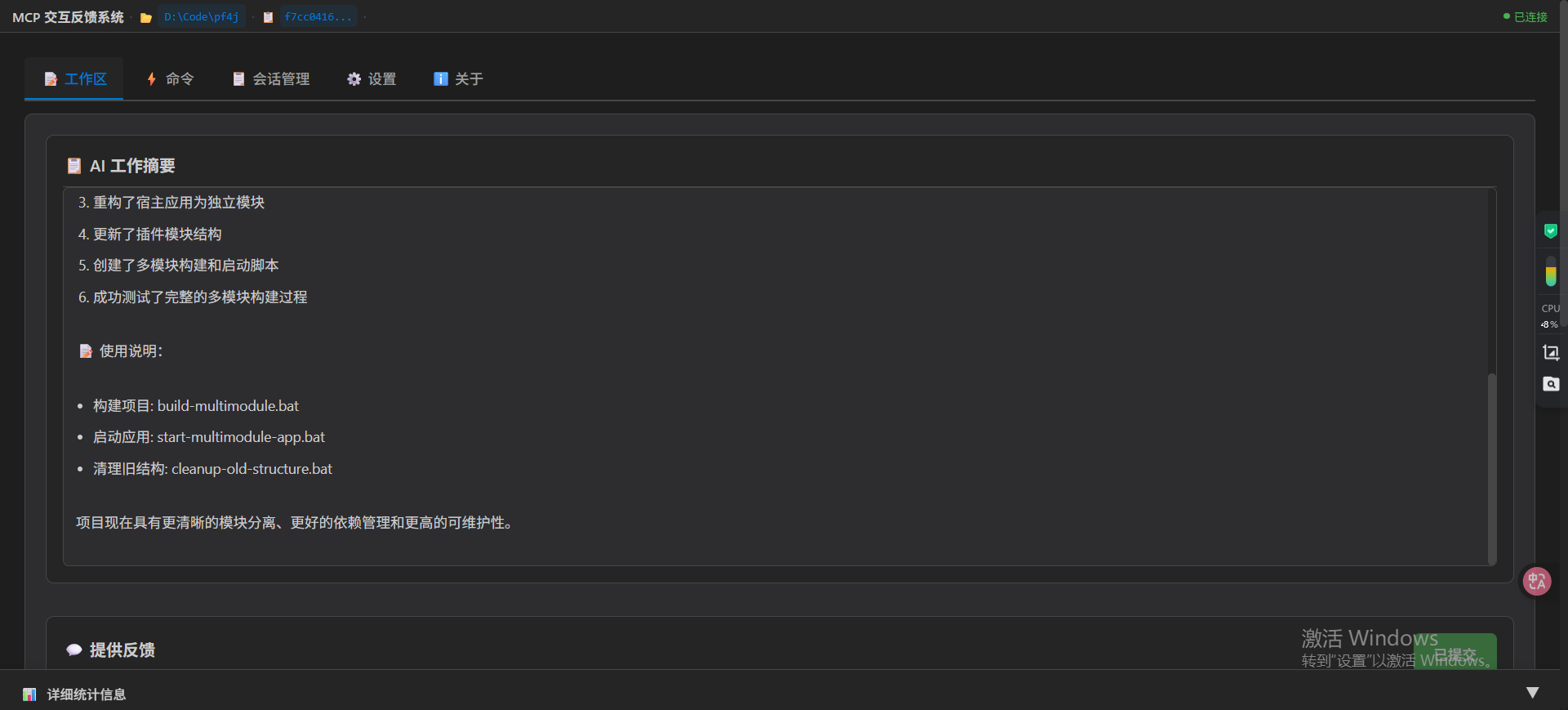

观察输出

最终如下:

用例 / 应用场景

下面是几个典型场景,展示 mcp-feedback-enhanced 能派上用场的地方:

-

AI 辅助编程 / 代码生成

在 “写函数 + 测试 + 重构” 这类复杂指令里,AI 在每个阶段可以 ask user 决定参数、风格、是否拆模块、命名规则等。避免 AI 一条路走到底然后偏离预期。 -

自动化运维 / 脚本执行

如果 AI 要生成并执行 shell 脚本或 infrastructure 操作(如创建资源、删表、迁移数据),在执行之前 ask 确认关键步骤,减少误操作风险。 -

数据处理 / ETL 流程构建

在清洗、转换、映射等环节,模型在遇到歧义(字段映射规则、异常处理逻辑)时可以调用反馈机制让用户确认规则。 -

文档 / 配置生成

在生成配置文件、YAML、CI/CD pipeline 脚本时,如果遇到多个选项(例如 “是开启缓存还是关闭”,“部署在哪个环境”),可以中断询问。 -

辅助调试 / 交互式流程

当 AI 在推理过程中可能犯错、模型不确定时,可以 ask user 请选择下一步操作而不是胡乱猜。

社区里就有关于 “在 Cursor 中用 mcp-feedback-enhanced 把 500 次额度“虚拟放大””的讨论——即用澄清机制降低无用调用,从而把有限请求“用得更细致” 。

在 Reddit、Cursor 论坛等,也有人评价:

“MCP Feedback Enhanced: Adds better structure to the feedback loop. It gives more actionable suggestions when reviewing code”

优缺点 / 挑战与风险

任何技术都有两面性。下面我列出这个方案的优点、局限、以及潜在风险。

优点

- 更高的控制力与安全性:关键步骤前有用户确认,减少误操作或错误输出。

- 资源节省 / 效率提升:避免 AI 因错误或猜测浪费额外完整请求(在限额场景下尤为关键)。

- 用户体验更“可对话”:AI 不再像独裁“我做了什么你看着吧”,而是先跟你确认意图再行动。

- 适应复杂任务:在复杂、多分支的任务中,澄清机制让模型能逐步推进,而不是一次性给大结果。

- 跨环境支持:支持 Web UI + 本地桌面(跨平台),环境适配(如 WSL 支持) 。

缺点 / 限制

- 增加交互延迟 / 需要人为等待:每次反馈确认都要用户介入,这在一些快速自动化任务里可能成为瓶颈。

- 界面 / 交互稳定性依赖性:如果 UI 异常、网络不通、序列化失败(例如图像序列化问题)就可能中断流程。GitHub 上就有关于 “Image 序列化错误” 的 issue 报告([GitHub][7])。

- 用户负担:如果反馈点设置过多、频率太高,就可能让用户疲劳。

- 模型与 Prompt 设计复杂度提升:模型要知道何时调用

interactive_feedback、如何构造选项、如何处理用户反馈、如何继续推进。Prompt 设计要更精细。 - 状态管理 / 上下文复杂:要在多个反馈环节里维系上下文、工具调用历史、回退逻辑、错误处理等,这对实现带来复杂度。

- 兼容性 / 客户端支持要求:需要客户端(如 Cursor、Claude 或其他 LLM 客户端)支持调用 MCP 工具、中断机制、工具列表更新等。若客户端不完全支持,就可能功能受限。社区就有 “Cursor 在工具列表变更通知 / roots support” 等与 MCP 集成的讨论与缺口 。

实践建议 / 使用指南

下面是一些在实际使用 / 集成 mcp-feedback-enhanced 时的建议(带坑与对策)。

-

明确哪些步骤需要反馈

不要每一步都 ask 用户,而是对可能产生歧义、风险大、或选择空间多的关键节点做反馈。可以在 Prompt 里设计 “如果不确定,就调用 interactive_feedback” 的规则。 -

设计合理的反馈模板 / 选项

给用户提供几个选择 + “自定义输入” 通道。避免让用户在自由文本里盲目写。模板要清晰、简洁。 -

设置超时 / 默认行为

如果用户长期不反馈,系统应该有默认行为或超时退回机制(例如继续执行、回滚、报错中断)。 -

错误 / 回退策略

UI 异常、通信失败、序列化失败时,要有 fallback 路径(如继续执行、日志报警、重试机制)。 -

记录反馈历史 / 统计分析

把用户反馈、分支选择、工具调用成功率等记录下来。这样可以优化触发点、模板、交互频率。 -

逐步引入 / 增量改造

在已有 MCP 基础或 AI Agent 中,建议先在少数“高风险、易错”场景中加入反馈机制,逐步扩展。不要一上来在每一步都中断。 -

客户端 / 环境兼容测试

在不同环境下(本地、远程、WSL、SSH、无 GUI 环境)验证反馈 UI 是否能正确启动/通信。文档里提到其支持 WSL 自动启动浏览器功能([GitHub][5]),但也可能有边缘环境失败。 -

Prompt / 模型设计配合

模型 Prompt 要加规则:在歧义或可选项较多时优先调用 interactive_feedback,而非盲目继续。Prompt 模板里可以写成 “如果对下一步不确定,则先调用 interactive_feedback 工具获取用户指令” 之类的格式。 -

监控与用户体验优化

通过反馈历史与用户反应,调整中断点、选项设计、交互频率,以避免用户疲劳。

未来方向与思考

技术的边界总在变,这里是几个值得思考 / 探索的方向:

-

自动化反馈建议

模型可以根据历史反馈数据、上下文相似性,预测用户最可能的选择,自动推荐选项,减少用户操作。即半自动反馈。 -

反馈模板自适应 / 学习

根据用户行为自动调整反馈模板(哪些选项常被选、哪些没用)或中断频率,让系统“学会少问”。 -

更复杂的反馈形式

不仅是文字/选项,还可以是图形界面、可视化对比、差异预览(例如 “变更前 / 变更后”图)让用户快速确认。 -

团队 / 协作模式支持

在多用户/协作环境下,反馈可能涉及多人意见(例如代码 review、配置审批等)。mcp-feedback-enhanced 可以扩展为支持多人反馈、审批流程。 -

跨客户端 / 跨模型兼容性增强

让更多客户端(IDE 插件、Web Agent、Terminal Agent 等)原生支持这种中断式反馈机制;以及支持更多模型 / agent 框架(如 LangChain + MCP 接口桥接)融合。 -

安全 / 权限控制

在反馈工具中加入权限控制(谁可以确认、是否可跳过、审计记录等),防止滥用。还要注意 prompt injection 之类的攻击风险。 -

反馈感知优化

模型可以主动“感知”用户反馈历史,在交互中避免重复发问或已知偏好冲突。

参考

https://github.com/Minidoracat/mcp-feedback-enhanced/blob/main/README.zh-CN.md