【论文阅读】π0:用于通用机器人控制的视觉-语言-动作流模型

Physical Intelligence 推出的 π0 模型引入了一个视觉-语言-动作(VLA)流模型,用于跨多样化操作任务和机器人平台的通用机器人控制。该模型利用大规模预训练和流匹配方法进行动作生成,在各种机器人任务中实现了卓越的零样本性能和高效的微调。

简介

开发能够执行各种任务的机器人一直是机器人领域长期存在的挑战。传统方法通常需要为单个任务训练专门的策略,从而导致泛化能力有限,并且每项新能力都需要大量数据。π0(发音为“pi-zero”)模型通过创建一个通用机器人控制系统来解决这些限制,该系统能够跨不同的机器人平台执行各种操作任务。

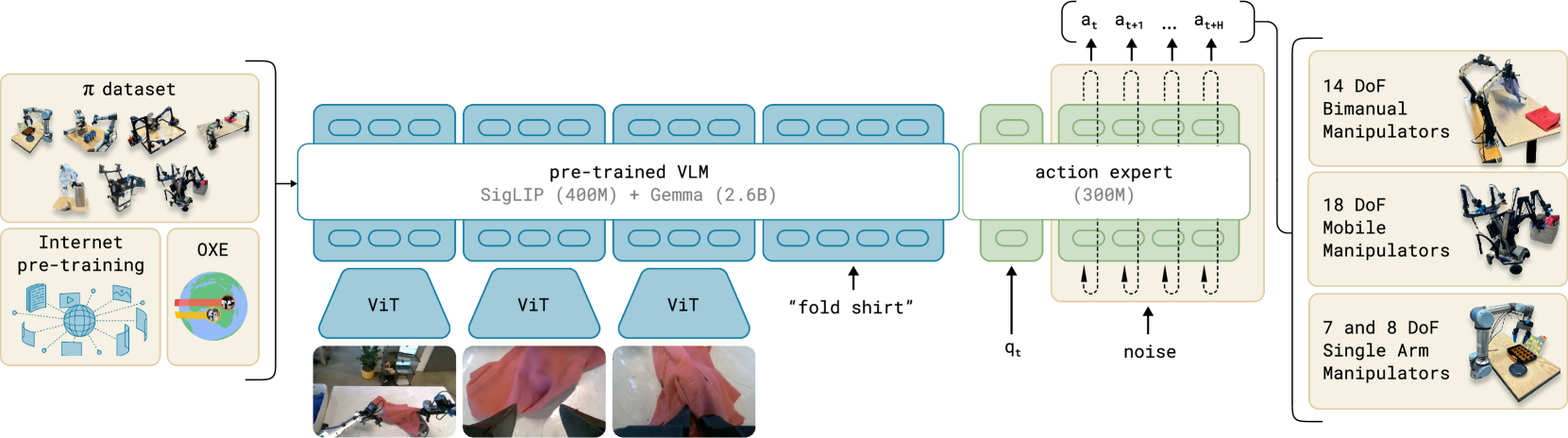

图 1:π0 模型架构,展示了预训练的视觉-语言模型(VLM)骨干网络如何处理视觉输入和语言指令,并通过动作专家模块生成机器人动作。

π0 由 Physical Intelligence 开发,是一种视觉-语言-动作(VLA)流模型,集成了视觉感知、自然语言理解和机器人控制。该模型利用大规模、多样化的数据集进行预训练,以开发可泛化的技能,使其能够执行复杂的操作任务并遵循自然语言指令,而无需针对特定任务进行工程设计。

模型架构

π0 的架构建立在视觉-语言模型(VLM)的最新进展之上,并将其扩展到机器人动作生成。该模型由两个主要组件组成:

视觉-语言骨干网络:基于 PaliGemma,一个预训练的 VLM,用于处理视觉输入和语言指令。该骨干网络利用来自 SigLIP 预训练的 4 亿张图像和来自 Gemma 语言模型的 26 亿个 token。

动作专家:一个专门的模块,将视觉和语言表示转换为机器人动作。该组件在大约 3 亿个参数上进行训练,并使用流匹配来生成适用于机器人控制的连续动作分布。

该架构旨在处理各种机器人形态和控制类型,从双手机械臂的位置控制到移动机器人的速度控制。通过建立在预训练 VLM 的强大基础上,π0 继承了通过互联网规模预训练开发的语义理解能力,同时将其扩展到控制物理系统。

预训练与数据收集

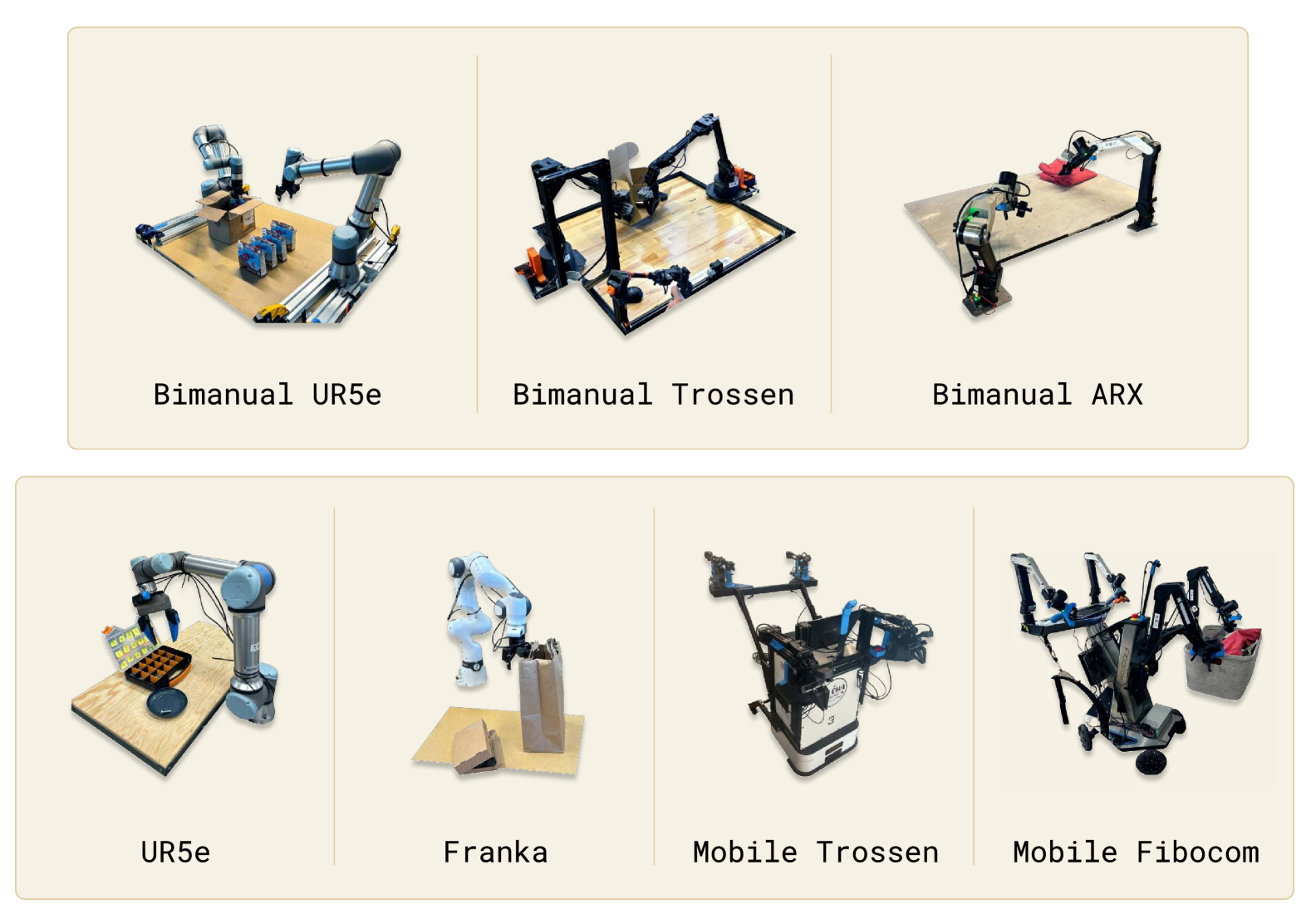

π0 的关键贡献之一是在多样化的机器人操作数据上进行大规模预训练。研究人员收集了超过 10,000 小时的演示数据,涵盖多个机器人平台和任务。该数据集包括:

- 7 种不同的机器人配置,具有不同程度的自由度(7-18 个自由度)

- 68 个不同的任务,范围从简单的拾取和放置到复杂的多阶段操作

- 不同的形态,包括双手机械臂、单臂机械臂和移动机械臂

图 2:π0 预训练中使用的各种机器人平台,包括双手机械臂(顶行)以及单臂和移动机械臂(底行)。

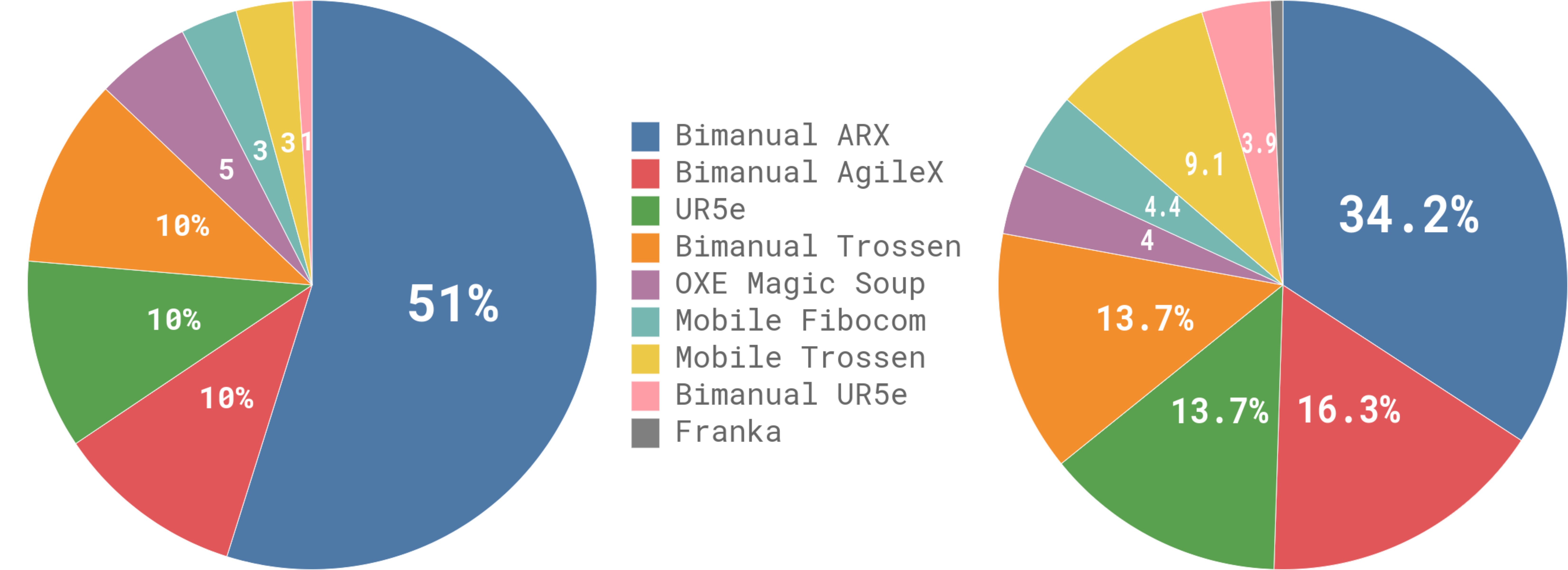

下图显示了机器人平台上预训练数据的分布,突出显示了对双手 ARX 机器人的重视(占数据的 51%),同时保持了其他平台的重要代表性:

图 3:预训练数据在不同机器人平台(左)和任务类型(右)之间的分布。

预训练数据集通过公开可用的机器人数据集(如 OXE (Open X-Embodiment))进一步扩充,以增加多样性。这种专有数据和开源数据的结合使 π0 能够接触到广泛的任务、实体和视觉环境,从而实现更好的泛化。

用于动作生成的 Flow Matching

π0 的一项重大创新是使用 flow matching 进行动作生成。与传统的确定性策略或基于扩散的方法不同,flow matching 为机器人控制提供了几个优势:

连续动作分布:Flow matching 直接对复杂的连续分布进行建模,这对于需要精确操作的机器人任务至关重要。

高效采样:与需要多次迭代步骤的扩散模型不同,flow matching 可以通过更少的步骤有效地采样动作,使其更适合实时机器人控制。

训练稳定性:与 GAN 或 VAE 等替代方案相比,Flow matching 表现出更稳定的训练动态。

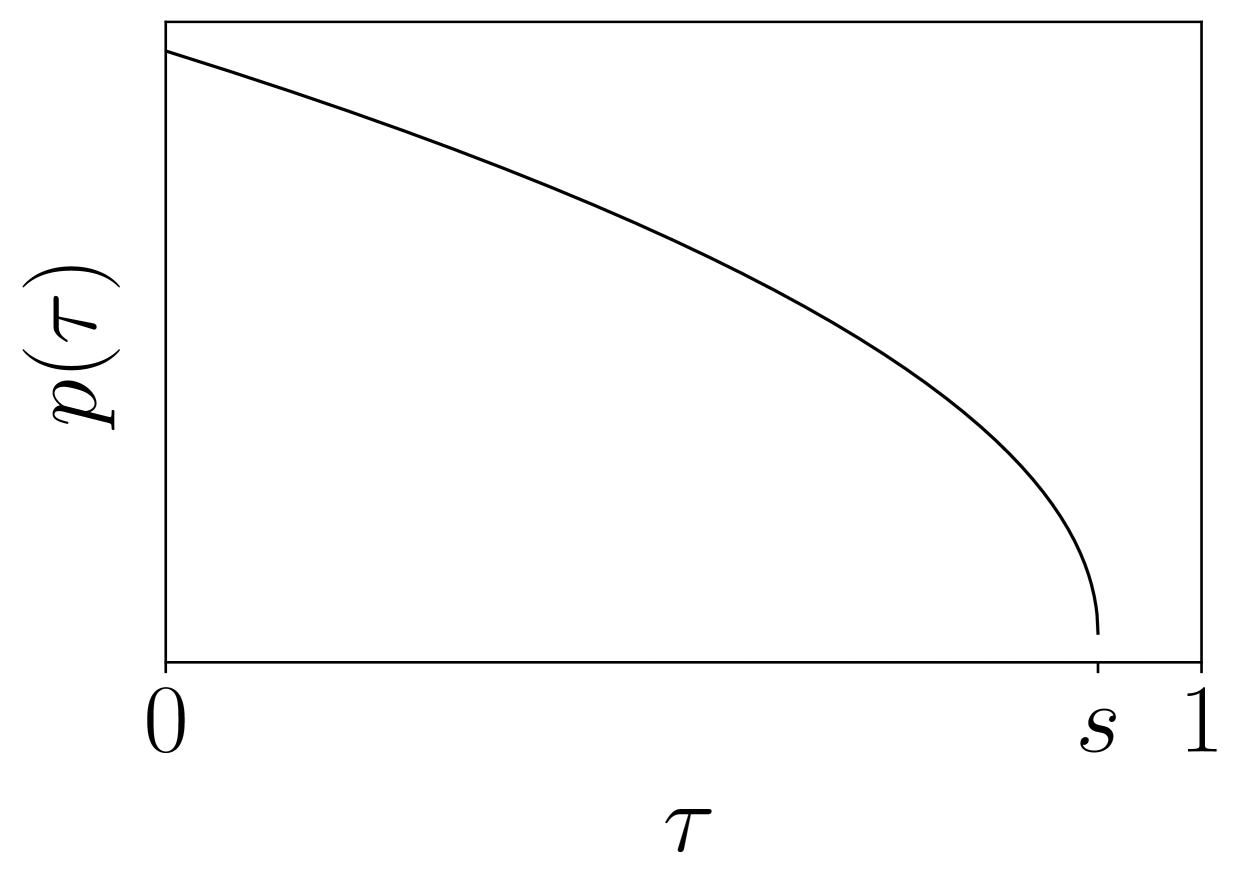

flow matching 过程可以用数学方式表示为:

Flow matching 的工作原理是通过学习将一个简单的基础分布(例如,标准正态分布)通过连续时间流转换为复杂的目标分布(机器人动作)。这是通过学习引导转换的向量场来实现的:

$$\frac{d\mathbf{x}(t)}{dt} = \mathbf{v}(\mathbf{x}(t), t)$$

其中 $\mathbf{v}$ 是学习到的向量场,$\mathbf{x}(t)$ 表示转换过程中时间 $t$ 的状态。

图 4:Flow matching 的概念图,展示了概率分布 p(τ) 如何随着时间从 τ=0 处的简单分布演变为 τ=1 处的复杂目标分布。

这种方法允许 π0 生成能够解释机器人控制问题多模态性质的动作,其中对于给定的情况可能存在多个有效的动作。

跨实体学习

开发通用机器人策略的一个主要挑战是处理不同的机器人实体,每个实体都具有独特的运动学、动力学和动作空间。π0 通过跨实体学习来解决这个问题,其中单个模型被训练来控制多个机器人平台。

该模型学习从视觉和语言输入映射到每个机器人类型的适当动作。这是通过以下方式实现的:

标准化动作表示:动作以跨机器人的一致格式表示,同时保留平台之间的基本差异。

机器人特定上下文:有关当前机器人平台的信息通过视觉上下文提供给模型。

在多样化实体上训练:通过在多种机器人类型的数据上进行训练,模型学习识别每个实体的相关模式。

这种方法使 π0 能够在机器人之间转移技能,并推广到不同平台上的新任务。例如,在双臂机械手上学到的技能可以为移动机械手上的行为提供信息,即使物理配置差异很大。

评估 π0 的能力

研究人员从三个主要维度评估了 π0:

零样本性能:模型在没有任何特定任务微调的情况下,执行任务的能力如何?

微调效率:模型使用有限的特定任务数据适应新任务的速度有多快?

语言跟随:模型遵循自然语言指令的效率如何?

评估包括与几种基线方法的比较:

- OpenVLA:另一个用于机器人控制的视觉-语言-动作模型

- Octo:一个最近的机器人基础模型

- 任务特定模型:从头开始为各个任务训练的模型

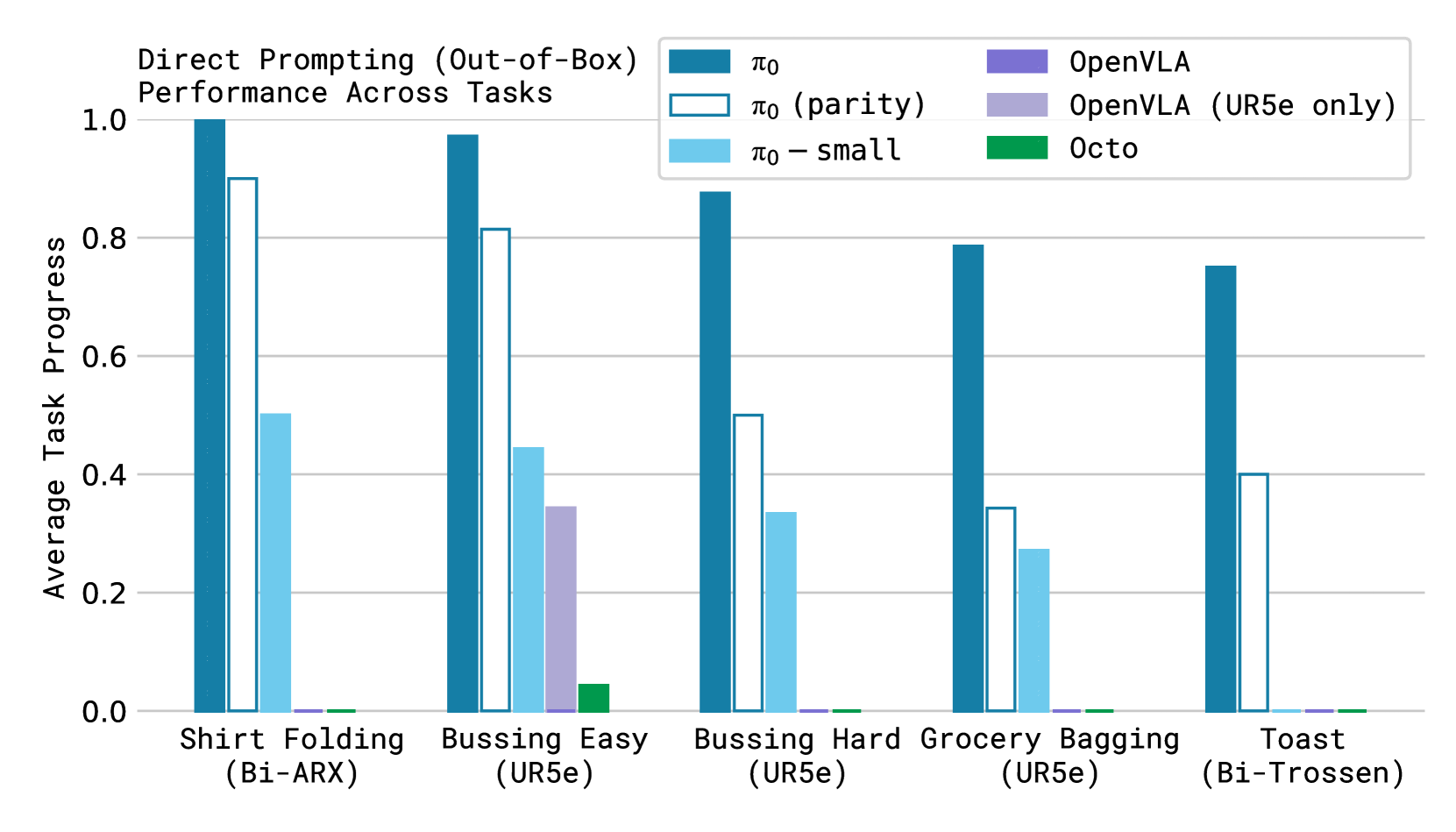

结果表明,π0 在零样本评估中显著优于其他方法,如下图所示:

图 5:跨不同任务和模型的零样本性能比较,显示了 π0 相对于 OpenVLA 和 Octo 等基线方法的卓越能力。

对于像叠衬衫这样的复杂任务,π0 开箱即用地实现了 100% 的成功率,而竞争模型的性能接近于零。这证明了 π0 的预训练方法和动作生成机制的有效性。

微调性能

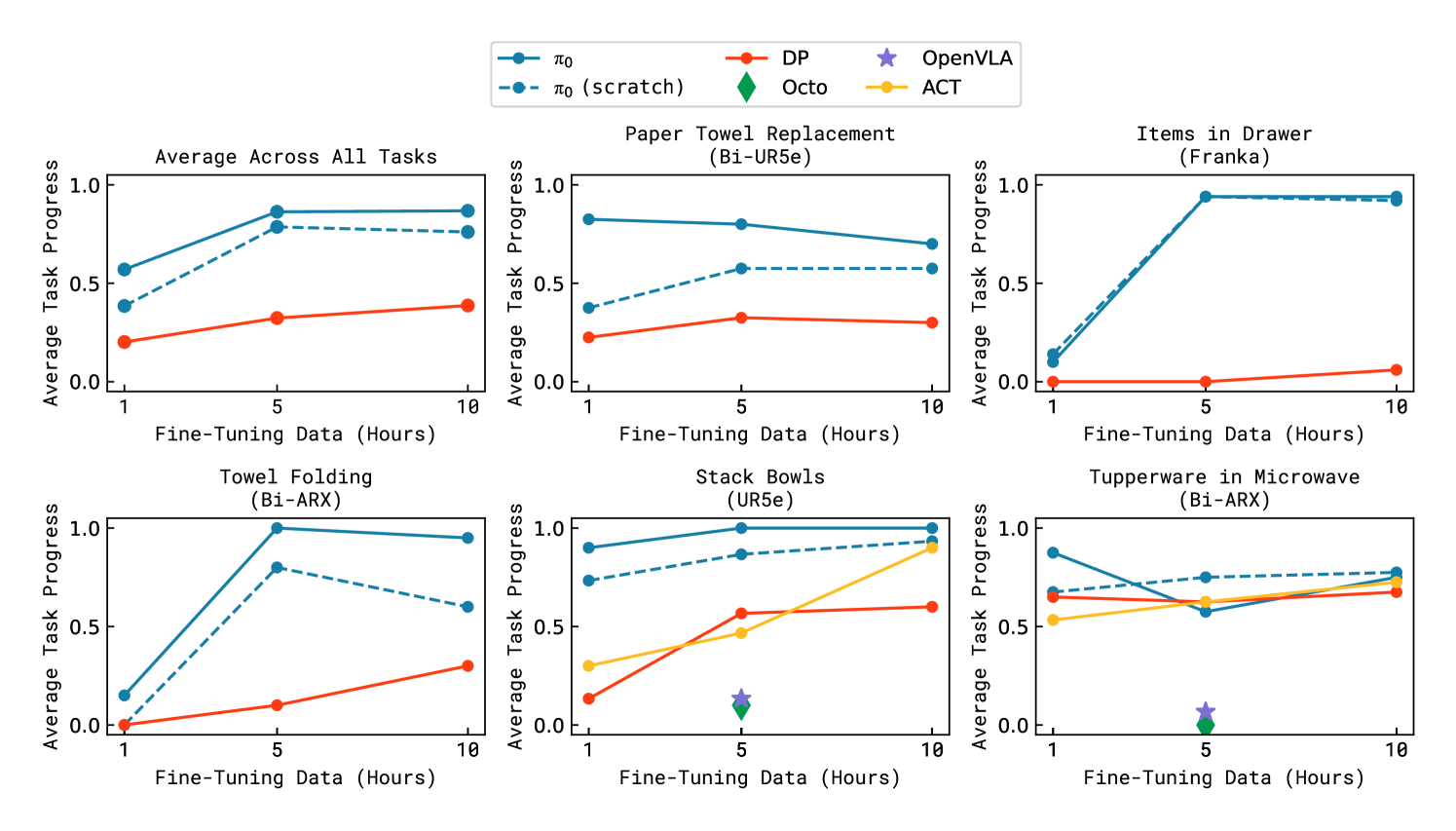

该论文还研究了 π0 在有限数据的情况下,对新任务进行微调的效果。结果表明,π0 的微调效率高于从头开始训练的模型,需要更少的数据来实现高性能:

图 6:在不同任务和不同数量的任务特定数据下的微调性能。π0 始终优于其他方法,尤其是在数据有限的情况下(1-5 小时)。

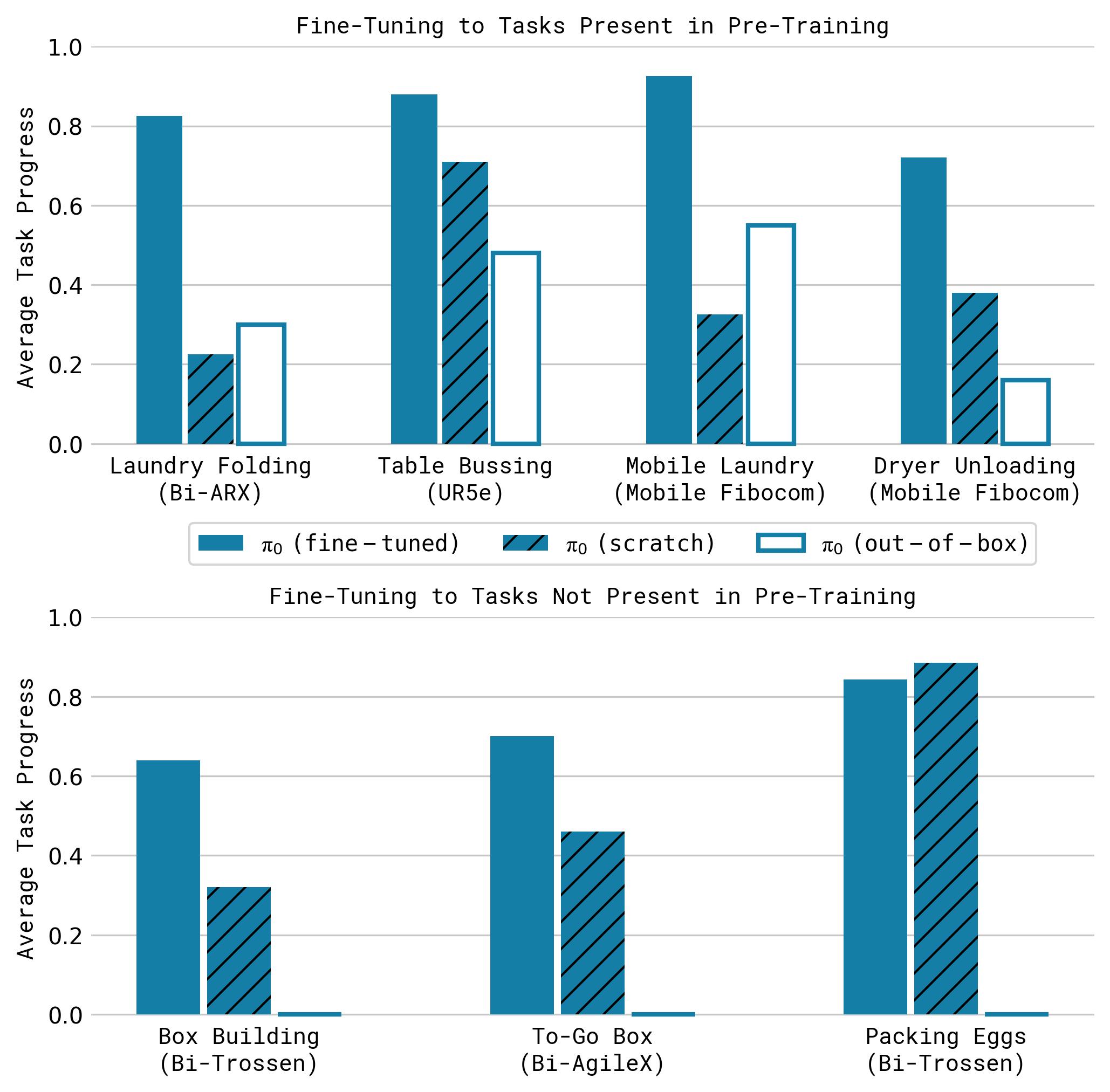

当微调到与预训练数据集中相似的任务时,预训练的优势尤其明显:

图 7:在预训练中存在的任务(顶部)与预训练中不存在的任务(底部)上的微调性能。π0 对于熟悉的任务类型表现出更强的预训练优势。

这些结果突出了多样化预训练数据对于开发通用机器人策略的重要性。当微调到与预训练中相似的任务时,π0 表现出显著的性能优势,同时对于新任务仍然优于基线(但优势较小)。

语言跟随能力

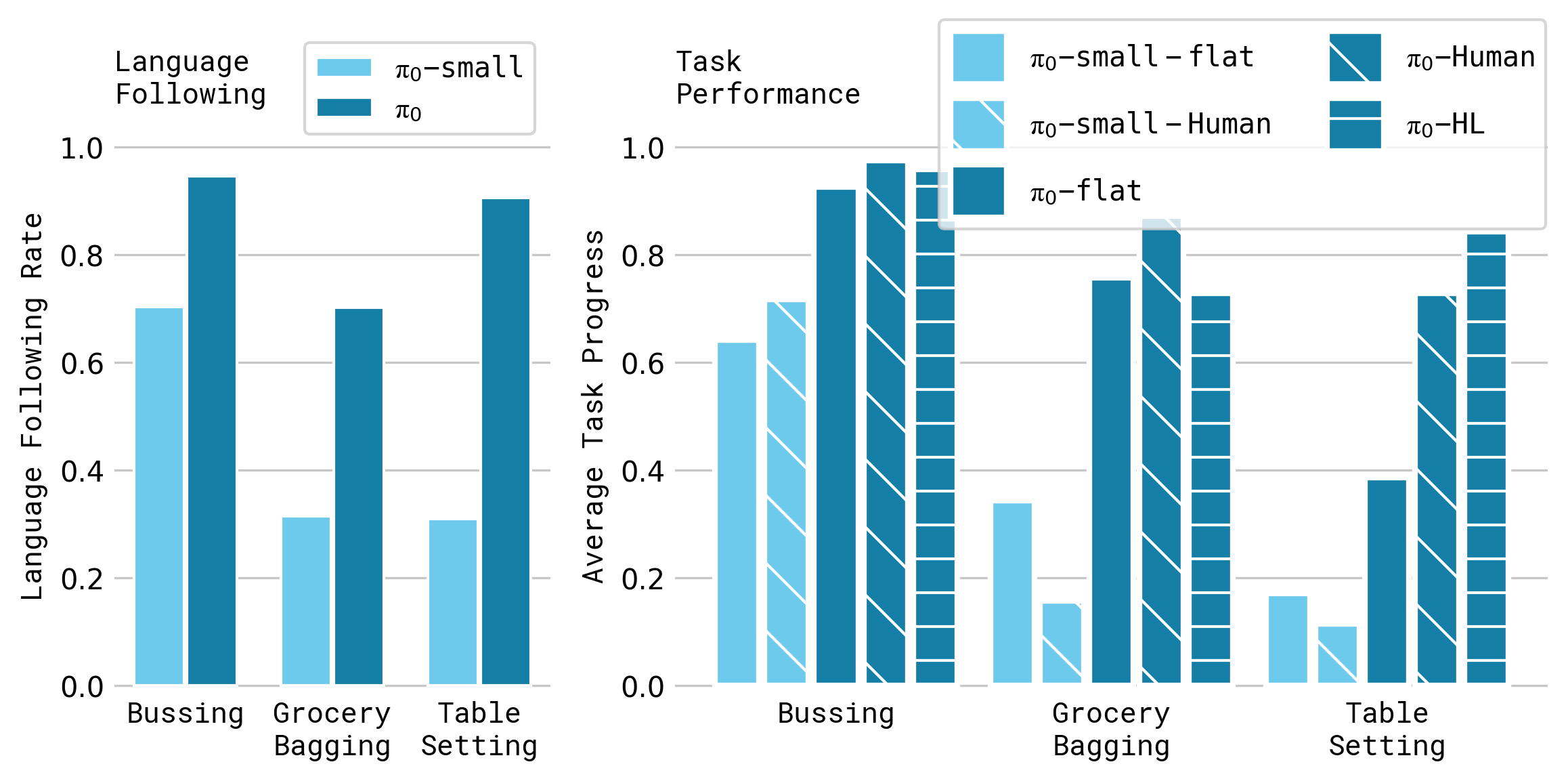

π0 的一个关键方面是它能够遵循自然语言指令,从而实现更直观的人机交互。研究人员在各种任务中评估了这种能力:

图 8:跨不同任务和模型变体的语言跟随能力(左)和任务性能(右)。π0 在理解和执行语言指令方面大大优于较小的模型。

结果表明,π0 可以有效地将自然语言命令转化为适当的机器人动作。例如,在餐桌布置任务中,该模型可以正确地解释诸如“将叉子放在盘子的左边”或“将玻璃杯移到餐巾旁边”之类的指令。

当与用于规划的高级 VLM 结合使用时,语言跟随能力会得到特别增强。在这种分层方法中:

- 高级 VLM 解释复杂的指令并将其分解为更简单的子任务

- π0 使用其动作生成能力执行每个子任务

- 如果需要,视觉反馈允许采取纠正措施

这种组合使 π0 能够执行由语言指导的复杂的多阶段任务,例如洗衣折叠序列或从组件组装结构。

与其他方法的比较

π0 在几个关键领域代表了对先前机器人控制方法的重大改进:

通用性:与专门的策略不同,π0 可以使用单个模型在不同的机器人平台上执行各种任务。

零样本能力:π0 可以在没有任何任务特定微调的情况下执行许多任务,从而利用在预训练期间获得的知识。

语言理解:π0 有效地弥合了自然语言指令和机器人动作之间的差距。

动作表示: 相比于确定性策略,流匹配方法允许 π0 生成更细致的动作分布。

模型在复杂操作任务上的表现证明了这些优势。例如,在移动洗衣任务(如图 2 所示)中,π0 可以成功地导航到洗衣篮,捡起物品,并将它们适当地放置——这是一个需要导航、操作和语义理解协调的序列。

结论

π0 代表着朝着创建能够执行各种任务的通用机器人控制系统迈出的重要一步。通过将预训练的视觉语言模型与基于流的动作生成机制相结合,π0 展示了令人印象深刻的零样本能力、高效的微调和有效的语言跟随能力。

π0 的成功突出了开发通用机器人策略的几个关键原则:

- 大规模预训练在多样化数据集上的重要性

- 利用预训练的视觉语言模型的价值

- 流匹配在建模复杂动作分布方面的有效性

- 跨多个机器人平台的跨具身学习的优势

这项研究为训练和评估机器人基础模型提供了一个全面的框架,为更强大和适应性更强的机器人铺平了道路。随着机器人越来越需要在非结构化环境中运行,并与人类自然地互动,像 π0 这样结合视觉感知、语言理解和灵巧控制的方法将变得越来越重要。

π0 模型表明,在计算机视觉和自然语言处理领域成功的基础模型方法可以有效地扩展到机器人控制,为更通用、适应性更强和更直观的机器人系统开辟了新的可能性。