多可见光线索引导的热红外无人机图像超分辨率重建

多可见光线索引导的热红外无人机图像超分辨率重建

Thermal UAV Image Super-Resolution Guided by Multiple Visible Cues

摘要

无人机(UAV)热成像技术已受到广泛关注,但热成像系统导致的图像分辨率不足仍是制约热红外无人机图像解读的关键问题。然而,高分辨率可见光图像相对易于获取,因此从可见光图像中挖掘有用信息以辅助热红外无人机图像超分辨率(SR)重建具有重要价值。本文提出一种新型多条件引导网络(MGNet),用于有效挖掘可见光图像信息,以支持热红外无人机图像超分辨率重建。高分辨率无人机可见光图像通常包含显著的外观、语义及边缘信息,这些信息对提升热红外无人机图像超分辨率重建性能具有关键作用。为此,本文设计了一种有效的多线索引导模块(MGM),利用可见光图像中的外观、边缘和语义线索,实现对热红外无人机图像超分辨率重建的引导。此外,本文构建了首个针对“可见光引导热红外无人机图像超分辨率重建”任务的基准数据集。该数据集通过多模态无人机平台采集,包含1025对人工配准的可见光与热红外图像对。在该数据集上开展的大量实验表明,本文提出的MGNet能够有效利用可见光图像中的有用信息,提升热红外无人机图像超分辨率重建性能,且相较于多种当前主流方法表现更优。该数据集可通过以下链接获取:https://github.com/mmic-lcl/Datasets-andbenchmark-code。

关键词

特征调制;多可见光线索;遥感;Swin Transformer;热红外图像超分辨率(SR);无人机(UAV)

1. 引言

热成像技术不受光照条件影响,因此在智慧城市[1]、森林防火[2]、气体泄漏检测[3]及农业生产[4]等领域具有广泛应用。然而,受限于热成像原理与系统本身,获取高分辨率热红外图像难度较大。在热成像应用更为广泛的无人机(UAV)平台上,传感器尺寸的限制进一步增加了获取高分辨率热红外图像的难度。图像分辨率不足已成为制约无人机热红外图像解读的关键问题。

为解决图像分辨率不足的问题,超分辨率(SR)技术被引入。现有的单图像超分辨率方法[5]、[6]、[7]、[8]要么采用迭代方式,要么利用卷积神经网络(CNN)学习上采样变换函数。这些方法在2倍(×2)和4倍(×4)超分辨率重建任务中取得了一定效果,但由于低分辨率图像所包含的信息有限,在进行大尺度图像超分辨率重建时,这类单图像超分辨率方法难以恢复出对应的纹理信息。这种现象在噪声更强的无人机场景图像超分辨率重建中更为明显。如图1中前三种方法所示,单图像超分辨率方法无法满足无人机平台下热红外图像超分辨率重建的需求,其重建出的纹理往往较为平滑。

为获得更优的重建结果,近年来的研究通过引入引导信息,在图像超分辨率重建过程中补充低分辨率图像中缺失的纹理。现有的引导式图像超分辨率方法[9]、[10]、[11]利用网络从可见光图像和热红外图像中提取特征,最终通过CNN对特征进行融合,以实现可见光图像中纹理的迁移。这些方法在手持相机拍摄的图像上取得了显著进展,但对于无人机热红外图像超分辨率重建而言,这类无法充分利用无人机平台可见光图像线索的方法,往往会恢复出错误的纹理。如图1所示,这些引导式图像超分辨率方法迁移的纹理模糊不清,难以分辨出其对应区域为石板路,这是因为仅依靠CNN实现可见光图像纹理迁移的效果并不理想。

在无人机平台下,受成像原理及无人机自身条件限制,获取高分辨率热红外图像难度较大,但获取高分辨率可见光图像则相对容易。由于可见光图像与热红外图像存在共享的内容信息,因此利用高分辨率可见光图像辅助低分辨率热红外图像超分辨率重建,成为一种极具可行性的解决方案。

为更好地研究无人机场景下“可见光图像引导热红外图像超分辨率重建(VGTSR)”任务,本文首先对相关数据集进行了调研。尽管目前许多无人机配备了多传感器相机,能够同时采集可见光图像与热红外图像,但当前仍缺乏经过良好配准的无人机平台可见光-热红外图像数据集,以支撑相关研究。现有引导式图像超分辨率方法所使用的数据集,如FLIR高级驾驶辅助系统数据集(FLIR-ADAS)[10]和彩色-热红外立体数据集(CATS)[14],均由手持相机采集,且数据集中的可见光图像与热红外图像要么存在配准偏差,要么尺寸不一致。为此,本文构建了一个全新的无人机基准数据集,专门用于可见光图像引导的无人机热红外图像超分辨率重建任务。该数据集包含1025对由无人机平台采集的可见光-热红外图像对,每幅图像分辨率均为640×512,且包含大量经过人工配准的小目标。

如图2所示,与自然场景图像相比,无人机图像因拍摄高度较高,其观测范围更大,这使得无人机图像包含更多轮廓信息,但纹理信息相对较少。本文构建的VGTSR数据集中的无人机图像涵盖三类主要语义类别:建筑物、道路和植被。无人机图像中的这些语义区域通常面积较大,且类别间区分度较高。因此,针对这三类语义类别,设计网络学习各类别对应的纹理信息相对容易。

边缘信息在超分辨率重建任务中具有至关重要的作用。然而,受“热交叉”现象影响,热红外图像中不同语义类别边缘处的边缘信息较弱。因此,利用可见光图像的边缘线索引导热红外图像超分辨率重建具有可行性。已有大量研究表明,图像超分辨率重建结果与边缘信息提取质量高度相关。尽管当前的边缘提取网络性能不断提升,但提取到的边缘信息中仍包含大量来自非语义边缘的噪声。与无人机图像相比,自然场景图像通常包含更多语义类别,这导致其边缘提取过程中产生的噪声更多。

除边缘线索和语义线索外,无人机可见光图像中的其他线索(如外观线索)也可能对无人机热红外图像超分辨率重建有所帮助。因此,如何挖掘并利用这些线索,是无人机热红外图像超分辨率重建任务中的关键问题。

本文提出一种新型多条件引导网络(MGNet),通过挖掘可见光图像中的外观、边缘和语义线索,实现对无人机热红外图像超分辨率重建的引导。具体而言,首先设计了多线索引导模块(MGM),利用不同的可见光线索增强无人机热红外图像的特征表示。该模块通过三个分支分别学习由不同线索引导的特征图:考虑到视觉Transformer强大的特征表示能力,在每个分支中利用Transformer的注意力机制嵌入引导线索;为建模特征的长距离依赖关系并保留全局上下文信息,采用自注意力机制增强不同线索的特征;为在超分辨率重建过程中引入不同线索,通过交叉注意力机制将增强后的线索特征嵌入到热红外图像特征中。基于自注意力和交叉注意力机制,每个引导分支均可获得由对应线索引导的特征表示,且不同引导分支能够聚焦于图像超分辨率重建过程中的不同细节。

为此,本文进一步设计了渐进式融合模块(PFM),以充分利用各引导分支的互补能力。考虑到语义线索与边缘线索之间的关联性,首先对语义线索和边缘线索引导的特征进行融合,整合这两类线索的互补信息;随后,将融合后的特征与外观线索引导分支的特征进行融合,实现三类线索信息的进一步结合;最后,对经过PFM模块融合后的特征进行上采样处理,得到高分辨率热红外图像。

大量实验结果表明,通过引入无人机可见光图像中的不同线索,能够帮助恢复无人机热红外图像中更优的细节与结构信息。本文提出的MGNet在评价指标和视觉感知效果两方面,均优于当前主流方法,同时还能抑制引导信息中的噪声。

综上,本文的主要贡献如下:

- 针对无人机平台下高分辨率热红外图像获取难度大的问题,提出“可见光线索引导无人机热红外图像超分辨率重建”这一新任务,该任务对获取高分辨率无人机热红外图像具有重要意义。

- 提出新型方法MGNet,该方法通过挖掘并利用无人机可见光图像中的多种有效线索,在无人机热红外图像超分辨率重建中恢复出更真实的纹理;具体而言,设计了多线索引导模块(MGM)以高效嵌入不同线索,同时设计了渐进式融合模块(PFM)以充分利用不同线索间的关联性与互补性。

- 构建了一个统一的基准数据集,该数据集包含经过良好标注的无人机平台可见光-热红外图像对,专门用于VGTSR任务。

- 与现有主流引导式图像超分辨率方法及单图像超分辨率方法相比,本文方法能够恢复出更真实的细节信息,在评价指标和视觉感知效果上均表现更优。

2. 相关工作

本节将综述与本文研究最相关的工作,包括单图像超分辨率方法、引导式图像超分辨率方法以及条件网络。

2.1 单图像超分辨率方法

图像超分辨率在计算机视觉任务中受到广泛关注。许多开创性的单可见光图像超分辨率方法(如文献[15]、[16]、[17]、[18]、[19]、[20]、[21]、[22]、[23]、[24]、[25]、[26])已取得优异性能。其中,残差通道注意力网络(RCAN)[27]、全局注意力网络(HAN)[28]、二阶注意力网络(SAN)[29]等方法通过注意力机制聚焦于图像的不同区域和通道,有助于获得更优的重建结果。

近年来,基于Transformer的方法(如用于图像恢复的Swin Transformer(SwinIR)[30]、Restormer[31])利用Transformer建模长距离依赖关系,实现了更高的重建质量。这些单可见光图像超分辨率方法在红外图像超分辨率任务中同样表现出色。

过去几十年间,由于红外成像相机成本较高,针对红外图像超分辨率的研究日益增多。Choi等人[6]提出了首个热红外图像超分辨率方法,该方法通过卷积神经网络(CNN)学习从低分辨率热红外图像到高分辨率热红外图像的映射关系。Lee等人[32]提出一种基于CNN的红外图像增强方法,结合了亮度域与残差学习技术。Zhang等人[7]利用判别性字典与深度残差网络,提出一种红外图像超分辨率方法。Liu等人[33]提出分类字典学习方法,用于重建高分辨率红外图像。Sun等人[34]提出一种引入缩放机制的新方法,以提升红外图像超分辨率的运行速度。

这些单红外图像超分辨率方法与单可见光图像超分辨率方法虽已取得一定改进,但仅依靠低分辨率图像,这类单图像超分辨率方法难以重建出高频细节信息。

B. 引导式图像超分辨率方法

近年来,引导式图像超分辨率方法也取得了一定进展。目前,针对深度图像[35]、[36]、[37]、[38]、[39]、[40]、[41]、[42]、[43]、[44]、[45]或高光谱图像[46]、[47]、[48]、[49]的引导式超分辨率方法,大多遵循相似的设计思路:这类方法通过两个结构相同的特征提取器分别提取两种模态图像的特征,随后对两种模态的特征图进行简单整合。

此外,现有研究中也存在部分针对红外图像的引导式超分辨率模型[11]、[50]、[51],这类模型采用卷积神经网络(CNN)提取并迁移引导信息。例如,Han等人[11]提出一种适用于低光照环境的可见光图像引导红外图像超分辨率方法,该方法先将可见光图像与红外图像的特征进行拼接,再利用拼接后的特征重建高分辨率红外图像;Almasri与Debeir[9]提出一种多模态视觉-红外融合模型,通过整合可见光图像中的高频纹理来解决热红外图像超分辨率问题。然而,这些引导式方法仅对不同模态图像的特征进行简单融合,往往会导致重建出的纹理模糊不清。

Gupta与Mitra[10]提出一种引导式图像超分辨率模型,该模型采用两个定制化的、含密集块(dense-block)的孪生网络(Siamese network)[52],分别从可见光图像和热红外图像中提取特征,随后在特征融合前对这些特征执行空间注意力操作。这种借助空间注意力模块融合跨域特征的方法,开始尝试选择性地融合可见光图像中的信息,而非直接进行特征融合。但该方法仍面临挑战:难以让网络精准选择并整合可见光图像中的纹理,可能会导致重建出错误的纹理。

Gupta与Mitra[53]还提出另一种热红外图像引导式超分辨率方法,该方法从可见光图像中提取边缘线索,并仅利用边缘线索引导热红外图像超分辨率重建。然而,仅依靠边缘线索引导热红外图像超分辨率重建的性能提升有限,且最终重建纹理的质量与边缘线索的提取质量高度相关。

因此,如何充分利用可见光图像与热红外图像之间的共享信息,成为当前热红外图像超分辨率任务中的关键问题。鉴于此,本文提出一种新型多条件引导网络,旨在高效利用可见光图像中的多种线索,实现无人机热红外图像超分辨率重建。

C. 条件网络

批量归一化(Batch Normalization, BN)[54]被广泛应用于各类网络中,通过对数据分布施加额外约束,提升模型的泛化能力。条件归一化(Conditional Normalization, CN)则通过可学习函数学习条件中的信息,在BN的基础上实现特征变换。目前已有众多研究者对CN展开研究,以更好地嵌入不同条件。

近年来的研究将空间信息引入CN领域,在计算机视觉任务中取得了重大突破。例如,Wang等人[55]提出空间特征变换(Spatial Feature Transform, SFT),通过融入类别先验信息,为图像超分辨率重建恢复对应的纹理;Li等人[56]设计门控逐特征变换(Gated Feature-wise Transform, GFT),在热红外图像语义分割任务中抑制边缘图中的噪声。

尽管SFT和GFT在图像超分辨率(SR)与语义分割任务中取得了一定改进,但在处理条件信息时,对噪声的抑制效果仍有待提升。因此,在本文提出的框架中,我们设计了引导层(Guidance Layers, GLs),以实现对不同线索的自适应嵌入。

3. MGNet:多条件引导网络

本章3.1节将阐述多条件引导网络(MGNet)的整体框架,3.2节和3.3节分别介绍所提出的多线索引导模块(MGM)与渐进式融合模块(PFM),3.4节则详细说明MGNet的损失函数。

3.1 整体框架

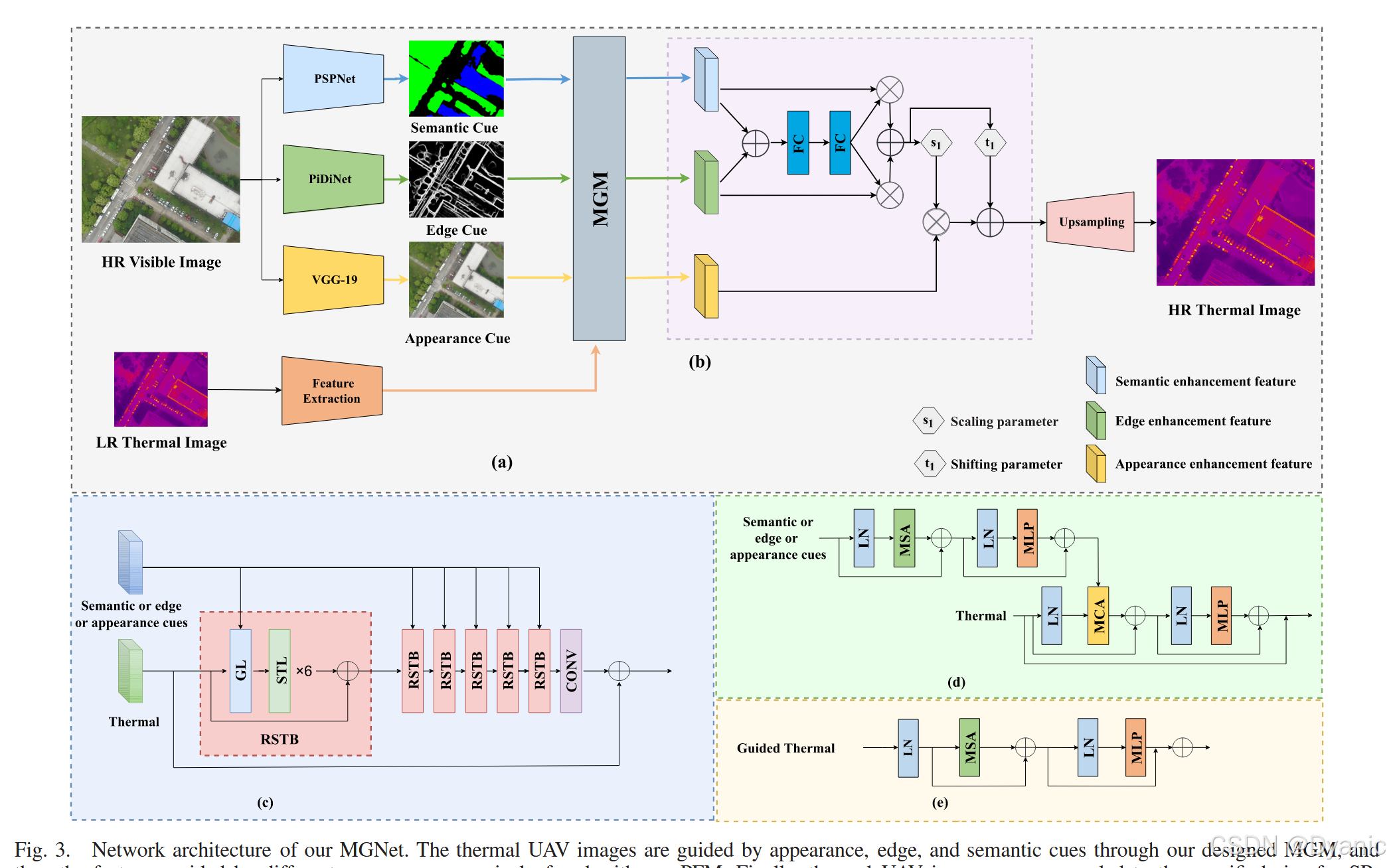

可见光图像与热红外图像共享相同的外观、边缘及语义线索,充分利用这些线索对超分辨率重建至关重要。鉴于Transformer在图像超分辨率领域的显著进展,本文选择基于Swin Transformer[57]构建的SwinIR[30]模型作为基准网络,并在此基础上提出新型MGNet,以高效利用无人机可见光图像中的多种线索,实现无人机热红外图像超分辨率重建。如图3(a)所示,MGNet主要由三部分构成:线索特征提取、多线索引导模块(MGM)和渐进式融合模块(PFM)。

-

线索特征提取:针对不同类型的线索,本文采用相同的引导模块,但配备不同的提取模块。

- 外观线索:为减小模态差异,采用预训练的VGG-19网络提取深层特征(而非浅层特征)。

- 边缘线索:利用在BSDS500[58]数据集上预训练的PiDiNet[13]从可见光图像中提取边缘信息;为获取由粗到细的边缘信息,将PiDiNet不同层的输出进行拼接。

- 语义线索:通过在Cityscapes[60]数据集上预训练的PSPNet[59]从可见光图像中提取语义信息。

- 热红外图像特征:采用自定义的浅层特征提取器(由一个3×3卷积层构成)提取无人机热红外图像的特征图。

-

多线索引导模块(MGM):为使网络学习到不同的特征表示,外观、边缘、语义三类线索经不同提取网络处理后,分别输入MGM。在MGM中,不同线索被用于生成注意力权重,以引导无人机热红外图像超分辨率重建,最终生成外观引导特征、边缘引导特征和语义引导特征。

-

渐进式融合模块(PFM):在无人机热红外图像超分辨率重建过程中,不同的特征表示聚焦于不同细节。为挖掘不同线索引导特征间的互补信息,本文设计PFM,以渐进方式对这些特征进行融合;对融合后的热红外图像特征图进行上采样,即可得到高分辨率(HR)无人机热红外图像。

3.2 多线索引导模块(MGM)

为从不同线索中学习到不同的特征表示,本文设计了MGNet的核心组件——多线索引导模块(MGM)。MGM的结构如图3(c)所示,由多个残差Swin Transformer块(RSTB)构成;每个RSTB包含6个Swin Transformer层(STL)[30]和1个本文设计的引导层(GL),GL与STL的结构分别如图3(d)和图3(e)所示。

为捕捉特征的长距离依赖关系并建模全局上下文信息,GL首先通过自注意力(self-attention)和移位窗口(shifted window)机制增强不同线索中的信息;随后通过交叉注意力(cross-attention)和移位窗口机制,从增强后的不同线索中生成注意力权重;最终利用该注意力权重实现对热红外图像特征的引导。

对于局部窗口特征,GL与STL中的查询矩阵(QQQ)、键矩阵(KKK)和值矩阵(VVV)计算方式如下:

Q=XWQ,K=XWK,V=XWV(1)Q = X W^Q, K = X W^K, V = X W^V \quad (1)Q=XWQ,K=XWK,V=XWV(1)

其中,WQW^QWQ、WKW^KWK、WVW^VWV为不同窗口间共享的投影矩阵,XXX表示输入特征。

局部窗口内基于自注意力或交叉注意力机制的注意力矩阵计算方式如下:

Attention(Q,K,V)=softmax(QKTdk+B)V(2)Attention(Q, K, V) = softmax\left( \frac{Q K^T}{\sqrt{d_k}} + B \right) V \quad (2)Attention(Q,K,V)=softmax(dkQKT+B)V(2)

其中,BBB为可学习的相对位置编码矩阵,dkd_kdk为查询矩阵KKK的维度,Attention(⋅)Attention(·)Attention(⋅)表示多头自注意力或多头交叉注意力函数。在多头自注意力函数中,QQQ、KKK、VVV均源自同一可见光特征;在多头交叉注意力机制中,QQQ和KKK源自可见光特征,VVV源自热红外特征。

GL中的完整处理流程可表示为:

z^l=MSA(LN(zl−1))+zl−1\hat{z}^l = MSA(LN(z^{l-1})) + z^{l-1}z^l=MSA(LN(zl−1))+zl−1

zl=MLP(LN(z^l))+z^lz^l = MLP(LN(\hat{z}^l)) + \hat{z}^lzl=MLP(LN(z^l))+z^l

z^l+1=MCA(LN(x),zl)+x\hat{z}_{l+1} = MCA(LN(x), z_l) + xz^l+1=MCA(LN(x),zl)+x

zl+1=MLP(LN(z^l+1))+z^l+1+x(3)z^{l+1} = MLP(LN(\hat{z}^{l+1})) + \hat{z}^{l+1} + x \quad (3)zl+1=MLP(LN(z^l+1))+z^l+1+x(3)

其中,MSAMSAMSA和MCAMCAMCA分别表示多头自注意力和多头交叉注意力函数,MLPMLPMLP和LNLNLN分别表示多层感知机和层归一化;xxx和zl−1z^{l-1}zl−1分别表示热红外特征和线索特征;z^l\hat{z}^lz^l和zlz^lzl分别表示第lll层中MSA模块和MLP模块的输出特征;z^l+1\hat{z}^{l+1}z^l+1和zl+1z^{l+1}zl+1分别表示第l+1l+1l+1层中MCA模块和MLP模块的输出特征。

3.3 渐进式融合模块(PFM)

经过MGM模块处理后,可得到三类聚焦于无人机热红外图像超分辨率重建不同细节的线索引导特征。为充分发挥各引导分支的互补潜力,本文设计PFM,以渐进方式对这些特征进行融合。PFM的结构如图3(b)所示。

边缘线索与语义线索之间存在较强的关联性与互补性,现有研究(如[61]、[62])常利用其中一类线索辅助另一类线索的利用。因此,PFM首先对边缘引导特征与语义引导特征进行融合,以挖掘两类线索中的互补信息;随后将融合后的特征与外观引导特征进一步融合,从而充分利用三类线索间的互补信息。

受SENet[63]启发,PFM首先对边缘引导特征与语义引导特征进行权重分配(以建模通道间的依赖关系),再将二者相加;为将该融合特征与外观引导特征有效整合,采用空间特征变换(SFT)[55]的思路对融合特征进行进一步变换。SFT层的计算方式如下:

SFT(x,p)=γ(p)⊙x⊕β(p)(4)SFT(x, p) = \gamma(p) \odot x \oplus \beta(p) \quad (4)SFT(x,p)=γ(p)⊙x⊕β(p)(4)

其中,SFTSFTSFT表示SFT层,xxx和ppp分别表示输入的原始特征与先验特征,⊙\odot⊙和⊕\oplus⊕分别表示按元素相乘和按元素相加,γ(⋅)\gamma(·)γ(⋅)和β(⋅)\beta(·)β(⋅)表示卷积层;γ(p)\gamma(p)γ(p)与β(p)\beta(p)β(p)的维度与ppp一致,输入ppp通过γ(⋅)\gamma(·)γ(⋅)和β(⋅)\beta(·)β(⋅)被映射为与ppp相关的缩放参数和偏移参数。通过仅对网络中间层特征进行变换,SFT即可调整超分辨率网络的输出行为。完整的PFM模块计算方式如下:

yf=Fex(Fsq(yed+yse))∗(yed+yse)y_f = F_{ex}\left( F_{sq}(y_{ed} + y_{se}) \right) * (y_{ed} + y_{se})yf=Fex(Fsq(yed+yse))∗(yed+yse)

s1=γ(yf),t1=β(yf)s_1 = \gamma(y_f), t_1 = \beta(y_f)s1=γ(yf),t1=β(yf)

PFM(yap,yed,yse)=s1⊙yap⊕t1(5)PFM(y_{ap}, y_{ed}, y_{se}) = s_1 \odot y_{ap} \oplus t_1 \quad (5)PFM(yap,yed,yse)=s1⊙yap⊕t1(5)

其中,PFMPFMPFM表示所提出的渐进式融合模块,yapy_{ap}yap、ysey_{se}yse、yedy_{ed}yed分别表示外观引导特征、语义引导特征、边缘引导特征,yfy_fyf表示语义引导特征与边缘引导特征的融合结果;Fex(⋅)F_{ex}(·)Fex(⋅)和Fsq(⋅)F_{sq}(·)Fsq(⋅)分别表示SENet中的“激发”(excitation)函数与“压缩”(squeeze)函数,⊙\odot⊙表示按通道相乘;缩放参数s1s_1s1与偏移参数t1t_1t1通过与SFT中相同的γ(⋅)\gamma(·)γ(⋅)和β(⋅)\beta(·)β(⋅)函数生成。

3.4 损失函数

MGNet的输入为无人机可见光图像与低分辨率(LR)无人机热红外图像:其中,LR无人机热红外图像通过对高分辨率真值(GT)热红外图像下采样得到,无人机可见光图像由无人机平台直接采集。

无人机可见光图像首先输入线索特征提取模块,以提取不同类型的线索特征;随后,各类线索特征分别与热红外特征一同输入MGM,得到由不同线索引导的热红外特征;三类线索引导特征经PFM以渐进方式融合后,对融合特征图进行上采样,即可得到高分辨率无人机热红外图像。

整个网络的训练通过最小化预测热红外图像与GT热红外图像间的L1像素损失实现,损失函数计算方式如下:

L(Θ)=1N∑i=1N∥MGNet(ILRi)−IGTi∥1(6)\mathcal{L}(\Theta) = \frac{1}{N} \sum_{i=1}^{N} \left\| MGNet(I_{LR}^i) - I_{GT}^i \right\|_1 \quad (6)L(Θ)=N1i=1∑NMGNet(ILRi)−IGTi1(6)

其中,MGNet(⋅)MGNet(·)MGNet(⋅)表示所提出的MGNet模型函数,Θ\ThetaΘ表示MGNet的参数集合;ILRiI_{LR}^iILRi表示输入LR热红外图像的第iii个像素,IGTiI_{GT}^iIGTi表示对应GT热红外图像的第iii个像素,NNN表示图像的总像素数。

4. 数据集

本节将介绍本文构建的可见光引导热红外超分辨率(VGTSR)数据集,内容包括现有数据集分析、数据采集与分析以及数据集面临的挑战。

4.1 现有数据集

由于专门用于VGTSR研究的无人机数据集极少,目前大多数热红外图像引导式超分辨率方法均采用FLIR-ADAS[10]和CATS[14]这两个由手持相机拍摄的数据集。其中,FLIR-ADAS数据集中可见光图像分辨率为1800×1600,而热红外图像分辨率仅为640×512,二者分辨率不匹配;CATS数据集中可见光与热红外图像对分辨率虽均为640×480,但存在严重的配准偏差。此外,这两个数据集均针对手持相机场景设计,无法满足无人机平台的研究需求。

为此,本文构建了一个全新的无人机基准数据集,专门用于可见光线索引导的无人机热红外图像超分辨率任务。该数据集包含多对可见光-热红外图像对,所有图像对分辨率均统一为640×512,且经过人工配准处理。同时,为支持不同尺度的超分辨率任务,本文还提供了通过不同退化模型生成的低分辨率热红外图像;这些图像也可用于图像增强、去噪等其他低层次视觉任务。

4.2 数据采集与分析

本文数据集包含1025对高分辨率无人机可见光-热红外图像对,所有图像均由搭载禅思H20T(Zenmuse H20T)传感器的大疆M300 RTK(DJI Matrice M300 RTK)无人机采集。禅思H20T传感器集成了多种类型的传感器,能够同时采集可见光图像与热红外图像。该无人机采集的可见光图像原始分辨率为1920×1080,热红外图像原始分辨率为640×512;为保证可见光与热红外图像观测范围一致,并确保可见光图像内容的真实性,本文对可见光图像进行缩放与裁剪处理,最终将其分辨率统一为640×512。

考虑到多数多模态方法对数据配准的要求,在裁剪过程中对所有图像对进行了人工配准,部分图像对示例如图4所示。为提高数据采集效率,本文未直接拍摄单张图像对,而是先录制可见光与热红外图像视频;随后邀请多名具有相关经验的从业者对视频进行配准,再通过Adobe Premiere软件从配准后的视频中提取帧,得到最终的图像对。

本文提供的低分辨率热红外图像,是通过对高分辨率热红外图像分别应用双三次插值下采样(BI)和模糊-下采样(BD)两种退化模型生成的;此外,用户也可根据自身研究需求,通过自定义退化方式从高分辨率热红外图像中生成低分辨率图像。

为更全面地分析数据集特性,本文对VGTSR数据集中的图像对进行了统计:数据集涵盖两种主要拍摄场景——校园场景与街道场景。其中,校园场景图像由无人机在约200米高度拍摄,主要包含行人、车辆、植被、道路等目标;与街道场景热红外图像相比,校园场景热红外图像包含更多在超分辨率重建中难以恢复的纹理细节。街道场景图像由无人机在约500米高度拍摄,主要包含建筑、道路、植被、车辆等目标;受拍摄高度影响,街道场景可见光图像比校园场景可见光图像包含更多噪声,这使得街道场景的热红外图像引导式超分辨率重建难度更大。

所有图像均在不同天气条件与不同时间段拍摄,以确保数据集的多样性。参考单图像超分辨率基准数据集DIV2K[64]的划分方式(训练集、验证集、测试集比例约为8:1:1),结合VGTSR数据集的规模,本文将其划分为800对训练图像对与225对测试图像对。为保证训练集与测试集的独立分布,划分时确保两类数据集分别包含不同拍摄高度、不同天气条件下采集的图像。

4.3 数据集挑战

与手持相机拍摄的数据集相比,本文构建的VGTSR数据集在超分辨率任务中面临更大挑战。总体而言,VGTSR任务的挑战主要体现在以下三个方面:

- 热红外图像质量低:与手持相机拍摄的热红外图像相比,无人机热红外图像对比度更低、纹理信息更稀疏,这导致其在大尺度超分辨率重建中效果不佳;且拍摄高度越高,这种对比度低、纹理缺失的问题越严重。

- 可见光图像噪声干扰:受拍摄高度与无人机自身设备特性影响,无人机平台采集的可见光图像比手持相机图像包含更多噪声;在利用可见光图像引导热红外图像超分辨率重建时,这些噪声信息易被引入热红外图像中,影响重建质量。

- 小目标边缘恢复难:无人机热红外图像中包含大量小目标甚至微小组标(如车辆、行人),在8倍(×8)超分辨率任务中,这些小目标的边缘信息难以有效恢复。

此外,为进一步提升数据集的挑战性,本文还在恶劣天气条件下采集了部分可见光-热红外图像对。

5. 性能评估

本节在VGTSR数据集上对所提出的MGNet与其他主流方法进行全面评估。首先,5.1节将介绍MGNet的实现细节;其次,5.2节验证MGNet的有效性;最后,5.3节将呈现消融实验与可视化结果。

5.1 实现细节

本研究的网络在配备24GB显存的TITAN RTX GPU平台上进行训练,基于公开框架PyTorch[65]实现。在提出的MGNet中,卷积核大小、嵌入维度、窗口大小、注意力头数与 patch 大小分别设置为3×3、96、8、6和1。该方法共包含4个残差Swin Transformer块(RSTB),每个RSTB内包含1个引导层(GL)和6个Swin Transformer层(STL)。

为构建低分辨率热红外训练集,本研究采用文献[29]、[28]中的双三次插值下采样(BI)退化模型与文献[53]中的模糊-下采样(BD)退化模型,模拟低分辨率无人机热红外图像。在可见光图像输入分支中,始终使用分辨率为640×512的高分辨率可见光图像;而在热红外图像输入分支中,输入为低分辨率热红外图像。

在训练阶段,直接将整幅图像作为输入会占用大量显存,因此常用解决方案是从图像中随机裁剪patch作为网络输入;在测试阶段,则以整幅图像作为输入。本研究分别对分辨率为32×32、48×48、64×64和80×64的patch进行实验,发现不同宽高比对实验结果影响极小(峰值信噪比(PSNR)波动不超过±0.02dB)。为与基准模型SwinIR及其他单图像超分辨率方法保持一致,最终选择48×48大小的patch作为输入。

对于4倍(×4)超分辨率任务,分别从160×128的热红外图像和640×512的可见光图像中裁剪48×48和192×192大小的patch作为MGNet的输入;对于8倍(×8)超分辨率任务,则分别从80×64的热红外图像和640×512的可见光图像中裁剪48×48和384×384大小的patch作为输入。

模型训练采用ADAM优化器[66],参数设置为β₁=0.9、β₂=0.99、ε=10⁻⁸。各引导分支的权重通过不同线索预训练200个epoch得到,随后对整个网络进行端到端训练。初始学习率设为10⁻⁴,之后每训练200个epoch学习率减半。

5.2 定量与定性评估

为验证MGNet的有效性,在构建的VGTSR数据集上针对不同尺度开展可见光线索引导的无人机热红外图像超分辨率实验,并与8种主流单图像超分辨率方法及3种引导式图像超分辨率方法进行对比,具体包括:

- 基于卷积神经网络(CNN)的模型:密集深度反投影网络(D-DBPN)[26]、残差密集网络(RDN)[25]、二阶注意力网络(SAN)[29]、增强型深度超分辨率网络(EDSR)[21]、残差通道注意力网络(RCAN)[27]、全局注意力网络(HAN)[28];

- 基于Transformer的模型:用于图像恢复的Swin Transformer(SwinIR)[30]、Restormer[31];

- 引导式模型:MultiNet[11]、PAG-SR[53]、非配准热红外图像引导式超分辨率(UGSR)[10]。

在单图像超分辨率方法中,D-DBPN、RDN、EDSR通过不同的残差块增强低分辨率图像特征;HAN、SAN、RCAN借助不同的注意力机制,聚焦低分辨率图像的不同区域与通道,以恢复更优纹理;基于Transformer的SwinIR和Restormer则通过不同的Transformer结构捕捉特征的长距离依赖关系,从而提升重建效果。

在引导式图像超分辨率方法中,MultiNet采用两个提取器分别提取可见光与热红外图像特征,并通过简单拼接实现纹理迁移;UGSR对可见光特征施加空间注意力以增强信息,再将两类特征相加;PAG-SR则用边缘图替代可见光图像,引导热红外图像超分辨率重建。

为定量评估超分辨率热红外图像的质量,采用两种常用评价指标:峰值信噪比(PSNR)和结构相似性(SSIM),指标数值越高表示重建质量越好。表1展示了在VGTSR数据集上,基于BD和BI两种退化模型的×4与×8超分辨率任务结果。

结果显示,在×8超分辨率任务中,相较于其他单图像超分辨率方法与引导式图像超分辨率方法,MGNet在BI退化模型下的PSNR提升0.58dB、SSIM提升0.0239;在BD退化模型下的PSNR提升0.61dB、SSIM提升0.0235。

不同单图像超分辨率模型的性能较为接近,值得注意的是,得益于Transformer捕捉长距离依赖的能力,SwinIR在单图像超分辨率模型中表现最优;Restormer虽利用Transformer聚焦特征通道间的关系,但在×8超分辨率任务中的表现不及SwinIR。

在引导式图像超分辨率模型中,MultiNet与UGSR通过不同融合方式迁移可见光图像纹理时易引入噪声,导致PSNR与SSIM偏低;PAG-SR用边缘线索替代可见光图像,因此相较于UGSR和MultiNet取得更优结果。而MGNet通过引入边缘、语义、外观三类线索,并利用各引导分支的互补信息,最终实现最优性能。

MGNet不仅在PSNR和SSIM指标上表现优异,在视觉感知质量上也有显著提升。如图5-7所示,无论是BD还是BI退化模型,MGNet恢复的纹理与结构信息均最接近高分辨率真值(GT)热红外图像。尤其在×8超分辨率任务中,MGNet在基于BD退化模型的无人机热红外图像上提升显著——即便输入热红外图像含噪声,在高分辨率可见光图像的引导下,模型仍能保持良好表现。

相比之下,单图像超分辨率方法因缺乏可见光线索引导,难以恢复纹理与结构信息,所有对比方法均存在严重的模糊伪影,无法重建更多细节;引导式图像超分辨率方法虽比单图像超分辨率方法能恢复更优的纹理与结构,但因未充分利用可见光引导信息,重建效果仍不理想。可视化结果表明,MGNet能从高分辨率可见光图像的不同线索中获取更多引导信息,从而恢复更丰富的细节。

为进一步验证方法的有效性与适应性,在VGTSR数据集的全部热红外图像上开展超分辨率实验。由于该实验设置下无法获取高质量热红外图像真值,采用无参考图像质量评估指标——自然图像质量评估器(NIQE)[67]、感知图像质量评估器(PIQE)[68]与盲/无参考图像空间质量评估器(BRISQUE)[69](三者均为图像质量评估领域广泛应用的无参考指标[70]、[71]、[72])进行评估。

定量评估结果如表2所示,MGNet在NIQE、PIQE、BRISQUE三项指标上均显著优于其他对比方法。可视化结果如图8所示,得益于可见光图像中多线索的渐进式引导,MGNet重建的热红外图像更清晰、真实;而单图像超分辨率方法与其他引导式图像超分辨率方法重建的热红外图像则可能存在明显伪影。这些可视化结果进一步证明了MGNet的鲁棒性与适应性。

与单图像超分辨率方法相比,MGNet的参数量处于相近水平。在推理速度方面,在512×640分辨率的无人机热红外图像上测试时,典型的基于CNN的模型HAN、PAG-SR,基于Transformer的模型SwinIR,以及本研究提出的MGNet的推理时间分别约为0.22秒、0.14秒、0.16秒和0.48秒——尽管MGNet推理时间略长,但其在重建质量上的提升十分显著。

5.3 消融实验

5.3.1 引导层(GL)的有效性

为验证所设计的GL挖掘引导信息的能力,在仅使用外观线索引导的情况下,分别将MGM中的GL层替换为按元素相加、特征拼接或空间特征变换(SFT)层。

由表3可知,在基于BI退化模型的无人机热红外图像上,采用GL层的SwinIR模型,其PSNR从30.72dB提升至30.87dB(提升0.15dB),SSIM从0.8943提升至0.8970(提升0.0027);且相较于其他三种引导方式,GL层的表现更优。图9展示了采用不同引导方式的SwinIR模型的可视化结果。实验表明,使用GL层引导热红外图像超分辨率重建,能从可见光图像中挖掘更多引导信息,从而恢复更真实的纹理。

5.3.2 不同线索与渐进式融合模块(PFM)的有效性

为验证三类线索的互补性与有效性,引入外观、边缘、语义线索的不同组合进行引导实验;为验证PFM挖掘互补信息的能力,采用不同融合方式(如按元素相加、特征拼接)对不同线索引导的特征进行融合,结果如表4所示。

与基准模型相比,MGM引入三类线索中的任意一类,均能实现性能提升,这表明从可见光图像中提取的每类线索均对超分辨率重建有帮助。不同线索引导的热红外图像重建结果往往聚焦于不同细节,但单一线索引导无法充分利用可见光图像中的信息,因此性能提升有限;而采用三类线索的不同组合进行引导时,实验结果进一步提升。

PFM先对边缘引导特征与语义引导特征进行权重分配与融合,生成缩放和偏移参数,再对外观引导特征进行调制——这种渐进式融合方式能充分发挥各引导分支的互补性,从而实现更优性能。当同时使用三类线索引导时,MGNet的PSNR从30.72dB提升至31.16dB(提升0.44dB),SSIM从0.8905提升至0.9033(提升0.0128)。

消融实验结果验证了可见光图像中三类不同线索的有效性,以及MGM充分挖掘各类线索引导信息的能力;同时证明,PFM通过渐进式融合不同线索引导的特征,有效整合了互补信息,从而提升了重建性能。

6. 结论

本文为“可见光引导热红外超分辨率(VGTSR)”任务构建了全新的VGTSR数据集,该数据集包含1025对由无人机平台采集的可见光-热红外图像对。在VGTSR数据集上,对多种单图像超分辨率方法与引导式图像超分辨率方法进行了全面实验分析,并提出了更适用于该任务的方法——MGNet。具体而言,MGNet通过渐进式利用可见光图像中的不同线索,实现了更优的超分辨率重建效果,实验结果验证了其有效性。

此外,本文还强调了对VGTSR任务至关重要的两个核心要素:

- 充足的数据集:当前热红外图像引导式超分辨率任务的数据集主要基于手持相机拍摄,尽管本文构建的VGTSR数据集填补了无人机场景的空白,但无人机可见光-热红外图像对的数量仍不足,尤其对于需要大量数据训练的CNN与Transformer模型而言,数据量限制可能影响模型性能。

- 高效的方法设计:可见光图像与热红外图像存在大量共享信息,因此设计高效的网络从无人机可见光图像中提取不同有用信息,以引导热红外图像超分辨率重建,具有极其重要的意义。

在未来工作中,将进一步探索利用无人机可见光图像中更多类型的线索,并研究非配准图像对的超分辨率重建问题。