【阿里云PAI平台】 如何在Dify调用阿里云模型在线服务 (EAS)

目录

- 1. 总述

- 2.前置环节

- 3.创建模型在线服务(EAS)实例

- 4.本地Dify接入模型在线服务 (EAS)

1. 总述

介绍如何部署阿里云PAI平台上的大模型,在本地服务器的dify如何直接调用部署在的阿里云上的大模型。

2.前置环节

-

目前已经在阿里云PAI平台上申请了OSS空间或者NAS空间,并且在空间内已经存在大模型的权重文件(可以直接下载开源的大模型权重,或者在PAI平台上进行微调训练后保存的大模型权重)

-

已经配置好

3.创建模型在线服务(EAS)实例

在左侧菜单栏找到模型在线服务(EAS),然后在右侧点击部署服务按钮;

然后选择自定义部署:

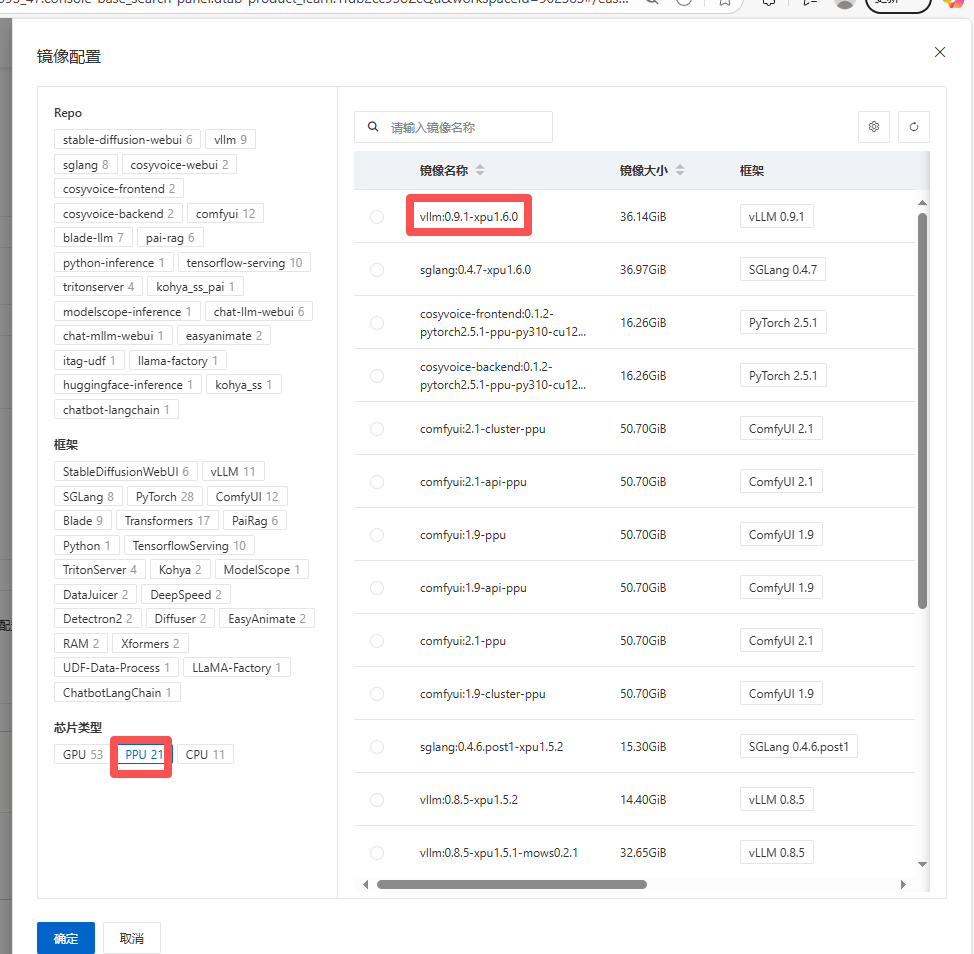

然后选择镜像配置,推荐使用微调大模型时的镜像环节;

本人使用LLama-factory lora微调Qwen2.5-VL-7B的模型,镜像选择的是官方的vllm:0.9.1-xpu1.6.0

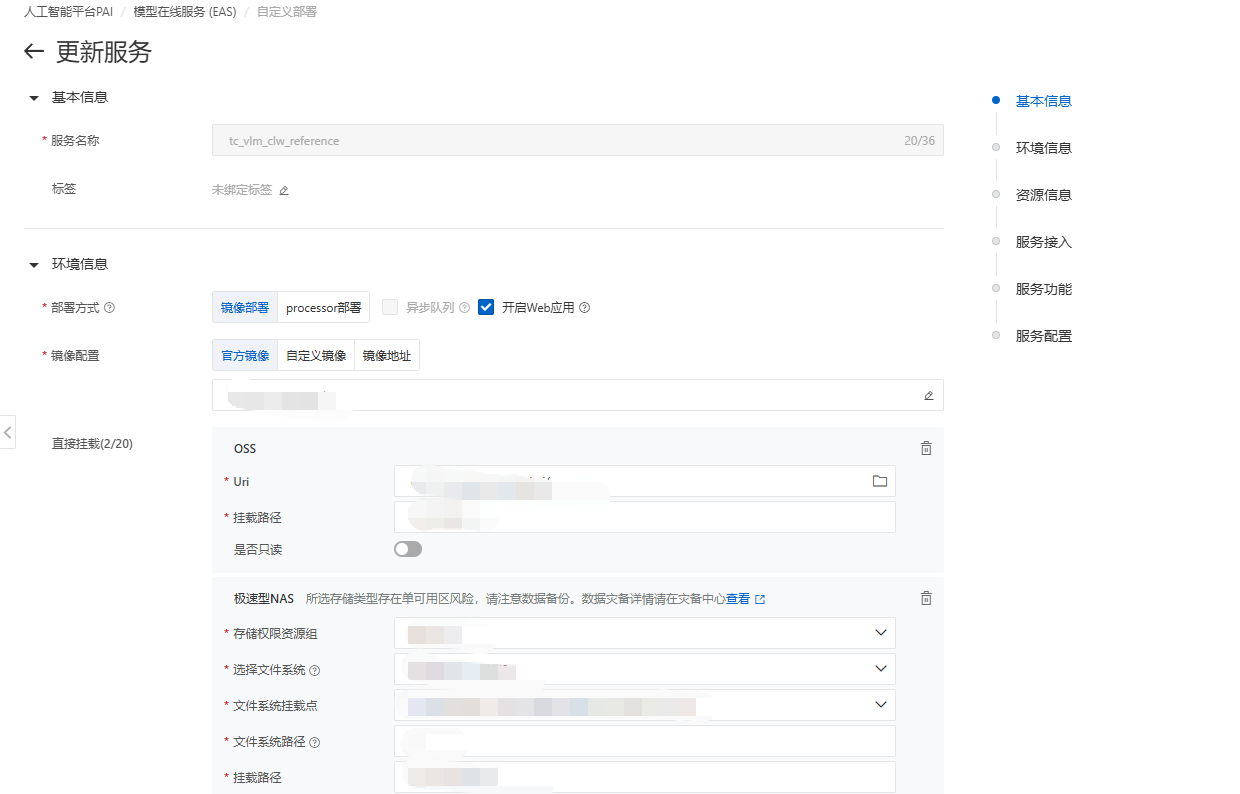

然后挂载OSS或者NAS空间

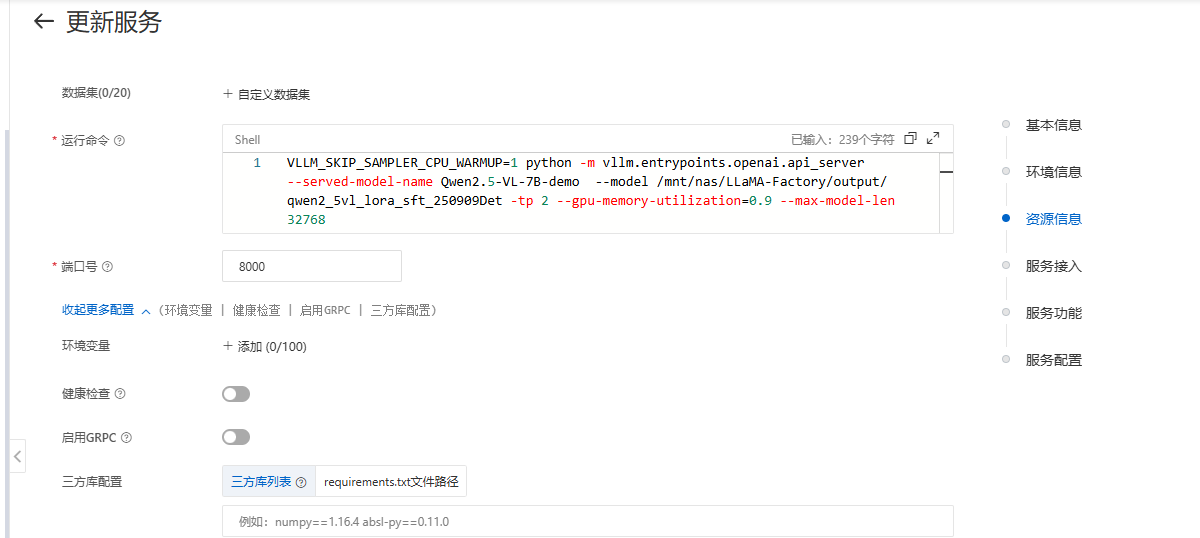

然后在运行指令输入运行大模型的指令:

VLLM_SKIP_SAMPLER_CPU_WARMUP=1 python -m vllm.entrypoints.openai.api_server --served-model-name [大模型应用名称] --model [大模型权重的文件目录] -tp 2 --gpu-memory-utilization=0.9 --max-model-len 32768

具体参数的含义可以查询官方文档

然后需要设置模型接入:

部署完成后就可以在公网访问,没有开通过服务的需要付费开通网络服务,根据提示来就可以;

然后点击部署按钮,等待几分钟,就可成功运行;

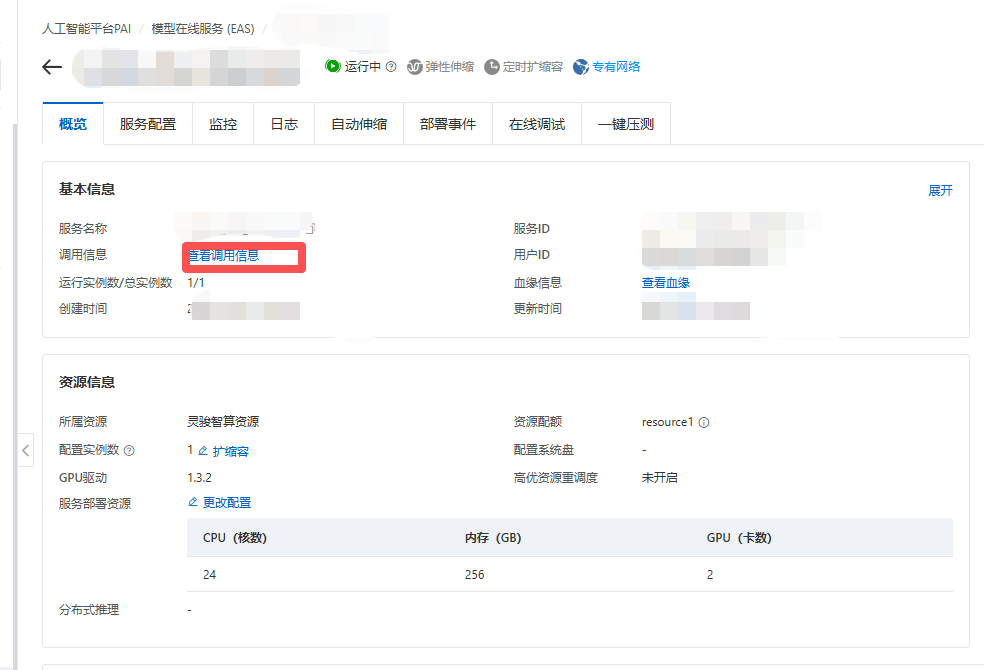

运行成功后,点击名称按钮:

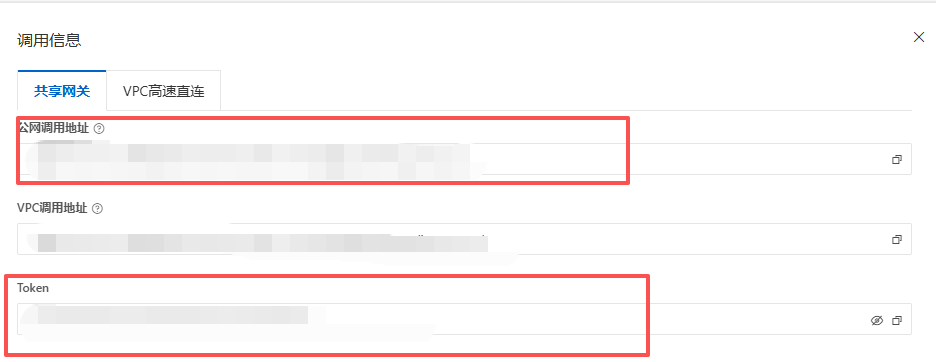

然后点击概览页面的查看调用信息按钮:

然后复制公网调用地址信息,这就是大模型的API endpoint URL;

复制Token信息,这就是大模型的API Key;

4.本地Dify接入模型在线服务 (EAS)

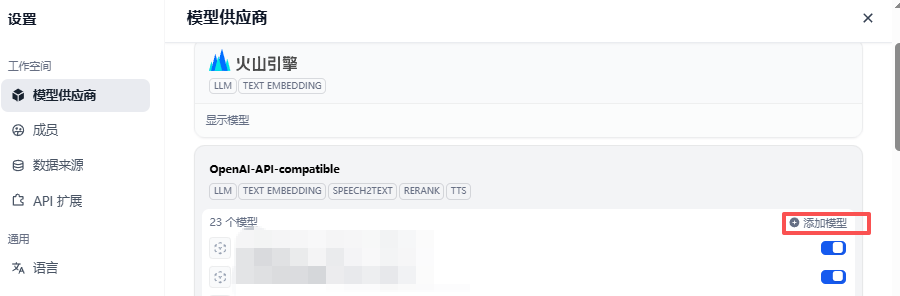

登录到本地的Dify平台,点击右上角用户按钮,然后点击设置按钮:

然后点击模型供应商,然后再选择OpenAI-API-compatible,点击显示模型,如果没有可以添加该模型供应商;

然后点击添加模型按钮

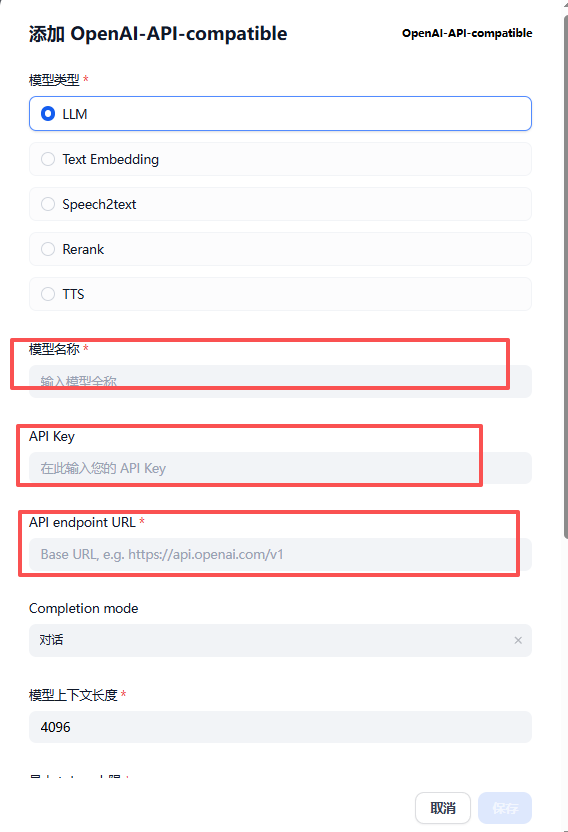

选择LLM模型

模型名称填写EAS部署时,运行指令定义的大模型应用名称;

VLLM_SKIP_SAMPLER_CPU_WARMUP=1 python -m vllm.entrypoints.openai.api_server --served-model-name [大模型应用名称] --model [大模型权重的文件目录] -tp 2 --gpu-memory-utilization=0.9 --max-model-len 32768

API Key填写EAS服务的概览页面----查看调用信息的Token信息;(第三章最后提到)

API endpoint URL填写EAS服务的概览页面----查看调用信息的公网调用地址信息;(第三章最后提到)

注意:直接复制公网调用地址,可能会报错失败,可以再网址最后加上/V1,再尝试,可以成功访问;

例如:http://xxxxxxxxxxx.yyyyyyyyy.cn-shanghai.pai-eas.aliyuncs.com/v1

然后Function calling、Stream function calling、Vision 支持按照实际需求来配置;

然后点击保存按钮之后,模型成功添加,之后能够顺利调用模型;(需要EAS服务处于运行状态)