OpenCV 图像拼接实战:从特征检测到全景融合

目录

一、前期准备:环境与核心函数定义

1. 图像显示函数(cv_show)

2. 特征检测与描述符提取函数(detectAndDescribe)

二、步骤拆解:从图像读取到全景融合

步骤 1:读取待拼接图像

步骤 2:提取两张图像的 SIFT 特征

步骤 3:特征匹配与筛选(去除错误匹配)

3.1 暴力匹配与 Ratio 测试

3.2 可视化匹配结果

步骤 4:计算透视变换矩阵(Homography)

步骤 5:图像变换与融合

5.1 透视变换图像 B

在计算机视觉领域,图像拼接技术是实现全景图生成、监控画面拼接、遥感图像合成的核心基础。它通过找到多张重叠图像的共性特征,将其统一到同一坐标系下,最终合成一幅视野更广阔的完整图像。本文将基于 OpenCV,从特征检测→特征匹配→透视变换→图像融合四个关键步骤,手把手教你实现双图拼接,代码可直接运行!

一、前期准备:环境与核心函数定义

首先确保已安装opencv-python和numpy库(若未安装,执行pip install opencv-python numpy)。

我们先定义两个高频使用的工具函数:图像显示函数和特征检测函数,为后续步骤复用。

1. 图像显示函数(cv_show)

简化 OpenCV 的图像显示流程,避免重复写imshow和waitKey:

import cv2

import numpy as np

import sysdef cv_show(name, img):"""自定义图像显示函数:param name: 窗口名称:param img: 待显示图像"""cv2.imshow(name, img)cv2.waitKey(0) # 按任意键关闭窗口cv2.destroyWindow(name) # 释放窗口资源,避免内存占用2. 特征检测与描述符提取函数(detectAndDescribe)

使用SIFT 算法(尺度不变特征变换)提取图像的关键点和描述符 ——SIFT 能在尺度、旋转、光照变化下保持特征稳定性,是图像匹配的经典选择:

def detectAndDescribe(image):"""提取图像的SIFT特征点和描述符:param image: 输入彩色图像(BGR格式):return: kps(关键点对象列表)、kps_float(关键点坐标数组)、des(描述符数组)"""# 1. 转为灰度图(特征检测无需颜色信息,减少计算量)gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)# 2. 创建SIFT对象(OpenCV 4.x需注意:SIFT在contrib库中,需确保安装opencv-contrib-python)sift = cv2.SIFT_create()# 3. 检测关键点并计算描述符(mask=None表示对全图检测)# kps:关键点对象列表(包含位置、尺度、方向等信息)# des:描述符数组(shape=(关键点数量, 128),每个关键点用128维向量描述)(kps, des) = sift.detectAndCompute(gray, None)# 4. 将关键点坐标转为NumPy数组(方便后续计算)# kp.pt 是关键点的(x, y)坐标(浮点数)kps_float = np.float32([kp.pt for kp in kps])return (kps, kps_float, des)二、步骤拆解:从图像读取到全景融合

以两张有重叠区域的图像(1.jpg和2.jpg)为例,完整实现拼接流程。

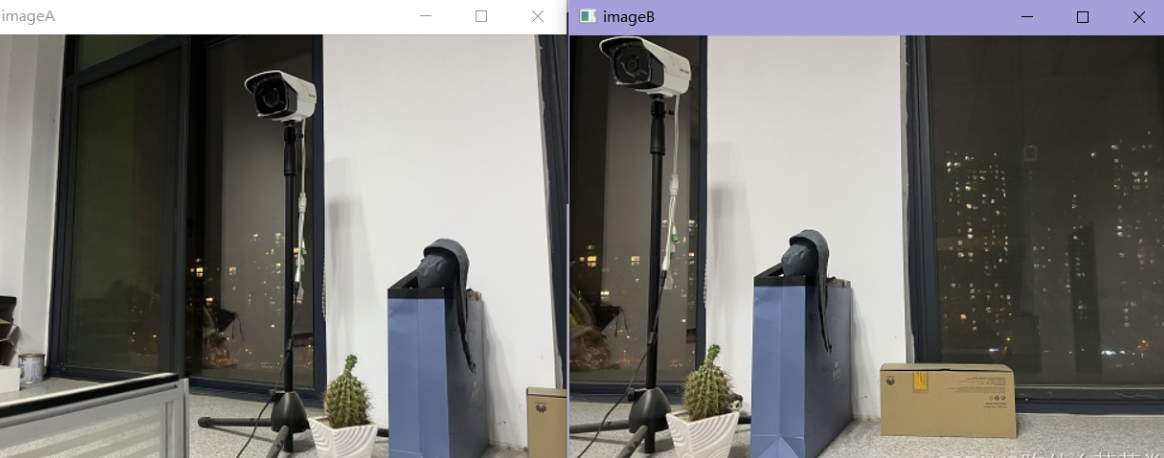

步骤 1:读取待拼接图像

首先读取两张图像,查看原始效果(需确保图像路径正确,建议将图像与代码放在同一目录):

# 读取两张待拼接图像

imageA = cv2.imread('1.jpg') # 左侧图像(作为拼接基准)

imageB = cv2.imread('2.jpg') # 右侧图像(需变换到左侧图像坐标系)# 显示原始图像,确认读取成功

cv_show('Original Image A', imageA)

cv_show('Original Image B', imageB)注意:若图像尺寸过大,可先缩放(如imageA = cv2.resize(imageA, (0,0), fx=0.5, fy=0.5)),减少后续计算耗时。

步骤 2:提取两张图像的 SIFT 特征

调用detectAndDescribe函数,分别获取两张图像的关键点和描述符:

# 提取图像A的特征

(kpsA, kps_floatA, desA) = detectAndDescribe(imageA)

# 提取图像B的特征

(kpsB, kps_floatB, desB) = detectAndDescribe(imageB)# 打印特征信息(可选,用于验证)

print(f"图像A关键点数量:{len(kpsA)},描述符维度:{desA.shape}")

print(f"图像B关键点数量:{len(kpsB)},描述符维度:{desB.shape}")

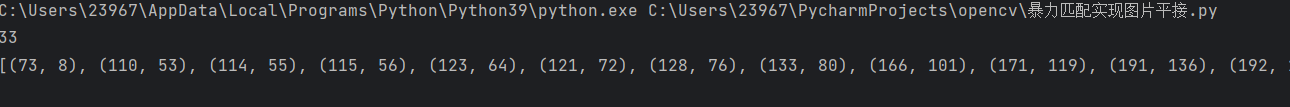

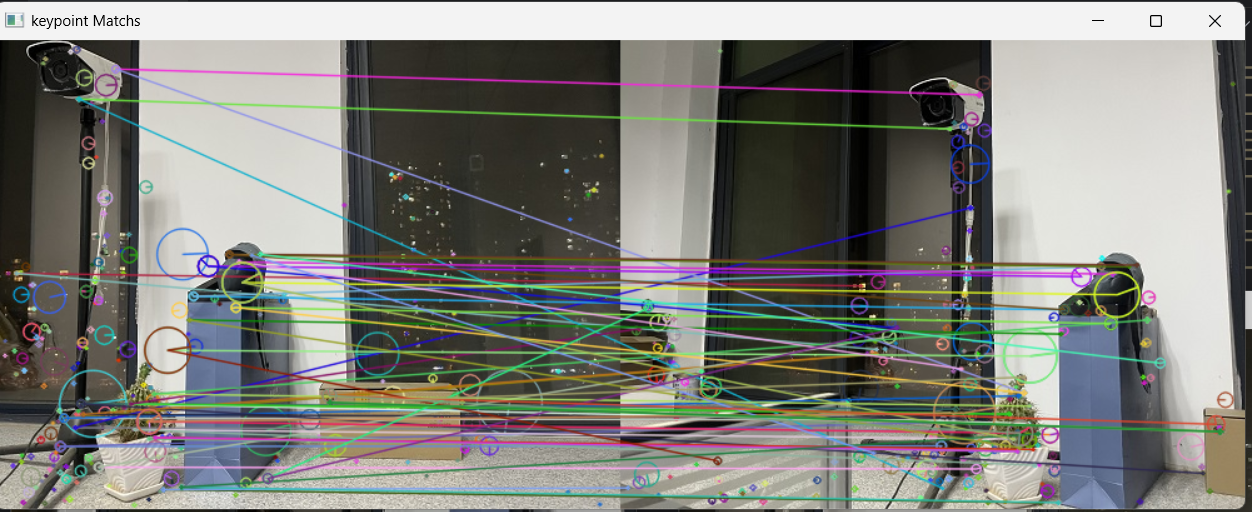

步骤 3:特征匹配与筛选(去除错误匹配)

特征描述符的作用是 “量化特征”,我们通过暴力匹配器(BFMatcher) 找到两张图像中相似的特征对,再通过 “_ratio 测试” 筛选出高质量匹配(去除错误匹配)。

3.1 暴力匹配与 Ratio 测试

# 1. 创建暴力匹配器(默认使用L2距离,适合SIFT等浮点型描述符)

matcher = cv2.BFMatcher()# 2. KNN匹配(K=2,为每个特征点找Top-2相似的匹配)

# 输入:desB(查询图像描述符)、desA(目标图像描述符)、k=2

rawMatches = matcher.knnMatch(desB, desA, 2)# 3. Ratio测试筛选高质量匹配(David Lowe提出,剔除错误匹配)

# 原理:若最佳匹配的距离远小于次佳匹配(如比值<0.65),则认为是正确匹配

good_matches = [] # 存储高质量匹配对(kNN匹配结果)

valid_matches = [] # 存储有效匹配的关键点索引(用于后续计算变换矩阵)for m in rawMatches:# 确保有2个匹配结果,且最佳匹配距离 < 0.65*次佳匹配距离if len(m) == 2 and m[0].distance < 0.65 * m[1].distance:good_matches.append(m)# 记录匹配对在两张图像中的关键点索引(trainIdx对应A,queryIdx对应B)valid_matches.append((m[0].trainIdx, m[0].queryIdx))# 打印匹配结果(验证筛选效果)

print(f"原始匹配对数:{len(rawMatches)}")

print(f"筛选后匹配对数:{len(good_matches)}")3.2 可视化匹配结果

通过drawMatchesKnn函数绘制匹配对,直观查看筛选效果:

# 绘制高质量匹配对(flags=DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS:显示关键点大小和方向)

match_vis = cv2.drawMatchesKnn(img1=imageB, kp1=kpsB, # 查询图像(B)及关键点img2=imageA, kp2=kpsA, # 目标图像(A)及关键点matches1to2=good_matches, # 筛选后的匹配对outImg=None, flags=cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS

)# 显示匹配结果

cv_show('Good Keypoint Matches', match_vis)

步骤 4:计算透视变换矩阵(Homography)

透视变换矩阵(3x3)能将图像 B 的坐标系转换到图像 A 的坐标系,核心是通过cv2.findHomography函数计算(需至少 4 对有效匹配点)。

# 1. 验证有效匹配点数量(至少4个才能计算透视矩阵)

if len(valid_matches) > 4:# 2. 提取匹配对的关键点坐标# ptsA:图像A中与B匹配的关键点坐标(shape=(N, 2))ptsA = np.float32([kps_floatA[i] for (i, _) in valid_matches])# ptsB:图像B中与A匹配的关键点坐标(shape=(N, 2))ptsB = np.float32([kps_floatB[j] for (_, j) in valid_matches])# 3. 计算透视变换矩阵H和内点掩码mask# method=cv2.RANSAC:使用RANSAC算法剔除外点(错误匹配)# ransacReprojThreshold=10:重投影误差阈值(超过则视为外点)(H, mask) = cv2.findHomography(srcPoints=ptsB, # 源点(图像B的关键点)dstPoints=ptsA, # 目标点(图像A的关键点)method=cv2.RANSAC, ransacReprojThreshold=10)print("透视变换矩阵H:")print(H) # 输出3x3矩阵,用于后续图像变换

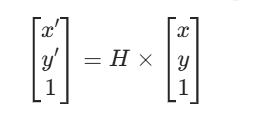

else:# 匹配点不足,无法拼接print("错误:未找到4个以上有效匹配点,无法进行拼接!")sys.exit() # 退出程序透视矩阵 H 含义:通过H可将图像 B 的任意点(x,y)转换为图像 A 坐标系下的点(x',y'),公式为:

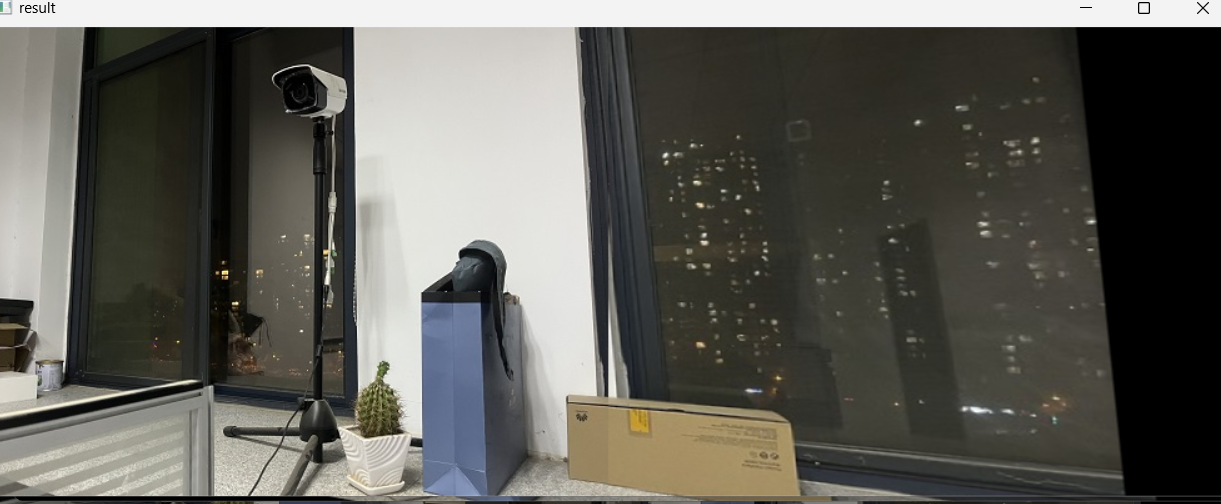

步骤 5:图像变换与融合

通过透视矩阵H将图像 B 变换到图像 A 的坐标系,再将两张图像合并,处理拼接缝隙。

5.1 透视变换图像 B

# 1. 计算变换后图像的尺寸(宽度=A宽+B宽,高度=A和B的最大高度,避免裁剪)

result_width = imageA.shape[1] + imageB.shape[1] # 拼接后总宽度

result_height = max(imageA.shape[0], imageB.shape[0]) # 拼接后总高度# 2. 对图像B执行透视变换(将B转到A的坐标系)

# warpPerspective:根据H变换图像,dsize=(宽度, 高度)

warped_B = cv2.warpPerspective(src=imageB, M=H, dsize=(result_width, result_height)

)# 显示变换后的图像B

cv_show('Warped Image B', warped_B)