[计算机毕业设计]基于深度学习的噪声过滤音频优化系统研究

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

最新最全计算机专业毕设选题精选推荐汇总

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于深度学习的噪声过滤音频优化系统研究

课题背景和意义

随着智能设备和语音助手的广泛应用,音频识别技术在日常生活中变得愈加重要。然而,现实环境中存在各种噪声(如交通声、人群声和设备噪声),这对音频识别的准确性造成了显著影响。传统的音频处理技术在噪声环境下往往难以有效提取清晰的语音信号,导致识别率下降。开发一种能够在嘈杂环境中有效工作的音频识别系统显得尤为重要。深度学习作为一种强大的数据驱动方法,近年来在声音处理领域取得了显著进展。通过构建复杂的神经网络模型,深度学习能够学习到音频信号的深层特征,从而在噪声环境中实现更高的识别准确性。

实现技术思路

一、检测方法

1.1 卷积神经网络

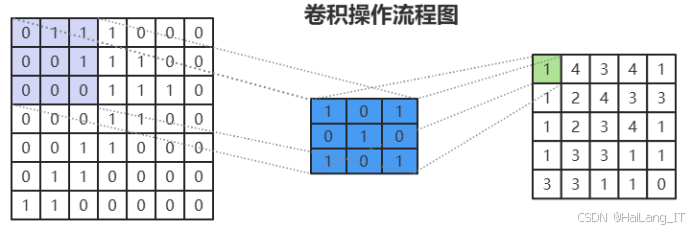

卷积神经网络(CNN)通常由三个主要部分组成:卷积层、池化层和全连接层。卷积层是CNN的核心组件,负责提取输入数据的局部特征,尤其在处理图像和声音等高维数据时显得尤为重要。通过使用多个可学习的卷积核在输入数据上滑动,卷积层进行逐点的卷积运算,生成特征图。这些卷积核能够有效识别图像中的边缘、角点以及其他重要特征,通过激活函数(如ReLU)引入非线性,使模型能够学习到更复杂的特征表示。卷积层的结构设计使得其在空间上具有局部连接的特性,能够有效捕捉输入数据的局部特征,并通过权重共享的方式减少模型的参数数量,从而提高计算效率。这种特性使得卷积层在处理视觉任务时表现出色,能够保持特征的平移不变性,从而增强模型的鲁棒性。卷积层通过多层叠加,能够逐步提取更高层次的特征,最终形成对图像内容的深刻理解。

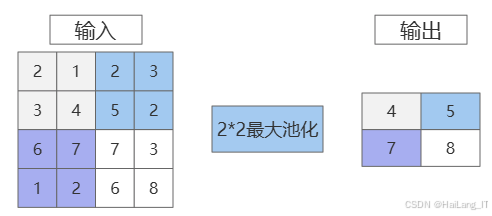

池化层是CNN中的另一个重要组成部分,主要用于降低特征图的空间维度,有效减少计算量和过拟合风险,同时提取更具代表性的特征。池化层的常用方法包括最大池化和平均池化,其中最大池化通过选择池化窗口内的最大值进行下采样,从而保留最显著的特征。池化操作通常在卷积层之后进行,其主要目的是帮助模型在一定程度上保持特征的不变性,避免因为小的变换(如平移或旋转)而导致特征的丢失。通过池化层,特征图的尺寸被显著减小,这不仅降低了后续计算的复杂度,还有助于提高模型的训练效率和泛化能力。池化层的引入使得模型在面对复杂的输入时,能够更好地提取和保留关键信息,增强模型对输入数据的适应性。池化过程还能够减少运算量,降低内存占用,从而加速训练过程。

全连接层位于CNN的最后部分,负责将提取到的特征映射到最终的输出,例如分类或回归结果。在全连接层中,前一层的每个神经元与当前层的每个神经元都有连接,这种全连接的方式使得模型能够综合所有提取的特征,以进行更高层次的决策。全连接层通常采用激活函数(如Softmax),使得输出能够表示为不同类别的概率分布,从而进行分类任务。全连接层的设计使得模型能够学习到复杂的特征组合,增强了模型的表达能力和预测能力。通过这一层,模型能够将低级特征转化为高层语义信息,从而实现最终的分类或回归。

1.2长短期记忆网络

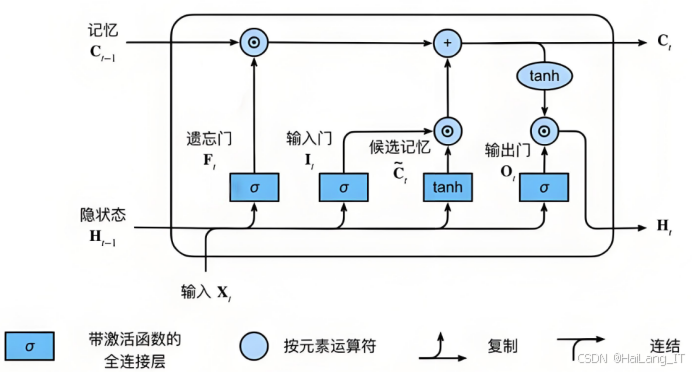

长短期记忆网络(LSTM)是一种特殊的循环神经网络(RNN),专门设计用于处理和预测时间序列数据。LSTM的主要组成部分包括输入门、遗忘门和输出门。输入门控制当前输入的信息有多少能够进入单元状态,它通过sigmoid激活函数决定哪些信息需要保留,同时使用tanh激活函数生成候选值来更新单元状态。遗忘门则决定哪些信息需要从单元状态中丢弃。通过sigmoid函数,遗忘门可以选择性地过滤掉不再需要的信息,从而保持对重要信息的关注。输出门则控制单元状态的输出,决定哪些信息将传递到下一层或下一时刻的计算。

LSTM的设计使其能够有效解决传统RNN在长序列训练过程中容易出现的梯度消失和梯度爆炸问题。通过引入门控机制,LSTM能够在较长时间跨度内保持信息的有效性。这种特性使得LSTM特别适合处理语言建模、语音识别、时间序列预测等任务。在这些应用中,LSTM能够根据历史数据动态调整其状态,从而捕捉长期依赖关系,增强模型对序列数据的理解能力。

LSTM网络的结构相对复杂,但这种复杂性带来了更强的表现力。每个LSTM单元内部包含多个参数,控制输入、遗忘和输出的门控机制。通过这些门的协同作用,LSTM能够在时间序列数据中提取重要特征,记住有用的信息并遗忘无关的信息。这种灵活性使得LSTM在许多应用场景中相较于传统RNN表现出色,尤其在需要长时间依赖的信息处理任务中展现出优势。

深度学习模型结合了卷积神经网络(CNN)和长短期记忆网络(LSTM),旨在实现噪声过滤以优化音频信号。输入层接受时频图作为输入数据,这些时频图可以是梅尔频率倒谱系数(MFCC)或短时傅里叶变换(STFT)生成的图像,输入的形状为 (时间步长, 特征维度, 1)。模型的第一部分是卷积层,首先通过使用二维卷积操作的卷积层1,卷积核大小设为 (3, 3),激活函数选择ReLU,输出通道数为32。接下来,池化层1采用最大池化层,池化窗口大小为 (2, 2),用于下采样特征图,减少计算量。卷积层2再次使用二维卷积操作,卷积核大小同样为 (3, 3),输出通道数增加到64,并继续使用ReLU激活函数。池化层2再次进行最大池化操作,进一步降低特征图的维度。最后,通过Flatten层将卷积层的输出展平,为后续的全连接层做准备。

下一部分是全连接层,连接一个或多个全连接层,激活函数仍为ReLU,节点数设定为128,以增强模型的表达能力。随后引入LSTM层,使用64个LSTM单元处理时序特征,捕捉音频信号的长期依赖关系。这一部分对于处理音频信号中的时间特性至关重要。最后,输出层使用全连接层,节点数与音频信号输出的维度相同,激活函数为线性,以生成经过噪声过滤后的音频信号。整体架构设计结合了CNN在特征提取方面的优势以及LSTM在时序建模上的能力,使得模型能够有效处理复杂的音频数据,提高噪声过滤的准确性和效果。

二、实验及结果分析

在开始训练之前,确保已安装TensorFlow,并且拥有稳定的网络连接和足够的磁盘空间以下载超过1GB的训练数据。此外,训练过程可能需要几个小时,因此请确保你有一台可以长时间使用的机器。在准备工作中,用户需要确保Python环境配置正确,并安装TensorFlow库,可以使用以下命令安装:

收集多种环境下的音频数据,包括清晰的语音片段和不同类型的噪声(如交通噪声、人群噪声、风声等),可以通过访问公开数据集获取,或者通过专门的录音设备在各种实际环境中自行录制,确保所收集的数据涵盖多种场景和说话者,以提高模型的泛化能力和适应性。使用音频处理工具(Audacity)对音频进行人工标注,标记出清晰的语音片段和背景噪声。手动标注虽然耗时,但可以确保数据的准确性,帮助模型更好地学习,还需要剔除音频中的静默部分,聚焦于有效的语音信号。可以通过设定音量阈值来判断静默段,并使用音频处理库(Librosa)进行自动化处理。所有的音频信号都应进行归一化处理,这样可以确保数据在相同的尺度上,减少模型训练时的偏差。归一化处理可以提高神经网络的收敛速度,确保模型在训练过程中更稳定。

import librosa

import numpy as npdef preprocess_audio(file_path):# 加载音频文件signal, sr = librosa.load(file_path, sr=None)# 去除静默部分non_silent_intervals = librosa.effects.split(signal, top_db=20)segments = [signal[start:end] for start, end in non_silent_intervals]# 合并处理后的片段processed_signal = np.concatenate(segments)# 归一化normalized_signal = processed_signal / np.max(np.abs(processed_signal))return normalized_signal, sr特征提取阶段,使用梅尔频率倒谱系数(MFCC)作为主要特征,因为MFCC能够有效捕捉音频的音质和语音特征。MFCC通过将音频信号分帧、加窗、进行傅里叶变换、通过梅尔滤波器组处理以及最终的离散余弦变换等步骤获得。这些步骤能提取出音频信号中频率的变化,使得模型能够更好地理解和分类音频信号中的内容。在特征提取过程中,还可以考虑其他特征,如谱图、Chroma特征或零交叉率等。这些特征能够提供更丰富的信息,帮助模型捕捉更多的音频信号细节。结合不同类型的特征将增强模型的表现力,使其在复杂的噪声环境中更具鲁棒性。

import librosa

import numpy as np

import osdef extract_mfccs_from_directory(directory, n_mfcc=13, max_length=100):mfccs_list = []labels = []for filename in os.listdir(directory):if filename.endswith('.wav'): # 只处理.wav文件file_path = os.path.join(directory, filename)signal, sr = librosa.load(file_path, sr=None)# 提取 MFCC 特征mfccs = librosa.feature.mfcc(y=signal, sr=sr, n_mfcc=n_mfcc)mfccs = np.mean(mfccs.T, axis=0) # 计算每个特征的均值# 限制特征长度if len(mfccs) > max_length:mfccs = mfccs[:max_length]else:mfccs = np.pad(mfccs, (0, max_length - len(mfccs)), 'constant')mfccs_list.append(mfccs)labels.append(get_label_from_filename(filename)) # 从文件名提取标签return np.array(mfccs_list), np.array(labels)def get_label_from_filename(filename):# 根据文件名定义标签提取逻辑# 例如, "traffic_noise_1.wav" -> "traffic"return filename.split('_')[0]# 示例使用

directory = 'path_to_audio_directory'

mfcc_features, labels = extract_mfccs_from_directory(directory)结合卷积神经网络(CNN)和长短期记忆网络(LSTM)的深度学习模型架构,使其能够充分发挥两者的优势。CNN在处理图像数据时表现出色,能够有效提取时频图中的空间特征,而LSTM则能够处理时间序列数据中的长期依赖关系。该模型架构包括输入层、多个卷积层、池化层、Flatten层、全连接层和LSTM层,最终输出经过噪声过滤的音频信号。卷积层的设计可以包括多层卷积和池化操作,以逐步抽取音频特征的高层表示。通过使用ReLU激活函数,模型能够引入非线性,增强特征提取的能力。LSTM层则用于对处理后的特征进行时序建模,使得模型能够捕捉音频中的时间相关性,处理长时间依赖关系。这种复杂的模型架构能够适应音频信号的多样性,使得模型在不同的噪声条件下都能保持较高的性能。

import tensorflow as tf

from tensorflow.keras import layers, modelsdef create_model(input_shape):model = models.Sequential()# 卷积层1model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=input_shape))model.add(layers.MaxPooling2D((2, 2)))# 卷积层2model.add(layers.Conv2D(64, (3, 3), activation='relu'))model.add(layers.MaxPooling2D((2, 2)))# Flatten层model.add(layers.Flatten())# 全连接层model.add(layers.Dense(128, activation='relu'))# LSTM层model.add(layers.Reshape((1, 128))) # Reshape为LSTM输入格式model.add(layers.LSTM(64))# 输出层model.add(layers.Dense(output_dim, activation='linear')) # output_dim为音频信号输出维度return modelinput_shape = (time_steps, feature_dim, 1) # 需要根据实际数据设置

model = create_model(input_shape)模型训练阶段,采用均方误差(MSE)作为损失函数,评估模型输出与真实语音信号之间的差异。使用Adam或RMSprop优化算法进行模型训练,调整学习率和其他超参数以提高收敛速度和准确性。在训练过程中,可以通过监控训练集和验证集的损失和准确率,及时调整超参数,以获得最佳的模型性能。

为了进一步增强模型的鲁棒性,进行数据增强也是非常必要的。通过添加背景噪声、进行音频变速、改变音高和添加混响等方法,可以增加模型对不同环境的适应能力。这些数据增强手段不仅能提高模型的泛化能力,还能有效避免过拟合现象的发生。

from sklearn.model_selection import train_test_split

from tensorflow.keras.callbacks import EarlyStopping, ModelCheckpoint# 假设 mfcc_features 和 labels 已经准备好

X_train, X_val, y_train, y_val = train_test_split(mfcc_features, labels, test_size=0.2, random_state=42)# 需要调整输入形状

X_train = X_train.reshape(X_train.shape[0], X_train.shape[1], 1) # 调整为 (样本数, 特征维度, 1)

X_val = X_val.reshape(X_val.shape[0], X_val.shape[1], 1)# 创建模型

model = create_model((X_train.shape[1], 1)) # 输入形状为 (特征维度, 1)# 编译模型

model.compile(optimizer='adam', loss='mean_squared_error', metrics=['mae'])# 设置回调函数

early_stopping = EarlyStopping(monitor='val_loss', patience=10, restore_best_weights=True)

model_checkpoint = ModelCheckpoint('best_model.h5', save_best_only=True, monitor='val_loss')# 训练模型

history = model.fit(X_train, y_train, epochs=100, batch_size=32, validation_data=(X_val, y_val), callbacks=[early_stopping, model_checkpoint])# 可视化训练过程

import matplotlib.pyplot as pltplt.plot(history.history['loss'], label='train_loss')

plt.plot(history.history['val_loss'], label='val_loss')

plt.title('Model Loss')

plt.ylabel('Loss')

plt.xlabel('Epoch')

plt.legend()

plt.show()使用准确率、召回率和F1-score等指标来评估模型的性能,以确保其在不同噪声环境下的有效性。此外,采用k折交叉验证的方法可以帮助确认模型的泛化能力,防止过拟合。在k折交叉验证中,将数据集分为k个子集,依次使用每个子集作为验证集,其余作为训练集,这样可以更全面地评估模型的性能。

from sklearn.metrics import classification_report# 预测并评估

y_pred = model.predict(X_test)

report = classification_report(y_test, y_pred)

print(report)# k折交叉验证示例

from sklearn.model_selection import KFoldkf = KFold(n_splits=5)

for train_index, val_index in kf.split(X):X_train, X_val = X[train_index], X[val_index]y_train, y_val = y[train_index], y[val_index]model.fit(X_train, y_train, epochs=50, validation_data=(X_val, y_val))将训练好的模型部署到实际应用中,以实现实时音频识别和噪声过滤。可以使用Flask等Web框架将模型集成到Web应用中,或者使用TensorFlow Serving进行高效的模型部署。在处理实时音频流时,需确保保持低延迟,以提高用户体验。

在部署过程中,需考虑系统的可扩展性和可维护性,确保模型能够适应未来的数据和需求变化。此外,定期监测模型的性能,及时进行更新和优化,以保持其在实际应用中的有效性。

from flask import Flask, request, jsonify

import numpy as npapp = Flask(__name__)@app.route('/filter', methods=['POST'])

def filter_audio():audio_data = request.files['audio']# 处理音频数据并进行预测signal, sr = preprocess_audio(audio_data)mfcc_features = extract_mfcc(signal, sr)mfcc_features = np.expand_dims(mfcc_features, axis=0) # 为模型输入添加批次维度filtered_audio = model.predict(mfcc_features)# 返回处理后的音频return jsonify({'filtered_audio': filtered_audio.tolist()})if __name__ == '__main__':app.run(debug=True)最后

我是海浪学长,创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!