ollama离线部署加载Qwen3-0.6b模型

Ollama部署

ollama是一个开源工具(ollama.ai),允许用户在 本地设备(无需联网)运行 LLM。终端用户通过ollama低成本体验大模型能力

支持模型:

- llama2(7B/13B/70B 参数)

- mistral(7B 高效模型)

- codellama(代码生成专用)

- phi(微软轻量模型)

典型使用场景:

- 离线环境使用 LLM

- 数据敏感场景(避免云端传输)

- 开发者快速测试模型

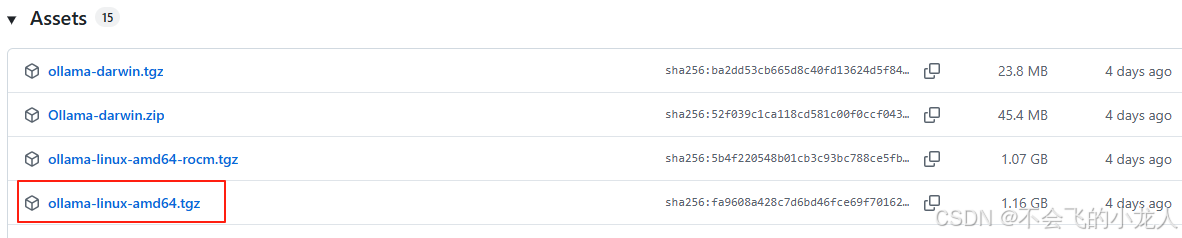

Github下载

https://github.com/ollama/ollama/releases/tag/v0.11.6

根据所需环境下载,本文在linux下采用二进制文件直接部署,因此下载ollama-linux-amd64.tgz版本,解压后直接可运行;

# 官方提供的安装脚本

# curl -fsSL https://ollama.com/install.sh | sh#下载后解压

tar -zxvf ollama-linux-amd64.tgz

#移动并重命名

mv ollama-linux-amd64 ollamahttps://github.com/ollama/ollama/blob/main/docs/linux.md

启动Ollama服务

进入ollama本地bin目录下,通过命令ollama serve启动服务后。

设置ollama服务api其它主机可访问,默认为localhost只能本机访问api,设置OLLAMA_HOST环境变量:export OLLAMA_HOST=0.0.0.0,此为临时性环境变量配置(生产使用需配置到系统文件中),或在启动命令前加上变量参数:OLLAMA_HOST=0.0.0.0 ./ollama serve

执行结果

[root@centos72 bin]# OLLAMA_HOST=0.0.0.0 ./ollama serve

time=2025-08-25T20:11:28.551+08:00 level=INFO source=routes.go:1318 msg="server config" env="map[CUDA_VISIBLE_DEVICES: GPU_DEVICE_ORDINAL: HIP_VISIBLE_DEVICES: HSA_OVERRIDE_GFX_VERSION: HTTPS_PROXY: HTTP_PROXY: NO_PROXY: OLLAMA_CONTEXT_LENGTH:4096 OLLAMA_DEBUG:INFO OLLAMA_FLASH_ATTENTION:false OLLAMA_GPU_OVERHEAD:0 OLLAMA_HOST:http://0.0.0.0:11434 OLLAMA_INTEL_GPU:false OLLAMA_KEEP_ALIVE:5m0s OLLAMA_KV_CACHE_TYPE: OLLAMA_LLM_LIBRARY: OLLAMA_LOAD_TIMEOUT:5m0s OLLAMA_MAX_LOADED_MODELS:0 OLLAMA_MAX_QUEUE:512 OLLAMA_MODELS:/root/.ollama/models OLLAMA_MULTIUSER_CACHE:false OLLAMA_NEW_ENGINE:false OLLAMA_NEW_ESTIMATES:false OLLAMA_NOHISTORY:false OLLAMA_NOPRUNE:false OLLAMA_NUM_PARALLEL:1 OLLAMA_ORIGINS:[http://localhost https://localhost http://localhost:* https://localhost:* http://127.0.0.1 https://127.0.0.1 http://127.0.0.1:* https://127.0.0.1:* http://0.0.0.0 https://0.0.0.0 http://0.0.0.0:* https://0.0.0.0:* app://* file://* tauri://* vscode-webview://* vscode-file://*] OLLAMA_SCHED_SPREAD:false ROCR_VISIBLE_DEVICES: http_proxy: https_proxy: no_proxy:]"

time=2025-08-25T20:11:28.551+08:00 level=INFO source=images.go:477 msg="total blobs: 0"

time=2025-08-25T20:11:28.552+08:00 level=INFO source=images.go:484 msg="total unused blobs removed: 0"

time=2025-08-25T20:11:28.552+08:00 level=INFO source=routes.go:1371 msg="Listening on [::]:11434 (version 0.11.6)"

time=2025-08-25T20:11:28.552+08:00 level=INFO source=gpu.go:217 msg="looking for compatible GPUs"

time=2025-08-25T20:11:28.561+08:00 level=INFO source=gpu.go:379 msg="no compatible GPUs were discovered"

time=2025-08-25T20:11:28.561+08:00 level=INFO source=types.go:130 msg="inference compute" id=0 library=cpu variant="" compute="" driver=0.0 name="" total="15.5 GiB" available="13.4 GiB"

time=2025-08-25T20:11:28.561+08:00 level=INFO source=routes.go:1412 msg="entering low vram mode" "total vram"="15.5 GiB" threshold="20.0 GiB"

[GIN] 2025/08/25 - 20:12:36 | 200 | 311.063µs | 127.0.0.1 | HEAD "/"

[GIN] 2025/08/25 - 20:12:36 | 200 | 581.712µs | 127.0.0.1 | GET "/api/tags"

[GIN] 2025/08/25 - 20:15:56 | 200 | 67.59µs | 127.0.0.1 | HEAD "/"

[GIN] 2025/08/25 - 20:16:10 | 201 | 7.175086744s | 127.0.0.1 | POST "/api/blobs/sha256:9465e63a22add5354d9bb4b99e90117043c7124007664907259bd16d043bb031"

[GIN] 2025/08/25 - 20:16:10 | 200 | 473.445126ms | 127.0.0.1 | POST "/api/create"

[GIN] 2025/08/25 - 20:16:25 | 200 | 49.783µs | 127.0.0.1 | HEAD "/"

[GIN] 2025/08/25 - 20:16:25 | 200 | 778.794µs | 127.0.0.1 | GET "/api/tags"其它命令

#另起一个ssh窗口查看ollama版本

./ollama -v

#查看命令帮助

./ollama -h 或 ./ollama --help

#下载ollama平台模型(本地不存在,则会自动远程拉取)

ollama run MODEL_NAME

#查已下载的模型

./ollama list

#查看正在运行的模型

./ollama ps

#通过模型描述文件创建模型(注意文件绝对路径)

./ollama create MODEL_NAME -f Modelfile

#删除模型

./ollama rm MODEL_NAME集成Qwen3-0.6b模型

Qwen3 是 Qwen 系列中的最新一代大型语言模型,提供了一整套密集型和专家混合(MoE)模型。基于广泛的训练,Qwen3 在推理、指令遵循、代理能力和多语言支持方面取得了突破性进展。

受限于本地服务器硬件资源(虚拟VM服务器,无计算卡和高端显卡),本文是为了快速体验Qwen3大模型,因此使用Qwen3系例最小参数模型:Qwen3-0.6B,做集成使用;

Qwen3-0.6B 具有以下特点:

- 类型:因果语言模型

- 训练阶段:预训练 & 后训练

- 参数数量:0.6B

- 非嵌入参数数量:0.44B

- 层数:28

- 注意力头数(GQA):Q 为 16,KV 为 8

- 上下文长度:32,768

- 量化:q8_0

Ollama官方提供了模型下载,可直接运行ollama run MODEL_NAME,等待拉取完毕后即加载运行模型。

如果不使用Ollama官方平台提供的大模型,而是从Hugging Face的.bin或.safetensors平台获取的不同用户供献的调优模型,则Ollama并不直接支持 Hugging Face的.bin或.safetensors格式类型的大模型文件,它需要一种名为 GGUF 的二进制格式。

可以从modelscope平台(一个提供大模型和训练数据集的公共平台)下载Qwen3-0.6b-GGUF模型。

模型下载平台地址:https://modelscope.cn/models/Qwen/Qwen3-0.6B-GGUF/summary

#此处用git命令克隆

git clone https://www.modelscope.cn/Qwen/Qwen3-0.6B-GGUF.git#也可以通过oallam远程拉取模型

ollama run modelscope.cn/Qwen/Qwen3-0.6B-GGUF

#或直接通过ollama服务下载官方支持的qwen3版本(ollama提供了各种大模型下载)

ollama run qwen3:0.6b注意:ollama只支持非ollama服务架构运行的Qwen3下GGUF类型格式模型加载,请勿下错,否则需要额外转换成gguf才可以创建导入本地大模型

下载后,将Qwen3-0.6B-GGUF解压(如有压缩),并移动到合适目录

[root@centos72 Qwen3-0.6B-GGUF]# ll

total 624496

-rw-r--r-- 1 root root 11544 Aug 22 15:24 LICENSE

-rw-r--r-- 1 root root 556 Aug 25 20:15 Modelfile

-rw-r--r-- 1 root root 639446688 Aug 22 15:37 Qwen3-0.6B-Q8_0.gguf

-rw-r--r-- 1 root root 6352 Aug 22 15:24 README.md

-rw-r--r-- 1 root root 48 Aug 22 15:24 configuration.json

-rw-r--r-- 1 root root 270 Aug 22 15:24 params创建Modelfile导入文件

进入到Qwen3-0.6B-GGUF目录下,创建导入GGUF格式模型到ollama的服务下Modelfile配置文件。

#创建Modelfile文件,无后缀

touch Modelfile

#编辑模型配置

vim ModelfileModelfile配置

FROM ./Qwen3-0.6B-Q8_0.gguf# 模型参数设置

# 创造性控制(0-1)

PARAMETER temperature 0.7

# 核采样阈值

PARAMETER top_p 0.8

# 重复惩罚系数

PARAMETER repeat_penalty 1.05

# 上下文窗口长度

PARAMETER num_ctx 2048# 系统提示词

SYSTEM """

You are Qwen, a large language model developed by Tongyi Lab.

You are a helpful assistant that answers questions accurately and concisely.

"""# 模板设置(针对 Qwen 格式)

TEMPLATE "{{ if .System }}<|im_start|>system

{{ .System }}<|im_end|>

{{ end }}{{ if .Prompt }}<|im_start|>user

{{ .Prompt }}<|im_end|>

{{ end }}<|im_start|>assistant

{{ .Response }}<|im_end|>"导入Qwen3-0.6b-GGUF模型

#在ollama本地bin目录下执行,其中Modelfile为Qwen3下载目录中的导入模型配置文件

./ollama create qwen3-0.6b -f /data3/models/Qwen3-0.6B-GGUF/Modelfile执行结果

[root@centos72 bin]# ./ollama create qwen3-0.6b -f /data3/models/Qwen3-0.6B-GGUF/Modelfile

gathering model components

copying file sha256:9465e63a22add5354d9bb4b99e90117043c7124007664901259bd16d043bb031 100%

parsing GGUF

using existing layer sha256:9465e63a22add5354d9bb4b99e90317043c7124007664907259bd16d043bb031

creating new layer sha256:64631f1262e4e87d47511bb7b405540321afd297f723f88bf72faae19992ddba

creating new layer sha256:2055182cae99c69884916784667894308b04d1218431dda896bc4f21dabb99d5

creating new layer sha256:f69fa739bb39a9594886d7a98aaa4a4d20e946ed856c57eb60fa22c6198ec44d

writing manifest

success 查看ollama已有的模型

[root@centos72 bin]# ./ollama list

NAME ID SIZE MODIFIED

qwen3-0.6b:latest 489740802b4d 639 MB 15 seconds ago 使用模型问答

完成上述ollama部署和qwen3的gguf格式模型文件导入后,即可通过ollama服务使用模型进行AI问答;

测试模型,ollama run qwen3-0.6b "xxx问题内容xxxx"

[root@centos72 bin]# ./ollama run qwen3-0.6b "你好,介绍一下人工智能"

<think>

好的,用户让我介绍一下人工智能。首先,我需要确保回答准确且全面。人工智能(AI)是计算机科学的一个分支,它使机器能够执行需要人类智能的任务,比如学习、推理、感知和决策等。接下来,我要考虑用户可能的背景。他们可能是学生、研究人员或普通大众,所以回答应该通俗易懂,避免使用过于专业的术语。同时,要涵盖人工智能的主要特点,如自主学习、适应环境、理解和创造能力等。然后,我需要检查是否有遗漏的信息点。比如,AI可以分为弱化型和强化型,或者分为机器学习和深度学习。这些分类也很重要,但可能用户更关心基础概念,所以保持简洁。另外,用户可能对AI的应用领域感兴趣,比如医疗、交通、金融等,但根据问题,重点还是介绍定义和基本特点。因此,在回答中应强调核心要素,同时给出简要的应用实例,帮助用户更好地理解。最后,确保语言流畅自然,信息准确无误。避免使用复杂句子结构,保持口语化,让用户容易理解和接受。

</think>人工智能(Artificial Intelligence, AI)是计算机科学的一个分支,旨在使机器具备学习、推理、感知和决策等人类智能的能力。它通过模拟人类思维过程,使机器能够执行诸如语言理解、图像识别、模式识别、自主学习等任务。人工智能的核心特点包括:

1. **自主学习**:通过不断优化模型参数,提高性能。

2. **适应性**:在不同环境下自动调整策略。

3. **理解与推理**:分析数据并得出结论。

4. **创造性**:生成新的内容或解决方案。AI的应用领域广泛,例如医疗诊断、自动驾驶、金融服务等,正在深刻改变各行各业。Chatbox集成

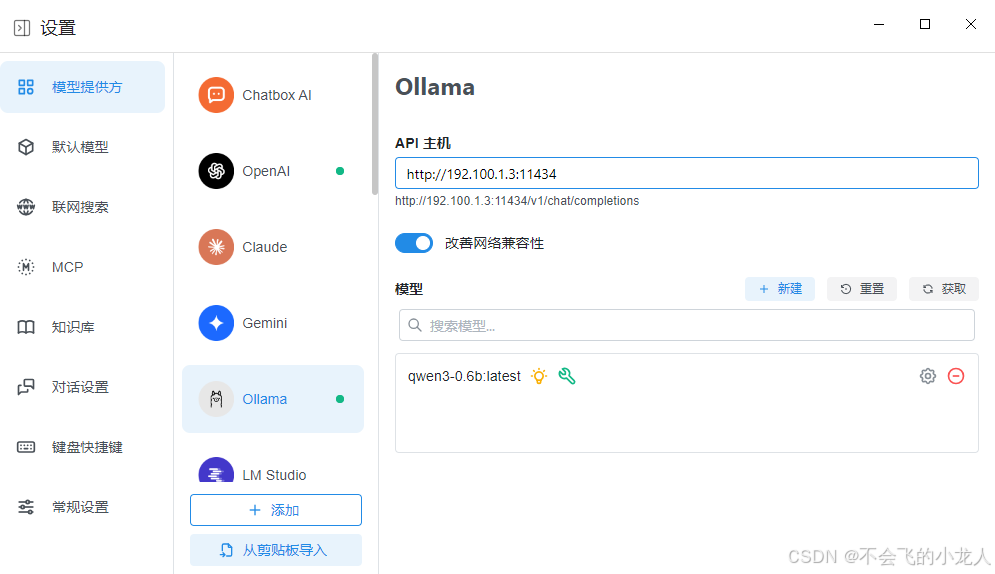

ollama提供了基于WEB服务API,因此可以使用UI工具来请求ollama的API,通过界面可视化、友好的体验大模型对话聊天;

本文中推荐一个比较好的大模型对话工具Chatbox,是一个简约强大的 AI 桌面客户端,支持最先进的多款大语言模型,让前沿的人工智能技术变成易于使用的生产力工具。

下载地址:https://chatboxai.app/zh#download

根据操作系统环境下载对应客户端,安装启动后,在设置》模型提供方》Ollama的配置界面中,输入:http://主机IP:端口,API主机IP即ollama的安装服务主机,端口默认11434。点击“获取”则会拉取ollama中的模型清单,选择“qwen3-0.6b:latest”即可;

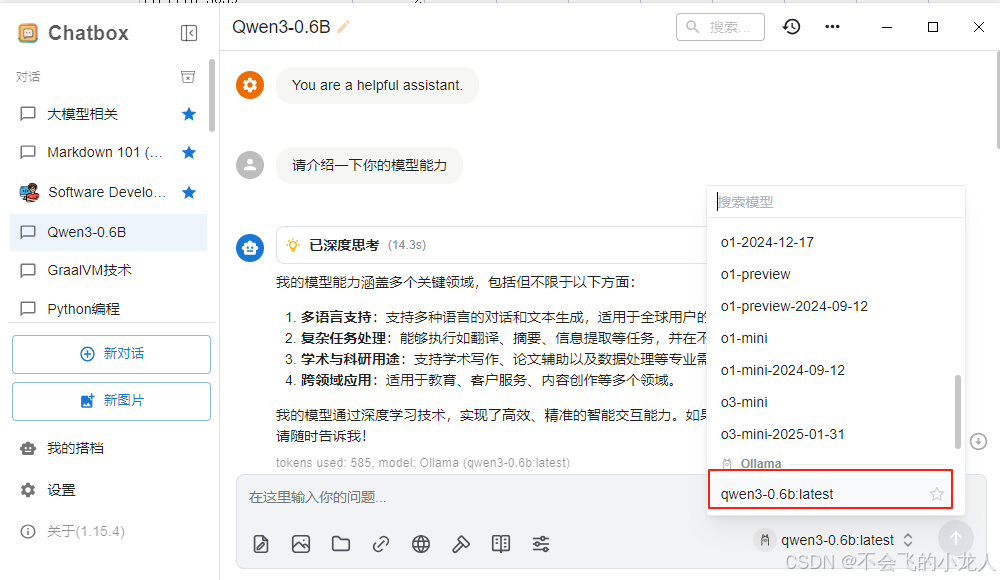

点击创建“新对话”(Qwen3-0.6B),选择Ollama/qwen3-0.6b:latest模型,输入你想问的内容,如:请介绍一下你的模型能力。

在深度思考十几秒后,开始回答,因是在纯CPU的虚拟VM(8核,16G内存)环境下运行,内容输出过程虽然不是很快,但还算比较顺畅,目测1秒钟能输出8~10个字符左右,整体能够接受;

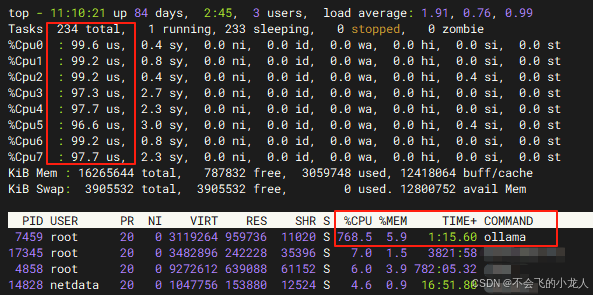

性能评测参考

在Chatbox中对ollama/Qwen3-0.6b进行对话时,监控ollama服务主机,CPU使用率达到768%(8核),甚至CPU有时快接近最大上限即8 * 每核100%,内存占用不高约6%左右;不难理解,大模型属于强计算类应用,纯纯的吃CPU资源(无独显,否则可卸载到GPU上计算)的大户,如果需要落地使用,还是需要好的计算卡或高端消费级显卡,否则要不了几个并发,会导致资源竞争性能出现严重挤兑,甚至停止服务;

参考:

https://ollama.com/library/qwen3

https://github.com/ollama/ollama/blob/main/docs/linux.md

https://modelscope.cn/

以及deepseek或qwen3提问整理