k8s交互桥梁:走进Client-Go

一、Client-Go是K8s生态的关键拼图

在云原生技术栈中,Kubernetes的API交互能力是构建自动化工具、自定义控制器(Operator)的核心基础。Client-Go作为Kubernetes官方Go语言客户端库,不仅支撑着kube-controller-manager等核心组件的运行,更成为开发者与K8s集群“对话”的首选工具。

它的价值体现在三层抽象:

底层封装:屏蔽HTTP/HTTPS、认证授权、URL路由等细节,提供统一的API调用入口;

缓存机制:通过本地缓存减少对API Server的直接请求,提升交互效率;

事件驱动:基于List-Watch实现资源变更的实时感知,为动态控制逻辑提供支撑。

二、Client-Go的模块协作体系

Client-Go的架构围绕“高效交互”与“灵活扩展”两大目标设计,各模块既独立封装又协同工作,形成完整的交互闭环。

2.1 客户端体系:多维度的资源操作入口

Client-Go提供四类客户端,覆盖不同场景的资源操作需求:

客户端类型 | 核心特性 | 典型场景 |

|---|---|---|

RESTClient | 基础HTTP客户端,支持原始REST操作,是其他客户端的底层依赖 | 自定义API请求、扩展客户端功能 |

Clientset | 类型安全的客户端集合,按Group/Version/Resource(GVR)自动生成代码 | 操作内置资源(Pod/Deployment等) |

DynamicClient | 动态操作任意资源(含CRD),基于非结构化数据(map[string]interface{}) | 处理未生成类型化代码的CRD资源 |

DiscoveryClient | 发现API Server支持的资源组、版本及资源信息 | 动态适配不同K8s版本的API差异 |

核心关系:Clientset和DynamicClient均基于RESTClient实现,前者通过代码生成工具(client-gen)实现类型封装,后者通过动态GVR标识实现通用操作。

2.2 缓存与监听体系:本地智能同步中枢

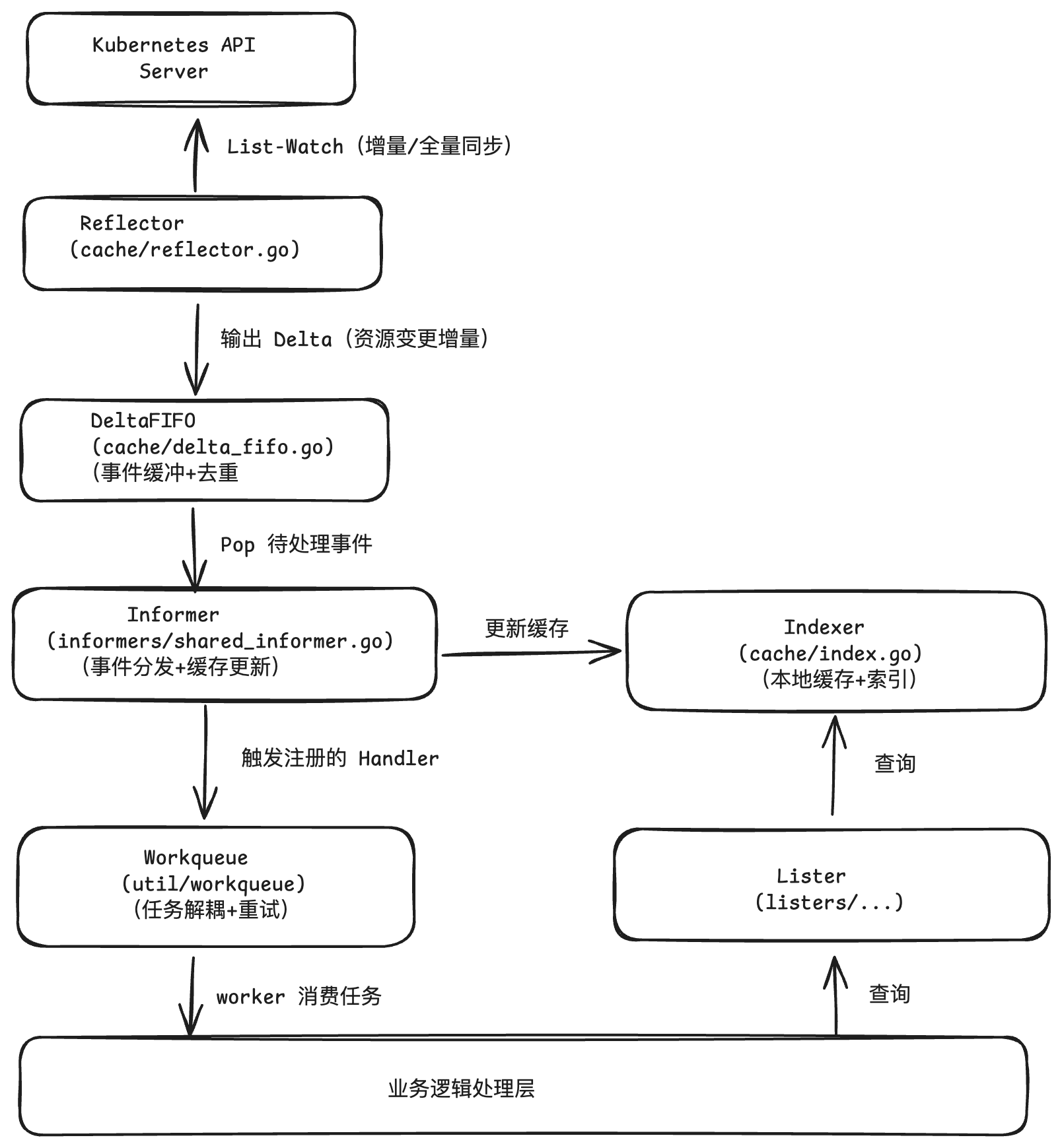

为减少API Server压力并实现实时感知,Client-Go设计了以Informer为核心的缓存监听体系,核心组件包括:

Reflector:与API Server交互的“数据同步器”,通过List-Watch机制拉取资源数据;

DeltaFIFO:事件“缓冲与去重器”,存储资源变更的增量(Delta)并保证处理顺序;

Indexer:带索引的本地缓存,支持按自定义字段快速查询资源;

Processor:事件“分发器”,将资源变更分发给注册的回调函数。

2.3 工具链:支撑生产级应用的辅助组件

Workqueue:任务队列,解耦事件监听与业务处理,支持重试、限流、延迟执行;

clientcmd:解析kubeconfig文件,生成与API Server通信的配置(rest.Config);

listers:基于Indexer的只读查询工具,提供类型安全的缓存查询方法。

三、核心组件解析

3.1 Clientset:类型安全的资源操作

Clientset是最常用的客户端,其核心是通过代码生成工具将K8s API的GVR映射为Go方法,实现编译期类型检查。

初始化流程:

解析kubeconfig生成

rest.Config(包含API Server地址、认证信息、QPS等);通过

kubernetes.NewForConfig聚合所有内置Group/Version的客户端;按“Group→Version→Resource”的层级调用方法(如

CoreV1().Pods(namespace))。

实战代码:

import ("context""k8s.io/client-go/kubernetes""k8s.io/client-go/tools/clientcmd""k8s.io/apimachinery/pkg/api/resource"corev1 "k8s.io/api/core/v1"metav1 "k8s.io/apimachinery/pkg/apis/meta/v1"

)// 1. 加载配置

config, err := clientcmd.BuildConfigFromFlags("", "~/.kube/config")

if err != nil { /* 处理错误 */ }// 2. 创建Clientset

clientset, err := kubernetes.NewForConfig(config)

if err != nil { /* 处理错误 */ }// 3. 操作Pod资源

// 创建Pod

newPod := &corev1.Pod{ObjectMeta: metav1.ObjectMeta{Name: "nginx"},Spec: corev1.PodSpec{Containers: []corev1.Container{{Name: "nginx", Image: "nginx:1.21"}},Resources: corev1.ResourceRequirements{Limits: corev1.ResourceList{"cpu": resource.MustParse("100m"), "memory": resource.MustParse("100Mi")},Requests: corev1.ResourceList{"cpu": resource.MustParse("100m"), "memory": resource.MustParse("100Mi")},},},

}

createdPod, err := clientset.CoreV1().Pods("default").Create(context.TODO(), newPod, metav1.CreateOptions{},

)// 查询Pod

pod, err := clientset.CoreV1().Pods("default").Get(context.TODO(), "nginx", metav1.GetOptions{},

)

3.2 DynamicClient:应对动态资源的万能工具

当操作CRD(自定义资源)时,若未生成类型化代码,DynamicClient是最佳选择。它通过schema.GroupVersionResource标识资源,用unstructured.Unstructured存储数据(键值对形式)。

实战代码:

CRD 声明,简单示例

apiVersion: apiextensions.k8s.io/v1 kind: CustomResourceDefinition metadata:name: redisclusters.cache.example.com spec:group: cache.example.comnames:kind: RedisClusterlistKind: RedisClusterListplural: redisclusterssingular: redisclustershortNames:- redisscope: Namespacedversions:- name: v1alpha1served: truestorage: trueschema:openAPIV3Schema:type: objectproperties:spec:type: objectrequired:- replicas - imageproperties:image:type: string# 副本数配置replicas:type: integerminimum: 1 # 最少1个节点maximum: 20 # 最多20个节点(可根据需求调整)description: "Redis集群的副本数量"status:type: objectproperties:readyReplicas:type: integerdescription: "当前就绪的Redis节点数量"phase:type: stringdescription: "集群状态"enum:- "Pending"- "Running"- "Scaling"- "Failed"

import ("context""k8s.io/client-go/dynamic""k8s.io/client-go/tools/clientcmd""k8s.io/apimachinery/pkg/runtime/schema""k8s.io/apimachinery/pkg/apis/meta/v1/unstructured"metav1 "k8s.io/apimachinery/pkg/apis/meta/v1"

)// 1. 初始化DynamicClient

config, _ := clientcmd.BuildConfigFromFlags("", "~/.kube/config")

dynClient, _ := dynamic.NewForConfig(config)// 2. 定义CRD的GVR(Group/Version/Resource)

gvr := schema.GroupVersionResource{Group: "cache.example.com",Version: "v1alpha1",Resource: "redisclusters", // 注意是复数形式

}// 3. 构造CRD资源(非结构化数据)

redisCluster := &unstructured.Unstructured{Object: map[string]interface{}{"apiVersion": "cache.example.com/v1alpha1","kind": "RedisCluster", // CRD的Kind(单数)"metadata": map[string]interface{}{"name": "test-redis","namespace": "default",},"spec": map[string]interface{}{"replicas": 3,"image": "redis:7.0",},},

}// 4. 创建CRD资源

result, _ := dynClient.Resource(gvr).Namespace("default").Create(context.TODO(), redisCluster, metav1.CreateOptions{},

)

3.3 Informer:资源变更的实时感知引擎

Informer是Client-Go的“灵魂组件”,通过List-Watch+本地缓存实现资源变更的高效监听,核心流程分为四步:

全量同步(List):启动时调用API Server的List接口,获取资源全量数据并初始化缓存;

增量监听(Watch):基于List返回的

ResourceVersion,监听后续变更;缓存更新:将变更转换为Delta(增量),更新本地Indexer;

事件分发:触发注册的回调函数(Add/Update/Delete)。

各单元协作图:

3.3.1 List-Watch机制:数据同步的核心协议

List-Watch由Reflector实现,确保本地缓存与API Server的数据一致性,核心逻辑在Reflector.ListAndWatch方法:

// 简化版ListAndWatch逻辑

func (r *Reflector) ListAndWatch(stopCh <-chan struct{}) error {var lastSyncResourceVersion stringfor {// 1. 全量List(首次或Watch失败后)list, err := r.listerWatcher.List(r.listOptions)if err != nil { /* 重试 */ }// 解析ResourceVersion(后续Watch的起点)resourceVersion := listMetaInterface.GetResourceVersion()// 同步到缓存r.syncWith(list, resourceVersion)lastSyncResourceVersion = resourceVersion// 2. 增量WatchwatchOpts.ResourceVersion = lastSyncResourceVersionwatcher, err := r.listerWatcher.Watch(watchOpts)if err != nil { /* 重试 */ }// 3. 处理Watch事件流if err := r.watchHandler(watcher, &lastSyncResourceVersion, stopCh); err != nil {watcher.Stop() // 断开后重试Listcontinue}}

}

关键保障:

连续性:通过

ResourceVersion确保增量同步不丢数据;容错性:Watch断开后自动重新List,避免数据中断。

3.3.2 DeltaFIFO:事件的智能缓冲

DeltaFIFO是Informer的“事件中枢”,负责存储资源变更的增量(Delta)并去重,核心特性:

Delta类型:

Added/Updated/Deleted/Replaced(全量同步用);去重逻辑:按资源的

Namespace/Name聚合,同一资源的多次变更合并为Delta链;FIFO队列:保证事件处理的顺序性。

// DeltaFIFO的Pop方法(简化)

func (f *DeltaFIFO) Pop(process PopProcessFunc) (interface{}, error) {f.lock.Lock()defer f.lock.Unlock()for {key := f.queue[0] // 取队列头部keydeltas := f.items[key] // 获取该key的Delta链f.queue = f.queue[1:] // 移除头部keydelete(f.items, key) // 从map中删除err := process(deltas) // 处理Delta链(交给Informer)if e, ok := err.(ErrRequeue); ok {f.add(key, deltas) // 处理失败则重新入队}return deltas, err}

}

3.3.3 Indexer:带索引的本地缓存

Indexer是线程安全的本地缓存,支持按自定义字段建立索引,大幅提升查询效率。

默认索引:内置

NamespaceIndex,按资源的Namespace分组;自定义索引:通过

IndexFunc定义索引规则(如按Pod状态、标签等)。

自定义索引示例:

import ("k8s.io/client-go/tools/cache"corev1 "k8s.io/api/core/v1"

)// 1. 定义索引函数:按Pod的NodeName索引

nodeNameIndexFunc := func(obj interface{}) ([]string, error) {pod, ok := obj.(*corev1.Pod)if !ok {return nil, fmt.Errorf("invalid type: %T", obj)}return []string{pod.Spec.NodeName}, nil // 返回NodeName作为索引值

}// 2. 创建带自定义索引的Indexer

indexer := cache.NewIndexer(cache.MetaNamespaceKeyFunc, // 资源唯一标识生成函数cache.Indexers{"nodeName": nodeNameIndexFunc, // 注册索引(名称:nodeName)},

)// 3. 按索引查询:获取某个Node上的所有Pod

podsOnNode, _ := indexer.ByIndex("nodeName", "node-1")

四、实战进阶:构建生产级控制器

4.1 Informer+Workqueue:解耦事件与业务

在自定义控制器中,直接在Informer回调中处理业务会导致阻塞和重试困难。通过Workqueue解耦:

Informer:负责监听事件,将资源标识(如

namespace/name)丢入队列;Worker:从队列中取任务,执行业务逻辑(如状态检查、资源调谐)。

完整控制器示例:

package mainimport ("fmt""time"corev1 "k8s.io/api/core/v1""k8s.io/client-go/kubernetes""k8s.io/client-go/tools/cache""k8s.io/client-go/tools/clientcmd""k8s.io/client-go/util/workqueue""k8s.io/client-go/informers"

)// Controller 控制器结构体

type Controller struct {clientset *kubernetes.Clientsetqueue workqueue.RateLimitingInterface // 带限流的工作队列informer cache.SharedIndexInformer // Pod Informer

}// NewController 创建控制器实例

func NewController(kubeconfig string) (*Controller, error) {// 1. 初始化Clientsetconfig, err := clientcmd.BuildConfigFromFlags("", kubeconfig)if err != nil {return nil, err}clientset, err := kubernetes.NewForConfig(config)if err != nil {return nil, err}// 2. 创建Informer工厂(30分钟重同步一次)factory := informers.NewSharedInformerFactory(clientset, 30*time.Minute)podInformer := factory.Core().V1().Pods().Informer()// 3. 创建工作队列(支持重试和限流)queue := workqueue.NewRateLimitingQueue(workqueue.DefaultControllerRateLimiter())// 4. 注册Informer事件回调:将事件丢入队列podInformer.AddEventHandler(cache.ResourceEventHandlerFuncs{AddFunc: func(obj interface{}) {key, err := cache.MetaNamespaceKeyFunc(obj) // 生成资源唯一标识(ns/name)if err == nil {queue.Add(key) // 入队}},UpdateFunc: func(oldObj, newObj interface{}) {key, err := cache.MetaNamespaceKeyFunc(newObj)if err == nil {queue.Add(key)}},DeleteFunc: func(obj interface{}) {key, err := cache.DeletionHandlingMetaNamespaceKeyFunc(obj) // 处理已删除资源if err == nil {queue.Add(key)}},})return &Controller{clientset: clientset,queue: queue,informer: podInformer,}, nil

}// Run 启动控制器

func (c *Controller) Run(stopCh <-chan struct{}) {defer c.queue.ShutDown()// 1. 启动Informergo c.informer.Run(stopCh)// 2. 等待缓存同步完成if !cache.WaitForCacheSync(stopCh, c.informer.HasSynced) {fmt.Println("缓存同步失败")return}// 3. 启动2个Worker处理队列for i := 0; i < 2; i++ {go c.worker(stopCh)}fmt.Println("控制器启动完成")<-stopCh

}// worker 处理队列中的任务

func (c *Controller) worker(stopCh <-chan struct{}) {for c.processNextWorkItem() {}

}// processNextWorkItem 从队列取任务并处理

func (c *Controller) processNextWorkItem() bool {key, shutdown := c.queue.Get() // 取任务if shutdown {return false}defer c.queue.Done(key) // 标记任务完成// 执行业务逻辑err := c.syncPod(key.(string))if err != nil {// 处理失败,重新入队(带重试间隔)c.queue.AddRateLimited(key)fmt.Printf("处理失败 %s: %v,将重试\n", key, err)return true}// 处理成功,取消限流c.queue.Forget(key)return true

}// syncPod 业务逻辑:检查Pod状态并打印

func (c *Controller) syncPod(key string) error {// 从缓存中获取Pod(解析key为namespace和name)namespace, name, err := cache.SplitMetaNamespaceKey(key)if err != nil {return err}// 从Informer缓存查询(避免直接调用API Server)obj, exists, err := c.informer.GetIndexer().GetByKey(key)if err != nil {return err}if !exists {fmt.Printf("Pod %s/%s 已删除\n", namespace, name)return nil}pod := obj.(*corev1.Pod)fmt.Printf("处理Pod %s/%s,状态:%s\n", namespace, name, pod.Status.Phase)return nil

}func main() {ctrl, err := NewController("~/.kube/config")if err != nil {panic(err)}stopCh := make(chan struct{})defer close(stopCh)ctrl.Run(stopCh)

}

五、最佳实践与注意事项

客户端选择:

内置资源优先用Clientset(类型安全);

CRD用DynamicClient或生成自定义Clientset(通过client-gen)。

Informer优化:

避免频繁创建独立Informer,优先用

SharedInformerFactory(缓存共享,减少API请求);合理设置resync周期(默认30分钟),过长可能导致缓存不一致,过短增加API压力。

Workqueue配置:

按需调整并发数(Worker数量),避免资源竞争;

使用

RateLimitingQueue控制重试频率,防止风暴。

缓存查询:

优先通过Lister/Indexer查询本地缓存,减少API Server调用;

缓存查询前需确认

HasSynced为true(避免缓存未就绪)。

六、总结

Client-Go通过分层抽象和高效缓存机制,为Kubernetes API交互提供了强大支撑。从类型化的Clientset到动态的DynamicClient,从实时监听的Informer到解耦处理的Workqueue,其设计既满足了开发便捷性,又保证了生产级性能。掌握Client-Go不仅是开发自定义控制器、Operator的基础,更是深入理解Kubernetes控制平面工作原理的关键。