VGG改进(5):基于Multi-Scale Attention的PyTorch实战

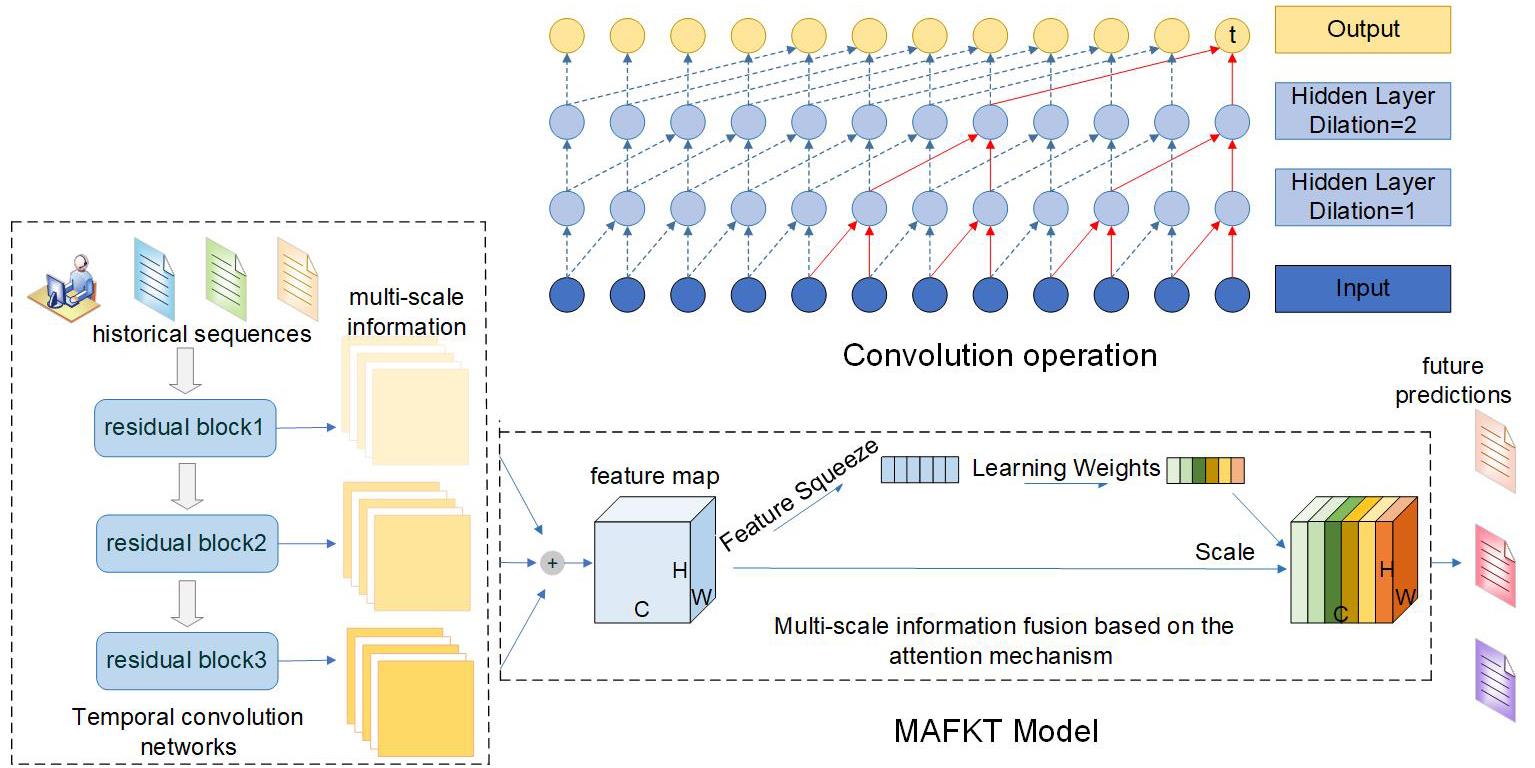

1. 多尺度注意力机制原理

1.1 注意力机制的基本概念

注意力机制源于人类视觉系统的工作原理——人类不会同时处理视野中的所有信息,而是选择性地关注重要区域。在深度学习领域,注意力机制使网络能够动态地聚焦于输入中最相关的部分,从而提高模型的表达能力和计算效率。

1.2 多尺度特征融合的重要性

不同尺度的特征包含不同类型的信息:

细粒度特征(小尺度)捕捉纹理、边缘等细节信息

粗粒度特征(大尺度)捕捉整体结构和上下文信息

多尺度融合能够综合利用这些互补信息,提高模型对不同大小目标的识别能力。

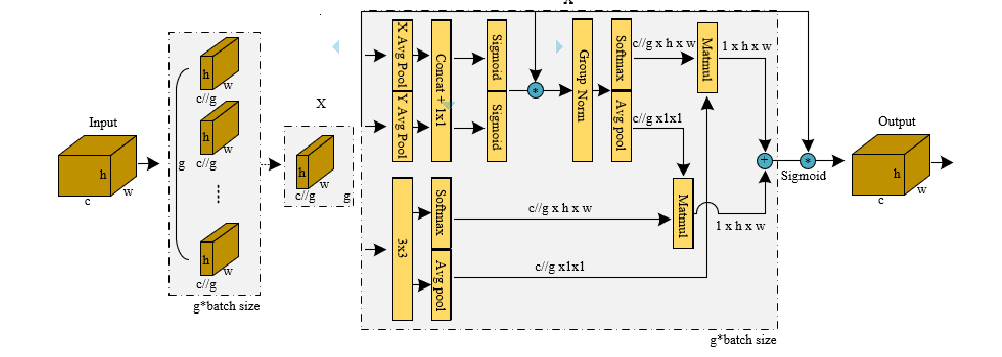

1.3 通道注意力与空间注意力的协同

我们的多尺度注意力模块同时结合了:

通道注意力:学习不同特征通道的重要性权重

空间注意力:学习特征图中不同空间位置的重要性权重

这种双注意力机制使模型能够在通道和空间两个维度上自适应地调整注意力分布。

2. 多尺度注意力模块实现详解

2.1 模块结构设计

class MultiScaleAttention(nn.Module):def __init__(self, in_channels, reduction_ratio=16):super(MultiScaleAttention, self).__init__()# 多尺度卷积路径self.conv1x1 = nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=1)self.conv3x3 = nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=3, padding=1)self.conv5x5 = nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=5, padding=2)# 通道注意力self.channel_attention = nn.Sequential(nn.AdaptiveAvgPool2d(1),nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=1),nn.ReLU(inplace=True),nn.Conv2d(in_channels // reduction_ratio, in_channels, kernel_size=1),nn.Sigmoid())# 空间注意力self.spatial_attention = nn.Sequential(nn.Conv2d(3, 1, kernel_size=7, padding=3),nn.Sigmoid())# 融合后的卷积self.fusion_conv = nn.Conv2d(in_channels * 3 // reduction_ratio, in_channels, kernel_size=1)2.2 多尺度特征提取原理

多尺度卷积路径使用三种不同大小的卷积核:

1×1卷积:捕获局部细节和进行降维

3×3卷积:平衡感受野和计算复杂度,是VGG的核心组件

5×5卷积:提供更大的感受野,捕获更广泛的上下文信息

这种设计使模块能够同时捕获不同尺度的特征信息,增强模型对多尺度目标的适应能力。

2.3 通道注意力机制实现

通道注意力通过全局平均池化获取全局上下文信息,然后使用两个全连接层(用1×1卷积实现)学习通道间的重要性关系:

# 通道注意力

channel_att = self.channel_attention(x)Sigmoid激活函数将输出限制在0-1之间,表示每个通道的权重系数。

2.4 空间注意力机制实现

空间注意力通过 concatenate 三种池化操作的结果:

最大池化:突出最显著的特征

平均池化:保留整体特征分布

标准差池化:捕获特征变异程度

# 空间注意力 max_pool = torch.max(x, dim=1, keepdim=True)[0] avg_pool = torch.mean(x, dim=1, keepdim=True) std_pool = torch.std(x, dim=1, keepdim=True) spatial_feat = torch.cat([max_pool, avg_pool, std_pool], dim=1) spatial_att = self.spatial_attention(spatial_feat)

2.5 特征融合与残差连接

多尺度特征首先被 concatenate 然后通过融合卷积进行整合:

# 融合多尺度特征

fused_feat = torch.cat([feat1x1, feat3x3, feat5x5], dim=1)

fused_feat = self.fusion_conv(fused_feat)最终通过残差连接将注意力加权的特征与原始输入相加,确保训练稳定性:

# 应用注意力

attended_feat = fused_feat * channel_att * spatial_att# 残差连接

return x + attended_feat3. 集成多尺度注意力的VGG16实现

3.1 VGG16架构回顾

标准VGG16由13个卷积层和3个全连接层组成,使用3×3小卷积核堆叠和2×2最大池化。我们在此基础上插入多尺度注意力模块。

3.2 注意力位置选择策略

class VGG16WithMSA(nn.Module):def __init__(self, num_classes=1000, attention_positions=None):super(VGG16WithMSA, self).__init__()# 默认在特定的卷积块后加入注意力if attention_positions is None:attention_positions = [4, 9, 16, 23, 30] # 在每个卷积块后我们选择在每个卷积块后插入注意力模块,这样可以在不同抽象层次上应用多尺度注意力:

浅层:关注边缘、纹理等低级特征

中层:关注部件和模式

深层:关注高级语义和全局上下文

3.3 动态网络构建

我们使用配置列表动态构建VGG16网络:

channel_sequence = [64, 64, 'M', 128, 128, 'M', 256, 256, 256, 'M', 512, 512, 512, 'M', 512, 512, 512, 'M']通过遍历这个序列,自动添加卷积层、ReLU激活函数、池化层和注意力模块。

4. 实操指南:使用与自定义

4.1 基础使用方法

# 创建默认配置的模型

model = vgg16_msa(num_classes=1000)# 前向传播测试

dummy_input = torch.randn(2, 3, 224, 224)

output = model(dummy_input)

print(f"Output shape: {output.shape}")4.2 自定义注意力位置

# 自定义注意力插入位置

custom_attention_positions = [3, 8, 15, 22, 29] # 在ReLU激活前

model = vgg16_msa(num_classes=10, attention_positions=custom_attention_positions)4.3 调整还原比率

还原比率(reduction_ratio)控制注意力机制的参数量和计算复杂度:

# 在MultiScaleAttention类中调整还原比率

self.conv1x1 = nn.Conv2d(in_channels, in_channels // 8, kernel_size=1) # 使用更小的还原比率较小的还原比率(如8)增加模型容量但提高计算成本,较大的还原比率(如32)减少参数但可能降低表现。

4.4 训练技巧与建议

学习率调整:注意力模块需要适当的学习率,建议使用略低于主干网络的学习率

渐进式训练:可以先训练主干网络,然后解冻注意力模块进行微调

正则化:由于增加了参数数量,建议使用适当的权重衰减和Dropout

5. 性能分析与实验设计

5.1 计算复杂度分析

多尺度注意力模块增加了额外的计算开销,主要包括:

多尺度卷积操作

通道注意力计算

空间注意力计算

通过还原比率可以有效控制这些开销。当reduction_ratio=16时,参数增加量约为原VGG16的5-10%。

5.2 内存占用考虑

注意力模块会增加训练时的内存占用,主要来自:

多尺度特征图的存储

注意力权重的计算

建议在内存受限的环境中使用梯度检查点或降低批量大小。

5.3 消融实验设计

为了验证各组件的有效性,可以设计以下消融实验:

基线模型:标准VGG16

仅多尺度:只有多尺度卷积,无注意力机制

仅通道注意力:多尺度+通道注意力

仅空间注意力:多尺度+空间注意力

完整模块:多尺度+双注意力

5.4 可视化分析建议

使用以下技术可视化注意力机制的效果:

特征图可视化:显示不同尺度的特征响应

注意力热力图:生成类别激活图,显示模型关注区域

通道重要性:分析不同通道的注意力权重分布

6. 实际应用场景

6.1 细粒度图像分类

多尺度注意力特别适合细粒度分类任务,如:

鸟类物种识别

车型识别

医学图像分析

注意力机制可以帮助模型聚焦于区分性区域。

6.2 目标检测与分割

作为Backbone网络,改进的VGG16可以用于:

Faster R-CNN、Mask R-CNN等检测框架

U-Net等分割架构

多尺度特征提取能力有助于处理不同大小的目标。

6.3 数据稀缺场景

在训练数据有限的情况下,注意力机制作为一种隐式正则化,可以降低过拟合风险,提高模型泛化能力。

7. 扩展与优化方向

7.1 高效注意力变体

可以考虑以下高效注意力变体来降低计算成本:

分组注意力:将通道分组并独立计算注意力

轴向注意力:分别沿高度和宽度维度计算注意力

线性注意力:使用线性复杂度近似标准注意力

7.2 自适应尺度选择

当前使用固定的1×1、3×3、5×5卷积核,可以扩展为:

可变形卷积:学习自适应的卷积采样位置

动态核大小:根据输入内容动态选择卷积核大小

7.3 跨模态注意力扩展

可以将多尺度注意力扩展到多模态任务:

视觉-语言任务:图像描述生成、视觉问答

多传感器融合:结合RGB、深度、红外等信息

完整代码

如下:

import torch

import torch.nn as nn

import torch.nn.functional as Fclass MultiScaleAttention(nn.Module):def __init__(self, in_channels, reduction_ratio=16):super(MultiScaleAttention, self).__init__()# 多尺度卷积路径self.conv1x1 = nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=1)self.conv3x3 = nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=3, padding=1)self.conv5x5 = nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=5, padding=2)# 通道注意力self.channel_attention = nn.Sequential(nn.AdaptiveAvgPool2d(1),nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=1),nn.ReLU(inplace=True),nn.Conv2d(in_channels // reduction_ratio, in_channels, kernel_size=1),nn.Sigmoid())# 空间注意力self.spatial_attention = nn.Sequential(nn.Conv2d(3, 1, kernel_size=7, padding=3),nn.Sigmoid())# 融合后的卷积self.fusion_conv = nn.Conv2d(in_channels * 3 // reduction_ratio, in_channels, kernel_size=1)def forward(self, x):batch_size, channels, height, width = x.size()# 多尺度特征提取feat1x1 = self.conv1x1(x)feat3x3 = self.conv3x3(x)feat5x5 = self.conv5x5(x)# 融合多尺度特征fused_feat = torch.cat([feat1x1, feat3x3, feat5x5], dim=1)fused_feat = self.fusion_conv(fused_feat)# 通道注意力channel_att = self.channel_attention(x)# 空间注意力max_pool = torch.max(x, dim=1, keepdim=True)[0]avg_pool = torch.mean(x, dim=1, keepdim=True)std_pool = torch.std(x, dim=1, keepdim=True)spatial_feat = torch.cat([max_pool, avg_pool, std_pool], dim=1)spatial_att = self.spatial_attention(spatial_feat)# 应用注意力attended_feat = fused_feat * channel_att * spatial_att# 残差连接return x + attended_featclass VGG16WithMSA(nn.Module):def __init__(self, num_classes=1000, attention_positions=None):super(VGG16WithMSA, self).__init__()# 默认在特定的卷积块后加入注意力if attention_positions is None:attention_positions = [4, 9, 16, 23, 30] # 在每个卷积块后self.attention_positions = attention_positions# 特征提取层layers = []in_channels = 3channel_sequence = [64, 64, 'M', 128, 128, 'M', 256, 256, 256, 'M', 512, 512, 512, 'M', 512, 512, 512, 'M']position_count = 0current_channels = in_channelsfor layer_config in channel_sequence:if layer_config == 'M':layers.append(nn.MaxPool2d(kernel_size=2, stride=2))else:layers.append(nn.Conv2d(current_channels, layer_config, kernel_size=3, padding=1))layers.append(nn.ReLU(inplace=True))current_channels = layer_configposition_count += 1# 在指定位置插入多尺度注意力if position_count in attention_positions:layers.append(MultiScaleAttention(current_channels))self.features = nn.Sequential(*layers)self.avgpool = nn.AdaptiveAvgPool2d((7, 7))self.classifier = nn.Sequential(nn.Linear(512 * 7 * 7, 4096),nn.ReLU(inplace=True),nn.Dropout(),nn.Linear(4096, 4096),nn.ReLU(inplace=True),nn.Dropout(),nn.Linear(4096, num_classes),)def forward(self, x):x = self.features(x)x = self.avgpool(x)x = torch.flatten(x, 1)x = self.classifier(x)return x# 创建带有多尺度注意力的VGG模型

def vgg16_msa(num_classes=1000, attention_positions=None):model = VGG16WithMSA(num_classes=num_classes, attention_positions=attention_positions)return model# 示例使用

if __name__ == "__main__":# 创建模型实例model = vgg16_msa(num_classes=1000)# 打印模型结构print("VGG16 with Multi-Scale Attention:")print(model)# 测试前向传播dummy_input = torch.randn(2, 3, 224, 224)output = model(dummy_input)print(f"\nInput shape: {dummy_input.shape}")print(f"Output shape: {output.shape}")print(f"Number of parameters: {sum(p.numel() for p in model.parameters()):,}")