LLM 残差链接是什么

LLM 残差链接是什么

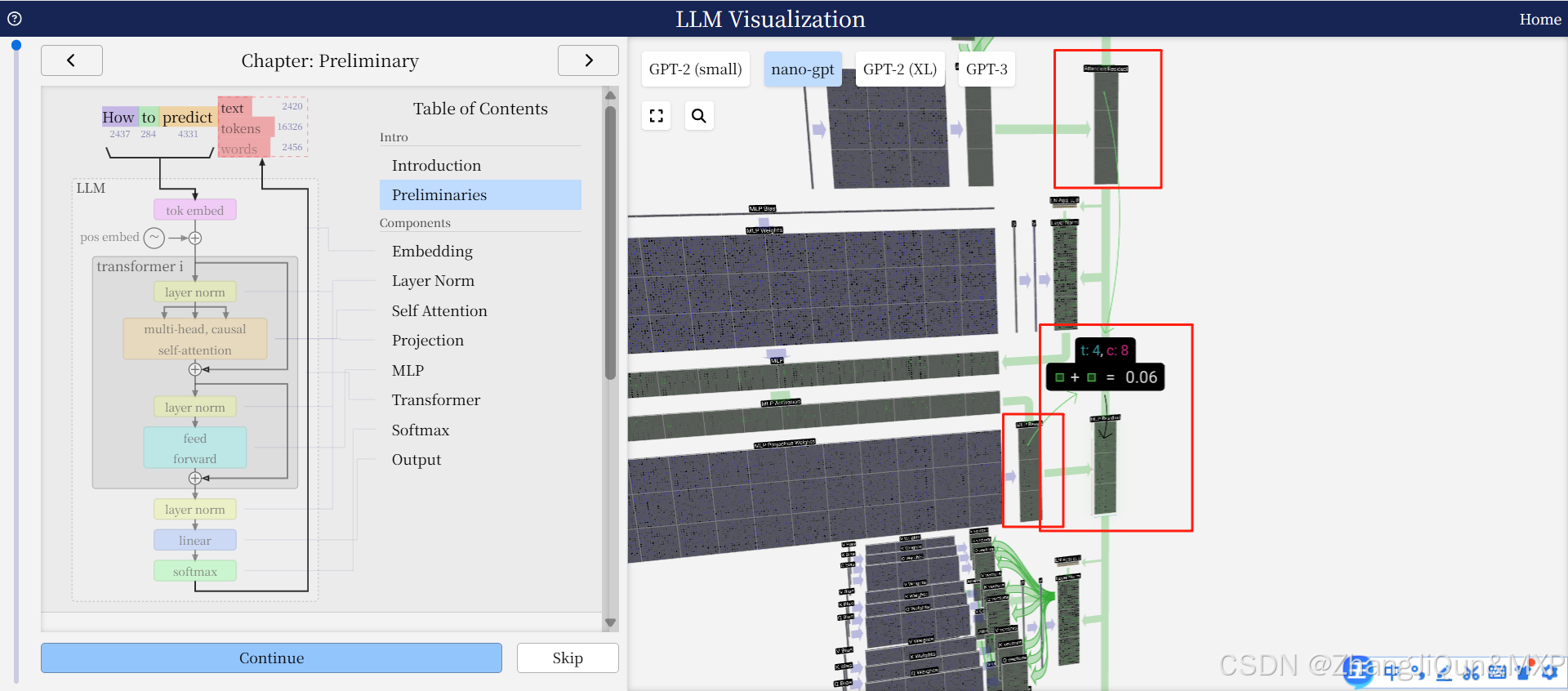

在大语言模型(LLM,如Transformer、GPT、BERT等)中,残差残残链接(Residual Connection)是核心组件之一,其设计思路与ResNet中的残差机制一致,但适配了自然语言处理的序列特征,主要作用是缓解深层网络的梯度消失问题,同时让模型更高效地学习“输入与输出的特征差异”。

一、LLM中残差链接的核心设计

LLM的基本单元是“Transformer块”(Transformer Block),每个块包含“多头注意力层”和“前馈神经网络层”,而残差链接会在每个子层(注意力层/前馈层)的输出与输入之间建立直接连接。

具体公式:

对于每个子层(如注意力层),设输入为 xxx,子层的计算结果为 <