规划是自动驾驶的“头脑”

规划是自动驾驶的“头脑”

感知模块(摄像头、雷达等)是自动驾驶汽车的眼睛和耳朵,它负责“看清”周围有什么(车道线、车辆、行人、红绿灯)。而规划模块就是汽车的“头脑”,它根据“眼睛”看到的信息,结合要去的目的地(导航信息),思考并决定汽车接下来应该怎么走——走哪条车道?是加速、减速还是变道?如何安全地绕过障碍物?如何与其他交通参与者互动?最终,它要生成一条具体的行驶路线(轨迹),告诉控制模块(汽车的“手脚”)方向盘怎么转、油门/刹车怎么踩。

为什么感知工程师需要了解规划?(Why Learn Planning?)

- 理解“客户”需求: 感知模块的输出(车道线位置、障碍物位置速度等)是规划模块的输入。了解规划需要什么信息、需要多高的精度、对哪些错误更敏感,能让感知工程师更好地优化自己的模块,提供更符合规划需求的数据。

- AI不只是感知: 虽然AI(特别是深度学习)在感知(图像识别、物体检测)上取得了巨大成功,但它正在向下游的预测和规划模块渗透。了解传统的规划原理,能帮助感知工程师理解AI如何能在整个自动驾驶流程中发挥更大作用。

- 问题驱动开发: 了解传统规划方法的局限性(比如处理复杂交互困难、依赖人工规则多),能帮助工程师更有针对性地利用AI工具(如神经网络、强化学习)去解决这些痛点。

- 更广阔的视野: 规划是任何自主系统(机器人、游戏AI)的核心。理解它有助于工程师参与更广泛的智能体开发领域。

规划是什么?(What is Planning?)

- 输入:

- 感知结果:静态道路结构(车道线、路沿)、动态物体(车辆、行人、自行车)的位置、速度、朝向等。

- 占用栅格(Occupancy Grid):标识哪些空间区域被占据或可能被占据。

- 交通规则信息(红绿灯状态)。

- 自车状态(位置、速度、加速度)。

- 导航信息(全局路线)。

- 输出: 一条轨迹 (Trajectory)。这是一系列在未来一段时间内(比如8秒),按固定时间间隔(比如0.4秒)给出的路径点 (Waypoints)。每个点包含车辆在那个时刻应该到达的位置(x, y)或(s, l,见坐标系说明)。

- 目标:

- 安全: 避免碰撞,遵守交通规则。

- 舒适: 控制加减速平顺(限制加速度和加加速度 Jerk),避免急打方向。

- 高效: 尽快、尽可能顺畅地到达目的地。

- 关键模块:

- 行为规划 (Behavior Planning / Decision Making): 决定高层策略或意图。例如:“在下一个路口左转”、“超越前方慢车”、“在行人前停车礼让”、“从左侧绕过障碍物”。它通常运行频率较低(1-5 Hz),输出比较“粗糙”的指示。

- 运动规划 / 轨迹规划 (Motion Planning / Trajectory Planning): 接收行为规划的输出,生成具体的、平滑且物理可行(车辆能执行)的行驶轨迹。它运行频率很高(10-20 Hz),输出精细的路径点序列。

- 全局路径规划 (Route Planning): 负责从起点到终点在道路级地图上规划路线(通常由地图服务提供,本文不重点讨论)。

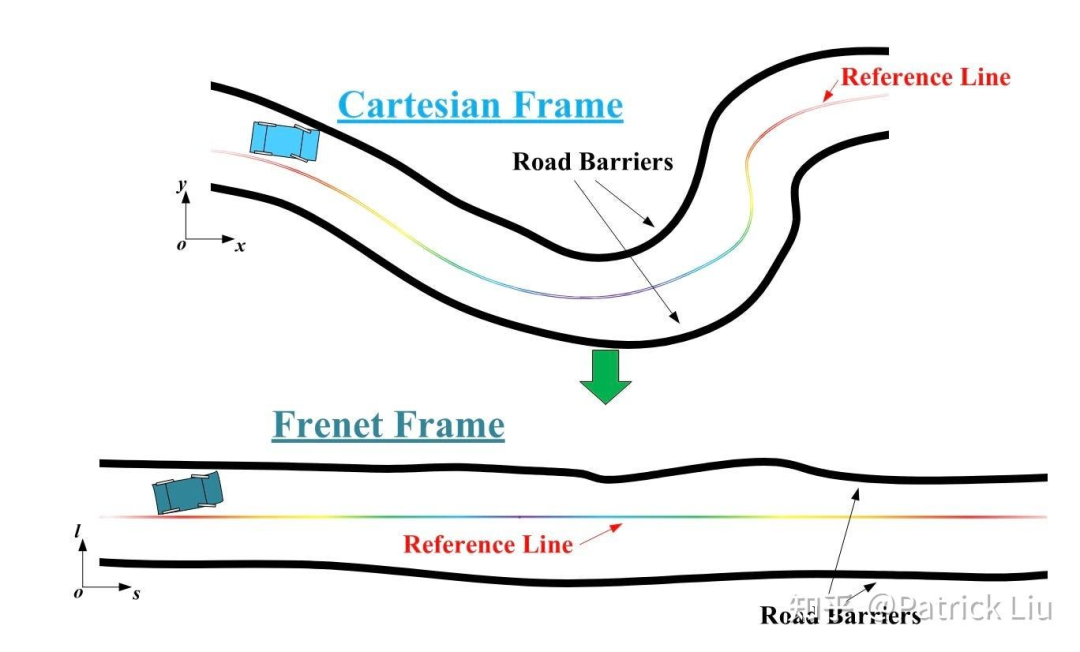

重要概念:Frenet坐标系 vs. 笛卡尔坐标系

- 笛卡尔坐标系 (Cartesian): 我们熟悉的直角坐标系 (x, y)。在复杂弯曲的道路上规划轨迹比较困难。

- Frenet坐标系: 基于一条参考线 (Reference Line)(通常是规划范围内的理想车道中心线)来定义位置。

- s (纵向): 沿着参考线走过的距离。

- l / d (横向): 垂直于参考线向左或向右的偏移距离。

- 优势: 将曲线道路“拉直”成一条隧道,使道路边界约束变成简单的线性约束(比如保持在-l_max到l_max之间),大大简化了优化问题(特别是横向运动)。人的舒适度感知在纵向(加减速)和横向(转向)上是不同的,Frenet坐标系允许分开优化。

- 局限性: 依赖清晰、曲率不高的结构化车道线(高速、城市快速路好用)。在高曲率道路(急弯)或非结构化道路(无车道线的停车场、路口)效果不好,这时笛卡尔坐标系更灵活。

经典工具:规划“三板斧”

规划的核心难题是在高维状态空间(位置、速度、加速度、时间等)中,找到满足所有约束(安全、物理可行)且达到目标(舒适、高效)的轨迹。工程师们主要用三种武器:

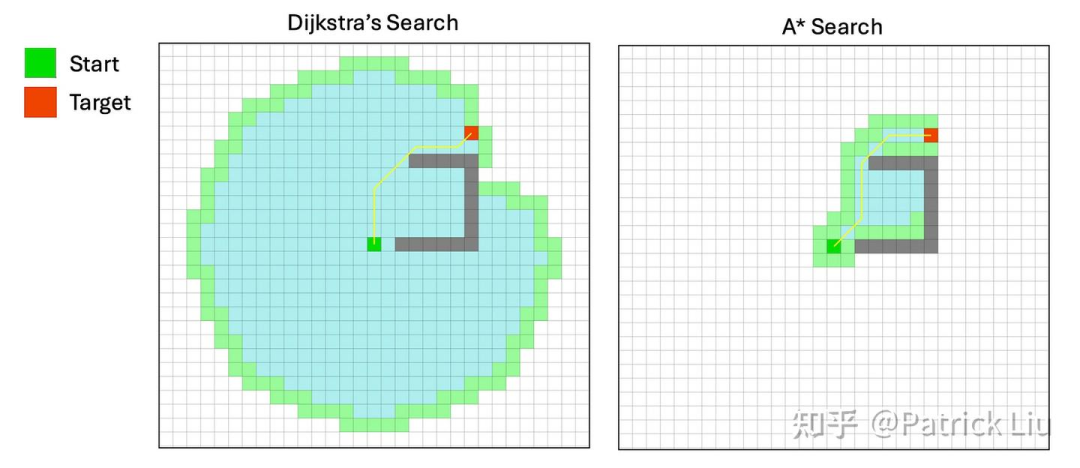

- 搜索 (Search):

- 思想: 系统地探索从起点到终点的可能路径,找到“最优”(比如最短、最安全)的一条。

- 代表算法:

- Dijkstra: “地毯式搜索”,保证找到最短路径,但效率低(探索所有方向)。

- A (A-Star):* Dijkstra的升级版,利用目标位置信息(启发函数 Heuristic)引导搜索方向,效率更高。

- 混合A (Hybrid A):** A* 的车辆运动学升级版。A* 在网格上移动,路径可能不符合车辆转向限制。混合A* 分离状态(在网格)和动作(连续,符合车辆转向角限制),并加入“解析扩展”(用符合车辆运动学的曲线如Dubins或Reeds-Shepp直接连到目标),在效率和最优性间折中。

- 适用场景: 停车场、无地图路口等非结构化环境路径规划。

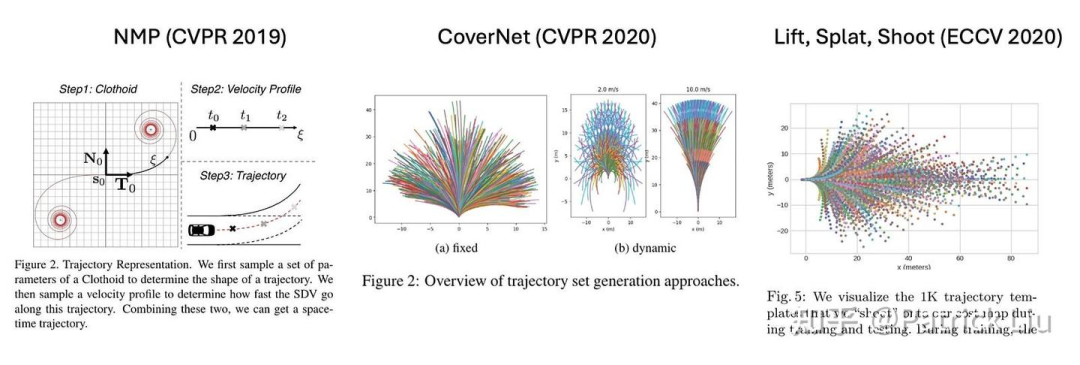

- 采样 (Sampling):

- 思想: 不系统搜索,而是随机或有指导地生成大量候选轨迹,然后根据预先定义的成本函数(Cost Function)评估并选择最好的那条。关键是要能快速评估大量选项。

- 代表思路:

- 数学采样: 知道问题有解析解(如最小化加加速度的轨迹是五次多项式),就在多项式参数空间采样候选轨迹,评估成本(考虑安全、舒适、效率等)。

- 数据驱动采样: 利用大量人类驾驶数据,直接学习并生成候选轨迹(模仿人类行为),然后用成本函数筛选。代表工作:CoverNet, Lift-Splat-Shoot, NMP。

- 优势: 天然并行化,易于结合数据(模仿学习)。

- 类比: 大语言模型(LLM)生成多个回答(采样),然后通过评估器(对齐人类偏好)选择最佳回答。

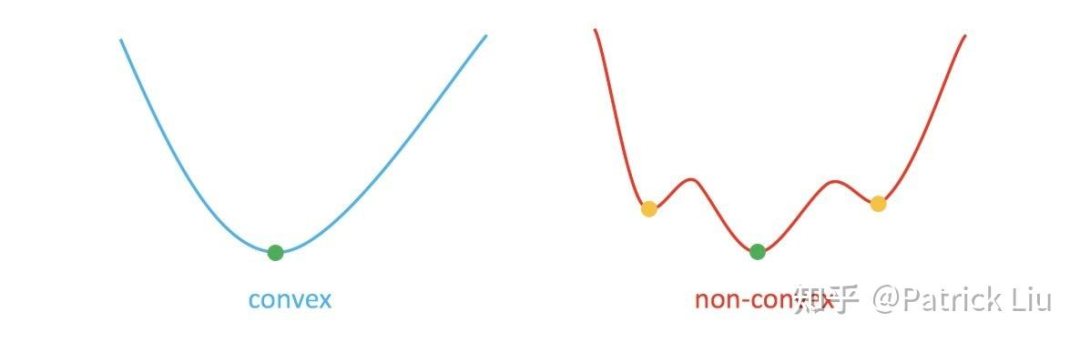

- 优化 (Optimization):

- 思想: 将规划问题公式化为一个数学问题:在给定的约束条件下(不能碰撞、不能压线、物理限制),寻找使目标函数(成本函数)最小化的轨迹变量(如位置序列)。成本函数通常包含:接近障碍物、偏离参考线、不舒适(急加/减速、急转)、低效率等惩罚项。

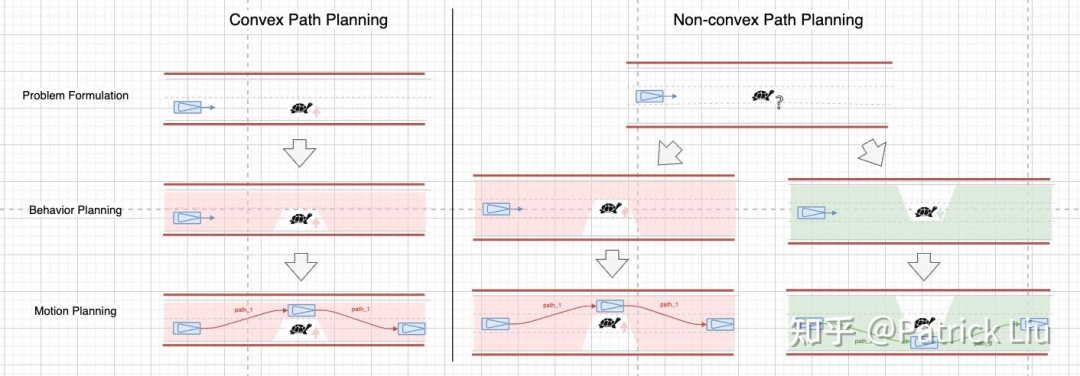

- 核心挑战: 规划问题是高度非凸 (Non-convex) 的,存在很多局部最优解(“坑”)。好的起点非常重要!

- 关键策略:

- 凸优化: 如果问题空间是凸的,则只有一个全局最优解,求解高效。通常依赖行为规划提供一个“绕行方向”(如“从左侧超车”),将非凸问题(避障)转化为凸问题(障碍物成为左侧边界约束)。

- 处理非凸性: 使用搜索或采样先找到一个粗略可行的路径 (粗解),将这个路径“膨胀”成一个安全的驾驶走廊 (Driving Corridor),在这个凸的走廊内进行精细的凸优化。这本质上是将行为规划(找方向/粗解)和运动规划(在走廊内优化)分离。

- 求解器效率: 优化求解速度是瓶颈(通常需~10ms)。10倍的速度提升可能带来算法设计的质变(特斯拉AI Day 2022展示了用NN加速优化)。

工业界实践:路径-速度解耦 vs. 时空联合

这是工业界实现运动规划的两种主流架构:

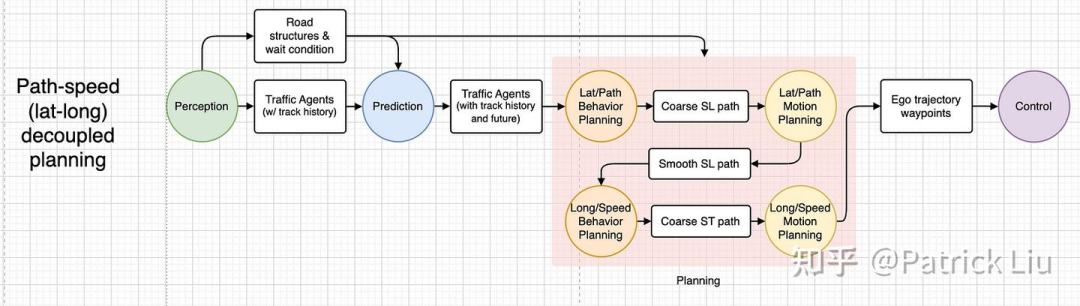

- 路径-速度解耦 (Path-Speed Decoupling / Lat-Long Decoupling):

- 思想: 将三维时空 (x, y, t 或 s, l, t) 规划问题拆解成两个二维问题:

- 路径规划 (横向, Lateral): 只考虑空间路径 (x, y 或 s, l)。决定车辆左右怎么走,比如保持车道、变道、绕障的路径。

- 速度规划 (纵向, Longitudinal): 在规划好的路径上,决定时间怎么分配,即速度曲线 (s, t)。决定何时加速、减速、停车。

- 代表:百度 Apollo EM Planner。

- E步 (Projection): 将3D问题投影到2D路径空间(SL)或2D速度空间(ST)。

- M步 (Optimization):

- 动态规划 (DP): 在路径或速度空间进行采样/搜索,生成粗解,解决非凸性(决定绕行方向/超车礼让),形成凸走廊。

- 二次规划 (QP): 在DP生成的凸走廊内进行精细优化,得到平滑、舒适的路径或速度曲线。

- 迭代: 路径优化和速度优化会迭代进行,相互提供信息。

- 优点: 实现相对简单,计算高效,能解决大部分(~95%)场景。

- 缺点: 在高度动态交互的复杂场景(如狭窄路口会车)可能表现保守或不够智能,因为路径和速度的决策被分开了。

- 思想: 将三维时空 (x, y, t 或 s, l, t) 规划问题拆解成两个二维问题:

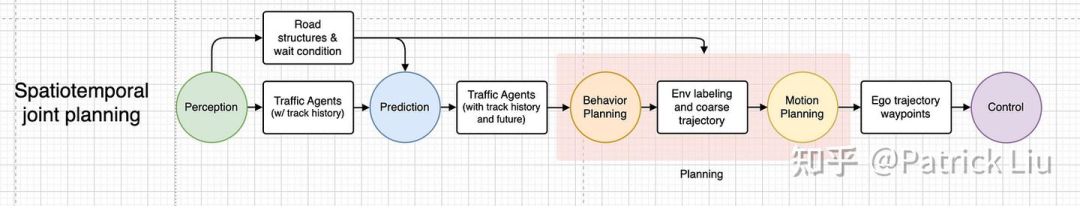

- 时空联合规划 (Joint Spatio-Temporal Planning):

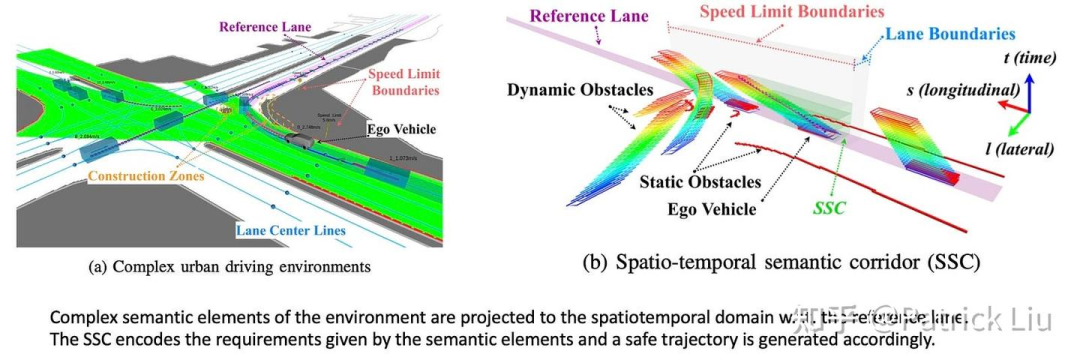

- 思想: 直接在三维时空 (x, y, t 或 s, l, t) 中进行规划,同时决定车辆的位置和速度。

- 动机: 为了解决那剩下5%的复杂交互场景(如狭窄空间会车、人车混行路口),需要更紧密地耦合空间和时间决策(比如,最佳策略可能是“稍微向右偏一点并减速”)。

- 难点: 直接在三维空间处理非凸优化问题计算量巨大。

- 解决方法:

- 暴力搜索: 在三维网格(如SLT)上使用改进的搜索算法(如混合A*在时空的扩展),考虑车辆运动学和时间约束。

- 构建时空走廊: 如时空语义走廊 (SSC)。先生成一个安全的时空隧道(一系列相连的无碰撞立方体),然后在每个凸的立方体内进行优化 (QP)。这仍然需要行为规划提供一个粗略的引导轨迹。

- 优点: 理论上在复杂交互场景中上限更高,能做出更类人的决策。

- 缺点: 实现复杂,计算开销大,参数调整困难。

决策 (Decision Making):应对交互与不确定性

行为规划的核心挑战在于交互和不确定性。其他交通参与者(车辆、行人)的意图和未来行为是未知的、概率性的。传统“预测-然后-规划”模式(把预测结果当确定事实)在密集交互场景容易导致过度保守(“冻结机器人”问题)。决策模块就是为解决这个问题而生。

- 理论基础:MDP & POMDP:

- 马尔可夫决策过程 MDP: 建模决策问题。包含:

- 状态 S: 环境(自车 + 他车 + 道路)的状态。

- 动作 A: 自车可以做的动作(如加速、左转)。

- 奖励 R: 执行动作后得到的好坏评价(如安全+1分,碰撞-100分)。

- 状态转移 P: 执行动作后,状态如何变化(概率性)。

- 折扣因子 γ: 未来奖励的重要程度衰减。

- 目标: 找到最优策略 (Policy) π(a|s),最大化长期累积奖励。

- 部分可观测马尔可夫决策过程 (POMDP): 现实世界状态无法完全观测(只能通过传感器感知),所以自动驾驶更适合用POMDP建模。它引入了观测 (Observation) 和 信念状态 (Belief)(对真实状态的概率估计)。

- 马尔可夫决策过程 MDP: 建模决策问题。包含:

- 求解方法:价值迭代 & 策略迭代: 系统求解MDP的方法(理论上保证最优,但计算量大,状态空间爆炸,不适合直接用于自动驾驶)。

- AlphaGo 的启示 - MCTS: AlphaGo用蒙特卡洛树搜索 (MCTS) 解决了围棋这个巨大状态空间的MDP问题。MCTS通过选择->扩展->评估(模拟/价值网络)->回溯四个步骤,在当前状态下进行有导向的深度搜索。它结合了策略网络(建议有希望的走法)和价值网络(快速评估局面好坏),极大地提升了搜索效率。这证明了树搜索 + 神经网络组合的强大威力。

- 应用到自动驾驶 - MPDM:

- 思想: 直接应用MCTS到自动驾驶状态空间仍然太大。MPDM (Multi-Policy Decision Making) 做了关键简化:

- 自车和其他车辆的行为被限制在有限的语义动作 (Semantic Actions) 集合内(如“加速超车”、“减速让行”、“左变道”)。这大大缩小了搜索空间。

- 为自车选择一个策略,为周围车辆选择一个(预测的)策略。

- 进行闭环前向模拟 (Rollout):模拟未来几秒(如5秒)内所有车辆按照选定策略互动的结果。

- 评估模拟结果(安全性、效率、舒适度)。

- 选择最优交互场景对应的策略,输出给运动规划模块执行。

- 优点: 能处理复杂交互(如主动切入车流),比“预测-然后-规划”更智能。

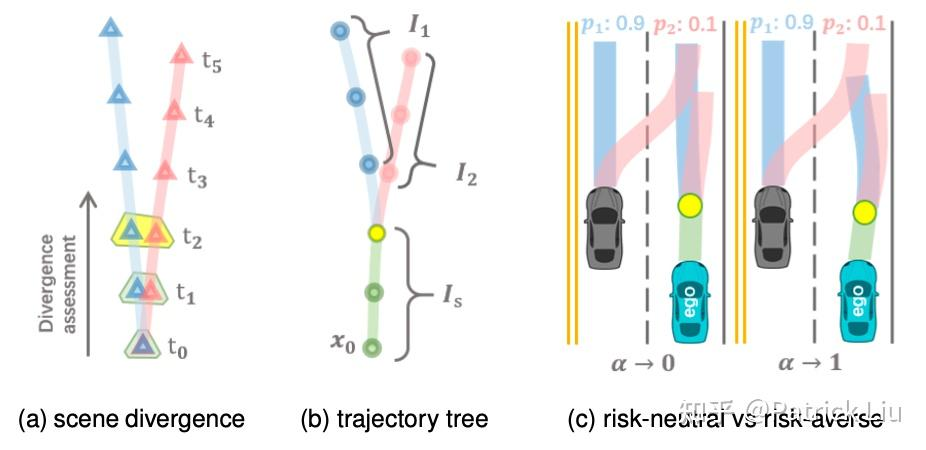

- 发展: EUDM, MARC 等后续工作改进了MPDM,如考虑更灵活的自车策略树、进行应急规划 (Contingency Planning)(为不同可能未来准备备选方案,延迟决策分叉点)、在模拟中使用更精细的运动规划。

- 思想: 直接应用MCTS到自动驾驶状态空间仍然太大。MPDM (Multi-Policy Decision Making) 做了关键简化:

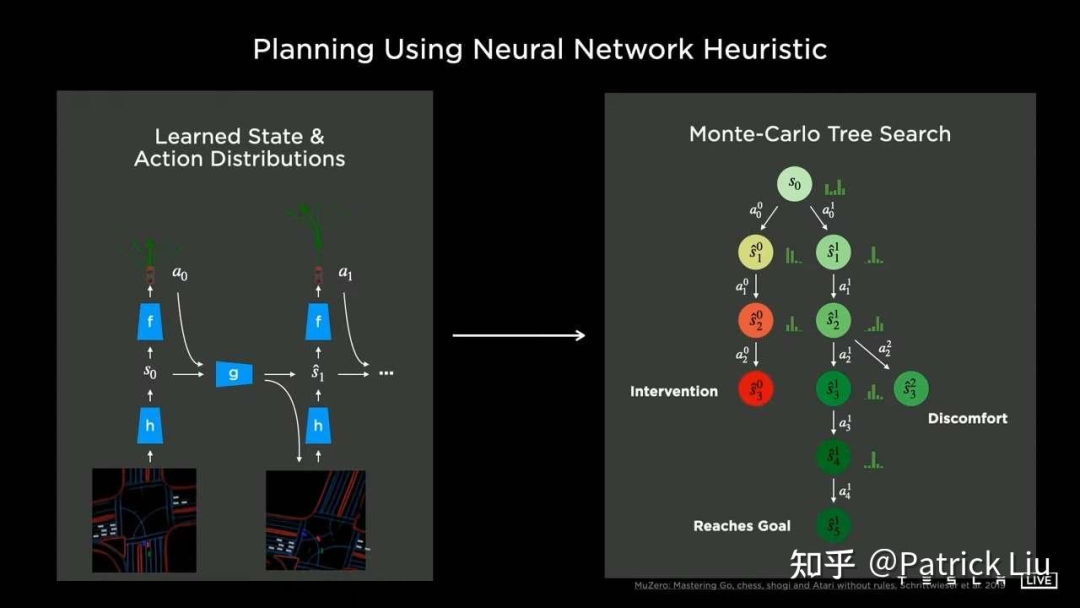

- 工业实践 - 特斯拉: 特斯拉在AI Day中展示了类似AlphaGo/MuZero的方法:

- 使用策略树(行为规划):定义目标,生成种子轨迹,评估关键场景,分支创建不同交互假设(如抢行/礼让)。

- 神经网络加速: 用神经规划器(模仿学习训练)极快生成候选轨迹(代替慢的基于物理的优化器),用神经评估器预测轨迹的“安全性”和“拟人性”,用于快速评分和剪枝策略树。

- 时空联合运动规划: 在策略树选定的“走廊”内进行优化。

AI在规划中的演进趋势

- 模块化系统中的AI增强: 在现有感知-预测-规划-控制流程中,AI逐渐渗透:

- 加速优化器: 用NN替代传统优化器(如QP求解器)的关键部分,实现10-100倍加速(特斯拉),让更复杂算法(如MCTS)实时运行成为可能。

- 数据驱动采样器: 用NN学习人类驾驶行为,生成更合理的候选轨迹(CoverNet, NMP)。

- 预测器与评估器: 用NN进行更准确的行为预测(多模态)和轨迹评估(安全性、舒适度、拟人性)。

- 端到端规划器: 用单一NN模型(如华为方案),输入结构化感知结果(物体列表、车道线等),直接输出轨迹,内部隐含了预测和决策。这是当前模块化系统的前沿。

- 端到端自动驾驶系统: 更激进的方案是单一巨型神经网络,从原始传感器输入(图像、雷达点云)直接输出控制信号(方向盘、油门/刹车),如特斯拉FSD v12和Wayve LINGO-2。这种模型像一个“世界模型”,学习驾驶的物理规律和交互逻辑。

- 潜在优势: 处理感知模块难以显式建模的复杂情况(如水坑、坑洼),通过海量数据学习涌现出智能行为。

- 挑战: 可解释性、安全性验证、需要巨量数据和计算。

- LLM用于决策? 大型语言模型(LLM)本身不是为连续决策设计的。但通过提示技术(思维链CoT、思维树ToT)或与MCTS结合(LLM作为常识知识库和策略建议器),LLM有潜力辅助高层决策和场景理解(如DriveVLM, LINGO-2)。目前仍是研究热点。

- 规划与感知的融合: 更紧密的结合是趋势,端到端模型是终极体现。传统模块中,UniAD等工作探索了通过可微分连接,让规划端的反馈能指导感知模块优化。

总结:感知规划速成要点

- 规划是大脑: 用感知输入(路、车、人)和导航,决策“怎么走”,输出轨迹 (x,y,t 序列)。

- 核心目标: 安全、舒适、高效。

- 两大模块:

- 行为规划/决策: 高层策略 (变道?超车?停车?),处理交互与不确定性。

- 运动规划: 生成平滑、可行的具体轨迹。

- Frenet坐标系: 基于参考线 (s, l),简化结构化道路规划。

- 经典工具:

- 搜索 (A, Hybrid A*):系统找路,适合非结构化环境。

- 采样: 生成大量候选,选最好的 (快,易结合数据)。

- 优化: 数学上求最佳解 (快慢依赖问题凸非凸)。

- 工业实践:

- 路径-速度解耦: 分开做路径 (左右) 和速度 (快慢),高效主流 (Apollo)。

- 时空联合: 同时做 (x,y,t),应对复杂交互,计算量大。

- 决策关键: 用树搜索 (MCTS) + 简化 (语义动作MPDM) + 模拟,处理交互不确定性。特斯拉是代表。

- AI趋势:

- 模块内:NN加速优化、生成候选、评估轨迹 (拟人、安全)。

- 模块间:可微分连接 (UniAD)、端到端规划器 (输入感知输出轨迹)。

- 全栈:端到端驾驶员 (输入传感器输出控制)。

- LLM辅助高层决策/理解。

- 为什么学? 理解下游需求,了解AI如何改变全栈,定位瓶颈,参与更广领域。

《Reloc3r: Large-Scale Training of Relative Camera Pose Regression for Generalizable, Fast, and Accurate Visual Localization》

核心目标:实现高效、精准、可泛化的视觉定位

你用手机拍照时,手机能立刻知道这张照片是在哪个建筑前、朝哪个方向拍的。这就是视觉定位(Visual Localization)或相机重定位(Camera Relocalization)的核心任务:给一张查询图片,找出它在已知场景(一个带坐标信息的图片数据库)中的精确位置和朝向(6自由度姿态:3D位置 + 3D旋转)。

视觉定位(Visual Localization):给定一张查询图像和一个包含已知相机位姿(位置和朝向)的图像数据库,快速且准确地估计出查询图像在相同场景中的6自由度(6-DoF)相机位姿(即3维位置 + 3维旋转)。这对于增强现实(AR)、机器人导航、自动驾驶等应用至关重要。

研究背景与现存问题

- 传统方法(基于SfM/结构):

- 原理:先离线重建场景的3D点云模型。在线定位时,将查询图像的特征点与3D模型点进行匹配,利用几何优化(如PnP算法)求解位姿。

- 优点:精度高。

- 缺点:依赖精确的3D重建;特征匹配和优化计算量大,速度慢(难以实时);3D模型构建和维护成本高。

- 场景坐标回归(Scene Coordinate Regression, SCR):

- 原理:训练神经网络为查询图像的像素点直接预测其在场景中的3D坐标(X, Y, Z)。有了3D-2D对应关系,再用PnP求解位姿。

- 优点:比传统方法快。

- 缺点:需要像素级的3D坐标真值作为监督(数据获取困难);模型通常绑定于特定训练场景,泛化到新场景能力差。

- 绝对位姿回归(Absolute Pose Regression, APR):

- 原理:训练神经网络直接输入单张图像,输出其6-DoF绝对位姿。

- 优点:推理速度极快(毫秒级)。

- 缺点:定位精度通常低于基于结构的方法;模型严重依赖训练数据,对新场景泛化能力非常有限(需要在每个新场景上重新训练或微调)。

- 相对位姿回归(Relative Pose Regression, RPR):

- 原理:训练神经网络输入一个图像对(查询图像 + 数据库参考图像),预测它们之间的相对旋转和平移。然后,利用已知的参考图像位姿和预测的相对位姿,计算出查询图像的绝对位姿(可能结合多个参考图像的结果)。

- 优点:有潜力泛化到新场景(学习的是图像对关系);速度较快。

- 缺点:

- 现有RPR方法的精度仍显著落后于APR和基于结构的方法。

- 泛化能力仍有限制(例如,需为室内/室外分别训练模型,或在新场景上误差显著增大)。

- 预测带度量尺度的相对平移对网络要求高,且场景尺度变化会影响泛化。

关键问题总结(痛点):

- 泛化性、效率、精度难以兼得:现有方法通常在至少一个方面存在明显短板。

- RPR潜力未完全释放:RPR框架本身具备跨场景潜力和效率优势,但在精度和泛化鲁棒性上尚未达到理想水平。

Reloc3r 解决方案:简约而强大

Reloc3r 的核心思路是:构建一个强大的RPR网络精确预测图像对相对位姿,并设计一个精巧的无参模块融合多个预测结果得到最终的高精度绝对位姿。 整个过程强调设计的简洁性和高效性。

工作流程详解:

- 图像检索:

- 使用现成的图像检索技术(如NetVLAD),从已知位姿的图像数据库中,为查询图像检索出最相似的 K 张参考图像(Top-K)。

- 输出:K 个 (查询图像, 参考图像) 对。

- 相对位姿回归网络(核心组件1):

- 输入:一个 (查询图像, 参考图像) 对。

- 架构:基于Vision Transformer (ViT),采用全对称设计:

- 共享编码器:同一个ViT编码器处理查询图像和参考图像。图像被分割成块(patches),线性嵌入并添加位置编码后输入编码器。

- 共享解码器 + 交叉注意力:同一个ViT解码器处理两个分支的信息。关键在于解码器块中包含交叉注意力层,允许查询图像的token去“关注”参考图像的token,反之亦然。这使得网络能深度理解两张图像之间的空间对应关系。

- 回归头:解码器输出的特征经过一个小型网络(由残差卷积块和MLP组成),直接预测该图像对之间的相对位姿:一个3x3的相对旋转矩阵

R_rel和一个3维的相对平移向量t_rel_dir。

- 关键创新点1:全对称性:

- 处理 (A, B) 和 (B, A) 对会得到一致的结果(

R_rel(A->B) = R_rel(B->A)^T,t_rel_dir(A->B) = -t_rel_dir(B->A)),符合物理规律。 - 权重共享显著减少了模型参数和计算量。

- 处理 (A, B) 和 (B, A) 对会得到一致的结果(

- 关键创新点2:尺度解耦:网络只预测方向性的相对平移

t_rel_dir(一个单位向量或未归一化但尺度任意的向量),不预测其度量尺度。尺度问题留给后续模块解决,简化了网络学习目标,增强了泛化能力。 - 监督信号:损失函数最小化预测的相对旋转与真实相对旋转之间的差异(常用基于旋转矩阵的损失,如角度差或矩阵差异),以及预测的相对平移方向与真实方向之间的差异(如余弦相似度)。

- 运动平均模块(核心组件2):

- 输入:K个参考图像对应的预测结果:K个

R_rel和 K个t_rel_dir,以及K个参考图像的已知绝对位姿(R_ref_i, C_ref_i)(C_ref_i 是相机中心位置)。 - 任务:融合这K个带噪声的预测,得到查询图像的最终绝对旋转

R_q和绝对位置C_q。 - 旋转平均:

- 利用每个预测的相对旋转

R_rel_i和参考图像的绝对旋转R_ref_i,可以计算出一个查询图像绝对旋转的估计值:R_q_est_i = R_rel_i * R_ref_i。 - 得到K个

R_q_est_i。将它们转换为四元数表示(便于平均计算)。 - 计算这K个四元数的中值四元数(Median)。中值比均值更能抵抗噪声的干扰。

- 将中值四元数转换回旋转矩阵,即得到最终估计的查询图像绝对旋转

R_q。

- 利用每个预测的相对旋转

- 相机中心三角测量(位置估计):

- 利用预测的相对平移方向

t_rel_dir_i、最终估计的绝对旋转R_q和参考图像的相机中心C_ref_i。 - 将预测的相对平移方向

t_rel_dir_i根据查询图像的旋转R_q转换到世界坐标系:d_i = R_q * t_rel_dir_i。d_i是从查询图像相机中心指向参考图像相机中心的方向向量(在世界坐标系下)。 - 因此,从参考图像相机中心

C_ref_i出发,沿着方向-d_i的射线,理论上应穿过查询图像的相机中心C_q。 - 由于存在噪声,K条射线 (

C_ref_i + s * (-d_i), s 是标量参数) 不会严格相交于一点。 - 最小二乘解:求解一个点

C_q,使得它到所有K条射线的距离平方和最小。这是一个标准的几何问题,可以转换为求解一个线性方程组(通过构建矩阵并进行SVD分解高效求解)。

- 利用预测的相对平移方向

- 关键创新点3:无参鲁棒融合:

- 该模块没有任何可训练参数,完全基于几何原理。

- 通过旋转平均(中值)和位置三角测量(最小二乘)有效融合多个预测,显著降低单个预测噪声的影响,提高鲁棒性和精度。

- 巧妙解决尺度问题:网络预测的

t_rel_dir没有固定尺度。在位置估计的最小二乘解中,尺度信息自然地通过优化过程从多个射线交汇的几何约束中恢复出来。

- 输入:K个参考图像对应的预测结果:K个

实验结果与优势:

- 相对位姿估计(核心能力证明):

- 在ScanNet1500, RealEstate10K, ACID数据集上评估成对图像之间的相对旋转和平移误差。

- 结果:Reloc3r显著优于其他RPR方法(如Relative-PN, Relpose, Map-free)。甚至媲美或超越计算开销巨大的非回归方法(如NoPoSplat, ROAM)。

- 速度:在512x512图像上仅需42毫秒处理一个图像对,比许多非RPR方法快1-2个数量级,与其他RPR方法相当。

- 视觉定位(核心任务表现):

- 室内 (7 Scenes):在未针对该数据集进行任何训练或微调的情况下,Reloc3r取得了平均中位误差 0.04米 / 1.02度。这:

- 大幅优于所有其他RPR方法(包括那些在7 Scenes上训练的!如RelocNet, Relative PN, Map-free)。

- 接近需要3D模型的最先进基于结构方法的精度。

- 证明了其卓越的跨场景泛化能力。

- 室外 (Cambridge Landmarks):同样未进行任何微调,Reloc3r:

- 显著超越之前最好的RPR方法(如ImageNet+NCM),在最后4个场景上平均将姿态误差减半至0.38米 / 0.52度。

- 在旋转精度上甚至优于部分APR方法。

- 再次证明了强大的泛化能力。

- 室内 (7 Scenes):在未针对该数据集进行任何训练或微调的情况下,Reloc3r取得了平均中位误差 0.04米 / 1.02度。这:

- 消融实验(设计有效性证明):

- 全对称网络的重要性:将网络改为非对称(独立的分支和回归头),性能显著下降,计算量增加。证明了对称设计的必要性和高效性。

- 尺度解耦的重要性:尝试让网络直接预测带尺度的平移向量 (

t_rel),性能变差。验证了仅预测方向性平移 (t_rel_dir) 并将尺度问题留给运动平均模块的设计是最优的。

- 网络行为洞察:

- 可视化解码器中的交叉注意力图发现,仅通过位姿监督训练,网络就能在早期层学习到有意义的跨图像特征匹配能力。这表明网络有效地理解了图像对之间的几何关系。

总结与意义:

Reloc3r成功地在视觉定位的“不可能三角”上取得了突破性进展:

- 高泛化性:在包含约800万图像对的大规模混合数据集(涵盖室内外)上训练后,模型能够直接、零样本(Zero-Shot) 应用于从未见过的室内外场景,无需微调。

- 高精度:在极具挑战性的基准测试(7 Scenes, Cambridge)上,定位精度大幅超越现有RPR方法,媲美甚至接近需要3D模型的传统方法。

- 高效率:推理速度快(~42ms 每图像对),满足实时应用需求。

- 关键创新:

- 全对称ViT回归网络:简洁、高效、对称性保证,专注于学习精确的相对旋转和方向性平移。

- 运动平均模块:无参数、基于几何、鲁棒地融合多个相对预测,恢复精确的绝对位姿,并巧妙解决尺度问题。

局限性:

当查询图像和所有检索到的参考图像完全共线时(Degenerate Case),三角测量无法求解出唯一的相机中心位置。这是所有基于多视角几何方法的固有挑战。

Reloc3r为构建高效、精准且易于部署(无需场景特定适配)的视觉定位系统提供了一种强大而简洁的解决方案,具有重要的理论意义和实用价值。

虽然中文里都可能被宽泛地称为“视觉定位”,但 Visual Localization 和 Visual Grounding 是两个完全不同但又相关的任务。

一句话总结它们的区别:

- Visual Localization (视觉定位):回答的是 “我(相机)在哪里?” 的问题。

- Visual Grounding (视觉定位/指代):回答的是 “你说的那个东西在哪里?” 的问题。

| 对比维度 | Visual Localization (相机重定位) | Visual Grounding (视觉指代/定位) |

|---|---|---|

| 核心任务 | 估计相机本身在三维空间中的精确位置和朝向。 | 根据语言描述,在场景中找到并定位出特定的物体。 |

| 输入 (Input) | 一张查询图片。 | 一段语言描述 + 完整的场景信息(如图片序列、点云等)。 |

| 输出 (Output) | 相机的6自由度位姿(6-DoF Pose),即一组描述相机位置(X, Y, Z)和旋转(Roll, Pitch, Yaw)的参数。 | 目标物体的3D边界框(Bounding Box)或分割掩码(Mask)。 |

| 解决的问题 | “我这张照片是在哪里拍的?当时我正朝哪个方向?”(关注观察者的位置) | “你说的‘沙发旁边的红色台灯’是哪一个?它在什么位置?”(关注被观察物体的位置) |

| 关键技术 | 图像特征匹配(如SIFT)、三维重建(SfM)、姿态估计、几何一致性验证。 | 自然语言处理(NLP)、跨模态信息融合(连接文本和视觉)、目标检测与分割、关系推理。 |

| 简单比喻 | 你的手机相册根据GPS和陀螺仪信息,自动为照片打上“摄于台北101大楼前,朝向正北”的标签。 | 你对智能机器人说:“帮我把桌上那本蓝色的书拿过来。” 机器人需要理解“蓝色”、“书”、“桌上”这些信息,然后准确地找到那本书。 |

最根本的区别在于定位的目标和信息的输入:

- 定位目标不同:Visual Localization 定位的是相机(观察者)。Visual Grounding 定位的是场景中的物体。

- 输入性质不同:Visual Localization 的输入是纯视觉的(一张图片),它不理解语义。而 Visual Groundging 的核心是多模态的,它必须同时处理视觉信息和语言信息,并理解它们之间的关联,才能完成任务。

因此,虽然它们都涉及“定位”,但解决的是从“我在哪”到“它在哪”的根本性问题差异。

https://mp.weixin.qq.com/s/LeZnLz1Mb1OVEQ_GITzhhQ

《SAE-V: Interpreting Multimodal Models for Enhanced Alignment》

核心目标:让“多模态大模型”更透明、更听话

你有一个很厉害的AI助手(比如GPT-4V或者Gemini),它既能看懂文字,又能看懂图片(这就是“多模态”)。但它有时候会犯一些奇怪的错误,比如:

- 看图说错话(幻觉):明明图片里是一只猫,它非说是狗。

- 理解有偏差:对图片或文字的理解带有偏见。

- “精神分裂”:对同一张图片和文字的搭配,给出的回答前后不一致。

- 学坏了:如果训练它的数据质量不高(比如图文不匹配),它就更容易学歪。

我们想知道:这个AI助手“脑子”里到底是怎么想的?它为什么有时候会犯错?更重要的是,能不能让它学得更快更好,特别是让它更“听话”(也就是更“对齐”人类的期望)?SAE-V这篇论文,就是为解决这些问题而生的一个工具和方法。

SAE-V是什么?

你可以把SAE-V想象成给AI模型戴的一副特殊的“X光眼镜”和“听诊器”。

-

“X光眼镜”:看透模型的“思维”

- 之前的工具(叫SAE)主要用于理解纯文字模型是怎么“想”的。SAE-V把这个工具升级了,让它能看清楚同时处理文字和图片的模型(多模态大模型)内部发生了什么。

- 它像一台精密的扫描仪,能够扫描模型在处理图文信息时,其内部复杂的神经活动(称为“激活”或“表示”),并将这些活动分解成一个个相对独立、容易理解的“想法单元”(称为“特征”)。这些“想法单元”可能代表“图片里有猫”、“文字在描述颜色”、“这个组合很和谐”等等。

- 关键是,SAE-V能看出哪些“想法单元”同时关联了文字和图片信息(跨模态特征)。

-

“听诊器”:诊断问题和提升“健康”

- 仅仅“看透”还不够,SAE-V更厉害的是,它能利用看到的“想法”来直接帮助模型变得更好。

- 它发现:那些能很好融合文字和图片信息的“想法单元”(跨模态特征),通常对应着模型理解得更准确、表现更好的时候。

- 于是,SAE-V发明了一个“评分卡”(基于跨模态特征的余弦相似度评分)。这个评分卡能用来:

- 诊断数据质量:给用来训练模型的图文数据打分。高质量的数据(图文高度相关、信息丰富)会激活更多“跨模态融合好”的特征,得分高;低质量的数据(图文无关、信息混乱)得分低。

- 过滤数据,高效训练:在训练模型时,优先使用那些得分高的高质量数据!神奇的是,论文实验表明,只用一小部分(比如50%甚至更少)由SAE-V挑选出来的优质数据去训练模型,训练后的模型表现反而比用全部数据训练出来的更好(性能提升超过110%!)。这大大提高了训练效率和对齐质量。

SAE-V解决了什么关键问题?

- “黑盒子”变“透明”:多模态模型内部极其复杂,以前很难理解它们如何处理图文信息。SAE-V提供了窥探其内部运作的机制。

- “瞎练”变“精练”:传统训练需要海量数据,但其中很多是低效甚至有害的“垃圾数据”。SAE-V提供了一个内置的、自动化的“数据质量检测器”(无需额外模型),帮助筛选出最有价值的精华数据用于训练,事半功倍。

- 提升“对齐”效率与效果:通过使用高质量数据,模型能更快、更有效地学习到图文之间的正确关联,减少幻觉、偏见和不一致,从而更好地与人类意图“对齐”。

简单总结:

SAE-V是一个强大的工具,它能让科学家们:

- 看清多模态大模型(能同时处理文字和图片的AI)在“想”什么,特别是图文信息是如何在模型内部融合的。

- 利用这种“看清”的能力,自动找出训练数据中最高质量的那部分(那些能最好促进图文融合理解的数据)。

- 只用这些精华数据去训练模型,就能让模型学得更快、更好、更“听话”(对齐效果大幅提升),同时节省大量计算资源和时间。

核心价值: SAE-V不仅让多模态模型更可解释(知其然),更重要的是,它把这种可解释性直接转化为了实际应用价值(高效提升模型的对齐性能),让模型训练更智能、更高效。这比单纯为了解释而解释要有意义得多。

核心问题: 能不能直接用现在很火的全模态大模型(比如 GPT-4V, Gemini 等能处理文本、图像、表格、音频等多种数据的模型)来融合来自不同来源的数据(多源数据融合)?这样做有没有意义?融合后的结果能不能用来做后续的严肃分析?

痛点:

- 输出不稳定(“每次结果不一样”): 全模态大模型本身具有一定的随机性(就像聊天时同一个问题可能得到不同回答)。用它处理同一批多源数据,融合出来的结果每次可能都不一样。

- “黑箱”效应(不知道它怎么融合的): 大模型内部运作非常复杂且不透明。我们不知道它是如何理解、关联和融合来自不同来源的数据的。它就像一个不透明的黑盒子,输入数据,输出结果,但过程难以解释。

- 结果的可信度存疑: 由于上述两点(不稳定 + 不可解释),人们会怀疑:这个融合出来的结果到底靠不靠谱?有没有逻辑错误?有没有引入模型本身的偏见或幻觉?它值不值得信赖,能不能作为后续更深入分析(比如建模、预测、决策)的基础?

观点:

-

承认问题的严重性:

- 大模型的“黑箱”特性是真实存在的硬伤,不能忽视。传统的数据处理方法步骤清晰、逻辑可追溯,而大模型的内部决策过程难以复现和解释。

- 输出结果的不稳定性(每次可能不同)确实存在,这是由模型本身的概率采样机制决定的。

-

后续分析建立在融合结果上风险高:

- 如果你打算把大模型融合后的结果(比如一个融合后的数据表示、一个总结报告、一个特征向量等)作为输入,去训练另一个模型(做分类、预测等)或者做深入的数据挖掘(找规律、做决策),那么风险很大。

- 原因: 输入(融合结果)本身不稳定(这次是A样,下次是B样)且不可解释(不知道A或B为什么长这样),那么基于它训练出来的模型或者分析出来的结论,其稳定性和可信度就失去了根基。你无法解释最终结果的来源,也无法保证结果的可重复性。

-

这个研究方向有意义吗?有!但要明确目标:

- 有意义场景1:快速原型与应用开发

- 如果你的目标是快速构建一个应用原型,比如一个能综合理解图文信息的智能客服、一个初步的多模态数据检索或推荐系统、或者进行数据的初步探索和可视化,那么大模型非常有用。它能快速整合多源数据,省去大量定制化开发的麻烦和成本。

- 有意义场景2:研究大模型本身

- 如果你的研究课题本身就是探索大模型的局限性,比如研究它在多源数据融合中的稳定性、鲁棒性(抗干扰能力)、可解释性、是否存在偏见或幻觉等,那么你所担忧的这些不稳定和黑箱问题,恰恰就是研究的价值和出发点。研究如何缓解这些问题本身就很有意义。

- 不推荐场景:严谨的科学研究或工业级建模

- 如果你需要进行严谨的科学研究(要求可复现、可解释、结果可靠)或者构建高可靠性的工业级模型(用于关键决策),那么不能完全依赖大模型的黑箱输出作为核心数据基础或判断依据。

- 建议策略:

- 精细控制: 如果一定要用,需要对大模型进行非常精细的微调(Fine-tuning) ,并加入可控的机制或规则来约束和引导其融合过程,尽量减少随机性和不可控因素。

- 辅助角色: 更安全的做法是让大模型扮演辅助角色,比如用它来初步探索数据关联、生成假设、辅助数据清洗或特征工程,但核心的融合逻辑、关键判断和最终决策应该由更透明、可控的传统方法或可解释模型来完成。

- 有意义场景1:快速原型与应用开发

总结:

- 有研究意义和应用价值,但要认清边界: 用全模态大模型做多源数据融合是一个活跃且有潜力的方向,特别是在快速应用开发和模型本身研究方面。

- “黑箱”和“不稳定”是核心障碍: 这两个特性导致融合结果的可解释性和可信赖性不足。

- 后续分析需谨慎: 将大模型融合的结果直接用于后续的严肃建模或分析风险很高,不推荐,因为这会导致整个分析链条的根基不稳。

- 实用建议:

- 快速原型/探索? -> 可以大胆用,省时省力。

- 研究模型本身? -> 痛点即价值,深入研究。

- 严肃科研/工业建模? -> 不要完全依赖黑箱输出! 要么严格控制和微调模型,要么只让大模型打辅助,核心部分用更透明的方法。

简单说:大模型在多源融合上是个好用的“瑞士军刀”,但用它做出来的结果像“魔术”,好看但不知道原理。如果后续要做严谨的“科学实验”或重要的“工程建造”,就不能完全相信这个“魔术”的结果,要么弄清楚魔术是怎么变的(控制它),要么只用它来活跃下气氛(辅助探索),关键部分还得靠可靠的“工具”和“图纸”(传统可控方法)。