SigLIP和SigLIP2

SigLIP

方法动机

目前,利用大规模图文对进行对比学习(contrastive learning)是训练视觉模型的重要方式,典型代表是 CLIP 和 ALIGN。这些方法通过图文对齐来学习统一的图文表示空间,但它们通常使用基于 softmax 的对比损失(InfoNCE 损失),这需要对所有图文对的相似度进行归一化计算,计算和显存开销都比较大。SigLIP提出了一个更简单的新方法:Sigmoid 损失(Sigmoid Loss),用于语言-图像预训练,称为 Sigmoid Language-Image Pre-training。

论文

核心创新

传统 softmax 对比损失

● 需要对整个 batch 中的图文对相似度进行 softmax 归一化。

● 对每个图像要在所有文本中选出最匹配的,对每个文本也一样,操作比较复杂。

● 对 batch size 敏感,通常需要很大的 batch size 才能取得好效果。

Sigmoid 损失

● 不需要对整个 batch 做归一化,每对图文独立计算。

● 可以理解为一个二分类问题:匹配的图文对为正样本(label=1),不匹配的为负样本(label=-1)。

● 简化了分布式实现,更节省显存,可以支持超大 batch(甚至 1 百万)。

● 在小 batch size 下效果优于 softmax,大 batch size 下性能相近。

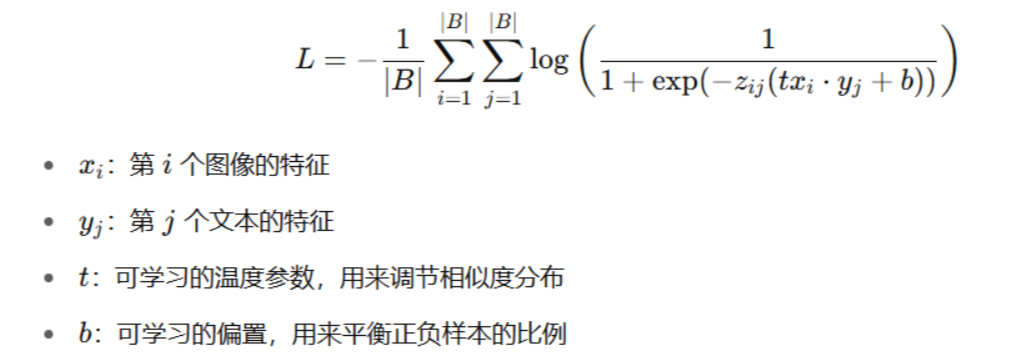

Sigmoid 损失是对每一对图文分别使用 sigmoid 激活函数进行二分类判断

模型架构

S